O que é um ataque de IA adversarial?

O que é um ataque de IA adversarial?

As tecnologias de aprendizagem profunda, como a Inteligência Artificial (IA) e a aprendizagem automática (ML), apresentam uma série de benefícios comerciais para as empresas. Ao mesmo tempo, um ataque de IA adversário é um desafio de segurança crescente para os sistemas modernos.

O que é um ataque de IA adversária? Uma forma de ciberataque que "engana" os modelos de IA com dados enganadores. Também conhecido como Adversarial ML, esta forma de ataque tem sido largamente registada na classificação de imagens e na deteção de spam.

De seguida, vamos discutir os vários riscos colocados por um ataque de IA Adversária.

Riscos colocados por um ataque de IA adversária

De acordo com Alexey Rubtsov do Global Risk Institute, "a aprendizagem automática adversarial explora as vulnerabilidades e especificidades dos modelos de aprendizagem automática". Por exemplo, a aprendizagem automática adversa pode levar um algoritmo de negociação baseado em aprendizagem automática a tomar decisões incorrectas sobre a negociação.

Como é que um ataque de IA adversária representa um risco para os sistemas de IA e de ML? Eis algumas conclusões comuns:

Engenharia das redes sociais: Neste caso, o ataque de IA "raspa" os perfis dos utilizadores nas plataformas de redes sociais utilizando a automatização. Em seguida, gera conteúdo automaticamente para "atrair" o perfil pretendido.

Deepfakes: Normalmente utilizados em fraudes bancárias, os deepfakes são agentes de ameaças em linha que podem atingir uma série de objectivos nefastos, incluindo:

Chantagem e extorsão

Prejudicar a credibilidade e a imagem de uma pessoa

Fraude documental

Redes sociais para assédio individual ou em grupo

Ocultação de malware: Aqui, os agentes de ameaças utilizam o ML para esconder o malware no tráfego "malicioso" que parece normal para os utilizadores regulares.

Palavras-passe: Os ataques de IA adversária podem até analisar um grande conjunto de palavras-passe e gerar variações. Por outras palavras, estes ataques tornam o processo de decifração de palavras-passe mais "científico". Para além das palavras-passe, o ML permite que os agentes de ameaças também resolvam CAPTCHAs.

Exemplos de ataques de IA adversária

Utilizando exemplos de IA adversária, os piratas informáticos podem simplesmente conceber um ataque para fazer com que o modelo de IA cometa um erro. Por exemplo, uma versão corrompida de uma entrada de modelo válida.

Eis alguns exemplos populares de métodos utilizados em ataques de IA Adversária:

Método do sinal de gradiente rápido (FGSM): Este é um método baseado em gradientes que pode gerar exemplos de IA adversária para causar a classificação incorrecta de imagens. Para tal, adiciona uma quantidade mínima de perturbação ao pixel da imagem.

Memória limitada Broyden-Fletcher-Goldfarb-Shanno (L-BFGS): Este método é outro algoritmo de otimização numérica não linear baseado em gradientes que pode minimizar o número de perturbações da imagem. Este método é extremamente eficaz na geração de exemplos de IA Adversarial.

Ataque de Deepfool: Este é outro método altamente eficaz na produção de ataques de IA adversária com uma elevada taxa de erros de classificação e menos perturbações. Esta forma de ataque utiliza uma técnica de geração de amostras adversárias não direccionadas para reduzir a distância euclidiana entre as amostras originais e as perturbadas.

Ataque ao mapa de saliência baseado em jacobianos (JSMA): Nesta forma de ataque de IA adversária, os hackers utilizam a seleção de características para minimizar o número de características modificadas, causando assim erros de classificação. As perturbações planas são adicionadas iterativamente às características com base no valor de saliência por ordem decrescente.

Estes são apenas alguns exemplos de IA Adversária. De seguida, vamos discutir como nos podemos defender dos ataques da IA Adversária.

Como se defender contra ataques de IA adversária

221122 skim ai infográfico 2 png 01

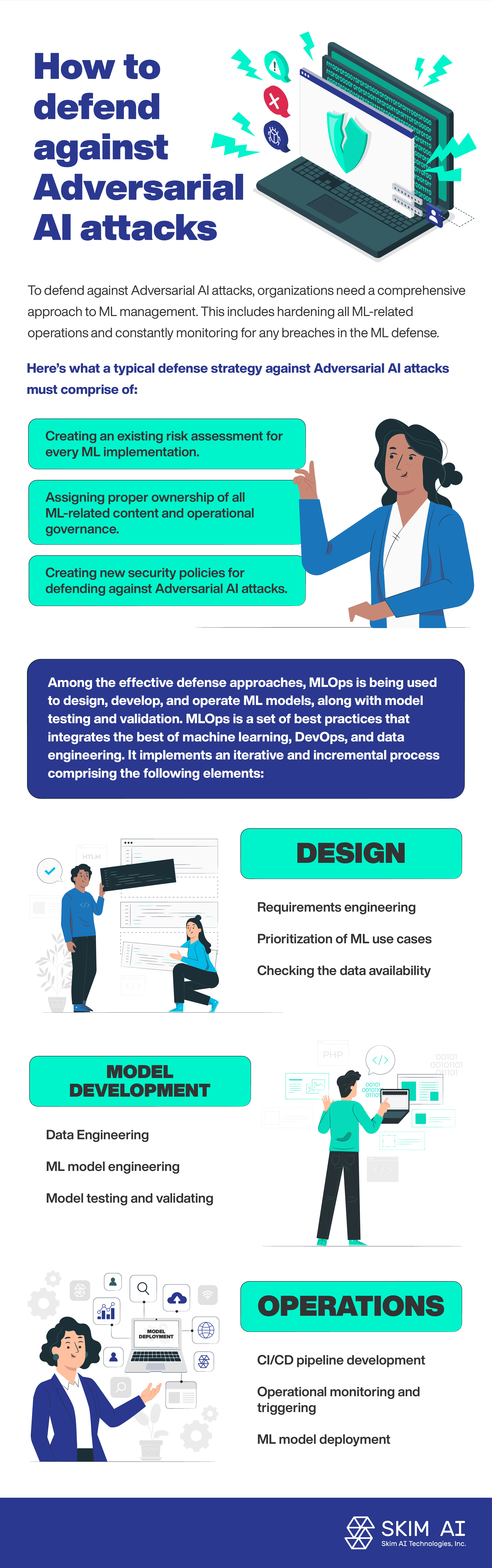

Para se defenderem contra ataques de IA adversária, as organizações precisam de uma abordagem abrangente à gestão de ML. Isto inclui o reforço de todas as operações relacionadas com o ML e a monitorização constante de quaisquer violações na defesa do ML.

Eis o que deve incluir uma estratégia de defesa típica contra ataques de IA adversária:

Criar uma avaliação de risco existente para cada implementação de ML.

Atribuição da propriedade adequada de todo o conteúdo relacionado com o ML e governação operacional.

Criação de novas políticas de segurança para a defesa contra ataques de IA adversária.

Entre as abordagens de defesa eficazes, o MLOps está a ser utilizado para conceber, desenvolver e operar modelos de ML, juntamente com o teste e a validação de modelos. O MLOps é um conjunto de práticas recomendadas que integra o melhor do aprendizado de máquina, DevOps e engenharia de dados. Implementa um processo iterativo e incremental que inclui os seguintes elementos:

Conceção:

Engenharia de requisitos

Priorização de casos de utilização de ML

Verificação da disponibilidade dos dados

Desenvolvimento de modelos:

Engenharia de dados

Engenharia de modelos ML

Teste e validação de modelos

Operações:

Implementação do modelo ML

Desenvolvimento de pipeline CI/CD

Monitorização operacional e acionamento

Conclusão

De acordo com a Comissão de Segurança Nacional dos EUA relatório sobre Inteligência Artificial, uma baixa percentagem dos fundos de investigação em IA está a ser investida na defesa dos sistemas de IA contra ataques adversários. A crescente adoção de tecnologias de IA e de aprendizagem automática está correlacionada com o aumento dos ataques de IA adversária. Efetivamente, os sistemas de IA e de aprendizagem automática representam uma nova superfície de ataque, aumentando assim os riscos relacionados com a segurança.