10 Estratégias comprovadas para reduzir os custos do seu LLM

À medida que as organizações dependem cada vez mais de modelos de linguagem de grande dimensão (LLMs) para várias aplicações, desde chatbots de serviço ao cliente até à geração de conteúdos, o desafio da gestão de custos dos LLMs tornou-se evidente. Os custos operacionais associados à implementação e manutenção de LLMs podem rapidamente ficar fora de controlo sem uma supervisão adequada e estratégias de otimização. Os picos de custos inesperados podem fazer descarrilar os orçamentos e impedir a adoção generalizada destas poderosas ferramentas.

Esta publicação do blogue explora dez estratégias comprovadas para ajudar a sua empresa a gerir eficazmente os custos de LLM, garantindo que pode aproveitar todo o potencial destes modelos, mantendo a eficiência de custos e o controlo das despesas.

- Estratégia 1: Seleção inteligente de modelos

- Estratégia 2: Implementar um acompanhamento robusto da utilização

- Estratégia 3: Otimizar a engenharia de prompts

- Estratégia 4: Aproveitar o aperfeiçoamento para a especialização

- Estratégia 5: Explorar opções gratuitas e de baixo custo

- Estratégia 6: Otimizar a gestão da janela de contexto

- Estratégia 7: Implementar sistemas multi-agentes

- Estratégia 8: Utilizar ferramentas de formatação de saída

- Estratégia 9: Integrar ferramentas não-LLM

- Estratégia 10: Auditoria e otimização regulares

- A linha de fundo

Estratégia 1: Seleção inteligente de modelos

Uma das estratégias mais impactantes para a gestão de custos do LLM é a seleção do modelo certo para cada tarefa. Nem todas as aplicações requerem os modelos mais avançados e maiores disponíveis. Ao adequar a complexidade do modelo aos requisitos da tarefa, é possível reduzir significativamente os custos sem sacrificar o desempenho.

Ao implementar aplicações LLM, é crucial avaliar a complexidade de cada tarefa e escolher um modelo que satisfaça essas necessidades específicas. Por exemplo, tarefas simples de classificação ou de resposta a perguntas básicas podem não exigir todas as capacidades do GPT-4o ou de outros modelos grandes e com muitos recursos.

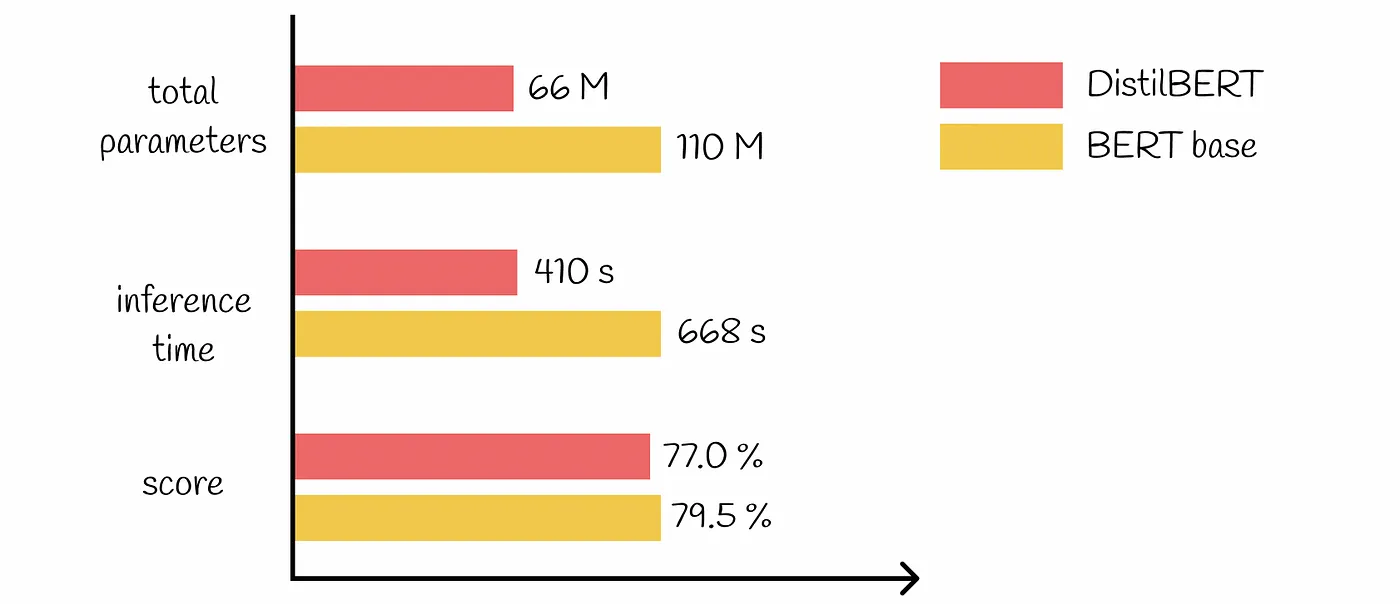

Estão disponíveis muitos modelos pré-treinados de vários tamanhos e complexidades. Optar por modelos mais pequenos e mais eficientes para tarefas simples pode levar a uma poupança substancial de custos. Por exemplo, pode utilizar um modelo leve como DistilBERT para análise de sentimentos em vez de um modelo mais complexo como o BERT-Grande.

Estratégia 2: Implementar um acompanhamento robusto da utilização

A gestão eficaz dos custos de LLM começa com uma compreensão clara da forma como estes modelos estão a ser utilizados na sua organização. A implementação de mecanismos robustos de acompanhamento da utilização é essencial para identificar áreas de ineficiência e oportunidades de otimização.

Para obter uma visão global do seu Utilização do LLMPara além disso, é crucial acompanhar as métricas a vários níveis:

Nível de conversação: Monitorize a utilização de tokens, os tempos de resposta e as chamadas de modelo para interacções individuais.

Nível do utilizador: Analisar padrões na utilização de modelos por diferentes utilizadores ou departamentos.

Nível da empresa: Agregar dados para compreender o consumo e as tendências globais de LLM.

Existem várias ferramentas e plataformas disponíveis para ajudar a controlar eficazmente a utilização do LLM. Estas podem incluir:

Painéis de controlo analíticos integrados fornecidos pelos prestadores de serviços de LLM

Ferramentas de monitorização de terceiros concebidas especificamente para aplicações de IA e ML

Soluções de rastreio personalizadas integradas na sua infraestrutura existente

Ao analisar os dados de utilização, pode descobrir informações valiosas que conduzem a estratégias de redução de custos. Por exemplo, pode descobrir que determinados departamentos estão a utilizar excessivamente modelos mais dispendiosos para tarefas que poderiam ser tratadas por alternativas de menor custo. Ou pode identificar padrões de consultas redundantes que podem ser resolvidos através de caching ou outras técnicas de otimização.

Estratégia 3: Otimizar a engenharia de prompts

Engenharia rápida é um aspeto crítico do trabalho com LLMs, e pode ter um impacto significativo no desempenho e no custo. Ao otimizar os seus prompts, pode reduzir a utilização de tokens e melhorar a eficiência das suas aplicações LLM.

Para minimizar o número de chamadas à API e reduzir os custos associados:

Utilize instruções claras e específicas nos seus avisos

Implementar o tratamento de erros para resolver problemas comuns sem exigir consultas LLM adicionais

Utilizar modelos de mensagens que se tenham revelado eficazes para tarefas específicas

A forma como estrutura os seus prompts pode afetar significativamente o número de tokens processados pelo modelo. Algumas práticas recomendadas incluem:

Ser conciso e evitar contextos desnecessários

Utilizar técnicas de formatação como pontos ou listas numeradas para organizar a informação de forma eficiente

Utilização de funções integradas ou parâmetros fornecidos pelo serviço LLM para controlar o comprimento e o formato da saída

Ao implementar estas técnicas de otimização imediata, pode reduzir substancialmente a utilização de tokens e, consequentemente, os custos associados às suas aplicações LLM.

Estratégia 4: Aproveitar o aperfeiçoamento para a especialização

O ajuste fino de modelos pré-treinados para tarefas específicas é uma técnica poderosa na gestão de custos do LLM. Ao adaptar os modelos às suas necessidades específicas, pode obter um melhor desempenho com modelos mais pequenos e mais eficientes, o que leva a uma poupança significativa de custos.

Em vez de confiar apenas em LLMs grandes e de uso geral, considere o ajuste fino de modelos menores para tarefas especializadas. Esta abordagem permite-lhe aproveitar o conhecimento de modelos pré-treinados enquanto optimiza para o seu caso de utilização específico.

Embora a afinação exija um investimento inicial, pode conduzir a poupanças substanciais a longo prazo. Os modelos aperfeiçoados requerem frequentemente menos tokens para obter os mesmos ou melhores resultados, reduzindo os custos de inferência. Podem também exigir menos tentativas ou correcções devido a uma maior precisão, reduzindo ainda mais os custos. Além disso, os modelos especializados podem muitas vezes ser mais pequenos, reduzindo a sobrecarga computacional e as despesas associadas.

Para maximizar os benefícios do ajuste fino, comece com um modelo pré-treinado mais pequeno como base. Utilize dados de alta qualidade e específicos do domínio para o ajuste fino e avalie regularmente o desempenho e a relação custo-eficácia do modelo. Este processo de otimização contínua garante que os seus modelos aperfeiçoados continuam a fornecer valor, mantendo os custos sob controlo.

Estratégia 5: Explorar opções gratuitas e de baixo custo

Para muitas empresas, especialmente durante as fases de desenvolvimento e de teste, a utilização de opções de LLM gratuitas ou a baixo custo podem reduzir significativamente as despesas sem comprometer a qualidade. Estas opções são particularmente valiosas para a criação de protótipos de novas aplicações LLM, formação de programadores na implementação LLM e execução de serviços não críticos ou internos.

No entanto, embora as opções gratuitas possam reduzir drasticamente os custos, é crucial considerar as contrapartidas. A privacidade dos dados e as implicações de segurança devem ser cuidadosamente avaliadas, especialmente quando se trata de informações sensíveis. Além disso, tenha em atenção as potenciais limitações das capacidades do modelo ou das opções de personalização. Considere a escalabilidade a longo prazo e as trajectórias de migração para garantir que as suas medidas de redução de custos não se tornam obstáculos ao crescimento futuro.

Estratégia 6: Otimizar a gestão da janela de contexto

O tamanho da janela de contexto em LLMs pode ter um impacto significativo no desempenho e nos custos. A gestão eficaz das janelas de contexto é crucial para controlar as despesas e manter a qualidade dos resultados. Janelas de contexto maiores permitem uma compreensão mais abrangente, mas têm um custo mais elevado devido ao aumento da utilização de tokens por consulta e a maiores requisitos computacionais.

Para otimizar a utilização da janela de contexto, considere a implementação do dimensionamento dinâmico do contexto com base na complexidade da tarefa. Utilize técnicas de resumo para condensar informações relevantes e utilize abordagens de janela deslizante para documentos ou conversas longas. Estes métodos podem ajudá-lo a encontrar o ponto ideal entre a compreensão e a rentabilidade.

Analise regularmente a relação entre o tamanho do contexto e a qualidade do resultado para aperfeiçoar a sua abordagem. Ajuste as janelas de contexto com base nos requisitos específicos da tarefa e considere a implementação de uma abordagem em camadas, usando contextos maiores apenas quando necessário. Ao gerir cuidadosamente as suas janelas de contexto, pode reduzir significativamente a utilização de tokens e os custos associados sem sacrificar a qualidade dos seus resultados LLM.

Estratégia 7: Implementar sistemas multi-agentes

Os sistemas multi-agente oferecem uma abordagem poderosa para melhorar a eficiência e a relação custo-eficácia das aplicações de LLM. Ao distribuir as tarefas por agentes especializados, as empresas podem otimizar a atribuição de recursos e reduzir os custos globais de LLM.

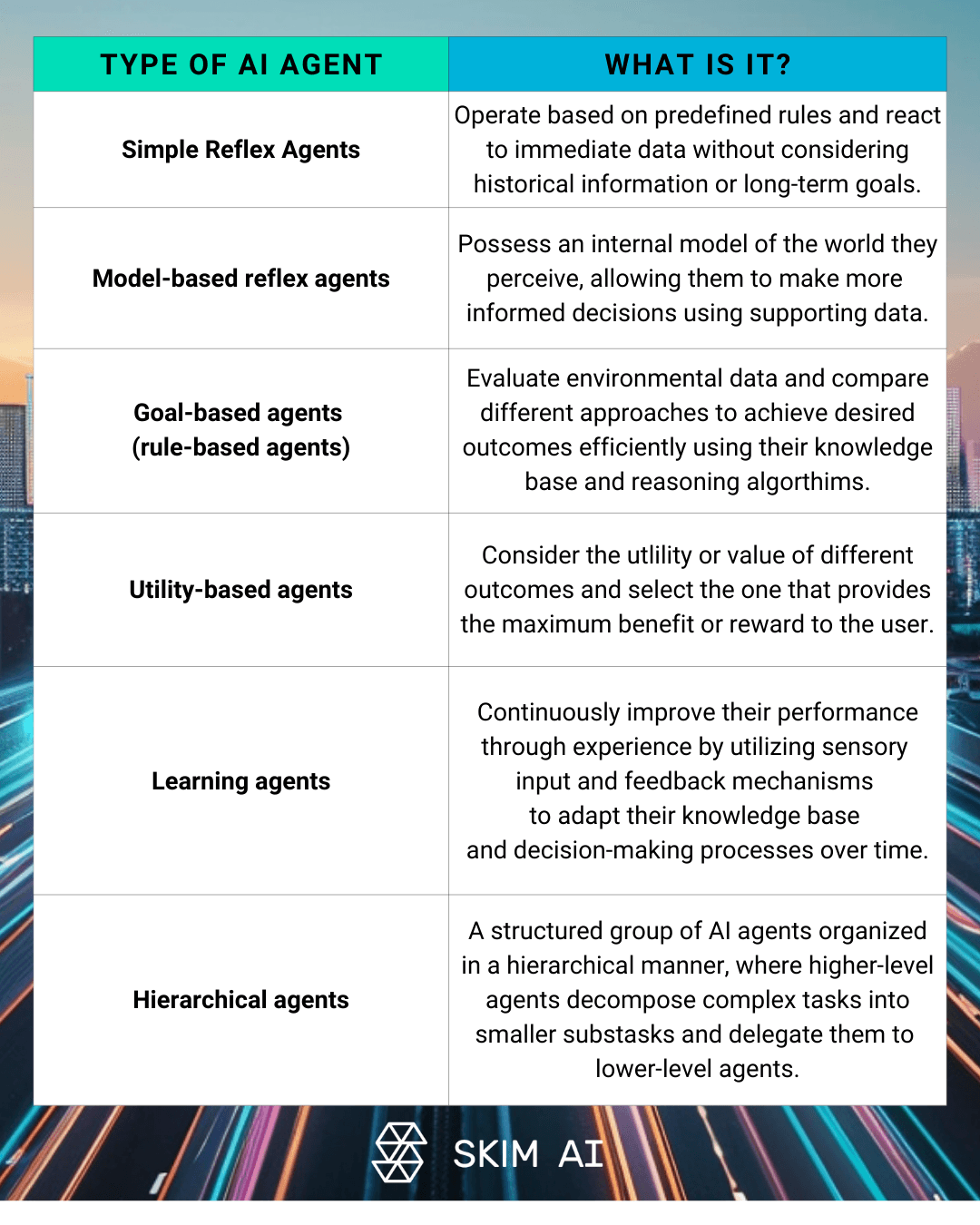

As arquitecturas LLM multi-agente envolvem múltiplos Agentes de IA trabalhar em colaboração para resolver problemas complexos. Esta abordagem pode incluir agentes especializados para diferentes aspectos de uma tarefa, estruturas hierárquicas com agentes de supervisão e trabalhadores, ou resolução colaborativa de problemas entre vários LLMs. Ao implementar estes sistemas, as organizações podem reduzir a sua dependência de modelos dispendiosos e de grande escala para cada tarefa.

As vantagens económicas do tratamento distribuído de tarefas são significativas. Os sistemas multiagentes permitem:

Atribuição optimizada de recursos com base na complexidade da tarefa

Melhoria da eficiência global do sistema e dos tempos de resposta

Redução da utilização de fichas através da implementação de modelos específicos

No entanto, para manter a eficiência de custos em sistemas multiagentes, é crucial implementar mecanismos de depuração robustos. Isto inclui o registo e a monitorização das comunicações entre agentes, a análise dos padrões de utilização de tokens para identificar trocas redundantes e a otimização da divisão do trabalho entre agentes para minimizar o consumo desnecessário de tokens.

Estratégia 8: Utilizar ferramentas de formatação de saída

A formatação adequada da saída é um fator chave na gestão de custos do LLM. Ao assegurar uma utilização eficiente dos tokens e minimizar a necessidade de processamento adicional, as empresas podem reduzir significativamente os seus custos operacionais.

Estas ferramentas oferecem capacidades poderosas para resultados de funções forçadas, permitindo aos programadores especificar formatos exactos para as respostas LLM. Esta abordagem reduz a variabilidade dos resultados e minimiza o desperdício de tokens, garantindo que o modelo gera apenas a informação necessária.

A redução da variabilidade dos resultados da LLM tem um impacto direto nos custos associados. Respostas consistentes e bem estruturadas diminuem a probabilidade de resultados malformados ou inutilizáveis, o que, por sua vez, reduz a necessidade de chamadas adicionais à API para clarificar ou reformatar a informação.

A implementação de resultados JSON pode ser particularmente eficaz em termos de eficiência. O JSON oferece uma representação compacta de dados estruturados, fácil análise e integração com vários sistemas e uso reduzido de tokens em comparação com respostas em linguagem natural. Ao tirar partido destas ferramentas de formatação de resultados, as empresas podem simplificar os seus fluxos de trabalho LLM e otimizar a utilização de tokens.

Estratégia 9: Integrar ferramentas não-LLM

Embora os LLM sejam poderosos, nem sempre são a solução mais económica para todas as tarefas. A integração de soluções nãoFerramentas LLM nos seus fluxos de trabalho pode reduzir significativamente os custos operacionais, mantendo ao mesmo tempo resultados de alta qualidade.

A incorporação de scripts Python para lidar com tarefas específicas que não requerem todas as capacidades de um LLM pode levar a economias substanciais de custos. Por exemplo, o processamento simples de dados ou a tomada de decisões com base em regras podem, muitas vezes, ser tratados de forma mais eficiente por abordagens de programação tradicionais.

Ao equilibrar LLM e ferramentas tradicionais em fluxos de trabalho, considere a complexidade da tarefa, a precisão necessária e a potencial economia de custos. Uma abordagem híbrida que aproveita os pontos fortes das LLMs e das ferramentas convencionais geralmente produz os melhores resultados em termos de desempenho e eficiência de custos.

É fundamental efetuar uma análise exaustiva dos custos e benefícios das abordagens híbridas. Esta análise deve ter em conta factores como:

Custos de desenvolvimento e manutenção de ferramentas personalizadas

Tempo de processamento e requisitos de recursos

Exatidão e fiabilidade dos resultados

Escalabilidade e flexibilidade a longo prazo

Estratégia 10: Auditoria e otimização regulares

O estabelecimento de técnicas de gestão de custos da Gestão de Custos de LLM é um processo contínuo que requer vigilância e otimização constantes. A auditoria regular da utilização e dos custos da Gestão de Custos de LLM é crucial para identificar ineficiências e implementar melhorias para o controlo de custos.

A importância da gestão e redução contínuas dos custos não pode ser exagerada. À medida que as suas aplicações de LLM evoluem e escalam, surgem novos desafios e oportunidades de otimização. Ao monitorizar e analisar consistentemente a sua utilização do LLM, pode antecipar-se a potenciais derrapagens de custos e garantir que os seus investimentos em IA proporcionam o máximo valor.

Para identificar tokens desperdiçados, implemente ferramentas robustas de rastreio e análise. Procure padrões de consultas redundantes, janelas de contexto excessivas ou concepções ineficazes de avisos. Utilize estes dados para aperfeiçoar as suas estratégias de LLM e eliminar o consumo desnecessário de tokens.

Finalmente, a promoção de uma cultura de consciência de custos dentro da sua organização é a chave para o sucesso a longo prazo na gestão eficiente dos recursos do LLM. Incentive as equipas a considerar as implicações de custo da sua utilização do LLM e a procurar ativamente oportunidades de otimização e controlo de despesas. Ao tornar a eficiência de custos uma responsabilidade partilhada, pode garantir que a sua empresa colhe todos os benefícios da tecnologia LLM, mantendo as despesas sob controlo.

A linha de fundo

À medida que os modelos linguísticos de grande dimensão continuam a ter impacto nas aplicações empresariais de IA, o domínio da gestão de custos de LLM torna-se crucial para o sucesso a longo prazo. Ao implementar as dez estratégias descritas neste artigo, desde a seleção inteligente de modelos até à auditoria e otimização regulares, a sua organização pode reduzir significativamente os custos de LLM, mantendo ou mesmo melhorando o desempenho. Lembre-se que a gestão eficaz dos custos é um processo contínuo que requer monitorização, análise e adaptação contínuas. Ao promover uma cultura de consciencialização dos custos e ao utilizar as ferramentas e técnicas certas, pode aproveitar todo o potencial dos LLMs, mantendo os custos operacionais sob controlo, garantindo que os seus investimentos em IA proporcionam o máximo valor à sua empresa.

Não hesite em contactar-nos para saber mais sobre LLM cost management.