Como construir a pilha LLM das suas empresas: Nossa pilha de 4 ferramentas + estrutura

Os modelos de linguagem de grande porte (LLMs) surgiram como uma chave para a construção de aplicações empresariais inteligentes. No entanto, o aproveitamento do poder desses modelos de linguagem requer uma pilha de aplicativos LLM robusta e eficiente. Na Skim AI, a nossa pilha de aplicações LLM permite-nos criar aplicações poderosas com capacidades avançadas de interação com a linguagem natural. A nossa pilha inclui ferramentas e estruturas cuidadosamente seleccionadas, como APIs LLM, LangChain e bases de dados vectoriais.

Com este conjunto de tecnologias, os programadores podem integrar dados específicos do domínio, afinar modelos, criar pipelines de dados eficientes para recuperar dados contextuais e muito mais. Isto permite que as empresas criem aplicações que compreendam e respondam às consultas dos utilizadores com uma precisão e uma consciência do contexto sem precedentes. Ao mesmo tempo, uma das principais técnicas para acompanhar esta pilha é utilizar ferramentas e estruturas existentes fornecidas pelos vários componentes. Isto permite que os programadores se concentrem na criação de aplicações em vez de criarem ferramentas de raiz, poupando tempo e esforço valiosos.

Uma API LLM como GPT, Claude, Llama ou Mistral

No centro da sua pilha de aplicações LLM deve estar uma API LLM. As APIs LLM fornecem uma forma de integrar modelos de linguagem poderosos nas suas aplicações sem a necessidade de treinar ou alojar os modelos. Funcionam como uma ponte entre o seu software e os algoritmos complexos que alimentam os modelos de linguagem, permitindo-lhe adicionar capacidades avançadas de processamento de linguagem natural às suas aplicações com um esforço mínimo.

Uma das principais vantagens da utilização de uma API LLM é a capacidade de aproveitar modelos linguísticos de última geração que foram treinados em grandes quantidades de dados. Estes modelos, como o GPT, Claude, Mistrale LhamaOs modelos de análise de sentimentos e de resposta a perguntas são capazes de compreender e gerar texto semelhante ao humano com precisão e fluência notáveis. Ao efetuar chamadas de API para estes modelos, pode adicionar rapidamente uma vasta gama de capacidades, incluindo geração de texto, análise de sentimentos, resposta a perguntas e muito mais às suas aplicações.

Factores a considerar na escolha de um LLM API

Ao escolher uma API LLM para a sua pilha, há vários factores a considerar:

Desempenho e precisão: Certifique-se de que a API pode lidar com o seu volume de trabalho e fornecer resultados fiáveis.

Personalização e flexibilidade: Pense se precisa de afinar o modelo para o seu caso de utilização específico ou de o integrar noutros componentes da sua pilha.

Escalabilidade: Se prevê grandes volumes de pedidos, certifique-se de que a API pode ser dimensionada em conformidade.

Apoio e comunidade: Avalie o nível de apoio e a dimensão da comunidade em torno da API, uma vez que isso pode afetar a viabilidade a longo prazo da sua aplicação.

Para fazer uso efetivo de uma API LLM, é importante entender seus principais componentes e capacidades. No centro da maioria das APIs LLM estão redes neurais profundas, normalmente baseadas em arquitecturas de transformadores, que são treinadas em grandes quantidades de dados de texto. Estes modelos são acedidos através de uma interface API, que trata de tarefas como a autenticação, o encaminhamento de pedidos e a formatação de respostas. As APIs LLM também costumam incluir componentes adicionais para processamento de dados, como tokenização e normalização, bem como ferramentas para ajuste fino e personalização.

Ao integrar uma API LLM à sua pilha de aplicativos, é importante considerar fatores como privacidade e segurança de dados. Dependendo do seu caso de uso, pode ser necessário garantir que dados confidenciais não sejam enviados ao provedor de API ou usados para treinamento de modelos. Também é necessário avaliar cuidadosamente a estrutura de custos da API, pois os preços baseados no uso podem aumentar rapidamente para aplicativos de alto volume.

Apesar destes desafios, os benefícios da utilização de uma API LLM são claros. Ao fornecer uma forma simples e flexível de integrar capacidades linguísticas avançadas nas suas aplicações, as APIs LLM podem ajudá-lo a criar software mais envolvente, inteligente e fácil de utilizar. Quer esteja a construir um chatbot, uma ferramenta de criação de conteúdos ou um sistema de gestão de conhecimentos, uma API LLM é uma adição crucial à sua pilha de aplicações empresariais.

LangChain

Depois de selecionar uma API LLM para a sua pilha de aplicações LLM, o próximo componente a considerar é LangChain. LangChain é uma estrutura poderosa projetada para simplificar o processo de construção de aplicativos em cima de grandes modelos de linguagem. Ele fornece uma interface padronizada para interagir com várias APIs LLM, facilitando a integração delas na sua pilha de tecnologia LLM.

Uma das principais vantagens da utilização do LangChain é a sua arquitetura modular. A LangChain é composta por vários componentes, como prompts, cadeias, agentes e memória, que podem ser combinados para criar fluxos de trabalho complexos. Esta modularidade permite-lhe criar aplicações que podem lidar com uma vasta gama de tarefas, desde a simples resposta a perguntas até casos de utilização mais avançados, como a geração de conteúdos e a análise de dados, permitindo a interação em linguagem natural com os dados específicos do seu domínio.

Várias ferramentas e suporte do LangChain

A LangChain também fornece uma variedade de ferramentas e utilitários que simplificam o trabalho com LLMs. Por exemplo, oferece ferramentas para trabalhar com embeddings, que são representações numéricas de texto usadas para tarefas como pesquisa semântica e agrupamento. Além disso, o LangChain inclui utilitários para gerir prompts, que são as cadeias de entrada utilizadas para orientar o comportamento dos modelos de linguagem.

Outra caraterística crucial do LangChain é o seu suporte para bases de dados vectoriais. Ao integrar-se com bases de dados vectoriais como a Chroma (que é a que usamos), a LangChain permite-lhe criar aplicações que podem armazenar e recuperar eficientemente grandes quantidades de dados. Esta integração permite-lhe criar aplicações de conhecimento intensivo que podem recorrer a uma vasta gama de fontes de informação, melhorando a recuperação de dados contextuais para a sua pilha de aplicações LLM.

A LangChain também possui uma comunidade ativa de programadores e utilizadores que contribuem para o seu desenvolvimento contínuo. Esta comunidade oferece uma grande quantidade de recursos, incluindo documentação, tutoriais e componentes pré-construídos que podem acelerar o desenvolvimento de aplicações com LLM. Além disso, o LangChain é compatível com modelos de código aberto, tornando-o uma ferramenta versátil para sua pilha de tecnologia LLM.

A LangChain é um componente vital de qualquer empresa LLM pilha de aplicações. O seu design modular, ferramentas poderosas e comunidade ativa fazem dela uma ferramenta indispensável para a criação de aplicações sofisticadas baseadas em linguagem. Ao utilizar a LangChain em conjunto com uma API LLM e outros componentes, como bases de dados vectoriais, pode criar aplicações empresariais que compreendem e geram linguagem humana com uma precisão e fluência inigualáveis, permitindo uma interação perfeita em linguagem natural com os seus dados privados e informações específicas do domínio.

Uma base de dados vetorial como Chroma

Para além de uma API LLM e LangChain, outro componente essencial da sua pilha de aplicações LLM é uma base de dados vetorial. As bases de dados vectoriais são armazenamentos de dados especializados optimizados para armazenar e pesquisar vectores de alta dimensão, tais como embeddings gerados por grandes modelos de linguagem. Ao integrar uma base de dados vetorial na sua pilha de tecnologia LLM, pode permitir a recuperação rápida e eficiente de dados relevantes com base na semelhança semântica.

Croma é uma escolha popular de código aberto para um banco de dados vetorial em pilhas de aplicativos LLM, e nós o usamos aqui no Skim AI. Ele foi projetado para funcionar perfeitamente com o LangChain e outros componentes da sua pilha, fornecendo uma solução robusta e escalável para armazenar e recuperar embeddings.

Uma das principais vantagens da utilização do Chroma é a sua capacidade de tratar eficientemente grandes volumes de dados. O Chroma utiliza técnicas de indexação avançadas para permitir uma pesquisa rápida por semelhança, mesmo em conjuntos de dados maciços. Isto torna-o uma escolha ideal para aplicações que necessitam de armazenar e pesquisar grandes quantidades de dados textuais, tais como repositórios de documentos, bases de conhecimento e sistemas de gestão de conteúdos.

Outra vantagem do Chroma é a sua flexibilidade e facilidade de utilização. O Chroma fornece uma API simples e intuitiva para armazenar e recuperar embeddings, facilitando a integração na sua pilha de aplicações LLM. Também suporta várias métricas de semelhança, como a semelhança de cosseno e a distância euclidiana, permitindo-lhe escolher a métrica mais adequada para o seu caso de utilização específico.

O Chroma também oferece funcionalidades avançadas, como filtragem e suporte de metadados. Pode armazenar metadados adicionais juntamente com as suas incorporações, tais como IDs de documentos, carimbos de data/hora ou atributos personalizados. Estes metadados podem ser utilizados para filtrar os resultados da pesquisa, permitindo uma recuperação mais precisa e direccionada dos dados contextuais.

Integração do Chroma na pilha LLM da sua empresa

A integração do Chroma na sua pilha de aplicações LLM é simples, graças à sua compatibilidade com o LangChain e outras ferramentas e estruturas populares. O LangChain fornece suporte integrado para o Chroma, facilitando o armazenamento e a recuperação de embeddings gerados pelos seus modelos de linguagem. Esta integração permite-lhe criar poderosos mecanismos de recuperação que podem rapidamente fazer emergir informações relevantes com base na interação com a linguagem natural.

A utilização de uma base de dados vetorial como a Chroma em conjunto com LLMs abre novas possibilidades para a criação de aplicações inteligentes e sensíveis ao contexto. Tirando partido do poder dos embeddings e da pesquisa por semelhança, é possível criar aplicações capazes de compreender e responder às consultas dos utilizadores com uma precisão e relevância sem precedentes. Isto é particularmente valioso para domínios como o apoio ao cliente, a recomendação de conteúdos e a gestão de conhecimentos, em que é fundamental apresentar a informação certa no momento certo.

Quando combinado com o LangChain e uma API LLM, o Chroma constitui uma base poderosa para a criação de aplicações inteligentes e orientadas para os dados que podem transformar a forma como interagimos com dados empresariais e informações específicas do domínio.

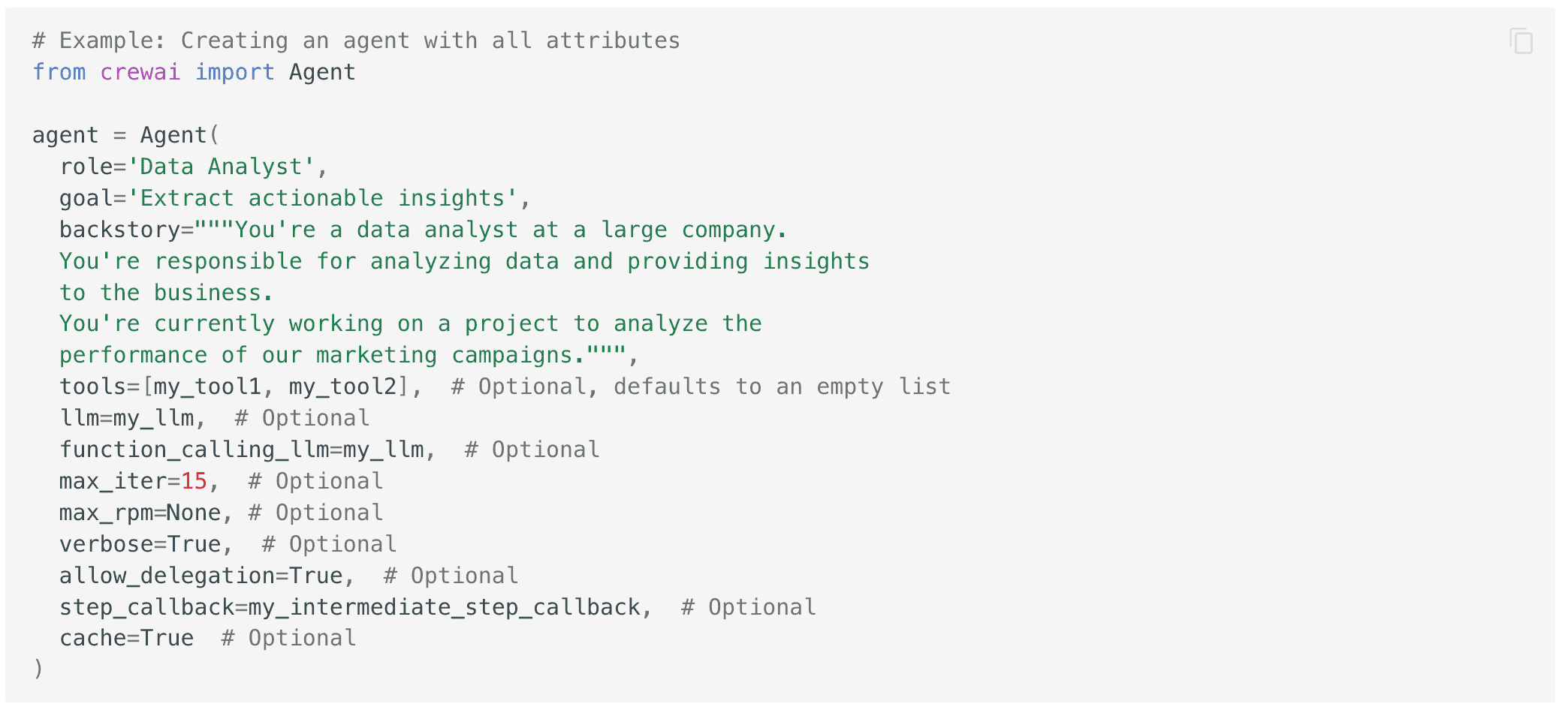

crewAI para sistemas multiagentes

tripulaçãoAI é outra ferramenta poderosa que pode ser adicionada à sua pilha de aplicações LLM para melhorar as capacidades das suas aplicações. crewAI é uma estrutura que permite criar sistemas multi-agentes, onde vários agentes de IA trabalham em conjunto para realizar tarefas complexas. Ao integrar o crewAI na sua pilha, pode criar aplicações que podem lidar com fluxos de trabalho e processos de tomada de decisão mais sofisticados, melhorando ainda mais as capacidades de interação de linguagem natural da sua pilha de aplicações LLM empresariais.

Na sua essência, o crewAI foi concebido para facilitar a colaboração entre vários agentes de IA, cada um com a sua função e conhecimentos específicos. Estes agentes podem comunicar e coordenar-se entre si para dividir problemas complexos em subtarefas mais pequenas e mais fáceis de gerir. Esta abordagem permite-lhe criar aplicações que podem enfrentar uma vasta gama de desafios do mundo real, desde o apoio ao cliente e a criação de conteúdos até à análise de dados e ao apoio à decisão, tudo isto tirando partido do poder dos grandes modelos linguísticos.

Aproveitar o poder da especialização

Uma das principais vantagens da utilização da crewAI na sua pilha de tecnologia LLM é a sua capacidade de alavancar o poder da especialização. Ao atribuir funções e tarefas específicas a diferentes agentes, pode criar um sistema que é mais eficiente e eficaz do que um modelo de IA único e monolítico. Cada agente pode ser treinado e optimizado para a sua tarefa específica, o que lhe permite ter um desempenho superior ao de um modelo de uso geral e permite uma recuperação mais direccionada dos dados contextuais dos conjuntos de dados específicos do seu domínio.

O crewAI também fornece uma arquitetura flexível e extensível que permite integrar facilmente diferentes tipos de agentes no seu sistema. Isso inclui agentes baseados em modelos de linguagem, bem como agentes que usam outras técnicas de IA, como visão computacional, reconhecimento de fala ou aprendizado por reforço. Ao combinar estes diferentes tipos de agentes, pode criar aplicações que podem perceber, compreender e interagir com o mundo de formas mais naturais e intuitivas, melhorando ainda mais as capacidades de interação de linguagem natural da sua pilha de aplicações LLM.

A integração do crewAI à sua pilha de aplicativos LLM é facilitada por sua compatibilidade com outras ferramentas e estruturas populares, como LangChain e bancos de dados vetoriais. Isso permite criar fluxos de trabalho de ponta a ponta que podem lidar com tarefas desde a ingestão e o processamento de dados até a interação de linguagem natural e a tomada de decisões, tudo isso aproveitando o poder de modelos e estruturas de código aberto.

A utilização da crewAI em combinação com outros componentes da sua pilha de tecnologia LLM pode ajudá-lo a desbloquear novas possibilidades para a criação de sistemas inteligentes e multiagentes que podem lidar com tarefas complexas do mundo real. Ao tirar partido do poder da especialização e da colaboração, pode criar aplicações mais eficientes, eficazes e fáceis de utilizar do que as abordagens tradicionais de modelo único.

Libertar o poder dos LLMs com a pilha de aplicações correcta

A criação de aplicações inteligentes e sensíveis ao contexto que aproveitam o poder de grandes modelos de linguagem requer uma pilha de aplicações LLM bem concebida. Ao combinar ferramentas poderosas como APIs LLM, LangChain, bancos de dados vetoriais como Chroma e estruturas multiagentes como crewAI, é possível criar fluxos de trabalho incrivelmente poderosos e valiosos.

Esta pilha permite-lhe integrar perfeitamente dados específicos de um domínio, permitir a recuperação eficiente de informações contextuais e criar fluxos de trabalho sofisticados que podem enfrentar desafios complexos do mundo real. Ao tirar partido do poder destas ferramentas e estruturas, pode ultrapassar os limites do que é possível com aplicações de IA baseadas em linguagem e criar sistemas verdadeiramente inteligentes que podem transformar a forma como a sua empresa interage com os dados e a tecnologia.