企業のLLMスタックを構築する方法:4ツールスタック+フレームワーク

大規模言語モデル(LLM)は、インテリジェントなエンタープライズ・アプリケーションを構築する鍵として浮上してきた。しかし、これらの言語モデルのパワーを活用するには、堅牢で効率的なLLMアプリケーションスタックが必要です。Skim AIでは、当社のLLMアプリケーションスタックにより、高度な自然言語対話機能を備えた強力なアプリケーションを作成することができます。私たちのスタックは、LLM API、LangChain、ベクトルデータベースなど、厳選されたツールとフレームワークで構成されています。

このような技術スタックにより、開発者は以下のことをシームレスに行うことができます。 統合 ドメイン固有のデータ、モデルの微調整、コンテキスト・データを取得するための効率的なデータ・パイプラインの作成など。これによって企業は、かつてない精度とコンテキスト認識でユーザーのクエリを理解し、それに応答するアプリケーションを構築できるようになる。同時に、このスタックに沿った主なテクニックの1つは、様々なコンポーネントが提供する既存のツールやフレームワークを活用することだ。これにより、開発者はゼロからツールを作成するのではなく、アプリケーションの構築に集中することができ、貴重な時間と労力を節約することができる。

GPT、クロード、ラマ、ミストラルのようなLLM API

LLMアプリケーション・スタックの中核には、LLM APIが必要です。LLM APIは、強力な言語モデルをアプリケーションに統合する方法を提供します。LLM APIは、あなたのソフトウェアと言語モデルを動かす複雑なアルゴリズムとの橋渡しをし、最小限の労力であなたのアプリケーションに高度な自然言語処理機能を追加することを可能にします。

LLM APIを使用する主な利点のひとつは、膨大な量のデータで訓練された最先端の言語モデルを活用できることだ。これらのモデルは、GPT、 クロード, ミストラルそして ラマこれらのモデルは、驚くべき精度と流暢さで人間のようなテキストを理解し、生成することができます。これらのモデルにAPIコールを行うことで、テキスト生成、感情分析、質問応答など、幅広い機能をアプリケーションに素早く追加することができます。

LLM APIを選択する際に考慮すべき要素

あなたのスタックにLLM APIを選択する場合、考慮すべきいくつかの要因があります:

パフォーマンスと精度: APIがワークロードを処理し、信頼できる結果を提供できることを確認する。

カスタマイズと柔軟性: 特定のユースケースに合わせてモデルを微調整する必要があるか、スタックの他のコンポーネントと統合する必要があるかを検討する。

スケーラビリティ: 大量のリクエストが予想される場合は、APIがそれに応じてスケールできることを確認すること。

サポートとコミュニティ: アプリケーションの長期的な実行可能性に影響を与える可能性があるため、API周りのサポートのレベルとコミュニティの規模を評価する。

LLM APIを効果的に利用するには、その主要なコンポーネントと機能を理解することが重要だ。ほとんどのLLM APIの中核にあるのは、一般的にトランスフォーマーアーキテクチャに基づくディープニューラルネットワークで、大量のテキストデータで学習される。これらのモデルはAPIインターフェースを介してアクセスされ、認証、リクエストルーティング、レスポンスのフォーマットなどのタスクを処理する。LLM APIには、トークン化や正規化といったデータ処理のための追加コンポーネントや、微調整やカスタマイズのためのツールも含まれていることが多い。

アプリケーションスタックにLLM APIを統合する場合、データプライバシーやセキュリティといった要素を考慮することが重要です。ユースケースによっては、機密データがAPIプロバイダーに送信されないようにしたり、モデルのトレーニングに使用されないようにする必要があるかもしれない。また、API のコスト構造も慎重に評価する必要がある。使用量に応じた価格設定は、大量のアプリケーションではすぐに膨れ上がる可能性があるからだ。

このような課題はありますが、LLM APIを使用するメリットは明らかです。高度な言語機能をアプリケーションに統合するシンプルで柔軟な方法を提供することで、LLM APIは、より魅力的でインテリジェントな、ユーザーフレンドリーなソフトウェアを作成するのに役立ちます。チャットボット、コンテンツ作成ツール、ナレッジ管理システムのいずれを構築する場合でも、LLM APIはエンタープライズ・アプリケーション・スタックに不可欠な追加機能です。

ラングチェーン

LLMアプリケーションスタック用にLLM APIを選択した後、次に考慮すべき要素は以下の通りです。 ラングチェーン.LangChainは、大規模な言語モデルの上にアプリケーションを構築するプロセスを簡素化するために設計された強力なフレームワークです。様々なLLM APIと対話するための標準化されたインタフェースを提供し、LLM技術スタックへの統合を容易にします。

LangChainを使う主な利点の一つは、そのモジュラーアーキテクチャです。LangChainはプロンプト、チェーン、エージェント、メモリなど複数のコンポーネントで構成されており、これらを組み合わせることで複雑なワークフローを作成することができます。このモジュール性により、単純な質問応答からコンテンツ生成やデータ分析のような高度なユースケースまで、幅広いタスクを処理できるアプリケーションを構築することができ、ドメイン固有のデータとの自然言語インタラクションを可能にします。

LangChainの各種ツールとサポート

LangChainはまた、LLMでの作業を効率化する様々なツールやユーティリティも提供している。例えば、意味検索やクラスタリングなどのタスクに使われるテキストの数値表現であるエンベッディングを扱うためのツールを提供します。さらにLangChainには、言語モデルの動作をガイドするための入力文字列であるプロンプトを管理するユーティリティも含まれている。

LangChainのもう一つの重要な特徴は、ベクターデータベースのサポートです。LangChainはChromaのようなベクターデータベースと統合することで、大量のデータを効率的に保存・検索できるアプリケーションを構築できます。この統合により、様々な情報ソースを利用できる知識集約型アプリケーションを作成することができ、LLMアプリケーションスタックのコンテキストデータの検索を強化することができます。

LangChainはまた、その継続的な開発に貢献する開発者とユーザの活発なコミュニティを誇っています。このコミュニティは、ドキュメント、チュートリアル、LLMアプリケーションの開発を加速させるビルド済みコンポーネントなど、豊富なリソースを提供しています。さらに、LangChainはオープンソースモデルと互換性があり、LLM技術スタックのための多用途ツールとなっています。

LangChainは、どのような企業にとっても不可欠なコンポーネントです。 企業LLM アプリケーション・スタックである。そのモジュール設計、強力なツール、活発なコミュニティは、洗練された言語ベースのアプリケーションを構築するために不可欠なツールとなっています。LangChainをLLM APIやベクターデータベースなどの他のコンポーネントと一緒に活用することで、比類のない精度と流暢さで人間の言語を理解し生成するエンタープライズアプリケーションを作成することができ、プライベートデータやドメイン固有の情報とのシームレスな自然言語インタラクションを可能にします。

Chromaのようなベクターデータベース

LLM APIとLangChainに加えて、LLMアプリスタックに不可欠なもう一つのコンポーネントはベクターデータベースです。ベクターデータベースは、大規模な言語モデルによって生成されたエンベッディングのような、高次元ベクターの保存と検索に最適化された特殊なデータストアです。ベクターデータベースをLLM技術スタックに統合することで、意味的類似性に基づく関連データの高速で効率的な検索が可能になります。

クロマ は、LLMアプリケーションスタックのベクトルデータベースとして人気のあるオープンソースの選択肢であり、ここSkim AIでも使用しています。LangChainやスタックの他のコンポーネントとシームレスに動作するように設計されており、エンベッディングの保存と取得のための堅牢でスケーラブルなソリューションを提供します。

Chromaを使用する主な利点の一つは、大量のデータを効率的に処理できることです。Chromaは高度なインデックス作成技術により、膨大なデータセットでも高速な類似検索を可能にします。そのため、ドキュメントリポジトリ、ナレッジベース、コンテンツ管理システムなど、大量のテキストデータを保存し、検索する必要があるアプリケーションに最適です。

Chromaのもう一つの利点は、その柔軟性と使いやすさです。Chromaは、エンベッディングの保存と取得のためのシンプルで直感的なAPIを提供し、LLMアプリケーションスタックへの統合を容易にします。また、コサイン類似度やユークリッド距離などの様々な類似度メトリックをサポートしており、特定のユースケースに最適なメトリックを選択することができます。

Chromaは、フィルタリングやメタデータサポートなどの高度な機能も提供します。ドキュメントID、タイムスタンプ、カスタム属性などのメタデータを埋め込むことができます。このメタデータを検索結果のフィルタリングに使用することで、より正確で的を絞った文脈データの検索が可能になります。

エンタープライズLLMスタックへのChromaの統合

Chromaは、LangChainや他の一般的なツールやフレームワークと互換性があるため、LLMアプリケーションスタックに統合するのは簡単です。LangChainはChromaのビルトインサポートを提供しており、言語モデルによって生成されたエンベッディングの保存と取得が簡単にできます。この統合により、自然言語とのインタラクションに基づいて関連情報を素早く表示できる強力な検索メカニズムを構築できます。

ChromaのようなベクターデータベースをLLMと組み合わせて使用することで、インテリジェントでコンテキストを意識したアプリケーションを構築するための新たな可能性が開けます。エンベッディングと類似検索のパワーを活用することで、これまでにない精度と関連性でユーザのクエリを理解し、それに応答できるアプリケーションを作成することができます。これは、適切な情報を適切なタイミングで提供することが重要な、カスタマーサポート、コンテンツ推薦、ナレッジマネジメントのような領域で特に価値があります。

Chromaは、LangChainやLLM APIと組み合わせることで、インテリジェントなデータ駆動型アプリケーションを構築するための強力な基盤を形成します。

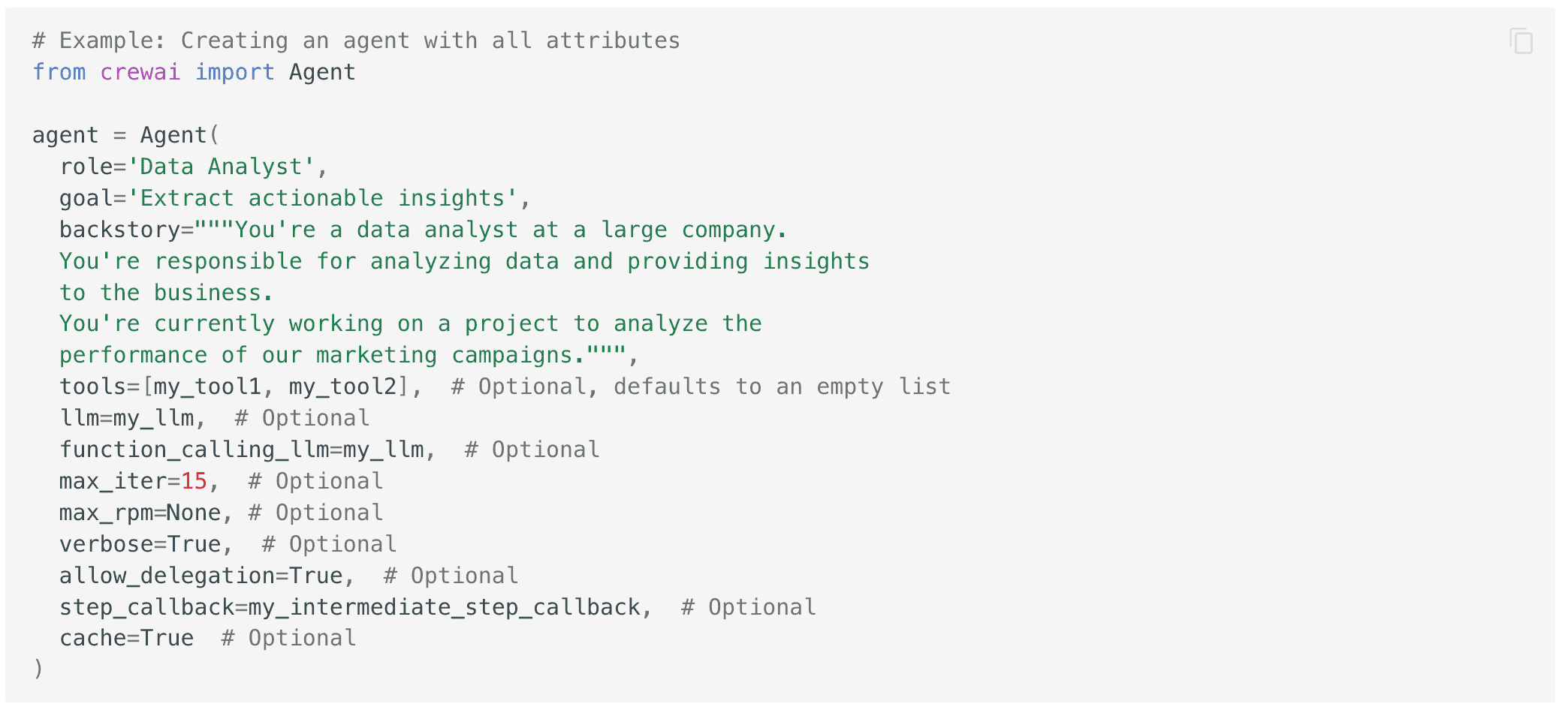

マルチエージェント・システムのためのcrewAI

クルーAI crewAIは、複数のAIエージェントが協力して複雑なタスクを遂行するマルチエージェントシステムを作成できるフレームワークです。crewAIをスタックに統合することで、より洗練されたワークフローや意思決定プロセスを扱うことができるアプリケーションを構築することができ、エンタープライズLLMアプリケーションスタックの自然言語対話機能をさらに強化することができます。

crewAIは、それぞれが特定の役割と専門知識を持つ複数のAIエージェント間のコラボレーションを促進するように設計されています。これらのエージェントは、複雑な問題をより小さく、より管理しやすいサブタスクに分解するために、相互に通信し、調整することができます。このアプローチにより、大規模な言語モデルのパワーを活用しながら、カスタマーサポートやコンテンツ作成からデータ分析や意思決定支援まで、実世界のさまざまな課題に取り組むことができるアプリケーションを作成することができます。

専門化の力を活用する

LLM技術スタックでcrewAIを使用する主な利点の1つは、特殊化の力を活用できることです。異なるエージェントに特定の役割やタスクを割り当てることで、単一のモノリシックなAIモデルよりも効率的で効果的なシステムを作ることができます。各エージェントは、その特定のタスクのために訓練され最適化されるため、汎用モデルよりも高いレベルで実行することができ、ドメイン固有のデータセットから、より的を絞った文脈データの検索が可能になります。

crewAIはまた、柔軟で拡張可能なアーキテクチャを提供しており、様々なタイプのエージェントを簡単にシステムに統合することができます。これには、言語モデルに基づくエージェントや、コンピュータビジョン、音声認識、強化学習などの他のAI技術を使用するエージェントが含まれます。これらの異なるタイプのエージェントを組み合わせることで、より自然で直感的な方法で世界を知覚、理解、対話できるアプリケーションを作成し、LLMアプリケーションスタックの自然言語対話機能をさらに強化することができます。

あなたのLLMアプリスタックにcrewAIを統合することは、LangChainやベクトルデータベースなどの他の一般的なツールやフレームワークとの互換性によって容易になります。これにより、オープンソースのモデルとフレームワークのパワーを活用しながら、データの取り込みと処理から自然言語対話と意思決定までのタスクを処理できるエンドツーエンドのワークフローを作成できます。

crewAIをLLM技術スタックの他のコンポーネントと組み合わせて使用することで、実世界の複雑なタスクを処理できるインテリジェントなマルチエージェントシステムを構築するための新しい可能性を引き出すことができます。専門性とコラボレーションの力を活用することで、従来の単一モデルのアプローチよりも効率的で効果的でユーザーフレンドリーなアプリケーションを作成できます。

適切なアプリケーション・スタックでLLMの力を引き出す

大規模な言語モデルのパワーを活用したインテリジェントでコンテキストを意識したアプリケーションの構築には、よく設計されたLLMアプリケーションスタックが必要です。LLM API、LangChain、Chromaのようなベクトルデータベース、crewAIのようなマルチエージェントフレームワークのような強力なツールを組み合わせることで、信じられないほど強力で価値のあるワークフローを作成することができます。

このスタックにより、ドメイン固有のデータをシームレスに統合し、コンテキスト情報の効率的な検索を可能にし、複雑な現実世界の課題に取り組むことができる洗練されたワークフローを構築することができます。これらのツールとフレームワークのパワーを活用することで、言語ベースのAIアプリケーションで可能なことの限界を押し広げ、真にインテリジェントなシステムを構築することができます。