Le 10 migliori tecniche di prompting LLM per massimizzare le prestazioni dell'IA

L'arte di creare suggerimenti efficaci per i modelli linguistici di grandi dimensioni (LLM) è diventata un'abilità cruciale per i professionisti dell'intelligenza artificiale. I suggerimenti ben progettati possono migliorare significativamente le prestazioni di un LLM, consentendo di ottenere risultati più accurati, pertinenti e creativi. Questo blog post esplora dieci delle più potenti tecniche di prompt, offrendo approfondimenti sulle loro applicazioni e sulle migliori pratiche. Che siate sviluppatori di IA esperti o alle prime armi con gli LLM, queste tecniche vi aiuteranno a sbloccare il pieno potenziale dei modelli di IA.

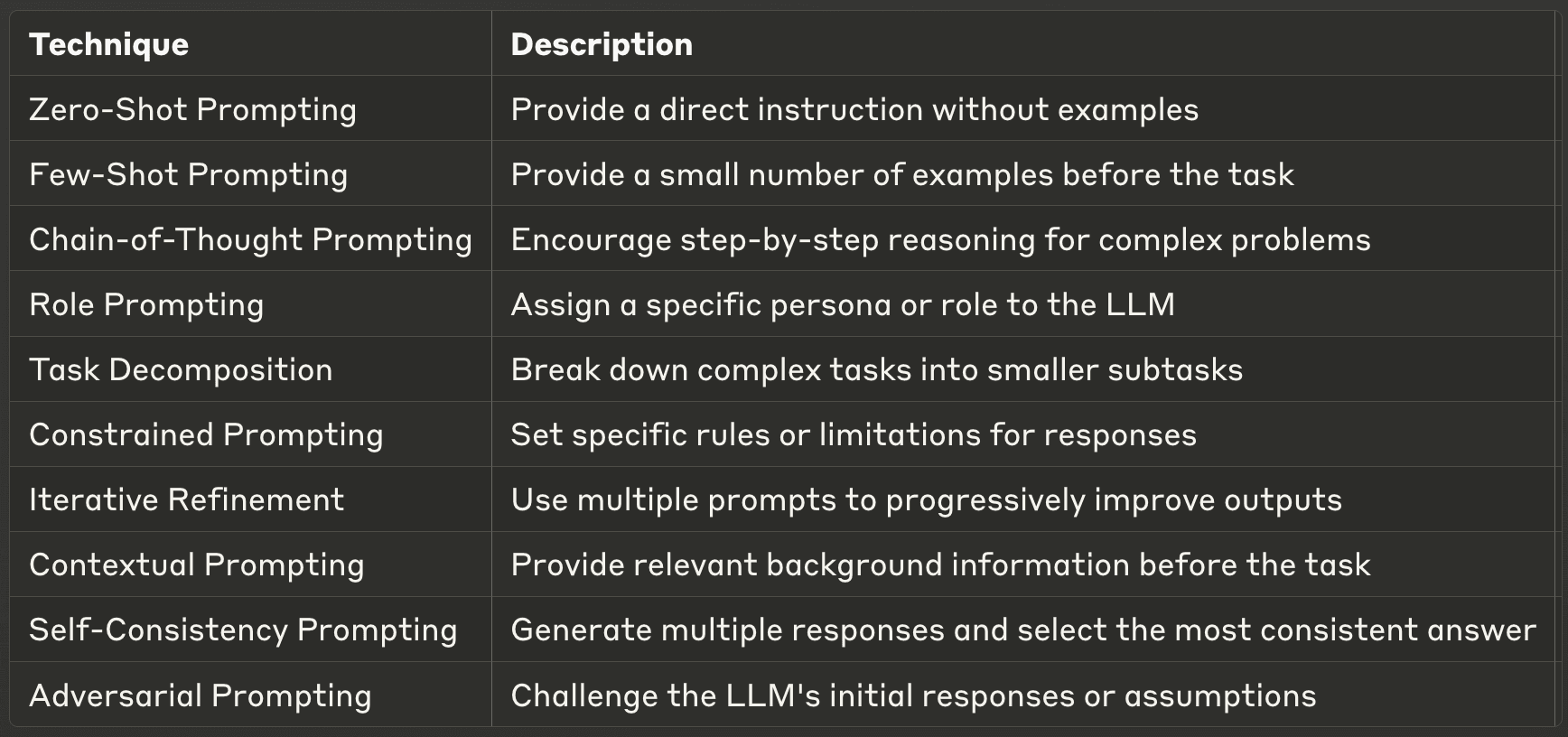

- 1. Prompt a colpo zero

- 2. Prompt a pochi colpi

- 3. Prompt a catena di pensiero (CoT)

- 4. Prompting di ruolo

- 5. Decomposizione dei compiti

- 6. Prompting vincolato

- 7. Raffinamento iterativo

- 8. Prompting contestuale

- 9. Prompt di autocoerenza

- 10. Prompting avversariale

- Trovare le giuste tecniche di ingegneria del prompt

1. Prompt a colpo zero

Il prompt a colpo zero è il modo più semplice per interagire con un LLM. In questa tecnica, si fornisce un'istruzione o una domanda diretta senza alcun esempio, affidandosi alle conoscenze pre-addestrate del modello per generare una risposta. Questo metodo mette alla prova la capacità del LLM di comprendere ed eseguire compiti basati esclusivamente sulla richiesta data, senza ulteriori contesti o esempi.

Il prompt a colpo zero è particolarmente utile per compiti semplici e diretti o per domande di conoscenza generale. È un modo eccellente per valutare le capacità di base di un LLM e può essere sorprendentemente efficace per un'ampia gamma di applicazioni. Tuttavia, la sua efficacia può variare a seconda della complessità del compito e dell'allineamento con i dati di addestramento del modello. Quando si usa il prompt a colpo zero, è fondamentale essere chiari e specifici nelle istruzioni per ottenere i migliori risultati.

Esempio: Quando si usa il prompt a colpo zero, si può semplicemente chiedere al LLM: "Spiega il concetto di fotosintesi in termini semplici". Il modello genererà una spiegazione basata sulle sue conoscenze preesistenti, senza fornire alcun contesto o esempio aggiuntivo.

2. Prompt a pochi colpi

Il prompt a pochi colpi fa un ulteriore passo avanti nell'interazione con i LLM, fornendo un piccolo numero di esempi prima di chiedere al modello di eseguire un compito. Questa tecnica aiuta a guidare il formato e lo stile di output del modello, dandogli essenzialmente un modello da seguire. Dimostrando la relazione desiderata tra input e output, il prompt a pochi colpi può migliorare significativamente le prestazioni del modello su compiti specifici.

Questo metodo è particolarmente efficace quando si ha bisogno di formati di output coerenti, quando si ha a che fare con compiti specifici del dominio o quando la richiesta a zero colpi produce risultati incoerenti. La richiesta di pochi colpi consente di mettere a punto il comportamento del modello senza la necessità di un addestramento o di una messa a punto approfonditi. È un modo efficace per adattare rapidamente l'LLM al vostro caso d'uso specifico. Tuttavia, è importante scegliere con cura gli esempi, perché influenzano pesantemente i risultati del modello.

Esempio: Nel caso di prompting con pochi colpi, potreste fornire al LLM un paio di esempi prima di porre la domanda principale. Per esempio:

D: Qual è la capitale della Francia? R: La capitale della Francia è Parigi.

D: Qual è la capitale del Giappone? R: La capitale del Giappone è Tokyo.

D: Qual è la capitale del Brasile? A:

Fornendo questi esempi, guidate il LLM a capire il formato e il tipo di risposta che state cercando, aumentando la probabilità di ricevere una risposta coerente e accurata.

3. Prompt a catena di pensiero (CoT)

Il prompt Chain-of-Thought è una tecnica più avanzata che incoraggia i LLM a scomporre problemi complessi in processi di ragionamento passo dopo passo. Questo metodo imita l'approccio umano alla risoluzione dei problemi, consentendo al modello di affrontare compiti più complessi che richiedono ragionamenti o calcoli in più fasi. Invitando l'LLM a mostrare il proprio lavoro, la CoT può migliorare significativamente le prestazioni su compiti complessi e fornire trasparenza nel processo decisionale del modello.

I vantaggi della richiesta di CoT vanno oltre il semplice miglioramento dell'accuratezza. Migliora anche l'interpretabilità dei risultati del modello, rendendo più facile per gli esseri umani comprendere e verificare il ragionamento alla base delle risposte. Ciò è particolarmente prezioso in campi come l'istruzione, dove la comprensione del processo di risoluzione dei problemi è importante quanto la risposta finale. Tuttavia, vale la pena notare che la richiesta di CoT può essere più impegnativa dal punto di vista computazionale e potrebbe non essere sempre necessaria per i compiti più semplici. È anche importante notare che i suggerimenti della CoT si sono dimostrati più efficaci quando si forniscono esempi molto pertinenti e specifici.

Esempio: Quando si utilizza il prompt della catena di pensiero, si può porre una domanda come questa: "Se una camicia costa $25 ed è in vendita con uno sconto di 20%, qual è il prezzo finale? Mostrate il vostro ragionamento passo dopo passo". Il LLM potrebbe rispondere con una spiegazione dettagliata:

"Affrontiamo la questione passo dopo passo:

Il prezzo originale è $25.

Uno sconto di 20% significa che dobbiamo calcolare 20% di $25.

20% di $25 è $25 × 0,20 = $5.

L'importo dello sconto è $5.

Per ottenere il prezzo finale, sottraiamo lo sconto dal prezzo originale.

$25 - $5 = $20. Pertanto, il prezzo finale della camicia è $20".

Questa risposta non solo fornisce la risposta corretta, ma dimostra anche il processo di ragionamento, rendendo più facile la verifica e la comprensione della soluzione.

4. Prompting di ruolo

Il role prompting è una tecnica creativa e potente che prevede l'assegnazione di un personaggio o di un ruolo specifico al LLM. Questo metodo può modificare drasticamente il tono, lo stile e il contenuto delle risposte del modello, consentendo di adattare i suoi risultati a esigenze o scenari specifici. Istruendo l'LLM ad assumere un ruolo particolare, è possibile accedere a diverse "personalità" o competenze all'interno della base di conoscenze del modello.

Questa tecnica è particolarmente utile quando è necessario generare contenuti con una voce o uno stile specifici, simulare la conoscenza di un esperto in un campo o creare prospettive diverse su un argomento. Il role prompting può portare a risposte più coinvolgenti e adeguate al contesto, rendendolo prezioso per la scrittura creativa, la pianificazione di scenari o le simulazioni didattiche. Tuttavia, è importante ricordare che, sebbene il LLM sia in grado di simulare ruoli diversi in modo convincente, le sue risposte si basano comunque sui dati di addestramento e non devono essere considerate come veri e propri consigli di esperti senza una verifica.

Esempio: Per quanto riguarda il ruolo, potreste istruire l'LLM come segue: "In qualità di esperto scienziato del clima, spiega i potenziali effetti a lungo termine dell'innalzamento del livello del mare sulle città costiere". Questa richiesta incoraggia il laureato magistrale ad assumere il ruolo di scienziato del clima, portando potenzialmente a una risposta più tecnica e autorevole sull'argomento.

5. Decomposizione dei compiti

La scomposizione dei compiti è un approccio strategico al prompt che prevede la suddivisione di compiti complessi in sottocompiti più piccoli e gestibili. Questa tecnica sfrutta la capacità dell'LLM di gestire pezzi discreti di informazioni e di combinarli in un insieme coeso. Scomponendo un compito di grandi dimensioni, è possibile guidare il modello attraverso una serie di passaggi, assicurandosi che ogni componente sia affrontato in modo completo e accurato.

Questo metodo è particolarmente efficace per affrontare problemi complessi che potrebbero sopraffare il modello se presentati tutti insieme. Riduce il carico cognitivo del LLM, consentendo risposte più mirate e accurate a ciascun sottocompito. La scomposizione dei compiti consente anche di gestire meglio i problemi in più fasi e può migliorare la qualità e la completezza del risultato finale. Inoltre, questo approccio può facilitare l'identificazione e la correzione degli errori, in quanto è possibile rivedere ogni fase singolarmente. Quando si implementa la scomposizione dei compiti, è fondamentale mantenere un chiaro flusso logico tra i sottocompiti per garantire un risultato finale coerente.

Esempio: Quando si usa la scomposizione dei compiti per un compito complesso, si può chiedere al LLM di fare così: "Per scrivere un documento di ricerca completo sulle energie rinnovabili, suddividiamolo in fasi. Per favore, elenca le fasi principali che dovremmo seguire, dalla definizione dell'ambito alla finalizzazione dell'elaborato".

L'LLM potrebbe quindi rispondere con una ripartizione di questo tipo:

"1. Definire l'ambito del documento (tipi di energia rinnovabile da trattare). 2. Delineare le sezioni principali (introduzione, stato attuale, sfide, prospettive future, conclusioni). 3. Per ogni sezione, elencate i punti chiave da trattare. 4. Ricercare e raccogliere dati per ogni punto. 5. Scrivete un'introduzione che definisca il contesto e gli obiettivi del documento. 6. Sviluppare ogni sezione, incorporando dati e analisi pertinenti. 7. Riassumere i risultati principali e le implicazioni future nella conclusione. 8. Rivedere e perfezionare l'intero documento per garantire la coerenza e la fluidità. 9. Creare una bibliografia delle fonti utilizzate.

Ora, iniziamo con la fase 1...".

Questa suddivisione consente di affrontare il complesso compito di scrivere un documento di ricerca in parti gestibili, migliorando la qualità complessiva e la completezza del risultato finale.

Certamente! Continuiamo con le altre sezioni del post "10 Best Prompting Techniques for LLMs". Ecco le sezioni 7-10, seguite da una conclusione e da consigli pratici:

6. Prompting vincolato

La richiesta vincolata prevede l'impostazione di regole o limitazioni specifiche che il LLM deve seguire nelle sue risposte. Questa tecnica è particolarmente utile quando è necessario controllare il formato, la lunghezza o il contenuto delle risposte del modello. Dichiarando esplicitamente i vincoli, si può guidare l'LLM a generare output più mirati e pertinenti.

I vincoli possono andare da semplici istruzioni, come i limiti di parole, a requisiti più complessi, come il rispetto di specifici stili di scrittura o l'evitare determinati argomenti. Questa tecnica è particolarmente preziosa in ambito professionale, dove la coerenza e l'aderenza alle linee guida sono fondamentali. Tuttavia, è importante bilanciare i vincoli con la flessibilità per consentire all'LLM di sfruttare appieno le sue capacità.

Esempio: "Fornite una sintesi degli ultimi sviluppi nel campo delle energie rinnovabili in 100 parole esatte. Concentratevi solo sull'energia solare ed eolica e non menzionate aziende specifiche o nomi di marchi".

7. Raffinamento iterativo

L'affinamento iterativo è una tecnica che prevede l'utilizzo di più suggerimenti per migliorare e perfezionare progressivamente i risultati del LLM. Questo approccio riconosce che i compiti complessi spesso richiedono più revisioni e miglioramenti. Suddividendo il compito in più fasi e fornendo un feedback in ogni fase, si può guidare l'LLM verso risultati finali più accurati e raffinati.

Questo metodo è particolarmente efficace per compiti come la scrittura, la risoluzione di problemi o il lavoro creativo, in cui la prima bozza è raramente perfetta. Il perfezionamento iterativo consente di sfruttare i punti di forza del LLM mantenendo il controllo sulla direzione e sulla qualità del risultato. È importante essere chiari e specifici con il proprio feedback a ogni iterazione per garantire un miglioramento continuo.

Esempio: Fase 1: "Scrivete una breve traccia per un articolo sull'impatto dell'intelligenza artificiale sull'assistenza sanitaria". Fase 2: "Sulla base di questo schema, approfondite la sezione sull'intelligenza artificiale nella diagnosi medica". Fase 3: "Ora, aggiungete a questa sezione esempi specifici di applicazioni dell'IA in radiologia".

8. Prompting contestuale

Il prompt contestuale consiste nel fornire al LLM informazioni di base o un contesto rilevante prima di chiedergli di eseguire un compito. Questa tecnica aiuta il modello a comprendere il quadro generale e a generare risposte più accurate e pertinenti. Preparando il terreno con un contesto appropriato, è possibile migliorare in modo significativo la qualità e la specificità dei risultati ottenuti dal LLM.

Questo metodo è particolarmente utile quando si tratta di argomenti specialistici, scenari unici o quando è necessario che il LLM prenda in considerazione informazioni specifiche che potrebbero non far parte delle sue conoscenze generali. I suggerimenti contestuali possono aiutare a colmare il divario tra le conoscenze generali del LLM e i requisiti specifici del vostro compito.

Esempio: "Contesto: La città di Amsterdam sta attuando diverse iniziative ecologiche per diventare più sostenibile. Sulla base di queste informazioni, suggerisci tre idee innovative di pianificazione urbana che potrebbero migliorare ulteriormente gli sforzi di Amsterdam per la sostenibilità."

9. Prompt di autocoerenza

La richiesta di autoconsistenza è una tecnica avanzata che prevede la generazione di più risposte alla stessa richiesta e la successiva selezione della risposta più coerente o affidabile. Questo metodo sfrutta la natura probabilistica dei LLM per migliorare l'accuratezza, soprattutto nei compiti che richiedono un ragionamento o la risoluzione di problemi.

Confrontando più risultati, la richiesta di autoconsistenza può aiutare a identificare e filtrare le incongruenze o gli errori che potrebbero verificarsi nelle singole risposte. Questa tecnica è particolarmente preziosa per le applicazioni critiche in cui l'accuratezza è fondamentale. Tuttavia, richiede più tempo e risorse computazionali rispetto ai metodi a risposta singola.

Esempio: "Risolvete il seguente problema matematico: se un treno viaggia a 60 miglia orarie per 2,5 ore, quanta strada fa? Generate cinque soluzioni indipendenti, quindi scegliete la risposta più coerente".

10. Prompting avversariale

L'Adversarial prompting è una tecnica che consiste nel mettere in discussione le risposte o le ipotesi iniziali del LLM per migliorare la qualità, l'accuratezza e la solidità dei suoi risultati. Questo metodo simula un dibattito o un processo di pensiero critico, spingendo il modello a considerare punti di vista alternativi, potenziali difetti nel suo ragionamento o fattori trascurati.

L'approccio contraddittorio funziona chiedendo al LLM di fornire una risposta o una soluzione iniziale, per poi spingerlo a criticare o mettere in discussione la propria risposta. Questo processo può essere ripetuto più volte e ogni iterazione affina e rafforza il risultato finale. Il prompt avversario è particolarmente utile per la risoluzione di problemi complessi, per gli scenari decisionali o quando si affrontano argomenti controversi o sfaccettati.

Questa tecnica aiuta a mitigare le potenziali distorsioni nelle risposte del modello e incoraggia la produzione di risultati più completi ed equilibrati. Tuttavia, richiede un'attenta formulazione delle richieste di contraddittorio per garantire una critica produttiva piuttosto che una semplice contraddizione.

Esempio: Fase 1: "Proponete una soluzione per ridurre la congestione del traffico urbano". Fase 2: "Ora, identificate tre potenziali svantaggi o sfide alla soluzione che avete appena proposto". Fase 3: "Tenendo conto di queste sfide, perfezionate la vostra soluzione originale o proponete un approccio alternativo". Fase 4: "Infine, confrontate i punti di forza e di debolezza della soluzione originale e di quella perfezionata e consigliate la migliore linea d'azione".

Trovare le giuste tecniche di ingegneria del prompt

La padronanza di queste tecniche di sollecitazione può migliorare notevolmente la vostra capacità di lavorare efficacemente con i LLM. Ogni metodo offre vantaggi unici ed è adatto a diversi tipi di compiti e scenari. Comprendendo e applicando queste tecniche, i professionisti dell'IA possono sbloccare il pieno potenziale degli LLM, ottenendo risultati più accurati, creativi e utili.

Con la continua evoluzione del campo dell'IA, si evolveranno anche le strategie di prompting. Tenersi informati sui nuovi sviluppi e sperimentare continuamente tecniche diverse sarà fondamentale per chiunque lavori con gli LLM. Ricordate che l'arte del prompt è tanto legata alla comprensione delle capacità e dei limiti del modello quanto alla creazione dell'input perfetto.