Che cos'è un attacco di intelligenza artificiale avversaria?

Che cos'è un attacco di intelligenza artificiale avversaria?

Le tecnologie di apprendimento profondo come l'intelligenza artificiale (AI) e l'apprendimento automatico (ML) presentano una serie di vantaggi commerciali per le imprese. Allo stesso tempo, un attacco avversario all'intelligenza artificiale rappresenta una sfida crescente per la sicurezza dei sistemi moderni.

Che cos'è un attacco Adversarial AI? Una forma di attacco informatico che "inganna" i modelli di intelligenza artificiale con dati ingannevoli. Conosciuta anche come Adversarial ML, questa forma di attacco è stata ampiamente segnalata nella classificazione delle immagini e nel rilevamento dello spam.

Discutiamo poi dei vari rischi posti da un attacco di IA avversaria.

Rischi posti da un attacco di IA avversaria

Secondo Alexey Rubtsov del Global Risk Institute, "l'adversarial machine learning sfrutta le vulnerabilità e le specificità dei modelli di ML". Ad esempio, l'adversarial ML può far sì che un algoritmo di trading basato su ML prenda decisioni errate in materia di trading.

In che modo un attacco di Adversarial AI rappresenta un rischio per i sistemi AI e ML? Ecco alcuni risultati comuni:

Ingegneria dei social media: In questo caso, l'attacco dell'intelligenza artificiale "raschia" i profili degli utenti nelle piattaforme di social media utilizzando l'automazione. Quindi genera automaticamente contenuti per "attirare" il profilo desiderato.

Deepfakes: Tipicamente utilizzati nelle frodi bancarie, i deepfakes sono attori di minacce online che possono raggiungere una serie di obiettivi nefasti, tra cui:

Ricatto ed estorsione

Danneggiare la credibilità e l'immagine di un individuo

Frode documentale

Social media per molestie individuali o di gruppo

Nascondere il malware: In questo caso, gli attori delle minacce sfruttano il ML per nascondere il malware all'interno di un traffico "dannoso" che sembra normale agli utenti normali.

Password: Gli attacchi di AI avversaria possono persino analizzare un'ampia serie di password e generare variazioni. In altre parole, questi attacchi rendono il processo di cracking delle password più "scientifico". Oltre alle password, il ML consente agli attori delle minacce di risolvere anche i CAPTCHA.

Esempi di attacchi di AI avversaria

Utilizzando esempi di Adversarial AI, gli hacker possono semplicemente progettare un attacco per indurre il modello AI a commettere un errore. Ad esempio, una versione corrotta di un input valido del modello.

Ecco alcuni esempi popolari di metodi utilizzati negli attacchi di Adversarial AI:

Metodo FastGradient Sign (FGSM): Si tratta di un metodo basato sul gradiente in grado di generare esempi di IA avversaria per causare una classificazione errata delle immagini. Lo fa aggiungendo una quantità minima di perturbazione al pixel dell'immagine.

Broyden-Fletcher-Goldfarb-Shanno (L-BFGS) a memoria limitata: Questo metodo è un altro algoritmo di ottimizzazione numerica non lineare basato sul gradiente, in grado di minimizzare il numero di perturbazioni dell'immagine. Questo metodo è estremamente efficace nel generare esempi di IA avversaria.

Attacco di Deepfool: Si tratta di un altro metodo molto efficace per produrre attacchi di IA avversaria con un alto tasso di misclassificazione e un minor numero di perturbazioni. Questa forma di attacco utilizza una tecnica di generazione di campioni avversari non mirati per ridurre la distanza euclidea tra i campioni originali e quelli perturbati.

Attacco alla mappa di salienza basato su Jacobian (JSMA): In questa forma di attacco di AI avversaria, gli hacker utilizzano la selezione delle caratteristiche per ridurre al minimo il numero di caratteristiche modificate, causando così una classificazione errata. Le perturbazioni piatte vengono aggiunte iterativamente alle caratteristiche in base al valore di salienza in ordine decrescente.

Questi sono solo alcuni esempi di Adversarial AI. Discutiamo quindi di come difendersi dagli attacchi di Adversarial AI.

Come difendersi dagli attacchi di Adversarial AI

221122 skim ai infografica 2 png 01

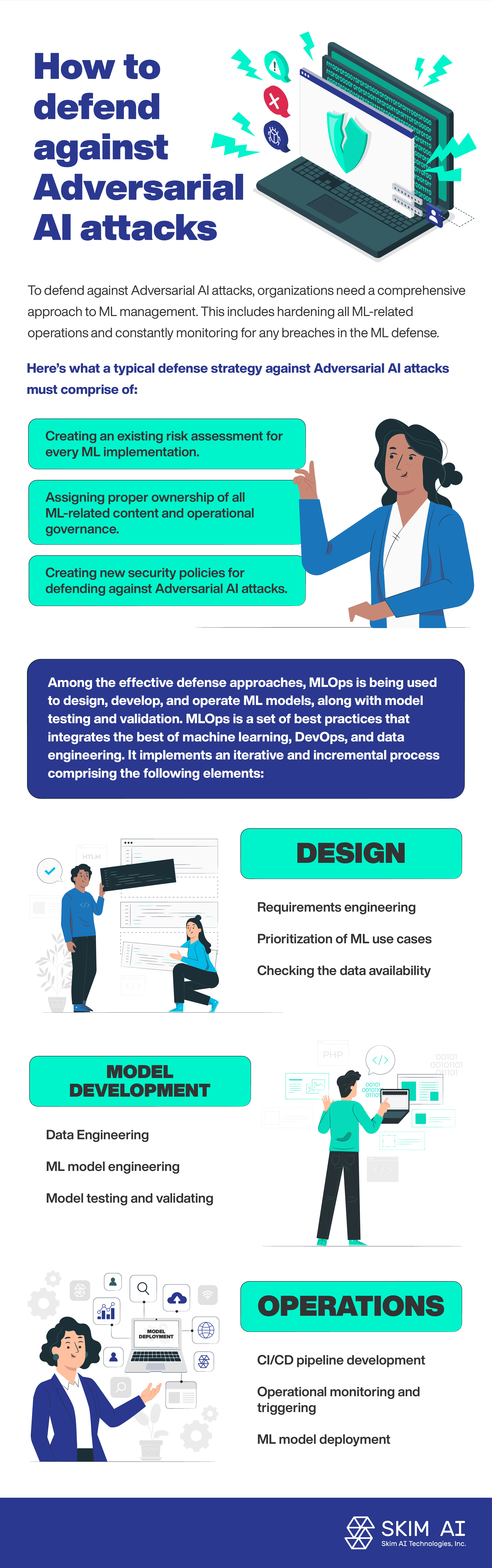

Per difendersi dagli attacchi di Adversarial AI, le organizzazioni devono adottare un approccio completo alla gestione del ML. Ciò include l'irrigidimento di tutte le operazioni legate al ML e il monitoraggio costante di eventuali falle nella difesa del ML.

Ecco come deve essere una tipica strategia di difesa contro gli attacchi di Adversarial AI:

Creare una valutazione del rischio esistente per ogni implementazione di ML.

Assegnare la corretta proprietà di tutti i contenuti relativi al ML e la governance operativa.

Creazione di nuove politiche di sicurezza per la difesa dagli attacchi di Adversarial AI.

Tra gli approcci di difesa efficaci, MLOps viene utilizzato per progettare, sviluppare e gestire modelli di ML, oltre che per testare e convalidare i modelli. MLOps è un insieme di best practice che integra il meglio dell'apprendimento automatico, di DevOps e dell'ingegneria dei dati. Implementa un processo iterativo e incrementale che comprende i seguenti elementi:

Design:

Ingegneria dei requisiti

Priorità ai casi d'uso del ML

Verifica della disponibilità dei dati

Sviluppo del modello:

Ingegneria dei dati

Ingegneria del modello ML

Test e validazione del modello

Operazioni:

Distribuzione del modello ML

Sviluppo della pipeline CI/CD

Monitoraggio operativo e attivazione

Conclusione

Secondo la Commissione per la sicurezza nazionale degli Stati Uniti rapporto sull'intelligenza artificiale, una bassa percentuale di fondi per la ricerca sull'IA viene investita per difendere i sistemi di IA dagli attacchi avversari. La crescente adozione delle tecnologie di IA e di apprendimento automatico è correlata all'aumento degli attacchi di IA avversaria. In effetti, i sistemi di intelligenza artificiale e di ML rappresentano una nuova superficie di attacco, aumentando così i rischi legati alla sicurezza.