Was ist ein feindlicher KI-Angriff?

Was ist ein feindlicher KI-Angriff?

Deep Learning-Technologien wie Künstliche Intelligenz (KI) und maschinelles Lernen (ML) bieten Unternehmen eine Reihe von Vorteilen. Gleichzeitig stellt ein KI-Angriff eine wachsende Sicherheitsherausforderung für moderne Systeme dar.

Was ist ein adversarischer KI-Angriff? Eine Form des Cyberangriffs, bei dem KI-Modelle mit trügerischen Daten "getäuscht" werden. Diese auch als "Adversarial ML" bezeichnete Angriffsform wurde vor allem bei der Bildklassifizierung und Spam-Erkennung beobachtet.

Als Nächstes wollen wir die verschiedenen Risiken eines KI-Angriffs erörtern.

Risiken, die ein KI-Angriff birgt

Nach Angaben von Alexey Rubtsov des Global Risk Institute, "nutzt gegnerisches maschinelles Lernen Schwachstellen und Besonderheiten von ML-Modellen aus". So kann beispielsweise ein ML-basierter Handelsalgorithmus durch negatives ML dazu gebracht werden, falsche Handelsentscheidungen zu treffen.

Inwiefern stellt ein KI-Angriff ein Risiko für KI- und ML-Systeme dar? Hier sind einige allgemeine Erkenntnisse:

Social Media Engineering: In diesem Fall "kratzt" die KI-Attacke mithilfe von Automatisierung an Nutzerprofilen auf Social-Media-Plattformen. Anschließend generiert er automatisch Inhalte, um das gewünschte Profil zu "locken".

Deepfakes: Deepfakes werden in der Regel bei Bankbetrügereien eingesetzt und sind Online-Bedrohungsakteure, die eine Reihe von schändlichen Zielen verfolgen können:

Erpressung und Schutzgelderpressung

Schädigung der Glaubwürdigkeit und des Images einer Person

Dokumentenbetrug

Soziale Medien zur Belästigung von Einzelpersonen oder Gruppen

Versteckte Malware: Hier nutzen Bedrohungsakteure ML, um die Malware in "bösartigem" Datenverkehr zu verstecken, der für normale Benutzer normal aussieht.

Passwörter: KI-Angriffe können sogar einen großen Satz von Kennwörtern analysieren und Variationen erzeugen. Mit anderen Worten: Diese Angriffe machen das Knacken von Passwörtern "wissenschaftlicher". Abgesehen von Passwörtern können Bedrohungsakteure mit ML auch CAPTCHAs lösen.

Beispiele für feindliche KI-Angriffe

Durch die Verwendung von KI-Beispielen können Hacker einfach einen Angriff entwerfen, um das KI-Modell zu einem Fehler zu veranlassen. Zum Beispiel durch eine verfälschte Version einer gültigen Modelleingabe.

Hier sind einige bekannte Beispiele für Methoden, die bei KI-Angriffen eingesetzt werden:

FastGradient Sign-Methode (FGSM): Dabei handelt es sich um eine gradientenbasierte Methode, mit der Adversarial AI-Beispiele erzeugt werden können, um eine Fehlklassifizierung von Bildern zu bewirken. Dies geschieht durch Hinzufügen einer minimalen Störung zu den Bildpixeln.

Broyden-Fletcher-Goldfarb-Shanno (L-BFGS) mit begrenztem Gedächtnis: Bei dieser Methode handelt es sich um einen weiteren nichtlinearen gradientenbasierten numerischen Optimierungsalgorithmus, der die Anzahl der Bildstörungen minimieren kann. Diese Methode ist äußerst effektiv bei der Erstellung von Adversarial-KI-Beispielen.

Deepfool-Angriff: Dies ist eine weitere sehr wirksame Methode zur Erzeugung von KI-Angriffen mit einer hohen Fehlklassifizierungsrate und weniger Störungen. Bei dieser Form des Angriffs wird eine ungezielte Technik zur Generierung negativer Proben verwendet, um den euklidischen Abstand zwischen den ursprünglichen und den gestörten Proben zu verringern.

Jacobian-basierter Salienzkarten-Angriff (JSMA): Bei dieser Form des feindlichen KI-Angriffs verwenden Hacker die Merkmalsauswahl, um die Anzahl der geänderten Merkmale zu minimieren, was zu einer Fehlklassifizierung führt. Flache Störungen werden iterativ zu den Merkmalen hinzugefügt, basierend auf dem Auffälligkeitswert in abnehmender Reihenfolge.

Dies sind nur einige Beispiele für KI-Angriffe. Als Nächstes wollen wir erörtern, wie man sich gegen KI-Angriffe verteidigen kann.

Wie man sich gegen KI-Angriffe verteidigt

221122 ai-Infografik überfliegen 2 png 01

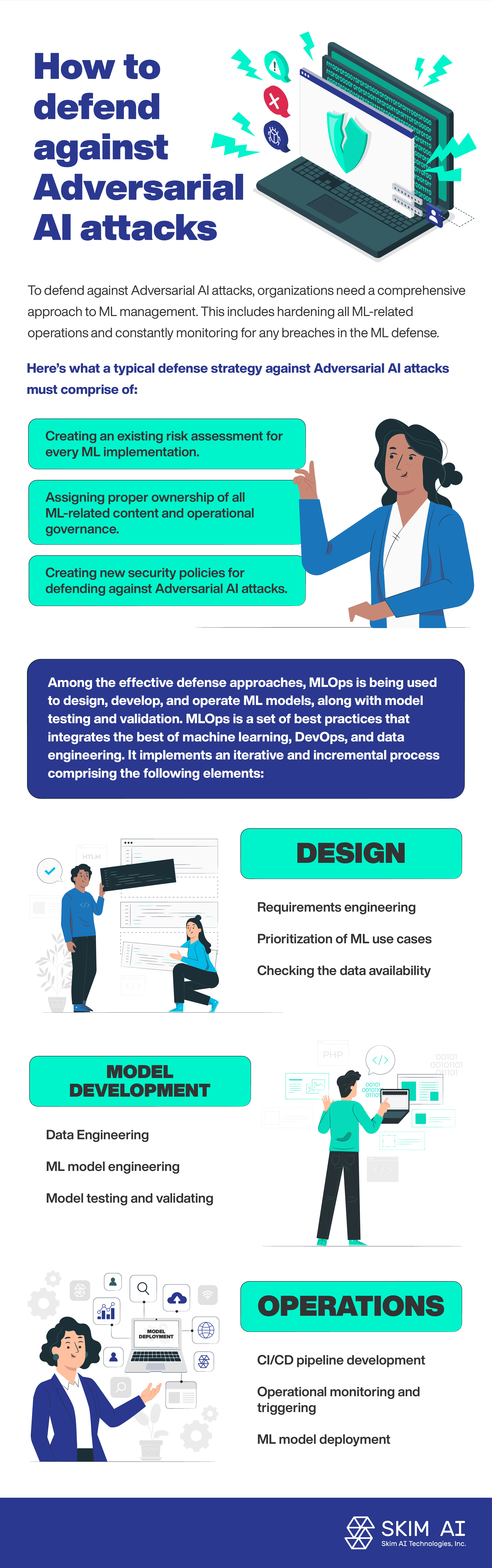

Um sich gegen KI-Angriffe zu schützen, benötigen Unternehmen einen umfassenden Ansatz für das ML-Management. Dazu gehören die Härtung aller ML-bezogenen Operationen und die ständige Überwachung auf Lücken in der ML-Abwehr.

Eine typische Verteidigungsstrategie gegen KI-Angriffe muss aus folgenden Elementen bestehen

Erstellung einer Risikobewertung für jede ML-Implementierung.

Zuweisung einer angemessenen Verantwortung für alle ML-bezogenen Inhalte und operative Steuerung.

Erstellung neuer Sicherheitsrichtlinien für die Abwehr von KI-Angriffen durch Adversarial AI.

Zu den effektiven Verteidigungsansätzen gehört MLOps, das für den Entwurf, die Entwicklung und den Betrieb von ML-Modellen sowie die Modellprüfung und -validierung eingesetzt wird. MLOps ist eine Reihe von Best Practices, die das Beste aus maschinellem Lernen, DevOps und Data Engineering vereinen. Es implementiert einen iterativen und inkrementellen Prozess, der die folgenden Elemente umfasst:

Entwurf:

Anforderungsmanagement

Priorisierung von ML-Anwendungsfällen

Überprüfung der Datenverfügbarkeit

Entwicklung von Modellen:

Datentechnik

ML-Modellbau

Modellprüfung und -validierung

Operationen:

ML-Modell-Einsatz

Entwicklung von CI/CD-Pipelines

Operative Überwachung und Auslösung

Schlussfolgerung

Nach Angaben der Nationalen Sicherheitskommission der Vereinigten Staaten Bericht Auf dem Gebiet der künstlichen Intelligenz wird nur ein geringer Prozentsatz der KI-Forschungsgelder in die Verteidigung von KI-Systemen gegen gegnerische Angriffe investiert. Die zunehmende Verbreitung von KI- und maschinellen Lerntechnologien korreliert mit der Zunahme von KI-Angriffen durch Angreifer. Tatsächlich stellen KI- und ML-Systeme eine neue Angriffsfläche dar und erhöhen damit die sicherheitsrelevanten Risiken.