Що таке ворожа атака штучного інтелекту?

Що таке ворожа атака штучного інтелекту?

Технології глибокого навчання, такі як штучний інтелект (ШІ) і машинне навчання (МН), надають підприємствам низку бізнес-переваг. У той же час, ворожі атаки ШІ є зростаючою проблемою безпеки для сучасних систем.

Що таке ворожа атака на ШІ? Форма кібератаки, яка "обманює" ШІ-моделі за допомогою неправдивих даних. Також відома як Adversarial ML, ця форма атаки здебільшого використовується для класифікації зображень і виявлення спаму.

Далі ми обговоримо різні ризики, пов'язані з атакою ворожого ШІ.

Ризики, пов'язані з атакою ворожого ШІ

За даними Олексій Рубцов Глобального інституту ризиків, "змагальне машинне навчання використовує вразливості та особливості моделей машинного навчання". Наприклад, змагальний ML може призвести до того, що торговий алгоритм, заснований на ML, прийматиме неправильні рішення про торгівлю.

Як ворожа атака ШІ створює ризик для систем ШІ та ML? Ось деякі загальні висновки:

Інженерія соціальних мереж: У цьому випадку ШІ-атака "прочісує" профілі користувачів у соціальних мережах за допомогою автоматизації. Потім вона автоматично генерує контент, щоб "заманити" потрібний профіль.

Підробка: Зазвичай використовувані в банківському шахрайстві, deepfakes є суб'єктами онлайн-загроз, які можуть досягати цілого ряду негідних цілей, в тому числі:

Шантаж і вимагання

Підрив довіри до особи та її іміджу

Підробка документів

Соціальні мережі для індивідуальних або групових переслідувань

Приховування шкідливого програмного забезпечення: Тут зловмисники використовують ML, щоб приховати шкідливе програмне забезпечення у "шкідливому" трафіку, який виглядає нормальним для звичайних користувачів.

Паролі: Атаки зі застосуванням штучного інтелекту можуть навіть аналізувати великий набір паролів і генерувати їхні варіації. Іншими словами, ці атаки роблять процес зламу паролів більш "науковим". Окрім паролів, ШІ дозволяє зловмисникам також розгадувати CAPTCHA.

Приклади ворожих атак ШІ

Використовуючи приклади змагального ШІ, хакери можуть просто розробити атаку, яка змусить модель ШІ зробити помилку. Наприклад, пошкоджену версію правильних вхідних даних моделі.

Ось кілька популярних прикладів методів, які використовуються в атаках з використанням ШІ:

Метод FastGradient Sign (FGSM): Це метод на основі градієнта, який може генерувати приклади змагального ШІ, що спричиняють неправильну класифікацію зображень. Він робить це, додаючи мінімальну кількість збурень до пікселя зображення.

Обмежена пам'ять Бройдена-Флетчера-Гольдфарба-Шанно (L-BFGS): Цей метод є ще одним нелінійним алгоритмом чисельної оптимізації на основі градієнта, який може мінімізувати кількість збурень зображення. Цей метод надзвичайно ефективний при створенні прикладів Adversarial AI.

Атака дурня: Це ще один метод, дуже ефективний для створення атак ШІ з високим рівнем помилкової класифікації та меншою кількістю збурень. Ця форма атаки використовує нецільову техніку генерації зразків, щоб зменшити евклідову відстань між вихідним і спотвореним зразками.

Атака на основі якобіанських карт привабливості (JSMA): У цій формі атаки на ШІ хакери використовують вибір ознак для мінімізації кількості модифікованих ознак, що призводить до помилкової класифікації. Плоскі збурення ітеративно додаються до ознак на основі значення корисності в порядку зменшення.

Це лише деякі приклади використання ШІ. Далі ми поговоримо про те, як захиститися від атак ШІ.

Як захиститися від атак супротивника зі штучним інтелектом

221122 skim ai інфографіка 2 png 01

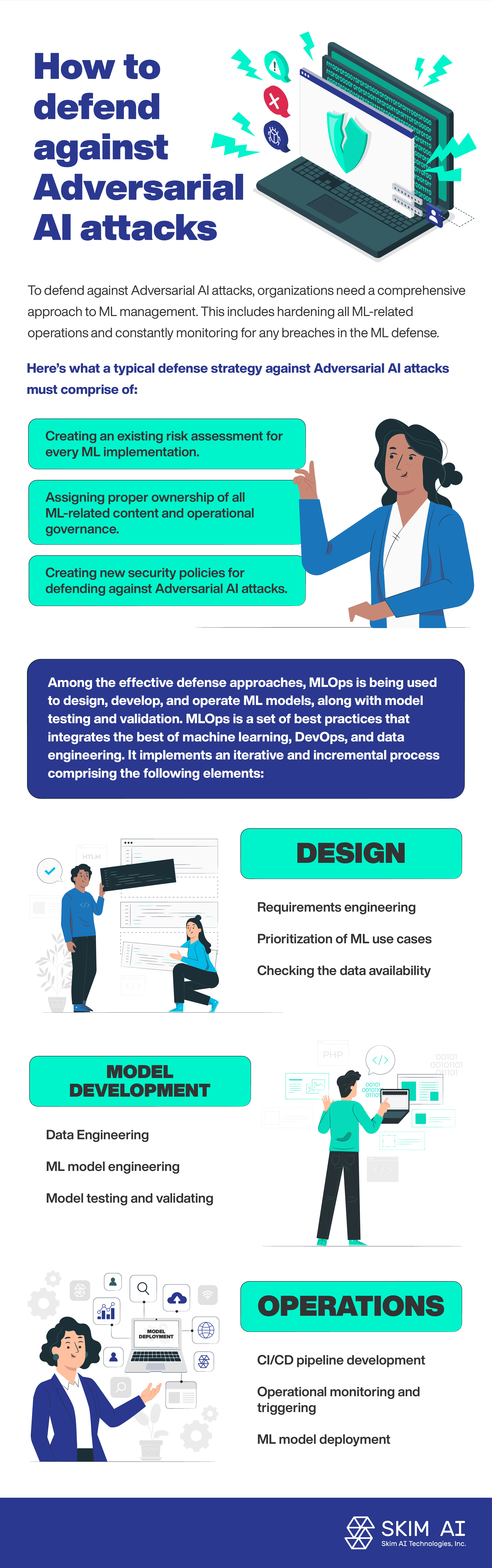

Щоб захиститися від атак ворожого ШІ, організаціям потрібен комплексний підхід до управління ризиками відмивання грошей. Це передбачає посилення всіх операцій, пов'язаних з ВК, та постійний моніторинг будь-яких прогалин у захисті від ВК.

Ось з чого має складатися типова стратегія захисту від атак ворожих ШІ:

Створення існуючої оцінки ризиків для кожної реалізації ВК.

Визначити належну власність на весь контент, пов'язаний з ВК, та оперативне управління ним.

Створення нових політик безпеки для захисту від атак ШІ.

Серед ефективних підходів до захисту, MLOps використовується для проектування, розробки та експлуатації моделей ML, а також для тестування та валідації моделей. MLOps - це набір найкращих практик, що поєднує в собі найкраще з машинного навчання, DevOps та інженерії даних. Він реалізує ітеративний та інкрементальний процес, що складається з наступних елементів:

Дизайн:

Інженерія вимог

Визначення пріоритетності випадків ВК

Перевірка наявності даних

Розробка моделей:

Інженерія даних

Інжиніринг ML-моделей

Тестування та валідація моделі

Операції:

Розгортання ML-моделі

Розробка конвеєра CI/CD

Оперативний моніторинг і запуск

Висновок

За даними Комісії національної безпеки США доповідь у сфері штучного інтелекту, невеликий відсоток коштів на дослідження штучного інтелекту інвестується в захист систем штучного інтелекту від ворожих атак. Дедалі ширше впровадження технологій штучного інтелекту та машинного навчання корелює зі збільшенням кількості ворожих атак на системи штучного інтелекту. По суті, системи ШІ та машинного навчання створюють нову поверхню для атак, що збільшує ризики, пов'язані з безпекою.