від Григорій Еліас | Сер 29, 2024 | Корпоративний штучний інтелект, Магістр права / НЛП, Швидкий інжиніринг

Великі мовні моделі (ВММ) демонструють чудові можливості в обробці та генерації природної мови (ПМ). Однак, коли ці моделі стикаються зі складними завданнями міркування, вони можуть не давати точних і надійних результатів. Саме тут на допомогу приходять підказки ланцюжків думок (CoT)

від Григорій Еліас | Сер 29, 2024 | Генеративний ШІ, Магістр права / НЛП, Швидкий інжиніринг

Підказки за принципом "ланцюжка думок" (Chain-of-Thought, CoT) були визнані проривом у розкритті можливостей міркувань у великих мовних моделях (ВММ). Ця методика, яка передбачає надання покрокових прикладів міркувань для керування БММ, привернула значну увагу спільноти ШІ. Багато хто

від Григорій Еліас | Сер 29, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Швидкий інжиніринг

Мистецтво створення ефективних підказок для великих мовних моделей (ВММ) стало ключовою навичкою для фахівців зі штучного інтелекту. Добре продумані підказки можуть значно підвищити продуктивність БММ, забезпечуючи більш точні, релевантні та креативні результати. У цій статті ми розглянемо десять з них

від Григорій Еліас | Сер 19, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Інтеграція LLM

У сфері штучного інтелекту здатність ефективно навчатися на основі обмежених даних набула вирішального значення. Представляємо вам Few Shot Learning - підхід, який покращує те, як ШІ-моделі здобувають знання та адаптуються до нових завдань. Але що саме являє собою Few Shot Learning? Визначення навчання з кількох пострілів Навчання з кількох пострілів...

від Григорій Еліас | Сер 19, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Магістр права / НЛП

Справжній потенціал великих мовних моделей (ВММ) полягає не лише в їхній великій базі знань, але й у здатності адаптуватися до конкретних завдань і областей з мінімальним додатковим навчанням. Саме тут з'являються концепції підказок і тонкого налаштування...

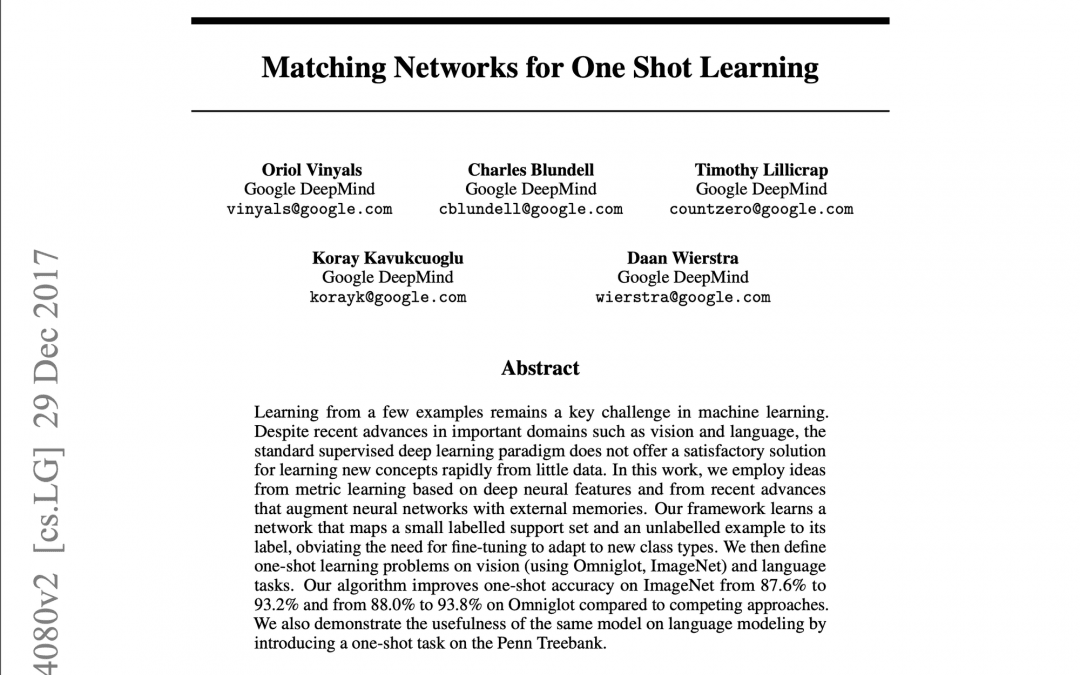

від Григорій Еліас | Сер 19, 2024 | Генеративний ШІ, Магістр права / НЛП, Дослідження / Статистика

Навчання з невеликою кількістю пострілів стало важливою сферою досліджень у машинному навчанні, спрямованою на розробку алгоритмів, які можуть навчатися на обмеженій кількості маркованих прикладів. Ця можливість має важливе значення для багатьох реальних застосувань, де дані є дефіцитними, дорогими або трудомісткими.

від Григорій Еліас | Сер 19, 2024 | Генеративний ШІ, Магістр права / НЛП, Інформаційний бюлетень

Статистика тижня: 72% опитаних організацій впровадили ШІ у 2024 році, що є значним стрибком у порівнянні з 50% у попередні роки. (McKinsey) Нещодавній випуск Llama 3.1 від Meta викликав хвилювання в корпоративному світі. Ця остання ітерація моделей Llama...

від Григорій Еліас | Сер 19, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Інтеграція LLM

Статистика тижня: Використання менших LLM, таких як GPT-J, в каскаді може знизити загальну вартість на 80% при одночасному підвищенні точності на 1,5% в порівнянні з GPT-4. (Dataiku) Оскільки організації все більше покладаються на великі мовні моделі (LLM) для різних додатків,

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Магістр права / НЛП

Оскільки організації все більше покладаються на великі мовні моделі (ВММ) для різних додатків, від чат-ботів для обслуговування клієнтів до генерації контенту, проблема управління витратами на ВММ вийшла на перший план. Операційні витрати, пов'язані з розгортанням і підтримкою LLM

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Інтеграція LLM

Для корпоративних стратегій ШІ розуміння структур ціноутворення на великі лінгвістичні моделі (LLM) має вирішальне значення для ефективного управління витратами. Операційні витрати, пов'язані з LLM, можуть швидко зростати без належного контролю, що потенційно може призвести до несподіваних стрибків витрат, які можуть зірвати бюджет.

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Магістр права / НЛП

Нещодавно компанія Meta оголосила про випуск Llama 3.1, найдосконалішої на сьогоднішній день великої мовної моделі з відкритим вихідним кодом (LLM). Цей реліз знаменує собою важливу віху в демократизації технології штучного інтелекту, потенційно долаючи розрив між моделями з відкритим вихідним кодом і пропрієтарними моделями. Лама...

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Інтеграція LLM, Управління проектами

Нещодавній випуск Llama 3.1 від компанії Meta викликав хвилювання у корпоративному світі. Ця остання ітерація моделей Llama являє собою значний стрибок вперед у сфері великих мовних моделей (LLM), пропонуючи поєднання продуктивності та доступності, які...

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Інтеграція LLM

Ландшафт великих мовних моделей (LLM) став полем битви між моделями з відкритою вагою, такими як Llama 3.1 від Meta, та пропрієтарними пропозиціями від технологічних гігантів, таких як OpenAI. Оскільки підприємства орієнтуються на цій складній місцевості, рішення між прийняттям відкритої...

від Григорій Еліас | Сер 4, 2024 | Корпоративний штучний інтелект, Інтеграція LLM

Llama 3.1 від Meta став вражаючим варіантом LLM, пропонуючи унікальне поєднання продуктивності, гнучкості та економічної ефективності. Оскільки підприємства орієнтуються в складному світі впровадження штучного інтелекту, Llama 3.1 надає переконливі причини для серйозного...

від Григорій Еліас | Сер 3, 2024 | Реклама та маркетинг, Інформаційний бюлетень

Статистика тижня: У травні 2024 року Perplexity AI отримав 67,42 мільйона відвідувань із середньою тривалістю сесії 10 хвилин 51 секунду. Трафік збільшився на 20,71% порівняно з квітнем. (Семруш) У цифровому маркетингу дуже важливо бути на крок попереду. У міру того, як розвиваються онлайн-дослідження,...

від Григорій Еліас | Сер 2, 2024 | Без категорії

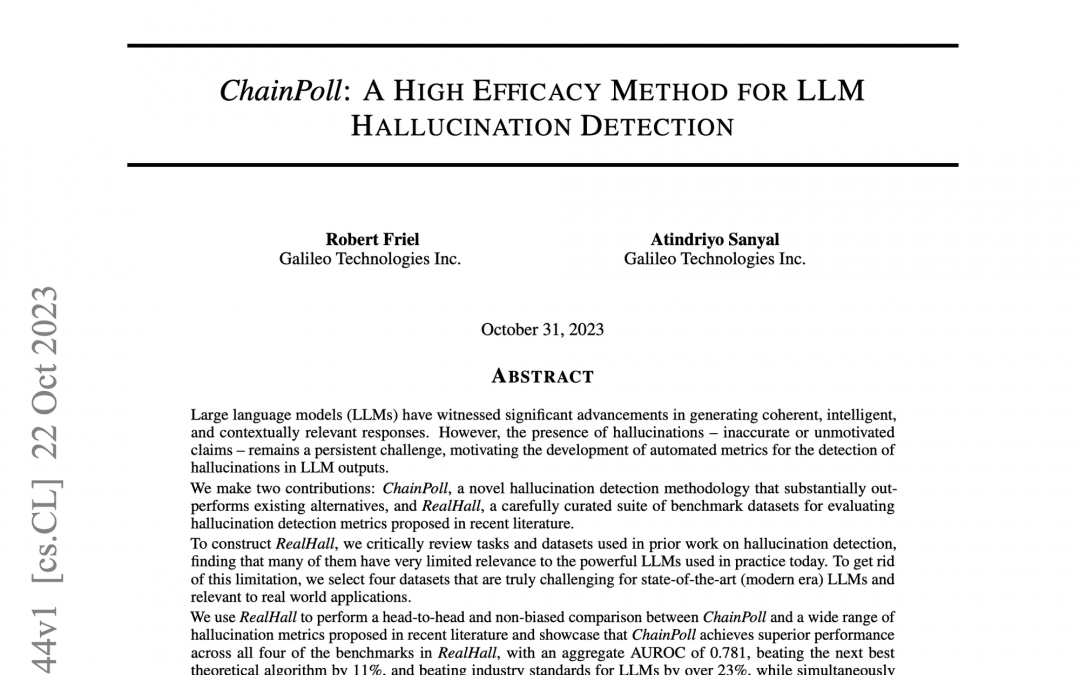

У цій статті ми розповімо про важливу наукову роботу, яка розглядає одну з найактуальніших проблем, що стоять перед великими мовними моделями (ВММ): галюцинації. Стаття під назвою "ChainPoll: високоефективний метод для виявлення галюцинацій у великих мовних моделях...

від Григорій Еліас | Сер 2, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Магістр права / НЛП

Великі мовні моделі (LLM) трансформують корпоративні додатки, пропонуючи безпрецедентні можливості обробки та генерації природної мови. Однак, перш ніж ваша компанія приєднається до LLM, вам потрібно вирішити одну важливу проблему...

від Григорій Еліас | Сер 2, 2024 | Корпоративний штучний інтелект, Генеративний ШІ, Магістр права / НЛП

Оскільки великі мовні моделі (БММ) продовжують проникати майже в кожну сферу та галузь, вони приносять із собою унікальну проблему: галюцинації. Ці неточності, спричинені штучним інтелектом, становлять значний ризик для надійності та достовірності результатів LLM. Що таке LLM

Останні коментарі