Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67 Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- O desafio da escassez de dados na IA

- Aprendizagem com poucos disparos vs. Aprendizagem supervisionada tradicional

- O espetro da aprendizagem eficiente por amostragem

- Few Shot Prompting vs Fine Tuning LLM

- Prompting de poucas palavras: Libertar o potencial do LLM

- Ajuste fino de LLMs: Adaptação de modelos com dados limitados

- Prompting de poucos disparos vs. afinação: Escolher a abordagem correta

- Top 5 Research Papers for Few-Shot Learning

- A linha de fundo

- Obrigado por ler AI & YOU!

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

Estatísticas da semana: Research by MobiDev on few-shot learning for coin image classification found that using just 4 image examples per coin denomination, they could achieve ~70% accuracy.

In AI, the ability to learn efficiently from limited data has become crucial. That’s why it’s important for enterprises to understand few-shot learning, few-shot prompting, and fine-tuning LLMs.

Na edição desta semana de AI&YOU, exploramos as ideias de três blogues que publicámos sobre estes temas:

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

Few Shot Learning is an innovative machine learning paradigm that enables AI models to learn new concepts or tasks from only a few examples. Unlike traditional supervised learning methods that require vast amounts of labeled training data, Few Shot Learning techniques allow models to generalize effectively using just a small number of samples. This approach mimics the human ability to quickly grasp new ideas without the need for extensive repetition.

A essência do Few Shot Learning reside na sua capacidade de aproveitar o conhecimento prévio e adaptar-se rapidamente a novos cenários. Ao utilizar técnicas como a meta-aprendizagem, em que o modelo "aprende a aprender", os algoritmos de Aprendizagem de Poucas Oportunidades podem lidar com uma vasta gama de tarefas com um mínimo de formação adicional. Esta flexibilidade torna-os numa ferramenta inestimável em cenários onde os dados são escassos, caros de obter ou estão em constante evolução.

O desafio da escassez de dados na IA

Nem todos os dados são iguais, e os dados rotulados de alta qualidade podem ser um bem raro e precioso. Esta escassez representa um desafio significativo para as abordagens tradicionais de aprendizagem supervisionada, que normalmente requerem milhares ou mesmo milhões de exemplos etiquetados para obter um desempenho satisfatório.

O problema da escassez de dados é particularmente grave em domínios especializados como os cuidados de saúde, em que as doenças raras podem ter um número limitado de casos documentados, ou em ambientes em rápida mutação, em que surgem frequentemente novas categorias de dados. Nestes cenários, o tempo e os recursos necessários para recolher e rotular grandes conjuntos de dados podem ser proibitivos, criando um estrangulamento no desenvolvimento e implementação da IA.

Aprendizagem com poucos disparos vs. Aprendizagem supervisionada tradicional

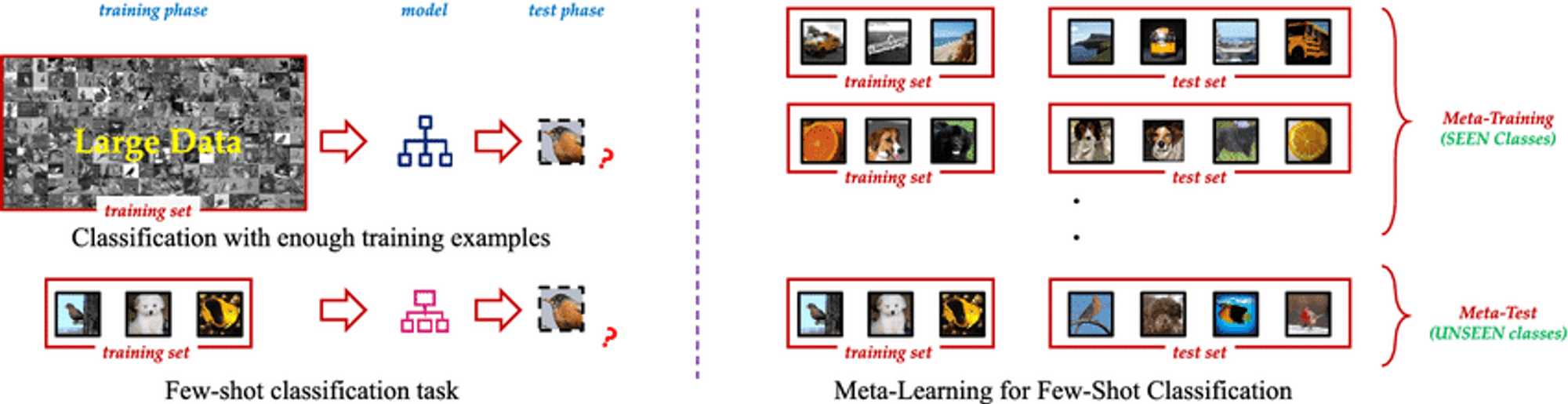

Understanding the distinction between Few Shot Learning and traditional supervised learning is crucial to grasp its real-world impact.

Tradicional aprendizagem supervisionada, while powerful, has drawbacks:

Dependência de dados: Struggles with limited training data.

Inflexibilidade: Performs well only on specific trained tasks.

Intensidade de recursos: Requires large, expensive datasets.

Atualização contínua: Needs frequent retraining in dynamic environments.

Few Shot Learning offers a paradigm shift:

Eficiência da amostra: Generalizes from few examples using meta-learning.

Adaptação rápida: Quickly adapts to new tasks with minimal examples.

Otimização de recursos: Reduces data collection and labeling needs.

Aprendizagem contínua: Suitable for incorporating new knowledge without forgetting.

Versatilidade: Applicable across various domains, from computer vision to NLP.

By tackling these challenges, Few Shot Learning enables more adaptable and efficient AI models, opening new possibilities in AI development.

O espetro da aprendizagem eficiente por amostragem

A fascinating spectrum of approaches aims to minimize required training data, including Zero Shot, One Shot, and Few Shot Learning.

Aprendizagem Zero Shot: Aprender sem exemplos

Recognizes unseen classes using auxiliary information like textual descriptions

Valuable when labeled examples for all classes are impractical or impossible

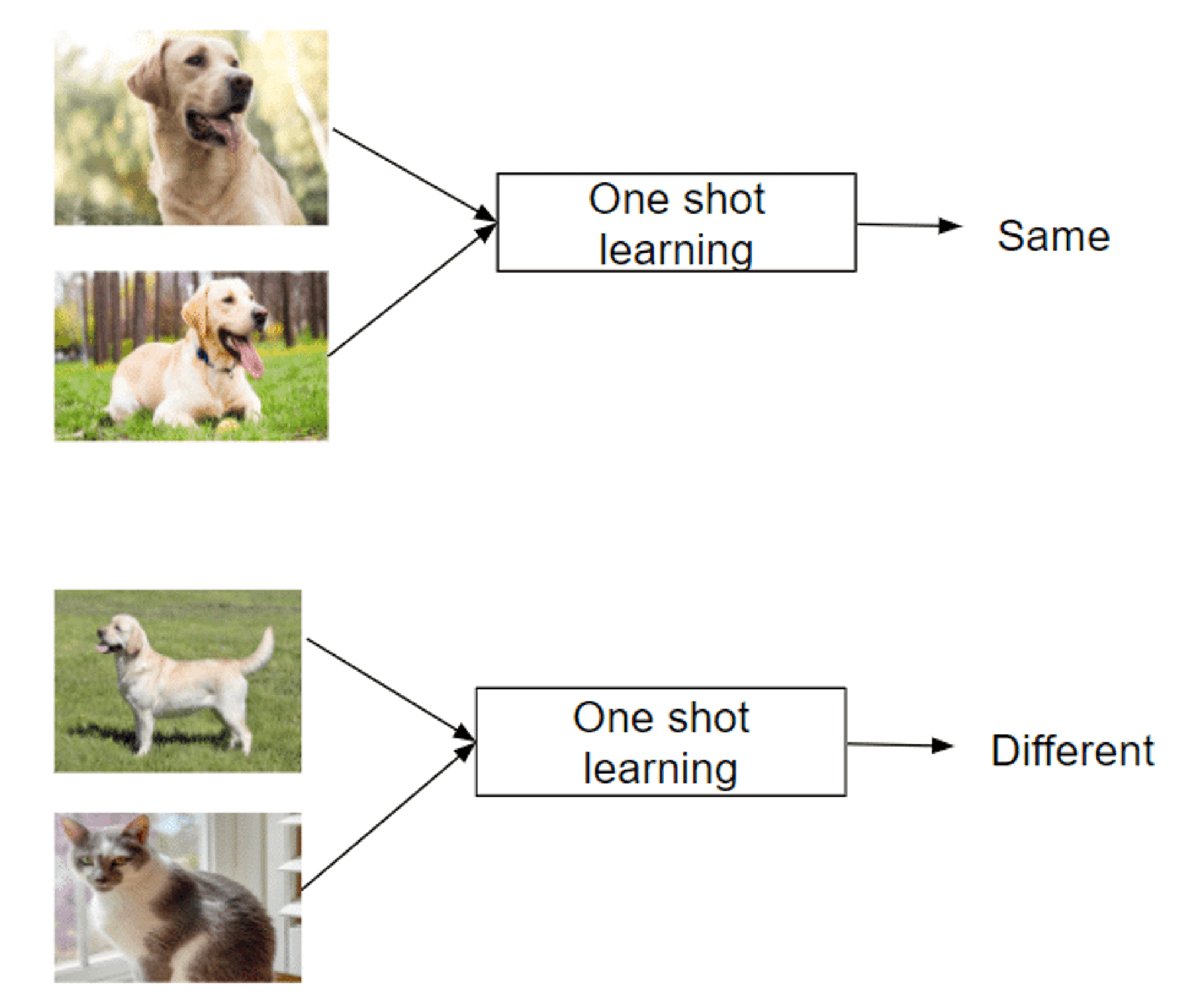

Aprendizagem de uma só vez: Aprender a partir de uma única instância

Recognizes new classes from just one example

Mimics human ability to grasp concepts quickly

Successful in areas like facial recognition

Aprendizagem com poucas hipóteses: Dominar tarefas com o mínimo de dados

Uses 2-5 labeled examples per new class

Balances extreme data efficiency and traditional methods

Enables rapid adaptation to new tasks or classes

Leverages meta-learning strategies to learn how to learn

This spectrum of approaches offers unique capabilities in tackling the challenge of learning from limited examples, making them invaluable in data-scarce domains.

Few Shot Prompting vs Fine Tuning LLM

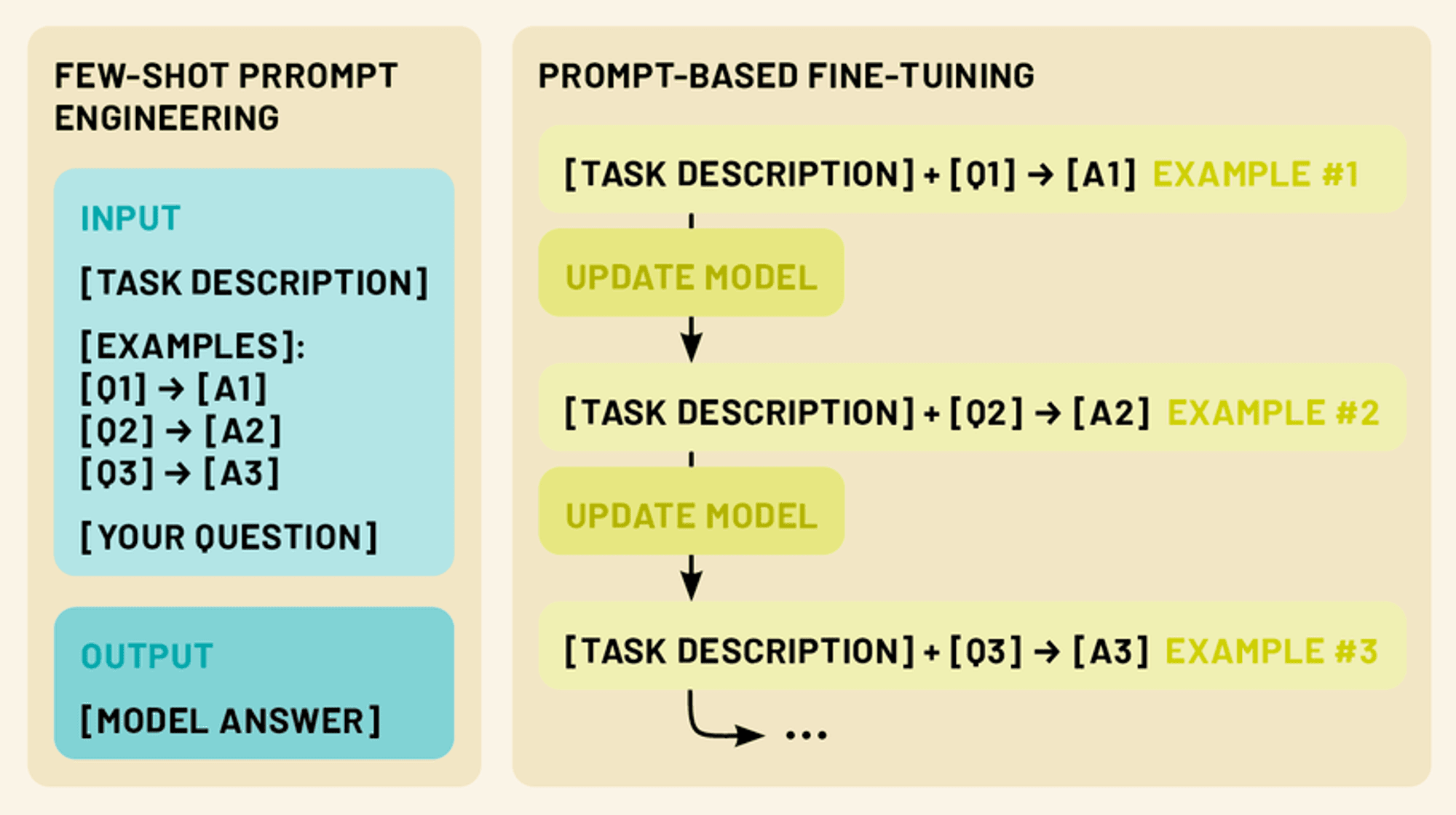

Two more powerful techniques exist in this realm: few-shot prompting and fine-tuning. Few-shot prompting involves crafting clever input prompts that include a small number of examples, guiding the model to perform a specific task without any additional training. Fine-tuning, on the other hand, involves updating the model’s parameters using a limited amount of task-specific data, allowing it to adapt its vast knowledge to a particular domain or application.

Both approaches fall under the umbrella of few-shot learning. By leveraging these techniques, we can dramatically enhance the performance and versatility of LLMs, making them more practical and effective tools for a wide range of applications in natural language processing and beyond.

Prompting de poucas palavras: Libertar o potencial do LLM

Few-shot prompting capitalizes on the model’s ability to understand instructions, effectively “programming” the LLM through crafted prompts.

Few-shot prompting provides 1-5 examples demonstrating the desired task, leveraging the model’s pattern recognition and adaptability. This enables performance of tasks not explicitly trained for, tapping into the LLM’s capacity for in-context learning.

By presenting clear input-output patterns, few-shot prompting guides the LLM to apply similar reasoning to new inputs, allowing quick adaptation to new tasks without parameter updates.

Tipos de prompts de poucos disparos (zero disparo, um disparo, poucos disparos)

Few-shot prompting encompasses a spectrum of approaches, each defined by the number of examples provided. (Just like few-shot learning):

Solicitação de disparo zero: Neste cenário, não são fornecidos exemplos. Em vez disso, o modelo recebe uma instrução ou descrição clara da tarefa. Por exemplo, "Traduzir para francês o seguinte texto em inglês: [texto de entrada]".

Solicitação de uma só vez: Neste caso, é fornecido um único exemplo antes da entrada efectiva. Isto dá ao modelo uma instância concreta da relação esperada entre entradas e saídas. Por exemplo: "Classifique o sentimento da seguinte crítica como positivo ou negativo. Exemplo: 'Este filme foi fantástico!' - Entrada positiva: 'Não consegui suportar o enredo'. - [o modelo gera a resposta]"

Poucos disparos: Esta abordagem fornece vários exemplos (normalmente 2-5) antes da entrada efectiva. Isto permite que o modelo reconheça padrões e nuances mais complexos na tarefa. Por exemplo: "Classifique as seguintes frases como perguntas ou afirmações: 'O céu é azul'. - Pergunta "Eu adoro gelado". - Declaração Entrada: 'Onde posso encontrar o restaurante mais próximo?' - [o modelo gera a resposta]"

Conceber prompts de poucas frases eficazes

A elaboração de prompts de poucos disparos eficazes é tanto uma arte como uma ciência. Aqui estão alguns princípios-chave a considerar:

Clareza e coerência: Certifique-se de que os seus exemplos e instruções são claros e seguem um formato consistente. Isto ajuda o modelo a reconhecer o padrão mais facilmente.

Diversidade: Ao utilizar vários exemplos, tente abranger uma gama de entradas e saídas possíveis para dar ao modelo uma compreensão mais ampla da tarefa.

Relevância: Escolha exemplos que estejam intimamente relacionados com a tarefa ou domínio específico a que se destina. Isto ajuda o modelo a concentrar-se nos aspectos mais relevantes do seu conhecimento.

Concisão: Embora seja importante fornecer um contexto suficiente, evite perguntas demasiado longas ou complexas que possam confundir o modelo ou diluir as informações principais.

Experimentação: Don’t be afraid to iterate and experiment with different prompt structures and examples to find what works best for your specific use case.

Ao dominarmos a arte de dar instruções em poucas doses, podemos desbloquear todo o potencial dos LLMs, permitindo-lhes realizar uma vasta gama de tarefas com um mínimo de informação ou formação adicional.

Ajuste fino de LLMs: Adaptação de modelos com dados limitados

Embora a solicitação de poucos disparos seja uma técnica poderosa para adaptar LLMs a novas tarefas sem modificar o próprio modelo, o ajuste fino oferece uma forma de atualizar os parâmetros do modelo para um desempenho ainda melhor em tarefas ou domínios específicos. O ajuste fino permite-nos aproveitar o vasto conhecimento codificado em LLMs pré-treinadas, adaptando-as às nossas necessidades específicas, utilizando apenas uma pequena quantidade de dados específicos da tarefa.

Compreender o ajuste fino no contexto dos LLMs

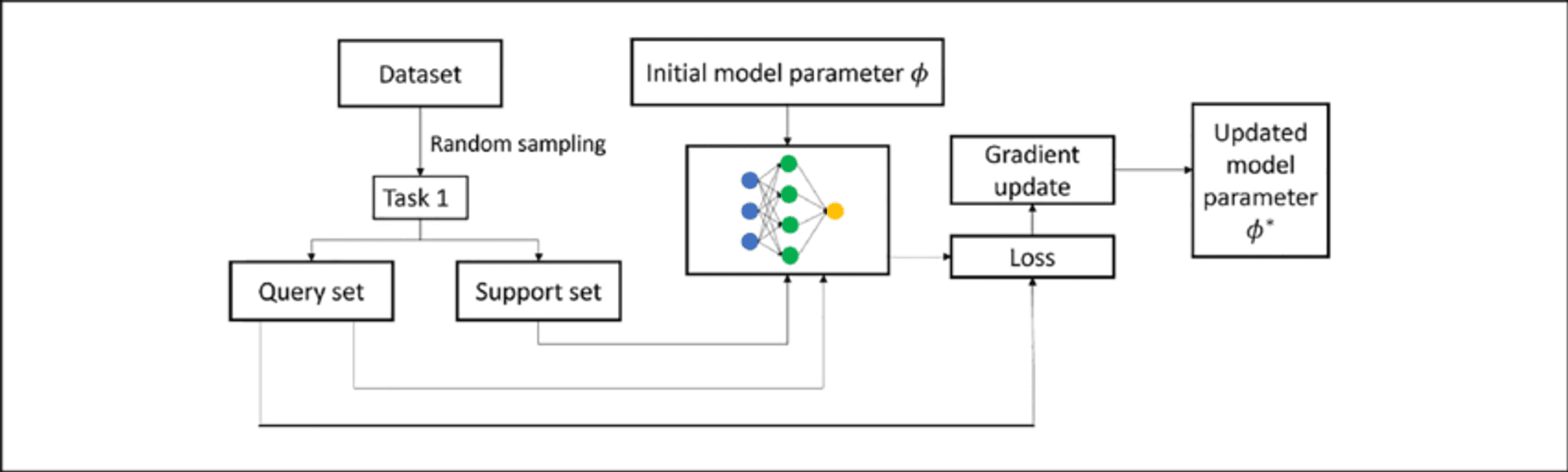

Fine-tuning an LLM involves further training a pre-trained model on a smaller, task-specific dataset. This process adapts the model to the target task while building upon existing knowledge, requiring less data and resources than training from scratch.

In LLMs, fine-tuning typically adjusts weights in upper layers for task-specific features, while lower layers remain largely unchanged. This “transfer learning” approach retains broad language understanding while developing specialized capabilities.

Técnicas de afinação de poucos disparos

Few-shot fine-tuning adapts the model using only 10 to 100 samples per class or task, valuable when labeled data is scarce. Key techniques include:

Afinação com base em pedidos: Combines few-shot prompting with parameter updates.

Abordagens de meta-aprendizagem: Methods like MAML aim to find good initialization points for quick adaptation.

Adapter-based fine-tuning: Introduces small “adapter” modules between pre-trained model layers, reducing trainable parameters.

Aprendizagem em contexto: Fine-tunes LLMs to better perform adaptation through prompts alone.

These techniques enable LLMs to adapt to new tasks with minimal data, enhancing their versatility and efficiency.

Prompting de poucos disparos vs. afinação: Escolher a abordagem correta

Ao adaptar os LLMs a tarefas específicas, tanto a solicitação de poucos disparos como o ajuste fino oferecem soluções poderosas. No entanto, cada método tem os seus próprios pontos fortes e limitações, e a escolha da abordagem correta depende de vários factores.

Few-Shot Prompting Strengths:

Não requer actualizações dos parâmetros do modelo, preservando o modelo original

Altamente flexível e pode ser adaptado em tempo real

Não é necessário tempo de formação ou recursos computacionais adicionais

Útil para prototipagem e experimentação rápidas

Limitações:

O desempenho pode ser menos consistente, especialmente em tarefas complexas

Limitado pelas capacidades e conhecimentos originais do modelo

Pode ter dificuldades em domínios ou tarefas altamente especializados

Fine-Tuning Strengths:

Obtém frequentemente um melhor desempenho em tarefas específicas

Pode adaptar o modelo a novos domínios e vocabulário especializado

Resultados mais consistentes em entradas semelhantes

Potencial de aprendizagem e melhoria contínuas

Limitações:

Requer tempo de formação e recursos computacionais adicionais

Risco de esquecimento catastrófico se não for cuidadosamente gerido

Pode ter um ajuste excessivo em pequenos conjuntos de dados

Menos flexível; requer reciclagem para mudanças significativas de tarefas

Top 5 Research Papers for Few-Shot Learning

This week, we also explore the following five papers that have significantly advanced this field, introducing innovative approaches that are reshaping AI capabilities.

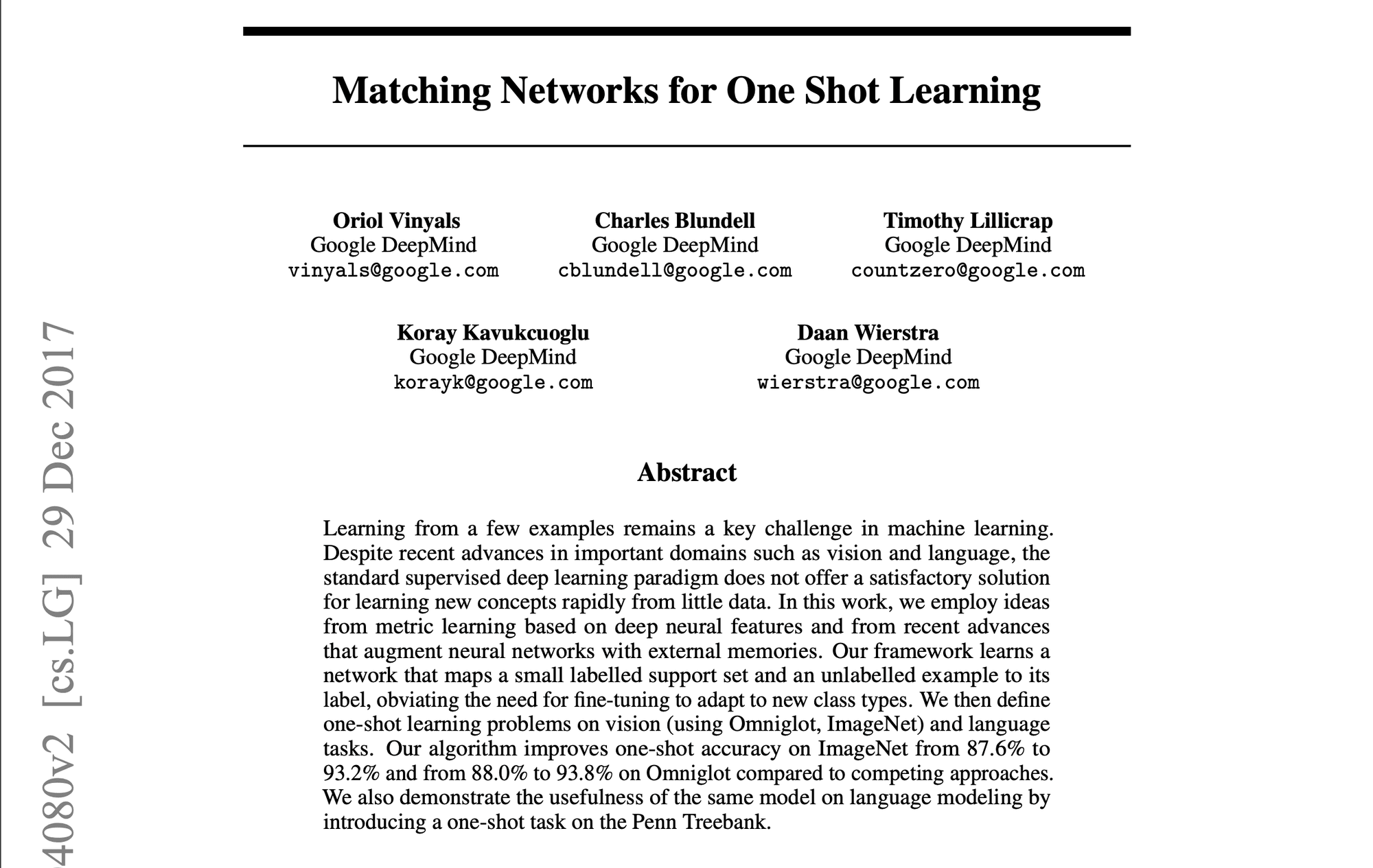

1️⃣ Matching Networks for One Shot Learning” (Vinyals et al., 2016)

Introduced a groundbreaking approach using memory and attention mechanisms. The matching function compares query examples to labeled support examples, setting a new standard for few-shot learning methods.

2️⃣ Prototypical Networks for Few-shot Learning” (Snell et al., 2017)

Presented a simpler yet effective approach, learning a metric space where classes are represented by a single prototype. Its simplicity and effectiveness made it a popular baseline for subsequent research.

3️⃣ Learning to Compare: Relation Network for Few-Shot Learning” (Sung et al., 2018)

Introduced a learnable relation module, allowing the model to learn a comparison metric tailored to specific tasks and data distributions. Demonstrated strong performance across various benchmarks.

4️⃣ A Closer Look at Few-shot Classification” (Chen et al., 2019)

Provided a comprehensive analysis of existing methods, challenging common assumptions. Proposed simple baseline models that matched or exceeded more complex approaches, emphasizing the importance of feature backbones and training strategies.

5️⃣ Meta-Baseline: Exploring Simple Meta-Learning for Few-Shot Learning” (Chen et al., 2021)

Combined standard pre-training with a meta-learning stage, achieving state-of-the-art performance. Highlighted the trade-offs between standard training and meta-learning objectives.

These papers have not only advanced academic research but also paved the way for practical applications in enterprise AI. They represent a progression towards more efficient, adaptable AI systems capable of learning from limited data – a crucial capability in many business contexts.

A linha de fundo

Few-shot learning, prompting, and fine-tuning represent groundbreaking approaches, enabling LLMs to adapt swiftly to specialized tasks with minimal data. As we’ve explored, these techniques offer unprecedented flexibility and efficiency in tailoring LLMs to diverse applications across industries, from enhancing natural language processing tasks to enabling domain-specific adaptations in fields like healthcare, law, and technology.

Obrigado por ler AI & YOU!

Para obter ainda mais conteúdos sobre IA empresarial, incluindo infográficos, estatísticas, guias de instruções, artigos e vídeos, siga o Skim AI em LinkedIn

É um Fundador, CEO, Capitalista de Risco ou Investidor que procura serviços de Consultoria de IA, Desenvolvimento de IA fraccionada ou Due Diligence? Obtenha a orientação necessária para tomar decisões informadas sobre a estratégia de produtos de IA da sua empresa e oportunidades de investimento.

Criamos soluções de IA personalizadas para empresas apoiadas por capital de risco e capital privado nos seguintes sectores: Tecnologia Médica, Agregação de Notícias/Conteúdo, Produção de Filmes e Fotos, Tecnologia Educacional, Tecnologia Jurídica, Fintech e Criptomoeda.