Meta's Llama 3.1: Ultrapassar os limites da IA de código aberto

A Meta anunciou recentemente Lhama 3.1O software de inteligência artificial (IA) da Microsoft, o seu modelo de grande linguagem (LLM) de código aberto mais avançado até à data. Este lançamento representa um marco significativo na democratização da tecnologia de IA, potencialmente colmatando o fosso entre modelos de código aberto e modelos proprietários.

O Llama 3.1 é um grande salto em frente nas capacidades de IA de código aberto. Com o seu modelo emblemático de 405 mil milhões de parâmetros, a Meta está a desafiar a noção de que a IA de ponta tem de ser de código fechado e proprietária. Este lançamento assinala uma nova era em que as capacidades de IA de ponta estão acessíveis a investigadores, programadores e empresas de todas as dimensões.

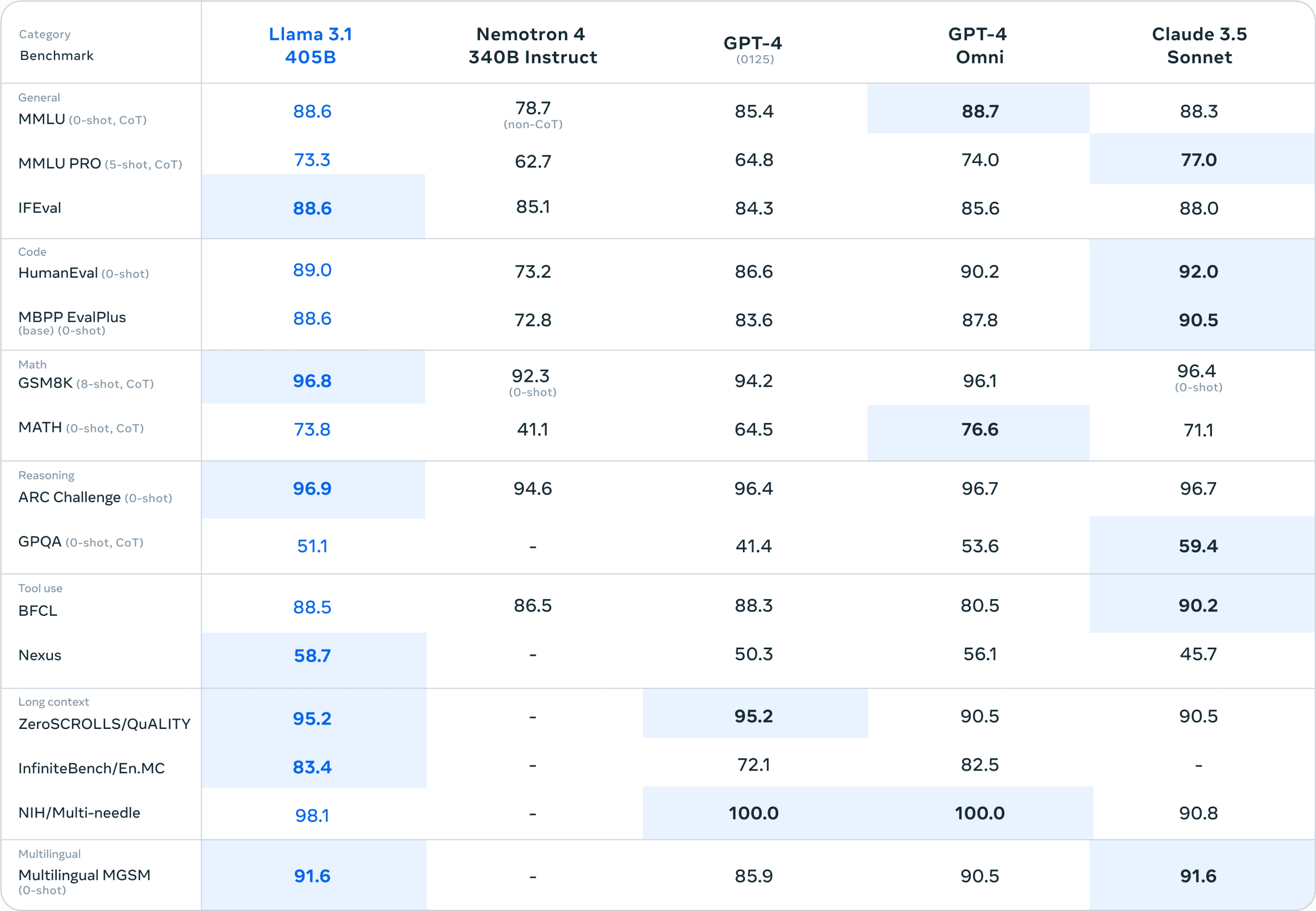

As principais melhorias na Llama 3.1 incluem um comprimento de contexto expandido de 128.000 tokens, suporte para oito idiomas e desempenho incomparável em áreas como raciocínio, matemática e geração de código. Esses avanços posicionam a Llama 3.1 como uma ferramenta versátil capaz de lidar com tarefas complexas do mundo real em vários domínios no ambiente corporativo.

A evolução do Llama: do 2 ao 3.1

Para apreciar o significado do Llama 3.1, vale a pena revisitar os seus antecessores. O Llama 2, lançado em 2023, já era um grande passo em frente na IA de código aberto. Oferecia modelos que variavam entre 7B e 70B parâmetros e demonstrava um desempenho competitivo em vários benchmarks.

A Llama 3.1 assenta nesta base com vários avanços importantes:

Aumento do tamanho do modelo: A introdução do modelo de parâmetros 405B alarga os limites do que é possível na IA de código aberto.

Comprimento do contexto alargado: De 4K tokens no Llama 2 para 128K no Llama 3.1, permitindo uma compreensão mais complexa e matizada de textos mais longos.

Capacidades multilingues: O suporte linguístico alargado permite aplicações mais diversificadas em diferentes regiões e casos de utilização.

Melhoria do raciocínio e das tarefas especializadas: Desempenho melhorado em áreas como o raciocínio matemático e a geração de código.

Quando comparado com modelos de código fechado, como o GPT-4 e o Claude 3.5 Sonnet, o Llama 3.1 405B mantém-se firme em vários benchmarks. Este nível de desempenho num modelo de código aberto não tem precedentes.

Especificações técnicas do Llama 3.1

Quanto aos pormenores técnicos, o Llama 3.1 oferece uma gama de tamanhos de modelos para se adaptar a diferentes necessidades e recursos computacionais:

Modelo de parâmetros 8B: Adequado para aplicações ligeiras e dispositivos de ponta.

Modelo de parâmetros 70B: Um equilíbrio entre os requisitos de desempenho e de recursos.

Modelo de parâmetros 405B: O modelo emblemático, que ultrapassa os limites das capacidades de IA de fonte aberta.

A metodologia de treino para o Llama 3.1 envolveu um conjunto de dados maciço de mais de 15 triliões de tokens, significativamente maior do que os seus antecessores. Estes dados de treino extensivos, combinados com técnicas refinadas de curadoria e pré-processamento de dados, contribuem para o melhor desempenho e versatilidade do modelo.

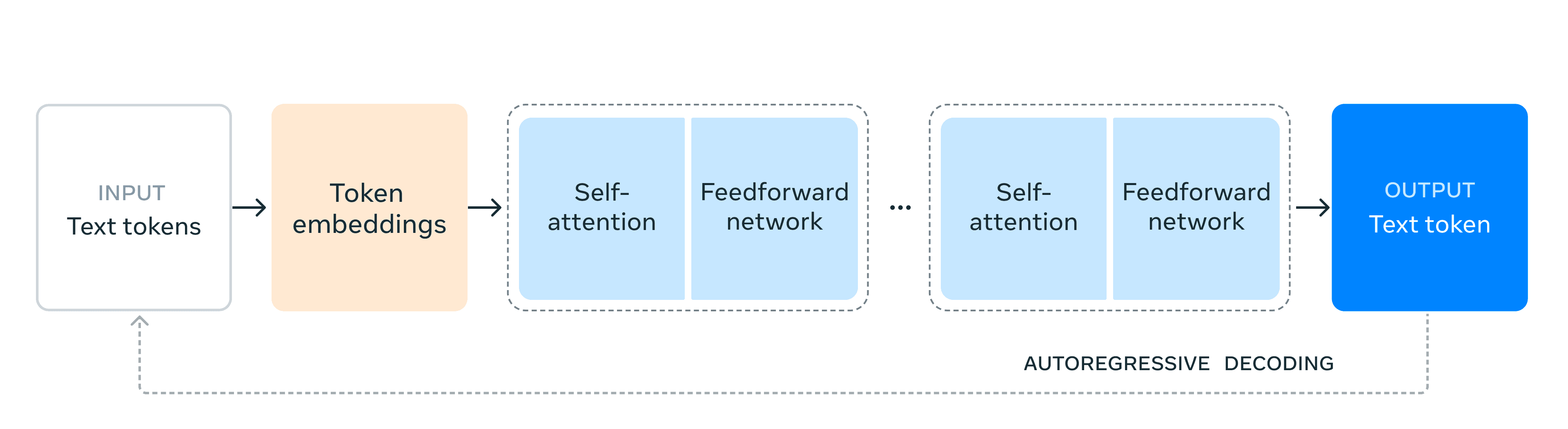

Arquitetonicamente, a Llama 3.1 mantém um modelo de transformador apenas de descodificador, dando prioridade à estabilidade do treino em detrimento de abordagens mais experimentais como a mistura de especialistas. No entanto, o Meta implementou várias optimizações para permitir uma formação e inferência eficientes a esta escala sem precedentes:

Infraestrutura de formação escalável: Utilizando mais de 16.000 GPUs H100 para treinar o modelo 405B.

Procedimento iterativo de pós-treino: Utilizar a afinação supervisionada e a otimização direta das preferências para melhorar capacidades específicas.

Técnicas de quantização: Reduzir o modelo de 16 bits para 8 bits numéricos para uma inferência mais eficiente, permitindo a implementação em nós de servidor único.

Estas escolhas técnicas reflectem um equilíbrio entre ultrapassar os limites da dimensão do modelo e garantir uma utilização prática numa série de cenários de implantação.

Ao disponibilizar abertamente estes modelos avançados, a Meta não está apenas a partilhar um produto, mas a fornecer uma plataforma para a inovação. As especificações técnicas do Llama 3.1 abrem novas possibilidades para os investigadores e programadores explorarem aplicações de IA de ponta, acelerando o ritmo do avanço da IA em toda a indústria.

Capacidades inovadoras

O Llama 3.1 apresenta várias capacidades inovadoras que o distinguem no panorama da IA:

Comprimento do contexto expandido

O salto para uma janela de contexto de token de 128K é um divisor de águas. Esta capacidade alargada permite à Llama 3.1 processar e compreender textos muito mais longos, permitindo:

Análise exaustiva de documentos

Geração de conteúdos de formato longo

Tratamento de conversas com mais nuances

Esta funcionalidade abre novas possibilidades para aplicações em áreas como o processamento de documentos jurídicos, a análise de literatura e a resolução de problemas complexos que exijam a retenção e a síntese de grandes quantidades de informação.

Suporte multilingue

O suporte da Llama 3.1 para oito línguas alarga significativamente a sua aplicabilidade global. Esta capacidade multilingue:

Melhora a comunicação intercultural

Permite aplicações de IA mais inclusivas

Apoia as operações comerciais globais

Ao quebrar as barreiras linguísticas, o Llama 3.1 abre caminho a soluções de IA mais diversificadas e orientadas para o mundo.

Raciocínio avançado e utilização de ferramentas

O modelo demonstra capacidades de raciocínio sofisticadas e a capacidade de utilizar eficazmente ferramentas externas. Este avanço manifesta-se em:

Melhoria da dedução lógica e da resolução de problemas

Capacidade acrescida de seguir instruções complexas

Utilização eficaz de bases de conhecimento externas e APIs

Estas capacidades fazem do Llama 3.1 uma ferramenta poderosa para tarefas que exigem competências cognitivas de alto nível, desde o planeamento estratégico à análise de dados complexos.

Geração de código e habilidade matemática

O Llama 3.1 demonstra capacidades notáveis nos domínios técnicos:

Geração de código funcional de alta qualidade em várias linguagens de programação

Resolver problemas matemáticos complexos com exatidão

Assistência na conceção e otimização de algoritmos

Estas características posicionam o Llama 3.1 como um ativo valioso para o desenvolvimento de software, computação científica e aplicações de engenharia.

A vantagem do código aberto

A natureza de código aberto da Llama 3.1 traz vários benefícios significativos.

Ao disponibilizar gratuitamente capacidades de IA de ponta, a Meta está a fazê-lo:

Reduzir os obstáculos à entrada na investigação e no desenvolvimento da IA

Permitir que as organizações mais pequenas e os programadores individuais tirem partido da IA avançada

Promover um ecossistema de IA mais diversificado e inovador

Esta democratização poderá conduzir a uma proliferação de aplicações de IA em vários sectores, acelerando potencialmente o progresso tecnológico.

A capacidade de aceder e modificar os pesos dos modelos da Llama 3.1 abre oportunidades de personalização sem precedentes:

Adaptação a domínios específicos para indústrias especializadas

Ajuste fino para casos de utilização e conjuntos de dados únicos

Experimentação de novas técnicas e arquitecturas de formação

Esta flexibilidade permite que as organizações adaptem o modelo às suas necessidades específicas, conduzindo potencialmente a soluções de IA mais eficazes e eficientes.

Ecossistema e implantação

O lançamento da Llama 3.1 é acompanhado por um ecossistema robusto para apoiar a sua implantação e utilização:

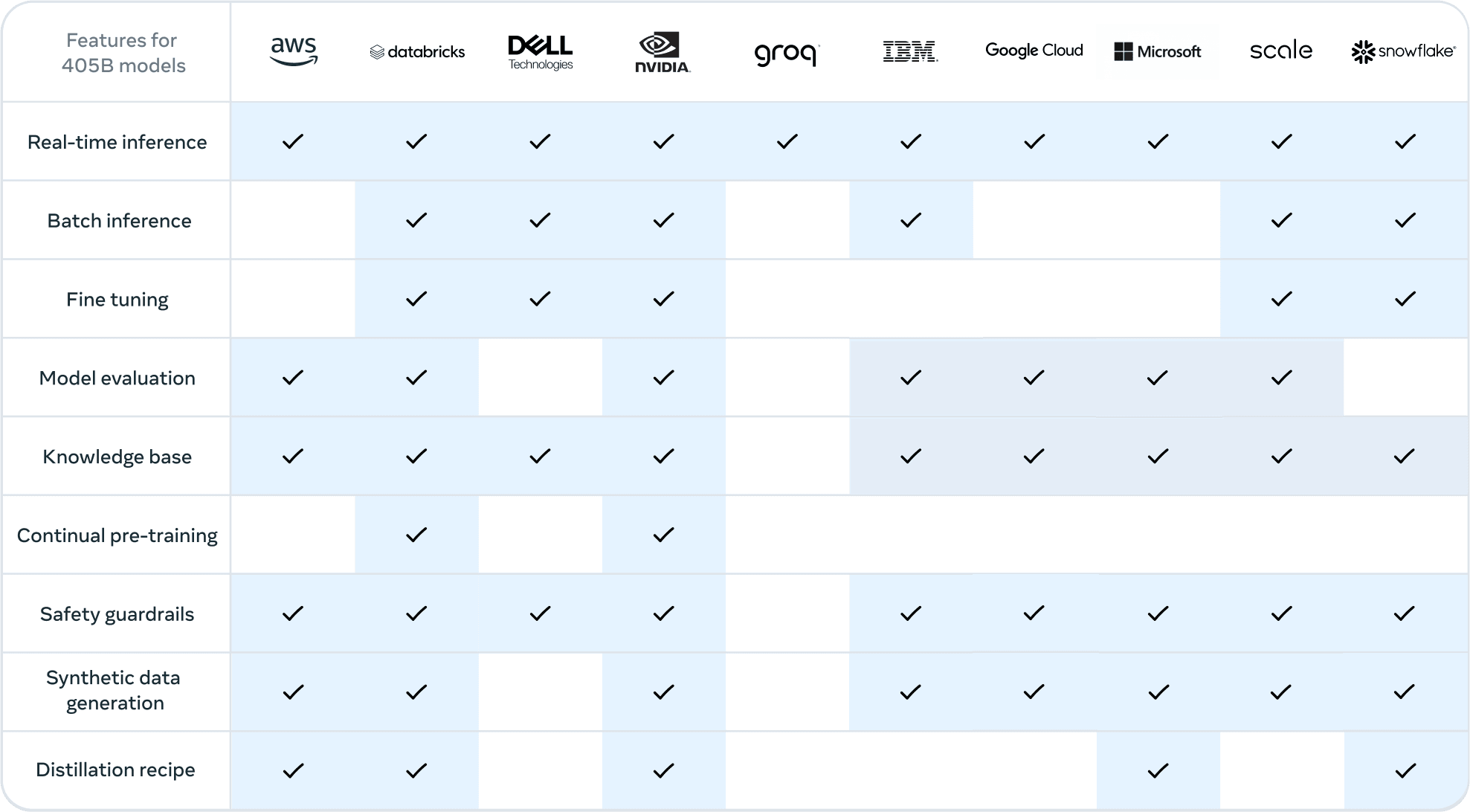

Integrações de parceiros

A Meta colaborou com os líderes do sector para garantir um apoio alargado à Llama 3.1:

Os fornecedores de serviços na nuvem, como o AWS, o Google Cloud e o Azure, oferecem opções de implementação sem descontinuidades

Os fabricantes de hardware, como a NVIDIA e a Dell, fornecem uma infraestrutura optimizada

Plataformas de dados como Databricks e Snowflake permitem o processamento eficiente de dados e a integração de modelos

Essas parcerias garantem que as organizações possam aproveitar a Llama 3.1 em seus conjuntos de tecnologia existentes.

Otimização e escalabilidade da inferência

Para tornar a Llama 3.1 prática para as aplicações do mundo real, foram implementadas várias optimizações:

As técnicas de quantização reduzem os requisitos computacionais do modelo

Motores de inferência optimizados como o vLLM e o TensorRT aumentam o desempenho

As opções de implementação escaláveis respondem a vários casos de utilização, desde dispositivos periféricos a centros de dados

Estas optimizações tornam viável a implementação até do modelo de parâmetros 405B em ambientes de produção.

A pilha Llama e os esforços de normalização

A Meta está a promover a normalização no ecossistema de IA:

A Llama Stack proposta tem por objetivo criar uma interface comum para os componentes de IA

As API normalizadas poderão facilitar a integração e a interoperabilidade entre diferentes ferramentas e plataformas de IA

Esta iniciativa poderá conduzir a um ecossistema de desenvolvimento de IA mais coeso e eficiente

Promessas e potencialidades da Llama 3.1

O lançamento do Llama 3.1 pela Meta marca um momento crucial no panorama da IA, democratizando o acesso a capacidades de IA de nível avançado. Ao oferecer um modelo de parâmetros 405B com desempenho de ponta, suporte multilingue e comprimento de contexto alargado, tudo numa estrutura de código aberto, a Meta estabeleceu um novo padrão para uma IA acessível e poderosa. Este passo não só desafia o domínio dos modelos de código fechado, como também abre caminho a uma inovação e colaboração sem precedentes na comunidade de IA.

Ao nos encontrarmos nesta encruzilhada do desenvolvimento de IA, a Llama 3.1 representa mais do que apenas um avanço tecnológico; ela incorpora uma visão de um futuro mais aberto, inclusivo e dinâmico para a inteligência artificial. O verdadeiro impacto desta versão será revelado à medida que os programadores, investigadores e empresas de todo o mundo aproveitarem o seu potencial, remodelando as indústrias e ultrapassando os limites do que é possível fazer com os LLM.