Como é que o AgentOps ajuda a gerir os custos do LLM

Como Agentes de IA À medida que os agentes de IA se tornam cada vez mais prevalecentes nas soluções empresariais, a gestão dos custos do Modelo de Linguagem Grande (LLM) surgiu como uma preocupação crítica tanto para os programadores como para as empresas. Os LLMs, embora poderosos, podem ser dispendiosos de operar, especialmente em escala. A importância crescente da gestão dos custos dos LLM no desenvolvimento de agentes de IA não pode ser exagerada, uma vez que tem um impacto direto na viabilidade e...

Acompanhamento e otimização Utilização do LLM apresenta vários desafios. Os programadores têm de navegar no complexo panorama do consumo de tokens, equilibrando a necessidade de capacidades sofisticadas de IA com restrições orçamentais. Além disso, a natureza dinâmica das interacções dos agentes de IA torna difícil prever e controlar os custos de forma eficaz. Estes desafios sublinham a necessidade de ferramentas e estratégias robustas para gerir as despesas de LLM, mantendo agentes de IA de elevado desempenho.

- Recursos abrangentes de gerenciamento de custos do LLM do AgentOps

- Análise detalhada e otimização de custos

- Integração com estruturas de agentes de IA

- Equilíbrio entre desempenho e custo no desenvolvimento de agentes de IA

- Segurança e conformidade na gestão de custos do LLM

- Potenciar o desenvolvimento de agentes de IA com uma boa relação custo-eficácia

Recursos abrangentes de gerenciamento de custos do LLM do AgentOps

AgenteOps oferece um conjunto de funcionalidades poderosas concebidas para lidar com as complexidades da gestão de custos do LLM. No centro dessas capacidades está o rastreamento em tempo real do uso e gasto de tokens. Esse recurso permite que os desenvolvedores monitorem os custos à medida que eles ocorrem, fornecendo visibilidade imediata de como os agentes de IA estão consumindo recursos do LLM. Ao oferecer esse nível de granularidade, o AgentOps capacita os desenvolvedores a tomar decisões informadas sobre alocação e otimização de recursos em tempo real.

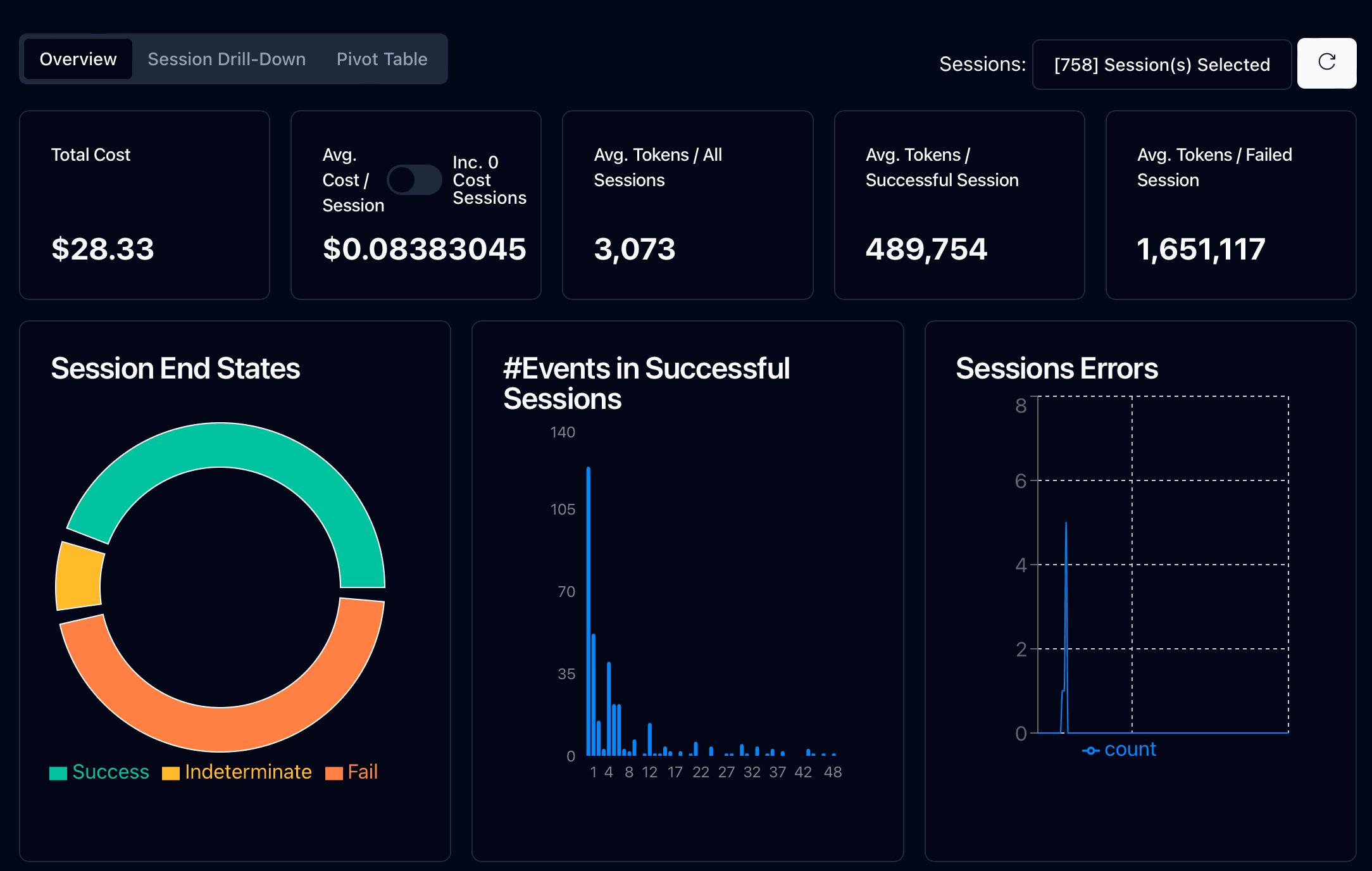

O painel de análise para monitoramento de custos é outro componente-chave do kit de ferramentas de gerenciamento de custos do LLM do AgentOps. Essa interface intuitiva apresenta estatísticas e métricas de alto nível sobre agentes em ambientes de desenvolvimento e produção. Os programadores podem acompanhar facilmente os custos, as contagens de tokens, a latência e as taxas de sucesso/falha, obtendo uma visão abrangente do desempenho e do impacto económico dos seus agentes de IA.

Um dos recursos mais valiosos do AgentOps é a instrumentação automática de provedores LLM populares. Após um simples processo de inicialização, o AgentOps se integra perfeitamente a provedores como OpenAI, Cohere e LiteLLM. Essa automação reduz significativamente a carga sobre os desenvolvedores, permitindo que eles capturem dados detalhados de custo e uso em chamadas LLM sem esforço adicional. O resultado é um processo de desenvolvimento mais simplificado e um acompanhamento de custos mais preciso.

Análise detalhada e otimização de custos

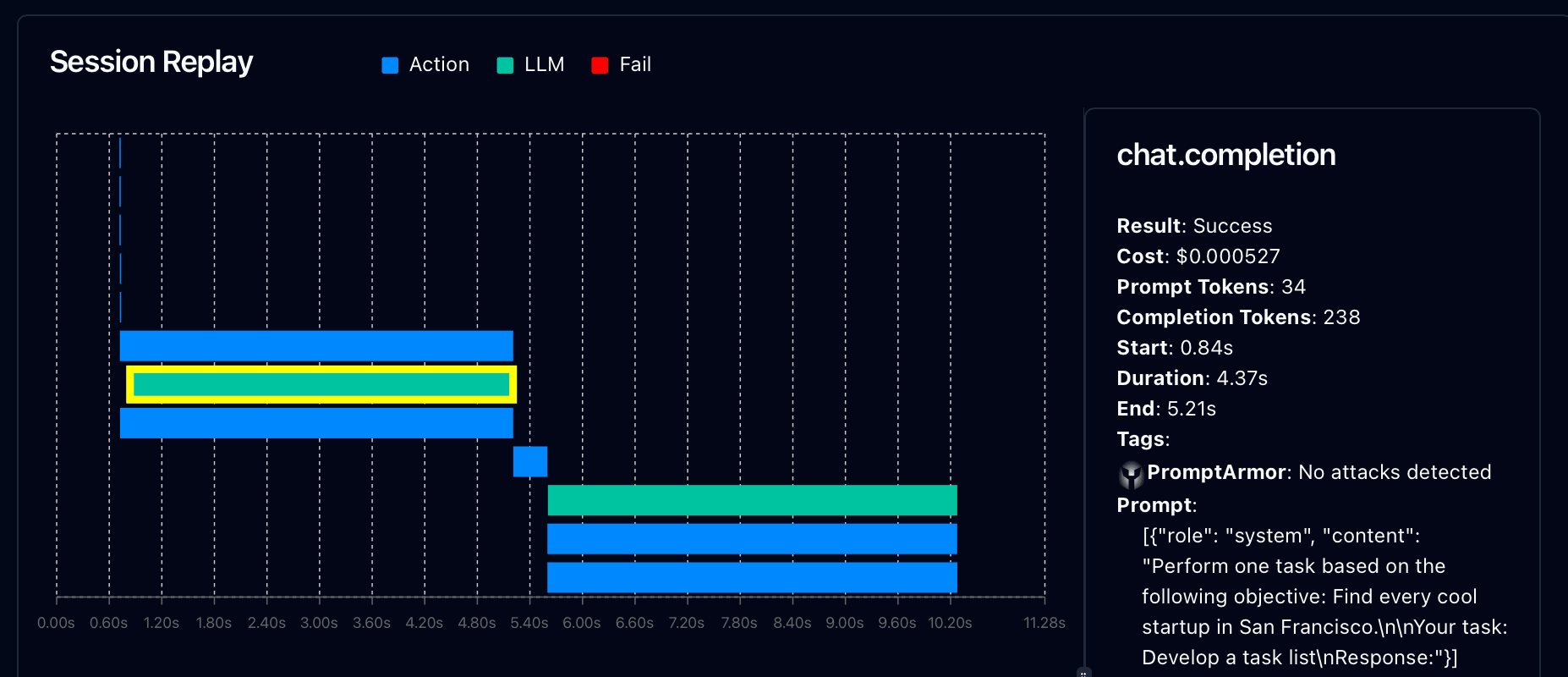

O AgentOps vai além do acompanhamento básico dos custos, oferecendo ferramentas de análise aprofundada para otimização. A plataforma fornece drilldowns e replays de sessão, oferecendo insights granulares de custo em cada interação de agente de IA. Os desenvolvedores podem examinar detalhes passo a passo da execução do agente, incluindo prompts LLM específicos, conclusões, uso de token e custos associados. Este nível de detalhe é inestimável para identificar áreas de ineficiência e oportunidades de redução de custos.

A identificação de chamadas e padrões de utilização ineficientes do LLM é crucial para otimizar os custos. As ferramentas de análise do AgentOps ajudam os desenvolvedores a identificar instâncias em que os agentes de IA podem estar usando demais os recursos do LLM ou fazendo chamadas desnecessárias. Ao destacar essas ineficiências, o AgentOps permite que os desenvolvedores refinem seus projetos de agentes e solicitações para uma operação mais econômica.

O AgentOps também fornece estratégias para reduzir o consumo de tokens, um fator-chave na gestão dos custos de LLM. A plataforma oferece recomendações baseadas em padrões de utilização, sugerindo formas de afinar os avisos e otimizar as interacções dos agentes. Estas estratégias podem incluir técnicas para uma maior eficiência engenharia rápidamelhor gestão do contexto ou armazenamento em cache mais inteligente das respostas LLM. Ao implementar estas optimizações, os programadores podem reduzir significativamente os seus custos de LLM sem comprometer o desempenho do agente.

Integração com estruturas de agentes de IA

O poder do AgentOps na gestão dos custos de LLM é ampliado pela sua integração perfeita com estruturas populares de agentes de IA. Essa integração permite que os desenvolvedores monitorem e otimizem os custos em várias arquiteturas de agentes sem interromper seus fluxos de trabalho existentes.

O AgentOps fornece capacidades de monitorização de custos incorporadas para várias estruturas chave:

CrewAI: Ideal para sistemas multi-agentes onde a utilização de LLM pode acumular-se rapidamente

AutoGen: Permite o controlo de custos para interacções automatizadas de agentes de IA

LangChain: Oferece informações sobre custos para cadeias e aplicações de modelos linguísticos

As principais vantagens da integração da estrutura do AgentOps incluem:

Configuração mínima necessária para visibilidade instantânea dos custos de LLM

Acompanhamento dos custos de todos os agentes de um sistema ou de uma equipa

Identificação de agentes ou interacções com utilização intensiva de recursos

Visibilidade entre estruturas para uma melhor afetação de recursos

Tomada de decisões informadas sobre a seleção de quadros para tarefas específicas

Ao simplificar a gestão de custos em diferentes arquitecturas de agentes, o AgentOps permite que os programadores escolham as soluções mais rentáveis para as suas aplicações de agentes de IA. Esta integração é crucial para as organizações que procuram otimizar os seus investimentos em IA em várias plataformas e casos de utilização.

Equilíbrio entre desempenho e custo no desenvolvimento de agentes de IA

Um dos aspectos mais difíceis do desenvolvimento de agentes de IA é encontrar o equilíbrio certo entre desempenho e custo. O AgentOps fornece ferramentas para ajudar os programadores a navegar neste complexo equilíbrio.

O AgentOps oferece informações sobre a correlação entre o uso de tokens e o desempenho do agente. Ao analisar essa relação, os desenvolvedores podem identificar o ponto ideal em que o aumento do uso de tokens não produz mais melhorias significativas no desempenho. Esse entendimento é crucial para otimizar os agentes de IA para fornecer o máximo de valor com o mínimo de custo.

O teste A/B para otimização do custo-desempenho é outra caraterística poderosa do AgentOps. Os desenvolvedores podem executar testes paralelos com diferentes configurações de agente, estratégias de solicitação ou opções de modelo para determinar qual abordagem oferece a melhor relação entre desempenho e custo. Este método orientado por dados elimina a adivinhação da otimização, permitindo a tomada de decisões baseadas em provas no desenvolvimento de agentes.

Definir e gerenciar limites de orçamento é um aspeto crítico do gerenciamento de custos do LLM que o AgentOps simplifica. Os desenvolvedores podem estabelecer limites de custo para agentes individuais, projetos ou sistemas inteiros de IA. O AgentOps fornece alertas em tempo real quando estes limites se aproximam ou são ultrapassados, permitindo um controlo proactivo dos custos. Esta funcionalidade é particularmente valiosa para as empresas que trabalham com orçamentos fixos de IA ou que procuram escalar gradualmente as suas operações de IA.

Segurança e conformidade na gestão de custos do LLM

À medida que os agentes de IA lidam com tarefas e dados cada vez mais sensíveis, a segurança e a conformidade na gestão de custos tornam-se fundamentais. O AgentOps aborda estas preocupações de frente, garantindo que o controlo de custos não compromete a privacidade dos dados ou a conformidade regulamentar.

Garantir a privacidade dos dados no controlo de custos é um princípio fundamental do AgentOps. A plataforma foi concebida para captar métricas relacionadas com os custos sem expor informações sensíveis contidas em avisos ou respostas. Esta separação permite uma gestão abrangente dos custos sem correr o risco de violações de dados ou de políticas de privacidade.

Para as empresas que operam em sectores regulamentados, a conformidade com os regulamentos financeiros é crucial. O AgentOps ajuda a navegar por esses requisitos complexos, fornecendo trilhas de auditoria detalhadas do uso do LLM e dos custos associados. Estes registos podem ser inestimáveis para demonstrar gastos responsáveis com IA e cumprir as normas de relatórios financeiros.

Além disso, os recursos de conformidade do AgentOps se estendem aos regulamentos de proteção de dados, como GDPR e HIPAA. A plataforma garante que os processos de rastreamento e otimização de custos estejam alinhados com esses requisitos rigorosos de tratamento de dados, dando às empresas a confiança para implantar agentes de IA em ambientes sensíveis sem comprometer os recursos de gerenciamento de custos.

Potenciar o desenvolvimento de agentes de IA com uma boa relação custo-eficácia

O AgentOps é uma ferramenta fundamental no cenário em evolução do desenvolvimento de agentes de IA, oferecendo uma solução abrangente para gerenciar os custos de LLM sem comprometer o desempenho ou a segurança. Ao fornecer rastreamento de custos em tempo real, análises detalhadas e integração perfeita com estruturas populares como CrewAI e AutoGen, o AgentOps capacita os desenvolvedores a tomar decisões informadas sobre alocação e otimização de recursos.

A capacidade da plataforma de equilibrar o desempenho com a relação custo-benefício, juntamente com recursos robustos de segurança e conformidade, torna-a um ativo valioso para empresas que buscam alavancar agentes de IA de forma sustentável. À medida que a IA continua a transformar as indústrias, o AgentOps garante que as organizações podem aproveitar todo o potencial dos LLMs, mantendo o controlo sobre os seus orçamentos, abrindo caminho para uma implementação de agentes de IA mais eficiente, económica e responsável.