As 10 melhores maneiras de eliminar as alucinações do LLM

À medida que os modelos de linguagem de grande dimensão (LLM) continuam a perturbar quase todos os domínios e sectores, trazem consigo um desafio único: as alucinações. Estas imprecisões geradas pela IA representam um risco significativo para a fiabilidade e credibilidade dos resultados dos LLM.

O que são alucinações LLM?

As alucinações dos LLM ocorrem quando estes poderosos modelos linguísticos geram texto factualmente incorreto, sem sentido ou não relacionado com os dados de entrada. Apesar de parecerem coerentes e confiantes, os conteúdos alucinados podem conduzir a desinformação, a tomadas de decisão erradas e a uma perda de confiança nas aplicações baseadas em IA.

Como os sistemas de IA são cada vez mais integrar em vários aspectos das nossas vidas, desde chatbots de atendimento ao cliente até ferramentas de criação de conteúdosPor isso, a necessidade de mitigar as alucinações torna-se fundamental. As alucinações não controladas podem resultar em danos para a reputação, problemas legais e potenciais danos para os utilizadores que confiam na informação gerada pela IA.

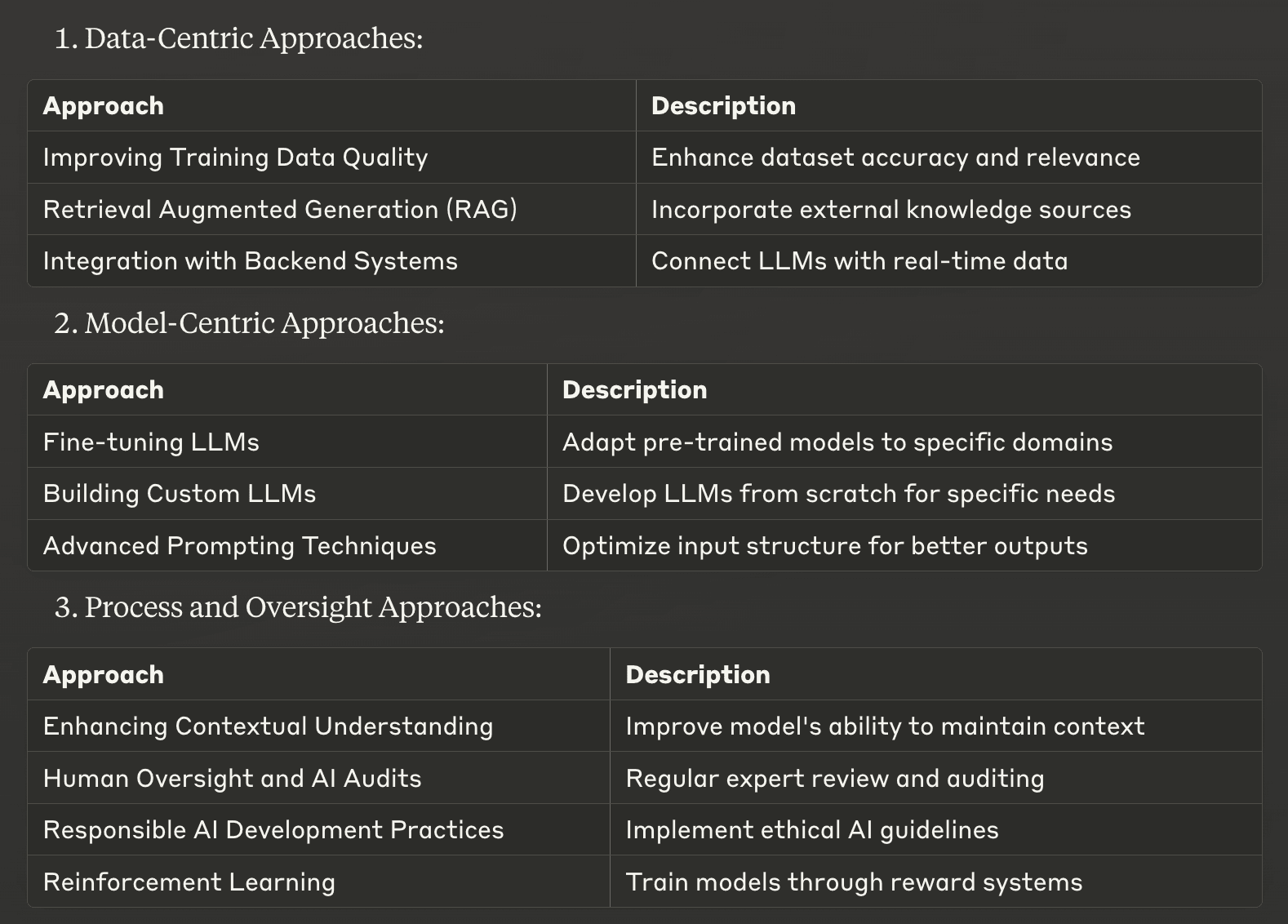

Compilámos uma lista das 10 principais estratégias para mitigar as alucinações do LLM, desde abordagens centradas nos dados a técnicas centradas em modelos e métodos orientados para o processo. Estas estratégias foram concebidas para ajudar as empresas e os programadores a melhorar a precisão factual e a fiabilidade dos seus sistemas de IA.

Abordagens centradas nos dados

1. Melhorar a qualidade dos dados de formação

Uma das formas mais fundamentais de atenuar as alucinações é melhorar a qualidade dos dados de treino utilizados para desenvolver modelos linguísticos de grande dimensão. Conjuntos de dados de alta qualidade, diversificados e bem seleccionados podem reduzir significativamente a probabilidade de os LLM aprenderem e reproduzirem informações incorrectas.

Para implementar esta estratégia, concentre-se em:

Verificação cuidadosa da exatidão e relevância das fontes de dados

Assegurar uma representação equilibrada de temas e perspectivas

Atualizar regularmente os conjuntos de dados para incluir informações actuais

Remoção de pontos de dados duplicados ou contraditórios

Ao investir em dados de formação de qualidade superior, está a criar uma base sólida para resultados de LLM mais fiáveis e precisos.

2. Geração Aumentada de Recuperação (RAG)

Geração Aumentada de Recuperação (RAG) é uma técnica poderosa que combina os pontos fortes das abordagens baseadas na recuperação e na geração. Este método permite que os LLM acedam e incorporem informações relevantes de fontes de conhecimento externas durante o processo de geração de texto.

A RAG trabalha por:

Recuperação de informações relevantes a partir de uma base de conhecimentos com curadoria

Integrar esta informação no contexto fornecido ao LLM

Gerar respostas baseadas em informações factuais e actualizadas

Ao implementar o RAG, as empresas podem reduzir significativamente as alucinações, ancorando as respostas LLM a fontes de informação externas e fiáveis. Esta abordagem é particularmente eficaz para aplicações de domínios específicos em que a precisão é crucial, como nos sistemas de IA jurídicos ou médicos.

3. Integração com sistemas backend

A integração de LLMs com os sistemas backend existentes de uma empresa pode melhorar drasticamente a precisão e a relevância do conteúdo gerado pela IA. Esta abordagem permite que o LLM aceda a dados em tempo real e específicos do contexto diretamente a partir das bases de dados ou APIs da empresa.

As principais vantagens da integração backend incluem:

Garantir que as respostas se baseiam nas informações mais actuais

Fornecer resultados personalizados e contextualmente relevantes

Reduzir a dependência de dados de formação potencialmente desactualizados

Por exemplo, um chatbot de comércio eletrónico integrado no sistema de inventário da empresa pode fornecer informações precisas e em tempo real sobre a disponibilidade dos produtos, reduzindo o risco de respostas alucinadas sobre níveis de stock ou preços.

Ao implementar estas abordagens centradas nos dados, as empresas podem aumentar significativamente a fiabilidade dos seus resultados de LLM, atenuando o risco de alucinações e melhorando o desempenho geral do sistema de IA.

Abordagens centradas em modelos

4. Ajuste fino de LLMs

O ajuste fino é uma técnica poderosa para adaptar modelos linguísticos de grande dimensão pré-treinados a domínios ou tarefas específicos. Este processo envolve o treino adicional do LLM num conjunto de dados mais pequeno e cuidadosamente selecionado, relevante para a aplicação-alvo. O ajuste fino pode reduzir significativamente as alucinações, alinhando os resultados do modelo com o conhecimento e a terminologia específicos do domínio.

As principais vantagens do ajuste fino incluem:

Maior precisão em campos especializados

Melhor compreensão do jargão específico do sector

Redução da probabilidade de gerar informações irrelevantes ou incorrectas

Por exemplo, um assistente de IA jurídica aperfeiçoado num corpus de documentos jurídicos e de jurisprudência terá menos probabilidades de alucinar ao responder a questões jurídicas, melhorando a sua fiabilidade e utilidade no domínio jurídico.

5. Construir LLMs personalizados

Para organizações com recursos substanciais e necessidades específicas, a criação de modelos de linguagem de grande porte personalizados a partir do zero pode ser uma forma eficaz de atenuar as alucinações. Esta abordagem permite um controlo total sobre os dados de formação, a arquitetura do modelo e o processo de aprendizagem.

Vantagens de LLMs personalizados incluir:

Base de conhecimentos adaptada e alinhada com as necessidades da empresa

Redução do risco de incorporação de informações irrelevantes ou inexactas

Maior controlo sobre o comportamento e os resultados do modelo

Embora esta abordagem exija recursos e conhecimentos computacionais significativos, pode resultar em sistemas de IA altamente precisos e fiáveis no domínio de funcionamento previsto.

6. Técnicas avançadas de solicitação

Técnicas sofisticadas de estímulo podem orientar os modelos linguísticos para gerar textos mais precisos e coerentes, reduzindo efetivamente as alucinações. Estes métodos ajudam a estruturar a entrada de dados de forma a obter resultados mais fiáveis do sistema de IA.

Algumas técnicas eficazes de estímulo incluem:

Incitamento à cadeia de pensamento: Incentiva o raciocínio passo a passo

Aprendizagem com poucos disparos: Fornece exemplos para orientar as respostas do modelo

Ao elaborar cuidadosamente os avisos, os programadores podem melhorar significativamente a exatidão factual e a relevância do conteúdo gerado pelo LLM, minimizando a ocorrência de alucinações.

Abordagens de processo e supervisão

7. Melhorar a compreensão do contexto

Melhorar a capacidade de um LLM para manter o contexto ao longo de uma interação pode reduzir significativamente as alucinações. Isto implica a implementação de técnicas que ajudem o modelo a seguir e a utilizar informações relevantes durante conversas prolongadas ou tarefas complexas.

As principais estratégias incluem:

Resolução de coreferências: Ajudar o modelo a identificar e ligar entidades relacionadas

Acompanhamento do histórico de conversações: Garantir a tomada em consideração dos intercâmbios anteriores

Modelação avançada do contexto: Permitir que o modelo se concentre em informações relevantes

Estas técnicas ajudam os LLM a manter a coerência e a consistência, reduzindo a probabilidade de gerar informações contraditórias ou irrelevantes.

8. Supervisão humana e auditorias de IA

A implementação da supervisão humana e a realização de auditorias regulares à IA são cruciais para identificar e tratar as alucinações nos resultados do LLM. Esta abordagem combina conhecimentos humanos com capacidades de IA para garantir o mais elevado nível de precisão e fiabilidade.

As práticas de supervisão eficazes incluem:

Revisão regular do conteúdo gerado pela IA por especialistas no domínio

Implementação de circuitos de feedback para melhorar o desempenho do modelo

Realização de auditorias exaustivas para identificar padrões de alucinação

Ao manter o envolvimento humano no processo de IA, as organizações podem detetar e corrigir alucinações que, de outra forma, poderiam passar despercebidas, aumentando a fiabilidade global dos seus sistemas de IA.

9. Práticas responsáveis de desenvolvimento de IA

A adoção de práticas responsáveis de desenvolvimento de IA é essencial para criar LLMs menos propensos a alucinações. Esta abordagem enfatiza as considerações éticas, a transparência e a responsabilidade ao longo do ciclo de vida do desenvolvimento da IA.

Os principais aspectos do desenvolvimento responsável da IA incluem:

Dar prioridade à equidade e a dados de formação imparciais

Implementação de processos sólidos de teste e validação

Garantir a transparência nos processos de tomada de decisões sobre IA

Ao aderir a estes princípios, as organizações podem desenvolver sistemas de IA que sejam mais fiáveis, dignos de confiança e menos susceptíveis de produzir resultados prejudiciais ou enganadores.

10. Aprendizagem por reforço

A aprendizagem por reforço oferece uma abordagem promissora para atenuar as alucinações nos LLMs. Esta técnica envolve o treino de modelos através de um sistema de recompensas e penalizações, encorajando os comportamentos desejados e desencorajando os indesejados.

Benefícios da aprendizagem por reforço na atenuação de alucinações:

Alinhamento dos resultados do modelo com objectivos de precisão específicos

Melhorar a capacidade de auto-correção do modelo

Melhorar a qualidade geral e a fiabilidade do texto gerado

Ao implementar técnicas de aprendizagem por reforço, os programadores podem criar LLMs mais aptos a evitar alucinações e a produzir conteúdos factualmente exactos.

Estas abordagens centradas no modelo e orientadas para o processo fornecem ferramentas poderosas para atenuar as alucinações em grandes modelos de linguagem. Ao combinar estas estratégias com as abordagens centradas nos dados discutidas anteriormente, as organizações podem melhorar significativamente a fiabilidade e a precisão dos seus sistemas de IA, abrindo caminho para aplicações de IA mais fiáveis e eficazes.

Implementação de estratégias eficazes de atenuação de alucinações

Como explorámos as 10 principais formas de mitigar as alucinações em modelos de linguagem de grande dimensão, é evidente que enfrentar este desafio é crucial para desenvolver sistemas de IA fiáveis. A chave para o sucesso está na implementação cuidadosa destas estratégias, adaptadas às suas necessidades e recursos específicos. Ao escolher a abordagem correcta, tenha em conta os seus requisitos específicos e os tipos de alucinações com que se depara. Algumas estratégias, como a melhoria da qualidade dos dados de formação, podem ser simples de adotar, enquanto outras, como a criação de LLMs personalizados, podem exigir investimentos significativos.

É essencial equilibrar a eficácia e os requisitos de recursos. Muitas vezes, uma combinação de estratégias fornece a solução óptima, permitindo-lhe aproveitar várias abordagens enquanto gere as restrições. Por exemplo, a combinação de RAG com técnicas avançadas de solicitação pode produzir melhorias significativas sem a necessidade de uma reciclagem extensiva do modelo.

À medida que a inteligência artificial continua a evoluir, o mesmo acontece com os métodos de atenuação das alucinações. Ao manter-se informado sobre os últimos desenvolvimentos e ao aperfeiçoar continuamente a sua abordagem, pode garantir que os seus sistemas de IA permanecem na vanguarda da precisão e fiabilidade. Lembre-se, o objetivo não é apenas gerar texto, mas criar resultados LLM em que os utilizadores possam confiar e depender, abrindo caminho para aplicações de IA mais eficazes e responsáveis em várias indústrias.

Se precisar de ajuda para atenuar as alucinações do LLM, não hesite em contactar-nos na Skim AI.