Repartição de documentos de investigação de IA para ChainPoll: um método de elevada eficácia para a deteção de alucinações LLM

Neste artigo, vamos analisar um importante trabalho de investigação que aborda um dos desafios mais prementes dos modelos de linguagem de grande dimensão (LLM): as alucinações. O artigo, intitulado "ChainPoll: Um método de alta eficácia para a deteção de alucinações LLMintroduz uma nova abordagem para identificar e atenuar estas imprecisões geradas pela IA.

O documento ChainPoll, da autoria de investigadores da Galileo Technologies Inc., apresenta uma nova metodologia para a deteção de alucinações em resultados de LLM. Este método, denominado ChainPoll, supera as alternativas existentes tanto em termos de precisão como de eficiência. Além disso, o documento apresenta o RealHall, um conjunto de conjuntos de dados de referência cuidadosamente seleccionados, concebido para avaliar a métrica de deteção de alucinações de forma mais eficaz do que as referências anteriores.

As alucinações nos LLMs referem-se a casos em que estes modelos de IA geram texto factualmente incorreto, sem sentido ou não relacionado com os dados de entrada. À medida que os LLM são cada vez mais integrados em várias aplicações, desde chatbots a ferramentas de criação de conteúdos, o risco de propagação de desinformação através destas alucinações aumenta exponencialmente. Esta questão representa um desafio significativo para a fiabilidade e a credibilidade dos conteúdos gerados por IA.

A capacidade de detetar e mitigar com precisão as alucinações é crucial para a implantação responsável de sistemas de IA. Esta investigação fornece um método mais robusto para identificar estes erros, o que pode levar a uma maior fiabilidade dos conteúdos gerados pela IA, a uma maior confiança dos utilizadores nas aplicações de IA e a um menor risco de disseminação de desinformação através dos sistemas de IA. Ao abordar o problema da alucinação, esta investigação abre caminho a aplicações de IA mais fiáveis e dignas de confiança em vários sectores.

Antecedentes e definição do problema

A deteção de alucinações em resultados de LLM é uma tarefa complexa devido a vários factores. O grande volume de texto que os LLMs podem gerar, combinado com a natureza frequentemente subtil das alucinações, torna-as difíceis de distinguir da informação exacta. Além disso, a natureza dependente do contexto de muitas alucinações e a falta de uma "verdade fundamental" abrangente para verificar todo o conteúdo gerado complicam ainda mais o processo de deteção.

Antes do documento ChainPoll, os métodos de deteção de alucinações existentes enfrentavam várias limitações. Muitos não eram eficazes em diversas tarefas e domínios, enquanto outros eram demasiado dispendiosos do ponto de vista computacional para aplicações em tempo real. Alguns métodos dependiam de arquitecturas de modelos específicos ou de dados de treino, e a maioria tinha dificuldade em distinguir entre diferentes tipos de alucinações, como erros factuais ou contextuais.

Além disso, os parâmetros de referência utilizados para avaliar estes métodos não reflectiam, muitas vezes, os verdadeiros desafios colocados pelas LLMs de última geração em aplicações reais. Muitos baseavam-se em modelos mais antigos e mais fracos ou centravam-se em tarefas específicas e restritas que não representavam toda a gama de capacidades e potenciais alucinações das LLM.

Para resolver estas questões, os investigadores por detrás do documento ChainPoll adoptaram uma abordagem em duas vertentes:

Desenvolvimento de um novo método de deteção de alucinações mais eficaz (ChainPoll)

Criar um conjunto de critérios de referência mais relevante e estimulante (RealHall)

Esta abordagem abrangente visava não só melhorar a deteção de alucinações, mas também estabelecer um quadro mais robusto para avaliar e comparar diferentes métodos de deteção.

Principais contributos do documento

O documento ChainPoll faz três contribuições principais para o campo da investigação e desenvolvimento da IA, cada uma abordando um aspeto crítico do desafio da deteção de alucinações.

Em primeiro lugar, o documento apresenta o ChainPollChainPoll, uma nova metodologia de deteção de alucinações. O ChainPoll aproveita o poder dos próprios LLMs para identificar alucinações, utilizando uma técnica de estímulo cuidadosamente concebida e um método de agregação para melhorar a precisão e a fiabilidade. Utiliza o estímulo da cadeia de pensamento para obter explicações mais detalhadas e sistemáticas, executa várias iterações do processo de deteção para aumentar a fiabilidade e adapta-se a cenários de deteção de alucinações tanto de domínio aberto como de domínio fechado.

Em segundo lugar, reconhecendo as limitações das referências existentes, os autores desenvolveram o RealHallum novo conjunto de dados de referência. O RealHall foi concebido para proporcionar uma avaliação mais realista e exigente dos métodos de deteção de alucinações. Inclui quatro conjuntos de dados cuidadosamente seleccionados que constituem um desafio mesmo para os LLMs mais avançados, centra-se em tarefas relevantes para aplicações LLM do mundo real e abrange cenários de alucinação tanto de domínio aberto como de domínio fechado.

Por último, o documento apresenta uma comparação exaustiva do ChainPoll com uma vasta gama de métodos de deteção de alucinações existentes. Esta avaliação exaustiva utiliza o recém-desenvolvido conjunto de referências RealHall, inclui métricas estabelecidas e inovações recentes no campo e considera factores como a precisão, a eficiência e a relação custo-eficácia. Através desta avaliação, o documento demonstra o desempenho superior do ChainPoll em várias tarefas e tipos de alucinações.

Ao oferecer estas três contribuições fundamentais, o documento ChainPoll não só faz avançar o estado da arte na deteção de alucinações, como também fornece um quadro mais robusto para a investigação e desenvolvimento futuros nesta área crítica da segurança e fiabilidade da IA.

Analisando a metodologia ChainPoll

Na sua essência, o ChainPoll tira partido das capacidades dos próprios modelos linguísticos de grande dimensão para identificar alucinações em textos gerados por IA. Esta abordagem destaca-se pela sua simplicidade, eficácia e adaptabilidade a diferentes tipos de alucinações.

Como funciona o ChainPoll

O método ChainPoll funciona com base num princípio simples mas poderoso. Utiliza um LLM (especificamente, GPT-3.5-turbo nas experiências do artigo) para avaliar se um determinado texto completo contém alucinações.

O processo envolve três etapas fundamentais:

Em primeiro lugar, o sistema pede ao LLM que avalie a presença de alucinações no texto-alvo, utilizando um rápido.

Em seguida, este processo é repetido várias vezes, normalmente cinco, para garantir a fiabilidade.

Finalmente, o sistema calcula uma pontuação dividindo o número de respostas "sim" (indicando a presença de alucinações) pelo número total de respostas.

Esta abordagem permite que o ChainPoll aproveite as capacidades de compreensão linguística dos LLMs e, ao mesmo tempo, reduza os erros de avaliação individual através da agregação.

O papel do estímulo da cadeia de pensamento

Uma inovação crucial do ChainPoll é a utilização da técnica da cadeia de raciocínio (CoT). Esta técnica incentiva o LLM a fornecer uma explicação passo a passo do seu raciocínio ao determinar se um texto contém alucinações. Os autores descobriram que um estímulo "CoT detalhado", cuidadosamente concebido, suscitava consistentemente explicações mais sistemáticas e fiáveis por parte do modelo.

Ao incorporar o CoT, o ChainPoll não só melhora a precisão da deteção de alucinações, como também fornece informações valiosas sobre o processo de tomada de decisão do modelo. Esta transparência pode ser crucial para compreender porque é que certos textos são assinalados como contendo alucinações, ajudando potencialmente no desenvolvimento de LLMs mais robustos no futuro.

Diferenciação entre alucinações de domínio aberto e alucinações de domínio fechado

Um dos pontos fortes do ChainPoll é a sua capacidade de lidar com alucinações de domínio aberto e de domínio fechado. As alucinações de domínio aberto referem-se a afirmações falsas sobre o mundo em geral, enquanto as alucinações de domínio fechado envolvem inconsistências com um texto ou contexto de referência específico.

Para lidar com estes diferentes tipos de alucinações, os autores desenvolveram duas variantes do ChainPoll: ChainPoll-Correctness para alucinações de domínio aberto e ChainPoll-Adherence para alucinações de domínio fechado. Estas variantes diferem principalmente na sua estratégia de estímulo, permitindo que o sistema se adapte a diferentes contextos de avaliação, mantendo a metodologia ChainPoll.

O RealHall Benchmark Suite

Reconhecendo as limitações dos padrões de referência existentes, os autores também desenvolveram o RealHall, um novo conjunto de padrões de referência concebido para fornecer uma avaliação mais realista e desafiante dos métodos de deteção de alucinações.

Critérios para a seleção de conjuntos de dados (desafio, realismo, diversidade de tarefas)

A criação do RealHall foi orientada por três princípios fundamentais:

Desafio: Os conjuntos de dados devem apresentar dificuldades significativas mesmo para os LLMs mais avançados, garantindo que o parâmetro de referência continue a ser relevante à medida que os modelos melhoram.

Realismo: As tarefas devem refletir de perto as aplicações reais dos LLM, tornando os resultados de referência mais aplicáveis a cenários práticos.

Tarefa Diversidade: O conjunto deve abranger uma vasta gama de capacidades LLM, proporcionando uma avaliação exaustiva dos métodos de deteção de alucinações.

Estes critérios levaram à seleção de quatro conjuntos de dados que, no seu conjunto, oferecem um campo de ensaio robusto para os métodos de deteção de alucinações.

Panorâmica dos quatro conjuntos de dados do RealHall

O RealHall inclui dois pares de conjuntos de dados, cada um abordando um aspeto diferente da deteção de alucinações:

RealHall Fechado: Este par inclui o conjunto de dados COVID-QA com recuperação e o conjunto de dados DROP. Estes centram-se em alucinações de domínio fechado, testando a capacidade de um modelo para se manter consistente com os textos de referência fornecidos.

RealHall Open: Este par é constituído pelo conjunto de dados Open Assistant prompts e pelo conjunto de dados TriviaQA. Estes visam alucinações de domínio aberto, avaliando a capacidade de um modelo para evitar fazer afirmações falsas sobre o mundo.

Cada conjunto de dados do RealHall foi escolhido pelos seus desafios únicos e pela sua relevância para as aplicações LLM do mundo real. Por exemplo, o conjunto de dados COVID-QA imita cenários de geração aumentada de recuperação, enquanto o DROP testa as capacidades de raciocínio discreto.

Como é que o RealHall resolve as limitações dos critérios de referência anteriores

O RealHall representa uma melhoria significativa em relação aos anteriores testes de referência em vários aspectos. Em primeiro lugar, utiliza LLMs mais recentes e potentes para gerar respostas, garantindo que as alucinações detectadas são representativas das produzidas pelos modelos actuais mais avançados. Isto resolve um problema comum com os testes de referência mais antigos, que utilizavam modelos desactualizados que produziam alucinações facilmente detectáveis.

Em segundo lugar, o facto de o RealHall se centrar na diversidade e no realismo das tarefas significa que proporciona uma avaliação mais abrangente e relevante para a prática dos métodos de deteção de alucinações. Este facto contrasta com muitos dos anteriores testes de referência que se centraram em tarefas específicas e limitadas ou em cenários artificiais.

Por último, ao incluir tarefas de domínio aberto e de domínio fechado, o RealHall permite uma avaliação mais matizada dos métodos de deteção de alucinações. Isto é particularmente importante porque muitas aplicações LLM do mundo real requerem ambos os tipos de deteção de alucinações.

Através destas melhorias, o RealHall fornece uma referência mais rigorosa e relevante para a avaliação dos métodos de deteção de alucinações, estabelecendo um novo padrão neste domínio.

Resultados experimentais e análise

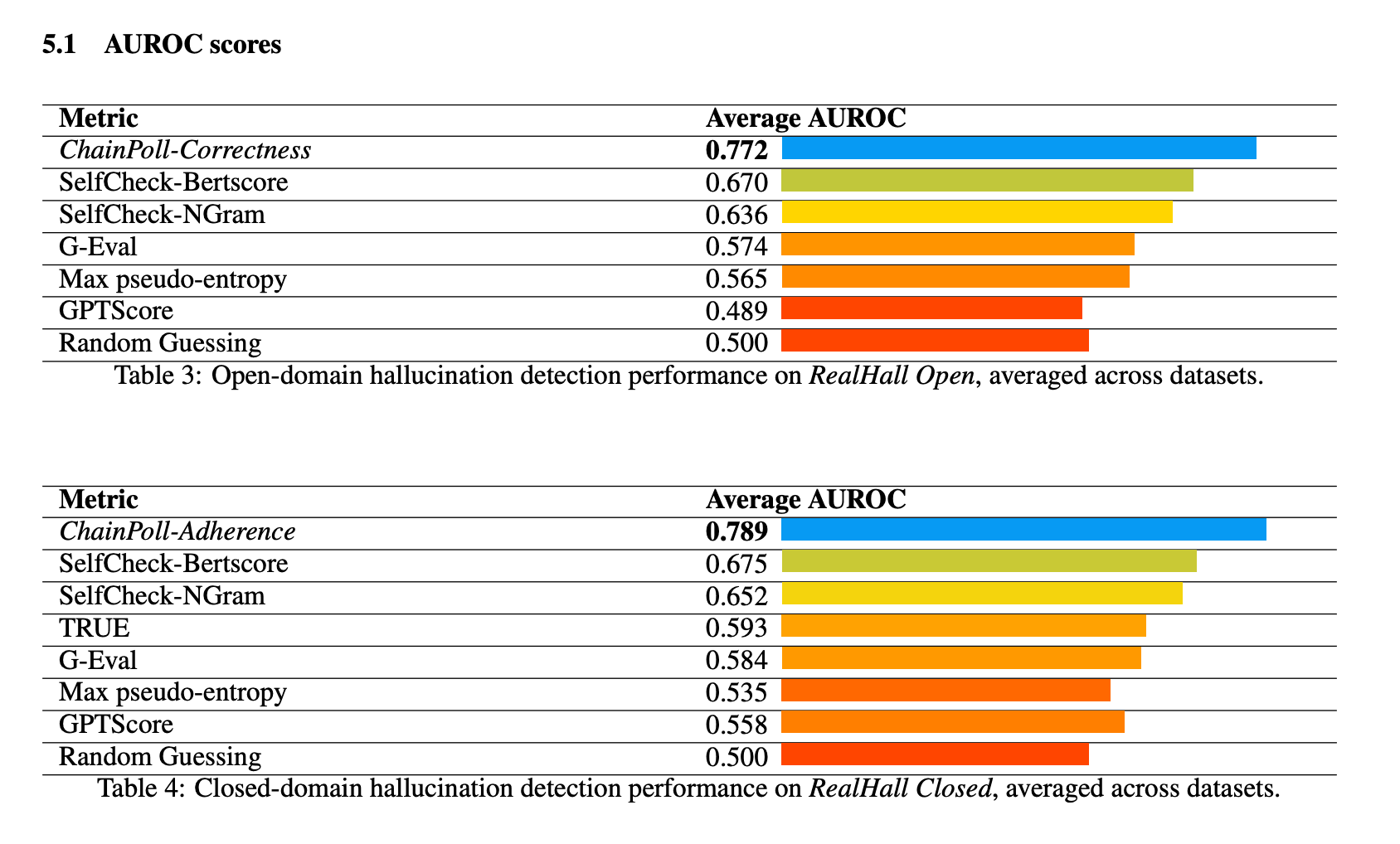

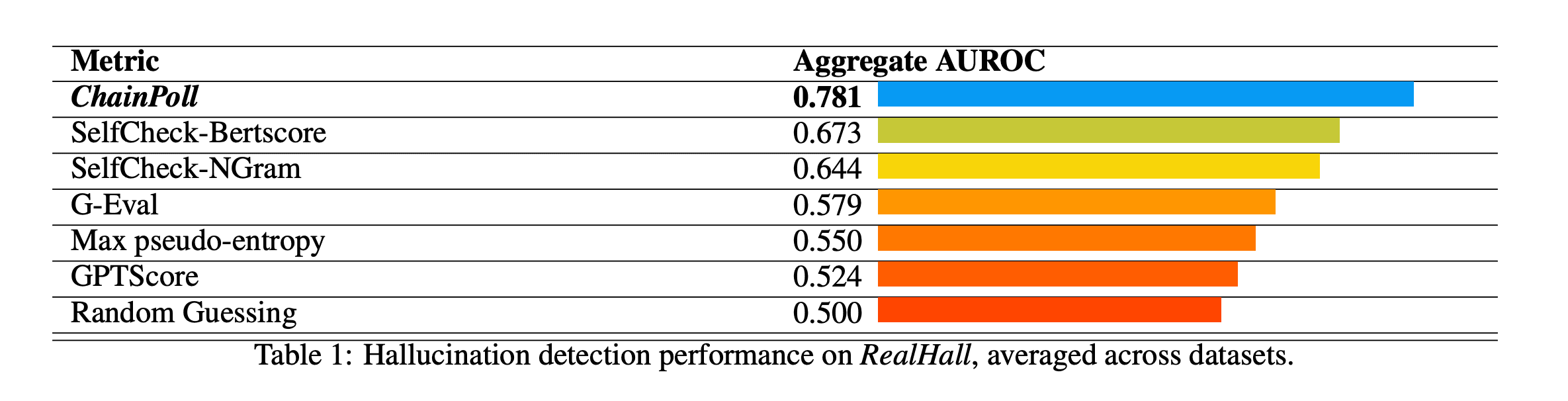

O ChainPoll demonstrou um desempenho superior em todos os testes de referência do conjunto RealHall. Atingiu um AUROC (Área sob a curva da caraterística de funcionamento do recetor) agregado de 0,781, superando significativamente o segundo melhor método, o SelfCheck-BertScore, que obteve 0,673. Esta melhoria substancial em relação ao 10% representa um salto significativo na capacidade de deteção de alucinações.

Outros métodos testados incluíram o SelfCheck-NGram, o G-Eval e o GPTScore, todos com um desempenho notavelmente pior do que o ChainPoll. Curiosamente, alguns métodos que se mostraram promissores em estudos anteriores, como o GPTScore, tiveram um desempenho fraco nos benchmarks RealHall mais desafiantes e diversificados.

O desempenho da ChainPoll foi consistentemente forte em tarefas de deteção de alucinações de domínio aberto e de domínio fechado. Para tarefas de domínio aberto (utilizando ChainPoll-Correção), alcançou um AUROC médio de 0,772, enquanto que para tarefas de domínio fechado (utilizando ChainPoll-Adherence), obteve 0,789.

O método mostrou uma força particular em conjuntos de dados desafiantes como o DROP, que requer um raciocínio discreto.

Para além da sua precisão superior, o ChainPoll também provou ser mais eficiente e económico do que muitos métodos concorrentes. Obtém os seus resultados utilizando apenas 1/4 da inferência LLM que o método seguinte, SelfCheck-BertScore. Além disso, o ChainPoll não requer a utilização de modelos adicionais como o BERT, reduzindo ainda mais a sobrecarga computacional.

Esta eficiência é crucial para aplicações práticas, uma vez que permite a deteção de alucinações em tempo real em ambientes de produção sem incorrer em custos proibitivos ou latência.

Implicações e trabalho futuro

O ChainPoll representa um avanço significativo no domínio da deteção de alucinações nos LLM. O seu sucesso demonstra o potencial da utilização dos próprios LLM como ferramentas para melhorar a segurança e a fiabilidade da IA. Esta abordagem abre novos caminhos para a investigação de sistemas de IA auto-aperfeiçoados e auto-verificados.

A eficiência e a precisão do ChainPoll tornam-no adequado para integração numa vasta gama de aplicações de IA. Pode ser utilizado para aumentar a fiabilidade dos chatbots, melhorar a precisão dos conteúdos gerados por IA em domínios como o jornalismo ou a escrita técnica e aumentar a fiabilidade dos assistentes de IA em domínios críticos como os cuidados de saúde ou as finanças.

Embora o ChainPoll apresente resultados impressionantes, ainda há espaço para mais investigação e melhorias. O trabalho futuro poderia explorar:

Adaptar o ChainPoll para trabalhar com uma maior variedade de LLMs e tarefas linguísticas

Investigação de formas de melhorar a eficiência sem sacrificar a exatidão

Explorar o potencial do ChainPoll para outros tipos de conteúdos gerados por IA para além do texto

Desenvolver métodos para não só detetar, mas também corrigir ou prevenir alucinações em tempo real

O documento ChainPoll dá contributos significativos para o domínio da segurança e fiabilidade da IA através da introdução de um novo método de deteção de alucinações e de uma referência de avaliação mais robusta. Ao demonstrar um desempenho superior na deteção de alucinações tanto em domínio aberto como em domínio fechado, o ChainPoll abre caminho a sistemas de IA mais fiáveis. Como os LLMs continuam a desempenhar um papel cada vez mais importante em várias aplicações, a capacidade de detetar e mitigar com precisão as alucinações torna-se crucial. Esta investigação não só faz avançar as nossas capacidades actuais, como também abre novos caminhos para a exploração e desenvolvimento futuros na área crítica da deteção de alucinações por IA.