Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67 Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67

- Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67 Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67

- Prompting, aprendizagem e afinação de poucos disparos para LLMs - AI&YOU #67

- O desafio da escassez de dados na IA

- Aprendizagem com poucos disparos vs. Aprendizagem supervisionada tradicional

- O espetro da aprendizagem eficiente por amostragem

- Prompting de poucos disparos vs. LLM de ajuste fino

- Prompting de poucas palavras: Libertar o potencial do LLM

- Ajuste fino de LLMs: Adaptação de modelos com dados limitados

- Prompting de poucos disparos vs. afinação: Escolher a abordagem correta

- Os 5 melhores trabalhos de investigação para uma aprendizagem rápida

- A linha de fundo

- Obrigado por ler AI & YOU!

Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67 Poucas tentativas, aprendizagem e afinação para LLMs - AI&YOU #67

Estatísticas da semana: A investigação efectuada pela MobiDev sobre a aprendizagem de poucas imagens para a classificação de imagens de moedas concluiu que, utilizando apenas 4 exemplos de imagens por denominação de moeda, era possível obter uma precisão de ~70%.

Na IA, a capacidade de aprender de forma eficiente a partir de dados limitados tornou-se crucial. É por isso que é importante que as empresas compreendam a aprendizagem de poucos disparos, a solicitação de poucos disparos e o ajuste fino dos LLMs.

Na edição desta semana de AI&YOU, exploramos as ideias de três blogues que publicámos sobre estes temas:

Prompting, aprendizagem e afinação de poucos disparos para LLMs - AI&YOU #67

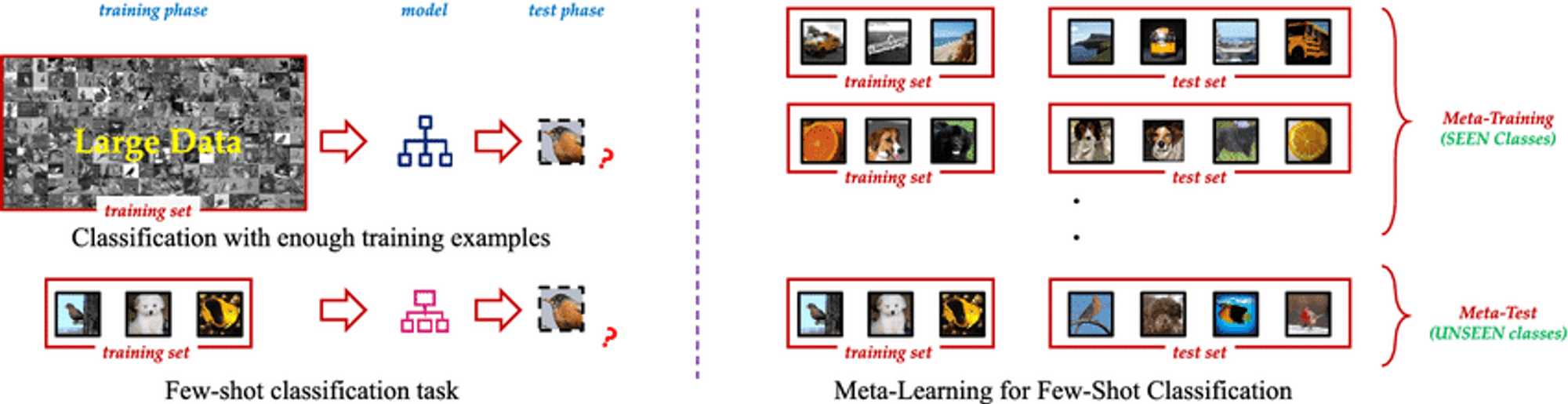

A Aprendizagem de Poucas Oportunidades é um paradigma inovador de aprendizagem automática que permite aos modelos de IA aprender novos conceitos ou tarefas a partir de apenas alguns exemplos. Ao contrário dos métodos tradicionais de aprendizagem supervisionada, que requerem grandes quantidades de dados de treino rotulados, as técnicas de aprendizagem de poucos disparos permitem que os modelos generalizem eficazmente utilizando apenas um pequeno número de amostras. Esta abordagem imita a capacidade humana de apreender rapidamente novas ideias sem a necessidade de repetição extensiva.

A essência do Few Shot Learning reside na sua capacidade de aproveitar o conhecimento prévio e adaptar-se rapidamente a novos cenários. Ao utilizar técnicas como a meta-aprendizagem, em que o modelo "aprende a aprender", os algoritmos de Aprendizagem de Poucas Oportunidades podem lidar com uma vasta gama de tarefas com um mínimo de formação adicional. Esta flexibilidade torna-os numa ferramenta inestimável em cenários onde os dados são escassos, caros de obter ou estão em constante evolução.

O desafio da escassez de dados na IA

Nem todos os dados são iguais, e os dados rotulados de alta qualidade podem ser um bem raro e precioso. Esta escassez representa um desafio significativo para as abordagens tradicionais de aprendizagem supervisionada, que normalmente requerem milhares ou mesmo milhões de exemplos etiquetados para obter um desempenho satisfatório.

O problema da escassez de dados é particularmente grave em domínios especializados como os cuidados de saúde, em que as doenças raras podem ter um número limitado de casos documentados, ou em ambientes em rápida mutação, em que surgem frequentemente novas categorias de dados. Nestes cenários, o tempo e os recursos necessários para recolher e rotular grandes conjuntos de dados podem ser proibitivos, criando um estrangulamento no desenvolvimento e implementação da IA.

Aprendizagem com poucos disparos vs. Aprendizagem supervisionada tradicional

Compreender a distinção entre a aprendizagem com poucos disparos e a aprendizagem supervisionada tradicional é crucial para compreender o seu impacto no mundo real.

Tradicional aprendizagem supervisionadaEmbora poderoso, tem inconvenientes:

Dependência de dados: Tem dificuldades com dados de formação limitados.

Inflexibilidade: Só tem um bom desempenho em tarefas específicas e treinadas.

Intensidade de recursos: Requer conjuntos de dados grandes e dispendiosos.

Atualização contínua: Necessita de reciclagem frequente em ambientes dinâmicos.

Aprendizagem com poucos tiros oferece uma mudança de paradigma:

Eficiência da amostra: Generaliza a partir de poucos exemplos utilizando a meta-aprendizagem.

Adaptação rápida: Adapta-se rapidamente a novas tarefas com exemplos mínimos.

Otimização de recursos: Reduz as necessidades de recolha de dados e de rotulagem.

Aprendizagem contínua: Adequado para incorporar novos conhecimentos sem os esquecer.

Versatilidade: Aplicável em vários domínios, desde a visão computacional à PNL.

Ao enfrentar estes desafios, a aprendizagem com poucos disparos permite modelos de IA mais adaptáveis e eficientes, abrindo novas possibilidades no desenvolvimento da IA.

O espetro da aprendizagem eficiente por amostragem

Um espetro fascinante de abordagens tem como objetivo minimizar os dados de formação necessários, incluindo a aprendizagem Zero Shot, One Shot e Few Shot.

Aprendizagem Zero Shot: Aprender sem exemplos

Reconhece classes não vistas utilizando informações auxiliares como descrições textuais

Valioso quando os exemplos etiquetados para todas as classes são impraticáveis ou impossíveis

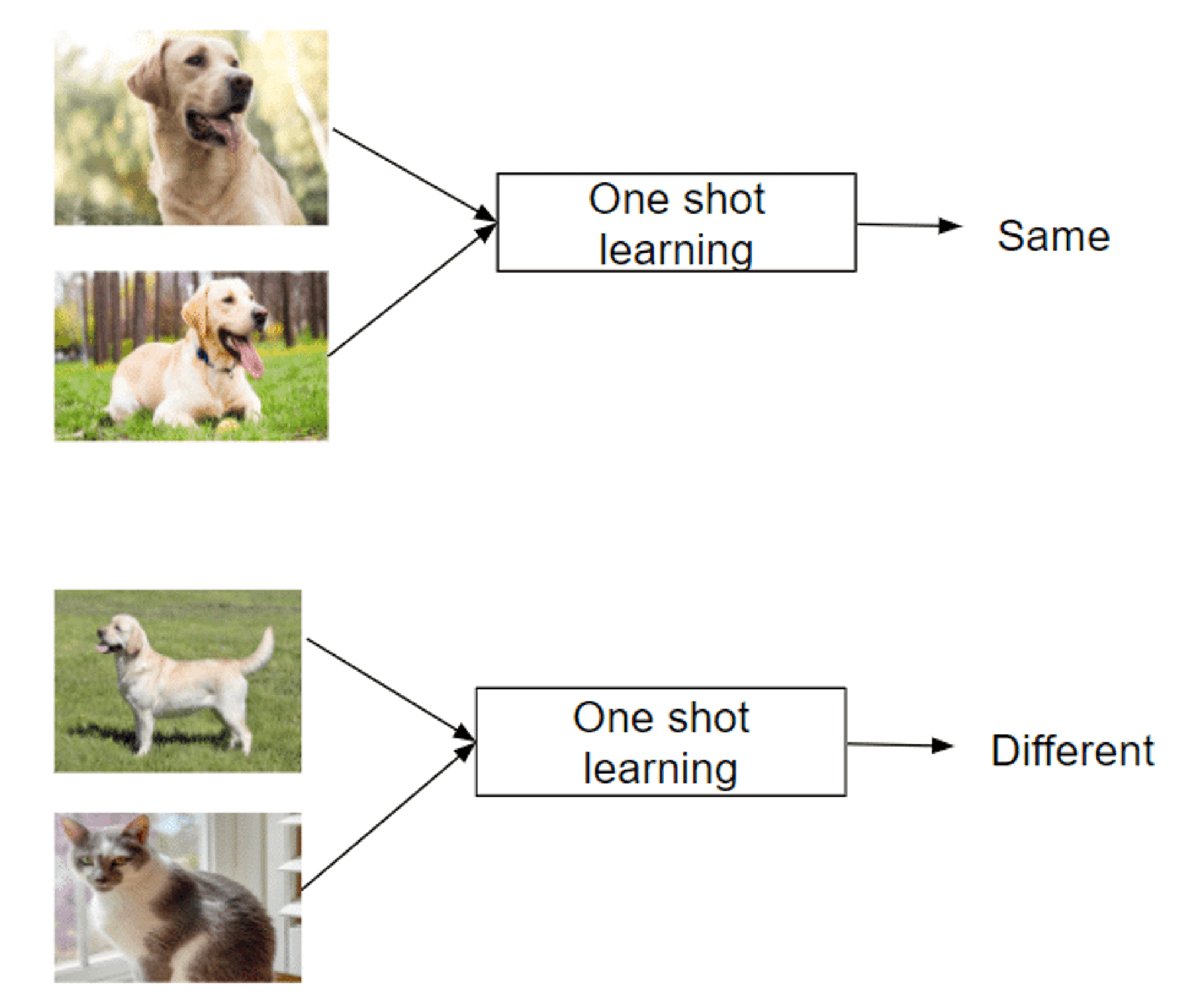

Aprendizagem de uma só vez: Aprender a partir de uma única instância

Reconhece novas classes a partir de apenas um exemplo

Imita a capacidade humana de apreender conceitos rapidamente

Sucesso em áreas como o reconhecimento facial

Aprendizagem com poucas hipóteses: Dominar tarefas com o mínimo de dados

Utiliza 2-5 exemplos rotulados por nova classe

Equilíbrio entre eficiência extrema de dados e métodos tradicionais

Permite uma rápida adaptação a novas tarefas ou classes

Utiliza estratégias de meta-aprendizagem para aprender a aprender

Este espetro de abordagens oferece capacidades únicas para enfrentar o desafio da aprendizagem a partir de exemplos limitados, tornando-as inestimáveis em domínios com escassez de dados.

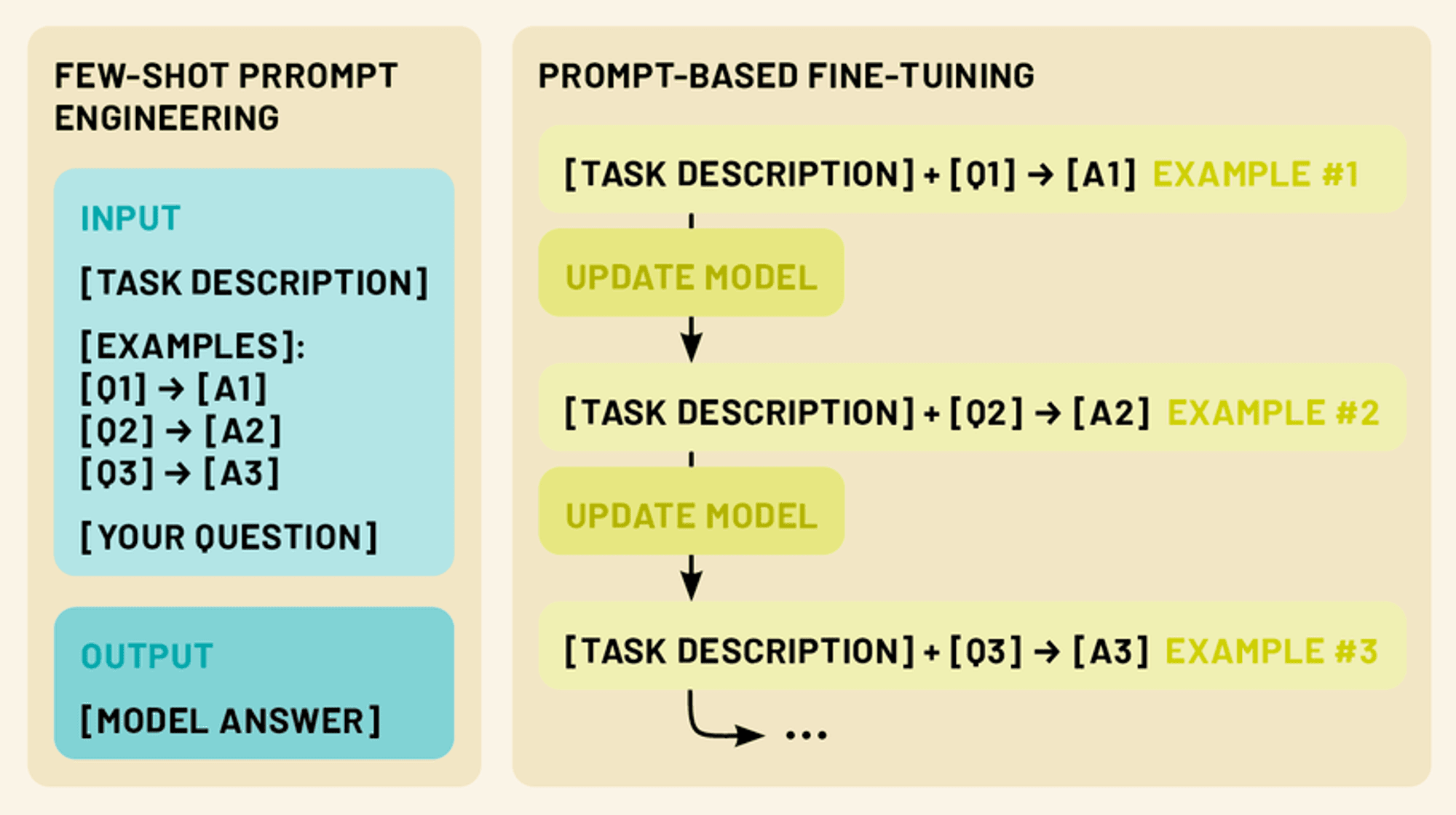

Prompting de poucos disparos vs. LLM de ajuste fino

Neste domínio, existem duas técnicas mais poderosas: a solicitação de poucas tentativas e o ajuste fino. A solicitação de poucos disparos envolve a criação de solicitações de entrada inteligentes que incluem um pequeno número de exemplos, orientando o modelo para executar uma tarefa específica sem qualquer formação adicional. O ajuste fino, por outro lado, envolve a atualização dos parâmetros do modelo utilizando uma quantidade limitada de dados específicos da tarefa, permitindo-lhe adaptar o seu vasto conhecimento a um determinado domínio ou aplicação.

Ambas as abordagens se enquadram no conceito de aprendizagem de poucos disparos. Ao tirar partido destas técnicas, podemos melhorar drasticamente o desempenho e a versatilidade dos LLMs, tornando-os ferramentas mais práticas e eficazes para uma vasta gama de aplicações no processamento de linguagem natural e não só.

Prompting de poucas palavras: Libertar o potencial do LLM

O comando de poucos disparos capitaliza a capacidade do modelo para compreender instruções, "programando" efetivamente o LLM através de comandos elaborados.

A solicitação de poucos disparos fornece de 1 a 5 exemplos que demonstram a tarefa desejada, aproveitando o reconhecimento de padrões e a adaptabilidade do modelo. Isto permite o desempenho de tarefas para as quais não foi explicitamente treinado, explorando a capacidade do LLM para a aprendizagem em contexto.

Ao apresentar padrões claros de entrada-saída, o prompting de poucos disparos orienta o LLM a aplicar um raciocínio semelhante a novas entradas, permitindo uma adaptação rápida a novas tarefas sem actualizações de parâmetros.

Tipos de prompts de poucos disparos (zero disparo, um disparo, poucos disparos)

O estímulo de poucos disparos engloba um espetro de abordagens, cada uma definida pelo número de exemplos fornecidos. (Tal como a aprendizagem com poucos exemplos):

Solicitação de disparo zero: Neste cenário, não são fornecidos exemplos. Em vez disso, o modelo recebe uma instrução ou descrição clara da tarefa. Por exemplo, "Traduzir para francês o seguinte texto em inglês: [texto de entrada]".

Solicitação de uma só vez: Neste caso, é fornecido um único exemplo antes da entrada efectiva. Isto dá ao modelo uma instância concreta da relação esperada entre entradas e saídas. Por exemplo: "Classifique o sentimento da seguinte crítica como positivo ou negativo. Exemplo: 'Este filme foi fantástico!' - Entrada positiva: 'Não consegui suportar o enredo'. - [o modelo gera a resposta]"

Poucos disparos: Esta abordagem fornece vários exemplos (normalmente 2-5) antes da entrada efectiva. Isto permite que o modelo reconheça padrões e nuances mais complexos na tarefa. Por exemplo: "Classifique as seguintes frases como perguntas ou afirmações: 'O céu é azul'. - Pergunta "Eu adoro gelado". - Declaração Entrada: 'Onde posso encontrar o restaurante mais próximo?' - [o modelo gera a resposta]"

Conceber prompts de poucas frases eficazes

A elaboração de prompts de poucos disparos eficazes é tanto uma arte como uma ciência. Aqui estão alguns princípios-chave a considerar:

Clareza e coerência: Certifique-se de que os seus exemplos e instruções são claros e seguem um formato consistente. Isto ajuda o modelo a reconhecer o padrão mais facilmente.

Diversidade: Ao utilizar vários exemplos, tente abranger uma gama de entradas e saídas possíveis para dar ao modelo uma compreensão mais ampla da tarefa.

Relevância: Escolha exemplos que estejam intimamente relacionados com a tarefa ou domínio específico a que se destina. Isto ajuda o modelo a concentrar-se nos aspectos mais relevantes do seu conhecimento.

Concisão: Embora seja importante fornecer um contexto suficiente, evite perguntas demasiado longas ou complexas que possam confundir o modelo ou diluir as informações principais.

Experimentação: Não tenha medo de repetir e experimentar diferentes estruturas e exemplos de mensagens para descobrir o que funciona melhor para o seu caso de utilização específico.

Ao dominarmos a arte de dar instruções em poucas doses, podemos desbloquear todo o potencial dos LLMs, permitindo-lhes realizar uma vasta gama de tarefas com um mínimo de informação ou formação adicional.

Ajuste fino de LLMs: Adaptação de modelos com dados limitados

Embora a solicitação de poucos disparos seja uma técnica poderosa para adaptar LLMs a novas tarefas sem modificar o próprio modelo, o ajuste fino oferece uma forma de atualizar os parâmetros do modelo para um desempenho ainda melhor em tarefas ou domínios específicos. O ajuste fino permite-nos aproveitar o vasto conhecimento codificado em LLMs pré-treinadas, adaptando-as às nossas necessidades específicas, utilizando apenas uma pequena quantidade de dados específicos da tarefa.

Compreender o ajuste fino no contexto dos LLMs

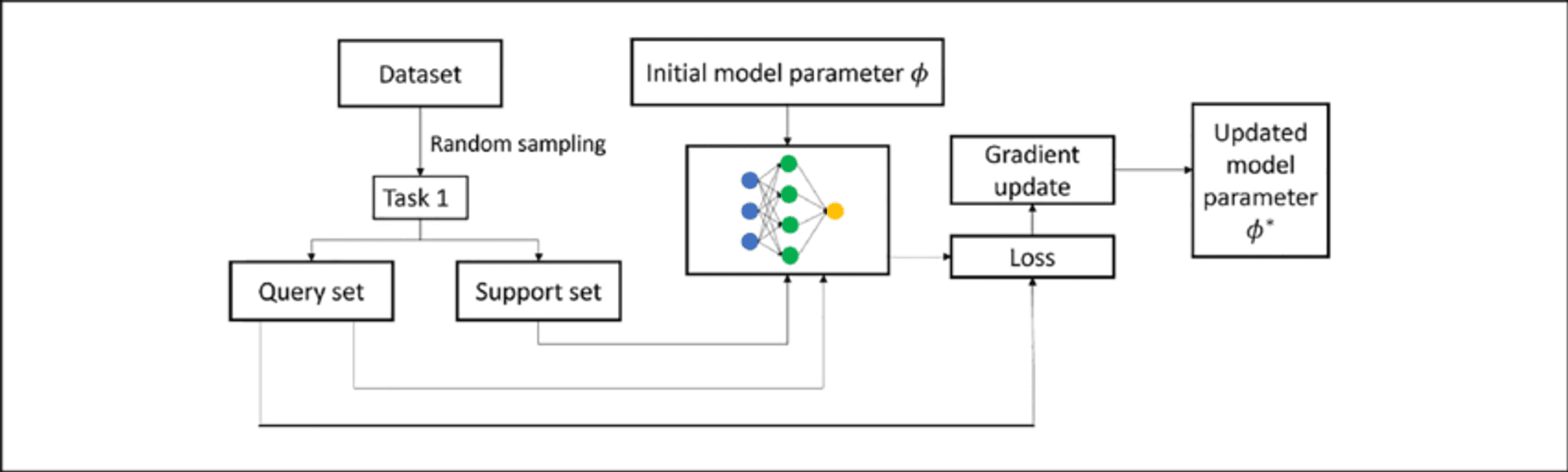

O ajuste fino de um LLM envolve o treino adicional de um modelo pré-treinado num conjunto de dados mais pequeno e específico da tarefa. Este processo adapta o modelo à tarefa-alvo enquanto se baseia no conhecimento existente, exigindo menos dados e recursos do que a formação de raiz.

Nos LLM, o ajuste fino ajusta normalmente os pesos nas camadas superiores para caraterísticas específicas da tarefa, enquanto as camadas inferiores permanecem praticamente inalteradas. Esta abordagem de "aprendizagem por transferência" mantém uma compreensão alargada da língua enquanto desenvolve capacidades especializadas.

Técnicas de afinação de poucos disparos

O ajuste fino de poucos disparos adapta o modelo usando apenas 10 a 100 amostras por classe ou tarefa, o que é valioso quando os dados rotulados são escassos. As principais técnicas incluem:

Afinação com base em pedidos: Combina a solicitação de poucos disparos com actualizações de parâmetros.

Abordagens de meta-aprendizagem: Métodos como MAML têm por objetivo encontrar bons pontos de inicialização para uma adaptação rápida.

Afinação baseada em adaptadores: Introduz pequenos módulos "adaptadores" entre camadas de modelos pré-treinados, reduzindo os parâmetros treináveis.

Aprendizagem em contexto: Ajusta os LLMs para melhor realizar a adaptação apenas através de avisos.

Estas técnicas permitem que as LLMs se adaptem a novas tarefas com um mínimo de dados, aumentando a sua versatilidade e eficiência.

Prompting de poucos disparos vs. afinação: Escolher a abordagem correta

Ao adaptar os LLMs a tarefas específicas, tanto a solicitação de poucos disparos como o ajuste fino oferecem soluções poderosas. No entanto, cada método tem os seus próprios pontos fortes e limitações, e a escolha da abordagem correta depende de vários factores.

Pontos fortes do estímulo de poucas tentativas:

Não requer actualizações dos parâmetros do modelo, preservando o modelo original

Altamente flexível e pode ser adaptado em tempo real

Não é necessário tempo de formação ou recursos computacionais adicionais

Útil para prototipagem e experimentação rápidas

Limitações:

O desempenho pode ser menos consistente, especialmente em tarefas complexas

Limitado pelas capacidades e conhecimentos originais do modelo

Pode ter dificuldades em domínios ou tarefas altamente especializados

Afinar os pontos fortes:

Obtém frequentemente um melhor desempenho em tarefas específicas

Pode adaptar o modelo a novos domínios e vocabulário especializado

Resultados mais consistentes em entradas semelhantes

Potencial de aprendizagem e melhoria contínuas

Limitações:

Requer tempo de formação e recursos computacionais adicionais

Risco de esquecimento catastrófico se não for cuidadosamente gerido

Pode ter um ajuste excessivo em pequenos conjuntos de dados

Menos flexível; requer reciclagem para mudanças significativas de tarefas

Os 5 melhores trabalhos de investigação para uma aprendizagem rápida

Esta semana, exploramos também os seguintes cinco documentos que fizeram avançar significativamente este domínio, introduzindo abordagens inovadoras que estão a remodelar as capacidades da IA.

1️⃣ Matching Networks for One Shot Learning" (Vinyals et al., 2016)

Introduziu uma abordagem inovadora que utiliza mecanismos de memória e atenção. A função de correspondência compara exemplos de consulta com exemplos de suporte rotulados, estabelecendo um novo padrão para métodos de aprendizagem de poucos disparos.

2️⃣ Prototypical Networks for Few-shot Learning" (Snell et al., 2017)

Apresentou uma abordagem mais simples mas eficaz, aprendendo um espaço métrico em que as classes são representadas por um único protótipo. A sua simplicidade e eficácia tornaram-na uma base de referência popular para a investigação subsequente.

3️⃣ Aprender a comparar: Rede de relações para a aprendizagem de poucos disparos" (Sung et al., 2018)

Introduziu um módulo de relação aprendível, permitindo que o modelo aprenda uma métrica de comparação adaptada a tarefas e distribuições de dados específicas. Demonstrou um forte desempenho em vários parâmetros de referência.

4️⃣ A Closer Look at Few-shot Classification" (Chen et al., 2019)

Forneceu uma análise exaustiva dos métodos existentes, desafiando os pressupostos comuns. Propôs modelos de base simples que correspondiam ou excediam abordagens mais complexas, sublinhando a importância das bases de recursos e das estratégias de formação.

5️⃣ Meta-Baseline: Exploring Simple Meta-Learning for Few-Shot Learning" (Chen et al., 2021)

Combinou a pré-treino padrão com uma fase de meta-aprendizagem, alcançando o desempenho mais avançado. Destacou os compromissos entre a formação padrão e os objectivos da meta-aprendizagem.

Estes documentos não só fizeram avançar a investigação académica, como também abriram caminho para aplicações práticas na IA empresarial. Representam uma progressão no sentido de sistemas de IA mais eficientes e adaptáveis, capazes de aprender com dados limitados - uma capacidade crucial em muitos contextos empresariais.

A linha de fundo

A aprendizagem de poucos instantes, o estímulo e o ajuste fino representam abordagens inovadoras, permitindo que os LLMs se adaptem rapidamente a tarefas especializadas com o mínimo de dados. Como já explorámos, estas técnicas oferecem uma flexibilidade e eficiência sem precedentes na adaptação dos LLM a diversas aplicações em todos os sectores, desde o melhoramento de tarefas de processamento de linguagem natural até à possibilidade de adaptações específicas de domínios em áreas como os cuidados de saúde, o direito e a tecnologia.

Obrigado por ler AI & YOU!

Para obter ainda mais conteúdos sobre IA empresarial, incluindo infográficos, estatísticas, guias de instruções, artigos e vídeos, siga o Skim AI em LinkedIn

É um Fundador, CEO, Capitalista de Risco ou Investidor que procura serviços de Consultoria de IA, Desenvolvimento de IA fraccionada ou Due Diligence? Obtenha a orientação necessária para tomar decisões informadas sobre a estratégia de produtos de IA da sua empresa e oportunidades de investimento.

Criamos soluções de IA personalizadas para empresas apoiadas por capital de risco e capital privado nos seguintes sectores: Tecnologia Médica, Agregação de Notícias/Conteúdo, Produção de Filmes e Fotos, Tecnologia Educacional, Tecnologia Jurídica, Fintech e Criptomoeda.