4 práticas recomendadas para evitar proibições de API da OpenAI e garantir a conformidade

Se a sua empresa está envolvida com IA em qualquer aspeto, a conformidade é mais crítica do que nunca, especialmente quando utiliza modelos de IA como os fornecidos pela OpenAI. O que muitas empresas não percebem é que o não cumprimento das políticas da OpenAI por parte dos utilizadores pode levar à proibição do seu acesso à API, muitas vezes sem aviso prévio. Para as empresas que gerem vários utilizadores, garantir a adesão às políticas da OpenAI é crucial para manter o acesso ininterrupto a estas poderosas ferramentas. O não cumprimento dos termos pode ter consequências graves, incluindo proibições que podem perturbar significativamente as suas operações comerciais.

A OpenAI estabeleceu um conjunto abrangente de políticas destinadas a evitar a utilização indevida. Estas políticas não só protegem a plataforma, como também garantem a utilização responsável das tecnologias de IA em todos os sectores. As empresas que utilizam as APIs da OpenAI devem ser diligentes na monitorização do comportamento dos utilizadores para evitar violações que possam levar a penalizações ou proibições. Compreender e navegar eficazmente por estas políticas é a chave para manter o acesso e obter uma vantagem competitiva no espaço da IA.

Compreender as políticas de utilização da API da OpenAI

As políticas de utilização das API da OpenAI foram concebidas para salvaguardar a utilização ética e adequada da IA. A utilização indevida destas APIs, em particular através de conteúdo gerado pelo utilizador, pode levar rapidamente à suspensão ou proibição de contas. O comportamento incorreto do utilizador, como a apresentação de conteúdos inadequados ou prejudiciais, não só viola os termos da OpenAI, como também coloca em risco todas as contas.

A OpenAI monitoriza ativamente os padrões de utilização e avalia as acções ocultas que possam violar as suas diretrizes. Por exemplo, a apresentação de conteúdos inadequados ou as tentativas de contornar os filtros de conteúdos podem conduzir a repercussões significativas. A OpenAI oculta pormenores específicos sobre a forma como avalia os pedidos, mantendo um controlo tão apertado sobre os seus processos de moderação para garantir que a conformidade é cumprida sem compromissos. Ao fazê-lo, a OpenAI garante que os seus modelos são utilizados de uma forma que está em conformidade com os seus padrões éticos.

Para evitar estes problemas, é essencial que os programadores e as empresas sejam proactivos na aplicação das diretrizes da OpenAI e na utilização de ferramentas integradas como a ponto final de moderaçãoque pode ajudar a filtrar conteúdos potencialmente nocivos antes de chegarem à API. Compreender os principais aspectos da utilização indevida e estar ciente da forma como a OpenAI monitoriza as violações permitirá às empresas gerir os riscos de forma mais eficaz.

Desafios enfrentados pelas aplicações multiutilizador

Para as empresas que gerem aplicações com vários utilizadores, os riscos associados à utilização indevida da API são significativamente maiores. Cada utilizador tem o potencial de violar, inadvertida ou intencionalmente, as políticas da OpenAI, levando a consequências que afectam toda a organização. Isto faz com que seja vital que os programadores compreendam os desafios únicos colocados pelos ambientes multiutilizadores.

A gestão de vários utilizadores apresenta desafios específicos, tais como níveis variáveis de compreensão da utilização aceitável, adesão inconsistente às diretrizes e o potencial comportamento malicioso de um pequeno subconjunto de utilizadores. Cada interação de utilizador tem de ser cuidadosamente monitorizada porque uma única violação pode pôr em risco todo o acesso à API de uma organização. Além disso, o escalonamento de uma plataforma com vários utilizadores introduz complexidades na garantia de que todos os utilizadores estão em conformidade sem sobrecarregar o sistema com verificações manuais.

Ao contrário dos modelos de IA anteriores, que podem ter sido menos rigorosos, o modelo de IA mais recente da OpenAI vem com diretrizes de conformidade mais rigorosas que são monitorizadas de perto. As empresas devem assumir a responsabilidade de monitorizar os conteúdos gerados pelos utilizadores para evitar violações, o que implica a implementação de filtragem automática de conteúdos e verificações de conformidade. Medidas proactivas como a integração do ponto final de moderação da OpenAI, a definição de políticas de utilização claras para os utilizadores finais e o fornecimento de recursos educativos aos utilizadores sobre conteúdos aceitáveis podem ajudar a mitigar estes riscos e garantir a disponibilidade contínua da API.

Ao gerir eficazmente o comportamento individual dos utilizadores e ao implementar ferramentas de monitorização robustas, as empresas podem evitar ser penalizadas pelas acções de alguns maus actores. Investir em processos e ferramentas de gestão de utilizadores não só ajuda na conformidade, como também cria um ambiente mais fiável para todos os utilizadores, apoiando, em última análise, os objectivos a longo prazo da empresa com a integração da IA.

Práticas recomendadas para evitar proibições de API da OpenAI

Para evitar proibições e garantir que a sua utilização da API se mantém em conformidade, é crucial implementar as melhores práticas específicas. Aqui estão várias estratégias que os programadores e as empresas podem seguir:

Utilizar o Ponto de extremidade de moderação: A OpenAI fornece um ponto final de moderação gratuito que ajuda a identificar conteúdos nocivos antes de chegarem à API. Esta ferramenta é essencial para filtrar conteúdos inadequados e reduzir o risco de sanções.

Limites de taxas e identificadores únicos de utilizadores: A implementação de limites de taxa e a atribuição de identificadores de utilizador únicos a cada pedido de API pode ajudar a gerir e a rastrear o comportamento do utilizador. Ao controlar o volume de pedidos e associá-los a utilizadores individuais, torna-se mais fácil identificar e restringir contas problemáticas.

Monitorização e registo em tempo real: Estabelecer sistemas de monitorização em tempo real para acompanhar a utilização da API. O registo de cada pedido permite aos programadores auditar o comportamento dos utilizadores e detetar anomalias numa fase inicial.

Validação de entrada: Certifique-se de que todas as entradas são validadas para evitar que dados prejudiciais ou inadequados sejam processados pela API. Uma validação de entrada correta pode reduzir os riscos e melhorar a conformidade.

Essas práticas não apenas minimizam o risco de violações, mas também fornecem às empresas uma vantagem competitiva, pois demonstram um compromisso com o uso responsável da IA. A incorporação de uma abordagem estruturada à conformidade, incluindo a utilização das ferramentas incorporadas do OpenAI, pode, em última análise, conduzir a uma utilização mais fiável e eficaz dos modelos de IA.

Compreender o ponto final de moderação da OpenAI

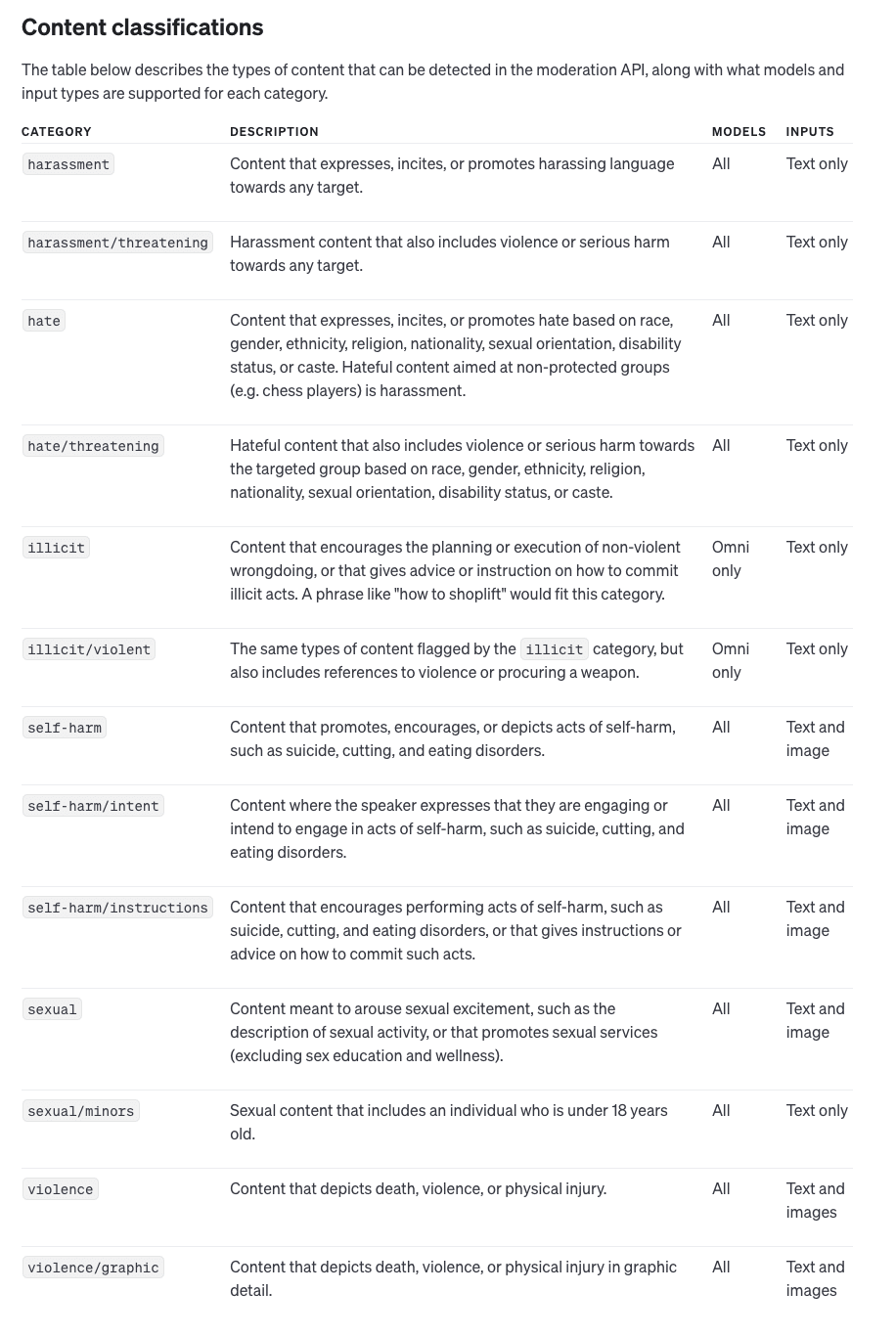

O Ponto de extremidade de moderação fornecido pela OpenAI é uma ferramenta essencial para garantir que o conteúdo prejudicial não passe pelo sistema, ajudando assim a manter a conformidade e a evitar proibições. O ponto de extremidade pode analisar entradas de texto e imagem, identificando categorias potencialmente prejudiciais, como violência, discurso de ódio e muito mais.

O ponto final de moderação da OpenAI oferece as seguintes funcionalidades:

Modelo de Omni-Moderação: Esta é a versão mais recente e suporta várias opções de categorização e multimodal o que o torna adequado tanto para texto como para imagens.

Moderação de texto legado: Modelos mais antigos que suportam apenas entradas de texto com menos capacidades de categorização. No entanto, para novas aplicações, recomenda-se o modelo de omni-moderação.

A utilização do ponto final de moderação envolve a passagem de dados de entrada para a API da OpenAI, que fornece uma resposta detalhada. Esta resposta inclui:

Conteúdo assinalado: O ponto final define um sinalizador como verdadeiro se a entrada contiver conteúdo nocivo ou inadequado.

Categoria Pontuações: Um sistema de pontuação detalhado que indica o nível de confiança do modelo na sua categorização de conteúdos potencialmente nocivos.

Dados específicos da categoria: O ponto final fornece uma indicação dos tipos de entrada (por exemplo, texto ou imagem) que accionaram a categorização, permitindo esforços de moderação mais precisos.

Ao implementar o ponto de extremidade de moderação, as empresas podem tomar medidas proactivas - filtrando o conteúdo sinalizado antes de este chegar à API principal da OpenAI. Isto não só protege a integridade do modelo de IA, como também minimiza o risco de violações de políticas que poderiam levar a uma proibição da API.

Garantir a conformidade e a vantagem competitiva

A conformidade não se trata apenas de evitar sanções; pode também servir como uma vantagem competitiva na indústria da IA. As empresas que aderem estritamente às diretrizes da OpenAI têm menos probabilidades de sofrer perturbações, o que lhes permite fornecer serviços consistentes e fiáveis aos seus utilizadores.

Além disso, ser proactivo na garantia da conformidade significa que as empresas podem aproveitar todo o potencial dos modelos de IA da OpenAI. Ao compreender o processo de raciocínio por detrás das políticas da OpenAI e ao implementar as melhores práticas, as organizações posicionam-se como líderes responsáveis no espaço da IA. A conformidade ajuda a criar confiança, tanto com os utilizadores como com os parceiros da indústria, permitindo que as empresas se diferenciem dos concorrentes que podem não ser tão diligentes.

A linha de fundo

A utilização responsável da API é fundamental para manter o acesso às poderosas ferramentas da OpenAI. O não cumprimento das políticas da OpenAI pode resultar em consequências graves, incluindo proibições de API que podem perturbar significativamente as suas operações comerciais. Os programadores e as empresas devem ser proactivos na gestão do comportamento dos utilizadores, na implementação de estratégias de moderação e na adesão às melhores práticas para evitar violações.

Em última análise, seguir as diretrizes da OpenAI não apenas evita interrupções, mas também posiciona as empresas como líderes no uso ético da IA. Ao demonstrar um compromisso com a conformidade, as organizações podem proteger seu acesso à API, melhorar sua vantagem competitiva e contribuir positivamente para o setor de IA em evolução.