10 práticas recomendadas para gerir conteúdos gerados pelo utilizador com a API da OpenAI

A gestão de conteúdos gerados pelos utilizadores é crucial para manter a conformidade com as políticas da OpenAI. Permitir conteúdo não verificado pode levar a repercussões graves, como proibições de API, que podem perturbar significativamente as operações. Neste blogue, vamos explorar dez práticas recomendadas que podem ajudar as empresas a gerir eficazmente os conteúdos gerados pelos utilizadores, garantindo a conformidade e a segurança.

- 1. Utilizar o ponto final de moderação

- 2. Implementar identificadores únicos de utilizador

- 3. Informar os utilizadores sobre as diretrizes de conteúdo

- 4. Monitorizar e registar a atividade do utilizador

- 5. Limitação da taxa e estrangulamento

- 6. Tratamento de erros e feedback

- 7. Rever e atualizar regularmente as políticas

- 8. Utilizar ferramentas de filtragem automatizadas

- 9. Testar a eficácia da moderação

- 10. Contactar o suporte da OpenAI

- A linha de fundo

1. Utilizar o ponto final de moderação

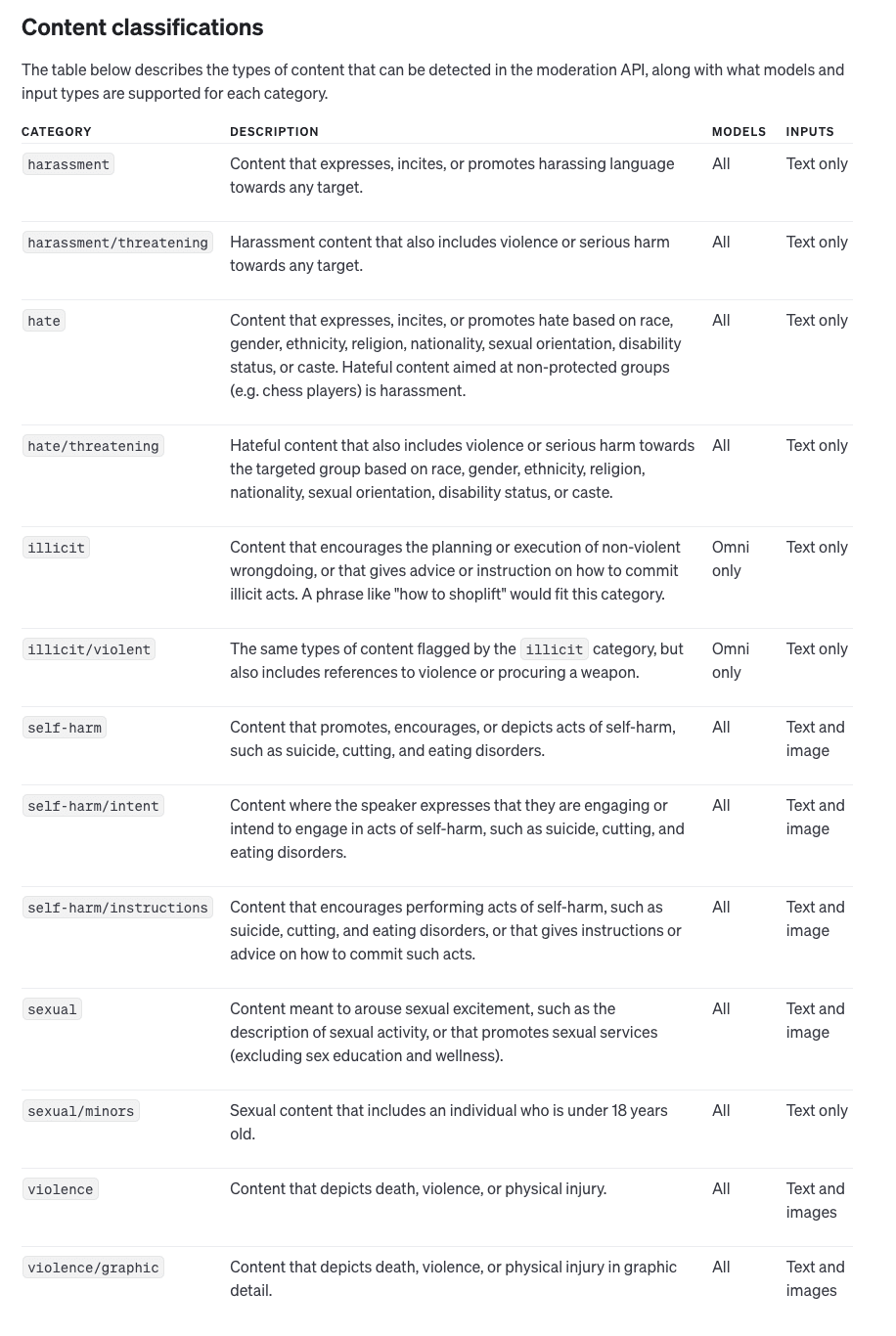

O ponto final de moderação da OpenAI é uma ferramenta poderosa que ajuda a detetar e filtrar conteúdos potencialmente nocivos antes de chegarem à API. O ponto final pode analisar entradas de texto e imagem, identificando categorias como discurso de ódio e violência. A integração desta ferramenta é simples e envolve a verificação da entrada de cada utilizador no ponto final de moderação antes de a enviar para a API principal, minimizando eficazmente o risco de violações.

Ao utilizar o ponto final de moderação de forma proactiva, as empresas podem garantir que estão a filtrar os conteúdos nocivos o mais cedo possível. Isto não só ajuda a manter a conformidade com as políticas da OpenAI, como também proporciona uma experiência de utilizador mais positiva, impedindo a apresentação de conteúdos inadequados. A utilização deste ponto final permite às empresas mitigar os riscos numa fase inicial, reduzindo as hipóteses de receberem avisos ou proibições da OpenAI.

2. Implementar identificadores únicos de utilizador

Incluir um identificador único de utilizador (user_id) em cada chamada de API é vital para rastrear utilizadores individuais. Isso permite que a OpenAI identifique qual usuário pode ser responsável por qualquer violação de política, protegendo seu aplicativo como um todo de ser penalizado devido às ações de um único usuário. O rastreio de utilizadores também fornece uma pista de auditoria clara, facilitando a aplicação da responsabilidade e a manutenção da conformidade.

Os identificadores de utilizador únicos também podem ajudá-lo a implementar controlos de moderação mais granulares. Por exemplo, se um determinado utilizador tentar sistematicamente submeter conteúdos prejudiciais, pode tomar medidas para bloquear ou limitar o acesso desse utilizador sem afetar os outros. Este nível de controlo garante que as acções de um utilizador não comprometem a disponibilidade e a reputação da sua aplicação como um todo.

3. Informar os utilizadores sobre as diretrizes de conteúdo

Para reduzir a probabilidade de violações, informe os seus utilizadores sobre o conteúdo aceitável. Comunique claramente os tipos de conteúdo que não são permitidos, como discursos de ódio ou imagens violentas. Fornecer diretrizes de conteúdo detalhadas pode impedir que os utilizadores enviem material prejudicial, protegendo o acesso à API e reduzindo a necessidade de intervenções de moderação.

Para além de publicar diretrizes de conteúdo, considere incorporar avisos e lembretes educativos na sua interface de utilizador. Ao orientar ativamente os utilizadores sobre os tipos de conteúdo adequados, pode reduzir as violações inadvertidas. Esta abordagem proactiva não só ajuda a manter a conformidade, como também promove uma cultura de criação responsável de conteúdos entre os seus utilizadores.

4. Monitorizar e registar a atividade do utilizador

O registo detalhado das interações dos utilizadores é uma parte essencial da gestão de conteúdos gerados pelos utilizadores. Ao monitorizar a atividade dos utilizadores, as empresas podem identificar rapidamente padrões de utilização indevida e resolver problemas antes que estes se agravem. Os registos podem fornecer provas cruciais para abordar o comportamento dos utilizadores e podem ser utilizados para melhorar as estratégias de moderação ao longo do tempo.

A manutenção de registos abrangentes também permite uma melhor auditoria e responsabilização. Se ocorrer uma violação, ter um histórico bem documentado permite-lhe rastrear e identificar exatamente onde as coisas correram mal. Isto ajuda a refinar a sua abordagem de moderação e a criar regras e filtros mais eficazes para evitar problemas semelhantes no futuro. Isto ajuda a aperfeiçoar a sua abordagem de moderação e a criar regras e filtros mais eficazes para evitar problemas semelhantes no futuro.

5. Limitação da taxa e estrangulamento

Implemente limites de taxa para controlar pedidos excessivos de utilizadores individuais. A limitação garante que nenhum utilizador individual pode sobrecarregar o sistema ou submeter repetidamente conteúdos problemáticos. Isto não só protege a sua API de abusos, como também ajuda a manter a estabilidade do sistema e o acesso equitativo para todos os utilizadores.

A limitação de taxa também pode servir como um mecanismo de alerta precoce para identificar potenciais utilizações indevidas. Por exemplo, se um utilizador começar subitamente a submeter pedidos a uma taxa anormalmente elevada, isso pode indicar um comportamento malicioso ou uma automação a tentar explorar a sua API. Ao detetar estes padrões precocemente, pode mitigar potenciais ameaças antes que estas conduzam a violações mais significativas.

6. Tratamento de erros e feedback

Um sistema robusto de tratamento de erros é crucial para melhorar a experiência do utilizador e, ao mesmo tempo, garantir a conformidade. Quando um pedido é rejeitado devido à moderação, forneça aos utilizadores um feedback claro e informativo sobre o motivo pelo qual o seu contributo foi rejeitado. Isto pode orientar os utilizadores para a apresentação de conteúdos conformes no futuro, reduzindo assim a frequência das violações.

As mensagens de erro eficazes devem não só indicar o que correu mal, mas também oferecer sugestões construtivas sobre a forma de corrigir a entrada. Por exemplo, se um utilizador submeter um conteúdo assinalado por conter linguagem imprópria, o feedback deve explicar este facto e encorajar o utilizador a reformular a frase. Esta abordagem educativa ajuda os utilizadores a compreender os requisitos de moderação e promove interações mais positivas com a sua aplicação.

7. Rever e atualizar regularmente as políticas

Políticas de conteúdo da OpenAI podem mudar ao longo do tempo, e é essencial manter-se informado sobre estas actualizações. Reveja e actualize regularmente as suas políticas internas e estratégias de moderação para as alinhar com quaisquer novas diretrizes. Manter-se atualizado ajudará a manter a conformidade e a evitar penalizações inesperadas.

As políticas internas também devem ser revistas em resposta a incidentes. Se descobrir que certos tipos de conteúdos nocivos estão a passar despercebidos, ajuste as suas regras e procedimentos para colmatar essas lacunas. As revisões regulares das políticas garantem que está sempre a funcionar de acordo com as expectativas mais recentes da OpenAI, minimizando assim o risco de violações.

8. Utilizar ferramentas de filtragem automatizadas

Para além do ponto de extremidade de moderação da OpenAI, considere a possibilidade de adicionar ferramentas de filtragem automatizadas que possam pré-selecionar as entradas do utilizador com base em critérios predefinidos. Esta camada extra de filtragem pode ajudar a reduzir a quantidade de conteúdo potencialmente prejudicial que chega à fase de moderação, tornando o processo de moderação mais eficiente e eficaz.

As ferramentas de filtragem automatizadas podem ser personalizadas para se adequarem às necessidades específicas da sua aplicação. Por exemplo, pode desenvolver filtros adaptados à sua base de utilizadores, concentrando-se em categorias específicas de conteúdo com maior probabilidade de serem problemáticas. Estes sistemas automatizados actuam como a primeira linha de defesa, permitindo que os moderadores humanos ou o ponto de extremidade de moderação OpenAI tratem de casos com mais nuances.

9. Testar a eficácia da moderação

Teste periodicamente a eficácia dos seus processos de moderação, analisando os falsos positivos e negativos. Ajuste os seus critérios de filtragem e algoritmos de moderação com base nestas informações para melhorar a precisão e garantir que os conteúdos conformes não são assinalados por engano enquanto os conteúdos nocivos são efetivamente filtrados.

Testar a eficácia da moderação também pode envolver a recolha de comentários dos utilizadores. Os utilizadores que considerem que o seu conteúdo foi erradamente assinalado podem fornecer informações sobre potenciais melhorias nos seus critérios de moderação. Este ciclo de feedback contínuo ajuda a aperfeiçoar o seu sistema para encontrar o equilíbrio correto entre segurança e liberdade de expressão.

10. Contactar o suporte da OpenAI

Se tiver dúvidas sobre casos de utilização específicos ou precisar de esclarecimentos sobre políticas, não hesite em contactar a equipa de suporte da OpenAI. Os seus conhecimentos podem ser valiosos para adaptar as práticas de moderação às necessidades da sua aplicação e garantir que a sua utilização da API está sempre em conformidade.

O contacto com o suporte da OpenAI também pode ser benéfico quando se está a lidar com áreas cinzentas. Se não tiver a certeza de que um determinado tipo de conteúdo é permitido, procurar aconselhamento pode evitar potenciais violações. O estabelecimento de uma boa relação com o suporte da OpenAI assegurará que tem uma fonte contínua de conhecimentos especializados para o ajudar a navegar em cenários de moderação complexos.

A linha de fundo

Gerir eficazmente o conteúdo gerado pelo utilizador é fundamental para manter a conformidade com as políticas da OpenAI e garantir que o seu acesso à API permanece seguro. Ao seguir estas dez práticas recomendadas, os programadores e as empresas podem reduzir o risco de violações, evitar penalizações e criar uma experiência de utilizador mais positiva. A gestão proactiva e a utilização das ferramentas de moderação da OpenAI podem salvaguardar o seu acesso e ajudá-lo a tirar o máximo partido do poder da IA.