LLMでエンタープライズ・アプリケーションを構築するための4ツール・スタックと戦略 - AI&YOU#53

今週のスタッツ/ファクト 世界のLLM市場は、2023年の$15.9億ドルから2030年には$2,598億ドルに成長し、2023~2030年のCAGRは79.8%になると予測されている(Springs)。

大規模言語モデル(LLM)は、インテリジェントなエンタープライズ・アプリケーションを構築する鍵として浮上してきた。しかし、これらの言語モデルのパワーを活用するには、堅牢で効率的なLLMアプリケーション・スタックが必要です。

Skim AIでは、当社のLLMアプリスタックにより、高度な自然言語対話機能を備えた強力なアプリケーションを作成することができます。私たちのスタックは、LLM API、LangChain、ベクトルデータベースなど、厳選されたツールとフレームワークで構成されています。

今週のAI&YOUでは、エンタープライズLLMアプリケーションを構築するための4つのツールスタックと戦略を、公開ブログを通じてご紹介します:

- LLMでエンタープライズ・アプリケーションを構築するための4つのツール・スタックと戦略 - AI&YOU #53

- ツール1:GPT、Claude、Llama、MistralのようなLLM API

- LLM APIを選択する際に考慮すべき要素

- ツール2:LangChain

- LangChainの各種ツールとサポート

- ツール3:Chromaのようなベクター・データベース

- エンタープライズLLMスタックへのChromaの統合

- ツール4:マルチエージェント・システムのためのcrewAI

- 専門化の力を活用する

- 適切なアプリケーション・スタックでLLMの力を引き出す

- 企業のためのLLM API統合戦略トップ5

- 企業向けオープンソースLLMトップ5

LLMでエンタープライズ・アプリケーションを構築するための4つのツール・スタックと戦略 - AI&YOU #53

私たちのエンタープライズLLMスタックを使用すると、開発者はシームレスに次のことができます。 統合 ドメイン固有のデータ、モデルの微調整、文脈データを取得するための効率的なデータパイプラインの作成など。

これによって企業は、これまでにない正確さとコンテキストを認識した上で、ユーザーのクエリを理解し、それに応答するアプリケーションを構築できるようになる。

同時に、このスタックに沿った主なテクニックの1つは、様々なコンポーネントが提供する既存のツールやフレームワークを活用することだ。これにより、開発者はゼロからツールを作成するのではなく、アプリケーションの構築に集中することができ、貴重な時間と労力を節約することができる。

ツール1:GPT、Claude、Llama、MistralのようなLLM API

LLMアプリケーション・スタックの中核には、LLM APIが必要です。LLM APIは、強力な言語モデルをアプリケーションに統合する方法を提供します。LLM APIは、あなたのソフトウェアと言語モデルを動かす複雑なアルゴリズムとの橋渡しをし、最小限の労力であなたのアプリケーションに高度な自然言語処理機能を追加することを可能にします。

LLM APIを使用する主な利点のひとつは、膨大な量のデータで訓練された最先端の言語モデルを活用できることだ。これらのモデルは、GPT、 クロード, ミストラルそして ラマそのため、人間のように正確で流暢な文章を理解し、生成することができる。

これらのモデルにAPIコールを行うことで、テキスト生成、感情分析、質問応答など、幅広い機能をアプリケーションに素早く追加することができる。

LLM APIを選択する際に考慮すべき要素

あなたのスタックにLLM APIを選択する場合、考慮すべきいくつかの要因があります:

パフォーマンスと精度: APIがワークロードを処理し、信頼できる結果を提供できることを確認する。

カスタマイズと柔軟性: 特定のユースケースに合わせてモデルを微調整する必要があるか、スタックの他のコンポーネントと統合する必要があるかを検討する。

スケーラビリティ: 大量のリクエストが予想される場合は、APIがそれに応じてスケールできることを確認すること。

サポートとコミュニティ: アプリケーションの長期的な実行可能性に影響を与える可能性があるため、API周りのサポートのレベルとコミュニティの規模を評価する。

ほとんどのLLM APIの中核にあるのは、大量のテキストデータで学習されるディープ・ニューラル・ネットワークで、通常はトランスフォーマ・アーキテクチャに基づいている。これらのモデルはAPIインターフェースを介してアクセスされ、認証、リクエストルーティング、レスポンスのフォーマットなどのタスクを処理する。LLM APIには、トークン化や正規化といったデータ処理のための追加コンポーネントや、微調整やカスタマイズのためのツールも含まれていることが多い。

ツール2:LangChain

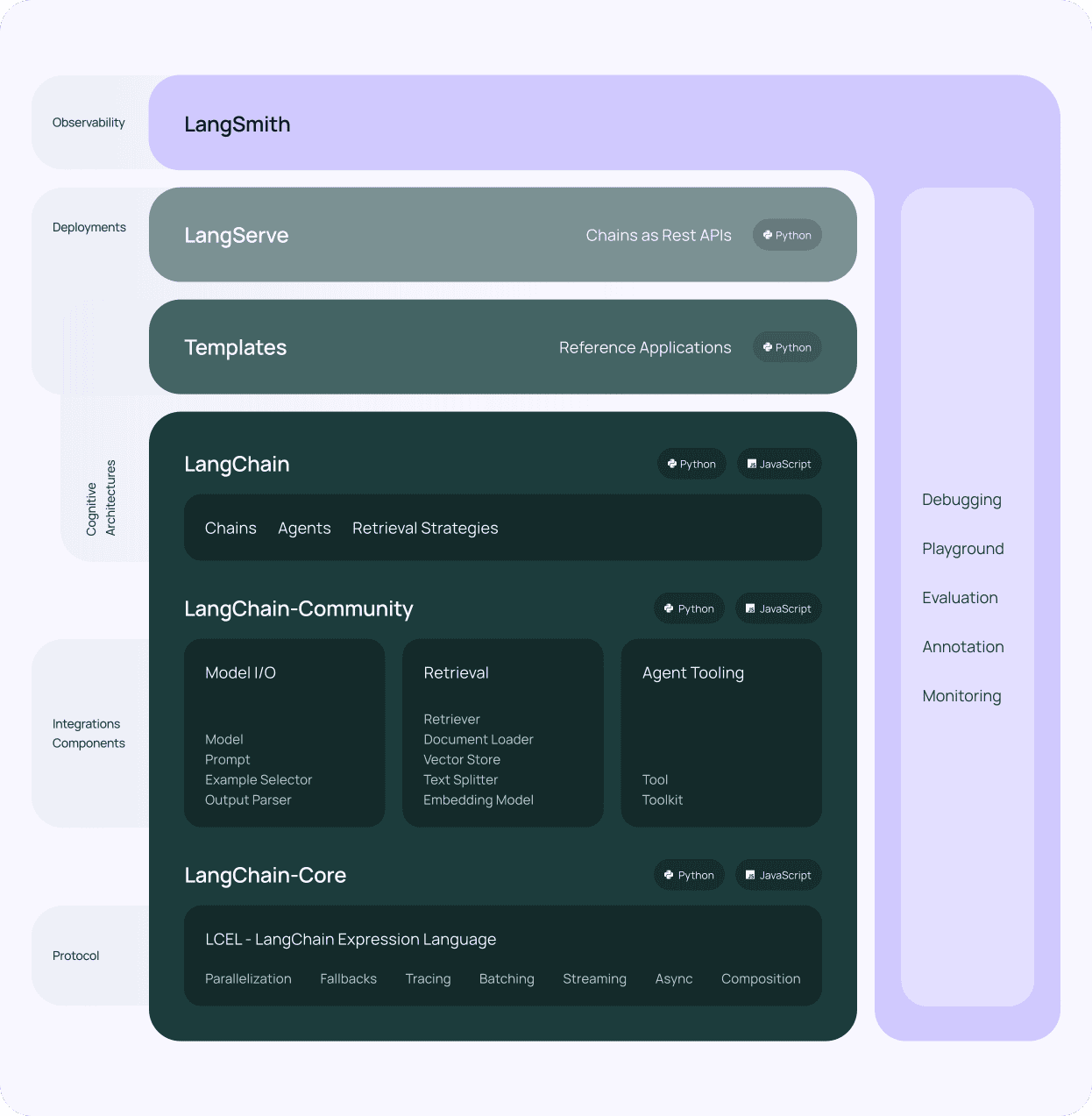

LLMアプリケーションスタック用にLLM APIを選択した後、次に考慮すべき要素は以下の通りです。 ラングチェーン.LangChainは、大規模な言語モデルの上にアプリケーションを構築するプロセスを簡素化するために設計された強力なフレームワークです。様々なLLM APIと対話するための標準化されたインタフェースを提供し、LLM技術スタックへの統合を容易にします。

LangChainを使う主な利点の一つは、そのモジュラーアーキテクチャです。LangChainはプロンプト、チェーン、エージェント、メモリなど複数のコンポーネントで構成されており、これらを組み合わせることで複雑なワークフローを作成することができます。このモジュール性により、単純な質問応答からコンテンツ生成やデータ分析のような高度なユースケースまで、幅広いタスクを処理できるアプリケーションを構築することができ、ドメイン固有のデータとの自然言語インタラクションを可能にします。

LangChainの各種ツールとサポート

LangChainはまた、LLMでの作業を効率化する様々なツールやユーティリティも提供している。例えば、意味検索やクラスタリングなどのタスクに使われるテキストの数値表現であるエンベッディングを扱うためのツールを提供します。さらにLangChainには、言語モデルの動作をガイドするための入力文字列であるプロンプトを管理するユーティリティも含まれている。

LangChainのもう一つの重要な特徴は、ベクターデータベースのサポートです。LangChainはChromaのようなベクターデータベースと統合することで、大量のデータを効率的に保存・検索できるアプリケーションを構築できます。この統合により、様々な情報ソースを利用できる知識集約型アプリケーションを作成することができ、LLMアプリケーションスタックのコンテキストデータの検索を強化することができます。

LangChainは、どのような企業にとっても不可欠なコンポーネントです。 企業LLM アプリケーション・スタックである。モジュール設計、強力なツール、活発なコミュニティにより、洗練された言語ベースのアプリケーションを構築するのに不可欠なツールとなっている。

ツール3:Chromaのようなベクター・データベース

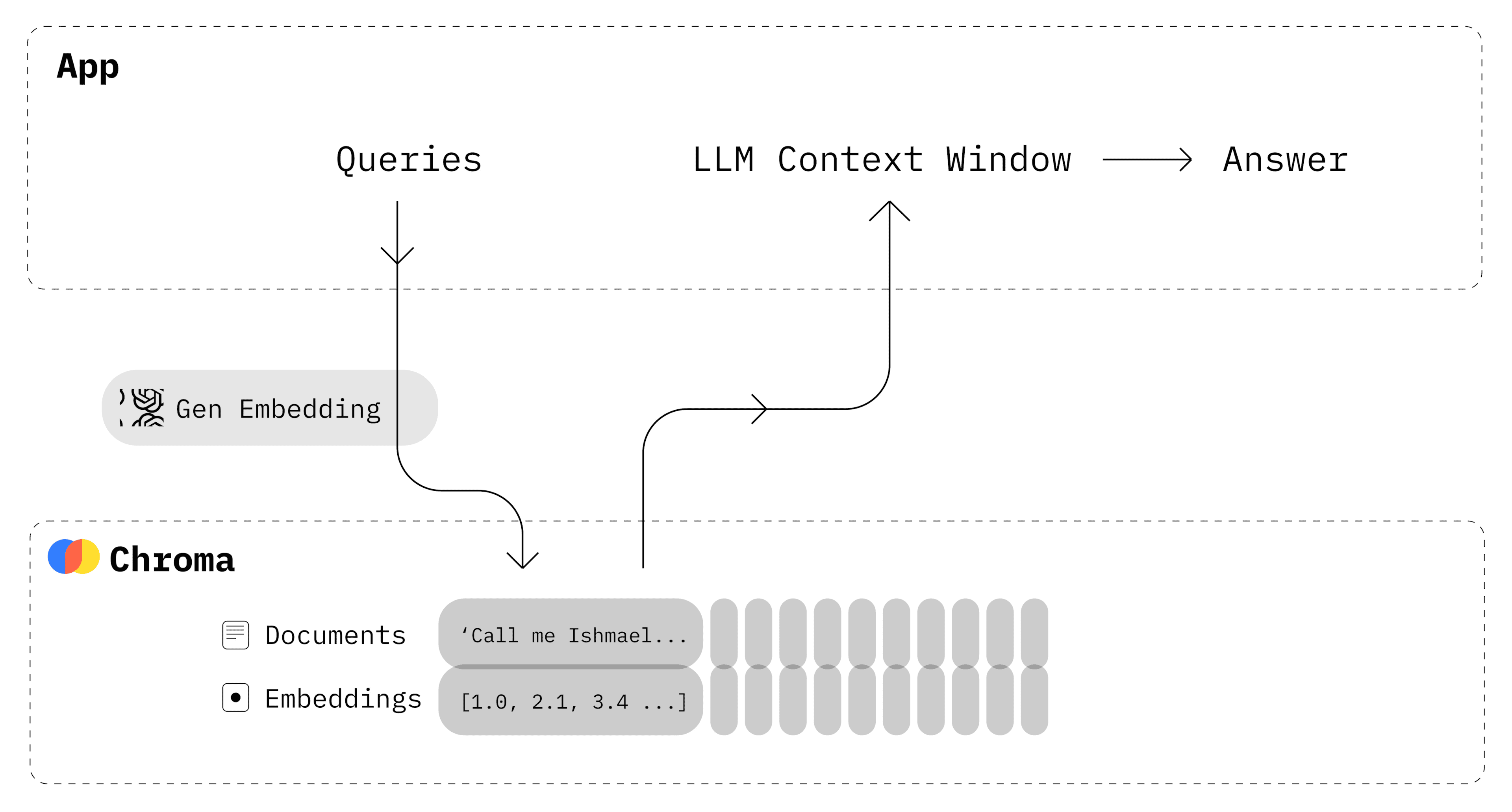

LLM APIとLangChainに加えて、LLMアプリスタックに不可欠なもう一つのコンポーネントはベクターデータベースです。ベクターデータベースは、大規模な言語モデルによって生成されたエンベッディングのような、高次元ベクターの保存と検索に最適化された特殊なデータストアです。ベクターデータベースをLLM技術スタックに統合することで、意味的類似性に基づく関連データの高速で効率的な検索が可能になります。

クロマ は、LLMアプリケーションスタックのベクトルデータベースとして人気のあるオープンソースの選択肢であり、ここSkim AIでも使用しています。LangChainやスタックの他のコンポーネントとシームレスに動作するように設計されており、エンベッディングの保存と取得のための堅牢でスケーラブルなソリューションを提供します。

Chromaを使用する主な利点の一つは、大量のデータを効率的に処理できることです。Chromaは高度なインデックス作成技術により、膨大なデータセットでも高速な類似検索を可能にします。そのため、ドキュメントリポジトリ、ナレッジベース、コンテンツ管理システムなど、大量のテキストデータを保存し、検索する必要があるアプリケーションに最適です。

Chromaは、フィルタリングやメタデータサポートなどの高度な機能も提供します。ドキュメントID、タイムスタンプ、カスタム属性などのメタデータを埋め込むことができます。このメタデータを検索結果のフィルタリングに使用することで、より正確で的を絞った文脈データの検索が可能になります。

エンタープライズLLMスタックへのChromaの統合

Chromaは、LangChainや他の一般的なツールやフレームワークと互換性があるため、LLMアプリケーションスタックに統合するのは簡単です。LangChainはChromaのビルトインサポートを提供しており、言語モデルによって生成されたエンベッディングの保存と取得が簡単にできます。この統合により、自然言語とのインタラクションに基づいて関連情報を素早く表示できる強力な検索メカニズムを構築できます。

ChromaのようなベクターデータベースをLLMと組み合わせて使用することで、インテリジェントでコンテキストを意識したアプリケーションを構築するための新たな可能性が開けます。エンベッディングと類似検索のパワーを活用することで、これまでにない精度と関連性でユーザーのクエリを理解し、それに応答できるアプリケーションを作成できます。

Chromaは、LangChainやLLM APIと組み合わせることで、インテリジェントなデータ駆動型アプリケーションを構築するための強力な基盤を形成します。

ツール4:マルチエージェント・システムのためのcrewAI

Skim AIでは、AIワークフローの未来はエージェント型であることを理解しており、マルチエージェントシステムが今日の企業にとって重要である理由はそこにある。

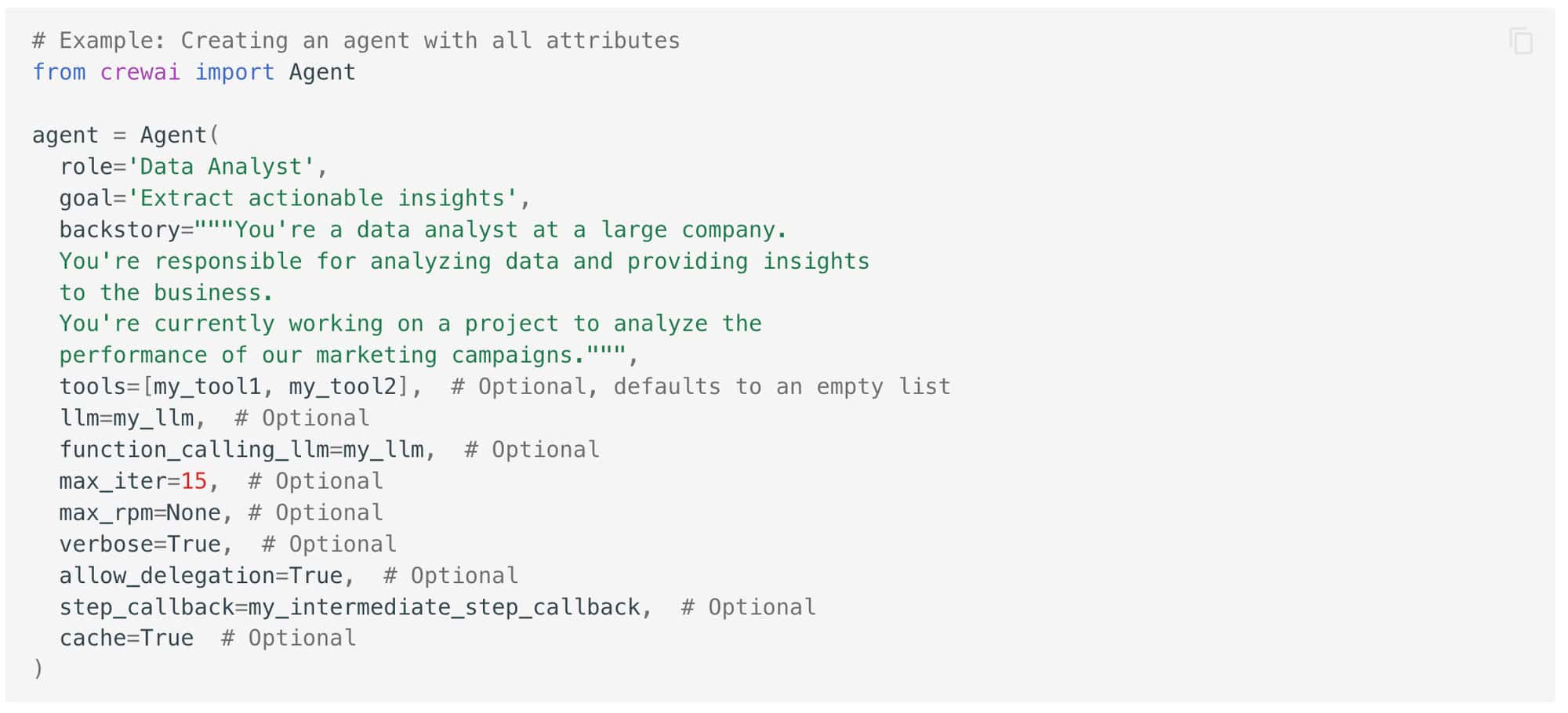

クルーAI crewAIは、複数のAIエージェントが協力して複雑なタスクを遂行するマルチエージェントシステムを作成できるフレームワークです。

crewAIは、それぞれが特定の役割と専門知識を持つ複数のAIエージェント間のコラボレーションを促進するように設計されています。これらのエージェントは、複雑な問題をより小さく、より管理しやすいサブタスクに分解するために、相互に通信し、調整することができます。

専門化の力を活用する

LLM技術スタックでcrewAIを使用する主な利点の1つは、特殊化の力を活用できることです。異なるエージェントに特定の役割やタスクを割り当てることで、単一のモノリシックなAIモデルよりも効率的で効果的なシステムを作ることができます。各エージェントは、その特定のタスクのために訓練され最適化されるため、汎用モデルよりも高いレベルで実行することができ、ドメイン固有のデータセットから、より的を絞った文脈データの検索が可能になります。

crewAIをLLM技術スタックの他のコンポーネントと組み合わせて使用することで、実世界の複雑なタスクを処理できるインテリジェントなマルチエージェントシステムを構築するための新しい可能性を引き出すことができます。専門性とコラボレーションの力を活用することで、従来の単一モデルのアプローチよりも効率的で効果的でユーザーフレンドリーなアプリケーションを作成できます。

適切なアプリケーション・スタックでLLMの力を引き出す

このスタックにより、ドメイン固有のデータをシームレスに統合し、コンテキスト情報の効率的な検索を可能にし、複雑な現実世界の課題に取り組むことができる洗練されたワークフローを構築することができます。これらのツールとフレームワークのパワーを活用することで、言語ベースのAIアプリケーションで可能なことの限界を押し広げ、真にインテリジェントなシステムを構築することができます。

企業のためのLLM API統合戦略トップ5

今週はまた、企業にとってのLLM API統合戦略のトップ5を探った。

モジュール式の統合から継続的な監視と最適化まで、これらの戦略は、スムーズな導入、最適なパフォーマンス、長期的な成功を確実にするように設計されています。

モジュラー・インテグレーション には、LLM API統合プロセスを、段階的に実装可能な、より小さく管理可能なモジュールに分解することが含まれる。このアプローチにより、段階的な実装、より容易なトラブルシューティング、より柔軟な更新と拡張が可能になります。

アン APIゲートウェイ は、認証、レート制限、リクエストルーティングを管理し、すべてのAPIリクエストの単一のエントリーポイントとして機能します。一元化された認証、レート制限、APIの使用状況とパフォーマンスに関する貴重な洞察を提供します。

マイクロサービス・アーキテクチャ これは、モノリシックなアプリケーションを、独立して開発、デプロイ、スケーリングが可能な、より小さく疎結合なサービスに分解することである。これにより、独立した開発、きめ細かなスケーラビリティ、俊敏性と柔軟性の向上が可能になる。

LLM APIのカスタマイズと微調整 には、特定の業界、ドメイン、またはアプリケーションの要件により適合させることが含まれる。これにより、アウトプットの正確性、関連性が向上し、用語、スタイル、フォーマットとの整合が可能になる。

継続的なモニタリングと最適化 には、パフォーマンスメトリクスの追跡、アウトプットの品質/関連性の評価、反復的な改善が含まれます。これにより、プロアクティブに問題を特定し、変化する要件に適応し、LLM API統合の価値を継続的に向上させることができます。

LLMテクノロジーの分野が急速なペースで進化を続けるなか、堅牢で拡張性があり、適応性の高い統合戦略に投資する企業は、こうした変革的ツールの可能性を最大限に引き出すことができる。

企業向けオープンソースLLMトップ5

オープンソースの大規模言語モデル(LLM)は、次のような役割を担っている。 2024年の企業向け強力ツール.

オープンソースLLMを使用する主な利点の一つは、柔軟性とカスタマイズ性である。さらに、オープンソースのLLMは、プロプライエタリなモデルの開発と保守に代わる費用対効果の高い選択肢を提供します。AIコミュニティの総力を結集することで、企業は研究開発に大規模な投資をすることなく、最先端の言語モデルを利用することができます。

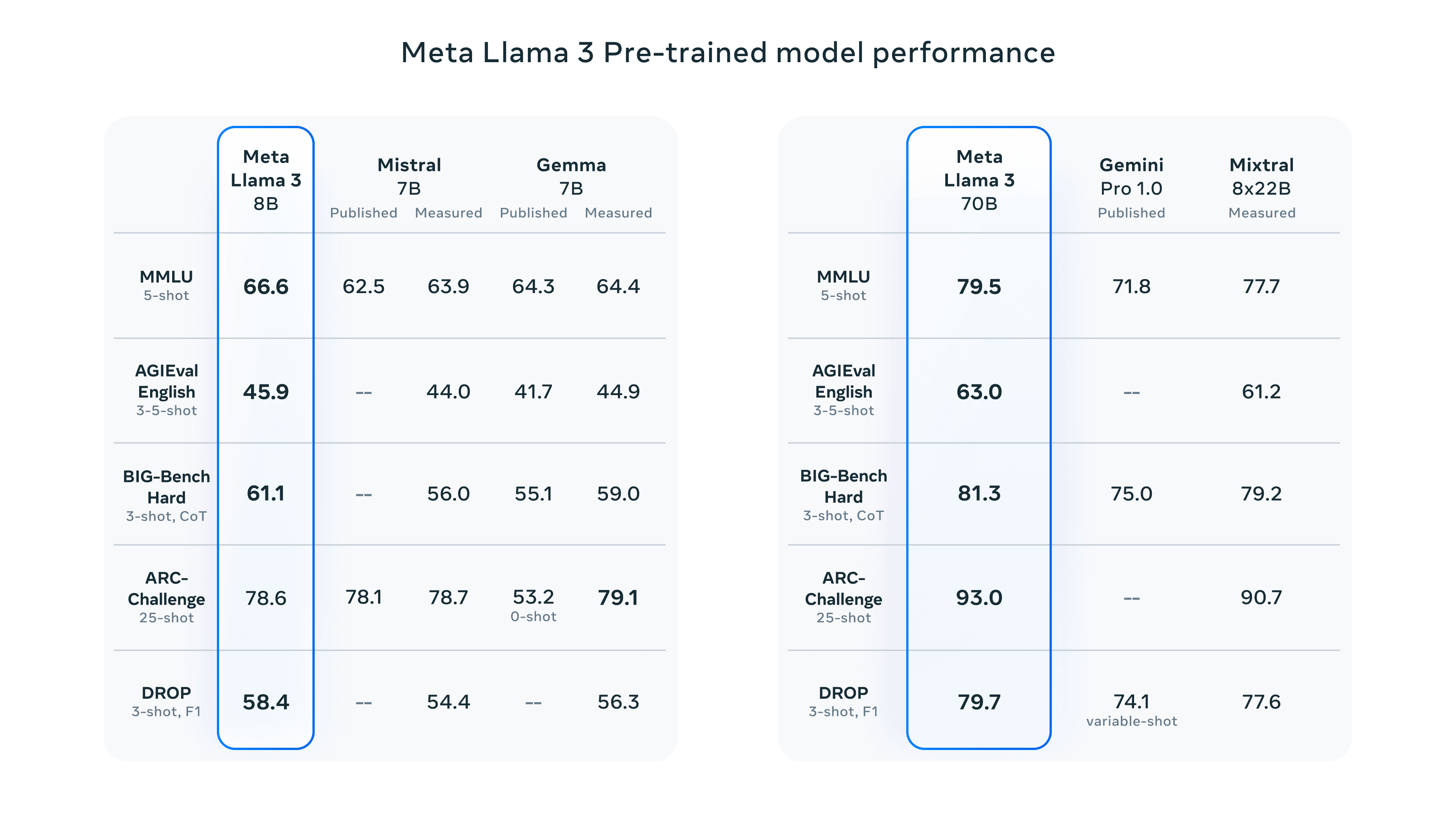

メタのラマ3 Llama 3は最先端のオープンソース大規模言語モデルで、2つのサイズバリエーション(パラメータ8Bと70B)があり、それぞれBaseモデルとInstructモデルを提供しています。様々なNLPタスクに優れ、展開が容易で、責任あるAIプラクティスを遵守しています。

クロード3 by Anthropic: クロード3には、さまざまなユースケースに最適化された3つのバリエーション(Haiku、Sonnet、Opus)がある。推論、専門知識、流暢な言語といった認知タスクにおいて、GPT-4のようなモデルを凌駕する素晴らしいパフォーマンスを発揮する。

xAIによるGrok: イーロン・マスクのxAIによって開発されたGrokは、テキストの要約と理解に特化している。その最新版であるGrok-1.5は、長い文脈の理解、高度な推論、強力なコーディング/数学機能を導入している。

GoogleによるBERT: BERTは双方向言語理解のパイオニアであり、テキスト分類、感情分析、質問応答などのタスクに優れている。その事前学習により、人間のようなテキストを生成し、文脈に関連した応答を提供することができる。

ミストラルAIによるミストラル・ラージ: 314Bのパラメータを持つMistral Largeは、複雑な推論タスクや特殊なアプリケーションで威力を発揮します。多言語サポート、命令追従、関数呼び出し機能を備え、汎用性を高めています。

オープンソースのAIコミュニティが言語モデルで可能なことの限界を押し広げ続ける中、これらの強力なツールを採用する企業は、曲線の先端に立ち、長期的な成功を達成するのに有利な立場になるだろう。

インフォグラフィックス、統計、ハウツーガイド、記事、ビデオなど、エンタープライズAIに関するその他のコンテンツについては、Skim AIをフォローしてください。 LinkedIn

創業者、CEO、ベンチャーキャピタリスト、投資家の皆様は、専門的なAIアドバイザリーまたはデューデリジェンスサービスをお探しですか?貴社のAI製品戦略や投資機会について、十分な情報に基づいた意思決定を行うために必要なガイダンスを得ることができます。

企業向けAIソリューションの立ち上げにお困りですか?当社のAIワークフォースマネジメント・プラットフォームを使用して独自のAI労働者を構築することをお考えですか?ご相談ください

ベンチャーキャピタルやプライベートエクイティが支援する以下の業界の企業向けに、カスタムAIソリューションを構築しています:医療テクノロジー、ニュース/コンテンツアグリゲーション、映画/写真制作、教育テクノロジー、リーガルテクノロジー、フィンテック&暗号通貨。