Il nostro stack di 4 strumenti e la strategia per la creazione di applicazioni aziendali sui LLM - AI&YOU#53

Statistica/fatto della settimana: Si prevede che il mercato globale dei LLM crescerà da $1,59 miliardi nel 2023 a $259,8 miliardi nel 2030, con un CAGR di 79,8% nel periodo 2023-2030 (Springs).

I modelli linguistici di grandi dimensioni (LLM) sono emersi come una chiave per costruire applicazioni aziendali intelligenti. Tuttavia, per sfruttare la potenza di questi modelli linguistici è necessario uno stack applicativo LLM robusto ed efficiente.

In Skim AI, il nostro stack di applicazioni LLM ci permette di creare potenti applicazioni con funzionalità avanzate di interazione in linguaggio naturale. Il nostro stack comprende strumenti e framework accuratamente selezionati, come le API LLM, LangChain e i database vettoriali.

Nell'edizione di questa settimana di AI&YOU, mettiamo in evidenza il nostro stack di 4 strumenti e la nostra strategia per la creazione di applicazioni LLM aziendali attraverso i nostri blog pubblicati:

Come costruire il vostro stack di applicazioni LLM con questi 4 strumenti e framework

Le 5 principali strategie di integrazione delle API LLM per la vostra azienda

- Il nostro stack di 4 strumenti e la nostra strategia per costruire applicazioni aziendali sui LLM - AI&YOU #53

- Strumento 1: un'API LLM come GPT, Claude, Llama o Mistral

- Fattori da considerare nella scelta di un LLM API

- Strumento 2: LangChain

- Vari strumenti e supporto di LangChain

- Strumento 3: un database vettoriale come Chroma

- Integrazione di Chroma nello stack LLM aziendale

- Strumento 4: crewAI per sistemi multi-agente

- Sfruttare il potere della specializzazione

- Sfruttare la potenza degli LLM con il giusto stack applicativo

- Le 5 principali strategie di integrazione delle API LLM per la vostra azienda

- I 5 migliori LLM open source per la vostra azienda

Il nostro stack di 4 strumenti e la nostra strategia per costruire applicazioni aziendali sui LLM - AI&YOU #53

Grazie al nostro stack LLM aziendale, gli sviluppatori possono integrare dati specifici del dominio, perfezionare i modelli, creare pipeline di dati efficienti per il recupero di dati contestuali e altro ancora.

Ciò consente alle aziende di creare applicazioni che comprendono e rispondono alle richieste degli utenti con una precisione e una consapevolezza del contesto senza precedenti.

Allo stesso tempo, una delle tecniche principali per accompagnare questo stack è quella di utilizzare gli strumenti e i framework esistenti forniti dai vari componenti. Questo permette agli sviluppatori di concentrarsi sulla costruzione di applicazioni piuttosto che sulla creazione di strumenti da zero, risparmiando tempo e fatica.

Strumento 1: un'API LLM come GPT, Claude, Llama o Mistral

Al centro del vostro stack di applicazioni LLM dovrebbe esserci un'API LLM. Le API LLM offrono un modo per integrare potenti modelli linguistici nelle applicazioni senza dover addestrare o ospitare i modelli stessi. Fanno da ponte tra il vostro software e i complessi algoritmi che alimentano i modelli linguistici, consentendovi di aggiungere alle vostre applicazioni funzionalità avanzate di elaborazione del linguaggio naturale con il minimo sforzo.

Uno dei vantaggi principali dell'utilizzo di un'API LLM è la possibilità di sfruttare modelli linguistici all'avanguardia che sono stati addestrati su grandi quantità di dati. Questi modelli, come GPT, Claude, Maestrale, e Lamasono in grado di comprendere e generare testi simili a quelli umani con notevole accuratezza e fluidità.

Effettuando chiamate API a questi modelli, è possibile aggiungere rapidamente alle proprie applicazioni un'ampia gamma di funzionalità, tra cui la generazione di testi, l'analisi del sentiment, la risposta a domande e molto altro ancora.

Fattori da considerare nella scelta di un LLM API

Quando si sceglie un LLM API per il proprio stack, ci sono diversi fattori da considerare:

Prestazioni e precisione: Assicuratevi che l'API sia in grado di gestire il vostro carico di lavoro e di fornire risultati affidabili.

Personalizzazione e flessibilità: Considerate se è necessario perfezionare il modello per il vostro caso d'uso specifico o integrarlo con altri componenti del vostro stack.

Scalabilità: Se prevedete un volume elevato di richieste, assicuratevi che l'API possa scalare di conseguenza.

Sostegno e comunità: Valutare il livello di supporto e le dimensioni della comunità intorno all'API, in quanto ciò può influire sulla redditività a lungo termine della vostra applicazione.

Il cuore della maggior parte delle API LLM è costituito da reti neurali profonde, tipicamente basate su architetture a trasformatori, che vengono addestrate su enormi quantità di dati testuali. A questi modelli si accede tramite un'interfaccia API, che gestisce compiti come l'autenticazione, l'instradamento delle richieste e la formattazione delle risposte. Le API LLM spesso includono anche componenti aggiuntivi per l'elaborazione dei dati, come la tokenizzazione e la normalizzazione, nonché strumenti per la messa a punto e la personalizzazione.

Strumento 2: LangChain

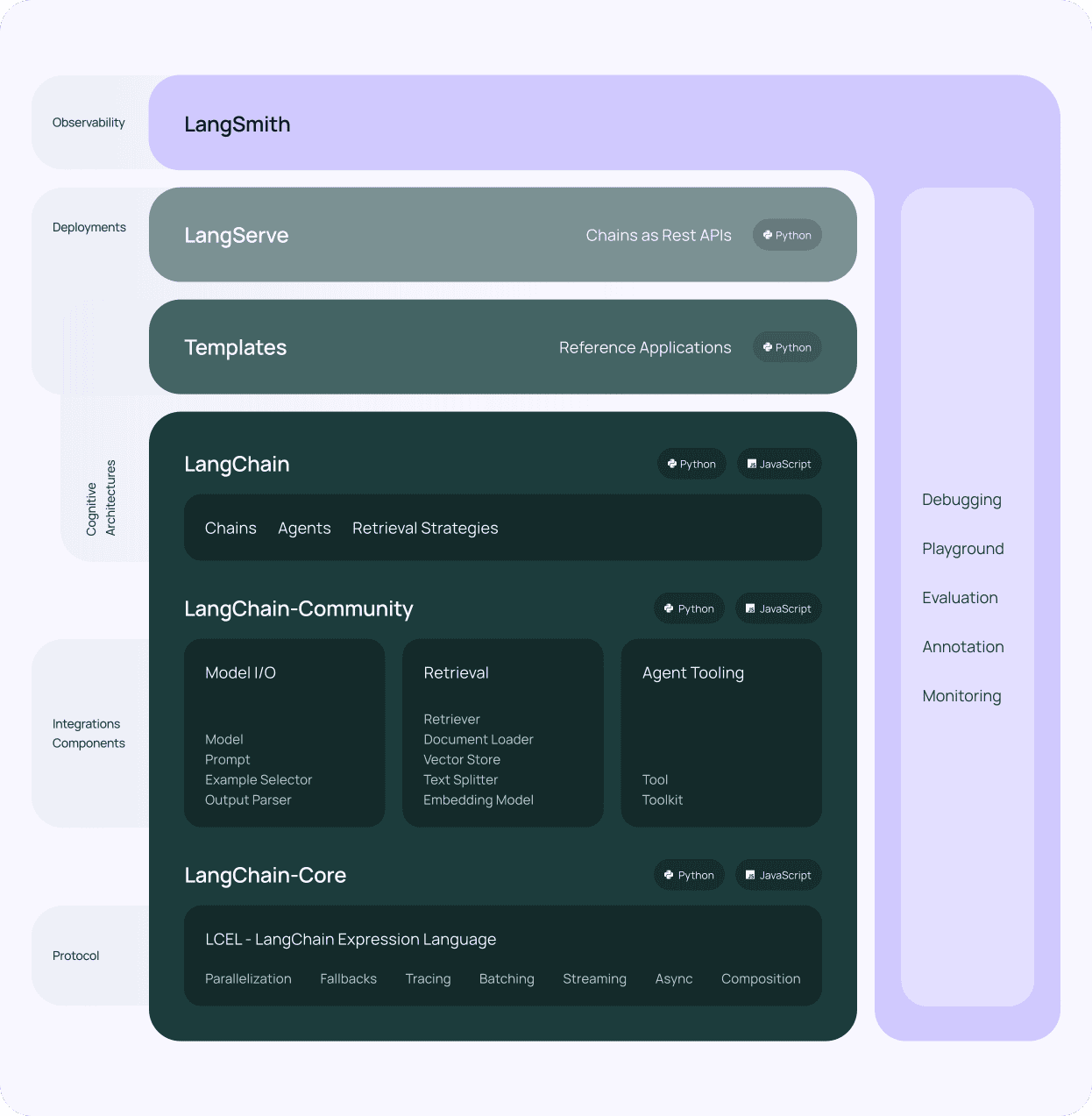

Dopo aver scelto un'API LLM per il vostro stack di applicazioni LLM, il componente successivo da considerare è Catena di Langhe. LangChain è un potente framework progettato per semplificare il processo di costruzione di applicazioni sulla base di modelli linguistici di grandi dimensioni. Fornisce un'interfaccia standardizzata per interagire con le varie API LLM, rendendo più facile la loro integrazione nel proprio stack tecnologico LLM.

Uno dei vantaggi principali dell'uso di LangChain è la sua architettura modulare. LangChain è costituito da diversi componenti, come prompt, catene, agenti e memoria, che possono essere combinati per creare flussi di lavoro complessi. Questa modularità consente di costruire applicazioni in grado di gestire un'ampia gamma di attività, dalla semplice risposta a domande a casi d'uso più avanzati come la generazione di contenuti e l'analisi dei dati, consentendo l'interazione in linguaggio naturale con i dati specifici del dominio.

Vari strumenti e supporto di LangChain

LangChain fornisce anche una serie di strumenti e utilità che semplificano il lavoro con gli LLM. Per esempio, offre strumenti per lavorare con gli embeddings, che sono rappresentazioni numeriche del testo utilizzate per compiti come la ricerca semantica e il clustering. Inoltre, LangChain include utility per gestire i prompt, ovvero le stringhe di input utilizzate per guidare il comportamento dei modelli linguistici.

Un'altra caratteristica fondamentale di LangChain è il supporto per i database vettoriali. Integrandosi con database vettoriali come Chroma (che è quello che usiamo noi), LangChain consente di creare applicazioni in grado di memorizzare e recuperare in modo efficiente grandi quantità di dati. Questa integrazione consente di creare applicazioni ad alta intensità di conoscenza che possono attingere a un'ampia gamma di fonti di informazioni, migliorando il reperimento di dati contestuali per il vostro stack di applicazioni LLM.

LangChain è un componente vitale di qualsiasi impresa LLM di applicazioni. Il suo design modulare, i suoi potenti strumenti e la sua attiva comunità lo rendono uno strumento indispensabile per la realizzazione di sofisticate applicazioni basate su un linguaggio.

Strumento 3: un database vettoriale come Chroma

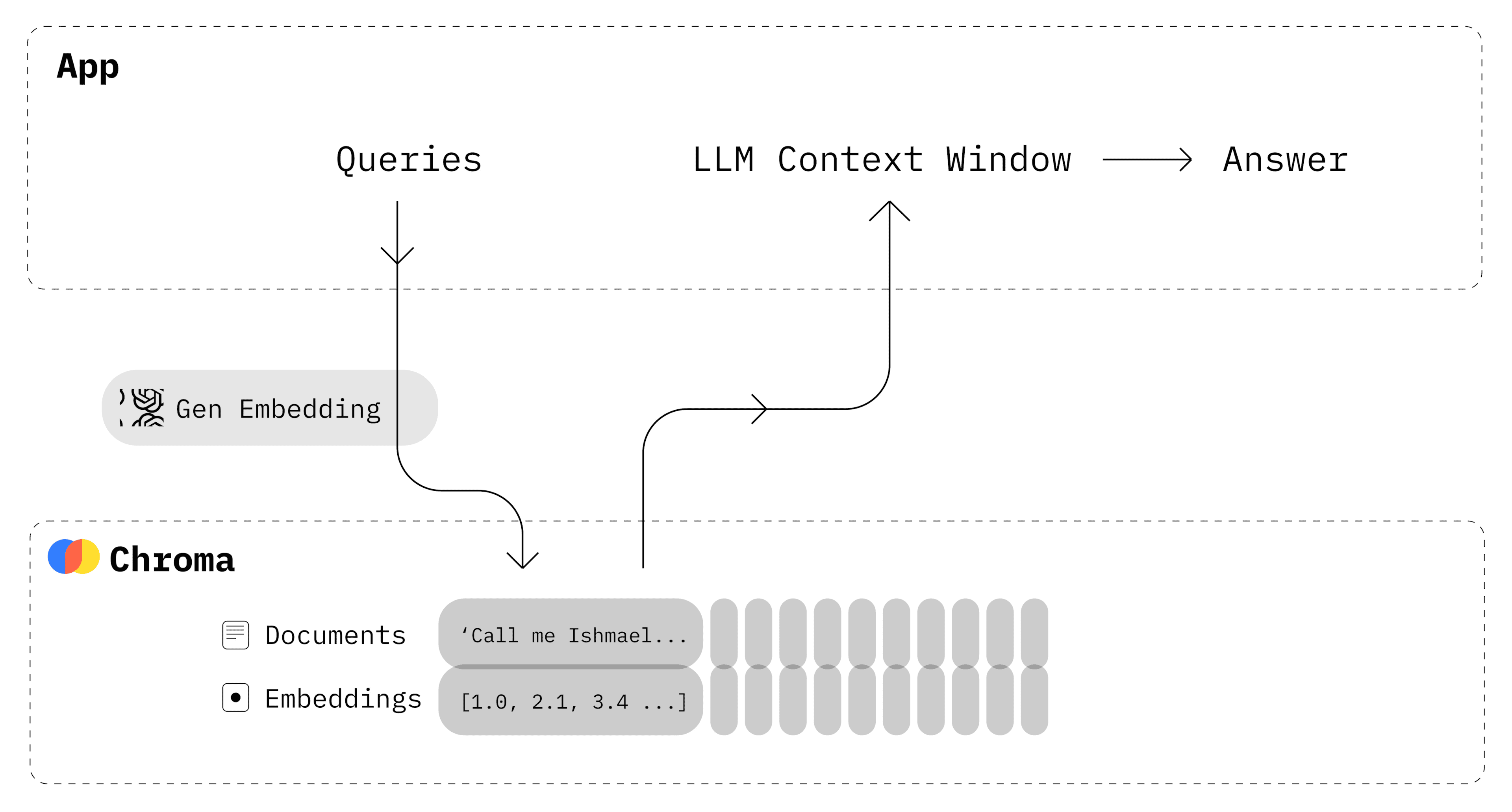

Oltre a un'API LLM e a LangChain, un altro componente essenziale dello stack di applicazioni LLM è un database vettoriale. I database vettoriali sono archivi di dati specializzati ottimizzati per l'archiviazione e la ricerca di vettori ad alta dimensionalità, come gli embeddings generati da modelli linguistici di grandi dimensioni. L'integrazione di un database vettoriale nello stack tecnologico di LLM consente di recuperare in modo rapido ed efficiente i dati pertinenti in base alla similarità semantica.

Croma è una scelta open-source molto diffusa come database vettoriale negli stack di applicazioni LLM, e noi lo usiamo qui a Skim AI. È progettato per funzionare senza problemi con LangChain e altri componenti dello stack, fornendo una soluzione robusta e scalabile per memorizzare e recuperare gli embeddings.

Uno dei vantaggi principali di Chroma è la sua capacità di gestire in modo efficiente grandi volumi di dati. Chroma utilizza tecniche di indicizzazione avanzate per consentire una rapida ricerca per similarità, anche su insiemi di dati enormi. Questo lo rende una scelta ideale per le applicazioni che devono archiviare e cercare in grandi quantità di dati testuali, come archivi di documenti, basi di conoscenza e sistemi di gestione dei contenuti.

Chroma offre anche funzioni avanzate come il filtraggio e il supporto dei metadati. È possibile memorizzare metadati aggiuntivi accanto alle incorporazioni, come ID documento, timestamp o attributi personalizzati. Questi metadati possono essere utilizzati per filtrare i risultati della ricerca, consentendo un recupero più preciso e mirato dei dati contestuali.

Integrazione di Chroma nello stack LLM aziendale

L'integrazione di Chroma nello stack di applicazioni LLM è semplice, grazie alla sua compatibilità con LangChain e altri strumenti e framework popolari. LangChain offre un supporto integrato per Chroma, rendendo più semplice l'archiviazione e il recupero degli embeddings generati dai modelli linguistici. Questa integrazione consente di costruire potenti meccanismi di recupero che possono far emergere rapidamente informazioni rilevanti basate sull'interazione con il linguaggio naturale.

L'utilizzo di un database vettoriale come Chroma in combinazione con gli LLM apre nuove possibilità per la creazione di applicazioni intelligenti e consapevoli del contesto. Sfruttando la potenza degli embeddings e della ricerca per similarità, è possibile creare applicazioni in grado di comprendere e rispondere alle richieste degli utenti con un'accuratezza e una pertinenza senza precedenti.

In combinazione con LangChain e un'API LLM, Chroma costituisce una base potente per la costruzione di applicazioni intelligenti e guidate dai dati, in grado di trasformare il modo in cui interagiamo con i dati aziendali e le informazioni specifiche del dominio.

Strumento 4: crewAI per sistemi multi-agente

Noi di Skim AI sappiamo che il futuro dei flussi di lavoro dell'AI è agenziale, ed è per questo che un sistema multi-agente è oggi importante per qualsiasi azienda.

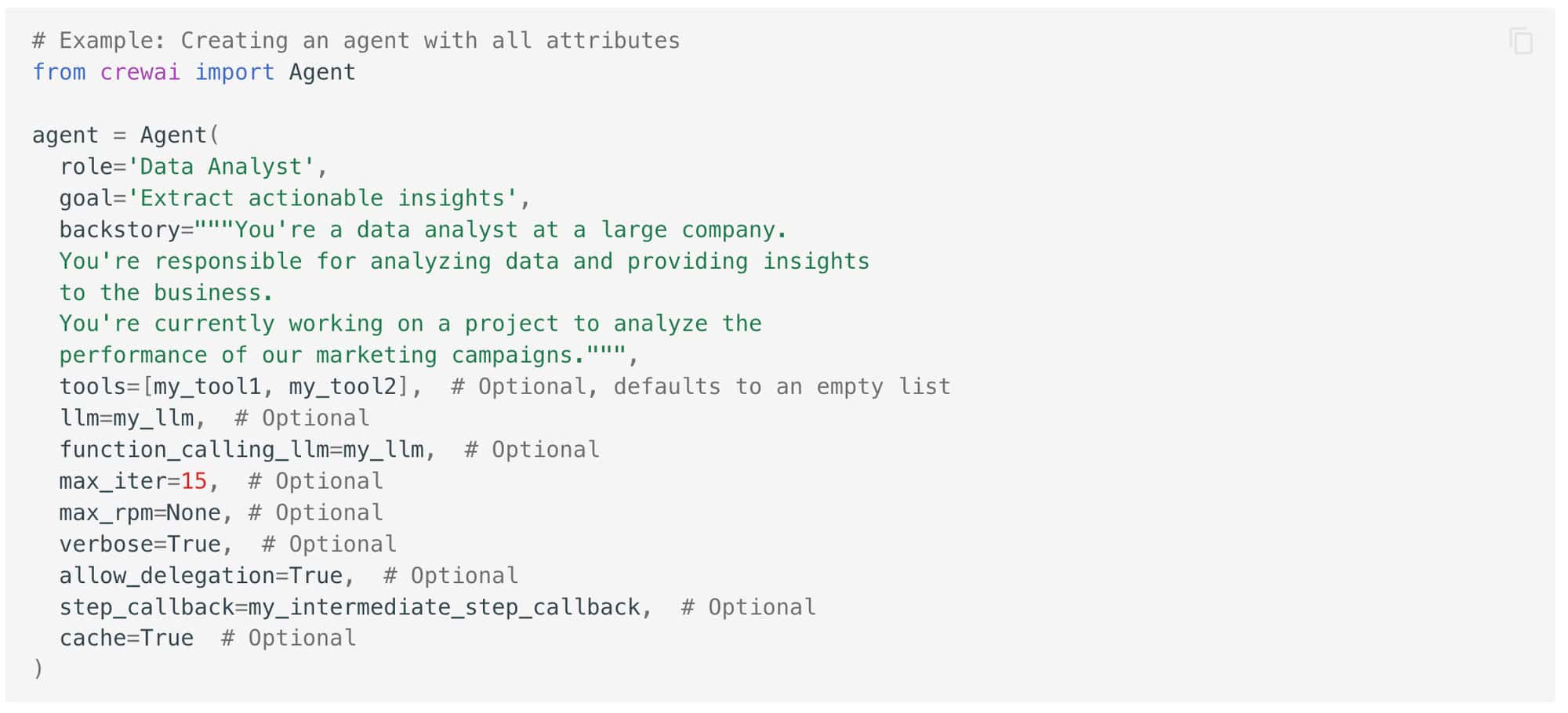

crewAI è un altro potente strumento che si può aggiungere allo stack di applicazioni LLM per migliorare le capacità delle applicazioni. crewAI è un framework che consente di creare sistemi multi-agente, in cui più agenti AI lavorano insieme per portare a termine compiti complessi.

Nel suo nucleo, crewAI è progettato per facilitare la collaborazione tra più agenti AI, ciascuno con un ruolo e una competenza specifici. Questi agenti possono comunicare e coordinarsi tra loro per suddividere problemi complessi in sottoattività più piccole e gestibili.

Sfruttare il potere della specializzazione

Uno dei vantaggi principali dell'utilizzo di crewAI nel vostro stack tecnologico LLM è la sua capacità di sfruttare il potere della specializzazione. Assegnando ruoli e compiti specifici a diversi agenti, è possibile creare un sistema più efficiente ed efficace di un singolo modello monolitico di IA. Ogni agente può essere addestrato e ottimizzato per il suo compito specifico, consentendogli di ottenere prestazioni più elevate rispetto a un modello generico e permettendo un recupero più mirato dei dati contestuali dai set di dati specifici del dominio.

L'uso di crewAI in combinazione con altri componenti del vostro stack tecnologico LLM può aiutarvi a sbloccare nuove possibilità di costruire sistemi intelligenti e multi-agente in grado di gestire compiti complessi del mondo reale. Sfruttando la potenza della specializzazione e della collaborazione, è possibile creare applicazioni più efficienti, efficaci e facili da usare rispetto ai tradizionali approcci a modello singolo.

Sfruttare la potenza degli LLM con il giusto stack applicativo

Questo stack consente di integrare senza problemi i dati specifici del dominio, di recuperare in modo efficiente le informazioni contestuali e di creare flussi di lavoro sofisticati in grado di affrontare sfide complesse del mondo reale. Sfruttando la potenza di questi strumenti e framework, è possibile superare i limiti di ciò che è possibile fare con le applicazioni di intelligenza artificiale basate sul linguaggio e creare sistemi veramente intelligenti che possono trasformare il modo in cui l'azienda interagisce con i dati e la tecnologia.

Le 5 principali strategie di integrazione delle API LLM per la vostra azienda

Questa settimana abbiamo anche esplorato le 5 principali strategie di integrazione delle API LLM per la vostra azienda.

Dall'integrazione modulare al monitoraggio e all'ottimizzazione continui, queste strategie sono progettate per garantire un'implementazione senza problemi, prestazioni ottimali e un successo a lungo termine.

Integrazione modulare prevede la suddivisione del processo di integrazione dell'API LLM in moduli più piccoli e gestibili che possono essere implementati in modo incrementale. Questo approccio consente un'implementazione graduale, una più facile risoluzione dei problemi e aggiornamenti e miglioramenti più flessibili.

Un Gateway API funge da punto di ingresso unico per tutte le richieste API, gestendo l'autenticazione, la limitazione del tasso e l'instradamento delle richieste. Fornisce autenticazione centralizzata, limitazione della velocità e preziose informazioni sull'uso e sulle prestazioni delle API.

Architettura a microservizi consiste nel suddividere un'applicazione monolitica in servizi più piccoli e liberamente accoppiati che possono essere sviluppati, distribuiti e scalati in modo indipendente. Ciò consente uno sviluppo indipendente, una scalabilità granulare e una maggiore agilità e flessibilità.

Personalizzazione e messa a punto delle API LLM comporta l'adattamento di tali documenti per adattarli meglio a specifici requisiti di settore, dominio o applicazione. Questo migliora l'accuratezza, la pertinenza dei risultati e permette di allinearsi alla terminologia, agli stili e ai formati.

Monitoraggio e ottimizzazione continui comportano il monitoraggio delle metriche di prestazione, la valutazione della qualità/rilevanza dei risultati e l'introduzione di miglioramenti iterativi. Ciò consente di identificare in modo proattivo i problemi, di adattarsi ai cambiamenti dei requisiti e di migliorare continuamente il valore delle integrazioni API di LLM.

Poiché il campo della tecnologia LLM continua a evolversi a ritmo sostenuto, le aziende che investono in strategie di integrazione solide, scalabili e adattabili saranno ben posizionate per sbloccare il pieno potenziale di questi strumenti trasformativi.

I 5 migliori LLM open source per la vostra azienda

I modelli linguistici di grandi dimensioni (LLM) open-source sono emersi come una potente strumento per le imprese nel 2024.

Uno dei vantaggi principali dell'utilizzo di LLM open-source è la flessibilità e la personalizzazione che offrono. Inoltre, gli LLM open-source rappresentano un'alternativa economica allo sviluppo e alla manutenzione di modelli proprietari. Sfruttando gli sforzi collettivi della comunità dell'intelligenza artificiale, le aziende possono accedere a modelli linguistici all'avanguardia senza dover investire molto in ricerca e sviluppo.

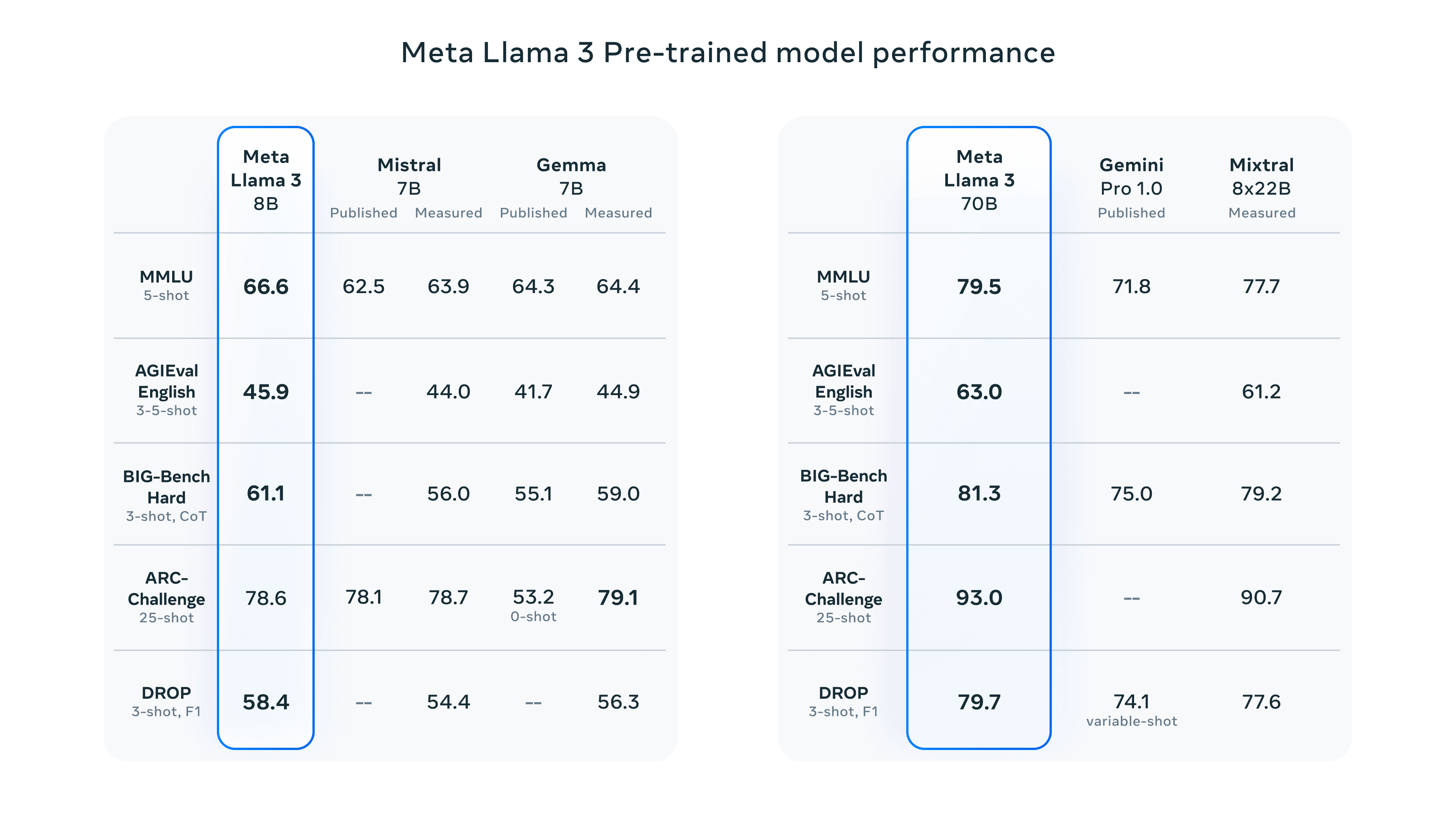

Llama 3 di Meta: Llama 3 è un modello linguistico open-source all'avanguardia con due varianti di dimensioni (8B e 70B parametri), ognuna delle quali offre modelli Base e Instruct. Eccelle in diversi compiti di NLP, è facile da implementare e aderisce a pratiche di AI responsabili.

Claude 3 di Anthropic: Claude 3 è disponibile in tre varianti (Haiku, Sonnet, Opus) ottimizzate per diversi casi d'uso. Ha dimostrato prestazioni impressionanti in compiti cognitivi come il ragionamento, la conoscenza esperta e la fluidità linguistica, superando modelli come il GPT-4.

Grok di xAI: Grok, sviluppato dalla xAI di Elon Musk, è specializzato nella sintesi e nella comprensione dei testi. La sua ultima iterazione, Grok-1.5, introduce la comprensione di lunghi contesti, il ragionamento avanzato e forti capacità di codifica/matematica.

BERT di Google: BERT è stato il pioniere della comprensione bidirezionale del linguaggio ed eccelle in compiti come la classificazione dei testi, l'analisi del sentiment e la risposta alle domande. Il suo pre-addestramento gli consente di generare testi simili a quelli umani e di fornire risposte contestualmente pertinenti.

Mistral Large di Mistral AI: Mistral Large, con i parametri 314B, si distingue nei compiti di ragionamento complessi e nelle applicazioni specializzate. Offre supporto multilingue, capacità di seguire le istruzioni e di richiamare le funzioni, aumentando la sua versatilità.

Mentre la comunità dell'IA open-source continua a spingere i confini di ciò che è possibile fare con i modelli linguistici, le aziende che abbracciano questi potenti strumenti saranno ben posizionate per rimanere all'avanguardia e ottenere un successo a lungo termine.

Per ulteriori contenuti sull'IA aziendale, tra cui infografiche, statistiche, guide, articoli e video, seguite Skim AI su LinkedIn

Siete un fondatore, un CEO, un Venture Capitalist o un investitore alla ricerca di servizi di consulenza o due diligence sull'IA? Ottenete la guida necessaria per prendere decisioni informate sulla strategia di prodotto AI della vostra azienda o sulle opportunità di investimento.

Realizziamo soluzioni AI personalizzate per aziende sostenute da Venture Capital e Private Equity nei seguenti settori: Tecnologia medica, aggregazione di notizie e contenuti, produzione di film e foto, tecnologia educativa, tecnologia legale, Fintech e criptovalute.