I 10 modi migliori per eliminare le allucinazioni da LLM

I modelli linguistici di grandi dimensioni (LLM) continuano a sconvolgere quasi ogni campo e settore, ma portano con sé una sfida unica: le allucinazioni. Queste imprecisioni generate dall'IA rappresentano un rischio significativo per l'affidabilità e l'attendibilità dei risultati degli LLM.

Cosa sono le allucinazioni LLM?

Le allucinazioni dei LLM si verificano quando questi potenti modelli linguistici generano testi non corretti, senza senso o non correlati ai dati di input. Nonostante appaiano coerenti e sicuri, i contenuti allucinati possono portare a informazioni errate, a decisioni sbagliate e a una perdita di fiducia nelle applicazioni alimentate dall'intelligenza artificiale.

I sistemi di intelligenza artificiale sono sempre più integrare in diversi aspetti della nostra vita, dai chatbot per il servizio clienti alle strumenti per la creazione di contenutiLa necessità di mitigare le allucinazioni diventa fondamentale. Allucinazioni non controllate possono causare danni alla reputazione, problemi legali e potenziali danni agli utenti che si affidano alle informazioni generate dall'IA.

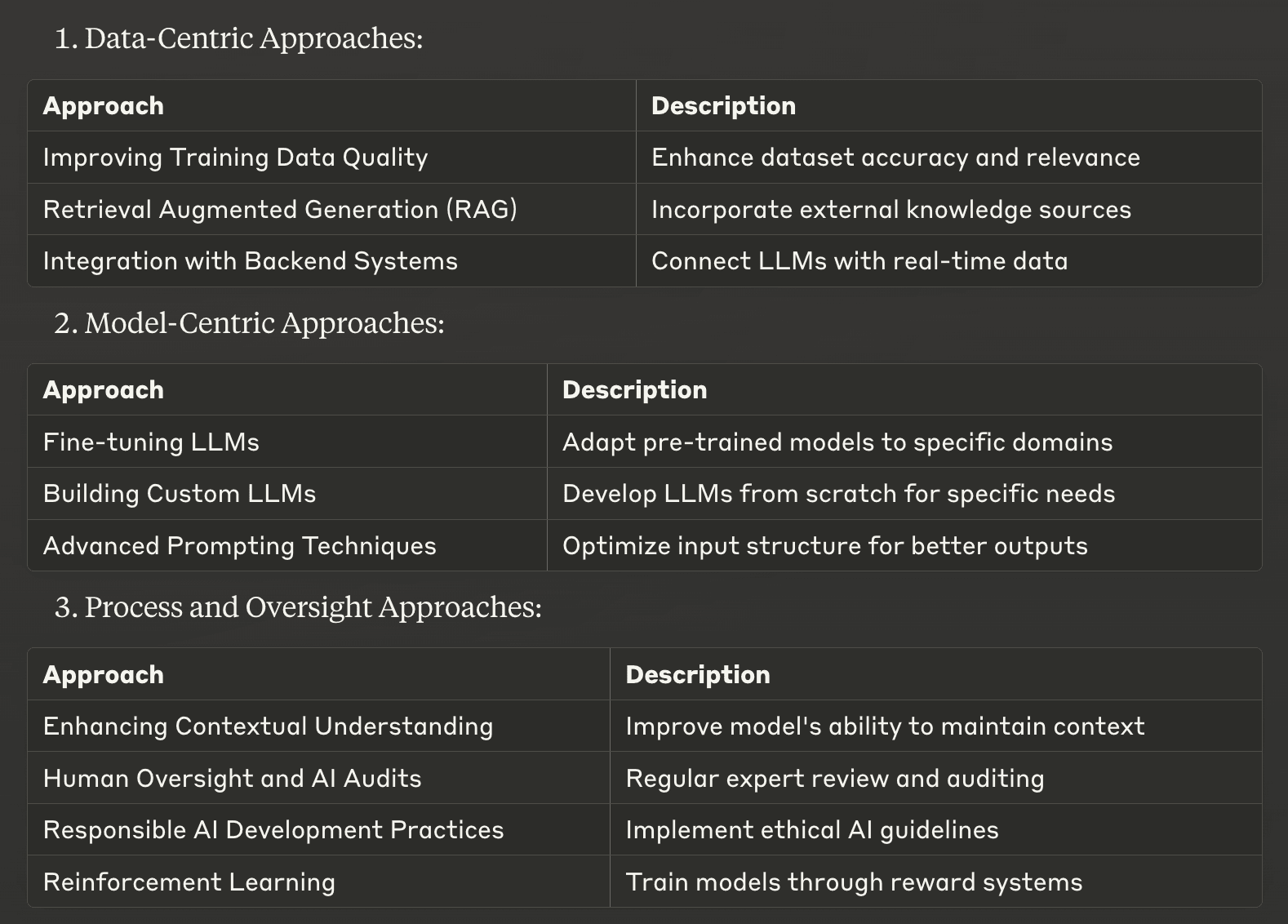

Abbiamo stilato un elenco delle 10 principali strategie per mitigare le allucinazioni LLM, che vanno dagli approcci incentrati sui dati alle tecniche incentrate sui modelli e ai metodi orientati ai processi. Queste strategie sono pensate per aiutare le aziende e gli sviluppatori a migliorare l'accuratezza dei fatti e l'affidabilità dei loro sistemi di intelligenza artificiale.

Approcci incentrati sui dati

1. Migliorare la qualità dei dati di formazione

Uno dei modi fondamentali per attenuare le allucinazioni è migliorare la qualità dei dati di addestramento utilizzati per sviluppare modelli linguistici di grandi dimensioni. Insiemi di dati di alta qualità, diversificati e ben curati possono ridurre significativamente la probabilità che i LLM apprendano e riproducano informazioni inaccurate.

Per attuare questa strategia, concentrarsi su:

Esaminare attentamente le fonti di dati per verificarne l'accuratezza e la rilevanza.

Garantire una rappresentazione equilibrata dei temi e delle prospettive

Aggiornare regolarmente gli insiemi di dati per includere le informazioni correnti.

Eliminazione di dati doppi o contraddittori

Investendo in dati di formazione di qualità superiore, si gettano solide basi per ottenere risultati LLM più affidabili e accurati.

2. Generazione aumentata di recupero (RAG)

Generazione aumentata di recupero (RAG) è una tecnica potente che combina i punti di forza degli approcci basati sul reperimento e sulla generazione. Questo metodo consente ai LLM di accedere e incorporare informazioni rilevanti da fonti di conoscenza esterne durante il processo di generazione del testo.

RAG opere di:

Recupero di informazioni rilevanti da una base di conoscenze curata

Incorporare queste informazioni nel contesto fornito al LLM

Generare risposte basate su informazioni concrete e aggiornate.

Implementando la RAG, le aziende possono ridurre significativamente le allucinazioni ancorando le risposte LLM a fonti di informazione esterne e affidabili. Questo approccio è particolarmente efficace per applicazioni specifiche in cui l'accuratezza è cruciale, come nei sistemi di intelligenza artificiale di tipo legale o medico.

3. Integrazione con i sistemi di backend

L'integrazione degli LLM con i sistemi backend esistenti di un'azienda può migliorare notevolmente l'accuratezza e la pertinenza dei contenuti generati dall'IA. Questo approccio consente all'LLM di accedere in tempo reale a dati specifici del contesto direttamente dai database o dalle API dell'azienda.

I vantaggi principali dell'integrazione del backend includono

Garantire che le risposte siano basate sulle informazioni più aggiornate.

Fornire output personalizzati e contestualmente rilevanti

Riduzione della dipendenza da dati di formazione potenzialmente obsoleti

Ad esempio, un chatbot per l'e-commerce integrato con il sistema di inventario dell'azienda può fornire informazioni precise e in tempo reale sulla disponibilità dei prodotti, riducendo il rischio di risposte allucinate sui livelli delle scorte o sui prezzi.

Implementando questi approcci incentrati sui dati, le aziende possono aumentare in modo significativo l'affidabilità dei loro risultati LLM, riducendo il rischio di allucinazioni e migliorando le prestazioni complessive del sistema AI.

Approcci incentrati sul modello

4. Messa a punto degli LLM

Il fine-tuning è una tecnica potente per adattare modelli linguistici di grandi dimensioni pre-addestrati a domini o compiti specifici. Questo processo prevede l'ulteriore addestramento del LLM su un set di dati più piccolo, accuratamente curato e pertinente all'applicazione di destinazione. Il fine-tuning può ridurre significativamente le allucinazioni, allineando i risultati del modello alle conoscenze e alla terminologia specifiche del dominio.

I principali vantaggi della messa a punto includono:

Maggiore precisione nei campi specializzati

Migliore comprensione del gergo specifico del settore

Riduzione della probabilità di generare informazioni non pertinenti o errate.

Ad esempio, un assistente AI legale messo a punto su un corpus di documenti legali e giurisprudenza avrà meno probabilità di avere allucinazioni quando risponde a domande di carattere legale, migliorando la sua affidabilità e utilità in ambito giuridico.

5. Costruire LLM personalizzati

Per le organizzazioni che dispongono di risorse consistenti e di esigenze specifiche, la creazione di modelli linguistici personalizzati di grandi dimensioni da zero può essere un modo efficace per attenuare le allucinazioni. Questo approccio consente un controllo completo sui dati di addestramento, sull'architettura del modello e sul processo di apprendimento.

Vantaggi di LLM personalizzati includono:

Base di conoscenze su misura allineata alle esigenze aziendali

Riduzione del rischio di incorporare informazioni irrilevanti o imprecise.

Maggiore controllo sul comportamento e sugli output del modello

Sebbene questo approccio richieda notevoli risorse computazionali e competenze, può portare a sistemi di IA altamente precisi e affidabili nell'ambito del dominio operativo previsto.

6. Tecniche avanzate di prompting

Sofisticate tecniche di prompting possono guidare i modelli linguistici a generare testi più accurati e coerenti, riducendo di fatto le allucinazioni. Questi metodi aiutano a strutturare l'input in modo da ottenere risultati più affidabili dal sistema di intelligenza artificiale.

Alcune tecniche di stimolo efficaci sono

Suggerimenti per la catena del pensiero: Incoraggia il ragionamento passo dopo passo

Apprendimento con pochi colpi: Fornisce esempi per guidare le risposte del modello

Grazie a un'attenta elaborazione dei suggerimenti, gli sviluppatori possono migliorare in modo significativo l'accuratezza dei fatti e la pertinenza dei contenuti generati da LLM, riducendo al minimo il verificarsi di allucinazioni.

Approcci al processo e alla supervisione

7. Migliorare la comprensione del contesto

Migliorare la capacità di un LLM di mantenere il contesto durante un'interazione può ridurre notevolmente le allucinazioni. Ciò comporta l'implementazione di tecniche che aiutino il modello a tenere traccia e a utilizzare le informazioni rilevanti nel corso di conversazioni prolungate o di compiti complessi.

Le strategie chiave includono:

Risoluzione delle coreferenze: Aiutare il modello a identificare e collegare entità correlate

Tracciamento della cronologia delle conversazioni: Garantire la considerazione degli scambi precedenti

Modellazione avanzata del contesto: Consentire al modello di concentrarsi sulle informazioni rilevanti

Queste tecniche aiutano i LLM a mantenere la coerenza e la consistenza, riducendo la probabilità di generare informazioni contraddittorie o irrilevanti.

8. Supervisione umana e audit dell'IA

L'implementazione di una supervisione umana e la conduzione di verifiche periodiche dell'IA sono fondamentali per identificare e affrontare le allucinazioni nei risultati del LLM. Questo approccio combina le competenze umane con le capacità dell'IA per garantire il massimo livello di accuratezza e affidabilità.

Le pratiche di supervisione efficaci comprendono:

Revisione regolare dei contenuti generati dall'IA da parte di esperti del settore.

Implementazione di cicli di feedback per migliorare le prestazioni del modello

Esecuzione di controlli approfonditi per identificare i modelli di allucinazione.

Mantenendo il coinvolgimento umano nel processo di IA, le organizzazioni possono individuare e correggere le allucinazioni che altrimenti potrebbero passare inosservate, migliorando l'affidabilità complessiva dei loro sistemi di IA.

9. Pratiche di sviluppo responsabile dell'IA

L'adozione di pratiche di sviluppo dell'IA responsabili è essenziale per creare LLM meno inclini alle allucinazioni. Questo approccio enfatizza le considerazioni etiche, la trasparenza e la responsabilità durante tutto il ciclo di vita dello sviluppo dell'IA.

Gli aspetti chiave dello sviluppo responsabile dell'IA comprendono:

Privilegiare la correttezza e l'imparzialità dei dati di formazione

Implementazione di solidi processi di test e convalida

Garantire la trasparenza dei processi decisionali in materia di IA

Aderendo a questi principi, le organizzazioni possono sviluppare sistemi di IA più affidabili, degni di fiducia e con minori probabilità di produrre risultati dannosi o fuorvianti.

10. Apprendimento per rinforzo

L'apprendimento per rinforzo offre un approccio promettente per attenuare le allucinazioni nelle LLM. Questa tecnica prevede l'addestramento dei modelli attraverso un sistema di premi e penalità, incoraggiando i comportamenti desiderati e scoraggiando quelli indesiderati.

Vantaggi dell'apprendimento per rinforzo nell'attenuazione delle allucinazioni:

Allineare i risultati del modello a specifici obiettivi di accuratezza

Migliorare la capacità di autocorrezione del modello

Miglioramento della qualità complessiva e dell'affidabilità del testo generato

Implementando le tecniche di apprendimento per rinforzo, gli sviluppatori possono creare LLM più abili nell'evitare le allucinazioni e nel produrre contenuti accurati.

Questi approcci centrati sul modello e orientati al processo forniscono strumenti potenti per attenuare le allucinazioni nei modelli linguistici di grandi dimensioni. Combinando queste strategie con gli approcci incentrati sui dati discussi in precedenza, le organizzazioni possono migliorare significativamente l'affidabilità e l'accuratezza dei loro sistemi di IA, aprendo la strada ad applicazioni di IA più affidabili ed efficaci.

Implementare strategie efficaci di mitigazione delle allucinazioni

Dopo aver esplorato i 10 modi migliori per mitigare le allucinazioni nei modelli linguistici di grandi dimensioni, è chiaro che affrontare questa sfida è fondamentale per sviluppare sistemi di intelligenza artificiale affidabili. La chiave del successo sta nell'implementazione ponderata di queste strategie, adattate alle vostre esigenze e risorse specifiche. Per scegliere l'approccio giusto, bisogna considerare i requisiti unici e i tipi di allucinazioni che si incontrano. Alcune strategie, come il miglioramento della qualità dei dati di addestramento, possono essere semplici da adottare, mentre altre, come la costruzione di LLM personalizzati, possono richiedere investimenti significativi.

È essenziale trovare un equilibrio tra efficacia e requisiti di risorse. Spesso la soluzione ottimale è rappresentata da una combinazione di strategie, che consente di sfruttare più approcci e di gestire i vincoli. Ad esempio, la combinazione di RAG e di tecniche avanzate di prompting può produrre miglioramenti significativi senza la necessità di un'estesa riqualificazione del modello.

Con la continua evoluzione dell'intelligenza artificiale, si evolveranno anche i metodi per attenuare le allucinazioni. Rimanendo informati sugli ultimi sviluppi e perfezionando continuamente il vostro approccio, potrete garantire che i vostri sistemi di IA rimangano all'avanguardia in termini di precisione e affidabilità. Ricordate che l'obiettivo non è solo quello di generare testo, ma di creare risultati di LLM di cui gli utenti possano fidarsi e su cui possano contare, aprendo la strada ad applicazioni di IA più efficaci e responsabili in vari settori.

Se avete bisogno di assistenza per attenuare le allucinazioni da LLM, non esitate a contattare noi di Skim AI.