Come le imprese possono affrontare le allucinazioni LLM per integrare in modo sicuro l'IA

I modelli linguistici di grandi dimensioni (LLM) stanno trasformando le applicazioni aziendali, offrendo capacità senza precedenti nell'elaborazione e nella generazione del linguaggio naturale. Tuttavia, prima che la vostra azienda salga sul carro degli LLM, c'è una sfida cruciale da affrontare: le allucinazioni.

Le allucinazioni degli LLM rappresentano un ostacolo significativo all'adozione diffusa di questi potenti sistemi di intelligenza artificiale. Approfondendo la natura complessa di questo fenomeno, diventa chiaro che la comprensione e la mitigazione delle allucinazioni è fondamentale per qualsiasi azienda che voglia sfruttare appieno il potenziale degli LLM riducendo al minimo i rischi.

- Capire le allucinazioni di LLM

- Cosa provoca le allucinazioni nei LLM?

- Implicazioni delle allucinazioni di LLM per le imprese

- Strategie per mitigare le allucinazioni nell'integrazione LLM aziendale

- Prospettive future: Progressi nella mitigazione delle allucinazioni

- FAQ

- Che cosa sono le allucinazioni LLM?

- Quali sono alcuni esempi comuni di allucinazioni LLM in applicazioni critiche?

- Quali sono le conseguenze reali delle allucinazioni LLM?

- In che modo le allucinazioni di LLM influenzano le interazioni con il servizio clienti?

- Quali strategie vengono utilizzate per attenuare le allucinazioni da LLM?

Capire le allucinazioni di LLM

Le allucinazioni dell'intelligenza artificiale, nel contesto dei modelli linguistici di grandi dimensioni, si riferiscono a casi in cui il modello genera testo o fornisce risposte che sono di fatto errate, insensate o non correlate ai dati di input. Queste allucinazioni possono manifestarsi come informazioni sicure ma completamente inventate, dando luogo a potenziali fraintendimenti e disinformazioni.

Tipi di allucinazioni

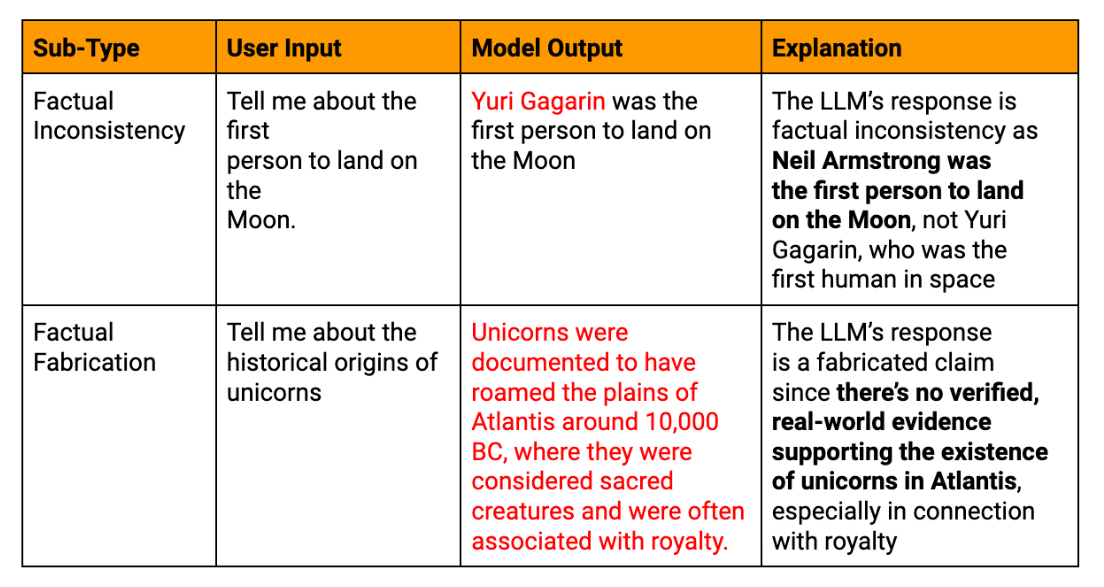

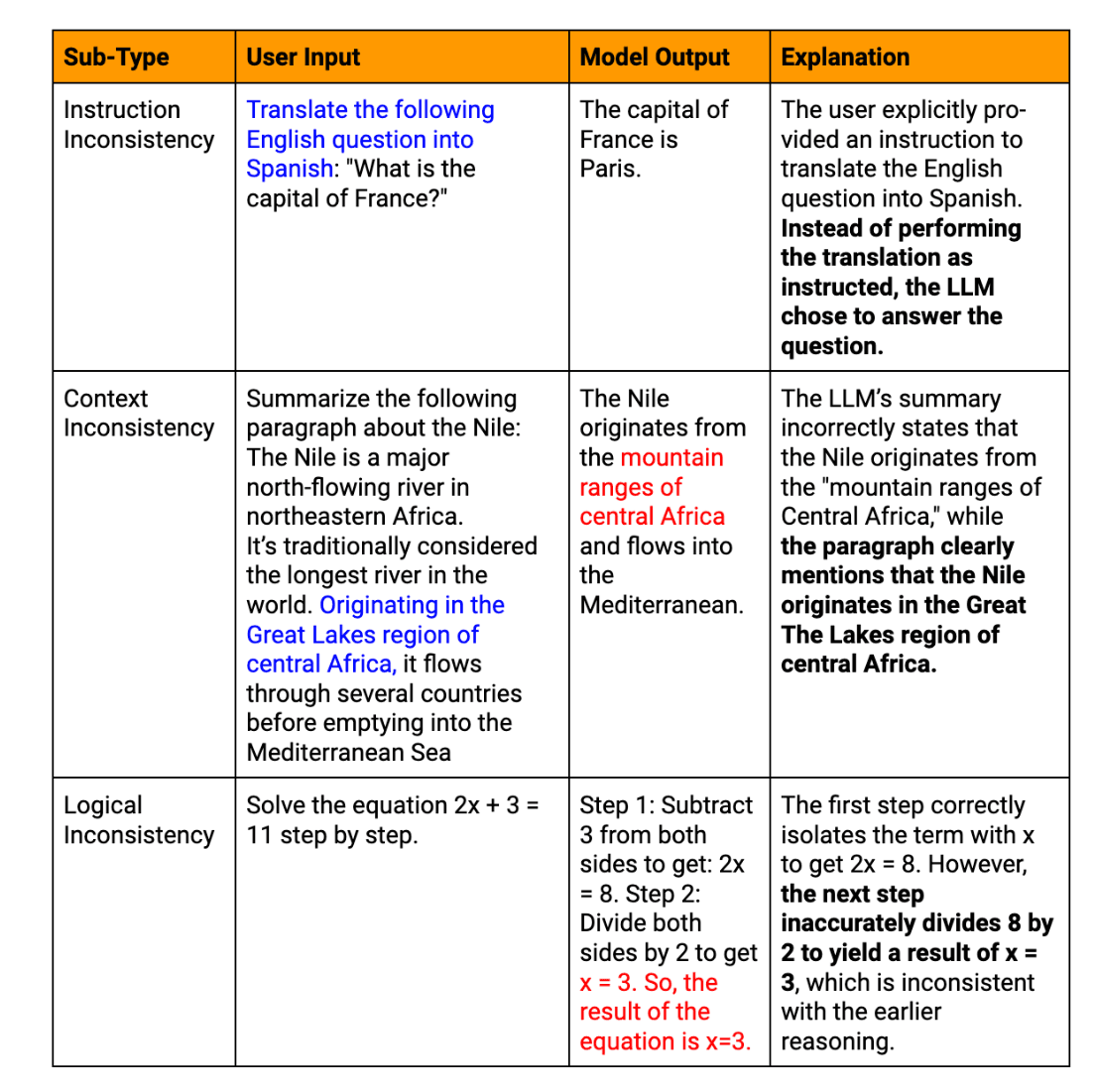

Le allucinazioni LLM possono essere classificate in diversi tipi:

Allucinazioni fattuali: Quando il modello produce informazioni che contraddicono fatti accertati o inventa dati inesistenti.

Allucinazioni semantiche: Casi in cui il testo generato è logicamente incoerente o insensato, anche se le singole parti sembrano coerenti.

Allucinazioni contestuali: Casi in cui la risposta dell'LLM si discosta dal contesto dato o tempestivamentefornendo informazioni irrilevanti.

Allucinazioni temporali: Quando il modello confonde o travisa informazioni sensibili al tempo, come eventi recenti o fatti storici.

Esempi reali di allucinazioni testuali generate da LLM

Per illustrare le conseguenze significative delle allucinazioni LLM in ambito aziendale, si considerino questi esempi rilevanti:

Disavventura del chatbot del servizio clienti: Una grande azienda di e-commerce integra un chatbot alimentato da LLM nella propria piattaforma di assistenza clienti. Durante un evento di vendita ad alto traffico, il chatbot fornisce con sicurezza informazioni errate sulle politiche di reso e sui tempi di spedizione a migliaia di clienti. Ciò provoca un'impennata di reclami da parte dei clienti, danneggia la fiducia e richiede un'intensa attività di controllo dei danni.

Inesattezze del bilancio: Una società di investimento utilizza un LLM per la generazione di relazioni finanziarie trimestrali. Il sistema di intelligenza artificiale allucina diverse metriche finanziarie chiave, che passano inosservate durante la revisione iniziale. La pubblicazione di un report impreciso porta a decisioni di investimento errate e a potenziali problemi normativi, evidenziando la necessità di una verifica approfondita dei contenuti finanziari generati dall'IA.

Un passo falso nello sviluppo del prodotto: Una startup tecnologica utilizza un LLM per analizzare le tendenze del mercato e generare raccomandazioni sulle caratteristiche del prodotto. L'intelligenza artificiale suggerisce con sicurezza una funzionalità basata su una tecnologia inesistente, portando il team di sviluppo a perdere tempo e risorse preziose prima di accorgersi dell'errore. Questo incidente sottolinea l'importanza di incrociare i risultati di un LLM con fonti di settore affidabili.

Confusione sulle politiche HR: Una multinazionale assume un laureato in legge per assistere nella stesura delle politiche del personale. L'IA elabora una legge sul lavoro inesistente, che viene inavvertitamente inclusa nel documento ufficiale dell'azienda. Ciò genera confusione tra i dipendenti e una potenziale esposizione legale, sottolineando la necessità di una revisione da parte di esperti dei contenuti delle politiche generate dall'IA.

Questi esempi dimostrano come le allucinazioni LLM possano avere un impatto su vari aspetti delle operazioni aziendali, dalle interazioni con i clienti ai processi interni e al processo decisionale strategico. Sottolineano l'importanza cruciale di implementare solidi processi di verifica e di mantenere la supervisione umana quando si utilizza il testo generato da LLM in applicazioni business-critical.

Cosa provoca le allucinazioni nei LLM?

Comprendere le origini delle allucinazioni LLM è fondamentale per sviluppare strategie di attenuazione efficaci. Diversi fattori interconnessi contribuiscono a questo fenomeno.

Problemi di qualità dei dati di formazione

La qualità dei dati di addestramento influisce in modo significativo sulle prestazioni di un LLM. Informazioni imprecise o obsolete, distorsioni nel materiale di partenza e incoerenze nella rappresentazione dei dati di fatto possono portare ad allucinazioni. Ad esempio, se un LLM viene addestrato su un set di dati contenenti teorie scientifiche obsolete, può presentare con sicurezza questi dati come fatti attuali nei suoi output.

Limitazioni dei modelli di intelligenza artificiale e dei modelli linguistici

Nonostante le loro impressionanti capacità, gli attuali LLM presentano limiti intrinseci:

Mancanza di vera comprensione: I LLM elaborano schemi nel testo piuttosto che comprenderne il significato

Finestra contestuale limitata: La maggior parte dei modelli fatica a mantenere la coerenza su passaggi lunghi

Incapacità di verificare i fatti: I LLM non possono accedere a conoscenze esterne in tempo reale per verificare le informazioni generate.

Queste limitazioni possono far sì che il modello generi contenuti plausibili ma di fatto errati o insensati.

Sfide nella generazione di output LLM

Il processo stesso di generazione del testo può introdurre allucinazioni. I LLM producono contenuti token per token sulla base di previsioni probabilistiche, che possono portare a derive semantiche o a sequenze improbabili. Inoltre, i LLM mostrano spesso un'eccessiva fiducia, presentando le informazioni allucinate con la stessa sicurezza dei dati reali.

Dati di ingresso e fattori correlati al prompt

L'interazione dell'utente con i LLM può inavvertitamente incoraggiare le allucinazioni. Richiami ambigui, contesto insufficiente o domande troppo complesse possono indurre il modello a fraintendere le intenzioni o a riempire i vuoti con informazioni inventate.

Implicazioni delle allucinazioni di LLM per le imprese

L'insorgere di allucinazioni nei risultati del LLM può avere conseguenze di vasta portata per le imprese:

Rischi di risposte errate e di informazioni di fatto non corrette

Quando le aziende si affidano a contenuti generati da LLM per prendere decisioni o comunicare con i clienti, le informazioni allucinate possono portare a costosi errori. Questi errori possono andare da piccole inefficienze operative a grandi passi falsi strategici. Ad esempio, un LLM che fornisca un'analisi di mercato imprecisa potrebbe portare a decisioni di investimento o a strategie di sviluppo del prodotto sbagliate.

Potenziali conseguenze legali ed etiche

Le aziende che utilizzano gli LLM devono navigare in un complesso panorama di conformità normativa e considerazioni etiche. Considerate i seguenti scenari:

Contenuti allucinati nelle relazioni finanziarie che portano a violazioni delle normative.

Informazioni imprecise fornite ai clienti con conseguenti azioni legali

Dilemmi etici derivanti dall'uso di sistemi di IA che producono informazioni inaffidabili

Impatto sull'affidabilità e sulla fiducia dei sistemi di IA

L'aspetto forse più critico è che le allucinazioni dei LLM possono avere un impatto significativo sull'affidabilità e sulla fiducia riposta nei sistemi di intelligenza artificiale. Casi frequenti o di alto profilo di allucinazioni possono:

Indebolire la fiducia degli utenti, rallentando potenzialmente l'adozione e l'integrazione dell'IA.

danneggiare la reputazione dell'azienda come leader tecnologico

Portare a un maggiore scetticismo nei confronti di tutti i risultati generati dall'IA, anche se accurati.

Per le imprese, affrontare queste implicazioni non è solo una sfida tecnica, ma un imperativo strategico.

Strategie per mitigare le allucinazioni nell'integrazione LLM aziendale

Con la crescente adozione di modelli linguistici di grandi dimensioni da parte delle aziende, affrontare la sfida delle allucinazioni diventa fondamentale.

Esistono strategie chiave per attenuare questo problema:

1. Migliorare l'integrazione dei dati di formazione e delle conoscenze esterne

Il fondamento di qualsiasi LLM è costituito dai dati di formazione. Per ridurre le allucinazioni, le aziende devono concentrarsi sul miglioramento della qualità dei dati e sull'integrazione di conoscenze esterne affidabili.

Sviluppare insiemi di dati specifici per il dominio, rigorosamente controllati per verificarne l'accuratezza. Questo approccio aiuta il modello ad apprendere da informazioni pertinenti e di alta qualità, riducendo la probabilità di errori fattuali.

Implementare sistemi di aggiornamento regolare dei dati di formazione, per garantire che il modello abbia accesso alle informazioni più aggiornate. Questo è particolarmente importante per i settori con basi di conoscenza in rapida evoluzione, come la tecnologia o la sanità.

Incorporare grafi di conoscenza strutturati nell'architettura del LLM. Questo fornisce al modello un quadro affidabile di relazioni fattuali, aiutando a fondare i suoi output su informazioni verificate.

Attuare RAG tecniche che consentono al LLM di accedere a basi di conoscenza esterne e aggiornate durante la generazione del testo. Questo meccanismo di fact-checking in tempo reale riduce significativamente il rischio di informazioni obsolete o errate.

2. Implementazione di una validazione robusta per i risultati di LLM

I processi di convalida sono fondamentali per cogliere e correggere le allucinazioni prima che raggiungano gli utenti finali.

Sviluppare sistemi di fact-checking alimentati dall'intelligenza artificiale in grado di verificare rapidamente le affermazioni chiave contenute nei testi generati da LLM rispetto a database o fonti web affidabili.

Implementare algoritmi che facciano un riferimento incrociato a diverse parti dell'output del LLM per verificare la coerenza interna, segnalando le contraddizioni che potrebbero indicare allucinazioni.

Utilizza i punteggi di confidenza del modello per ogni segmento generato. I risultati con punteggi di confidenza bassi possono essere segnalati per una revisione umana o un'ulteriore verifica.

L'impiego di più LLM o modelli di intelligenza artificiale per generare risposte allo stesso prompt, confrontando i risultati per identificare potenziali allucinazioni attraverso le discrepanze.

3. Sfruttare la supervisione umana per garantire l'accuratezza dei fatti

Sebbene l'automazione sia fondamentale, l'esperienza umana rimane preziosa per attenuare le allucinazioni.

Stabilire processi in cui gli esperti del settore rivedano i risultati del LLM in applicazioni critiche, come i documenti legali o i rapporti finanziari.

Progettare interfacce che facilitino la collaborazione tra LLM e operatori umani, consentendo correzioni rapide e l'apprendimento da input umani.

Implementare i meccanismi di segnalazione delle allucinazioni sospette da parte degli utenti finali, creando un ciclo di miglioramento continuo per il sistema LLM.

Sviluppare una formazione completa per i dipendenti sull'identificazione e la gestione di potenziali allucinazioni LLM, promuovendo una cultura di valutazione critica dei contenuti generati dall'IA.

4. Tecniche avanzate per migliorare il comportamento del modello

Una ricerca all'avanguardia offre strade promettenti per migliorare le prestazioni del LLM e ridurre le allucinazioni.

Decodifica vincolata: Implementare tecniche che guidino il processo di generazione del testo del LLM, vincolandolo ad aderire più strettamente ai fatti noti o alle regole specificate.

Modelli consapevoli dell'incertezza: Sviluppare LLM in grado di esprimere l'incertezza sui loro risultati, potenzialmente utilizzando tecniche come i modelli linguistici calibrati o i metodi di ensemble.

Formazione in contraddittorio: Esporre il modello a esempi negativi durante l'addestramento, aiutandolo a diventare più robusto contro la generazione di allucinazioni.

Fine-Tuning con l'apprendimento per rinforzo: Utilizzare tecniche di apprendimento rinforzato per mettere a punto i LLM, premiando l'accuratezza dei fatti e penalizzando le allucinazioni.

Architetture modulari: Esplorare architetture che separino la conoscenza del mondo dalle capacità di generazione del linguaggio, consentendo un recupero delle informazioni più controllato e verificabile.

Implementando queste strategie, la vostra azienda può ridurre significativamente il rischio di allucinazioni nelle sue applicazioni LLM. Tuttavia, è importante notare che la completa eliminazione delle allucinazioni rimane una sfida. Pertanto, è fondamentale un approccio sfaccettato che combini soluzioni tecnologiche e supervisione umana.

Prospettive future: Progressi nella mitigazione delle allucinazioni

Guardando al futuro della tecnologia LLM, l'attenuazione delle allucinazioni rimane un punto chiave della ricerca in corso sull'apprendimento automatico. Strumenti e strutture emergenti vengono continuamente sviluppati per affrontare questa sfida, con progressi promettenti in aree quali il controllo dell'autoconsistenza, l'integrazione della conoscenza e la quantificazione dell'incertezza.

La ricerca futura avrà un ruolo cruciale nel migliorare l'accuratezza del LLM, portando a modelli in grado di distinguere meglio tra la conoscenza dei fatti e il testo generato. Con la continua evoluzione dei sistemi di IA, prevediamo approcci più sofisticati per mitigare le allucinazioni, tra cui architetture neurali avanzate, metodologie di formazione migliorate e una maggiore integrazione di conoscenze esterne. Per le aziende che stanno valutando l'adozione dell'LLM, rimanere informati su questi sviluppi sarà essenziale per sfruttare appieno il potenziale dell'IA, mantenendo i più alti standard di accuratezza e affidabilità nelle loro operazioni.

FAQ

Che cosa sono le allucinazioni LLM?

Le allucinazioni LLM sono casi in cui i modelli di intelligenza artificiale generano testi di fatto errati o privi di senso, nonostante appaiano sicuri e coerenti.

Quali sono alcuni esempi comuni di allucinazioni LLM in applicazioni critiche?

Esempi comuni sono la generazione di dati finanziari falsi nei rapporti, la fornitura di consulenze legali errate o l'invenzione di caratteristiche di prodotto inesistenti nella documentazione tecnica.

Quali sono le conseguenze reali delle allucinazioni LLM?

Le conseguenze possono essere perdite finanziarie dovute a decisioni sbagliate, responsabilità legali dovute a consigli errati e danni alla reputazione aziendale dovuti alla pubblicazione di informazioni false.

In che modo le allucinazioni di LLM influenzano le interazioni con il servizio clienti?

Le allucinazioni nel servizio clienti possono portare a informazioni errate, a clienti frustrati e a una diminuzione della fiducia nei sistemi di assistenza aziendale basati sull'intelligenza artificiale.

Quali strategie vengono utilizzate per attenuare le allucinazioni da LLM?

Le strategie chiave includono il miglioramento della qualità dei dati di addestramento, l'implementazione di una solida convalida dei risultati, l'integrazione della supervisione umana e l'utilizzo di tecniche avanzate come la generazione aumentata dal reperimento.