10 buone pratiche per gestire i contenuti generati dagli utenti con le API di OpenAI

La gestione dei contenuti generati dagli utenti è fondamentale per mantenere la conformità alle politiche di OpenAI. Consentire contenuti non controllati può portare a gravi ripercussioni, come il divieto di utilizzare le API, che possono interrompere significativamente le operazioni. In questo blog esploreremo dieci best practice che possono aiutare le aziende a gestire efficacemente i contenuti generati dagli utenti, garantendo conformità e sicurezza.

- 1. Utilizzare il punto finale di moderazione

- 2. Implementare gli identificatori univoci degli utenti

- 3. Educare gli utenti alle linee guida sui contenuti

- 4. Monitoraggio e registrazione dell'attività dell'utente

- 5. Limitazione e strozzatura della velocità

- 6. Gestione degli errori e feedback

- 7. Rivedere e aggiornare regolarmente le politiche

- 8. Utilizzare strumenti di filtraggio automatico

- 9. Efficacia della moderazione dei test

- 10. Impegnarsi con l'assistenza OpenAI

- Il bilancio

1. Utilizzare il punto finale di moderazione

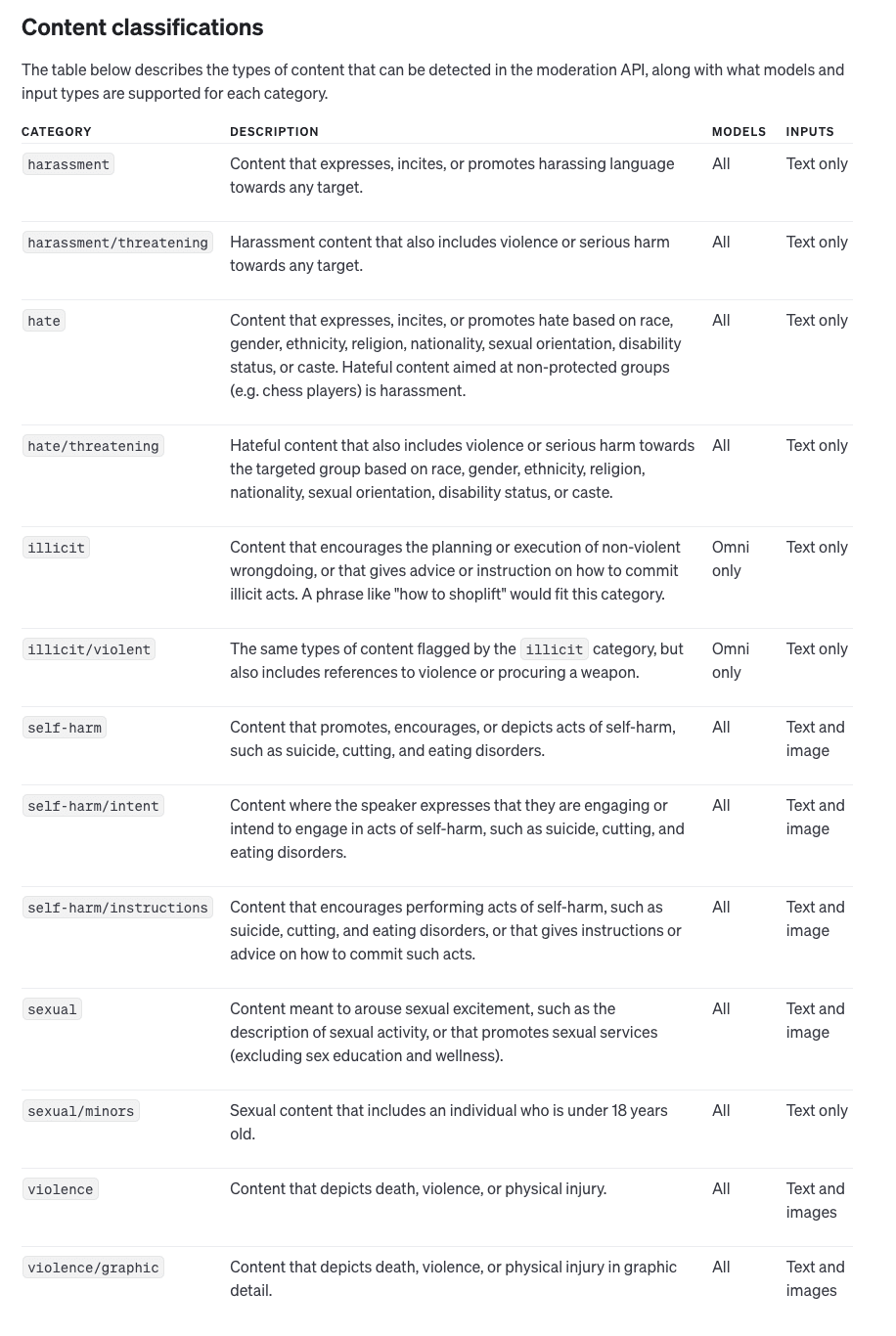

L'endpoint di moderazione di OpenAI è un potente strumento che aiuta a rilevare e filtrare i contenuti potenzialmente dannosi prima che raggiungano l'API. L'endpoint è in grado di analizzare gli input di testo e di immagine, identificando categorie come l'incitamento all'odio e la violenza. L'integrazione di questo strumento è semplice e prevede il controllo degli input di ogni utente con l'endpoint di moderazione prima di inviarli all'API principale, riducendo così al minimo il rischio di violazioni.

Utilizzando l'endpoint di moderazione in modo proattivo, le aziende possono assicurarsi di filtrare i contenuti dannosi il prima possibile. Questo non solo aiuta a mantenere la conformità con le politiche di OpenAI, ma fornisce anche un'esperienza utente più positiva, impedendo l'invio di contenuti inappropriati. L'utilizzo di questo endpoint consente alle aziende di mitigare i rischi in anticipo, riducendo le possibilità di ricevere avvisi o divieti da OpenAI.

2. Implementare gli identificatori univoci degli utenti

Incluso un identificativo utente univoco (ID utente) in ogni chiamata API è fondamentale per tracciare i singoli utenti. Ciò consente a OpenAI di identificare l'utente responsabile di eventuali violazioni delle policy, proteggendo l'applicazione nel suo complesso da penalizzazioni dovute alle azioni di un singolo utente. Il tracciamento dell'utente fornisce anche una chiara traccia di audit, rendendo più facile l'applicazione della responsabilità e il mantenimento della conformità.

Gli identificatori univoci degli utenti possono anche aiutare a implementare controlli di moderazione più granulari. Ad esempio, se un particolare utente tenta costantemente di inviare contenuti dannosi, è possibile intervenire per bloccarne o limitarne l'accesso senza influenzare gli altri. Questo livello di controllo garantisce che le azioni di un utente non compromettano la disponibilità e la reputazione dell'applicazione nel suo complesso.

3. Educare gli utenti alle linee guida sui contenuti

Per ridurre la probabilità di violazioni, educate i vostri utenti sui contenuti accettabili. Comunicate chiaramente i tipi di contenuti non consentiti, come i discorsi di odio o le immagini violente. Fornire linee guida dettagliate sui contenuti può impedire agli utenti di inviare materiale dannoso, proteggendo l'accesso all'API e riducendo la necessità di interventi di moderazione.

Oltre a pubblicare le linee guida per i contenuti, considerate la possibilità di incorporare suggerimenti e promemoria educativi all'interno della vostra interfaccia utente. Guidando attivamente gli utenti su quali tipi di contenuti sono appropriati, è possibile ridurre le violazioni involontarie. Questo approccio proattivo non solo aiuta a mantenere la conformità, ma promuove anche una cultura di creazione responsabile di contenuti tra gli utenti.

4. Monitoraggio e registrazione dell'attività dell'utente

La registrazione dettagliata delle interazioni degli utenti è una parte essenziale della gestione dei contenuti generati dagli utenti. Monitorando l'attività degli utenti, le aziende possono identificare rapidamente i modelli di abuso e affrontare i problemi prima che si aggravino. I registri possono fornire prove cruciali per affrontare il comportamento degli utenti e possono essere utilizzati per migliorare le strategie di moderazione nel tempo.

La conservazione di registri completi consente inoltre di migliorare l'audit e la responsabilità. Se si verifica una violazione, avere una cronologia ben documentata consente di risalire al passato e di identificare esattamente dove le cose sono andate male. Questo aiuta a perfezionare l'approccio alla moderazione e a creare regole e filtri più efficaci per evitare problemi simili in futuro.

5. Limitazione e strozzatura della velocità

Implementare limiti di velocità per controllare le richieste eccessive da parte di singoli utenti. Il throttling assicura che nessun singolo utente possa sovraccaricare il sistema o inviare ripetutamente contenuti problematici. Questo non solo protegge la vostra API dagli abusi, ma aiuta anche a mantenere la stabilità del sistema e un accesso equo per tutti gli utenti.

La limitazione della velocità può anche servire come meccanismo di allarme precoce per identificare potenziali abusi. Ad esempio, se un utente inizia improvvisamente a inviare richieste a una velocità anormalmente elevata, ciò può indicare un comportamento dannoso o un'automazione che tenta di sfruttare la vostra API. Individuando tempestivamente questi schemi, è possibile mitigare le potenziali minacce prima che portino a violazioni più significative.

6. Gestione degli errori e feedback

Un solido sistema di gestione degli errori è fondamentale per migliorare l'esperienza dell'utente e al tempo stesso imporre la conformità. Quando una richiesta viene rifiutata a causa della moderazione, fornite agli utenti un feedback chiaro e informativo sul motivo per cui il loro contributo è stato rifiutato. Questo può guidare gli utenti verso l'invio di contenuti conformi in futuro, riducendo in ultima analisi la frequenza delle violazioni.

I messaggi di errore efficaci non devono solo indicare cosa è andato storto, ma anche offrire suggerimenti costruttivi su come correggere l'input. Ad esempio, se un utente invia un contenuto contrassegnato da un linguaggio inappropriato, il feedback dovrebbe spiegarlo e incoraggiare l'utente a riformularlo. Questo approccio educativo aiuta gli utenti a comprendere i requisiti di moderazione e favorisce interazioni più positive con l'applicazione.

7. Rivedere e aggiornare regolarmente le politiche

Politiche di contenuto di OpenAI possono cambiare nel tempo ed è essenziale rimanere informati su questi aggiornamenti. Rivedete e aggiornate regolarmente le vostre politiche interne e le strategie di moderazione per allinearvi alle nuove linee guida. Mantenersi aggiornati aiuta a mantenere la conformità e a prevenire sanzioni inaspettate.

Anche le politiche interne dovrebbero essere riviste in risposta agli incidenti. Se vi accorgete che alcuni tipi di contenuti dannosi sfuggono, modificate le vostre regole e procedure per coprire queste lacune. La revisione regolare delle policy assicura che si operi sempre in linea con le ultime aspettative di OpenAI, riducendo così al minimo il rischio di violazioni.

8. Utilizzare strumenti di filtraggio automatico

Oltre all'endpoint di moderazione di OpenAI, è opportuno considerare l'aggiunta di strumenti di filtraggio automatico in grado di pre-selezionare gli input degli utenti in base a criteri predefiniti. Questo ulteriore livello di filtraggio può contribuire a ridurre la quantità di contenuti potenzialmente dannosi che raggiungono la fase di moderazione, rendendo il processo di moderazione più efficiente ed efficace.

Gli strumenti di filtraggio automatico possono essere personalizzati per soddisfare le esigenze specifiche della vostra applicazione. Ad esempio, è possibile sviluppare filtri personalizzati in base alla propria base di utenti, concentrandosi su particolari categorie di contenuti che hanno maggiori probabilità di essere problematici. Questi sistemi automatici agiscono come prima linea di difesa, consentendo ai moderatori umani o all'endpoint di moderazione di OpenAI di gestire i casi più complessi.

9. Efficacia della moderazione dei test

Verificate periodicamente l'efficacia dei vostri processi di moderazione analizzando i falsi positivi e negativi. Regolate i criteri di filtraggio e gli algoritmi di moderazione in base a queste informazioni per migliorare l'accuratezza e garantire che i contenuti conformi non vengano erroneamente segnalati, mentre quelli dannosi vengono effettivamente filtrati.

Per verificare l'efficacia della moderazione si può anche raccogliere il feedback degli utenti. Gli utenti che ritengono che i loro contenuti siano stati erroneamente segnalati possono fornire spunti per potenziali miglioramenti dei criteri di moderazione. Questo ciclo continuo di feedback aiuta a perfezionare il sistema per trovare il giusto equilibrio tra sicurezza e libertà di espressione.

10. Impegnarsi con l'assistenza OpenAI

Se avete domande su casi d'uso specifici o avete bisogno di chiarimenti sulle policy, non esitate a contattare il team di supporto di OpenAI. Le loro indicazioni possono essere preziose per adattare le pratiche di moderazione alle esigenze della vostra applicazione e per garantire che l'uso dell'API sia sempre conforme.

Il coinvolgimento dell'assistenza OpenAI può essere utile anche quando si ha a che fare con aree grigie. Se non si è sicuri che un particolare tipo di contenuto sia consentito, chiedere consiglio può evitare potenziali violazioni. Stabilire un buon rapporto con l'assistenza OpenAI vi garantirà di avere una fonte continua di esperienza per aiutarvi a gestire scenari di moderazione complessi.

Il bilancio

Gestire efficacemente i contenuti generati dagli utenti è fondamentale per mantenere la conformità con le policy di OpenAI e garantire la sicurezza dell'accesso alle API. Seguendo queste dieci best practice, sviluppatori e aziende possono ridurre il rischio di violazioni, evitare sanzioni e creare un'esperienza utente più positiva. Una gestione proattiva e l'utilizzo degli strumenti di moderazione di OpenAI possono salvaguardare il vostro accesso e aiutarvi a sfruttare appieno la potenza dell'IA.