par Greggory Elias | 19 septembre 2024 | Bulletin d'information, Ingénierie rapide

La statistique de la semaine : La performance de la chaîne de pensée à l'essai zéro n'était que de 5,551 TTP3T pour GPT-4-Turbo, de 8,511 TTP3T pour Claude-3-Opus et de 4,441 TTP3T pour GPT-4. (L'incitation à la chaîne de pensée (CoT) a été saluée comme une percée dans le déverrouillage du raisonnement...

par Greggory Elias | 19 septembre 2024 | IA générative, Avis

Elon Musk a relancé sa bataille juridique contre OpenAI, Sam Altman et Greg Brockman, ce qui devrait attirer l'attention de la communauté de l'IA. Il s'agit d'une affaire qui pourrait fondamentalement façonner l'avenir de l'intelligence artificielle, notamment en définissant...

par Greggory Elias | 19 septembre 2024 | IA d'entreprise, Startups + VC

Dans le monde de l'intelligence artificielle, où les enjeux sont considérables, le talent est la monnaie d'échange par excellence. Le récent exode d'OpenAI n'est pas seulement une redistribution des cartes, c'est aussi une mine d'or potentielle pour les investisseurs en capital-risque avisés. Alors que nous assistons à l'une des plus importantes...

par Greggory Elias | 19 septembre 2024 | Non classé

OpenAI est à l'avant-garde de nombreux développements révolutionnaires dans le domaine de l'IA et fait constamment parler d'elle, tant pour ses innovations que pour ses turbulences. Alors que l'entreprise connaît des changements dans son vivier de talents, y compris une récente fuite des cerveaux vers l'extérieur, les investisseurs en capital-risque devraient...

par Greggory Elias | 29 août 2024 | IA d'entreprise, LLMs / NLP, Ingénierie rapide

Les grands modèles de langage (LLM) présentent des capacités remarquables en matière de traitement du langage naturel (NLP) et de génération. Cependant, lorsqu'ils sont confrontés à des tâches de raisonnement complexes, ces modèles peuvent avoir du mal à produire des résultats précis et fiables. C'est là qu'intervient l'incitation à la chaîne de pensée (CoT)

par Greggory Elias | 29 août 2024 | IA générative, LLMs / NLP, Ingénierie rapide

L'incitation à la chaîne de pensée (CoT) a été saluée comme une percée dans le déblocage des capacités de raisonnement des grands modèles de langage (LLM). Cette technique, qui consiste à fournir des exemples de raisonnement étape par étape pour guider les LLM, a suscité une grande attention dans la communauté de l'IA. De nombreux

par Greggory Elias | 29 août 2024 | IA d'entreprise, IA générative, Ingénierie rapide

L'art d'élaborer des messages-guides efficaces pour les grands modèles de langage (LLM) est devenu une compétence cruciale pour les praticiens de l'IA. Des invites bien conçues peuvent améliorer de manière significative les performances d'un LLM, en permettant des résultats plus précis, plus pertinents et plus créatifs. Cet article de blog explore dix des

par Greggory Elias | 19 août 2024 | IA d'entreprise, IA générative, Intégration du LLM

Dans le domaine de l'IA, la capacité à apprendre efficacement à partir de données limitées est devenue cruciale. C'est là qu'intervient l'apprentissage par petites touches, une approche qui améliore la manière dont les modèles d'IA acquièrent des connaissances et s'adaptent à de nouvelles tâches. Mais qu'est-ce que l'apprentissage par petites touches ? Définir l'apprentissage par petites touches L'apprentissage par petites...

par Greggory Elias | 19 août 2024 | IA d'entreprise, IA générative, LLMs / NLP

Le véritable potentiel des grands modèles de langage (LLM) ne réside pas seulement dans leur vaste base de connaissances, mais aussi dans leur capacité à s'adapter à des tâches et à des domaines spécifiques avec un minimum de formation supplémentaire. C'est là que les concepts d'incitation à quelques essais et de réglage fin entrent en jeu...

par Greggory Elias | 19 août 2024 | IA générative, LLMs / NLP, Recherche / Statistiques

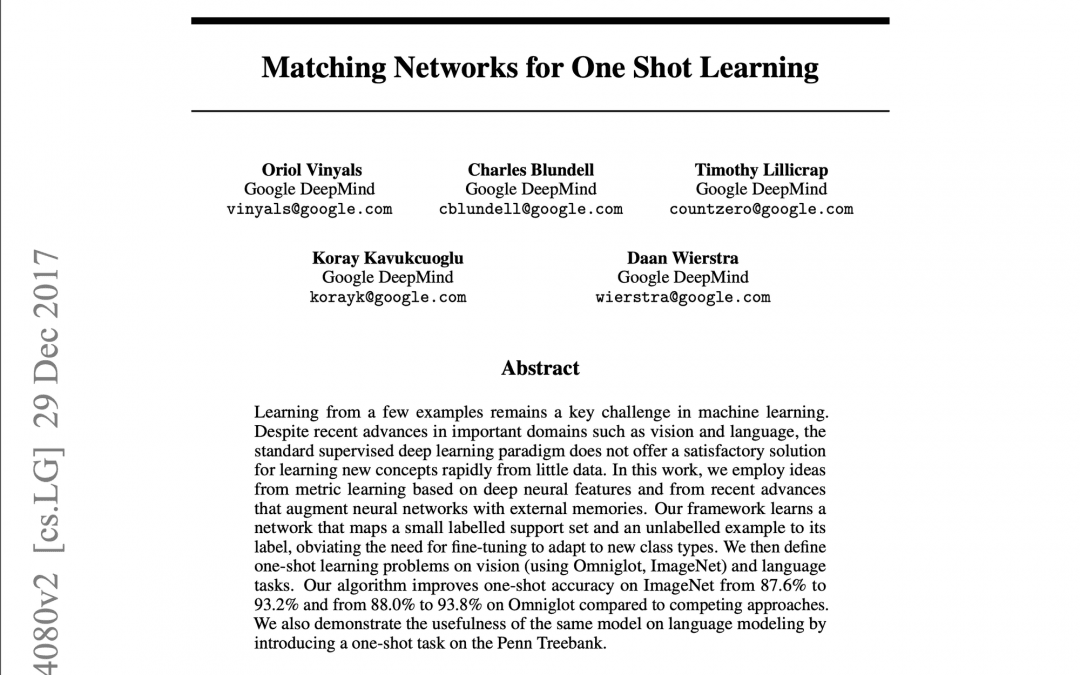

L'apprentissage à partir d'un nombre limité d'exemples a émergé comme un domaine de recherche crucial dans l'apprentissage automatique, visant à développer des algorithmes capables d'apprendre à partir d'un nombre limité d'exemples étiquetés. Cette capacité est essentielle pour de nombreuses applications dans le monde réel où les données sont rares, coûteuses ou prennent du temps

par Greggory Elias | 19 août 2024 | IA générative, LLMs / NLP, Bulletin d'information

La statistique de la semaine : 72% des organisations interrogées ont adopté l'IA en 2024, un bond significatif par rapport aux 50% des années précédentes. (McKinsey) La récente sortie de Llama 3.1 de Meta a fait des vagues dans le monde de l'entreprise. Cette dernière itération des modèles Llama...

par Greggory Elias | 19 août 2024 | IA d'entreprise, IA générative, Intégration du LLM

La statistique de la semaine : L'utilisation de LLM plus petits comme GPT-J dans une cascade peut réduire le coût global de 80% tout en améliorant la précision de 1,5% par rapport à GPT-4. (Dataiku) Les organisations s'appuient de plus en plus sur de grands modèles de langage (LLM) pour diverses applications,

par Greggory Elias | 4 août 2024 | IA d'entreprise, IA générative, LLMs / NLP

Alors que les organisations s'appuient de plus en plus sur de grands modèles de langage (LLM) pour diverses applications, des chatbots de service à la clientèle à la génération de contenu, le défi de la gestion des coûts des LLM est devenu primordial. Les coûts opérationnels associés au déploiement et à la maintenance des LLM

par Greggory Elias | 4 août 2024 | IA d'entreprise, Intégration du LLM

Pour les stratégies d'IA des entreprises, il est essentiel de comprendre les structures de tarification des grands modèles de langage (LLM) pour une gestion efficace des coûts. Les coûts opérationnels associés aux LLM peuvent rapidement augmenter en l'absence d'une surveillance adéquate, ce qui peut entraîner des hausses de coûts inattendues susceptibles de faire dérailler les budgets

par Greggory Elias | 4 août 2024 | IA d'entreprise, IA générative, LLMs / NLP

Meta a récemment annoncé Llama 3.1, son modèle de grand langage (LLM) open-source le plus avancé à ce jour. Cette version marque une étape importante dans la démocratisation de la technologie de l'IA, en comblant potentiellement le fossé entre les modèles open-source et les modèles propriétaires. Llama...

par Greggory Elias | 4 août 2024 | IA d'entreprise, Intégration du LLM, Gestion de projet

La récente sortie de Llama 3.1 de Meta a fait des vagues dans le monde de l'entreprise. Cette dernière itération des modèles Llama représente une avancée significative dans le domaine des grands modèles de langage (LLM), offrant un mélange de performance et d'accessibilité qui...

par Greggory Elias | 4 août 2024 | IA d'entreprise, Intégration du LLM

Le paysage des grands modèles de langage (LLM) est devenu un champ de bataille entre les modèles ouverts comme Llama 3.1 de Meta et les offres propriétaires des géants de la technologie comme OpenAI. Alors que les entreprises naviguent sur ce terrain complexe, la décision entre l'adoption d'un modèle ouvert et l'adoption d'un modèle propriétaire se pose de plus en plus.

par Greggory Elias | 4 août 2024 | IA d'entreprise, Intégration du LLM

Le Llama 3.1 de Meta s'est imposé comme une option LLM impressionnante, offrant un mélange unique de performances, de flexibilité et de rentabilité. Alors que les entreprises naviguent dans le monde complexe de l'implémentation de l'IA, Llama 3.1 présente des raisons convaincantes pour...

Commentaires récents