¿Qué es un ataque de IA adversaria?

¿Qué es un ataque de IA adversaria?

Las tecnologías de aprendizaje profundo, como la Inteligencia Artificial (IA) y el aprendizaje automático (AM), presentan una serie de ventajas comerciales para las empresas. Al mismo tiempo, un ataque adversario de IA es un reto de seguridad cada vez mayor para los sistemas modernos.

¿Qué es un ataque Adversarial AI? Una forma de ciberataque que "engaña" a los modelos de IA con datos engañosos. También conocido como Adversarial ML, esta forma de ataque se ha registrado principalmente en la clasificación de imágenes y la detección de spam.

A continuación, analicemos los distintos riesgos que plantea un ataque de IA Adversarial.

Riesgos de un ataque de IA adversaria

Según Alexey Rubtsov del Global Risk Institute, "el aprendizaje automático adversarial explota las vulnerabilidades y especificidades de los modelos de ML". Por ejemplo, el ML adversarial puede hacer que un algoritmo de negociación basado en ML tome decisiones incorrectas sobre la negociación.

¿De qué manera un ataque de IA Adversarial supone un riesgo para los sistemas de IA y ML? He aquí algunas conclusiones comunes:

Ingeniería de redes sociales: En este caso, el ataque de IA "raspa" los perfiles de los usuarios en las plataformas de redes sociales utilizando la automatización. A continuación, genera contenido automáticamente para "atraer" al perfil deseado.

Deepfakes: Utilizados habitualmente en fraudes bancarios, los deepfakes son actores de amenazas en línea que pueden lograr una serie de objetivos nefastos, entre ellos:

Chantaje y extorsión

Dañar la credibilidad y la imagen de una persona

Fraude documental

Redes sociales para el acoso individual o en grupo

Ocultación de malware: En este caso, los autores de las amenazas aprovechan el ML para ocultar el malware dentro de tráfico "malicioso" que a los usuarios normales les parece normal.

Contraseñas: Los ataques de IA adversaria pueden incluso analizar un gran conjunto de contraseñas y generar variaciones. En otras palabras, estos ataques hacen que el proceso de descifrado de contraseñas sea más "científico". Además de las contraseñas, el ML permite a los actores de amenazas resolver también CAPTCHAs.

Ejemplos de ataques de IA adversaria

Utilizando ejemplos de IA Adversarial, los hackers pueden simplemente diseñar un ataque para provocar que el modelo de IA cometa un error. Por ejemplo, una versión corrupta de una entrada válida del modelo.

He aquí algunos ejemplos populares de métodos utilizados en los ataques de IA Adversarial:

Método FastGradient Sign (FGSM): Se trata de un método basado en el gradiente que puede generar ejemplos de IA Adversarial para provocar la clasificación errónea de las imágenes. Para ello, añade una cantidad mínima de perturbación al píxel de la imagen.

Broyden-Fletcher-Goldfarb-Shanno (L-BFGS) de memoria limitada: Este método es otro algoritmo de optimización numérica no lineal basado en gradientes que puede minimizar el número de perturbaciones de la imagen. Este método es extremadamente eficaz para generar ejemplos de IA Adversarial.

Ataque de Deepfool: Se trata de otro método muy eficaz para producir ataques Adversarial AI con un alto índice de clasificación errónea y menos perturbaciones. Esta forma de ataque utiliza una técnica de generación de muestras adversariales no dirigidas para reducir la distancia euclidiana entre las muestras originales y las perturbadas.

Ataque de mapa de saliencia basado en jacobianos (JSMA): En esta forma de ataque de IA adversaria, los hackers utilizan la selección de características para minimizar el número de características modificadas, provocando así una clasificación errónea. Las perturbaciones planas se añaden iterativamente a las características en función del valor de saliencia en orden decreciente.

Estos son sólo algunos ejemplos de IA adversaria. A continuación, vamos a discutir cómo defenderse contra los ataques de IA Adversaria.

Cómo defenderse de los ataques de IA adversaria

221122 skim ai infographic 2 png 01

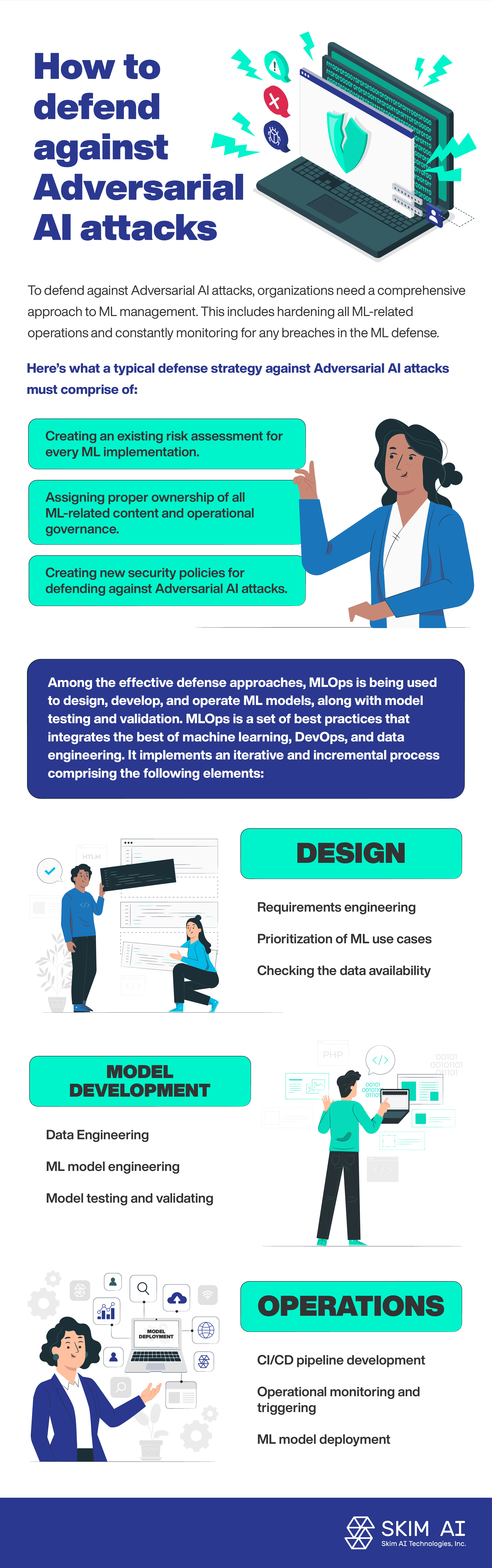

Para defenderse de los ataques de IA adversaria, las organizaciones necesitan un enfoque integral de la gestión de ML. Esto incluye el refuerzo de todas las operaciones relacionadas con ML y la supervisión constante de cualquier brecha en la defensa ML.

He aquí lo que debe comprender una estrategia de defensa típica contra los ataques de IA adversaria:

Creación de una evaluación de riesgos existente para cada implementación de ML.

Asignación de la propiedad adecuada de todos los contenidos relacionados con el ML y gobernanza operativa.

Creación de nuevas políticas de seguridad para defenderse de los ataques de IA adversaria.

Entre los enfoques de defensa eficaces, MLOps se está utilizando para diseñar, desarrollar y operar modelos de ML, junto con la prueba y validación de modelos. MLOps es un conjunto de buenas prácticas que integra lo mejor del aprendizaje automático, DevOps y la ingeniería de datos. Implementa un proceso iterativo e incremental que comprende los siguientes elementos:

Diseño:

Ingeniería de requisitos

Priorización de casos de uso de ML

Comprobar la disponibilidad de los datos

Desarrollo de modelos:

Ingeniería de datos

Ingeniería de modelos ML

Comprobación y validación de modelos

Operaciones:

Despliegue del modelo ML

Desarrollo de canalizaciones CI/CD

Supervisión operativa y activación

Conclusión

Según la Comisión de Seguridad Nacional de EE.UU. informe sobre Inteligencia Artificial, se está invirtiendo un bajo porcentaje de los fondos de investigación sobre IA en la defensa de los sistemas de IA frente a ataques adversarios. La creciente adopción de la IA y de las tecnologías de aprendizaje automático está en correlación con el aumento de los ataques adversarios a la IA. En efecto, los sistemas de IA y ML plantean una nueva superficie de ataque, aumentando así los riesgos relacionados con la seguridad.