Wie Unternehmen mit LLM-Halluzinationen umgehen können, um KI sicher zu integrieren

Große Sprachmodelle (Large Language Models, LLMs) verändern Unternehmensanwendungen und bieten nie dagewesene Möglichkeiten bei der Verarbeitung und Generierung natürlicher Sprache. Bevor Ihr Unternehmen jedoch auf den LLM-Zug aufspringt, müssen Sie eine entscheidende Herausforderung meistern: Halluzinationen.

LLM-Halluzinationen stellen eine erhebliche Hürde für die breite Einführung dieser leistungsstarken KI-Systeme dar. Wenn wir uns mit der komplexen Natur dieses Phänomens befassen, wird deutlich, dass das Verständnis und die Abschwächung von Halluzinationen für jedes Unternehmen, das das volle Potenzial von LLMs nutzen und gleichzeitig die Risiken minimieren möchte, von entscheidender Bedeutung sind.

- Verstehen von LLM-Halluzinationen

- Was sind die Ursachen für Halluzinationen bei LLMs?

- Auswirkungen von LLM-Halluzinationen auf Unternehmen

- Strategien zur Abschwächung von Halluzinationen bei der Integration von LLM in Unternehmen

- Ausblick auf die Zukunft: Fortschritte bei der Minderung von Halluzinationen

- FAQ

- Was sind LLM-Halluzinationen?

- Was sind einige häufige Beispiele für LLM-Halluzinationen bei kritischen Anwendungen?

- Welche Folgen haben LLM-Halluzinationen in der realen Welt?

- Wie wirken sich LLM-Halluzinationen auf die Interaktionen mit dem Kundendienst aus?

- Welche Strategien werden zur Abschwächung von LLM-Halluzinationen eingesetzt?

Verstehen von LLM-Halluzinationen

KI-Halluzinationen beziehen sich im Zusammenhang mit großen Sprachmodellen auf Fälle, in denen das Modell Text generiert oder Antworten liefert, die sachlich falsch, unsinnig oder ohne Bezug zu den Eingabedaten sind. Diese Halluzinationen können sich als selbstbewusst klingende, aber völlig erfundene Informationen äußern, die zu Missverständnissen und Fehlinformationen führen können.

Arten von Halluzinationen

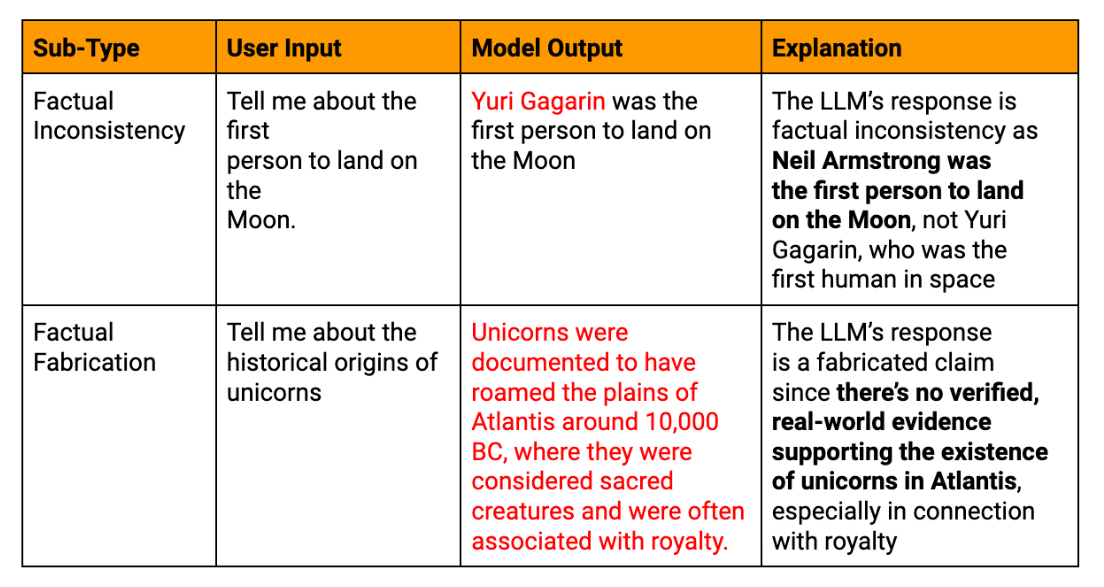

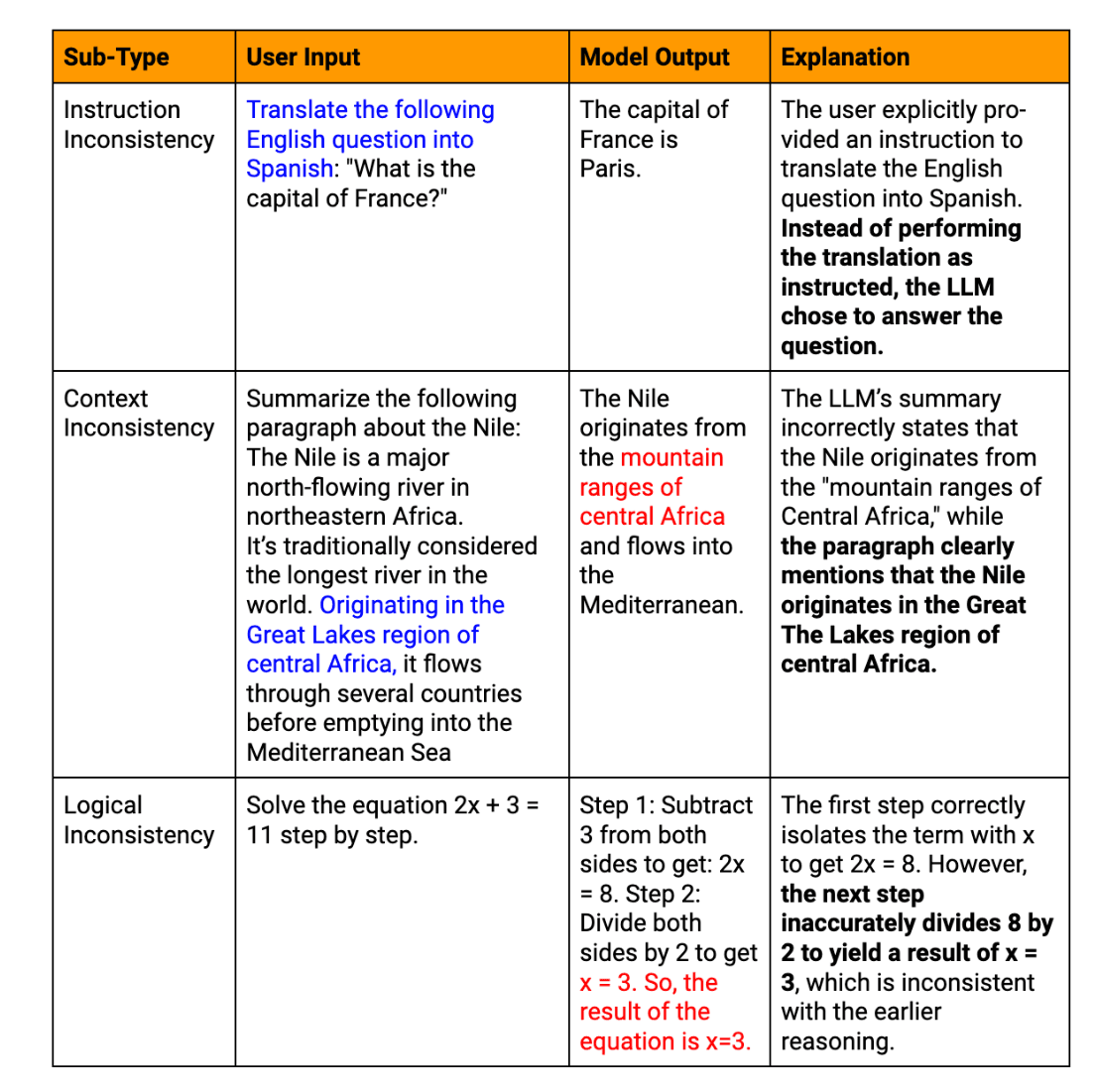

LLM-Halluzinationen können in verschiedene Typen eingeteilt werden:

Tatsächliche Halluzinationen: Wenn das Modell Informationen liefert, die etablierten Fakten widersprechen, oder wenn es nicht existierende Daten erfindet.

Semantische Halluzinationen: Fälle, in denen der generierte Text logisch widersprüchlich oder unsinnig ist, auch wenn einzelne Teile kohärent erscheinen.

Kontextuelle Halluzinationen: Fälle, in denen die Antwort des LLM vom gegebenen Kontext abweicht oder Aufforderungund liefert irrelevante Informationen.

Temporale Halluzinationen: Wenn das Modell zeitabhängige Informationen, wie z. B. aktuelle Ereignisse oder historische Fakten, verwechselt oder falsch darstellt.

Beispiele aus der Praxis für LLM-generierte Texthalluzinationen

Zur Veranschaulichung der bedeutenden Folgen von LLM-Halluzinationen in Unternehmen seien diese einschlägigen Beispiele angeführt:

Missgeschick im Kundenservice Chatbot: Ein großes E-Commerce-Unternehmen integriert einen LLM-gesteuerten Chatbot in seine Kundendienstplattform. Während einer stark frequentierten Verkaufsveranstaltung gibt der Chatbot Tausenden von Kunden falsche Informationen über Rückgaberichtlinien und Versandzeiten. Dies führt zu einem Anstieg der Kundenbeschwerden, beschädigt das Vertrauen und erfordert umfangreiche Bemühungen zur Schadensbegrenzung.

Ungenauigkeiten im Finanzbericht: Eine Investmentfirma verwendet ein LLM zur Unterstützung bei der Erstellung vierteljährlicher Finanzberichte. Das KI-System halluziniert mehrere wichtige Finanzkennzahlen, was bei der ersten Überprüfung unbemerkt bleibt. Wenn der ungenaue Bericht veröffentlicht wird, führt dies zu falschen Investitionsentscheidungen und potenziellen aufsichtsrechtlichen Problemen, was die dringende Notwendigkeit einer gründlichen Überprüfung von KI-generierten Finanzinhalten unterstreicht.

Fehltritt bei der Produktentwicklung: Ein technisches Startup nutzt ein LLM, um Markttrends zu analysieren und Empfehlungen für Produktmerkmale zu generieren. Die KI schlägt zuversichtlich eine Funktion vor, die auf einer nicht existierenden Technologie basiert, was dazu führt, dass das Entwicklungsteam wertvolle Zeit und Ressourcen verschwendet, bevor es den Fehler erkennt. Dieser Vorfall unterstreicht, wie wichtig es ist, die Ergebnisse von LLMs mit zuverlässigen Branchenquellen abzugleichen.

Verwirrung in der Personalpolitik: Ein multinationales Unternehmen stellt einen LLM ein, der bei der Ausarbeitung von Personalrichtlinien helfen soll. Die KI halluziniert ein nicht existierendes Arbeitsrecht, das versehentlich in das offizielle Richtliniendokument des Unternehmens aufgenommen wird. Dies führt zu Verwirrung bei den Mitarbeitern und zu einem potenziellen rechtlichen Risiko, was die Notwendigkeit einer fachlichen Überprüfung der von der KI erstellten Richtlinieninhalte unterstreicht.

Diese Beispiele zeigen, wie sich LLM-Halluzinationen auf verschiedene Aspekte der Unternehmensabläufe auswirken können, von der Interaktion mit dem Kunden bis hin zu internen Prozessen und strategischen Entscheidungen. Sie unterstreichen, wie wichtig es ist, robuste Verifizierungsprozesse zu implementieren und die menschliche Kontrolle aufrechtzuerhalten, wenn LLM-generierter Text in geschäftskritischen Anwendungen eingesetzt wird.

Was sind die Ursachen für Halluzinationen bei LLMs?

Das Verständnis der Ursachen von LLM-Halluzinationen ist für die Entwicklung wirksamer Abhilfestrategien von entscheidender Bedeutung. Mehrere miteinander verknüpfte Faktoren tragen zu diesem Phänomen bei.

Probleme mit der Qualität der Schulungsdaten

Die Qualität der Trainingsdaten hat einen erheblichen Einfluss auf die Leistung eines LLM. Ungenaue oder veraltete Informationen, Verzerrungen im Quellmaterial und Unstimmigkeiten in der Darstellung von Sachdaten können zu Halluzinationen führen. Wenn zum Beispiel ein LLM auf einem Datensatz trainiert wird, der veraltete wissenschaftliche Theorien enthält, kann es diese in seinen Ergebnissen getrost als aktuelle Fakten darstellen.

Beschränkungen bei AI-Modellen und Sprachmodellen

Trotz ihrer beeindruckenden Fähigkeiten haben die derzeitigen LLMs inhärente Grenzen:

Mangel an echtem Verständnis: LLMs verarbeiten eher Muster im Text als dass sie die Bedeutung verstehen

Begrenztes Kontextfenster: Den meisten Modellen fällt es schwer, über lange Strecken kohärent zu bleiben

Unfähigkeit, Fakten zu überprüfen: LLMs können nicht in Echtzeit auf externes Wissen zugreifen, um generierte Informationen zu verifizieren

Diese Einschränkungen können dazu führen, dass das Modell zwar plausibel klingende, aber sachlich falsche oder unsinnige Inhalte erzeugt.

Herausforderungen bei der LLM-Erzeugung

Der Prozess der Texterstellung selbst kann zu Halluzinationen führen. LLMs produzieren Inhalt Token für Token auf der Grundlage probabilistischer Vorhersagen, was zu semantischem Drift oder unwahrscheinlichen Sequenzen führen kann. Darüber hinaus zeigen LLMs oft ein übermäßiges Selbstvertrauen, indem sie halluzinierte Informationen mit der gleichen Gewissheit präsentieren wie faktische Daten.

Eingabedaten und aufforderungsbezogene Faktoren

Die Interaktion des Benutzers mit LLMs kann unbeabsichtigt Halluzinationen fördern. Zweideutige Aufforderungen, unzureichender Kontext oder zu komplexe Abfragen können dazu führen, dass das Modell die Absicht falsch interpretiert oder Lücken mit erfundenen Informationen füllt.

Auswirkungen von LLM-Halluzinationen auf Unternehmen

Das Auftreten von Halluzinationen bei LLM-Outputs kann weitreichende Folgen für Unternehmen haben:

Risiken falscher Antworten und sachlich falscher Informationen

Wenn sich Unternehmen bei der Entscheidungsfindung oder der Kundenkommunikation auf LLM-generierte Inhalte verlassen, können halluzinierte Informationen zu kostspieligen Fehlern führen. Diese Fehler können von kleinen operativen Ineffizienzen bis hin zu großen strategischen Fehltritten reichen. Zum Beispiel könnte ein LLM, das ungenaue Marktanalysen liefert, zu falschen Investitionsentscheidungen oder Produktentwicklungsstrategien führen.

Mögliche rechtliche und ethische Konsequenzen

Unternehmen, die LLM einsetzen, müssen sich in einer komplexen Landschaft von gesetzlichen Vorschriften und ethischen Überlegungen zurechtfinden. Betrachten Sie die folgenden Szenarien:

Halluzinierte Inhalte in Finanzberichten, die zu Verstößen gegen Rechtsvorschriften führen

Ungenaue Informationen für Kunden, die zu rechtlichen Schritten führen

Ethische Dilemmata, die sich aus dem Einsatz von KI-Systemen ergeben, die unzuverlässige Informationen liefern

Auswirkungen auf die Zuverlässigkeit und das Vertrauen von KI-Systemen

Am kritischsten ist vielleicht, dass LLM-Halluzinationen die Zuverlässigkeit und das Vertrauen in KI-Systeme erheblich beeinträchtigen können. Häufige oder auffällige Fälle von Halluzinationen können:

Schwächung des Vertrauens der Nutzer, was die Einführung und Integration von KI verlangsamen könnte

Schädigung des Rufs eines Unternehmens als Technologieführer

zu einer erhöhten Skepsis gegenüber allen von KI generierten Ergebnissen führen, selbst wenn diese korrekt sind

Für Unternehmen ist die Bewältigung dieser Auswirkungen nicht nur eine technische Herausforderung, sondern ein strategisches Gebot.

Strategien zur Abschwächung von Halluzinationen bei der Integration von LLM in Unternehmen

Da Unternehmen zunehmend große Sprachmodelle einsetzen, wird die Bewältigung der Herausforderung von Halluzinationen von größter Bedeutung sein.

Es gibt wichtige Strategien, um dieses Problem zu entschärfen:

1. Verbesserung der Integration von Schulungsdaten und externem Wissen

Die Grundlage eines jeden LLM sind die Trainingsdaten. Um Halluzinationen zu vermeiden, müssen sich Unternehmen auf die Verbesserung der Datenqualität und die Integration von zuverlässigem externem Wissen konzentrieren.

Entwickeln Sie bereichsspezifische Datensätze, die gründlich auf ihre Genauigkeit hin überprüft werden. Dieser Ansatz hilft dem Modell, aus qualitativ hochwertigen, relevanten Informationen zu lernen, wodurch die Wahrscheinlichkeit von sachlichen Fehlern verringert wird.

Implementieren Sie Systeme zur regelmäßigen Aktualisierung der Trainingsdaten, um sicherzustellen, dass das Modell Zugriff auf die aktuellsten Informationen hat. Dies ist besonders wichtig für Branchen mit sich schnell entwickelnden Wissensbeständen, wie z. B. Technologie oder Gesundheitswesen.

Einbindung strukturierter Wissensgraphen in die Architektur des LLM. Dadurch erhält das Modell einen verlässlichen Rahmen von faktischen Beziehungen, der dazu beiträgt, seine Ergebnisse auf verifizierte Informationen zu stützen.

Umsetzung RAG Techniken, die es dem LLM ermöglichen, während der Texterstellung auf externe, aktuelle Wissensdatenbanken zuzugreifen und darauf zu verweisen. Dieser Mechanismus zur Überprüfung der Fakten in Echtzeit verringert das Risiko veralteter oder falscher Informationen erheblich.

2. Implementierung einer robusten Validierung für LLM-Ausgaben

Validierungsprozesse sind von entscheidender Bedeutung, um Halluzinationen zu erkennen und zu korrigieren, bevor sie die Endnutzer erreichen.

Entwicklung von KI-gestützten Systemen zur Überprüfung von Fakten, die wichtige Aussagen in LLM-generierten Texten schnell mit vertrauenswürdigen Datenbanken oder Webquellen abgleichen können.

Implementierung von Algorithmen, die verschiedene Teile des LLM-Outputs auf interne Konsistenz prüfen und Widersprüche aufzeigen, die auf Halluzinationen hindeuten könnten.

Verwenden Sie die eigenen Vertrauenswerte des Modells für jedes generierte Segment. Ausgaben mit niedrigen Vertrauenswerten können für eine menschliche Überprüfung oder zusätzliche Verifizierung gekennzeichnet werden.

Setzen Sie mehrere LLMs oder KI-Modelle ein, um Antworten auf dieselbe Aufforderung zu generieren, und vergleichen Sie die Ergebnisse, um mögliche Halluzinationen durch Diskrepanzen zu erkennen.

3. Nutzung menschlicher Aufsicht zur Gewährleistung der sachlichen Richtigkeit

Auch wenn die Automatisierung von entscheidender Bedeutung ist, bleibt das menschliche Fachwissen von unschätzbarem Wert für die Eindämmung von Halluzinationen.

Einrichtung von Prozessen, bei denen Fachleute die LLM-Ergebnisse in kritischen Anwendungen, wie z. B. juristischen Dokumenten oder Finanzberichten, überprüfen.

Entwicklung von Schnittstellen, die eine nahtlose Zusammenarbeit zwischen LLMs und menschlichen Bedienern erleichtern und schnelle Korrekturen und Lernen aus menschlichen Eingaben ermöglichen.

Einführung von Mechanismen für Endnutzer, um vermutete Halluzinationen zu melden und einen kontinuierlichen Verbesserungszyklus für das LLM-System zu schaffen.

Entwicklung umfassender Schulungen für Mitarbeiter zur Erkennung von und zum Umgang mit potenziellen LLM-Halluzinationen, um eine Kultur der kritischen Bewertung von KI-generierten Inhalten zu fördern.

4. Fortgeschrittene Techniken zur Verbesserung des Verhaltens des Modells

Die Spitzenforschung bietet vielversprechende Wege zur Verbesserung der LLM-Leistung und zur Verringerung von Halluzinationen.

Eingeschränkte Dekodierung: Implementierung von Techniken, die den Textgenerierungsprozess des LLM leiten und ihn dazu zwingen, sich enger an bekannte Fakten oder festgelegte Regeln zu halten.

Unsicherheitsbewusste Modelle: Entwicklung von LLMs, die Unsicherheit über ihre Ergebnisse ausdrücken können, möglicherweise unter Verwendung von Techniken wie kalibrierten Sprachmodellen oder Ensemble-Methoden.

Gegenseitiges Training: Setzen Sie das Modell während des Trainings ungünstigen Beispielen aus, damit es robuster gegen die Erzeugung von Halluzinationen wird.

Feinabstimmung mit Reinforcement Learning: Anwendung von Verstärkungslerntechniken zur Feinabstimmung von LLMs, wobei sachliche Genauigkeit belohnt und Halluzinationen bestraft werden.

Modulare Architekturen: Erforschung von Architekturen, die das Weltwissen von den Fähigkeiten zur Spracherzeugung trennen und so eine kontrolliertere und überprüfbare Informationsbeschaffung ermöglichen.

Durch die Umsetzung dieser Strategien kann Ihr Unternehmen das Risiko von Halluzinationen in seinen LLM-Anwendungen erheblich reduzieren. Es ist jedoch wichtig zu beachten, dass die vollständige Beseitigung von Halluzinationen eine Herausforderung bleibt. Daher ist ein vielseitiger Ansatz, der technologische Lösungen mit menschlicher Aufsicht kombiniert, von entscheidender Bedeutung.

Ausblick auf die Zukunft: Fortschritte bei der Minderung von Halluzinationen

Mit Blick auf die Zukunft der LLM-Technologie bleibt die Abschwächung von Halluzinationen ein wichtiger Schwerpunkt der laufenden Forschung im Bereich des maschinellen Lernens. Zur Bewältigung dieser Herausforderung werden laufend neue Tools und Frameworks entwickelt, mit vielversprechenden Fortschritten in Bereichen wie Selbstkonsistenzprüfung, Wissensintegration und Quantifizierung von Unsicherheit.

Zukünftige Forschung wird eine entscheidende Rolle bei der Verbesserung der LLM-Faktengenauigkeit spielen und zu Modellen führen, die besser zwischen Faktenwissen und generiertem Text unterscheiden können. Im Zuge der Weiterentwicklung von KI-Systemen erwarten wir ausgefeiltere Ansätze zur Abschwächung von Halluzinationen, einschließlich fortschrittlicher neuronaler Architekturen, verbesserter Trainingsmethoden und verbesserter Integration von externem Wissen. Für Unternehmen, die den Einsatz von LLM in Erwägung ziehen, ist es von entscheidender Bedeutung, über diese Entwicklungen informiert zu bleiben, um das volle Potenzial von KI zu nutzen und gleichzeitig die höchsten Standards für Genauigkeit und Zuverlässigkeit in ihren Abläufen zu wahren.

FAQ

Was sind LLM-Halluzinationen?

LLM-Halluzinationen sind Fälle, in denen KI-Modelle Texte erzeugen, die faktisch falsch oder unsinnig sind, obwohl sie selbstbewusst und kohärent erscheinen.

Was sind einige häufige Beispiele für LLM-Halluzinationen bei kritischen Anwendungen?

Häufige Beispiele sind die Erstellung falscher Finanzdaten in Berichten, falsche Rechtsberatung oder die Erfindung nicht vorhandener Produktmerkmale in technischen Unterlagen.

Welche Folgen haben LLM-Halluzinationen in der realen Welt?

Zu den Folgen können finanzielle Verluste aufgrund falscher Entscheidungen, rechtliche Verpflichtungen aufgrund falscher Beratung und eine Schädigung des Rufs des Unternehmens durch die Veröffentlichung falscher Informationen gehören.

Wie wirken sich LLM-Halluzinationen auf die Interaktionen mit dem Kundendienst aus?

Halluzinationen im Kundenservice können zu Fehlinformationen, frustrierten Kunden und sinkendem Vertrauen in die KI-gestützten Supportsysteme des Unternehmens führen.

Welche Strategien werden zur Abschwächung von LLM-Halluzinationen eingesetzt?

Zu den wichtigsten Strategien gehören die Verbesserung der Qualität der Trainingsdaten, die Implementierung einer robusten Output-Validierung, die Integration menschlicher Kontrolle und die Verwendung fortgeschrittener Techniken wie die abruferweiterte Generierung.