Metas Llama 3.1: Die Grenzen der Open-Source-KI verschieben

Meta hat kürzlich angekündigt Llama 3.1sein bisher fortschrittlichstes Open-Source-Modell für große Sprachen (LLM). Diese Veröffentlichung stellt einen wichtigen Meilenstein in der Demokratisierung der KI-Technologie dar und überbrückt möglicherweise die Kluft zwischen Open-Source- und proprietären Modellen.

Llama 3.1 ist ein großer Sprung nach vorn bei den Open-Source-KI-Funktionen. Mit seinem 405-Milliarden-Parameter-Flaggschiff stellt Meta die Vorstellung in Frage, dass modernste KI quelloffen und proprietär sein muss. Diese Version läutet eine neue Ära ein, in der modernste KI-Funktionen für Forscher, Entwickler und Unternehmen jeder Größe zugänglich sind.

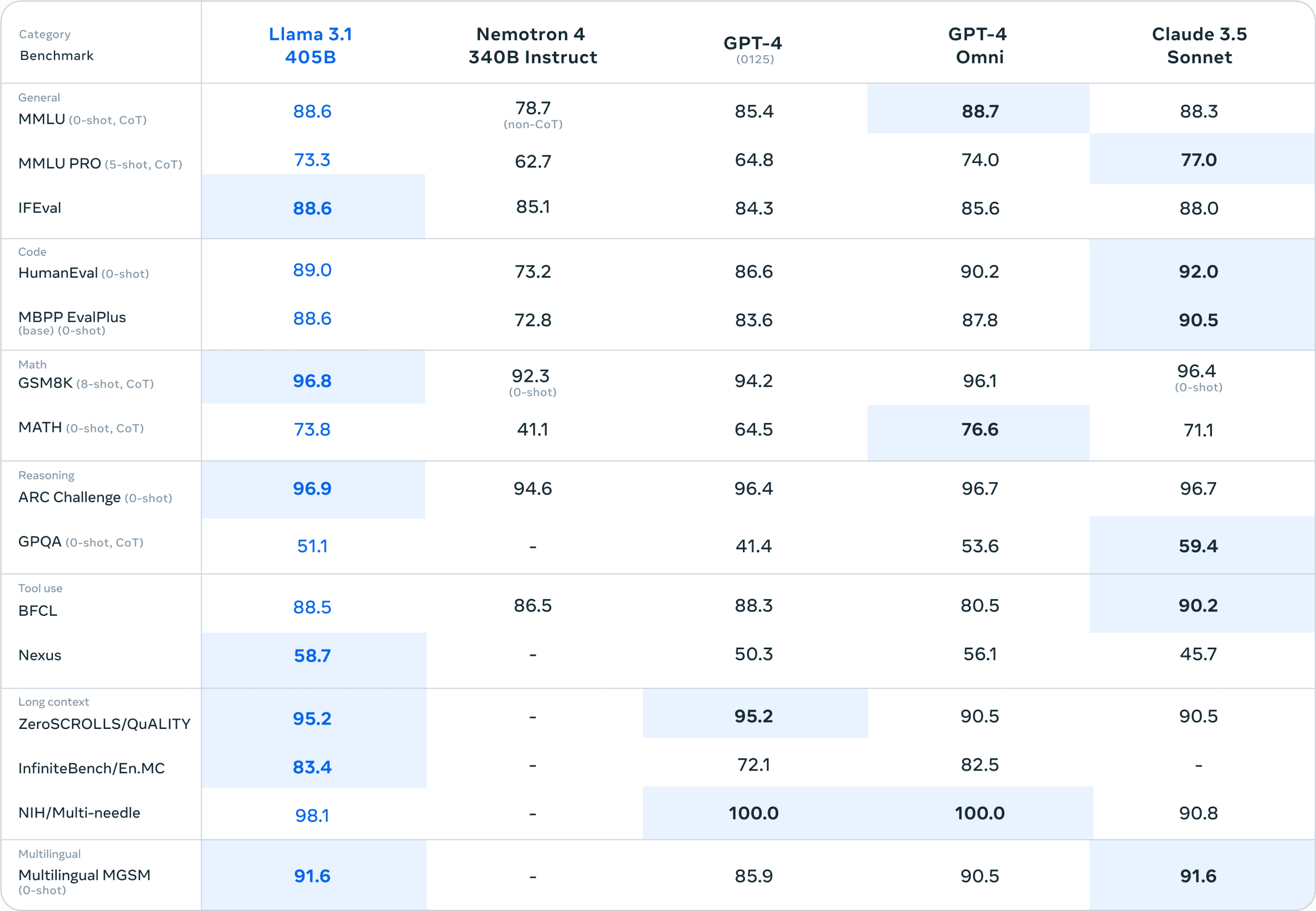

Zu den wichtigsten Verbesserungen in Llama 3.1 gehören eine erweiterte Kontextlänge von 128.000 Token, Unterstützung für acht Sprachen und eine beispiellose Leistung in Bereichen wie Argumentation, Mathematik und Codegenerierung. Diese Verbesserungen machen Llama 3.1 zu einem vielseitigen Werkzeug, das in der Lage ist, komplexe, reale Aufgaben in verschiedenen Bereichen im Unternehmen zu bewältigen.

Die Entwicklung von Llama: Von 2 zu 3.1

Um die Bedeutung von Llama 3.1 zu verstehen, lohnt es sich, einen Blick auf seine Vorgänger zu werfen. Llama 2, das im Jahr 2023 veröffentlicht wurde, war bereits ein großer Schritt nach vorn in der Open-Source-KI. Es bot Modelle mit 7B bis 70B Parametern und zeigte bei verschiedenen Benchmarks eine konkurrenzfähige Leistung.

Llama 3.1 baut auf dieser Grundlage mit mehreren wichtigen Verbesserungen auf:

Erhöhte Modellgröße: Die Einführung des 405B-Parameter-Modells verschiebt die Grenzen dessen, was in der Open-Source-KI möglich ist.

Erweiterte Kontextlänge: Von 4K Token in Llama 2 auf 128K in Llama 3.1, was ein komplexeres und differenzierteres Verständnis von längeren Texten ermöglicht.

Mehrsprachige Fähigkeiten: Die erweiterte Sprachunterstützung ermöglicht eine größere Vielfalt von Anwendungen in verschiedenen Regionen und Anwendungsfällen.

Verbessertes logisches Denken und spezialisierte Aufgaben: Verbesserte Leistung in Bereichen wie mathematische Argumentation und Codegenerierung.

Im Vergleich zu Closed-Source-Modellen wie GPT-4 und Claude 3.5 Sonnet behauptet sich Llama 3.1 405B in verschiedenen Benchmarks. Dieses Leistungsniveau bei einem Open-Source-Modell ist beispiellos.

Technische Daten von Llama 3.1

Zu den technischen Details: Llama 3.1 bietet eine Reihe von Modellgrößen, um unterschiedlichen Bedürfnissen und Rechenressourcen gerecht zu werden:

8B-Parameter-Modell: Geeignet für leichte Anwendungen und Edge-Geräte.

70B-Parameter-Modell: Ein ausgewogenes Verhältnis zwischen Leistungs- und Ressourcenanforderungen.

405B-Parameter-Modell: Das Vorzeigemodell, das die Grenzen der Open-Source-KI-Funktionen ausreizt.

Die Trainingsmethodik für Llama 3.1 umfasste einen riesigen Datensatz von über 15 Billionen Token, deutlich mehr als die Vorgängerversionen. Diese umfangreichen Trainingsdaten in Verbindung mit einer verfeinerten Datenkuration und Vorverarbeitungstechniken tragen zur verbesserten Leistung und Vielseitigkeit des Modells bei.

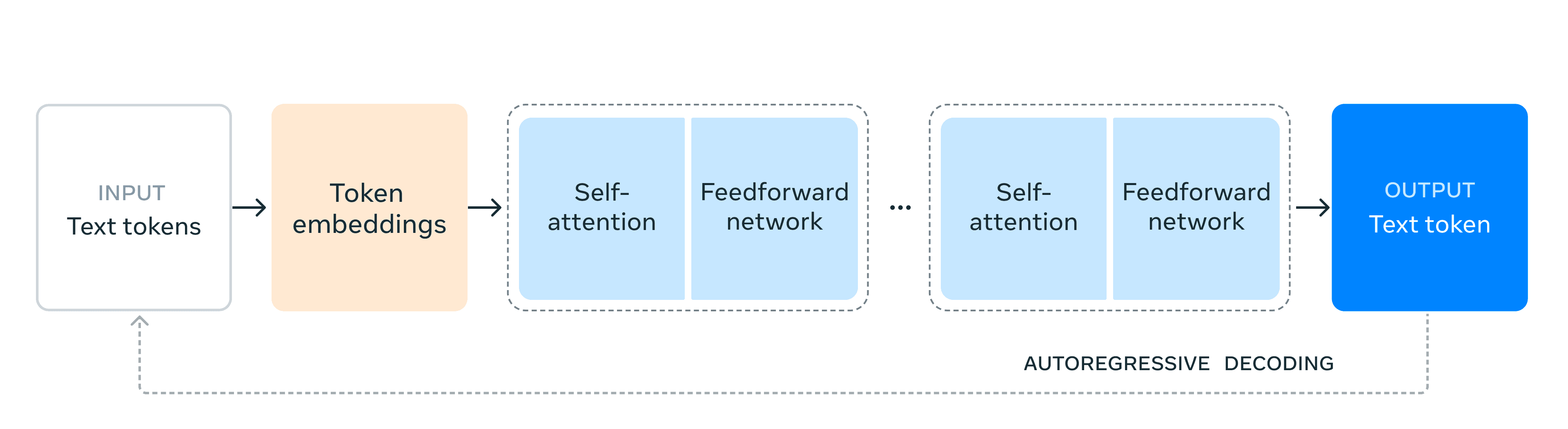

Architektonisch bleibt Llama 3.1 ein reines Decoder-Transformationsmodell, das der Trainingsstabilität Vorrang vor experimentelleren Ansätzen wie Mixture-of-Experts einräumt. Meta hat jedoch mehrere Optimierungen implementiert, um effizientes Training und Inferenz in dieser beispiellosen Größenordnung zu ermöglichen:

Skalierbare Schulungsinfrastruktur: Verwendung von über 16.000 H100-GPUs zum Trainieren des 405B-Modells.

Iteratives Nachschulungsverfahren: Einsatz von überwachter Feinabstimmung und direkter Präferenzoptimierung zur Verbesserung bestimmter Fähigkeiten.

Quantisierungsverfahren: Reduzierung des Modells von 16-Bit- auf 8-Bit-Zahlen für eine effizientere Inferenz, die den Einsatz auf einzelnen Serverknoten ermöglicht.

Diese technischen Entscheidungen spiegeln ein Gleichgewicht zwischen der Überschreitung der Grenzen der Modellgröße und der Gewährleistung der praktischen Verwendbarkeit in einer Reihe von Einsatzszenarien wider.

Indem Meta diese fortschrittlichen Modelle offen zugänglich macht, stellt es nicht nur ein Produkt zur Verfügung, sondern bietet eine Plattform für Innovationen. Die technischen Spezifikationen von Llama 3.1 eröffnen Forschern und Entwicklern neue Möglichkeiten, innovative KI-Anwendungen zu erforschen und das Tempo der KI-Fortschritte in der gesamten Branche zu beschleunigen.

Bahnbrechende Fähigkeiten

Llama 3.1 führt mehrere bahnbrechende Funktionen ein, die es in der KI-Landschaft hervorheben:

Erweitertes Kontext Länge

Der Sprung zu einem 128K Token-Kontextfenster ist ein entscheidender Fortschritt. Diese erweiterte Kapazität ermöglicht es Llama 3.1, viel längere Textstücke zu verarbeiten und zu verstehen, wodurch:

Umfassende Dokumentenanalyse

Erstellung langfristiger Inhalte

Differenziertere Gesprächsführung

Diese Funktion eröffnet neue Möglichkeiten für Anwendungen in Bereichen wie der Verarbeitung von Rechtsdokumenten, der Literaturanalyse und der Lösung komplexer Probleme, die die Speicherung und Synthese großer Mengen von Informationen erfordern.

Mehrsprachige Unterstützung

Die Unterstützung von acht Sprachen erweitert die globale Anwendbarkeit von Llama 3.1 erheblich. Diese mehrsprachige Fähigkeit:

Verbessert die interkulturelle Kommunikation

Ermöglicht umfassendere KI-Anwendungen

Unterstützt globale Geschäftsabläufe

Durch die Überwindung von Sprachbarrieren ebnet Llama 3.1 den Weg für vielfältigere und global ausgerichtete KI-Lösungen.

Fortgeschrittenes logisches Denken und Einsatz von Werkzeugen

Das Modell zeigt ausgefeilte Argumentationsfähigkeiten und die Fähigkeit, externe Werkzeuge effektiv zu nutzen. Dieser Fortschritt manifestiert sich in:

Verbesserte logische Schlussfolgerung und Problemlösung

Verbesserte Fähigkeit, komplexe Anweisungen zu befolgen

Effektive Nutzung von externen Wissensdatenbanken und APIs

Diese Fähigkeiten machen Llama 3.1 zu einem leistungsstarken Werkzeug für Aufgaben, die kognitive Fähigkeiten auf hohem Niveau erfordern, von der strategischen Planung bis zur komplexen Datenanalyse.

Codegenerierung und mathematische Fähigkeiten

Llama 3.1 zeigt bemerkenswerte Fähigkeiten in technischen Bereichen:

Generierung von hochwertigem, funktionalem Code in mehreren Programmiersprachen

Komplexe mathematische Probleme mit Genauigkeit lösen

Unterstützung bei der Entwicklung und Optimierung von Algorithmen

Diese Funktionen machen Llama 3.1 zu einer wertvollen Bereicherung für die Softwareentwicklung, wissenschaftliche Berechnungen und technische Anwendungen.

Der Open-Source-Vorteil

Der Open-Source-Charakter von Llama 3.1 bringt mehrere bedeutende Vorteile mit sich.

Meta macht KI-Fähigkeiten der Spitzenklasse frei verfügbar:

Senkung der Eintrittsbarrieren für die KI-Forschung und -Entwicklung

Befähigung kleinerer Organisationen und einzelner Entwickler zur Nutzung fortschrittlicher KI

Förderung eines vielfältigeren und innovativeren KI-Ökosystems

Diese Demokratisierung könnte zu einer Verbreitung von KI-Anwendungen in verschiedenen Sektoren führen, was den technologischen Fortschritt beschleunigen könnte.

Die Möglichkeit, auf die Modellgewichte von Llama 3.1 zuzugreifen und sie zu verändern, eröffnet ungeahnte Möglichkeiten der Anpassung:

Bereichsspezifische Anpassung für spezialisierte Branchen

Feinabstimmung für spezielle Anwendungsfälle und Datensätze

Experimentieren mit neuen Trainingstechniken und -architekturen

Diese Flexibilität ermöglicht es Unternehmen, das Modell auf ihre spezifischen Bedürfnisse zuzuschneiden, was zu effektiveren und effizienteren KI-Lösungen führen kann.

Ökosystem und Einsatz

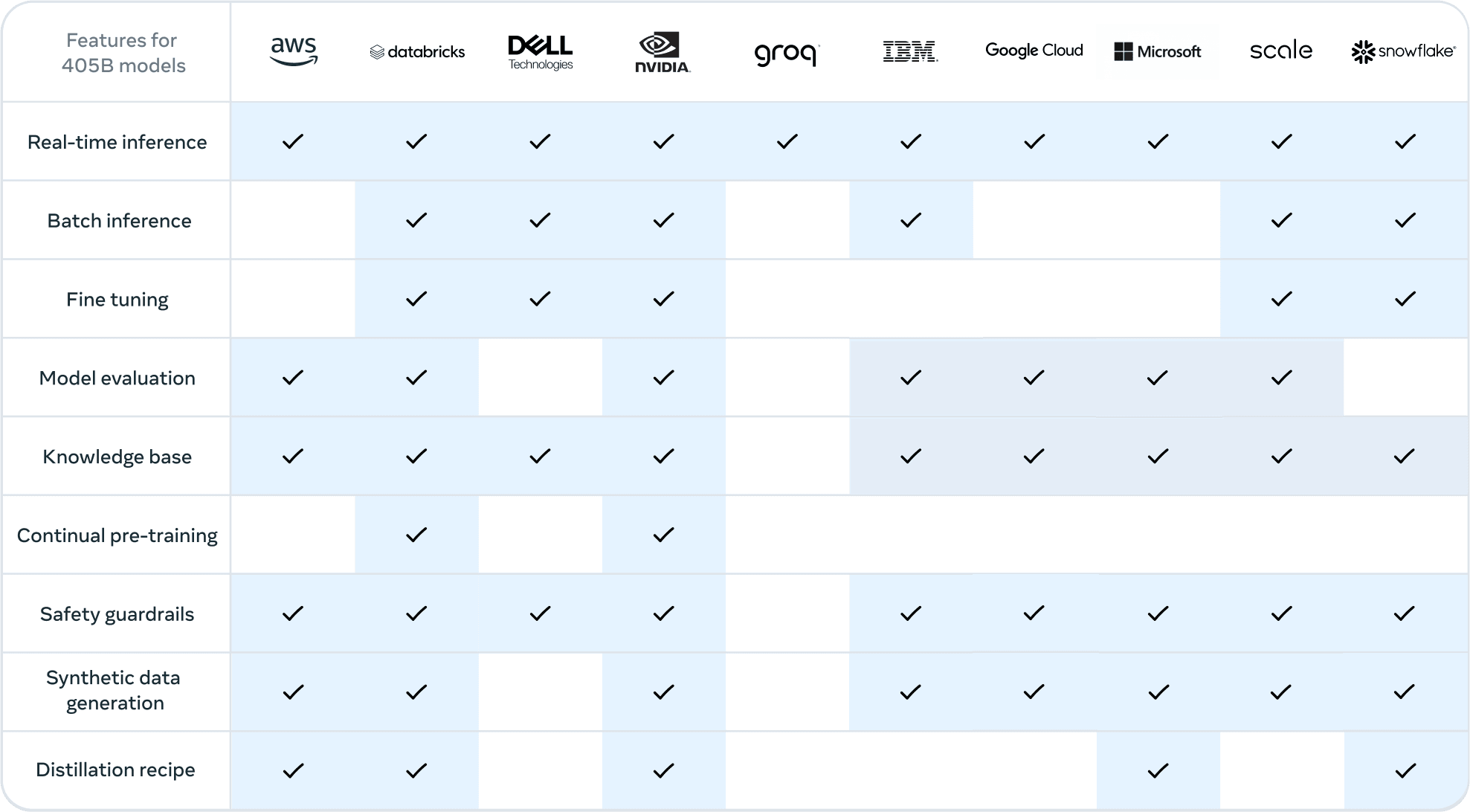

Die Veröffentlichung von Llama 3.1 wird von einem robusten Ökosystem begleitet, das den Einsatz und die Nutzung der Software unterstützt:

Partner-Integrationen

Meta hat mit führenden Unternehmen der Branche zusammengearbeitet, um eine weitreichende Unterstützung für Llama 3.1 zu gewährleisten:

Cloud-Anbieter wie AWS, Google Cloud und Azure bieten nahtlose Bereitstellungsoptionen

Hardwarehersteller wie NVIDIA und Dell bieten eine optimierte Infrastruktur

Datenplattformen wie Databricks und Snowflake ermöglichen eine effiziente Datenverarbeitung und Modellintegration

Diese Partnerschaften stellen sicher, dass Unternehmen Llama 3.1 innerhalb ihrer bestehenden Technologiepakete nutzen können.

Optimierung der Schlussfolgerungen und Skalierbarkeit

Um Llama 3.1 für reale Anwendungen praxistauglich zu machen, wurden mehrere Optimierungen vorgenommen:

Quantisierungstechniken reduzieren den Rechenaufwand des Modells

Optimierte Inferenzmaschinen wie vLLM und TensorRT steigern die Leistung

Skalierbare Bereitstellungsoptionen für verschiedene Anwendungsfälle, von Edge-Geräten bis zu Rechenzentren

Diese Optimierungen machen es möglich, sogar das 405B-Parameter-Modell in Produktionsumgebungen einzusetzen.

Der Llama-Stapel und Standardisierungsbemühungen

Meta setzt sich für eine Standardisierung im KI-Ökosystem ein:

Der vorgeschlagene Llama Stack zielt darauf ab, eine gemeinsame Schnittstelle für KI-Komponenten zu schaffen

Standardisierte APIs könnten die Integration und Interoperabilität zwischen verschiedenen KI-Tools und Plattformen erleichtern

Diese Initiative könnte zu einem kohärenteren und effizienteren Ökosystem für die KI-Entwicklung führen

Versprechen und Potenzial von Llama 3.1

Metas Veröffentlichung von Llama 3.1 markiert einen entscheidenden Moment in der KI-Landschaft, da es den Zugang zu KI-Fähigkeiten auf Spitzenniveau demokratisiert. Durch das Angebot eines 405B-Parameter-Modells mit hochmoderner Leistung, mehrsprachiger Unterstützung und erweiterter Kontextlänge, alles in einem Open-Source-Framework, hat Meta einen neuen Standard für zugängliche, leistungsstarke KI gesetzt. Dieser Schritt stellt nicht nur die Dominanz von Closed-Source-Modellen in Frage, sondern ebnet auch den Weg für beispiellose Innovation und Zusammenarbeit in der KI-Community.

An diesem Scheideweg der KI-Entwicklung stellt Llama 3.1 mehr als nur einen technologischen Fortschritt dar; es verkörpert eine Vision einer offeneren, inklusiveren und dynamischeren Zukunft für künstliche Intelligenz. Die wahren Auswirkungen dieser Version werden sich entfalten, wenn Entwickler, Forscher und Unternehmen auf der ganzen Welt das Potenzial von Llama nutzen, um Branchen umzugestalten und die Grenzen dessen zu erweitern, was mit LLMs möglich ist.