Was ist Chain-of-Thought (CoT) Prompting?

Große Sprachmodelle (Large Language Models, LLMs) zeigen bemerkenswerte Fähigkeiten bei der Verarbeitung und Generierung natürlicher Sprache (NLP). Bei komplexen Denkaufgaben können diese Modelle jedoch Schwierigkeiten haben, genaue und zuverlässige Ergebnisse zu liefern. Hier kommt das Chain-of-Thought (CoT) Prompting ins Spiel, das eine leistungsstarke Technik zur Verbesserung der Problemlösungsfähigkeiten von LLMs bietet. Verstehen...

- Verstehen der Gedankenkettenanregung

- Die Mechanik der Gedankenkettenanregung

- Anwendungen der Gedankenkettenanregung

- Vorteile der Implementierung von CoT Prompting

- Beschränkungen und Überlegungen

- Das Fazit zu CoT Prompting

- Häufig gestellte Fragen (FAQ)

- 1. Wie verbessert die Gedankenkette die Genauigkeit von Sprachmodellen?

- 2. Kann die Gedankenkettenführung auch für andere Aufgaben als Rechen- und Logikrätsel verwendet werden?

- Was sind die häufigsten Herausforderungen bei der Umsetzung der Gedankenkettenführung?

- Wie unterscheidet sich Auto-CoT von der traditionellen Denkkettensteuerung?

- Gibt es bestimmte Sprachmodelle, die bei der Aufforderung zu einer Gedankenkette besser funktionieren?

Verstehen der Gedankenkettenanregung

Chain-of-Thought-Prompting ist eine fortgeschrittene schnelles Engineering Technik, die LLMs durch einen Schritt-für-Schritt-Argumentationsprozess führen soll. Im Gegensatz zu herkömmlichen Prompting-Methoden, die auf direkte Antworten abzielen, ermutigt das CoT-Prompting das Modell, Zwischenschritte zu generieren, bevor es zu einer endgültigen Antwort kommt. Dieser Ansatz ahmt menschliche Denkmuster nach und ermöglicht es KI-Systemen, komplexe Aufgaben mit größerer Genauigkeit und Transparenz zu bewältigen.

Im Kern geht es bei der CoT-Eingabeaufforderung darum, die Eingabeaufforderungen so zu strukturieren, dass das Modell eine logische Abfolge von Gedanken auslöst. Indem komplexe Probleme in kleinere, überschaubare Schritte unterteilt werden, ermöglicht CoT den LLMs, effektiver durch komplizierte Denkpfade zu navigieren. Dies ist besonders wertvoll für Aufgaben, die eine mehrstufige Problemlösung erfordern, wie z. B. mathematische Wortprobleme, logische Denkaufgaben und komplexe Entscheidungsszenarien.

Die Entwicklung der Gedankenkettenführung im Bereich der KI ist eng mit der Entwicklung immer ausgefeilterer Sprachmodelle verbunden. Als die LLMs immer größer und leistungsfähiger wurden, stellten die Forscher fest, dass ausreichend große Sprachmodelle bei richtiger Eingabeaufforderung Denkfähigkeiten aufweisen können. Diese Beobachtung führte zur Formalisierung von CoT als eigenständige Prompting-Technik.

Ursprünglich von Google-Forschern im Jahr 2022 eingeführthat das CoT-Prompting in der KI-Gemeinschaft schnell an Bedeutung gewonnen. Die Technik zeigte signifikante Verbesserungen der Modellleistung bei verschiedenen komplexen Denkaufgaben, darunter:

Arithmetisches Denken

Vernünftige Argumentation

Symbolische Manipulation

Beantwortung von Fragen mit mehreren Schritten

Was CoT von anderen Prompt-Engineering-Techniken unterscheidet, ist die Tatsache, dass nicht nur die Antwort, sondern der gesamte Denkprozess, der zu dieser Antwort führt, im Mittelpunkt steht. Dieser Ansatz bietet mehrere Vorteile:

Verbessertes Problemlösen: Indem sie komplexe Aufgaben in kleinere Schritte zerlegen, können die Modelle Probleme lösen, die ihnen bisher nicht zugänglich waren.

Verbesserte Interpretierbarkeit: Der Schritt-für-Schritt-Argumentationsprozess gibt Aufschluss darüber, wie das Modell zu seinen Schlussfolgerungen kommt, wodurch die KI-Entscheidungsfindung transparenter wird.

Vielseitigkeit: CoT kann auf eine Vielzahl von Aufgaben und Bereichen angewandt werden, was es zu einem wertvollen Werkzeug im KI-Toolkit macht.

Wenn wir uns eingehender mit den Mechanismen und Anwendungen von Chain-of-Thought Prompting befassen, wird deutlich, dass diese Technik einen bedeutenden Fortschritt in unserer Fähigkeit darstellt, das volle Potenzial großer Sprachmodelle für komplexe Denkaufgaben zu nutzen.

Die Mechanik der Gedankenkettenanregung

Lassen Sie uns die Mechanik hinter CoT-Prompting, seine verschiedenen Arten und die Unterschiede zu Standard-Prompting-Techniken untersuchen.

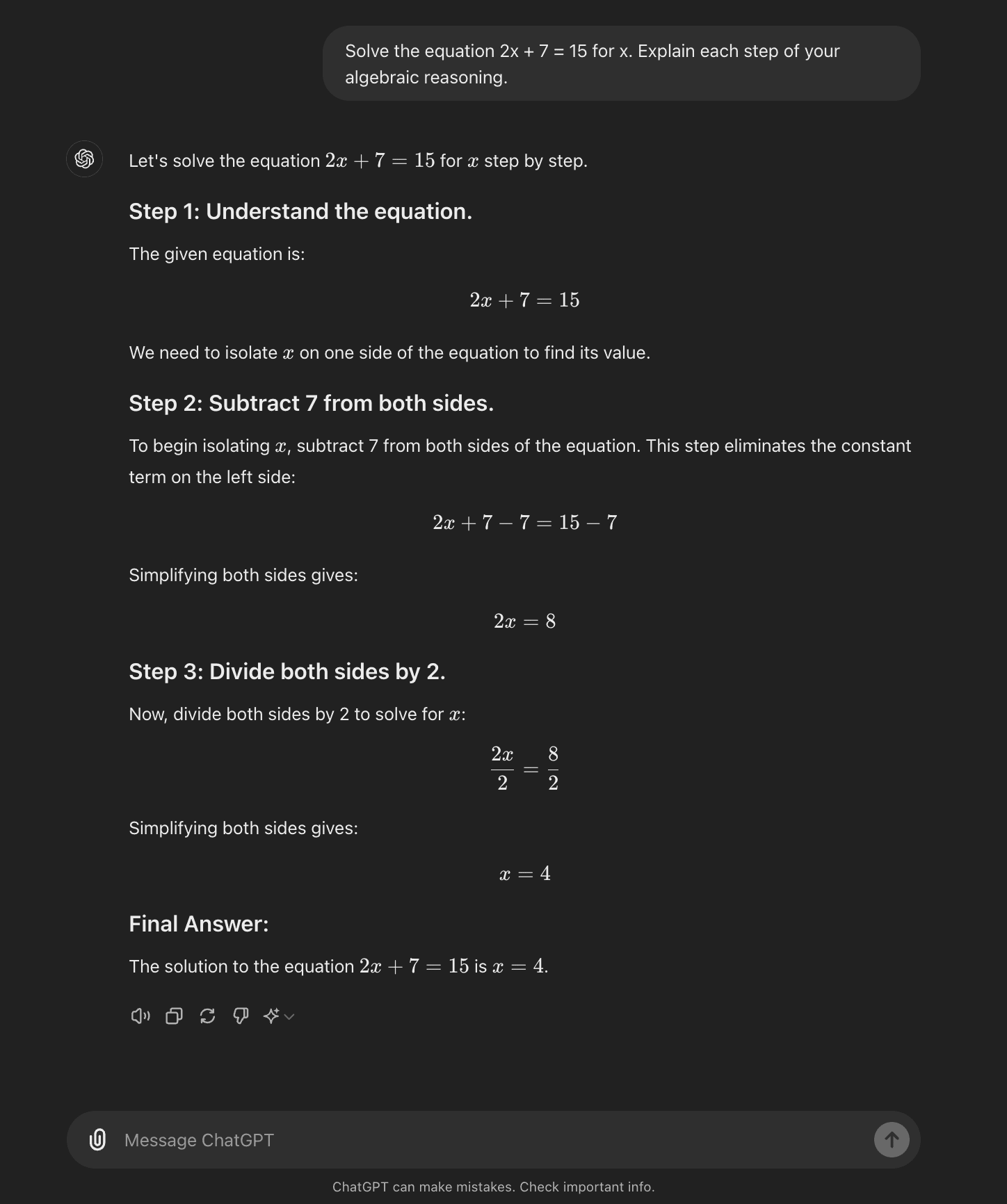

Wie CoT funktioniert

Im Kern führt das CoT-Prompting Sprachmodelle durch eine Reihe von Zwischenschritten, bevor sie zu einer endgültigen Antwort gelangen. Dieser Prozess umfasst in der Regel folgende Schritte:

Problem-Zerlegung: Die komplexe Aufgabe wird in kleinere, überschaubare Schritte aufgeteilt.

Schritt-für-Schritt-Reasoning: Das Modell wird dazu aufgefordert, jeden Schritt explizit zu durchdenken.

Logische Progression: Jeder Schritt baut auf dem vorherigen auf und bildet eine Gedankenkette.

Fazit Zeichnung: Die endgültige Antwort ergibt sich aus den kumulierten Argumentationsschritten.

Indem das Modell dazu angehalten wird, "seine Arbeit zu zeigen", trägt die CoT-Aufforderung dazu bei, Fehler zu vermeiden, die auftreten können, wenn ein Modell versucht, direkt zu einer Schlussfolgerung zu gelangen. Dieser Ansatz ist besonders effektiv bei komplexen Argumentationsaufgaben, die mehrere logische Schritte oder die Anwendung von domänenspezifischem Wissen erfordern.

Arten von CoT Prompting

Das Prompting der Gedankenkette kann auf verschiedene Weise umgesetzt werden, wobei zwei Haupttypen hervorstechen:

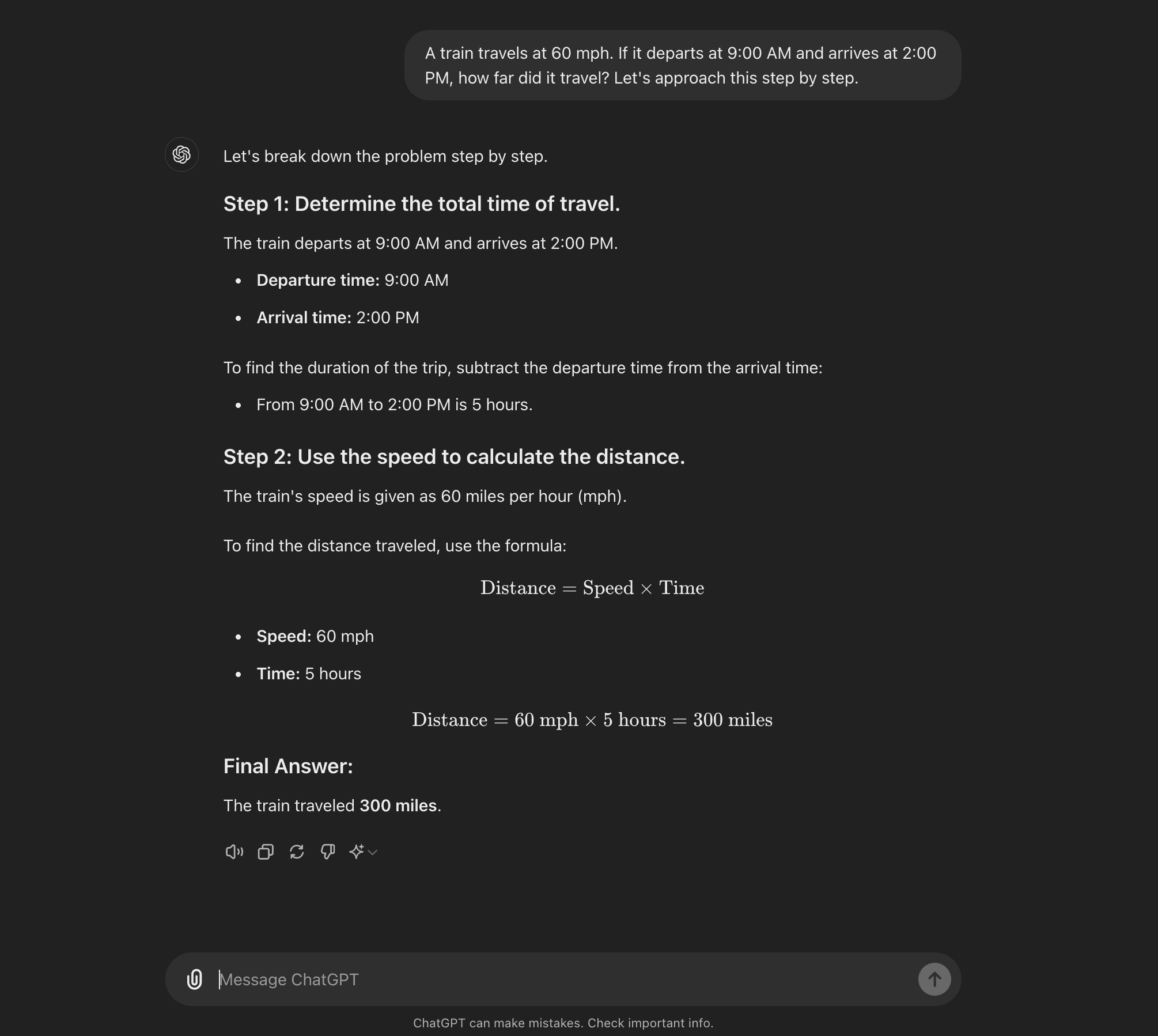

1. Null-Schuss CoT

Zero-Shot CoT ist eine leistungsstarke Variante, die keine aufgabenspezifischen Beispiele erfordert. Stattdessen wird eine einfache Aufforderung wie "Gehen wir das Schritt für Schritt an" verwendet, um das Modell zu ermutigen, seinen Denkprozess aufzuschlüsseln. Diese Technik hat eine bemerkenswerte Effektivität bei der Verbesserung der Modellleistung bei einer Vielzahl von Aufgaben gezeigt, ohne dass ein zusätzliches Training oder eine Feinabstimmung erforderlich ist.

Die wichtigsten Merkmale des Zero-Shot CoT:

Erfordert keine aufgabenspezifischen Beispiele

Nutzt das vorhandene Wissen des Modells

Äußerst vielseitig bei verschiedenen Problemtypen

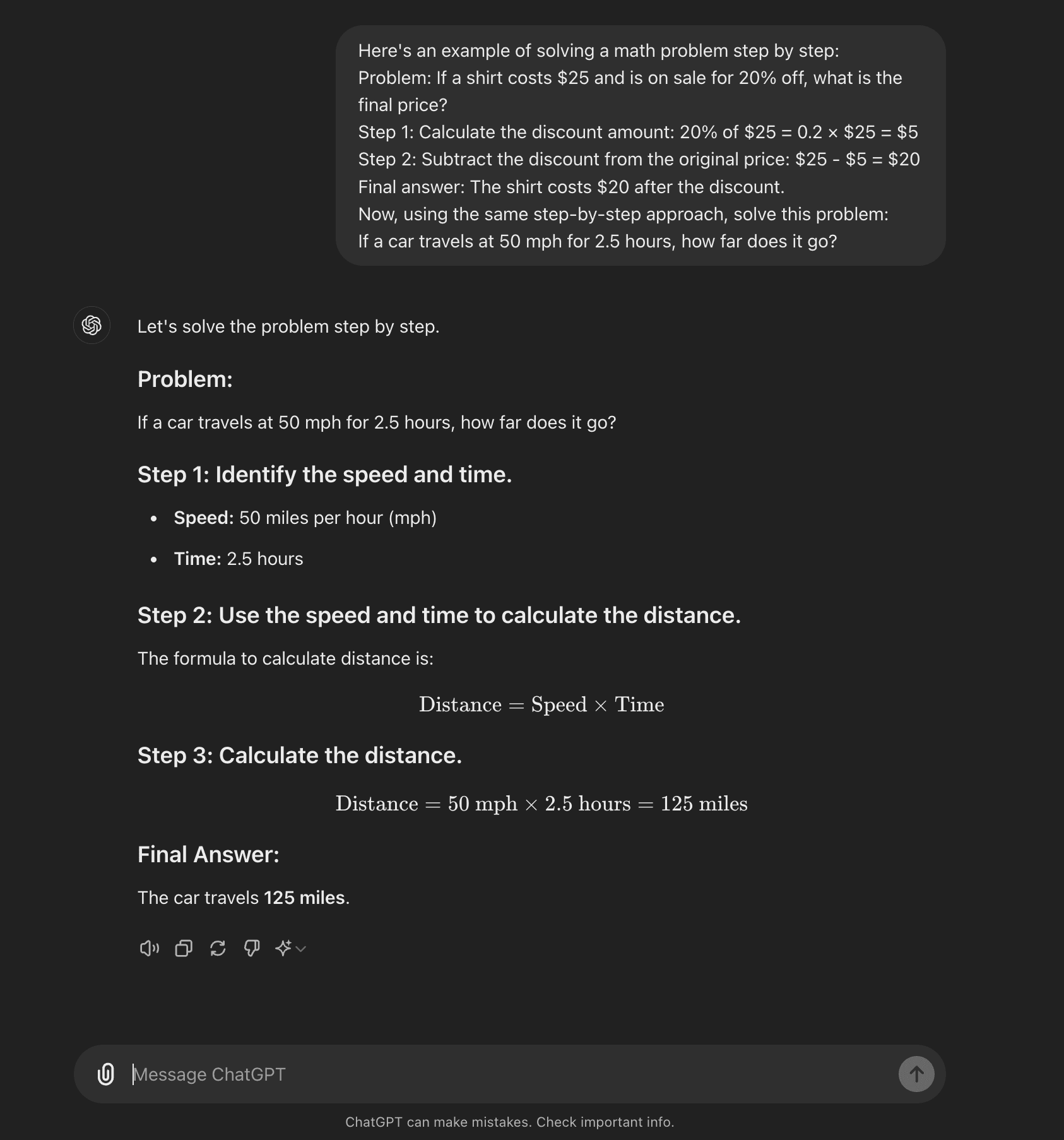

2. Wenige Schüsse CoT

Beim Few-shot CoT wird dem Modell eine kleine Anzahl von Beispielen zur Verfügung gestellt, die den gewünschten Denkprozess veranschaulichen. Diese Beispiele dienen als Vorlage für das Modell, wenn es neue, unbekannte Probleme angeht.

Merkmale von CoT mit wenigen Schüssen:

Bietet 1-5 Beispiele für den Argumentationsprozess

Hilft, das Denkmuster des Modells expliziter zu steuern

Kann auf bestimmte Arten von Problemen oder Bereichen zugeschnitten werden

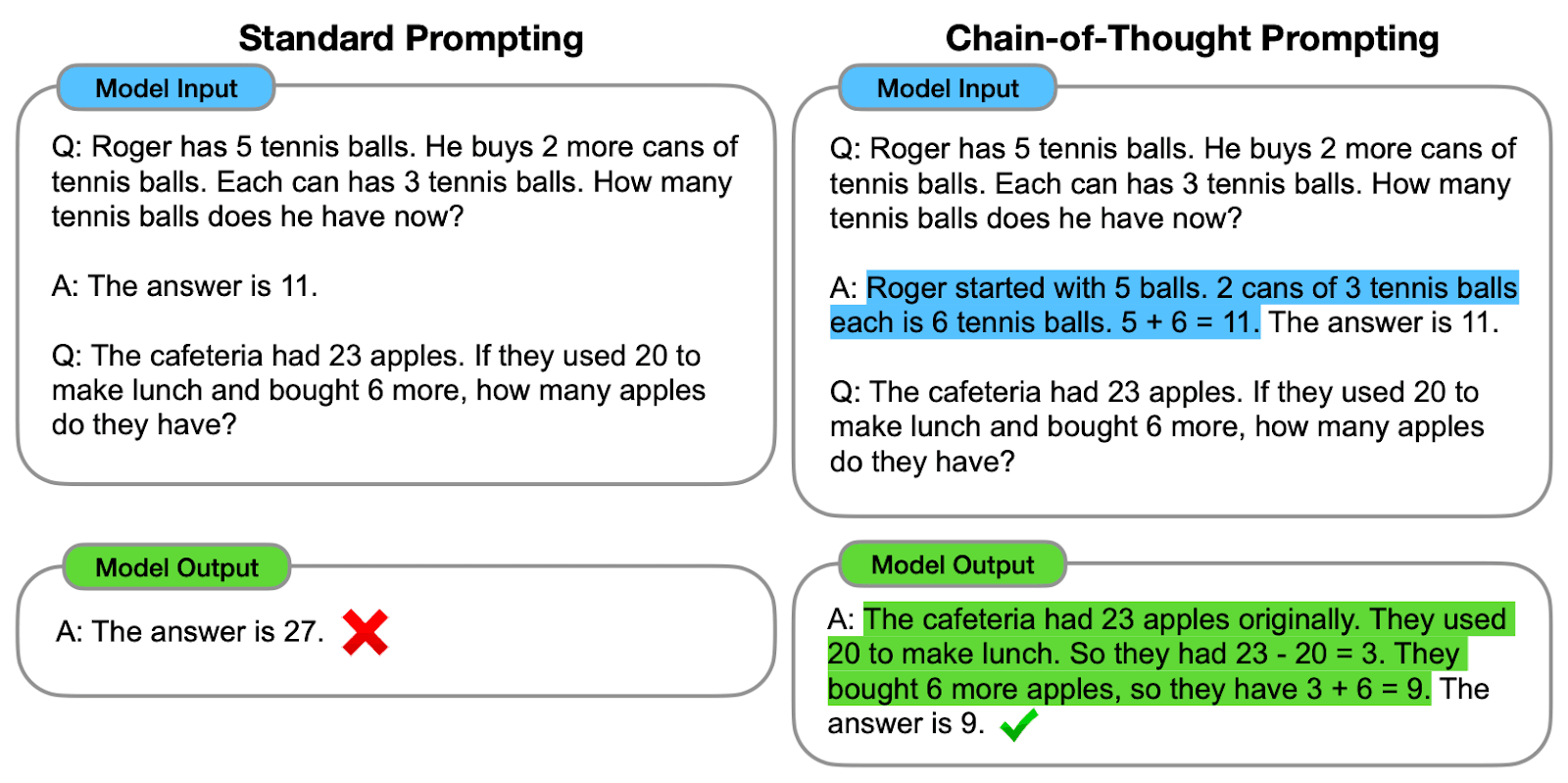

Vergleich mit Standard-Prompting-Techniken

Um den Wert von Chain-of-Thought-Prompting zu erkennen, ist es wichtig zu verstehen, wie es sich von Standard-Prompting-Techniken unterscheidet:

Transparenz in der Argumentation:

Standard-Prompting: Dies führt oft zu direkten Antworten ohne Erklärung.

CoT Prompting: Erzeugt Zwischenschritte, die einen Einblick in den Argumentationsprozess geben.

Handhabung komplexer Probleme:

Standard-Prompting: Hat möglicherweise Schwierigkeiten mit mehrstufigen oder komplexen Denkaufgaben.

CoT Prompting: Hervorragende Fähigkeit, komplexe Probleme systematisch aufzuschlüsseln und zu lösen.

Fehlererkennung:

Standard-Prompting: Fehler in der Argumentation können schwer zu erkennen sein.

CoT Prompting: Bei der schrittweisen Bearbeitung lassen sich Fehler leichter erkennen.

Anpassungsfähigkeit:

Standard-Prompting: Für verschiedene Problemtypen können spezifische Aufforderungen erforderlich sein.

CoT Prompting: Bessere Anpassungsfähigkeit an verschiedene Problembereiche mit minimaler sofortiger Anpassung.

Menschenähnliche Vernunft:

Standard-Prompting: Erzeugt oft maschinenartige, direkte Antworten.

CoT Prompting: Er ahmt menschliche Denkprozesse nach und macht die Ergebnisse nachvollziehbar und verständlich.

Durch die Nutzung von Zwischenschritten bei der Argumentation ermöglicht Chain-of-Thought Prompting Sprachmodellen, komplexe Aufgaben mit größerer Genauigkeit und Transparenz zu bewältigen. Unabhängig davon, ob Zero-Shot- oder Little-Shot-Ansätze verwendet werden, stellt CoT einen bedeutenden Fortschritt in der Prompt-Engineering-Technik dar und verschiebt die Grenzen dessen, was mit großen Sprachmodellen in komplexen Argumentationsszenarien möglich ist.

Anwendungen der Gedankenkettenanregung

CoT-Prompting hat sich als vielseitige Technik erwiesen, die in verschiedenen Bereichen, die komplexes Denken erfordern, Anwendung findet. Sehen wir uns einige Schlüsselbereiche an, in denen sich CoT-Prompting auszeichnet:

Komplexe Aufgaben zum logischen Denken

CoT-Prompting eignet sich hervorragend für Szenarien, die mehrstufige Problemlösungen und logische Schlussfolgerungen erfordern. Einige bemerkenswerte Anwendungen sind:

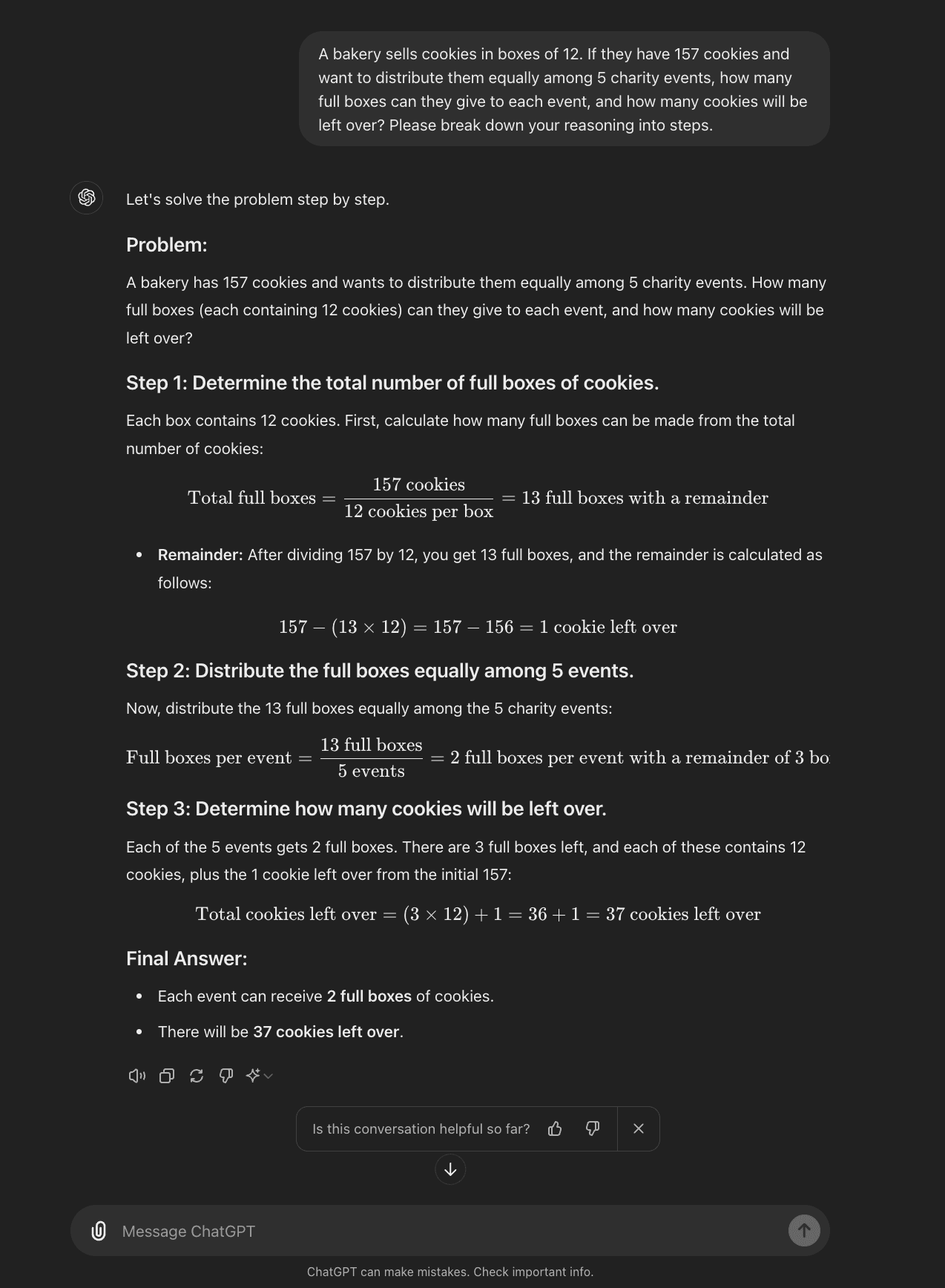

Mathe-Wortaufgaben: CoT führt die Modelle durch die Schritte des Interpretierens des Problems, des Erkennens relevanter Informationen und der Anwendung geeigneter mathematischer Operationen.

Wissenschaftliche Analyse: In Bereichen wie Physik oder Chemie kann die CoT dazu beitragen, dass Modelle komplexe Phänomene in grundlegende Prinzipien und logische Schritte zerlegen.

Strategische Planung: Bei Aufgaben, die mehrere Variablen und langfristige Folgen beinhalten, ermöglicht CoT den Modellen, verschiedene Faktoren systematisch zu berücksichtigen.

Prozess des symbolischen Denkens

Aufgaben zum symbolischen Denken, bei denen es um den Umgang mit abstrakten Symbolen und Konzepten geht, profitieren stark von der CoT-Anleitung:

Algebra und Lösen von Gleichungen: CoT hilft den Modellen bei der Navigation durch die Schritte des Vereinfachens und Lösens von Gleichungen.

Logische Beweise: In der formalen Logik oder bei mathematischen Beweisen führt die CoT das Modell durch jeden Schritt des Arguments.

Erkennung von Mustern: Bei Aufgaben, die komplexe Muster oder Sequenzen beinhalten, ermöglicht CoT den Modellen, die Regeln und Beziehungen zu artikulieren, die sie identifizieren.

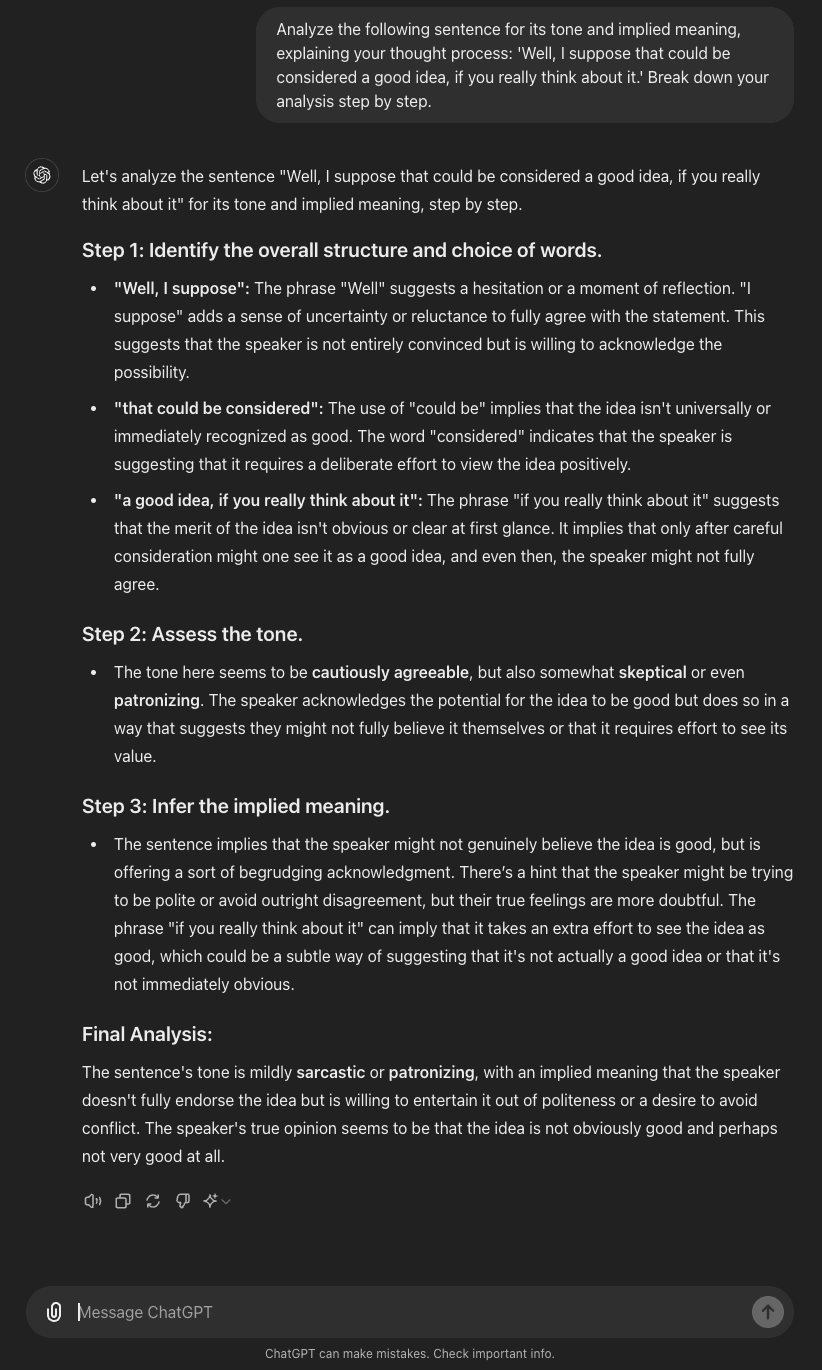

Herausforderungen bei der Verarbeitung natürlicher Sprache

CoT-Prompting hat sich als vielversprechend erwiesen, wenn es darum geht, einige der differenzierteren Herausforderungen bei der Verarbeitung natürlicher Sprache zu bewältigen:

Vernünftige Argumentation: Durch die Zerlegung von Szenarien in logische Schritte hilft CoT den Modellen, Schlussfolgerungen zu ziehen, die auf allgemeinem Wissen über die Welt basieren.

Text-Zusammenfassung: CoT kann Modelle durch den Prozess der Identifizierung von Schlüsselpunkten, der Organisation von Informationen und der Erstellung prägnanter Zusammenfassungen führen.

Übersetzung in eine andere Sprache: Bei komplexen oder idiomatischen Ausdrücken kann CoT den Modellen helfen, die Bedeutung und den Kontext zu durchdenken, bevor sie eine Übersetzung liefern.

Vorteile der Implementierung von CoT Prompting

Die Anwendung von Chain-of-Thought-Prompting bietet mehrere bedeutende Vorteile, die die Fähigkeiten großer Sprachmodelle bei komplexen Schlussfolgerungen verbessern.

Einer der wichtigsten Vorteile ist verbesserte Genauigkeit bei der Problemlösung. Durch die Förderung des schrittweisen Denkens führt die CoT-Aufforderung häufig zu genaueren Ergebnissen, insbesondere bei komplexen Aufgaben. Diese Verbesserung ergibt sich aus der geringeren Fehlerfortpflanzung, da Fehler weniger wahrscheinlich sind, wenn jeder Schritt explizit berücksichtigt wird. Darüber hinaus fördert CoT eine umfassende Problemexploration, indem es das Modell anleitet, alle relevanten Aspekte zu berücksichtigen, bevor es zu einem Ergebnis kommt.

Ein weiterer entscheidender Vorteil ist die verbesserte Interpretierbarkeit von KI-Entscheidungen. CoT Prompting erhöht die Transparenz von KI-Entscheidungsprozessen erheblich, indem es einen sichtbaren Argumentationspfad liefert. Die Nutzer können den Denkprozess des Modells nachvollziehen und erhalten einen Einblick, wie es zu einer bestimmten Schlussfolgerung gekommen ist. Diese Transparenz erleichtert nicht nur die Fehlersuche, wenn Fehler auftreten, sondern fördert auch das Vertrauen der Nutzer und Interessengruppen in KI-Systeme.

CoT-Prompting eignet sich besonders gut für folgende Bereiche mehrstufige Argumentationsprobleme. In Szenarien, die eine Reihe von logischen Schritten erfordern, wie z. B. komplexe Entscheidungsbäume oder sequenzielle Problemlösungsaufgaben, hilft CoT den Modellen, systematisch durch verschiedene Möglichkeiten zu navigieren. Bei Aufgaben, die auf früheren Ergebnissen aufbauen, sorgt CoT dafür, dass jeder Schritt sorgfältig bedacht wird und logisch auf dem letzten aufbaut, was zu kohärenteren und zuverlässigeren Ergebnissen führt.

Beschränkungen und Überlegungen

Obwohl die Gedankenkettenführung zahlreiche Vorteile bietet, ist es wichtig, sich ihrer Grenzen und potenziellen Herausforderungen bewusst zu sein, um sie effektiv einzusetzen.

Eine wichtige Einschränkung ist Modellabhängigkeit. Die Wirksamkeit der CoT-Eingabeaufforderung kann je nach zugrunde liegendem Sprachmodell erheblich variieren. Im Allgemeinen funktioniert CoT am besten mit ausreichend großen Sprachmodellen, die in der Lage sind, komplexe Schlussfolgerungen zu ziehen. Die Daten des Modells vor dem Training können sich auch auf seine Fähigkeit auswirken, in bestimmten Bereichen sinnvolle Gedankenketten zu erzeugen. Das bedeutet, dass der Erfolg von CoT-Prompting eng mit den Fähigkeiten und dem Training des verwendeten Sprachmodells verbunden ist.

Schnelles Engineering stellt eine weitere Herausforderung bei der Umsetzung von CoT dar. Die Erstellung effektiver CoT-Prompts erfordert Geschick und beinhaltet oft Versuch und Irrtum. Die Prompts müssen genügend Anhaltspunkte bieten, ohne übermäßig präskriptiv zu sein, und die Erstellung effektiver Prompts für spezielle Bereiche kann Expertenwissen erfordern. Die Aufrechterhaltung der Kohärenz in der gesamten Gedankenkette kann eine Herausforderung darstellen, insbesondere bei komplexeren Argumentationsaufgaben.

Es ist auch erwähnenswert, dass die CoT-Eingabeaufforderung nicht immer der optimale Ansatz ist. Bei einfachen Aufgaben kann es dazu führen, dass unnötige Komplexität und Rechenaufwand. Es besteht auch die Gefahr, dass ÜbererläuterungDie detaillierte Argumentation kann die einfache Antwort, die der Nutzer sucht, verdecken. Darüber hinaus ist eine kohärente Gedankenkette keine Garantie für eine korrekte Schlussfolgerung, was möglicherweise dazu führt, dass Selbstüberschätzung zu falschen Ergebnissen führen.

Das Fazit zu CoT Prompting

Chain-of-Thought-Prompting stellt einen bedeutenden Fortschritt in der Prompt-Engineering-Technik dar, der die Grenzen dessen, was mit großen Sprachmodellen möglich ist, verschiebt. Durch die Ermöglichung schrittweiser Denkprozesse verbessert CoT die Fähigkeit von KI-Systemen, komplexe Denkaufgaben zu bewältigen, vom symbolischen Denken bis zur Verarbeitung natürlicher Sprache. Sie bietet zwar eine höhere Genauigkeit, eine bessere Interpretierbarkeit und die Fähigkeit, mehrstufige Probleme zu bewältigen, doch müssen auch ihre Grenzen berücksichtigt werden, wie z. B. die Modellabhängigkeit und die Herausforderungen beim Prompt Engineering.

Im Zuge der Weiterentwicklung der KI ist das CoT-Prompting ein leistungsfähiges Werkzeug, um das volle Potenzial von Sprachmodellen auszuschöpfen und die Kluft zwischen maschineller Berechnung und menschenähnlichem Denken zu überbrücken. Seine Auswirkungen auf Bereiche, die komplexe Problemlösungen erfordern, sind entscheidend und ebnen den Weg für anspruchsvollere und transparentere KI-Anwendungen in verschiedenen Bereichen.

Häufig gestellte Fragen (FAQ)

1. Wie verbessert die Gedankenkette die Genauigkeit von Sprachmodellen?

Es ermutigt die Modelle, komplexe Probleme in einzelne Schritte zu zerlegen, wodurch Fehler reduziert und das logische Denken verbessert werden. Dieser schrittweise Ansatz ermöglicht eine bessere Bewältigung von Aufgaben mit vielen Facetten.

2. Kann die Gedankenkettenführung auch für andere Aufgaben als Rechen- und Logikrätsel verwendet werden?

Ja, es ist auf eine Vielzahl von Aufgaben anwendbar, darunter die Verarbeitung natürlicher Sprache, Entscheidungsszenarien und wissenschaftliche Argumentation. Jede Aufgabe, die strukturiertes Denken erfordert, kann von CoT Prompting profitieren.

Was sind die häufigsten Herausforderungen bei der Umsetzung der Gedankenkettenführung?

Zu den wichtigsten Herausforderungen gehören die Ausarbeitung wirksamer Aufforderungen, die Gewährleistung der Kohärenz in der gesamten Argumentationskette und die Bewältigung der gestiegenen Rechenanforderungen. Außerdem müssen die Fähigkeiten und Grenzen des Modells sorgfältig berücksichtigt werden.

Wie unterscheidet sich Auto-CoT von der traditionellen Denkkettensteuerung?

Auto-CoT automatisiert den Prozess der Generierung von Argumentationsschritten und reduziert so den Bedarf an manueller Promptentwicklung. Es verwendet Clustering- und Sampling-Techniken, um verschiedene, aufgabenspezifische Prompts automatisch zu erstellen.

Gibt es bestimmte Sprachmodelle, die bei der Aufforderung zu einer Gedankenkette besser funktionieren?

Im Allgemeinen zeigen größere Sprachmodelle wie GPT-4 und Claude eine bessere Leistung mit CoT-Prompting. Modelle mit umfangreichem Vortraining in verschiedenen Domänen profitieren eher von dieser Technik.