Wie man OpenAI o1 anfordert und ob man es verwenden sollte - AI&YOU #72

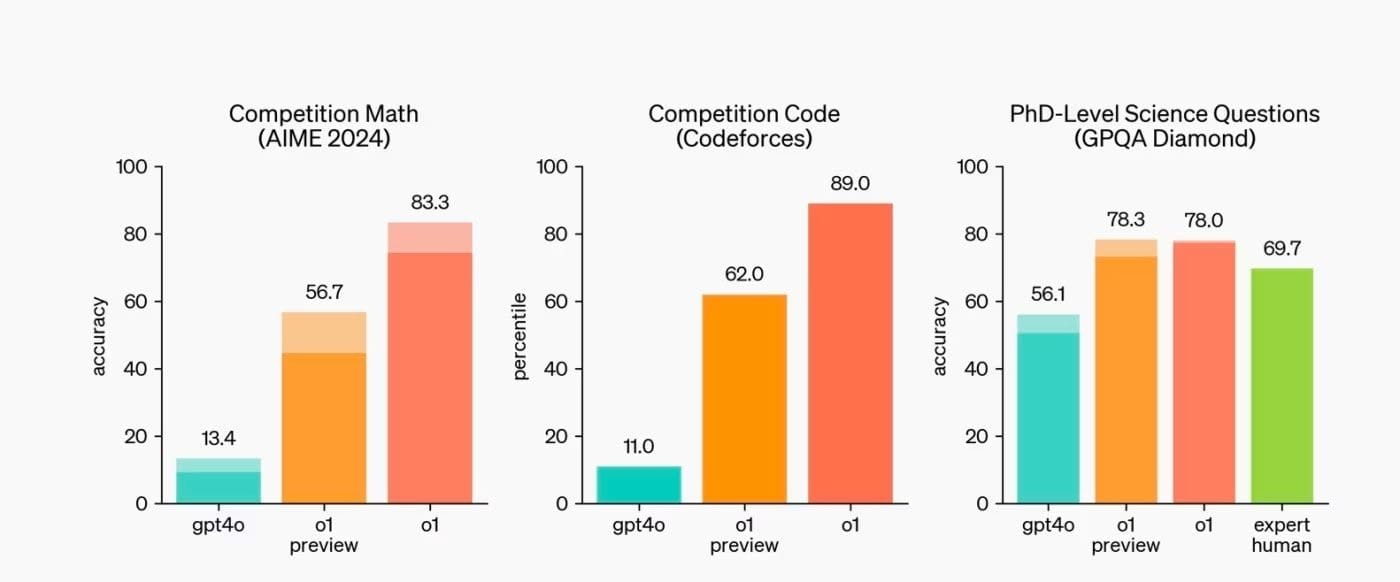

Statistik der Woche: o1 has shown exceptional skill, ranking in the 89th percentile on Codeforces, a renowned platform for coding challenges. (OpenAI)

OpenAI’s new o1 model marks a paradigm shift in how AI processes and responds to complex queries. Unlike its predecessors, o1 is designed to “think” through problems before generating a response, mimicking a more human-like reasoning process. This fundamental change in model architecture necessitates a corresponding evolution in our prompting techniques.

In der diesjährigen Ausgabe von AI&YOU befassen wir uns mit den Erkenntnissen aus drei Blogs, die wir zu diesem Thema veröffentlicht haben:

- How to Prompt OpenAI o1 + Should You Use It? – AI&YOU #72

- Verstehen der Argumentationsfähigkeiten von o1

- Interne Gedankenkette Argumentation

- Performance Leaps in Complex Tasks

- Grundprinzipien für Prompting o1

- Einfachheit und Direktheit der Aufforderungen

- Vermeiden von übermäßiger Beratung

- Verwendung von Begrenzungszeichen für mehr Klarheit

- How to Optimize Input for o1

- Wer sollte das o1-Modell von OpenAI nutzen?

- Ideale Kandidaten für die o1-Adoption

- 15 Stats/Facts to Know About OpenAI’s o1 Model

- Die Quintessenz

- Danke, dass Sie sich die Zeit genommen haben, AI & YOU zu lesen!

How to Prompt OpenAI o1 + Should You Use It? – AI&YOU #72

For AI enterprises and developers accustomed to working with previous models like GPT-4o, adapting to o1’s unique characteristics is crucial. The prompting strategies that yielded optimal results with earlier models may not be as effective—or could even hinder performance—when applied to o1.

Understanding how to effectively prompt this new model is key to unlocking its full potential and leveraging its advanced reasoning capabilities in real-world applications.

Verstehen der Argumentationsfähigkeiten von o1

Während Modelle wie GPT-4o bei der Generierung von menschenähnlichem Text und der Durchführung einer breiten Palette von Sprachaufgaben hervorragende Leistungen erbrachten, hatten sie oft Schwierigkeiten mit komplexen Schlussfolgerungen, insbesondere in Bereichen, die eine logische, schrittweise Problemlösung erfordern. Das Modell o1 wurde jedoch speziell entwickelt, um diese Lücke zu schließen.

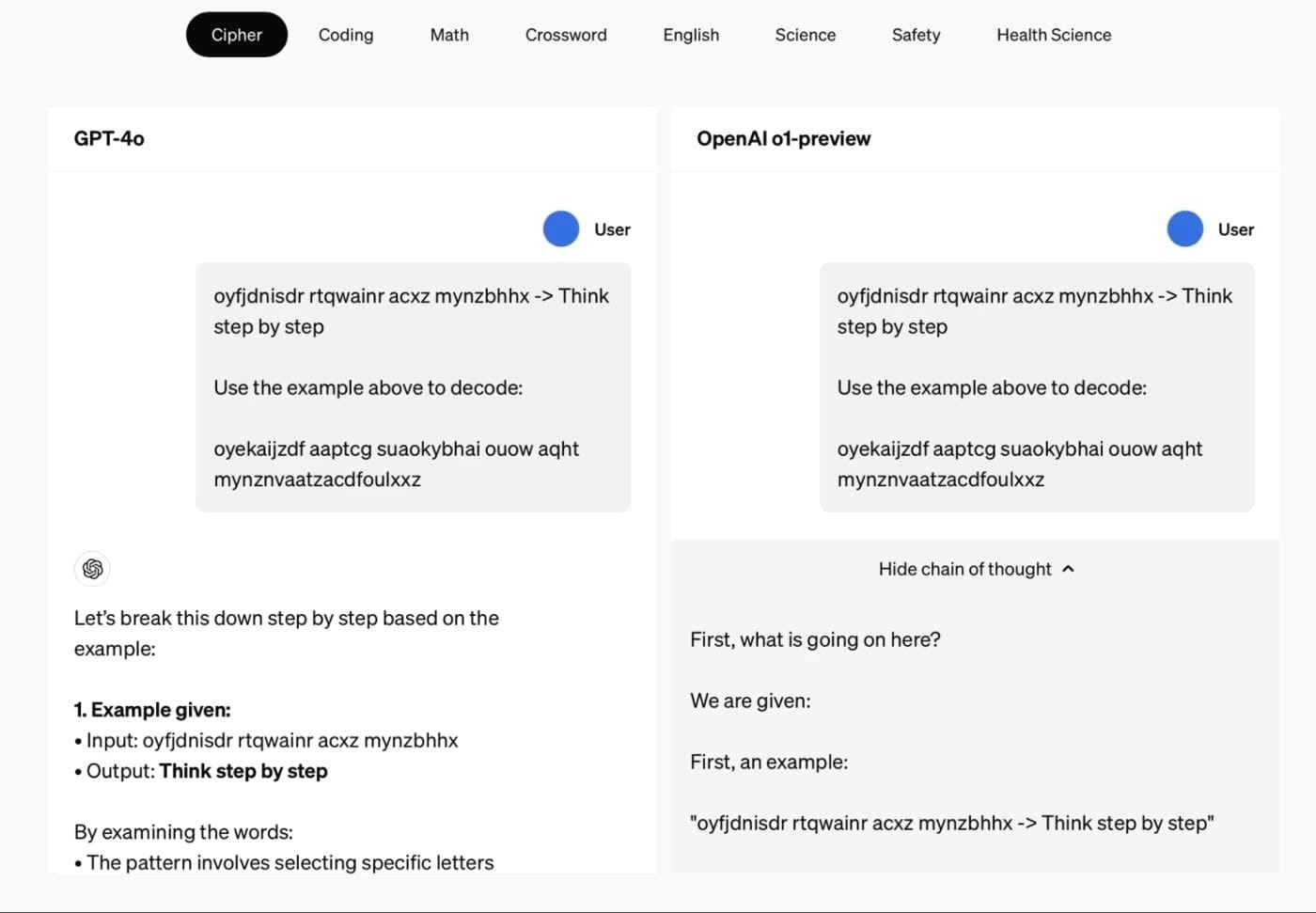

Der entscheidende Unterschied liegt darin, wie o1 Informationen verarbeitet. Im Gegensatz zu früheren Modellen, die Antworten in erster Linie auf der Grundlage der Mustererkennung in ihren Trainingsdaten generieren, verfolgt o1 einen stärker strukturierten Ansatz zur Problemlösung. Dadurch kann es Aufgaben, die mehrstufiges Denken, logische Schlussfolgerungen und sogar kreative Problemlösungen erfordern, mit deutlich höherer Genauigkeit bewältigen.

Interne Gedankenkette Argumentation

Das Herzstück der Fähigkeiten von o1 ist die integrierte Gedankenkette (CoT) Argumentation. Dieser Ansatz, der bisher als externe Prompting-Technik verwendet wurde, ist nun direkt in die Architektur des Modells integriert. Wenn eine komplexe Anfrage gestellt wird, generiert o1 nicht sofort eine Antwort. Stattdessen zerlegt es das Problem zunächst in kleinere, überschaubare Schritte.

Dieser interne Denkprozess ermöglicht es o1,:

Identifizieren Sie die wichtigsten Komponenten des Problems

Logische Verbindungen zwischen verschiedenen Elementen herstellen

Mehrere Ansätze zur Lösung der Aufgabe in Betracht ziehen

seine eigenen Überlegungen zu bewerten und zu korrigieren, während er fortschreitet

Performance Leaps in Complex Tasks

o1’s integration of CoT reasoning has led to remarkable improvements in complex logical tasks:

Mathematisches Lösen von Problemen: Achieves accuracy levels orders of magnitude higher than predecessors on olympiad-level problems.

Coding capabilities: Rivals skilled human programmers in software development and debugging.

Wissenschaftliche Argumentation: Excels in data analysis and hypothesis generation, opening new research frontiers.

Logische Schlussfolgerung in mehreren Schritten: Handles tasks requiring complex step-by-step reasoning with increased proficiency.

By integrating CoT reasoning, o1 has achieved substantial improvements in tasks demanding complex cognition, setting new benchmarks in AI capabilities.

Grundprinzipien für Prompting o1

Wenn wir uns mit der Kunst des Promptens von OpenAIs o1-Modell befassen, ist es wichtig zu verstehen, dass diese neue Generation von Argumentationsmodellen eine Änderung unseres Ansatzes erfordert. Lassen Sie uns die Schlüsselprinzipien erkunden, die Ihnen helfen werden, das volle Potenzial der fortschrittlichen Argumentationsfähigkeiten von o1 zu nutzen.

Einfachheit und Direktheit der Aufforderungen

When it comes to prompting o1, simplicity is key. Unlike previous models that often benefited from detailed instructions or extensive context, o1’s built-in reasoning capabilities allow it to perform best with straightforward prompts.

Im Folgenden finden Sie einige Tipps für die Erstellung einfacher und direkter Aufforderungen:

Seien Sie klar und prägnant: Nennen Sie Ihre Frage oder Aufgabe direkt und ohne unnötige Ausführlichkeit.

Vermeiden Sie übermäßige Erklärungen: Vertrauen Sie auf die Fähigkeit des Modells, Zusammenhänge zu verstehen und Details abzuleiten.

Konzentrieren Sie sich auf das Kernproblem: Stellen Sie die wesentlichen Elemente Ihrer Anfrage ohne überflüssige Informationen dar.

Anstatt eine Schritt-für-Schritt-Anleitung für die Lösung eines komplexen mathematischen Problems zu geben, könnten Sie zum Beispiel einfach sagen: "Ich habe ein Problem: "Lösen Sie die folgende Gleichung und erläutern Sie Ihre Überlegungen: 3x^2 + 7x - 2 = 0."

Vermeiden von übermäßiger Beratung

While previous models often benefited from detailed instructions or examples (a technique known as “few-shot learning”), o1’s improved performance and internal reasoning process make such guidance less necessary and potentially counterproductive.

Bedenken Sie Folgendes:

Widerstehen Sie dem Drang, mehrere Beispiele oder ausführliche Zusammenhänge anzuführen, wenn es nicht unbedingt notwendig ist.

Erlauben Sie dem Modell, seine eigenen Denkfähigkeiten zu nutzen, anstatt zu versuchen, seinen Denkprozess zu steuern.

Vermeiden Sie die explizite Angabe von Schritten oder Methoden zur Lösung eines Problems, da dies die interne Gedankenkette von o1 stören könnte.

Indem Sie auf eine übermäßige Anleitung verzichten, ermöglichen Sie es o1, seine fortschrittlichen Denkmodelle voll zu nutzen und möglicherweise effizientere oder innovative Lösungen für komplexe Denkaufgaben zu finden.

Verwendung von Begrenzungszeichen für mehr Klarheit

Obwohl Einfachheit entscheidend ist, gibt es Fälle, in denen Sie strukturierte Eingaben machen oder verschiedene Komponenten Ihrer Eingabeaufforderung voneinander trennen müssen. In diesen Fällen kann die Verwendung von Trennzeichen die Klarheit erheblich verbessern und o1 helfen, Ihre Eingaben effektiver zu verarbeiten.

Begrenzungszeichen dienen mehreren Zwecken:

Sie trennen die verschiedenen Abschnitte Ihres Prompts deutlich voneinander ab.

Sie helfen dem Modell, zwischen Anweisungen, Kontext und der eigentlichen Anfrage zu unterscheiden.

Sie können verwendet werden, um bestimmte Formate oder Arten von Informationen anzugeben.

Einige effektive Möglichkeiten zur Verwendung von Begrenzungszeichen sind:

Dreifache Anführungszeichen: """Ihr Text hier"""

XML-ähnliche Tags: Ihre Anweisung hier

Bindestriche oder Sternchen: - oder ***

Klar beschriftete Abschnitte: [KONTEXT], [ABFRAGE], [AUSGABEFORMAT]

Wenn Sie zum Beispiel mit Zellsequenzierungsdaten oder anderen wissenschaftlichen Informationen arbeiten, könnten Sie Ihre Eingabeaufforderung wie folgt strukturieren:

—

[CONTEXT]

Im Folgenden wird ein Datensatz aus einem Zellsequenzierungsexperiment gezeigt:

<data>

...Ihre Daten hier...

</data>

[QUERY]

Analysieren Sie diese Daten und ermitteln Sie signifikante Muster oder Anomalien.

[AUSGABEFORMAT]

Erstellen Sie Ihre Analyse in einem strukturierten Bericht mit Abschnitten für Methoden, Ergebnisse und Schlussfolgerungen.

—

Durch den effektiven Einsatz von Begrenzungszeichen können Sie den notwendigen Kontext und die Struktur bereitstellen, ohne die Argumentationsfähigkeit von o1 zu überfordern oder seinen internen Denkprozess zu stören.

How to Optimize Input for o1

Effectively leveraging o1’s advanced reasoning capabilities requires optimized input. Balance context and conciseness by providing essential background without overwhelming the model. Focus on quality over quantity, trusting o1’s ability to infer and reason. For complex tasks, offer a brief overview rather than an exhaustive explanation.

When using Retrieval Augmented Generation (RAG) with o1, be selective with external information. Prioritize high-quality, relevant data over volume, using RAG primarily for specific facts rather than general context. This targeted approach enhances o1’s performance on domain-specific tasks without overwhelming its reasoning process.

Embrace o1’s improved performance by trusting it with more challenging, nuanced prompts. Expect sophisticated responses even from concise inputs, and experiment with complex queries that might have been unsuitable for previous AI models. This adaptation allows you to fully harness o1’s potential for complex reasoning tasks.

Wer sollte das o1-Modell von OpenAI nutzen?

Da sich Unternehmen und Forscher mit immer komplexeren Herausforderungen und dem Aufkommen neuer LLM-Modelle auseinandersetzen, stellt sich die Frage: Sollte ich OpenAI o1 für meine spezifischen Bedürfnisse nutzen?

Ideale Kandidaten für die o1-Adoption

Wenn wir darüber nachdenken, wer das o1-Modell von OpenAI nutzen sollte, stechen mehrere Gruppen hervor, die besonders gut geeignet sind, die fortschrittlichen Fähigkeiten des Modells zu nutzen. Die einzigartigen Stärken des o1-Modells im Bereich des komplexen Denkens und Problemlösens machen es zu einem unschätzbaren Werkzeug für diejenigen, die an der Spitze von Innovation und Entdeckung arbeiten.

1️⃣ Research and Development Teams: R&D teams across industries should adopt o1 for its ability to tackle complex challenges using chain of thought reasoning. This model can accelerate research processes, from drug discovery to experimental design, by efficiently analyzing complex interactions and generating hypotheses. O1’s capacity for detailed, step-by-step reasoning aligns well with R&D’s rigorous approach, making it an invaluable tool for exploring new research directions and solving multi-step problems.

2️⃣ Software Development and Coding: o1’s enhanced abilities in tackling coding tasks, optimizing algorithms, and debugging complex systems make it an invaluable asset for developers. For competitive programmers, o1’s systematic approach to coding challenges mirrors top-tier programmers’ thought processes, serving not just as a tool but as a potential mentor to improve problem-solving skills.

3️⃣ Scientific and Academic Institutions: In scientific research and academia, o1’s advanced reasoning capabilities excel at analyzing vast datasets, formulating hypotheses, and suggesting experimental approaches across fields from astrophysics to genomics. Its ability to provide detailed explanations for complex concepts makes it a powerful aid in both research and education. In theoretical physics and advanced mathematics, o1’s proficiency could lead to new insights on long-standing questions, making it an essential tool for pushing the boundaries of human knowledge.

15 Stats/Facts to Know About OpenAI’s o1 Model

1️⃣ 83% accuracy on International Mathematics Olympiad qualifier

This is a significant improvement over GPT-4o’s 13%, showcasing o1’s advanced mathematical reasoning abilities.

2️⃣ 89th percentile ranking on Codeforces

Demonstrates o1’s exceptional skill in competitive programming and solving complex algorithmic problems.

3️⃣ 74% success rate on AIME problems

A huge leap from GPT-4o’s 9%, highlighting o1’s prowess in tackling difficult, multi-step mathematical challenges.

4️⃣ PhD-level accuracy on GPQA benchmark for physics, biology, and chemistry

Shows o1’s versatility across scientific disciplines, making it valuable for high-level scientific research.

5️⃣ 128,000 token context window

Allows o1 to process and understand much longer pieces of text or more complex problems in a single prompt.

6️⃣ Two variants: o1-preview and o1-mini

Offers flexibility for different use cases, balancing capability and speed.

7️⃣ Uses internal “reasoning tokens” for problem-solving

Enables o1 to break down complex problems into steps, mimicking human-like reasoning.

8️⃣ Improved performance in challenging languages like Yoruba and Swahili

Enhances o1’s utility for multilingual tasks and global applications.

9️⃣ 0.44 score on SimpleQA test for hallucinations

Lower than GPT-4o’s 0.61, indicating reduced likelihood of generating false information.

🔟 94% correct answer selection on unambiguous questions

Improvement over GPT-4o’s 72%, suggesting enhanced fairness and reduced bias in responses.

1️⃣1️⃣ Enhanced jailbreak resistance and content policy adherence

Improves safety and reliability for public-facing or sensitive applications.

1️⃣2️⃣ Slower response times compared to previous models

Trade-off for its more extensive reasoning processes and deeper analysis capabilities.

1️⃣3️⃣ o1-preview pricing: $15 per million input tokens, $60 per million output tokens

Reflects the advanced capabilities and increased computational resources required.

1️⃣4️⃣ Excels in mathematics, coding, and scientific reasoning

Shows particular excellence in STEM fields, making it invaluable for research institutions, tech companies, and educational organizations.

1️⃣5️⃣ o1-mini priced at $3 per million input tokens

Offers a more cost-effective option compared to o1-preview, though likely with some trade-offs in capability.

Die Quintessenz

OpenAI’s o1 model represents a significant leap forward in AI capabilities, particularly in complex reasoning tasks across STEM fields. Its improved performance in areas like mathematics, coding, and scientific analysis, coupled with enhanced safety features and reduced biases, makes it a powerful tool for enterprises tackling sophisticated challenges.

However, the trade-offs in terms of processing speed and higher costs necessitate careful consideration. As AI continues to evolve, o1 stands as a testament to the rapid advancements in the field, offering unprecedented capabilities that could potentially transform how businesses and researchers approach complex problem-solving in the near future.

Danke, dass Sie sich die Zeit genommen haben, AI & YOU zu lesen!

Für noch mehr Inhalte zum Thema KI für Unternehmen, einschließlich Infografiken, Statistiken, Anleitungen, Artikeln und Videos, folgen Sie Skim AI auf LinkedIn

We enable Venture Capital and Private Equity backed companies in the following industries: Medical Technology, News/Content Aggregation, Film & Photo Production, Educational Technology, Legal Technology, Fintech & Cryptocurrency to automate work and scale with AI.