Top 10 Wege zur Beseitigung von LLM-Halluzinationen

Große Sprachmodelle (Large Language Models, LLMs), die weiterhin fast jeden Bereich und jede Branche verändern, bringen eine einzigartige Herausforderung mit sich: Halluzinationen. Diese durch KI erzeugten Ungenauigkeiten stellen ein erhebliches Risiko für die Zuverlässigkeit und Vertrauenswürdigkeit von LLM-Ergebnissen dar.

Was sind LLM-Halluzinationen?

LLM-Halluzinationen treten auf, wenn diese leistungsstarken Sprachmodelle Text erzeugen, der sachlich falsch, unsinnig oder ohne Bezug zu den Eingabedaten ist. Obwohl sie kohärent und sicher erscheinen, können halluzinierte Inhalte zu Fehlinformationen, falschen Entscheidungen und einem Vertrauensverlust in KI-gestützte Anwendungen führen.

Da KI-Systeme zunehmend integrieren in verschiedene Aspekte unseres Lebens, von Chatbots für den Kundenservice bis hin zu Tools zur Erstellung von Inhaltenwird die Notwendigkeit, Halluzinationen abzuschwächen, von größter Bedeutung. Unkontrollierte Halluzinationen können zu Reputationsschäden, rechtlichen Problemen und potenziellen Schäden für Nutzer führen, die sich auf KI-generierte Informationen verlassen.

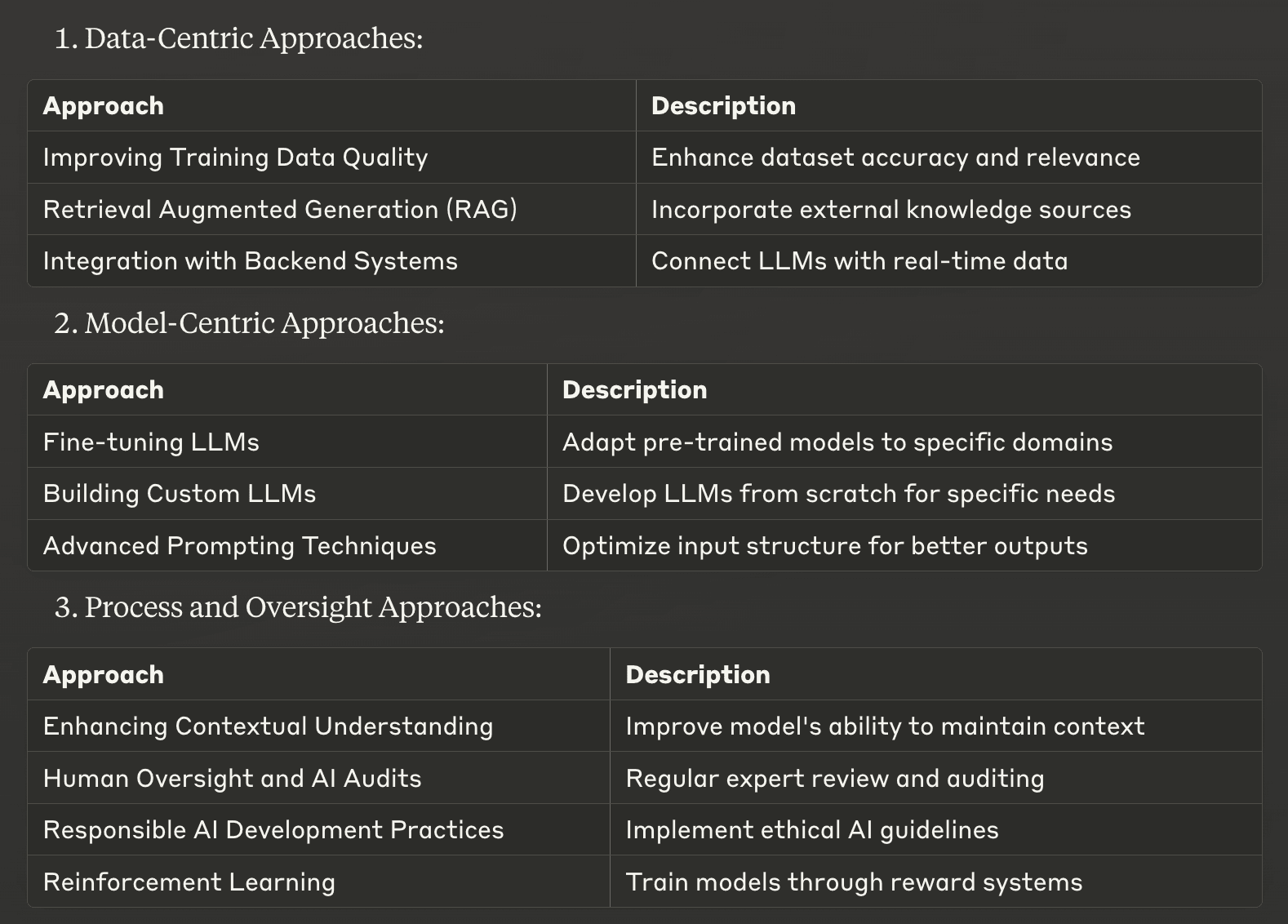

Wir haben eine Liste der 10 besten Strategien zur Abschwächung von LLM-Halluzinationen zusammengestellt, die von datenzentrierten Ansätzen über modellzentrierte Techniken bis hin zu prozessorientierten Methoden reicht. Diese Strategien sollen Unternehmen und Entwicklern helfen, die faktische Genauigkeit und Zuverlässigkeit ihrer KI-Systeme zu verbessern.

Datenzentrierte Ansätze

1. Verbesserung der Qualität der Ausbildungsdaten

Eine der grundlegendsten Möglichkeiten zur Abschwächung von Halluzinationen ist die Verbesserung der Qualität der Trainingsdaten, die zur Entwicklung großer Sprachmodelle verwendet werden. Qualitativ hochwertige, vielfältige und gut kuratierte Datensätze können die Wahrscheinlichkeit, dass LLMs ungenaue Informationen lernen und reproduzieren, erheblich verringern.

Um diese Strategie umzusetzen, sollten Sie sich auf Folgendes konzentrieren:

Sorgfältige Prüfung der Datenquellen auf Genauigkeit und Relevanz

Gewährleistung einer ausgewogenen Vertretung von Themen und Perspektiven

Regelmäßige Aktualisierung der Datensätze zur Aufnahme aktueller Informationen

Entfernen von doppelten oder widersprüchlichen Datenpunkten

Durch die Investition in hochwertige Trainingsdaten legen Sie eine solide Grundlage für zuverlässigere und genauere LLM-Ergebnisse.

2. Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) ist eine leistungsstarke Technik, die die Stärken von abrufbasierten und generationsbasierten Ansätzen kombiniert. Diese Methode ermöglicht es LLMs, während des Texterstellungsprozesses auf relevante Informationen aus externen Wissensquellen zuzugreifen und diese einzubeziehen.

Die RAG arbeitet nach:

Abrufen relevanter Informationen aus einer kuratierten Wissensdatenbank

Einbindung dieser Informationen in den Kontext, der dem LLM zur Verfügung gestellt wird

Erarbeitung von Antworten, die auf sachlichen, aktuellen Informationen beruhen

Durch die Implementierung von RAG können Unternehmen Halluzinationen deutlich reduzieren, indem sie LLM-Antworten auf zuverlässige, externe Informationsquellen verankern. Dieser Ansatz ist besonders effektiv für domänenspezifische Anwendungen, bei denen es auf Genauigkeit ankommt, wie z. B. bei juristischen oder medizinischen KI-Systemen.

3. Integration mit Backend-Systemen

Die Integration von LLMs mit den bestehenden Backend-Systemen eines Unternehmens kann die Genauigkeit und Relevanz von KI-generierten Inhalten erheblich verbessern. Dieser Ansatz ermöglicht es dem LLM, auf kontextspezifische Echtzeitdaten direkt aus den Datenbanken oder APIs des Unternehmens zuzugreifen.

Zu den wichtigsten Vorteilen der Backend-Integration gehören:

Sicherstellen, dass die Antworten auf den aktuellsten Informationen beruhen

Bereitstellung personalisierter und kontextbezogener Ergebnisse

Verringerung der Abhängigkeit von potenziell veralteten Schulungsdaten

Ein E-Commerce-Chatbot, der in das Inventarsystem des Unternehmens integriert ist, kann beispielsweise genaue Echtzeitinformationen über die Produktverfügbarkeit liefern und so das Risiko halluzinierter Antworten über Lagerbestände oder Preise verringern.

Durch die Umsetzung dieser datenzentrierten Ansätze können Unternehmen die Zuverlässigkeit ihrer LLM-Ergebnisse erheblich steigern, das Risiko von Halluzinationen verringern und die Gesamtleistung des KI-Systems verbessern.

Modellzentrierte Ansätze

4. Feinabstimmung der LLMs

Die Feinabstimmung ist eine leistungsstarke Technik zur Anpassung von vortrainierten großen Sprachmodellen an bestimmte Bereiche oder Aufgaben. Dieser Prozess beinhaltet ein weiteres Training des LLM auf einem kleineren, sorgfältig kuratierten Datensatz, der für die Zielanwendung relevant ist. Die Feinabstimmung kann Halluzinationen erheblich reduzieren, indem die Ergebnisse des Modells mit domänenspezifischem Wissen und Terminologie abgeglichen werden.

Zu den wichtigsten Vorteilen der Feinabstimmung gehören:

Verbesserte Genauigkeit in spezialisierten Bereichen

Besseres Verständnis des branchenspezifischen Jargons

Geringere Wahrscheinlichkeit, dass irrelevante oder falsche Informationen generiert werden

Ein juristischer KI-Assistent, der auf einen Korpus von Rechtsdokumenten und Rechtsprechung abgestimmt ist, wird beispielsweise bei der Beantwortung juristischer Fragen seltener halluzinieren, was seine Zuverlässigkeit und Nützlichkeit im juristischen Bereich erhöht.

5. Erstellung benutzerdefinierter LLMs

Für Unternehmen, die über umfangreiche Ressourcen und spezifische Anforderungen verfügen, kann die Erstellung von benutzerdefinierten großen Sprachmodellen von Grund auf eine wirksame Methode sein, um Halluzinationen abzuschwächen. Dieser Ansatz ermöglicht die vollständige Kontrolle über die Trainingsdaten, die Modellarchitektur und den Lernprozess.

Vorteile von benutzerdefinierte LLMs umfassen:

Maßgeschneiderte, auf die Geschäftsanforderungen abgestimmte Wissensbasis

Geringeres Risiko, dass irrelevante oder ungenaue Informationen aufgenommen werden

Bessere Kontrolle über das Verhalten und die Ergebnisse des Modells

Dieser Ansatz erfordert zwar beträchtliche Rechenressourcen und Fachkenntnisse, kann aber zu KI-Systemen führen, die in ihrem vorgesehenen Einsatzbereich sehr genau und zuverlässig sind.

6. Fortgeschrittene Prompting-Techniken

Ausgefeilte Prompting-Techniken können Sprachmodelle dazu bringen, genauere und kohärentere Texte zu generieren, wodurch Halluzinationen effektiv reduziert werden. Diese Methoden helfen, die Eingabe so zu strukturieren, dass das KI-System zuverlässigere Ergebnisse liefert.

Einige wirksame Souffleurtechniken sind:

Gedankenkettenführung: Ermutigt zu schrittweisem Denken

Lernen mit wenigen Schüssen: Liefert Beispiele für die Antworten des Modells

Durch die sorgfältige Ausarbeitung von Prompts können Entwickler die sachliche Genauigkeit und Relevanz von LLM-generierten Inhalten erheblich verbessern und das Auftreten von Halluzinationen minimieren.

Prozess- und Überwachungsansätze

7. Verbessern des kontextuellen Verständnisses

Die Verbesserung der Fähigkeit eines LLM, den Kontext während einer Interaktion beizubehalten, kann Halluzinationen erheblich reduzieren. Dies beinhaltet die Implementierung von Techniken, die dem Modell helfen, relevante Informationen über längere Gespräche oder komplexe Aufgaben zu verfolgen und zu nutzen.

Zu den wichtigsten Strategien gehören:

Auflösung der Kernaussagen: Unterstützung des Modells bei der Identifizierung und Verknüpfung verwandter Entitäten

Verfolgung des Gesprächsverlaufs: Sicherstellung der Berücksichtigung früherer Austausche

Erweiterte Kontextmodellierung: Ermöglichung der Konzentration des Modells auf relevante Informationen

Diese Techniken tragen dazu bei, dass LLMs kohärent und konsistent bleiben, wodurch die Wahrscheinlichkeit, dass widersprüchliche oder irrelevante Informationen erzeugt werden, verringert wird.

8. Menschliche Aufsicht und KI-Audits

Die Einführung menschlicher Aufsicht und die Durchführung regelmäßiger KI-Audits sind entscheidend für die Erkennung und Behebung von Halluzinationen in LLM-Ergebnissen. Dieser Ansatz kombiniert menschliches Fachwissen mit KI-Fähigkeiten, um ein Höchstmaß an Genauigkeit und Zuverlässigkeit zu gewährleisten.

Zu den wirksamen Aufsichtspraktiken gehören:

Regelmäßige Überprüfung von KI-generierten Inhalten durch Fachleute

Implementierung von Feedback-Schleifen zur Verbesserung der Modellleistung

Durchführung gründlicher Prüfungen zur Ermittlung von Halluzinationsmustern

Indem sie die menschliche Beteiligung am KI-Prozess aufrechterhalten, können Unternehmen Halluzinationen erkennen und korrigieren, die andernfalls unbemerkt bleiben würden, und so die allgemeine Vertrauenswürdigkeit ihrer KI-Systeme erhöhen.

9. Verantwortungsvolle AI-Entwicklungspraktiken

Verantwortungsvolle Praktiken bei der Entwicklung von KI sind für die Schaffung von LLMs, die weniger anfällig für Halluzinationen sind, von entscheidender Bedeutung. Dieser Ansatz betont ethische Überlegungen, Transparenz und Verantwortlichkeit während des gesamten Lebenszyklus der KI-Entwicklung.

Zu den wichtigsten Aspekten einer verantwortungsvollen KI-Entwicklung gehören:

Vorrang für faire und unverfälschte Trainingsdaten

Einführung robuster Test- und Validierungsverfahren

Sicherstellung von Transparenz in AI-Entscheidungsprozessen

Durch die Einhaltung dieser Grundsätze können Unternehmen KI-Systeme entwickeln, die zuverlässiger und vertrauenswürdiger sind und weniger wahrscheinlich schädliche oder irreführende Ergebnisse liefern.

10. Verstärkungslernen

Das Verstärkungslernen bietet einen vielversprechenden Ansatz, um Halluzinationen bei LLMs zu mildern. Bei dieser Technik werden Modelle durch ein System von Belohnungen und Bestrafungen trainiert, das erwünschte Verhaltensweisen fördert und unerwünschte unterbindet.

Vorteile des Verstärkungslernens bei der Eindämmung von Halluzinationen:

Abgleich der Modellergebnisse mit spezifischen Genauigkeitszielen

Verbesserung der Fähigkeit des Modells zur Selbstkorrektur

Verbesserung der Gesamtqualität und Zuverlässigkeit des generierten Textes

Durch den Einsatz von Techniken des verstärkten Lernens können Entwickler LLMs erstellen, die besser in der Lage sind, Halluzinationen zu vermeiden und sachlich korrekte Inhalte zu produzieren.

Diese modellzentrierten und prozessorientierten Ansätze bieten leistungsstarke Werkzeuge zur Abschwächung von Halluzinationen in großen Sprachmodellen. Durch die Kombination dieser Strategien mit den zuvor besprochenen datenzentrierten Ansätzen können Unternehmen die Zuverlässigkeit und Genauigkeit ihrer KI-Systeme erheblich verbessern und so den Weg für vertrauenswürdigere und effektivere KI-Anwendungen ebnen.

Umsetzung wirksamer Strategien zur Eindämmung von Halluzinationen

Wir haben die 10 besten Möglichkeiten zur Abschwächung von Halluzinationen in großen Sprachmodellen untersucht und dabei festgestellt, dass die Bewältigung dieser Herausforderung entscheidend für die Entwicklung zuverlässiger KI-Systeme ist. Der Schlüssel zum Erfolg liegt in der durchdachten Umsetzung dieser Strategien, die auf Ihre spezifischen Bedürfnisse und Ressourcen zugeschnitten sind. Bei der Wahl des richtigen Ansatzes sollten Sie Ihre individuellen Anforderungen und die Arten von Halluzinationen berücksichtigen, die bei Ihnen auftreten. Einige Strategien, wie z. B. die Verbesserung der Qualität der Trainingsdaten, lassen sich ohne großen Aufwand umsetzen, während andere, wie z. B. die Erstellung benutzerdefinierter LLMs, erhebliche Investitionen erfordern.

Das Gleichgewicht zwischen Effektivität und Ressourcenbedarf ist entscheidend. Oft bietet eine Kombination von Strategien die optimale Lösung, die es Ihnen ermöglicht, mehrere Ansätze zu nutzen und gleichzeitig Einschränkungen zu bewältigen. So kann beispielsweise die Kombination von RAG mit fortschrittlichen Prompting-Techniken zu erheblichen Verbesserungen führen, ohne dass ein umfangreiches Modelltraining erforderlich ist.

In dem Maße, wie sich die künstliche Intelligenz weiterentwickelt, werden auch die Methoden zur Abschwächung von Halluzinationen immer besser. Indem Sie über die neuesten Entwicklungen informiert bleiben und Ihren Ansatz kontinuierlich verfeinern, können Sie sicherstellen, dass Ihre KI-Systeme in puncto Genauigkeit und Zuverlässigkeit führend bleiben. Denken Sie daran, dass das Ziel nicht nur darin besteht, Text zu generieren, sondern LLM-Ausgaben zu erstellen, denen die Nutzer vertrauen und auf die sie sich verlassen können, um den Weg für effektivere und verantwortungsvollere KI-Anwendungen in verschiedenen Branchen zu ebnen.

Wenn Sie Unterstützung bei der Abschwächung von LLM-Halluzinationen benötigen, zögern Sie nicht, sich an uns von Skim AI zu wenden.