Die 10 besten LLM-Prompting-Techniken zur Maximierung der KI-Leistung

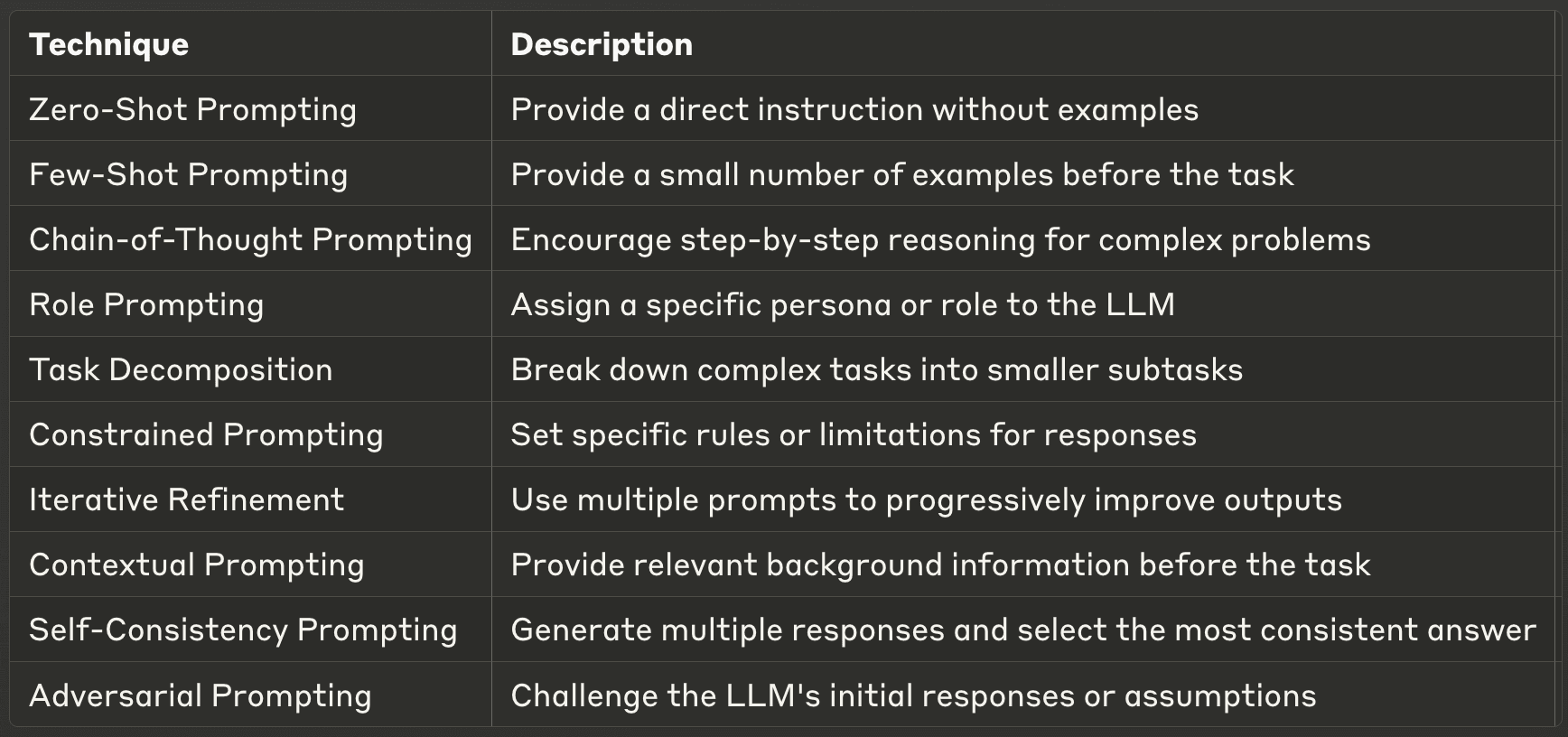

Die Kunst, effektive Prompts für große Sprachmodelle (LLM) zu erstellen, ist zu einer entscheidenden Fähigkeit für KI-Praktiker geworden. Gut konzipierte Prompts können die Leistung eines LLMs erheblich verbessern und genauere, relevantere und kreativere Ergebnisse ermöglichen. In diesem Blogbeitrag werden zehn der leistungsfähigsten Prompting-Techniken vorgestellt und Einblicke in ihre Anwendungen und bewährten Verfahren gegeben. Egal, ob Sie ein erfahrener KI-Entwickler sind oder gerade erst mit LLMs beginnen, diese Techniken werden Ihnen helfen, das volle Potenzial von KI-Modellen zu erschließen.

- 1. Null-Schuss-Aufforderung

- 2. Few-Shot Prompting

- 3. Aufforderung zur Gedankenkette (CoT)

- 4. Rollen-Prompting

- 5. Aufgabenzerlegung

- 6. Eingeschränktes Prompting

- 7. Iterative Verfeinerung

- 8. Kontextabhängiges Prompting

- 9. Aufforderung zur Selbstkorrektur

- 10. Adversariales Prompting

- Die richtigen Techniken für die Prompt-Technik finden

1. Null-Schuss-Aufforderung

Zero-Shot Prompting ist die einfachste Art, mit einem LLM zu interagieren. Bei dieser Technik geben Sie eine direkte Anweisung oder Frage ohne Beispiele und verlassen sich darauf, dass das Modell auf der Grundlage seines vorher trainierten Wissens eine Antwort erzeugt. Diese Methode testet die Fähigkeit des LLM, Aufgaben allein auf der Grundlage der gegebenen Aufforderung zu verstehen und auszuführen, ohne zusätzlichen Kontext oder Beispiele.

Zero-Shot Prompting ist besonders nützlich für einfache, geradlinige Aufgaben oder Abfragen von Allgemeinwissen. Es ist eine hervorragende Möglichkeit, die grundlegenden Fähigkeiten eines LLM zu beurteilen und kann für eine Vielzahl von Anwendungen überraschend effektiv sein. Die Effektivität kann jedoch je nach Komplexität der Aufgabe und je nachdem, wie gut sie mit den Trainingsdaten des Modells übereinstimmt, variieren. Bei der Verwendung von Zero-Shot-Prompting ist es wichtig, dass die Anweisungen klar und spezifisch sind, um die besten Ergebnisse zu erzielen.

Beispiel: Bei der Verwendung von Zero-Shot Prompting könnten Sie das LLM einfach fragen: "Erklären Sie das Konzept der Photosynthese in einfachen Worten." Das Modell würde dann eine Erklärung auf der Grundlage seines bereits vorhandenen Wissens erstellen, ohne dass ein zusätzlicher Kontext oder Beispiele bereitgestellt würden.

2. Few-Shot Prompting

Few-shot prompting geht bei der Interaktion mit LLMs noch einen Schritt weiter, indem es eine kleine Anzahl von Beispielen liefert, bevor es das Modell auffordert, eine Aufgabe auszuführen. Diese Technik hilft dabei, das Ausgabeformat und den Stil des Modells zu lenken, indem sie ihm im Wesentlichen ein Muster vorgibt, dem es folgen soll. Durch die Demonstration der gewünschten Input-Output-Beziehung kann das few-shot prompting die Leistung des Modells bei bestimmten Aufgaben erheblich verbessern.

Diese Methode ist besonders effektiv, wenn Sie konsistente Ausgabeformate benötigen, wenn Sie mit domänenspezifischen Aufgaben zu tun haben oder wenn Zero-Shot-Prompting zu uneinheitlichen Ergebnissen führt. Mit Few-Shot Prompting können Sie das Verhalten des Modells feinabstimmen, ohne dass ein umfangreiches Training oder eine Feinabstimmung erforderlich ist. Dies ist eine leistungsstarke Methode, um das LLM schnell an Ihren spezifischen Anwendungsfall anzupassen. Es ist jedoch wichtig, dass Sie Ihre Beispiele sorgfältig auswählen, da sie die Ergebnisse des Modells stark beeinflussen werden.

Beispiel: Bei einem "few-shot prompting" können Sie dem LLM ein paar Beispiele geben, bevor Sie Ihre Hauptfrage stellen. Zum Beispiel:

F: Was ist die Hauptstadt von Frankreich? A: Die Hauptstadt von Frankreich ist Paris.

F: Was ist die Hauptstadt von Japan? A: Die Hauptstadt von Japan ist Tokio.

F: Was ist die Hauptstadt von Brasilien? A:

Indem Sie diese Beispiele anführen, helfen Sie dem LLM, das Format und die Art der Antwort zu verstehen, die Sie erwarten, und erhöhen so die Wahrscheinlichkeit, eine konsistente und genaue Antwort zu erhalten.

3. Aufforderung zur Gedankenkette (CoT)

Die Gedankenkette ist eine fortschrittlichere Technik, die LLMs dazu anregt, komplexe Probleme in schrittweise Denkprozesse zu zerlegen. Diese Methode ahmt menschliche Problemlösungsansätze nach und ermöglicht es dem Modell, kompliziertere Aufgaben zu bewältigen, die mehrstufige Überlegungen oder Berechnungen erfordern. Indem der CoT das LLM auffordert, seine Arbeit zu zeigen, kann er die Leistung bei komplexen Aufgaben erheblich verbessern und Transparenz in den Entscheidungsprozess des Modells bringen.

Die Vorteile der CoT-Eingabeaufforderung gehen über eine verbesserte Genauigkeit hinaus. Sie verbessert auch die Interpretierbarkeit der Modellergebnisse, so dass es für Menschen einfacher wird, die den Antworten zugrunde liegenden Überlegungen zu verstehen und zu überprüfen. Dies ist besonders wertvoll in Bereichen wie der Bildung, wo das Verständnis des Problemlösungsprozesses ebenso wichtig ist wie die endgültige Antwort. Es ist jedoch zu beachten, dass CoT-Prompting rechenintensiver sein kann und für einfachere Aufgaben nicht immer notwendig ist. Es ist auch wichtig zu beachten, dass CoT Prompting sich als effektiver erwiesen hat, wenn es sehr relevante und spezifische Beispiele liefert.

Beispiel: Wenn Sie die Gedankenkette verwenden, könnten Sie eine Frage wie diese stellen: "Wenn ein Hemd $25 kostet und im Angebot für 20% reduziert ist, wie hoch ist dann der Endpreis? Bitte zeigen Sie Ihre schrittweise Argumentation." Der LLM könnte dann mit einer detaillierten Aufschlüsselung antworten:

"Lassen Sie uns Schritt für Schritt vorgehen:

Der ursprüngliche Preis ist $25.

Ein Rabatt von 20% bedeutet, dass wir 20% von $25 berechnen müssen.

20% von $25 ist $25 × 0,20 = $5.

Der Rabattbetrag beträgt $5.

Um den Endpreis zu erhalten, wird der Rabatt vom ursprünglichen Preis abgezogen.

$25 - $5 = $20. Daher beträgt der Endpreis des Hemdes $20."

Diese Antwort liefert nicht nur die richtige Antwort, sondern zeigt auch den Denkprozess auf, was es einfacher macht, die Lösung zu überprüfen und zu verstehen.

4. Rollen-Prompting

Rollen-Prompting ist eine kreative und leistungsstarke Technik, bei der dem LLM eine bestimmte Persona oder Rolle zugewiesen wird. Diese Methode kann den Ton, den Stil und den Inhalt der Antworten des Modells drastisch verändern und ermöglicht es Ihnen, die Ergebnisse auf bestimmte Bedürfnisse oder Szenarien zuzuschneiden. Indem Sie das LLM anweisen, eine bestimmte Rolle anzunehmen, können Sie auf verschiedene "Persönlichkeiten" oder Fachkenntnisse innerhalb der Wissensbasis des Modells zugreifen.

Diese Technik ist besonders nützlich, wenn Sie Inhalte mit einer bestimmten Stimme oder in einem bestimmten Stil erstellen, Expertenwissen in einem bestimmten Bereich simulieren oder verschiedene Perspektiven zu einem Thema erstellen möchten. Das Rollenspiel kann zu ansprechenderen und kontextgerechten Antworten führen, was es für kreatives Schreiben, Szenarienplanung oder Bildungssimulationen wertvoll macht. Es ist jedoch wichtig, daran zu denken, dass das LLM zwar verschiedene Rollen überzeugend simulieren kann, seine Antworten jedoch immer noch auf seinen Trainingsdaten basieren und nicht ohne Überprüfung als tatsächlicher Expertenrat angesehen werden sollten.

Beispiel: Für die Rollenaufforderung könnten Sie den LLM wie folgt instruieren: "Erklären Sie als erfahrener Klimawissenschaftler die möglichen langfristigen Auswirkungen des steigenden Meeresspiegels auf die Küstenstädte." Diese Aufforderung ermutigt den LLM, sich in die Rolle eines Klimawissenschaftlers zu versetzen, was möglicherweise zu einer fachlich fundierteren und verbindlicheren Antwort auf das Thema führt.

5. Aufgabenzerlegung

Die Aufgabenzerlegung ist ein strategischer Ansatz für die Eingabeaufforderung, bei dem komplexe Aufgaben in kleinere, besser zu bewältigende Teilaufgaben zerlegt werden. Diese Technik nutzt die Fähigkeit des LLM, diskrete Informationen zu verarbeiten und sie zu einem zusammenhängenden Ganzen zu kombinieren. Durch die Zerlegung einer großen Aufgabe können Sie das Modell durch eine Reihe von Schritten leiten und sicherstellen, dass jede Komponente gründlich und genau behandelt wird.

Diese Methode eignet sich besonders gut für die Bewältigung komplexer Probleme, die das Modell überfordern könnten, wenn sie auf einmal gestellt werden. Sie verringert die kognitive Belastung des LLM und ermöglicht eine gezieltere und genauere Beantwortung der einzelnen Teilaufgaben. Die Aufgabenzerlegung ermöglicht auch eine bessere Handhabung von mehrstufigen Problemen und kann die Gesamtqualität und Vollständigkeit des Endergebnisses verbessern. Darüber hinaus kann dieser Ansatz die Identifizierung und Korrektur von Fehlern erleichtern, da Sie jeden Schritt einzeln überprüfen können. Bei der Implementierung der Aufgabenzerlegung ist es wichtig, dass ein klarer logischer Fluss zwischen den Teilaufgaben eingehalten wird, um ein kohärentes Endergebnis zu gewährleisten.

Beispiel: Wenn Sie die Aufgabenzerlegung für eine komplexe Aufgabe verwenden, könnten Sie den LLM wie folgt auffordern: "Um eine umfassende Forschungsarbeit über erneuerbare Energien zu schreiben, sollten wir sie in einzelne Schritte unterteilen. Bitte listen Sie die wichtigsten Schritte auf, die wir befolgen sollten, von der Festlegung des Umfangs bis zur Fertigstellung des Papiers".

Der LLM könnte dann mit einer Aufschlüsselung wie dieser antworten:

"1. den Geltungsbereich des Papiers festlegen (welche Arten von erneuerbaren Energien sollen behandelt werden). 2. Skizzieren Sie die wichtigsten Abschnitte (Einleitung, aktueller Stand, Herausforderungen, Zukunftsaussichten, Schlussfolgerung). 3. Listen Sie für jeden Abschnitt die wichtigsten Punkte auf, die angesprochen werden sollen. 4. Recherchieren und sammeln Sie Daten für jeden Punkt. 5. Verfassen Sie eine Einleitung, die den Kontext und die Ziele der Arbeit darlegt. 6. Entwickeln Sie jeden Abschnitt, indem Sie relevante Daten und Analysen einbeziehen. 7. Fassen Sie die wichtigsten Ergebnisse und zukünftigen Auswirkungen in der Schlussfolgerung zusammen. 8. Überprüfen und verfeinern Sie das gesamte Papier auf Kohärenz und Fluss. 9. Erstellen Sie eine Bibliographie der verwendeten Quellen.

Beginnen wir also mit Schritt 1..."

Diese Aufteilung ermöglicht es Ihnen, die komplexe Aufgabe des Schreibens einer Forschungsarbeit in überschaubaren Abschnitten anzugehen, was die Gesamtqualität und Vollständigkeit des Endprodukts verbessert.

Sicherlich! Lassen Sie uns mit den verbleibenden Abschnitten des Blogbeitrags "10 Best Prompting Techniques for LLMs" fortfahren. Hier sind die Abschnitte 7-10, gefolgt von einem Fazit und praktischen Tipps:

6. Eingeschränktes Prompting

Bei der eingeschränkten Eingabeaufforderung werden bestimmte Regeln oder Einschränkungen festgelegt, die der LLM bei seinen Antworten befolgen soll. Diese Technik ist besonders nützlich, wenn Sie das Ausgabeformat, die Länge oder den Inhalt der Antworten des Modells kontrollieren müssen. Durch die explizite Angabe von Einschränkungen können Sie den LLM dazu bringen, gezieltere und relevantere Ausgaben zu erzeugen.

Die Vorgaben können von einfachen Anweisungen wie der Begrenzung der Wortzahl bis hin zu komplexeren Anforderungen wie der Einhaltung eines bestimmten Schreibstils oder dem Vermeiden bestimmter Themen reichen. Diese Technik ist besonders wertvoll im beruflichen Umfeld, wo Konsistenz und die Einhaltung von Richtlinien entscheidend sind. Es ist jedoch wichtig, ein Gleichgewicht zwischen Einschränkungen und Flexibilität herzustellen, damit der LLM seine Möglichkeiten voll ausschöpfen kann.

Beispiel: "Fassen Sie die neuesten Entwicklungen im Bereich der erneuerbaren Energien in genau 100 Wörtern zusammen. Konzentrieren Sie sich nur auf Solar- und Windenergie und erwähnen Sie keine bestimmten Unternehmen oder Markennamen.

7. Iterative Verfeinerung

Bei der iterativen Verfeinerung handelt es sich um eine Technik, bei der mehrere Aufforderungen zur schrittweisen Verbesserung und Verfeinerung der LLM-Ergebnisse verwendet werden. Dieser Ansatz erkennt an, dass komplexe Aufgaben oft mehrere Runden der Überarbeitung und Verbesserung erfordern. Indem Sie die Aufgabe in mehrere Schritte aufteilen und in jeder Phase Feedback geben, können Sie den LLM zu genaueren und ausgefeilteren Endergebnissen führen.

Diese Methode ist besonders effektiv für Aufgaben wie Schreiben, Problemlösung oder kreative Arbeit, bei denen der erste Entwurf selten perfekt ist. Die iterative Verfeinerung ermöglicht es Ihnen, die Stärken des LLM zu nutzen und gleichzeitig die Kontrolle über die Richtung und Qualität des Ergebnisses zu behalten. Es ist wichtig, dass Sie Ihr Feedback bei jeder Iteration klar und spezifisch formulieren, um eine kontinuierliche Verbesserung zu gewährleisten.

Beispiel: Schritt 1: "Schreiben Sie eine kurze Gliederung für einen Artikel über die Auswirkungen der künstlichen Intelligenz auf das Gesundheitswesen." Schritt 2: "Erweitern Sie auf der Grundlage dieser Gliederung den Abschnitt über KI in der medizinischen Diagnose." Schritt 3: "Ergänzen Sie nun diesen Abschnitt um konkrete Beispiele für KI-Anwendungen in der Radiologie."

8. Kontextabhängiges Prompting

Bei der kontextuellen Eingabeaufforderung werden dem LLM relevante Hintergrundinformationen oder ein Kontext zur Verfügung gestellt, bevor es aufgefordert wird, eine Aufgabe zu erfüllen. Diese Technik hilft dem Modell, das Gesamtbild zu verstehen und genauere und relevantere Antworten zu geben. Indem Sie die Voraussetzungen für einen angemessenen Kontext schaffen, können Sie die Qualität und Spezifität der Ergebnisse des LLM erheblich verbessern.

Diese Methode ist besonders nützlich, wenn es sich um spezielle Themen oder einzigartige Szenarien handelt, oder wenn Sie von den LLM verlangen, dass sie spezifische Informationen berücksichtigen, die nicht zu ihrem allgemeinen Wissen gehören. Das kontextuelle Prompting kann helfen, die Lücke zwischen dem breiten Wissen des LLM und den spezifischen Anforderungen Ihrer Aufgabe zu schließen.

Beispiel: "Der Kontext: Die Stadt Amsterdam hat verschiedene grüne Initiativen umgesetzt, um nachhaltiger zu werden. Nennen Sie auf der Grundlage dieser Informationen drei innovative städtebauliche Ideen, die Amsterdams Nachhaltigkeitsbemühungen weiter verbessern könnten."

9. Aufforderung zur Selbstkorrektur

Self-consistency prompting" ist eine fortgeschrittene Technik, bei der mehrere Antworten auf dieselbe Aufforderung generiert werden und dann die konsistenteste oder zuverlässigste Antwort ausgewählt wird. Diese Methode nutzt die probabilistische Natur von LLMs, um die Genauigkeit zu verbessern, insbesondere bei Aufgaben, die logisches Denken oder Problemlösen erfordern.

Durch den Vergleich mehrerer Ausgaben kann die Selbstkonsistenzabfrage dazu beitragen, Unstimmigkeiten oder Fehler, die bei einzelnen Antworten auftreten könnten, zu erkennen und herauszufiltern. Diese Technik ist besonders wertvoll für kritische Anwendungen, bei denen es auf Genauigkeit ankommt. Allerdings erfordert sie im Vergleich zu Einzelantwortmethoden mehr Rechenressourcen und Zeit.

Beispiel: "Lösen Sie die folgende Rechenaufgabe: Wenn ein Zug 2,5 Stunden lang mit 60 km/h fährt, wie weit kommt er dann? Erstelle fünf unabhängige Lösungen und wähle dann die stimmigste Antwort."

10. Adversariales Prompting

Adversarial Prompting ist eine Technik, bei der die ursprünglichen Antworten oder Annahmen des LLM in Frage gestellt werden, um die Qualität, Genauigkeit und Robustheit seiner Ergebnisse zu verbessern. Diese Methode simuliert eine Debatte oder einen Prozess des kritischen Denkens, indem sie das Modell dazu anregt, alternative Standpunkte, mögliche Fehler in seiner Argumentation oder übersehene Faktoren zu berücksichtigen.

Beim kontradiktorischen Ansatz wird das LLM zunächst aufgefordert, eine erste Antwort oder Lösung zu liefern, und dann aufgefordert, seine eigene Antwort zu kritisieren oder zu hinterfragen. Dieser Prozess kann mehrere Male wiederholt werden, wobei jede Iteration das endgültige Ergebnis verfeinert und stärkt. Adversariales Prompting ist besonders nützlich für komplexe Problemlösungen, Entscheidungsszenarien oder bei der Behandlung von kontroversen oder vielschichtigen Themen.

Diese Technik trägt dazu bei, mögliche Verzerrungen in den Antworten des Modells abzuschwächen und fördert gründlichere und ausgewogenere Ergebnisse. Sie erfordert jedoch eine sorgfältige Formulierung der kontradiktorischen Aufforderungen, um eine produktive Kritik statt eines einfachen Widerspruchs zu gewährleisten.

Beispiel: Schritt 1: "Schlagen Sie eine Lösung vor, um die Verkehrsüberlastung in den Städten zu verringern." Schritt 2: "Nennen Sie nun drei mögliche Nachteile oder Herausforderungen für die Lösung, die Sie gerade vorgeschlagen haben." Schritt 3: "Verfeinern Sie unter Berücksichtigung dieser Herausforderungen Ihre ursprüngliche Lösung oder schlagen Sie einen alternativen Ansatz vor." Schritt 4: "Vergleichen Sie abschließend die Stärken und Schwächen Ihrer ursprünglichen und Ihrer verfeinerten Lösung und empfehlen Sie die beste Vorgehensweise."

Die richtigen Techniken für die Prompt-Technik finden

Die Beherrschung dieser Souffleurtechniken kann Ihre Fähigkeit, effektiv mit LLMs zu arbeiten, erheblich verbessern. Jede Methode bietet einzigartige Vorteile und ist für verschiedene Arten von Aufgaben und Szenarien geeignet. Durch das Verständnis und die Anwendung dieser Techniken können KI-Praktiker das volle Potenzial von LLMs freisetzen, was zu genaueren, kreativeren und nützlicheren Ergebnissen führt.

In dem Maße, wie sich der Bereich der künstlichen Intelligenz weiterentwickelt, werden sich auch die Souffleurstrategien weiterentwickeln. Für jeden, der mit LLMs arbeitet, ist es entscheidend, über neue Entwicklungen informiert zu bleiben und kontinuierlich mit verschiedenen Techniken zu experimentieren. Denken Sie daran, dass es bei der Kunst des Promptens genauso wichtig ist, die Fähigkeiten und Grenzen des Modells zu verstehen, wie die perfekte Eingabe zu gestalten.