10 Best Practices für die Verwaltung nutzergenerierter Inhalte mit der API von OpenAI

Die Verwaltung nutzergenerierter Inhalte ist entscheidend für die Einhaltung der OpenAI-Richtlinien. Das Zulassen von ungeprüften Inhalten kann zu schwerwiegenden Folgen führen, wie z. B. API-Sperren, die den Betrieb erheblich stören können. In diesem Blog stellen wir zehn Best Practices vor, die Unternehmen dabei helfen können, nutzergenerierte Inhalte effektiv zu verwalten und dabei die Einhaltung von Richtlinien und Sicherheit zu gewährleisten.

- 1. Nutzen Sie den Moderationsendpunkt

- 2. Eindeutige Benutzerkennungen einführen

- 3. Nutzer über Inhaltsrichtlinien aufklären

- 4. Benutzeraktivitäten überwachen und protokollieren

- 5. Ratenbegrenzung und Drosselung

- 6. Fehlerbehandlung und Rückmeldung

- 7. Regelmäßige Überprüfung und Aktualisierung der Politiken

- 8. Automatisierte Filterwerkzeuge verwenden

- 9. Test der Wirksamkeit der Moderation

- 10. Mit OpenAI-Support in Kontakt treten

- Die Quintessenz

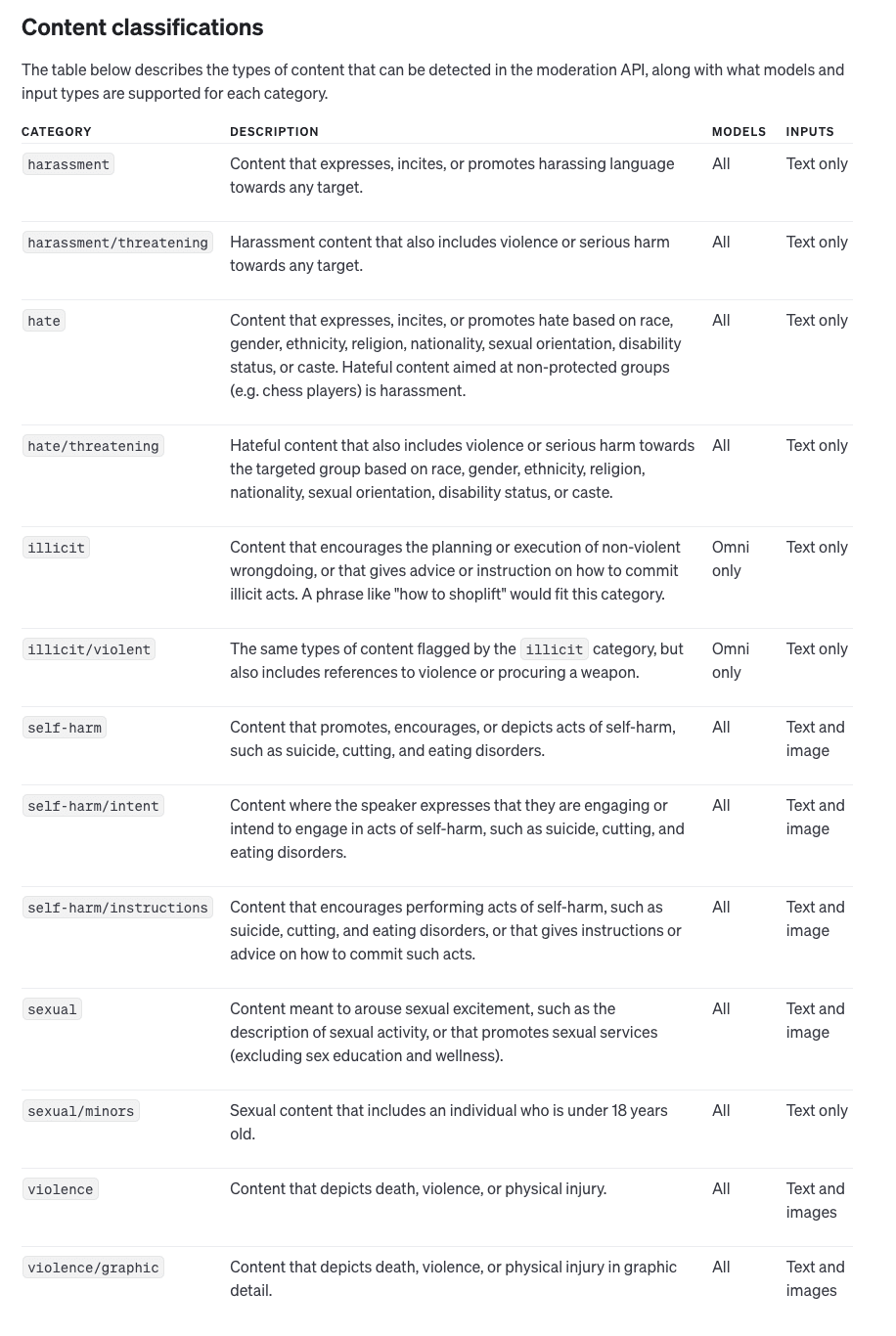

1. Nutzen Sie den Moderationsendpunkt

Der Moderationsendpunkt von OpenAI ist ein leistungsfähiges Werkzeug, das dabei hilft, potenziell schädliche Inhalte zu erkennen und zu filtern, bevor sie die API erreichen. Der Endpunkt kann Text- und Bildeingaben analysieren und Kategorien wie Hassreden und Gewalt identifizieren. Die Integration dieses Tools ist einfach und beinhaltet die Überprüfung jeder Nutzereingabe mit dem Mäßigungsendpunkt, bevor sie an die Haupt-API gesendet wird, wodurch das Risiko von Verstößen effektiv minimiert wird.

Durch die proaktive Nutzung des Moderationsendpunkts können Unternehmen sicherstellen, dass sie schädliche Inhalte so früh wie möglich herausfiltern. Dies hilft nicht nur bei der Einhaltung der OpenAI-Richtlinien, sondern sorgt auch für ein positives Nutzererlebnis, indem es die Einreichung unangemessener Inhalte verhindert. Die Nutzung dieses Endpunkts ermöglicht es Unternehmen, Risiken frühzeitig zu minimieren und die Wahrscheinlichkeit zu verringern, dass sie von OpenAI Verwarnungen oder Verbote erhalten.

2. Eindeutige Benutzerkennungen einführen

Einschließlich eines eindeutigen Benutzerkennzeichens (user_id) in jedem API-Aufruf ist entscheidend für die Verfolgung einzelner Benutzer. Auf diese Weise kann OpenAI feststellen, welcher Benutzer für Richtlinienverstöße verantwortlich sein könnte, wodurch Ihre Anwendung als Ganzes davor geschützt wird, aufgrund der Aktionen eines einzelnen Benutzers bestraft zu werden. Die Benutzerverfolgung bietet auch einen klaren Prüfpfad, der es einfacher macht, die Verantwortlichkeit durchzusetzen und die Einhaltung der Richtlinien zu gewährleisten.

Eindeutige Benutzerkennungen können Ihnen auch dabei helfen, detailliertere Moderationskontrollen durchzuführen. Wenn beispielsweise ein bestimmter Benutzer ständig versucht, schädliche Inhalte zu übermitteln, können Sie Maßnahmen ergreifen, um den Zugang dieses Benutzers zu sperren oder einzuschränken, ohne dass andere davon betroffen sind. Auf diese Weise können Sie sicherstellen, dass die Aktionen eines einzelnen Benutzers nicht die Verfügbarkeit und den Ruf Ihrer gesamten Anwendung gefährden.

3. Nutzer über Inhaltsrichtlinien aufklären

Um die Wahrscheinlichkeit von Verstößen zu verringern, sollten Sie Ihre Nutzer über akzeptable Inhalte aufklären. Kommunizieren Sie klar und deutlich, welche Arten von Inhalten nicht erlaubt sind, wie z. B. Hassreden oder Gewaltdarstellungen. Detaillierte Inhaltsrichtlinien können Nutzer davon abhalten, schädliches Material einzureichen, Ihren API-Zugang zu schützen und die Notwendigkeit von Moderationsmaßnahmen zu verringern.

Zusätzlich zur Veröffentlichung von Inhaltsrichtlinien sollten Sie in Erwägung ziehen, aufklärende Hinweise und Erinnerungen in Ihre Benutzeroberfläche einzubauen. Indem Sie die Nutzer aktiv anleiten, welche Arten von Inhalten angemessen sind, können Sie unbeabsichtigte Verstöße reduzieren. Dieser proaktive Ansatz hilft nicht nur bei der Einhaltung der Richtlinien, sondern fördert auch eine Kultur der verantwortungsvollen Inhaltserstellung unter Ihren Nutzern.

4. Benutzeraktivitäten überwachen und protokollieren

Die detaillierte Protokollierung von Nutzerinteraktionen ist ein wesentlicher Bestandteil der Verwaltung nutzergenerierter Inhalte. Durch die Überwachung der Nutzeraktivitäten können Unternehmen Missbrauchsmuster schnell erkennen und Probleme angehen, bevor sie eskalieren. Die Protokolle können wichtige Anhaltspunkte für die Behandlung des Nutzerverhaltens liefern und im Laufe der Zeit zur Verbesserung der Moderationsstrategien genutzt werden.

Die Führung umfassender Protokolle ermöglicht auch eine bessere Kontrolle und Rechenschaftspflicht. Wenn es zu einem Verstoß kommt, können Sie anhand eines gut dokumentierten Verlaufs zurückverfolgen, wo genau etwas schief gelaufen ist. So können Sie Ihren Moderationsansatz verfeinern und wirksamere Regeln und Filter erstellen, um ähnliche Probleme in Zukunft zu vermeiden.

5. Ratenbegrenzung und Drosselung

Implementieren Sie Ratenbegrenzungen, um übermäßige Anfragen von einzelnen Nutzern zu kontrollieren. Die Drosselung stellt sicher, dass kein einzelner Nutzer das System überlasten oder wiederholt problematische Inhalte übermitteln kann. Dies schützt nicht nur Ihre API vor Missbrauch, sondern trägt auch zur Systemstabilität und zum gleichberechtigten Zugang für alle Nutzer bei.

Die Ratenbegrenzung kann auch als Frühwarnmechanismus zur Erkennung von potenziellem Missbrauch dienen. Wenn beispielsweise ein Benutzer plötzlich anfängt, Anfragen mit einer ungewöhnlich hohen Rate zu übermitteln, kann dies entweder auf böswilliges Verhalten oder auf eine Automatisierung hinweisen, die versucht, Ihre API auszunutzen. Durch frühzeitiges Erkennen dieser Muster können Sie potenzielle Bedrohungen entschärfen, bevor sie zu größeren Verstößen führen.

6. Fehlerbehandlung und Rückmeldung

Ein robustes System zur Fehlerbehandlung ist entscheidend für die Verbesserung der Benutzerfreundlichkeit bei gleichzeitiger Durchsetzung der Compliance. Wenn eine Anfrage aufgrund von Moderation abgelehnt wird, geben Sie den Nutzern ein klares und informatives Feedback, warum ihr Beitrag abgelehnt wurde. Auf diese Weise können die Benutzer dazu angehalten werden, in Zukunft konforme Inhalte einzureichen, was letztlich die Häufigkeit von Verstößen verringert.

Wirksame Fehlermeldungen sollten nicht nur angeben, was falsch gelaufen ist, sondern auch konstruktive Vorschläge zur Korrektur der Eingabe machen. Wenn ein Benutzer beispielsweise Inhalte einreicht, die als unangemessener Sprachgebrauch gekennzeichnet sind, sollte die Rückmeldung dies erklären und den Benutzer ermutigen, seinen Text umzuformulieren. Dieser pädagogische Ansatz hilft den Nutzern, die Anforderungen der Moderation zu verstehen und fördert eine positivere Interaktion mit Ihrer Anwendung.

7. Regelmäßige Überprüfung und Aktualisierung der Politiken

Die Inhaltspolitik von OpenAI können sich im Laufe der Zeit ändern, und es ist wichtig, dass Sie über diese Aktualisierungen informiert bleiben. Überprüfen und aktualisieren Sie regelmäßig Ihre internen Richtlinien und Moderationsstrategien, um sie an neue Richtlinien anzupassen. Wenn Sie auf dem neuesten Stand bleiben, können Sie die Einhaltung der Richtlinien gewährleisten und unerwartete Strafen vermeiden.

Interne Richtlinien sollten auch in Reaktion auf Vorfälle überprüft werden. Wenn Sie feststellen, dass bestimmte Arten von schädlichen Inhalten durchschlüpfen, passen Sie Ihre Regeln und Verfahren an, um diese Lücken zu schließen. Regelmäßige Überprüfungen der Richtlinien stellen sicher, dass Sie immer im Einklang mit den neuesten Erwartungen der OpenAI arbeiten und somit das Risiko von Verstößen minimieren.

8. Automatisierte Filterwerkzeuge verwenden

Ziehen Sie in Erwägung, zusätzlich zum OpenAI-Moderationsendpunkt automatisierte Filterwerkzeuge hinzuzufügen, die Benutzereingaben anhand vordefinierter Kriterien vorprüfen können. Diese zusätzliche Filterebene kann dazu beitragen, die Menge an potenziell schädlichen Inhalten zu reduzieren, die die Moderationsphase erreichen, und macht den Moderationsprozess effizienter und effektiver.

Automatisierte Filterwerkzeuge können an die spezifischen Anforderungen Ihrer Anwendung angepasst werden. So können Sie beispielsweise Filter entwickeln, die auf Ihre Nutzerbasis zugeschnitten sind und sich auf bestimmte Inhaltskategorien konzentrieren, die mit größerer Wahrscheinlichkeit problematisch sind. Diese automatisierten Systeme fungieren als erste Verteidigungslinie und überlassen es menschlichen Moderatoren oder dem OpenAI-Moderationsendpunkt, differenziertere Fälle zu behandeln.

9. Test der Wirksamkeit der Moderation

Testen Sie regelmäßig die Effektivität Ihrer Moderationsprozesse, indem Sie falsch-positive und -negative Ergebnisse analysieren. Passen Sie Ihre Filterkriterien und Moderationsalgorithmen auf der Grundlage dieser Erkenntnisse an, um die Genauigkeit zu verbessern und sicherzustellen, dass konforme Inhalte nicht fälschlicherweise gekennzeichnet werden, während schädliche Inhalte effektiv gefiltert werden.

Zum Testen der Wirksamkeit der Moderation kann auch das Einholen von Nutzerfeedback gehören. Nutzer, die der Meinung sind, dass ihre Inhalte zu Unrecht gekennzeichnet wurden, können Hinweise auf mögliche Verbesserungen Ihrer Moderationskriterien geben. Diese kontinuierliche Feedback-Schleife hilft bei der Verfeinerung Ihres Systems, um das richtige Gleichgewicht zwischen Sicherheit und freier Meinungsäußerung zu finden.

10. Mit OpenAI-Support in Kontakt treten

Wenn Sie Fragen zu bestimmten Anwendungsfällen haben oder eine Klärung der Richtlinien benötigen, zögern Sie nicht, sich an das Support-Team von OpenAI zu wenden. Deren Erkenntnisse können wertvoll sein, wenn es darum geht, die Moderationspraktiken auf die Bedürfnisse Ihrer Anwendung zuzuschneiden und sicherzustellen, dass Ihre Nutzung der API stets konform ist.

Die Einschaltung des OpenAI-Supports kann auch dann von Vorteil sein, wenn Sie mit Grauzonen konfrontiert sind. Wenn Sie sich nicht sicher sind, ob eine bestimmte Art von Inhalt erlaubt ist, kann eine Beratung mögliche Verstöße verhindern. Der Aufbau einer guten Beziehung zum OpenAI-Support stellt sicher, dass Sie eine ständige Quelle von Fachwissen haben, um komplexe Moderationsszenarien zu bewältigen.

Die Quintessenz

Die effektive Verwaltung nutzergenerierter Inhalte ist der Schlüssel zur Einhaltung der OpenAI-Richtlinien und zur Gewährleistung eines sicheren API-Zugangs. Durch die Befolgung dieser zehn Best Practices können Entwickler und Unternehmen das Risiko von Verstößen verringern, Strafen vermeiden und eine positivere Nutzererfahrung schaffen. Proaktives Management und die Verwendung der OpenAI-Moderationstools können Ihren Zugang schützen und Ihnen helfen, die Möglichkeiten der KI voll auszuschöpfen.