Wie Sie Ihr Unternehmen LLM Stack aufbauen: Unser 4-Tool Stack + Framework

Große Sprachmodelle (LLMs) haben sich als Schlüssel zum Aufbau intelligenter Unternehmensanwendungen erwiesen. Um die Leistung dieser Sprachmodelle zu nutzen, ist jedoch ein robuster und effizienter LLM-Anwendungsstack erforderlich. Bei Skim AI ermöglicht unser LLM-App-Stack die Erstellung leistungsstarker Anwendungen mit fortschrittlichen Funktionen zur Interaktion mit natürlicher Sprache. Unser Stack umfasst sorgfältig ausgewählte Tools und Frameworks, wie LLM-APIs, LangChain und Vektordatenbanken.

Mit einem solchen Technologiepaket können Entwickler nahtlos integrieren Sie können domänenspezifische Daten verarbeiten, Modelle feinabstimmen, effiziente Datenpipelines für den Abruf kontextbezogener Daten erstellen und vieles mehr. Dies ermöglicht es Unternehmen, Anwendungen zu entwickeln, die Benutzeranfragen mit einer noch nie dagewesenen Genauigkeit und Kontexterkennung verstehen und beantworten. Gleichzeitig besteht eine der wichtigsten Techniken, die mit diesem Stack einhergehen, darin, die vorhandenen Tools und Frameworks zu nutzen, die von den verschiedenen Komponenten bereitgestellt werden. Dadurch können sich die Entwickler auf die Erstellung von Anwendungen konzentrieren, anstatt Tools von Grund auf neu zu entwickeln, was wertvolle Zeit und Mühe spart.

Eine LLM-API wie GPT, Claude, Llama oder Mistral

Das Herzstück Ihres LLM-Anwendungsstacks sollte eine LLM-API sein. LLM-APIs bieten eine Möglichkeit, leistungsstarke Sprachmodelle in Ihre Anwendungen zu integrieren, ohne dass Sie die Modelle selbst trainieren oder hosten müssen. Sie fungieren als Brücke zwischen Ihrer Software und den komplexen Algorithmen, die Sprachmodelle antreiben, und ermöglichen es Ihnen, Ihren Anwendungen mit minimalem Aufwand fortschrittliche Funktionen zur Verarbeitung natürlicher Sprache hinzuzufügen.

Einer der Hauptvorteile der Verwendung einer LLM-API ist die Möglichkeit, hochmoderne Sprachmodelle zu nutzen, die anhand großer Datenmengen trainiert wurden. Diese Modelle, wie z. B. GPT, Claude, Mistralund Lamasind in der Lage, menschenähnlichen Text mit bemerkenswerter Genauigkeit und Geläufigkeit zu verstehen und zu erzeugen. Durch API-Aufrufe zu diesen Modellen können Sie Ihren Anwendungen schnell eine breite Palette von Funktionen hinzufügen, einschließlich Texterstellung, Stimmungsanalyse, Fragenbeantwortung und vieles mehr.

Faktoren, die bei der Auswahl eines LLM-API zu berücksichtigen sind

Bei der Auswahl einer LLM-API für Ihren Stack gibt es mehrere Faktoren zu berücksichtigen:

Leistung und Genauigkeit: Vergewissern Sie sich, dass die API Ihr Arbeitsaufkommen bewältigen und zuverlässige Ergebnisse liefern kann.

Anpassungsfähigkeit und Flexibilität: Überlegen Sie, ob Sie das Modell auf Ihren speziellen Anwendungsfall abstimmen oder es in andere Komponenten Ihres Stacks integrieren müssen.

Skalierbarkeit: Wenn Sie mit einem hohen Anfragevolumen rechnen, sollten Sie sicherstellen, dass die API entsprechend skaliert werden kann.

Unterstützung und Gemeinschaft: Beurteilen Sie den Grad der Unterstützung und die Größe der Community rund um die API, da dies die langfristige Lebensfähigkeit Ihrer Anwendung beeinflussen kann.

Um eine LLM-API effektiv nutzen zu können, ist es wichtig, ihre wichtigsten Komponenten und Fähigkeiten zu verstehen. Das Herzstück der meisten LLM-APIs sind tiefe neuronale Netze, die in der Regel auf Transformer-Architekturen basieren und auf großen Mengen von Textdaten trainiert werden. Der Zugriff auf diese Modelle erfolgt über eine API-Schnittstelle, die Aufgaben wie Authentifizierung, Anfragerouting und Antwortformatierung übernimmt. LLM-APIs enthalten häufig auch zusätzliche Komponenten für die Datenverarbeitung, wie Tokenisierung und Normalisierung, sowie Tools für die Feinabstimmung und Anpassung.

Bei der Integration einer LLM-API in Ihren Anwendungsstapel ist es wichtig, Faktoren wie Datenschutz und Sicherheit zu berücksichtigen. Je nach Anwendungsfall müssen Sie sicherstellen, dass sensible Daten nicht an den API-Anbieter gesendet oder für die Modellschulung verwendet werden. Sie sollten auch die Kostenstruktur der API sorgfältig prüfen, da sich die nutzungsabhängige Preisgestaltung für Anwendungen mit hohem Volumen schnell summieren kann.

Trotz dieser Herausforderungen liegen die Vorteile der Verwendung einer LLM-API klar auf der Hand. LLM-APIs bieten eine einfache und flexible Möglichkeit, fortschrittliche Sprachfunktionen in Ihre Anwendungen zu integrieren, und können Ihnen so helfen, ansprechende, intelligente und benutzerfreundliche Software zu erstellen. Ganz gleich, ob Sie einen Chatbot, ein Tool zur Erstellung von Inhalten oder ein Wissensmanagementsystem entwickeln, eine LLM-API ist eine wichtige Ergänzung für Ihre Unternehmensanwendungen.

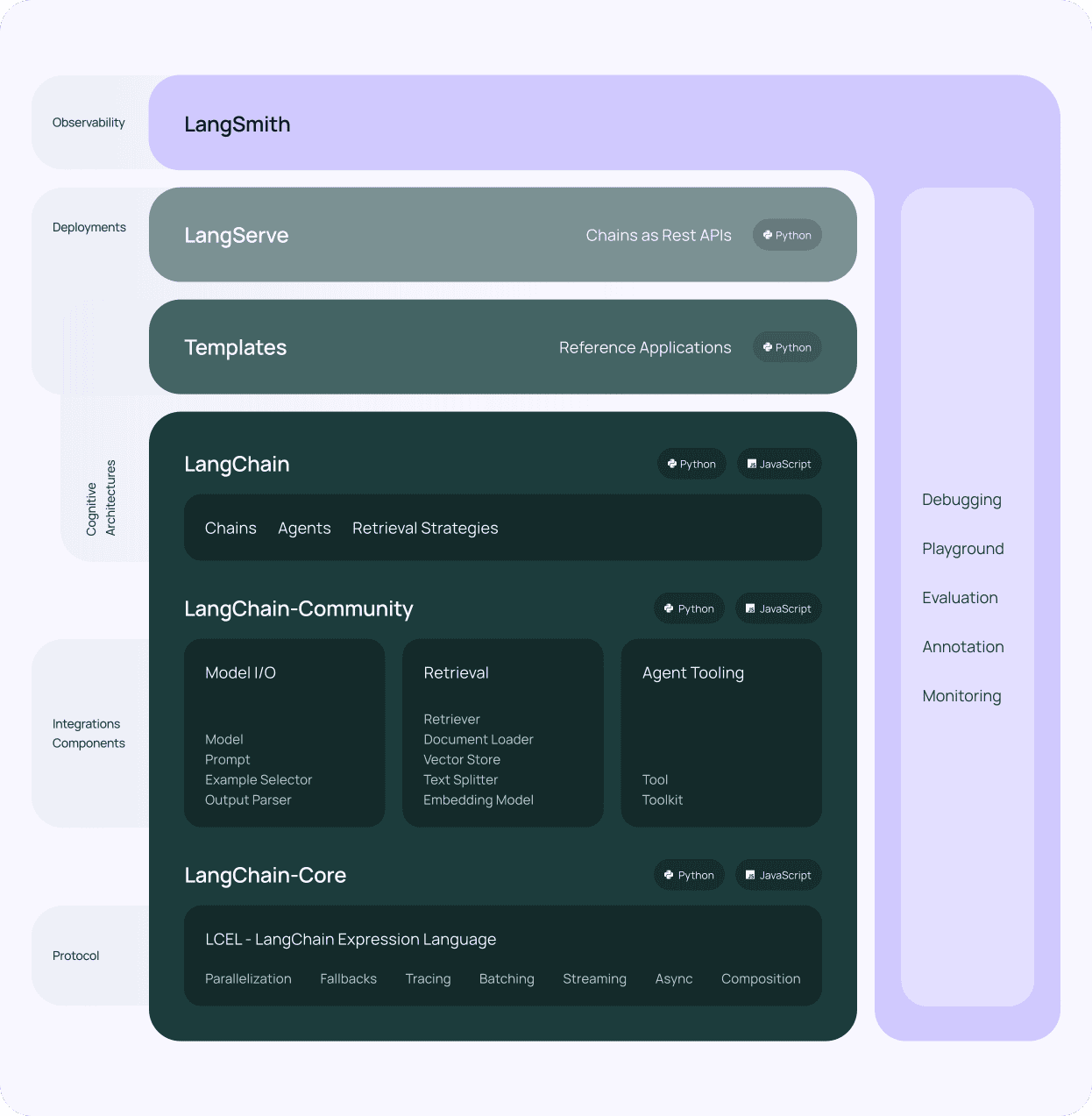

LangChain

Nach der Auswahl einer LLM-API für Ihren LLM-Anwendungsstapel ist die nächste zu berücksichtigende Komponente LangChain. LangChain ist ein leistungsfähiges Framework, das entwickelt wurde, um den Prozess der Erstellung von Anwendungen auf der Grundlage von großen Sprachmodellen zu vereinfachen. Es bietet eine standardisierte Schnittstelle für die Interaktion mit verschiedenen LLM-APIs, was die Integration in Ihren LLM-Technologiestapel erleichtert.

Einer der Hauptvorteile von LangChain ist seine modulare Architektur. LangChain besteht aus mehreren Komponenten, wie Prompts, Ketten, Agenten und Speicher, die kombiniert werden können, um komplexe Workflows zu erstellen. Diese Modularität ermöglicht es Ihnen, Anwendungen zu erstellen, die eine breite Palette von Aufgaben bewältigen können, von der einfachen Beantwortung von Fragen bis hin zu fortgeschrittenen Anwendungsfällen wie der Generierung von Inhalten und der Datenanalyse, die eine natürlichsprachliche Interaktion mit Ihren domänenspezifischen Daten ermöglichen.

LangChain's verschiedene Tools und Unterstützung

LangChain bietet auch eine Reihe von Tools und Dienstprogrammen, die die Arbeit mit LLMs vereinfachen. Zum Beispiel bietet es Werkzeuge für die Arbeit mit Einbettungen, die numerische Darstellungen von Text sind, die für Aufgaben wie semantische Suche und Clustering verwendet werden. Darüber hinaus enthält LangChain Dienstprogramme für die Verwaltung von Prompts, d. h. von Eingabezeichenfolgen, die das Verhalten von Sprachmodellen steuern.

Ein weiteres wichtiges Merkmal von LangChain ist die Unterstützung von Vektordatenbanken. Durch die Integration mit Vektordatenbanken wie Chroma (die wir verwenden), ermöglicht LangChain die Erstellung von Anwendungen, die große Datenmengen effizient speichern und abrufen können. Diese Integration ermöglicht es Ihnen, wissensintensive Anwendungen zu erstellen, die auf eine breite Palette von Informationsquellen zurückgreifen können, wodurch die Abfrage von kontextbezogenen Daten für Ihren LLM-App-Stack verbessert wird.

LangChain rühmt sich auch einer aktiven Gemeinschaft von Entwicklern und Nutzern, die zur laufenden Entwicklung beitragen. Diese Gemeinschaft bietet eine Fülle von Ressourcen, einschließlich Dokumentation, Tutorials und vorgefertigte Komponenten, die die Entwicklung von LLM-gestützten Anwendungen beschleunigen können. Darüber hinaus ist LangChain mit Open-Source-Modellen kompatibel, was es zu einem vielseitigen Werkzeug für Ihren LLM-Technologiestapel macht.

LangChain ist ein wesentlicher Bestandteil jeder Unternehmen LLM Anwendungsstapel. Der modulare Aufbau, die leistungsstarken Tools und die aktive Community machen es zu einem unverzichtbaren Werkzeug für die Entwicklung anspruchsvoller sprachbasierter Anwendungen. Durch die Nutzung von LangChain zusammen mit einer LLM-API und anderen Komponenten wie Vektordatenbanken können Sie Unternehmensanwendungen erstellen, die menschliche Sprache mit beispielloser Genauigkeit und Flüssigkeit verstehen und generieren und eine nahtlose natürlichsprachliche Interaktion mit Ihren privaten Daten und domänenspezifischen Informationen ermöglichen.

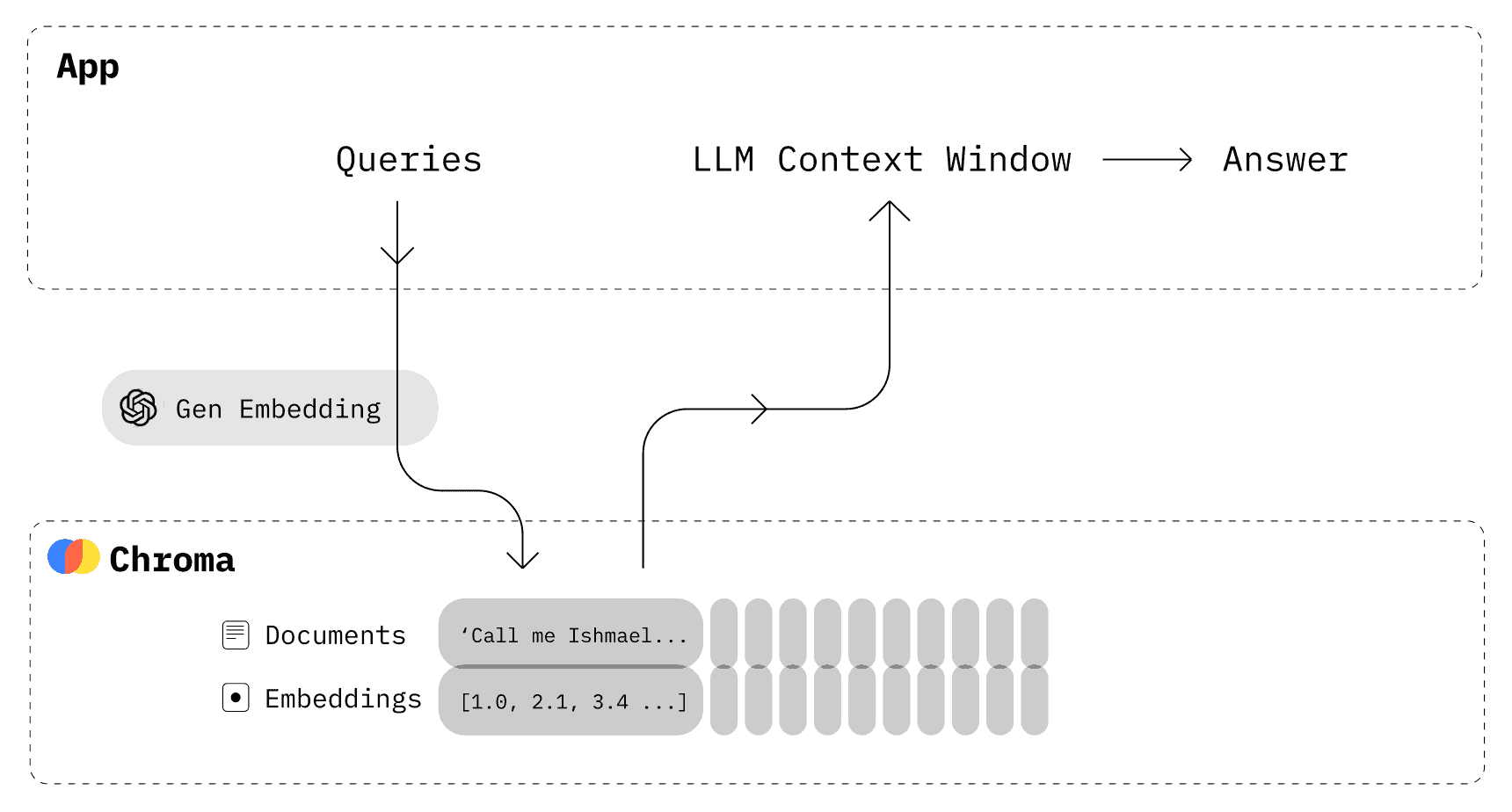

Eine Vektordatenbank wie Chroma

Neben einer LLM-API und LangChain ist eine Vektordatenbank eine weitere wesentliche Komponente Ihres LLM-App-Stacks. Vektordatenbanken sind spezialisierte Datenspeicher, die für die Speicherung und Suche von hochdimensionalen Vektoren optimiert sind, wie z. B. Einbettungen, die von großen Sprachmodellen erzeugt werden. Durch die Integration einer Vektordatenbank in Ihren LLM-Tech-Stack können Sie eine schnelle, effiziente Suche nach relevanten Daten auf der Grundlage semantischer Ähnlichkeit ermöglichen.

Chroma ist eine beliebte Open-Source-Wahl für eine Vektordatenbank in LLM-Anwendungsstacks, und wir verwenden sie hier bei Skim AI. Sie ist so konzipiert, dass sie nahtlos mit LangChain und anderen Komponenten Ihres Stacks zusammenarbeitet und eine robuste und skalierbare Lösung zum Speichern und Abrufen von Einbettungen bietet.

Einer der Hauptvorteile von Chroma ist seine Fähigkeit, große Datenmengen effizient zu verarbeiten. Chroma verwendet fortschrittliche Indizierungstechniken, um eine schnelle Ähnlichkeitssuche auch in großen Datenmengen zu ermöglichen. Dies macht es zu einer idealen Wahl für Anwendungen, die große Mengen an Textdaten speichern und durchsuchen müssen, wie z. B. Dokumenten-Repositories, Wissensdatenbanken und Content-Management-Systeme.

Ein weiterer Vorteil von Chroma ist seine Flexibilität und Benutzerfreundlichkeit. Chroma bietet eine einfache, intuitive API zum Speichern und Abrufen von Einbettungen und lässt sich so leicht in Ihren LLM-Anwendungsstack integrieren. Chroma unterstützt außerdem verschiedene Ähnlichkeitsmetriken wie die Kosinusähnlichkeit und den euklidischen Abstand, so dass Sie die für Ihren speziellen Anwendungsfall am besten geeignete Metrik auswählen können.

Chroma bietet auch erweiterte Funktionen wie Filterung und Unterstützung von Metadaten. Sie können neben Ihren Einbettungen zusätzliche Metadaten speichern, z. B. Dokument-IDs, Zeitstempel oder benutzerdefinierte Attribute. Diese Metadaten können zum Filtern von Suchergebnissen verwendet werden und ermöglichen einen präziseren und gezielteren Abruf von kontextbezogenen Daten.

Integration von Chroma in Ihren LLM-Stack für Unternehmen

Die Integration von Chroma in Ihren LLM-App-Stack ist dank der Kompatibilität mit LangChain und anderen gängigen Tools und Frameworks unkompliziert. LangChain bietet eine integrierte Unterstützung für Chroma, die es einfach macht, von Ihren Sprachmodellen generierte Einbettungen zu speichern und abzurufen. Diese Integration ermöglicht es Ihnen, leistungsstarke Suchmechanismen zu entwickeln, mit denen Sie schnell relevante Informationen auf der Grundlage der Interaktion mit natürlicher Sprache anzeigen können.

Die Verwendung einer Vektordatenbank wie Chroma in Verbindung mit LLMs eröffnet neue Möglichkeiten für die Entwicklung intelligenter, kontextbezogener Anwendungen. Indem Sie die Leistungsfähigkeit von Einbettungen und Ähnlichkeitssuche nutzen, können Sie Anwendungen erstellen, die Benutzeranfragen mit beispielloser Genauigkeit und Relevanz verstehen und darauf reagieren können. Dies ist besonders wertvoll für Bereiche wie Kundensupport, Inhaltsempfehlungen und Wissensmanagement, in denen die Bereitstellung der richtigen Informationen zur richtigen Zeit entscheidend ist.

In Kombination mit LangChain und einer LLM-API bildet Chroma eine leistungsstarke Grundlage für den Aufbau intelligenter, datengesteuerter Anwendungen, die die Art und Weise verändern können, wie wir mit Unternehmensdaten und domänenspezifischen Informationen interagieren.

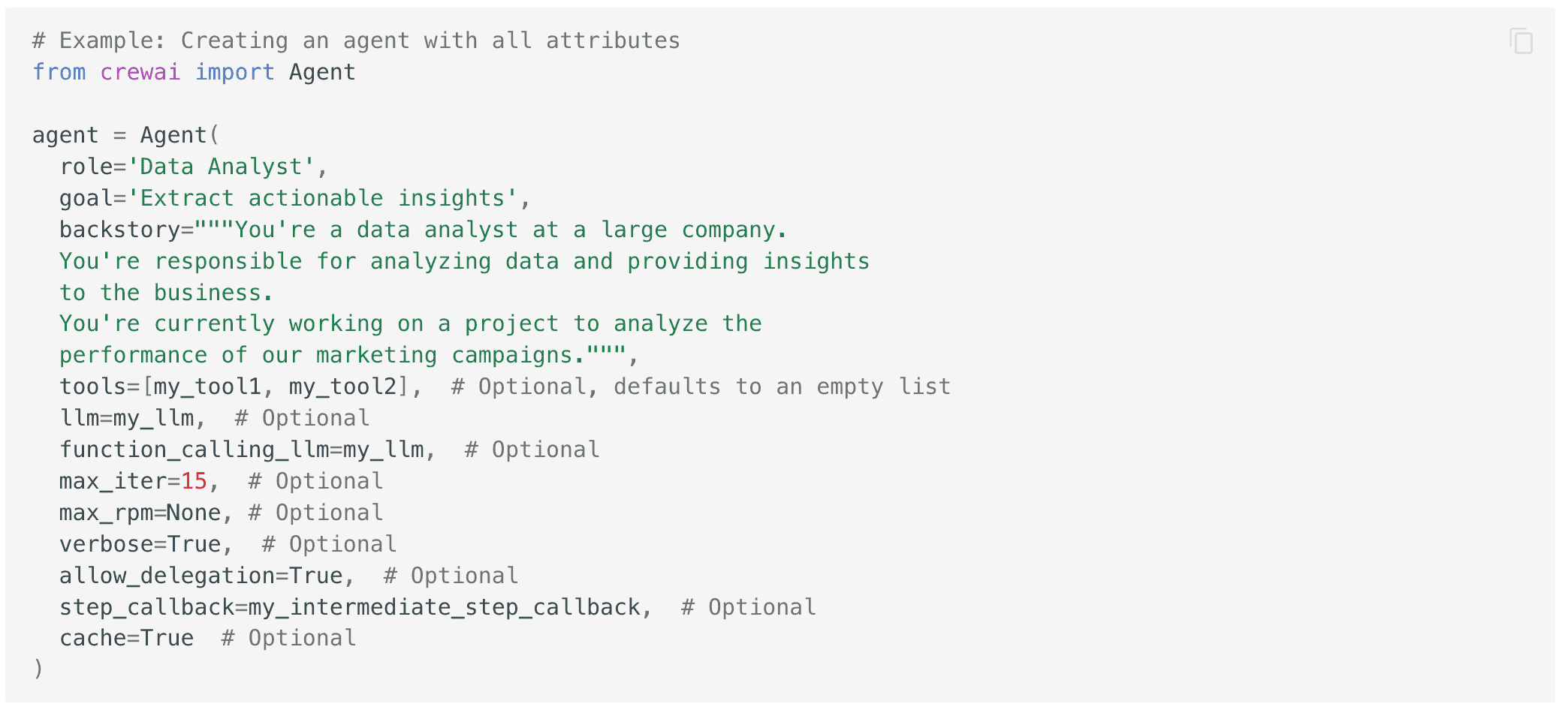

crewAI für Multi-Agenten-Systeme

crewAI ist ein weiteres leistungsfähiges Tool, das Sie Ihrem LLM-App-Stack hinzufügen können, um die Fähigkeiten Ihrer Anwendungen zu erweitern. crewAI ist ein Framework, mit dem Sie Multi-Agenten-Systeme erstellen können, in denen mehrere KI-Agenten zusammenarbeiten, um komplexe Aufgaben zu erfüllen. Durch die Integration von crewAI in Ihren Stack können Sie Anwendungen erstellen, die anspruchsvollere Workflows und Entscheidungsfindungsprozesse bewältigen können, und so die natürlichsprachlichen Interaktionsfähigkeiten Ihres LLM-Anwendungsstacks für Unternehmen weiter ausbauen.

Im Kern ist crewAI darauf ausgelegt, die Zusammenarbeit zwischen mehreren KI-Agenten zu erleichtern, von denen jeder seine eigene spezifische Rolle und Expertise hat. Diese Agenten können miteinander kommunizieren und sich abstimmen, um komplexe Probleme in kleinere, besser zu bewältigende Teilaufgaben zu zerlegen. Mit diesem Ansatz können Sie Anwendungen erstellen, die ein breites Spektrum an realen Herausforderungen bewältigen können, vom Kundensupport und der Erstellung von Inhalten bis hin zur Datenanalyse und Entscheidungsunterstützung, und dabei die Leistung großer Sprachmodelle nutzen.

Die Macht der Spezialisierung nutzen

Einer der Hauptvorteile der Verwendung von crewAI in Ihrem LLM-Tech-Stack ist die Fähigkeit, die Macht der Spezialisierung zu nutzen. Indem Sie verschiedenen Agenten spezifische Rollen und Aufgaben zuweisen, können Sie ein System schaffen, das effizienter und effektiver ist als ein einzelnes, monolithisches KI-Modell. Jeder Agent kann für seine spezielle Aufgabe trainiert und optimiert werden, so dass er auf einem höheren Niveau arbeitet als ein Allzweckmodell und eine gezieltere Abfrage von Kontextdaten aus Ihren domänenspezifischen Datensätzen ermöglicht.

crewAI bietet außerdem eine flexible und erweiterbare Architektur, die es Ihnen ermöglicht, verschiedene Arten von Agenten in Ihr System zu integrieren. Dazu gehören Agenten, die auf Sprachmodellen basieren, aber auch Agenten, die andere KI-Techniken wie Computer Vision, Spracherkennung oder Reinforcement Learning nutzen. Durch die Kombination dieser verschiedenen Arten von Agenten können Sie Anwendungen erstellen, die die Welt auf natürlichere und intuitivere Weise wahrnehmen, verstehen und mit ihr interagieren können, wodurch die natürlichsprachlichen Interaktionsmöglichkeiten Ihres LLM-Anwendungsstapels weiter verbessert werden.

Die Integration von crewAI in Ihren LLM-App-Stack wird durch seine Kompatibilität mit anderen beliebten Tools und Frameworks wie LangChain und Vektordatenbanken erleichtert. So können Sie End-to-End-Workflows erstellen, die Aufgaben von der Datenaufnahme und -verarbeitung bis hin zur natürlichsprachlichen Interaktion und Entscheidungsfindung bewältigen können, während Sie gleichzeitig die Leistungsfähigkeit von Open-Source-Modellen und -Frameworks nutzen.

Die Verwendung von crewAI in Kombination mit anderen Komponenten Ihres LLM-Tech-Stacks kann Ihnen helfen, neue Möglichkeiten für den Aufbau intelligenter Multi-Agenten-Systeme zu erschließen, die komplexe Aufgaben in der realen Welt bewältigen können. Indem Sie die Kraft der Spezialisierung und Zusammenarbeit nutzen, können Sie Anwendungen erstellen, die effizienter, effektiver und benutzerfreundlicher sind als herkömmliche Einzelmodellansätze.

Entfaltung der Leistungsfähigkeit von LLMs mit dem richtigen Anwendungsstack

Der Aufbau intelligenter, kontextbezogener Anwendungen, die die Leistung großer Sprachmodelle nutzen, erfordert einen gut konzipierten LLM-Anwendungsstack. Durch die Kombination leistungsstarker Tools wie LLM-APIs, LangChain, Vektordatenbanken wie Chroma und Multi-Agenten-Frameworks wie crewAI können Sie unglaublich leistungsstarke und wertvolle Workflows erstellen.

Dieser Stack ermöglicht Ihnen die nahtlose Integration domänenspezifischer Daten, die effiziente Abfrage kontextbezogener Informationen und die Erstellung anspruchsvoller Workflows, mit denen Sie komplexe reale Herausforderungen bewältigen können. Indem Sie die Leistungsfähigkeit dieser Tools und Frameworks nutzen, können Sie die Grenzen dessen, was mit sprachbasierten KI-Anwendungen möglich ist, verschieben und wirklich intelligente Systeme schaffen, die die Art und Weise, wie Ihr Unternehmen mit Daten und Technologie interagiert, verändern können.