4 найкращі практики для запобігання заборонам OpenAI API та забезпечення відповідності

Якщо ваша компанія використовує штучний інтелект у будь-якому аспекті, дотримання нормативних вимог є як ніколи важливим, особливо коли ви використовуєте моделі штучного інтелекту, подібні до тих, що надає OpenAI. Багато компаній не усвідомлюють, що недотримання користувачами політик OpenAI може призвести до заборони доступу до API, часто без попереднього попередження. Для компаній, які керують багатьма користувачами, забезпечення дотримання політик OpenAI має вирішальне значення для підтримки безперебійного доступу до цих потужних інструментів. Недотримання умов може призвести до серйозних наслідків, включаючи заборони, які можуть суттєво порушити роботу вашого бізнесу.

OpenAI розробила комплексний набір політик, спрямованих на запобігання зловживанням. Ці політики не тільки захищають платформу, але й забезпечують відповідальне використання технологій штучного інтелекту в різних галузях. Компанії, які використовують API OpenAI, повинні ретельно стежити за поведінкою користувачів, щоб уникнути порушень, які можуть призвести до штрафів або заборон. Розуміння та ефективне дотримання цих політик є запорукою збереження доступу та отримання конкурентних переваг у сфері ШІ.

Розуміння політики використання API OpenAI

Політика використання API OpenAI розроблена для забезпечення етичного та належного використання ШІ. Неправильне використання цих API, особливо за допомогою створеного користувачем контенту, може швидко призвести до призупинення або блокування облікового запису. Неправильна поведінка користувачів, наприклад, надсилання невідповідного або шкідливого контенту, не тільки порушує умови OpenAI, але й ставить під загрозу цілі акаунти.

OpenAI активно відстежує шаблони використання та оцінює приховані дії, які можуть порушувати їхні правила. Наприклад, неналежне подання контенту або спроби обійти контент-фільтри можуть призвести до значних наслідків. OpenAI приховує конкретні деталі щодо того, як він оцінює запити, підтримуючи таку жорстку кришку на своїх процесах модерації, щоб забезпечити відповідність вимогам без компромісів. Таким чином, OpenAI гарантує, що його моделі використовуються відповідно до його етичних стандартів.

Щоб уникнути цих проблем, розробникам і підприємствам необхідно активно дотримуватися рекомендацій OpenAI і використовувати вбудовані інструменти, такі як кінцева точка модераціїщо може допомогти відфільтрувати потенційно шкідливий контент ще до того, як він потрапить до API. Розуміння ключових аспектів зловживань і знання того, як OpenAI відстежує порушення, дозволить компаніям більш ефективно управляти ризиками.

Проблеми, з якими стикаються багатокористувацькі програми

Для компаній, які керують додатками з кількома користувачами, ризики, пов'язані з неправильним використанням API, значно вищі. Кожен користувач може ненавмисно або навмисно порушити політику OpenAI, що призведе до наслідків, які вплинуть на всю організацію. Це робить життєво важливим для розробників розуміння унікальних викликів, що виникають у багатокористувацьких середовищах.

Управління багатьма користувачами пов'язане зі специфічними проблемами, такими як різний рівень розуміння допустимого використання, непослідовне дотримання інструкцій і можливість зловмисної поведінки з боку невеликої групи користувачів. Кожна взаємодія користувача повинна ретельно контролюватися, оскільки одне порушення може поставити під загрозу весь доступ до API для організації. Крім того, масштабування платформи з великою кількістю користувачів створює складнощі в забезпеченні відповідності всіх користувачів вимогам, не перевантажуючи систему ручними перевірками.

На відміну від попередніх моделей штучного інтелекту, які могли бути менш суворими, остання модель OpenAI поставляється з більш суворими рекомендаціями щодо дотримання вимог, які ретельно контролюються. Компанії повинні взяти на себе відповідальність за моніторинг контенту, створеного користувачами, щоб запобігти порушенням, а це передбачає впровадження автоматичної фільтрації контенту та перевірку відповідності. Проактивні заходи, такі як інтеграція кінцевої точки модерації OpenAI, встановлення чітких правил використання для кінцевих користувачів і надання користувачам освітніх ресурсів про прийнятний контент, можуть допомогти знизити ці ризики і забезпечити постійну доступність API.

Ефективно керуючи поведінкою окремих користувачів і впроваджуючи надійні інструменти моніторингу, компанії можуть уникнути покарання за дії кількох зловмисників. Інвестиції в процеси та інструменти управління користувачами не тільки допомагають у дотриманні нормативних вимог, але й створюють більш надійне середовище для всіх користувачів, що в кінцевому підсумку сприяє досягненню довгострокових цілей компанії завдяки інтеграції штучного інтелекту.

Найкращі практики для запобігання заборонам OpenAI API

Щоб запобігти заборонам і гарантувати, що ваше використання API залишається сумісним, дуже важливо впроваджувати певні найкращі практики. Ось кілька стратегій, яких можуть дотримуватися розробники та компанії:

Використовуйте кінцеву точку модерації: OpenAI надає безкоштовну кінцеву точку модерації, яка допомагає виявити шкідливий вміст ще до того, як він потрапить до API. Цей інструмент необхідний для фільтрації неприйнятного контенту та зменшення ризику штрафів.

Тарифні ліміти та унікальні ідентифікатори користувачів: Впровадження лімітів на швидкість і присвоєння унікальних ідентифікаторів користувача кожному запиту до API може допомогти керувати і відстежувати поведінку користувачів. Контролюючи обсяг запитів і прив'язуючи їх до окремих користувачів, стає легше виявляти і обмежувати проблемні акаунти.

Моніторинг та ведення журналу в режимі реального часу: Встановіть системи моніторингу в реальному часі, щоб відстежувати використання API. Логування кожного запиту дозволяє розробникам проводити аудит поведінки користувачів і виявляти аномалії на ранніх стадіях.

Перевірка вхідних даних: Переконайтеся, що всі вхідні дані перевірені, щоб запобігти обробці API шкідливих або невідповідних даних. Належна перевірка вхідних даних може зменшити ризики та покращити відповідність вимогам.

Такі практики не лише мінімізують ризик порушень, але й надають компаніям конкурентну перевагу, оскільки демонструють прихильність до відповідального використання АІ. Впровадження структурованого підходу до комплаєнсу, включно з використанням вбудованих інструментів OpenAI, може в кінцевому підсумку призвести до більш надійного та ефективного використання моделей штучного інтелекту.

Розуміння кінцевої точки модерації OpenAI

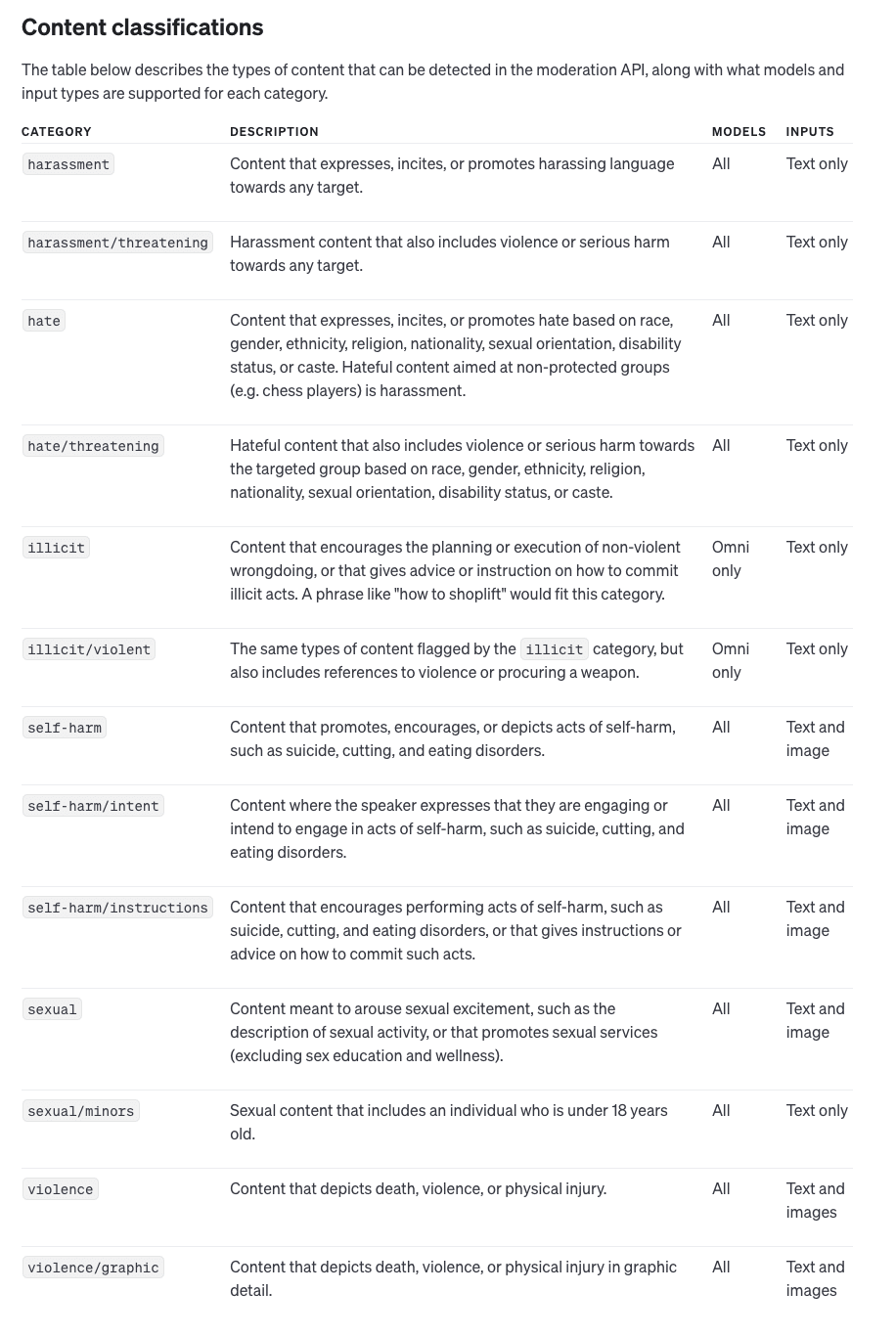

Кінцева точка модерації, яку надає OpenAI, є критично важливим інструментом для забезпечення того, щоб шкідливий контент не потрапляв до системи, таким чином допомагаючи підтримувати відповідність вимогам і запобігати заборонам. Кінцева точка може аналізувати як текстові, так і графічні дані, визначаючи потенційно шкідливі категорії, такі як насильство, мова ворожнечі тощо.

Кінцева точка модерації OpenAI пропонує наступні можливості:

Модель всемодерації: Це остання версія, яка підтримує декілька варіантів категоризації та мультимодальний що робить його придатним як для тексту, так і для зображень.

Модерація застарілих текстів: Старіші моделі, які підтримують лише текстове введення з меншими можливостями категоризації. Однак для нових додатків рекомендується використовувати модель всемодерації.

Використання кінцевої точки модерації передбачає передачу вхідних даних до API OpenAI, який потім надає детальну відповідь. Ця відповідь включає в себе

Позначений вміст: Кінцева точка встановлює прапорець у true, якщо вхідні дані містять шкідливий або неприйнятний вміст.

Оцінки категорії: Детальна система оцінювання, яка вказує на рівень довіри до моделі в категоризації потенційно шкідливого контенту.

Дані для конкретних категорій: Кінцева точка вказує на те, які типи вхідних даних (наприклад, текст або зображення) спричинили категоризацію, що дає змогу точніше здійснювати модерацію.

Впровадивши кінцеву точку модерації, компанії можуть діяти на випередження - відфільтровувати позначений контент ще до того, як він потрапить до основного API OpenAI. Це не тільки захищає цілісність моделі штучного інтелекту, але й мінімізує ризик порушень політики, які можуть призвести до заборони API.

Забезпечення комплаєнсу та конкурентних переваг

Дотримання вимог - це не лише спосіб уникнути штрафів, але й конкурентна перевага в галузі штучного інтелекту. Компанії, які суворо дотримуються рекомендацій OpenAI, рідше стикаються зі збоями в роботі, що дозволяє їм надавати користувачам стабільні та надійні послуги.

Більше того, проактивна позиція в забезпеченні відповідності означає, що компанії можуть використовувати весь потенціал моделей штучного інтелекту OpenAI. Розуміючи логіку політики OpenAI та впроваджуючи найкращі практики, організації позиціонують себе як відповідальних лідерів у сфері ШІ. Комплаєнс допомагає побудувати довіру як з користувачами, так і з партнерами в галузі, дозволяючи компаніям диференціювати себе від конкурентів, які можуть бути не такими старанними.

Підсумок

Відповідальне використання API має вирішальне значення для збереження доступу до потужних інструментів OpenAI. Недотримання політики OpenAI може призвести до серйозних наслідків, включаючи заборону на використання API, що може суттєво порушити ваші бізнес-операції. Розробники та компанії повинні активно керувати поведінкою користувачів, впроваджувати стратегії модерації та дотримуватися найкращих практик, щоб уникнути порушень.

Зрештою, дотримання рекомендацій OpenAI не лише запобігає збоям, але й позиціонує компанії як лідерів у сфері етичного використання ШІ. Демонструючи прихильність до дотримання вимог, організації можуть захистити свій доступ до API, посилити конкурентні переваги та зробити позитивний внесок у розвиток індустрії штучного інтелекту.