Як підприємствам боротися з галюцинаціями LLM для безпечної інтеграції АІ

Великі мовні моделі (LLM) трансформують корпоративні додатки, пропонуючи безпрецедентні можливості для обробки та генерації природної мови. Однак, перш ніж ваша компанія приєднається до LLM, вам потрібно вирішити одну важливу проблему: галюцинації.

Галюцинації LLM є значною перешкодою на шляху широкого впровадження цих потужних систем штучного інтелекту. Заглиблюючись у складну природу цього явища, стає зрозуміло, що розуміння та пом'якшення галюцинацій має вирішальне значення для будь-якого підприємства, яке прагне використати весь потенціал LLM, мінімізуючи при цьому ризики.

Розуміння галюцинацій LLM

Галюцинації ШІ в контексті великих мовних моделей - це випадки, коли модель генерує текст або надає відповіді, які є фактично неправильними, безглуздими або не пов'язаними з вхідними даними. Ці галюцинації можуть проявлятися у вигляді впевненого звучання, але повністю сфабрикованої інформації, що призводить до потенційних непорозумінь і дезінформації.

Типи галюцинацій

Галюцинації, пов'язані з ГПМ, можна розділити на кілька типів:

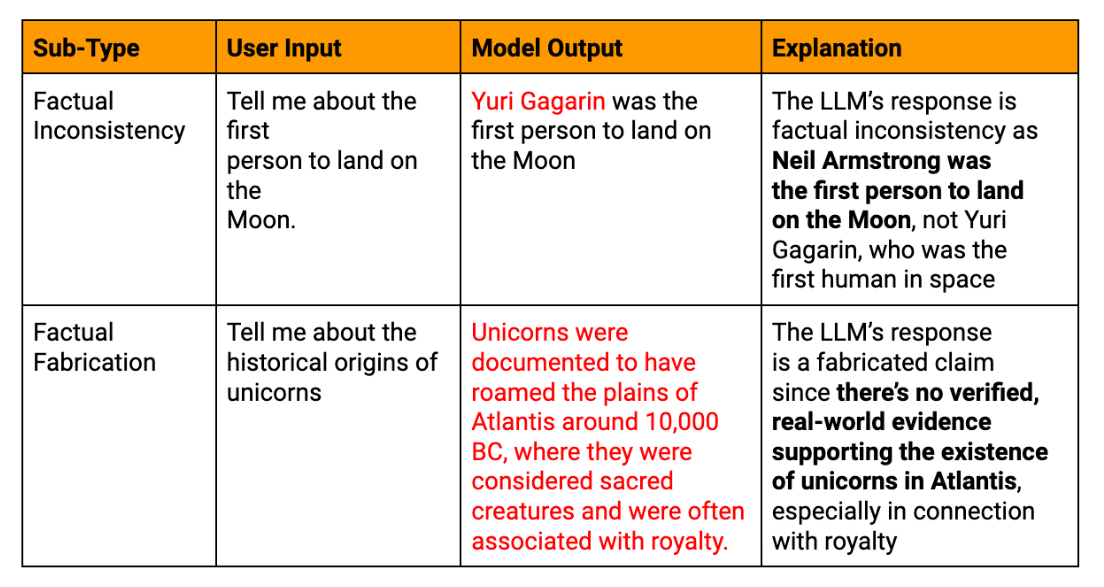

Фактичні галюцинації: Коли модель видає інформацію, яка суперечить встановленим фактам або вигадує неіснуючі дані.

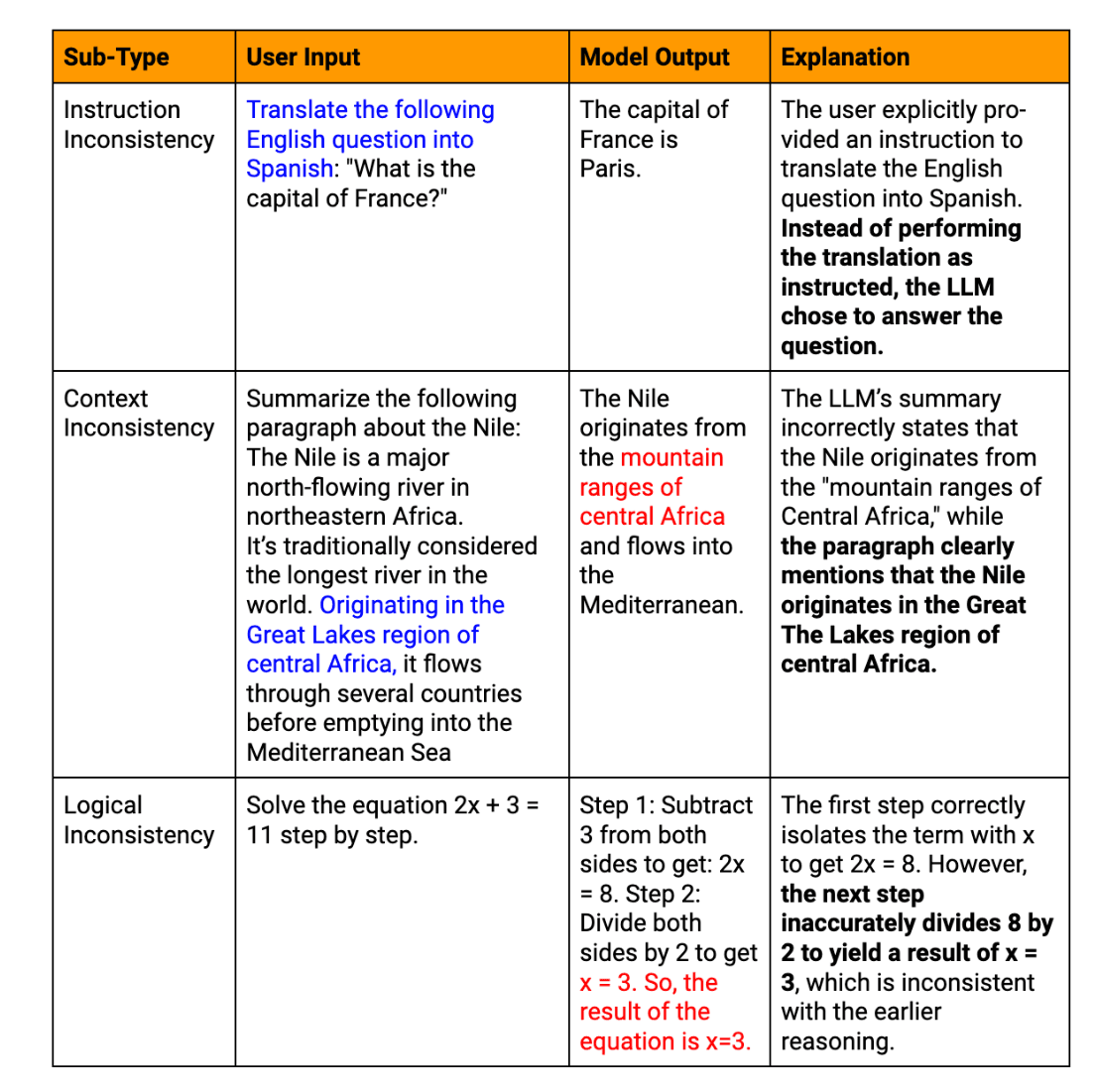

Семантичні галюцинації: Випадки, коли згенерований текст є логічно непослідовним або безглуздим, навіть якщо окремі частини здаються зв'язними.

Контекстуальні галюцинації: Випадки, коли відповідь LLM відхиляється від заданого контексту або підказканадаючи нерелевантну інформацію.

Тимчасові галюцинації: Коли модель об'єднує або спотворює чутливу до часу інформацію, наприклад, нещодавні події або історичні факти.

Реальні приклади текстових галюцинацій, згенерованих LLM

Щоб проілюструвати значні наслідки галюцинацій LLM на підприємствах, розглянемо відповідні приклади:

Несправність чат-бота для обслуговування клієнтів: Велика компанія, що займається електронною комерцією, інтегрує чат-бота на базі LLM у свою платформу обслуговування клієнтів. Під час розпродажу з високим трафіком чат-бот впевнено надає тисячам клієнтів невірну інформацію про політику повернення та терміни доставки. Це призводить до сплеску скарг клієнтів, підриву довіри та вимагає значних зусиль для усунення наслідків.

Неточності у фінансовій звітності: Інвестиційна компанія використовує LLM для допомоги у створенні щоквартальних фінансових звітів. Система штучного інтелекту галюцинує кілька ключових фінансових показників, що залишається непоміченим при первинному перегляді. Коли неточний звіт публікується, це призводить до помилкових інвестиційних рішень і потенційних регуляторних проблем, що підкреслює гостру потребу в ретельній перевірці фінансового контенту, згенерованого штучним інтелектом.

Помилка при розробці продукту: Технологічний стартап використовує LLM для аналізу ринкових тенденцій і генерування рекомендацій щодо функцій продукту. ШІ впевнено запропонував функцію, засновану на неіснуючій технології, що призвело до того, що команда розробників змарнувала цінний час і ресурси, перш ніж усвідомила помилку. Цей інцидент підкреслює важливість перехресних посилань на результати LLM з надійними галузевими джерелами.

Плутанина в кадровій політиці: Транснаціональна корпорація наймає магістра права для допомоги в розробці кадрової політики. Штучний інтелект галюцинує неіснуючий закон про працю, який випадково потрапляє в офіційний документ компанії. Це призводить до плутанини серед працівників і потенційної юридичної відповідальності, що підкреслює необхідність експертної оцінки змісту політики, згенерованої штучним інтелектом.

Ці приклади демонструють, як галюцинації LLM можуть впливати на різні аспекти діяльності підприємства - від взаємодії з клієнтами до внутрішніх процесів і прийняття стратегічних рішень. Вони підкреслюють критичну важливість впровадження надійних процесів верифікації та людського нагляду при використанні тексту, створеного LLM, у критично важливих для бізнесу додатках.

Що спричиняє галюцинації у магістрів права?

Розуміння походження галюцинацій при ГПМ має вирішальне значення для розробки ефективних стратегій пом'якшення їх наслідків. Цьому явищу сприяють кілька взаємопов'язаних факторів.

Питання якості навчальних даних

Якість навчальних даних суттєво впливає на ефективність роботи LLM. Неточна або застаріла інформація, упередженість вихідних матеріалів і невідповідність у представленні фактичних даних - усе це може призвести до галюцинацій. Наприклад, якщо LLM навчався на наборі даних, що містить застарілі наукові теорії, він може впевнено представити їх як актуальні факти у своїх результатах.

Обмеження в моделях ШІ та мовних моделях

Незважаючи на свої вражаючі можливості, сучасні магістерські програми мають певні обмеження:

Відсутність справжнього розуміння: Магістри обробляють шаблони в тексті, а не розуміють зміст

Обмежене контекстне вікно: Більшість моделей намагаються підтримувати узгодженість на довгих відрізках

Невміння перевіряти факти: Магістри не можуть отримати доступ до зовнішніх знань у режимі реального часу для перевірки отриманої інформації

Ці обмеження можуть призвести до того, що модель генеруватиме правдоподібний на вигляд, але фактично неправильний або безглуздий контент.

Виклики у створенні вихідних даних LLM

Сам процес генерування тексту може викликати галюцинації. LLM створюють контент почергово, на основі імовірнісних прогнозів, що може призвести до семантичного дрейфу або неправдоподібних послідовностей. Крім того, LLM часто демонструють надмірну самовпевненість, представляючи галюцинаційну інформацію з такою ж достовірністю, як і фактичні дані.

Вхідні дані та фактори, пов'язані з опитуванням

Взаємодія користувача з LLM може ненавмисно сприяти виникненню галюцинацій. Неоднозначні підказки, недостатній контекст або надто складні запити можуть призвести до того, що модель неправильно інтерпретуватиме наміри або заповнюватиме прогалини вигаданою інформацією.

Наслідки галюцинацій LLM для підприємств

Виникнення галюцинацій у вихідних даних LLM може мати далекосяжні наслідки для підприємств:

Ризики неправильних відповідей та фактично невірної інформації

Коли бізнес покладається на контент, створений LLM, для прийняття рішень або комунікації з клієнтами, галюцинації можуть призвести до дорогих помилок. Ці помилки можуть варіюватися від незначної операційної неефективності до великих стратегічних прорахунків. Наприклад, неточний аналіз ринку, проведений LLM, може призвести до помилкових інвестиційних рішень або стратегій розвитку продукту.

Потенційні правові та етичні наслідки

Підприємства, які використовують LLM, повинні орієнтуватися в складному ландшафті нормативно-правового регулювання та етичних міркувань. Розглянемо наступні сценарії:

Галюцинації у фінансових звітах, що призводять до регуляторних порушень

Неточна інформація, надана клієнтам, призвела до судового позову

Етичні дилеми, що виникають у зв'язку з використанням систем штучного інтелекту, які надають недостовірну інформацію

Вплив на надійність і довіру до систем штучного інтелекту

Можливо, найбільш критичним є те, що галюцинації LLM можуть суттєво вплинути на надійність і довіру до систем ШІ. Часті або гучні випадки галюцинацій можуть:

Підриває довіру користувачів, потенційно сповільнюючи впровадження та інтеграцію ШІ

Зашкодити репутації компанії як технологічного лідера

Призводить до зростання скептицизму щодо всіх результатів, отриманих за допомогою ШІ, навіть якщо вони є точними

Для підприємств подолання цих наслідків є не просто технічним завданням, а стратегічним імперативом.

Стратегії пом'якшення галюцинацій під час інтеграції корпоративного LLM

Оскільки підприємства все частіше впроваджують великі мовні моделі, вирішення проблеми галюцинацій набуває першочергового значення.

Існують ключові стратегії для пом'якшення цієї проблеми:

1. Покращення інтеграції навчальних даних та зовнішніх знань

Основою будь-якого LLM є навчальні дані. Щоб зменшити кількість галюцинацій, підприємства повинні зосередитися на підвищенні якості даних та інтеграції надійних зовнішніх знань.

Створюйте специфічні для домену набори даних, які ретельно перевіряються на точність. Такий підхід допомагає моделі навчатися на якісній, релевантній інформації, зменшуючи ймовірність фактичних помилок.

Впровадити системи регулярного оновлення навчальних даних, щоб забезпечити доступ моделі до найактуальнішої інформації. Це особливо важливо для галузей з базами знань, що швидко розвиваються, таких як технології або охорона здоров'я.

Включіть структуровані графи знань в архітектуру LLM. Це забезпечує модель надійною структурою фактичних взаємозв'язків, допомагаючи ґрунтувати її результати на перевіреній інформації.

Реалізувати ГАНЧІР'Я методи, які дозволяють LLM отримувати доступ до зовнішніх, актуальних баз знань і посилатися на них під час створення тексту. Цей механізм перевірки фактів у режимі реального часу значно знижує ризик появи застарілої або неправильної інформації.

2. Впровадження надійної валідації для результатів навчання на рівні магістратури

Процеси валідації мають вирішальне значення для виявлення та виправлення галюцинацій до того, як вони потраплять до кінцевих користувачів.

Розробити системи перевірки фактів на основі штучного інтелекту, які можуть швидко перевіряти ключові твердження в тексті, створеному LLM, за допомогою перевірених баз даних або веб-джерел.

Впровадити алгоритми, які перехресно посилаються на різні частини висновку ЛПМ для внутрішньої узгодженості, відзначаючи протиріччя, які можуть свідчити про галюцинації.

Використовуйте власні оцінки достовірності моделі для кожного згенерованого сегмента. Результати з низьким рівнем довіри можуть бути позначені для перевірки людиною або додаткової перевірки.

Розгорніть кілька LLM або ШІ-моделей для генерування відповідей на один і той самий запит, порівнюючи результати, щоб виявити потенційні галюцинації через розбіжності.

3. Використання громадського контролю для забезпечення точності фактів

Хоча автоматизація має вирішальне значення, людський досвід залишається безцінним у зменшенні галюцинацій.

Впровадити процеси, в яких експерти галузі перевіряють результати LLM у критично важливих додатках, таких як юридичні документи або фінансові звіти.

Розробляйте інтерфейси, які сприяють безперешкодній співпраці між LLMs і людьми-операторами, дозволяючи швидко вносити корективи та навчатися на основі людського вкладу.

Впровадити механізми для кінцевих користувачів повідомляти про підозри щодо галюцинацій, створюючи безперервний цикл вдосконалення системи LLM.

Розробити комплексний тренінг для працівників щодо виявлення та роботи з потенційними галюцинаціями LLM, виховуючи культуру критичної оцінки контенту, згенерованого ШІ.

4. Прогресивні методи покращення поведінки моделі

Передові дослідження пропонують багатообіцяючі шляхи для підвищення продуктивності LLM та зменшення галюцинацій.

Обмежене розшифрування: Впроваджуйте методи, які скеровують процес створення тексту LLM, змушуючи його більш чітко дотримуватися відомих фактів або визначених правил.

Моделі з урахуванням невизначеності: Розробляйте LLM, які можуть виражати невизначеність щодо своїх результатів, потенційно використовуючи такі методи, як калібровані мовні моделі або ансамблеві методи.

Навчання протистояння: Під час тренувань давайте моделі приклади з конкурентами, щоб допомогти їй стати більш стійкою до генерування галюцинацій.

Тонке налаштування за допомогою навчання з підкріпленням: Використовуйте методи навчання з підкріпленням для точного налаштування LLM, заохочуючи точність фактів і караючи галюцинації.

Модульна архітектура: Вивчіть архітектури, які відокремлюють знання про світ від можливостей генерування мови, що дає змогу більш контрольовано та верифіковано шукати інформацію.

Впроваджуючи ці стратегії, ваше підприємство може значно знизити ризик виникнення галюцинацій у своїх заявках на отримання ступеня магістра. Однак важливо зазначити, що повне усунення галюцинацій залишається складним завданням. Тому багатогранний підхід, що поєднує технологічні рішення з людським наглядом, має вирішальне значення.

Перспективи на майбутнє: Досягнення в боротьбі з галюцинаціями

Заглядаючи в майбутнє технології LLM, ми бачимо, що зменшення галюцинацій залишається ключовим напрямком досліджень у галузі машинного навчання. Для вирішення цієї проблеми постійно розробляються нові інструменти та фреймворки, з багатообіцяючими досягненнями в таких сферах, як перевірка самоузгодженості, інтеграція знань та кількісна оцінка невизначеності.

Майбутні дослідження відіграватимуть вирішальну роль у підвищенні фактичної точності LLM, що призведе до створення моделей, які зможуть краще розрізняти фактичні знання і згенерований текст. Оскільки системи штучного інтелекту продовжують розвиватися, ми очікуємо, що з'являться більш досконалі підходи до зменшення галюцинацій, включаючи вдосконалені нейронні архітектури, покращені методики навчання та посилену інтеграцію зовнішніх знань. Підприємствам, які розглядають можливість впровадження LLM, важливо бути в курсі цих розробок, щоб використовувати весь потенціал ШІ, зберігаючи при цьому найвищі стандарти точності та надійності своїх операцій.

ПОШИРЕНІ ЗАПИТАННЯ

Що таке галюцинації LLM?

LLM-галюцинації - це випадки, коли ШІ-моделі генерують фактично неправильний або безглуздий текст, незважаючи на те, що виглядають впевненими та послідовними.

Які найпоширеніші приклади галюцинацій LLM у критичних сферах застосування?

Поширеними прикладами є генерування неправдивих фінансових даних у звітах, надання некоректних юридичних консультацій або вигадування неіснуючих властивостей продукту в технічній документації.

Які реальні наслідки галюцинацій на рівні LLM?

Наслідки можуть включати фінансові втрати через неправильно прийняті рішення, юридичні зобов'язання через неправильні поради та шкоду для репутації компанії через оприлюднення неправдивої інформації.

Як галюцинації LLM впливають на взаємодію з клієнтами?

Галюцинації в обслуговуванні клієнтів можуть призвести до дезінформації, розчарування клієнтів і зниження довіри до систем підтримки на основі штучного інтелекту.

Які стратегії використовуються для пом'якшення галюцинацій НЛМ?

Ключові стратегії включають покращення якості навчальних даних, впровадження надійної перевірки результатів, інтеграцію людського нагляду та використання передових методів, таких як генерація, доповнена пошуком.