敵対的AI攻撃とは何か?

敵対的AI攻撃とは何か?

人工知能(AI)や機械学習(ML)などのディープラーニング技術は、企業にさまざまなビジネス上のメリットをもたらす。同時に、敵対的なAI攻撃は、最新のシステムにとってセキュリティ上の課題となっている。

AI攻撃とは?AIモデルを欺くデータで「騙す」サイバー攻撃の一種。敵対的ML(Adversarial ML)とも呼ばれ、主に画像分類やスパム検知で報告されている。

次に、敵対的AI攻撃がもたらすさまざまなリスクについて説明しよう。

敵対的AI攻撃がもたらすリスク

によると アレクセイ・ルブツォフ 敵対的機械学習は、MLモデルの脆弱性と特異性を悪用する」。例えば、敵対的なMLは、MLベースの取引アルゴリズムに取引に関する誤った決定をさせる可能性がある。

敵対的AI攻撃はAIやMLシステムにどのようなリスクをもたらすのか?一般的な調査結果をいくつか紹介しよう:

ソーシャルメディア・エンジニアリング この場合、AI攻撃は自動化を用いてソーシャルメディア・プラットフォームのユーザー・プロフィールを「スクレイピング」する。そして、目的のプロフィールを「おびき寄せる」ためのコンテンツを自動的に生成する。

ディープフェイク: 一般的に銀行詐欺で使用されるディープフェイクは、以下のような様々な悪意のある目的を達成することができるオンライン脅威アクターである:

恐喝と強要

個人の信用やイメージを損なうこと

文書詐欺

個人またはグループによる嫌がらせのためのソーシャルメディア

マルウェアの潜伏: ここで脅威者はMLを活用し、一般ユーザーには普通に見える「悪意のある」トラフィックの中にマルウェアを隠す。

パスワード: 敵対的AI攻撃は、大規模なパスワードのセットを分析し、バリエーションを生成することさえできる。言い換えれば、これらの攻撃はパスワードの解読プロセスをより「科学的」にする。パスワードとは別に、MLは脅威行為者がCAPTCHAを解くことも可能にする。

敵対的AI攻撃の例

敵対的AIの例を使えば、ハッカーは単純にAIモデルにミスをさせる攻撃を設計することができる。例えば、有効なモデル入力の破損バージョンなどだ。

ここでは、敵対的AI攻撃で使用される手法の一般的な例をいくつか紹介する:

FastGradient Sign法(FGSM): これは勾配に基づく手法で、画像の誤分類を引き起こすために逆説的なAI例を生成することができる。これは、画像ピクセルに最小限の摂動を加えることによって行われる。

リミテッド・メモリー・ブロイデン・フレッチャー・ゴールドファーブ・シャンノ(L-BFGS): この手法も非線形勾配ベースの数値最適化アルゴリズムであり、画像摂動の回数を最小化することができる。この方法は、逆境的AI例を生成するのに非常に効果的である。

ディープフールの攻撃 これは、誤分類率が高く、摂動が少ない敵対的AI攻撃を生成するのに非常に効果的な別の手法である。この形式の攻撃は、元のサンプルと摂動されたサンプルの間のユークリッド距離を縮めるために、ターゲット化されていない敵対的サンプル生成技術を使用します。

ヤコビアンに基づく顕著性マップ攻撃(JSMA): この種の敵対的AI攻撃では、ハッカーは修正された特徴の数を最小化するために特徴選択を使用し、誤分類を引き起こす。平坦な摂動は、顕著性の値に基づいて、小さい順に特徴に繰り返し追加される。

これらは逆境的AIのほんの一例に過ぎない。次に、逆境的AIの攻撃に対する防御方法について説明しよう。

敵対的AI攻撃から身を守るには

221122 スキムAIインフォグラフィック2 png 01

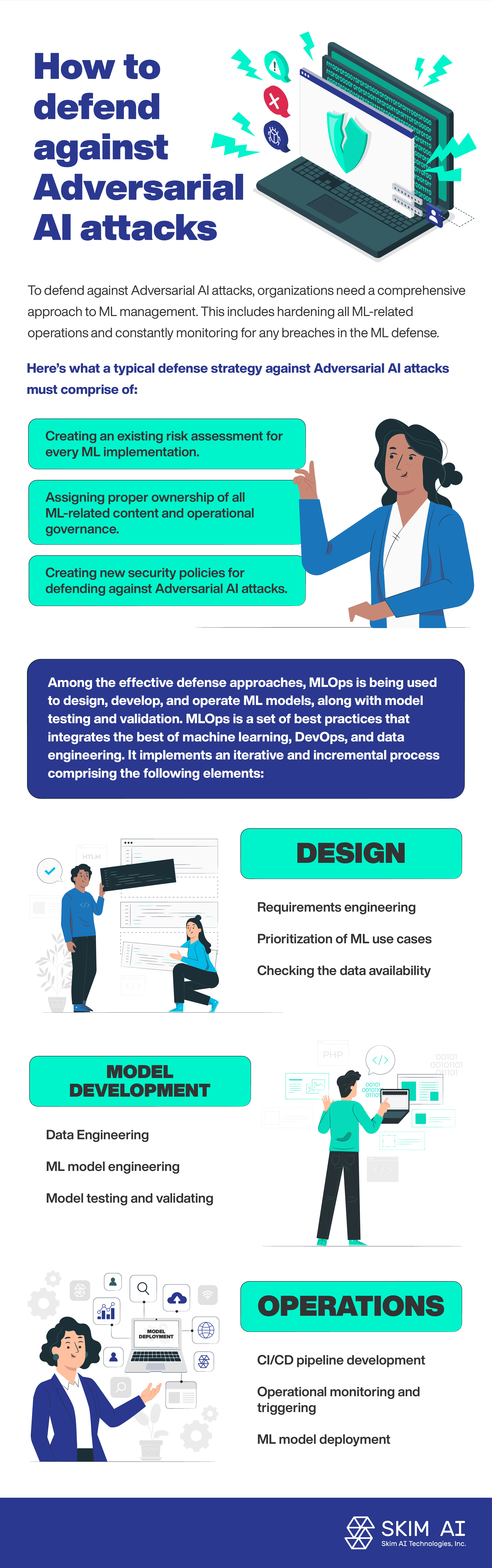

敵対的AI攻撃を防御するために、組織はML管理への包括的なアプローチが必要である。これには、MLに関連するすべてのオペレーションを強化し、ML防御におけるあらゆる違反を常に監視することが含まれる。

敵対的AI攻撃に対する典型的な防御戦略は、以下のようなものだ:

すべてのML導入に対して既存のリスクアセスメントを作成する。

すべてのML関連コンテンツの適切な所有権を割り当て、運営上のガバナンスを行う。

敵対的AI攻撃を防御するための新しいセキュリティポリシーの作成。

効果的な防御アプローチの中で、MLOpsはMLモデルの設計、開発、運用、そしてモデルのテストと検証に利用されている。MLOpsは、機械学習、DevOps、データエンジニアリングの長所を統合したベストプラクティスのセットである。以下の要素からなる反復的かつ漸進的なプロセスを実装している:

デザイン:

要求工学

MLユースケースの優先順位付け

データの可用性をチェックする

モデル開発:

データエンジニアリング

MLモデル工学

モデルのテストと検証

オペレーション

MLモデルの展開

CI/CDパイプライン開発

運用監視とトリガー

結論

アメリカ国家安全保障委員会によると レポート 人工知能に関する研究資金のうち、AIシステムを敵対的攻撃から守るために投資されている割合は低い。AIや機械学習技術の採用が進むにつれて、敵対的なAI攻撃が増加している。事実上、AIとMLシステムは新たな攻撃対象となり、セキュリティ関連のリスクを増大させている。