Qu'est-ce qu'une attaque d'IA accusatoire ?

Qu'est-ce qu'une attaque d'IA accusatoire ?

Les technologies d'apprentissage profond telles que l'intelligence artificielle (IA) et l'apprentissage machine (ML) présentent une série d'avantages pour les entreprises. Dans le même temps, une attaque de l'IA constitue un défi de sécurité croissant pour les systèmes modernes.

Qu'est-ce qu'une attaque d'IA adversive ? Il s'agit d'une forme de cyberattaque qui "trompe" les modèles d'IA à l'aide de données trompeuses. Également connue sous le nom d'Adversarial ML, cette forme d'attaque a été largement signalée dans les domaines de la classification d'images et de la détection de spams.

Ensuite, examinons les différents risques posés par une attaque d'IA adverses.

Risques posés par une attaque de l'IA adverse

Selon le Alexey Rubtsov de l'Institut mondial du risque, "l'apprentissage automatique antagoniste exploite les vulnérabilités et les spécificités des modèles d'apprentissage automatique". Par exemple, l'apprentissage automatique antagoniste peut amener un algorithme de négociation basé sur l'apprentissage automatique à prendre des décisions erronées en matière de négociation.

En quoi une attaque d'IA adversariale représente-t-elle un risque pour les systèmes d'IA et de ML ? Voici quelques constatations courantes :

Ingénierie des médias sociaux : Dans ce cas, l'attaque d'IA "scrape" les profils d'utilisateurs sur les plateformes de médias sociaux en utilisant l'automatisation. Elle génère ensuite automatiquement du contenu pour "appâter" le profil visé.

Les Deepfakes : Généralement utilisés dans les fraudes bancaires, les "deepfakes" sont des acteurs de la menace en ligne qui peuvent atteindre toute une série d'objectifs néfastes :

Chantage et extorsion

Atteinte à la crédibilité et à l'image d'une personne

Fraude documentaire

Médias sociaux pour le harcèlement individuel ou collectif

Dissimulation de logiciels malveillants : Dans ce cas, les acteurs de la menace s'appuient sur la ML pour dissimuler les logiciels malveillants dans un trafic "malveillant" qui semble normal aux yeux des utilisateurs normaux.

Mots de passe : Les attaques d'IA adverses peuvent même analyser un grand nombre de mots de passe et générer des variations. En d'autres termes, ces attaques rendent le processus de craquage des mots de passe plus "scientifique". Outre les mots de passe, l'intelligence artificielle permet également aux acteurs de la menace de résoudre les CAPTCHA.

Exemples d'attaques d'IA adverses

En utilisant des exemples d'IA adverses, les pirates peuvent simplement concevoir une attaque pour amener le modèle d'IA à commettre une erreur. Par exemple, une version corrompue d'une entrée valide du modèle.

Voici quelques exemples de méthodes utilisées dans les attaques d'IA adverses :

Méthode du signe de gradient rapide (FastGradient Sign method - FGSM) : Il s'agit d'une méthode basée sur le gradient qui permet de générer des exemples d'IA adversaires afin de provoquer une mauvaise classification des images. Pour ce faire, elle ajoute une quantité minimale de perturbations au pixel de l'image.

Broyden-Fletcher-Goldfarb-Shanno (L-BFGS) à mémoire limitée : Cette méthode est un autre algorithme d'optimisation numérique non linéaire basé sur le gradient qui peut minimiser le nombre de perturbations de l'image. Cette méthode est extrêmement efficace pour générer des exemples d'intelligence artificielle adverses.

Attaque de Deepfool : Il s'agit d'une autre méthode très efficace pour produire des attaques IA adverses avec un taux élevé de mauvaises classifications et moins de perturbations. Cette forme d'attaque utilise une technique de génération d'échantillons adverses non ciblés pour réduire la distance euclidienne entre les échantillons originaux et les échantillons perturbés.

Attaque par carte de saillance basée sur le jacobien (JSMA) : Dans cette forme d'attaque de l'intelligence artificielle, les pirates utilisent la sélection des caractéristiques pour minimiser le nombre de caractéristiques modifiées, ce qui entraîne une classification erronée. Des perturbations plates sont ajoutées itérativement aux caractéristiques en fonction de la valeur de saillance, par ordre décroissant.

Il ne s'agit là que de quelques exemples d'IA adverses. Voyons maintenant comment se défendre contre les attaques de l'IA adverse.

Comment se défendre contre les attaques de l'intelligence artificielle

221122 skim ai infographic 2 png 01

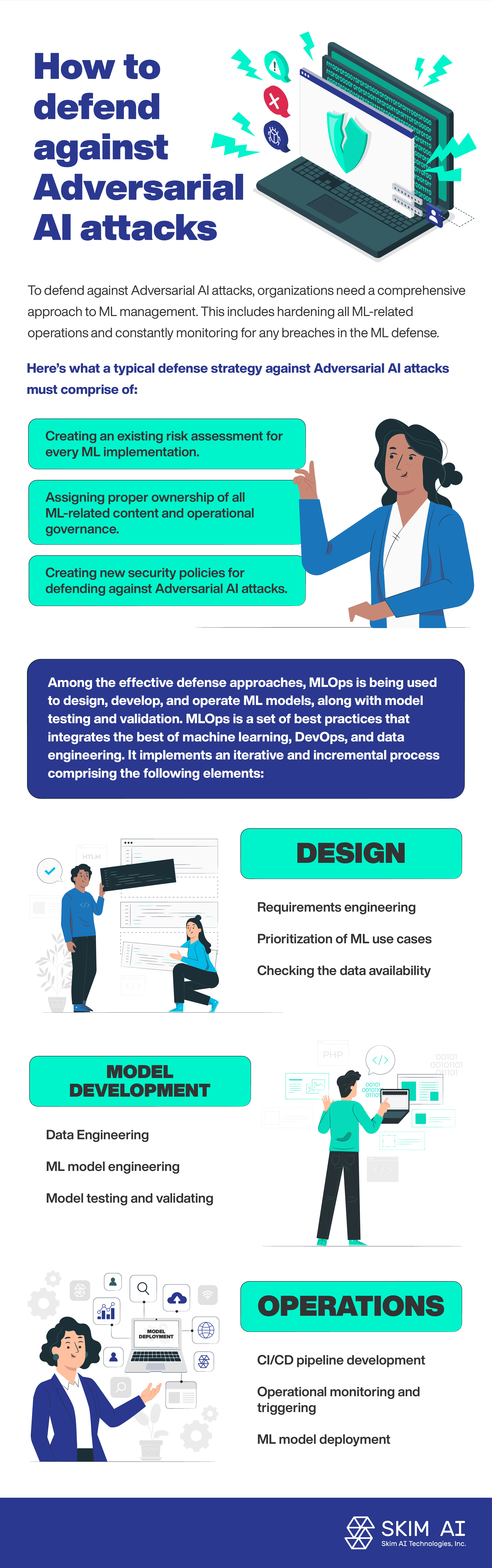

Pour se défendre contre les attaques d'IA adverses, les organisations doivent adopter une approche globale de la gestion de l'intelligence artificielle. Il s'agit notamment de renforcer toutes les opérations liées à l'intelligence artificielle et de surveiller en permanence toute faille dans la défense contre l'intelligence artificielle.

Voici ce que doit comprendre une stratégie de défense typique contre les attaques d'IA adverses :

Création d'une évaluation des risques pour chaque mise en œuvre de la ML.

Attribuer la propriété de tous les contenus liés au ML et la gouvernance opérationnelle.

Création de nouvelles politiques de sécurité pour se défendre contre les attaques de l'intelligence artificielle.

Parmi les approches de défense efficaces, MLOps est utilisé pour concevoir, développer et exploiter des modèles de ML, ainsi que pour tester et valider les modèles. MLOps est un ensemble de bonnes pratiques qui intègre le meilleur de l'apprentissage automatique, du DevOps et de l'ingénierie des données. Il met en œuvre un processus itératif et incrémental comprenant les éléments suivants :

Conception :

Ingénierie des exigences

Priorité aux cas d'utilisation de la ML

Vérification de la disponibilité des données

Développement de modèles :

Ingénierie des données

Ingénierie des modèles ML

Test et validation des modèles

Opérations :

Déploiement du modèle ML

Développement d'un pipeline CI/CD

Surveillance opérationnelle et déclenchement

Conclusion

Selon la Commission nationale de sécurité des États-Unis rapport Dans le domaine de l'intelligence artificielle, un faible pourcentage des fonds consacrés à la recherche sur l'intelligence artificielle est investi dans la défense des systèmes d'intelligence artificielle contre les attaques adverses. L'adoption croissante de l'IA et des technologies d'apprentissage automatique est en corrélation avec l'augmentation des attaques adverses par l'IA. En effet, les systèmes d'IA et d'apprentissage automatique constituent une nouvelle surface d'attaque, ce qui accroît les risques liés à la sécurité.