4 bonnes pratiques pour éviter les interdictions d'API de l'OpenAI et garantir la conformité

Si votre entreprise est impliquée dans l'IA sous quelque aspect que ce soit, la conformité est plus critique que jamais, en particulier lorsqu'elle exploite des modèles d'IA tels que ceux fournis par OpenAI. Ce que beaucoup d'entreprises ne réalisent pas, c'est que le non-respect des politiques d'OpenAI par les utilisateurs peut entraîner l'interdiction de leur accès à l'API, souvent sans avertissement préalable. Pour les entreprises qui gèrent plusieurs utilisateurs, il est essentiel de veiller au respect des politiques d'OpenAI afin de maintenir un accès ininterrompu à ces outils puissants. Le non-respect des conditions peut avoir des conséquences graves, y compris des interdictions qui pourraient perturber considérablement vos activités commerciales.

L'OpenAI a mis en place un ensemble complet de politiques visant à prévenir les abus. Ces politiques protègent non seulement la plateforme, mais garantissent également une utilisation responsable des technologies d'IA dans tous les secteurs. Les entreprises qui utilisent les API d'OpenAI doivent faire preuve de diligence dans la surveillance du comportement des utilisateurs afin d'éviter les violations susceptibles d'entraîner des sanctions ou des interdictions. Comprendre et naviguer efficacement dans ces politiques est la clé du maintien de l'accès et de l'obtention d'un avantage concurrentiel dans l'espace de l'IA.

Comprendre les politiques d'utilisation de l'API d'OpenAI

Les politiques d'utilisation des API de l'OpenAI sont conçues pour protéger l'utilisation éthique et appropriée de l'IA. L'utilisation abusive de ces API, en particulier par le biais de contenus générés par les utilisateurs, peut rapidement conduire à des suspensions ou à des interdictions de compte. Le mauvais comportement d'un utilisateur, tel que la soumission d'un contenu inapproprié ou nuisible, ne viole pas seulement les conditions d'OpenAI, mais met également en danger des comptes entiers.

OpenAI surveille activement les schémas d'utilisation et évalue les actions cachées susceptibles d'enfreindre ses lignes directrices. Par exemple, la soumission de contenu inapproprié ou les tentatives de contournement des filtres de contenu peuvent entraîner des répercussions importantes. OpenAI cache des détails spécifiques sur la manière dont elle évalue les demandes, en maintenant un couvercle serré sur ses processus de modération afin de s'assurer que la conformité est respectée sans compromis. Ce faisant, OpenAI s'assure que ses modèles sont utilisés d'une manière conforme à ses normes éthiques.

Pour éviter ces problèmes, il est essentiel que les développeurs et les entreprises soient proactifs dans l'application des lignes directrices de l'OpenAI et qu'ils tirent parti d'outils intégrés tels que l'interface de l'OpenAI. point final de la modérationqui peut aider à filtrer les contenus potentiellement dangereux avant qu'ils n'atteignent l'API. En comprenant les principaux aspects de l'utilisation abusive et en sachant comment l'OpenAI suit les violations, les entreprises pourront gérer les risques plus efficacement.

Défis posés par les applications multi-utilisateurs

Pour les entreprises qui gèrent des applications avec plusieurs utilisateurs, les risques associés à une mauvaise utilisation de l'API sont nettement plus élevés. Chaque utilisateur peut, par inadvertance ou intentionnellement, violer les politiques de l'OpenAI, ce qui peut avoir des conséquences sur l'ensemble de l'organisation. Il est donc essentiel que les développeurs comprennent les défis uniques posés par les environnements multi-utilisateurs.

La gestion de plusieurs utilisateurs présente des défis spécifiques, tels que des niveaux variables de compréhension de l'utilisation acceptable, une adhésion incohérente aux lignes directrices et la possibilité d'un comportement malveillant de la part d'un petit sous-ensemble d'utilisateurs. Chaque interaction entre les utilisateurs doit être soigneusement contrôlée, car une seule violation peut mettre en péril l'ensemble de l'accès à l'API pour une organisation. En outre, la mise à l'échelle d'une plateforme avec de multiples utilisateurs introduit des complexités pour garantir que tous les utilisateurs sont conformes sans surcharger le système avec des vérifications manuelles.

Contrairement aux modèles d'IA précédents qui étaient peut-être moins stricts, le dernier modèle d'IA d'OpenAI est assorti de lignes directrices plus strictes en matière de conformité, qui font l'objet d'un suivi attentif. Les entreprises doivent prendre la responsabilité de surveiller le contenu généré par les utilisateurs afin de prévenir les violations, ce qui implique la mise en œuvre d'un filtrage automatisé du contenu et de contrôles de conformité. Des mesures proactives telles que l'intégration du point final de modération d'OpenAI, la définition de politiques d'utilisation claires pour les utilisateurs finaux et la fourniture de ressources éducatives aux utilisateurs sur les contenus acceptables peuvent contribuer à atténuer ces risques et à garantir la disponibilité continue de l'API.

En gérant efficacement le comportement des utilisateurs individuels et en mettant en œuvre des outils de surveillance robustes, les entreprises peuvent éviter d'être pénalisées pour les actions de quelques mauvais acteurs. Investir dans des processus et des outils de gestion des utilisateurs ne contribue pas seulement à la conformité, mais crée également un environnement plus digne de confiance pour tous les utilisateurs, soutenant ainsi les objectifs à long terme de l'entreprise en matière d'intégration de l'IA.

Meilleures pratiques pour éviter les interdictions d'API de l'OpenAI

Pour éviter les interdictions et garantir que votre utilisation de l'API reste conforme, il est essentiel de mettre en œuvre des bonnes pratiques spécifiques. Voici quelques stratégies que les développeurs et les entreprises peuvent suivre :

Utiliser le point final de modération : OpenAI fournit un point final de modération gratuit qui aide à identifier les contenus nuisibles avant qu'ils n'atteignent l'API. Cet outil est essentiel pour filtrer les contenus inappropriés et réduire le risque de sanctions.

Limites tarifaires et identificateurs uniques d'utilisateur : La mise en œuvre de limites de taux et l'attribution d'identifiants d'utilisateur uniques à chaque demande d'API peuvent aider à gérer et à tracer le comportement des utilisateurs. En contrôlant le volume des demandes et en les reliant à des utilisateurs individuels, il devient plus facile d'identifier et de restreindre les comptes problématiques.

Surveillance et enregistrement en temps réel : Mettre en place des systèmes de surveillance en temps réel pour suivre l'utilisation de l'API. L'enregistrement de chaque requête permet aux développeurs de vérifier le comportement des utilisateurs et de détecter rapidement les anomalies.

Validation des entrées : Veillez à ce que toutes les entrées soient validées afin d'éviter que des données nuisibles ou inappropriées ne soient traitées par l'API. Une validation correcte des entrées peut atténuer les risques et améliorer la conformité.

Ces pratiques permettent non seulement de minimiser le risque de violation, mais aussi d'offrir aux entreprises un avantage concurrentiel, car elles témoignent d'un engagement en faveur d'une utilisation responsable de l'IA. L'intégration d'une approche structurée de la conformité, y compris l'utilisation des outils intégrés d'OpenAI, peut en fin de compte conduire à une utilisation plus fiable et plus efficace des modèles d'IA.

Comprendre le point final de modération d'OpenAI

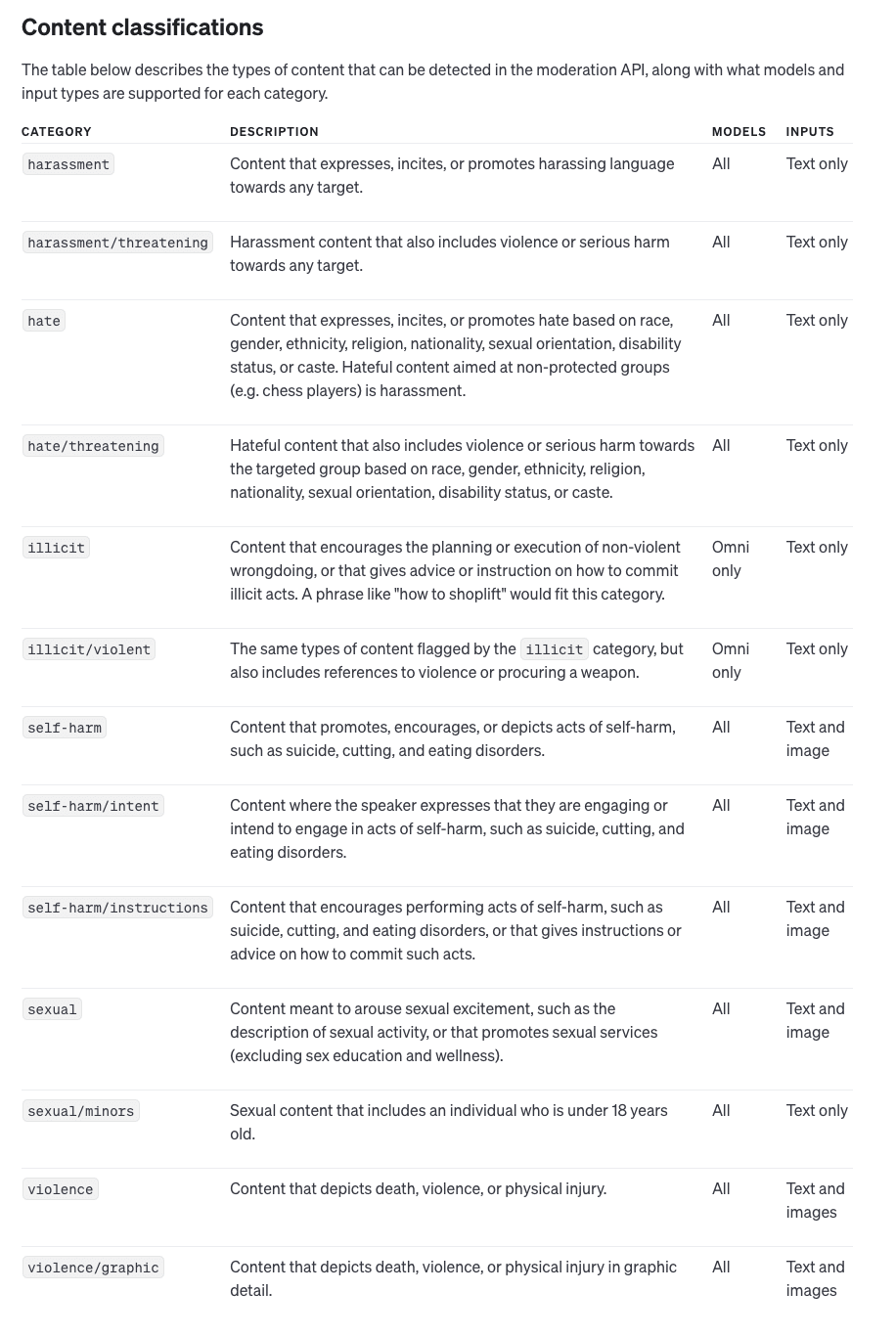

Le point final de modération fourni par OpenAI est un outil essentiel pour s'assurer que les contenus nuisibles ne passent pas dans le système, ce qui permet de maintenir la conformité et d'éviter les interdictions. Le point final peut analyser à la fois les entrées de texte et d'image, en identifiant les catégories potentiellement nuisibles comme la violence, les discours de haine, et plus encore.

Le point final de modération d'OpenAI offre les fonctionnalités suivantes :

Modèle d'omni-modération : Il s'agit de la dernière version et elle prend en charge de multiples options de catégorisation et de multimodal ce qui lui permet de s'adapter à la fois au texte et aux images.

Modération des textes hérités : Les anciens modèles qui ne prennent en charge que les entrées textuelles ont moins de capacités de catégorisation. Toutefois, pour les nouvelles applications, le modèle omni-modération est recommandé.

L'utilisation du point final de modération consiste à transmettre des données d'entrée à l'API d'OpenAI, qui fournit ensuite une réponse détaillée. Cette réponse comprend

Contenu signalé : Le point de terminaison définit un drapeau à true si l'entrée contient un contenu nuisible ou inapproprié.

Catégorie Scores : Un système de notation détaillé qui indique le niveau de confiance du modèle dans sa catégorisation des contenus potentiellement dangereux.

Données spécifiques à la catégorie : Le point d'arrivée fournit une indication des types d'entrée (par exemple, texte ou image) qui ont déclenché la catégorisation, ce qui permet des efforts de modération plus précis.

En mettant en œuvre le point final de modération, les entreprises peuvent prendre des mesures proactives en filtrant les contenus signalés avant qu'ils n'atteignent l'API principale d'OpenAI. Cela permet non seulement de protéger l'intégrité du modèle d'IA, mais aussi de minimiser le risque de violation de la politique qui pourrait conduire à une interdiction de l'API.

Garantir la conformité et l'avantage concurrentiel

La conformité ne consiste pas seulement à éviter les sanctions ; elle peut également constituer un avantage concurrentiel dans le secteur de l'IA. Les entreprises qui adhèrent strictement aux lignes directrices de l'OpenAI sont moins susceptibles de subir des perturbations, ce qui leur permet de fournir des services cohérents et fiables à leurs utilisateurs.

En outre, le fait d'être proactif en matière de conformité signifie que les entreprises peuvent exploiter tout le potentiel des modèles d'IA d'OpenAI. En comprenant le processus de raisonnement derrière les politiques d'OpenAI et en mettant en œuvre les meilleures pratiques, les organisations se positionnent comme des leaders responsables dans l'espace de l'IA. La conformité contribue à instaurer la confiance, tant avec les utilisateurs qu'avec les partenaires de l'industrie, ce qui permet aux entreprises de se différencier de leurs concurrents qui ne sont peut-être pas aussi diligents.

Le bilan

L'utilisation responsable de l'API est essentielle pour maintenir l'accès aux puissants outils de l'OpenAI. Le non-respect des politiques d'OpenAI peut avoir des conséquences graves, y compris des interdictions d'API qui peuvent perturber considérablement vos opérations commerciales. Les développeurs et les entreprises doivent être proactifs dans la gestion du comportement des utilisateurs, la mise en œuvre de stratégies de modération et l'adhésion aux meilleures pratiques pour éviter les violations.

En fin de compte, le respect des lignes directrices de l'OpenAI permet non seulement d'éviter les perturbations, mais aussi de positionner les entreprises en tant que leaders de l'utilisation éthique de l'IA. En démontrant leur engagement en matière de conformité, les organisations peuvent sécuriser leur accès à l'API, renforcer leur avantage concurrentiel et contribuer positivement à l'évolution du secteur de l'IA.