10 bonnes pratiques pour gérer le contenu généré par les utilisateurs avec l'API de l'OpenAI

La gestion du contenu généré par les utilisateurs est cruciale pour maintenir la conformité avec les politiques de l'OpenAI. L'autorisation d'un contenu non contrôlé peut entraîner de graves répercussions, telles que des interdictions d'API, qui peuvent perturber considérablement les opérations. Dans ce blog, nous allons explorer dix bonnes pratiques qui peuvent aider les entreprises à gérer efficacement le contenu généré par les utilisateurs, en garantissant la conformité et la sécurité.

- 1. Utiliser le point final de la modération

- 2. Mettre en place des identifiants uniques pour les utilisateurs

- 3. Sensibiliser les utilisateurs aux lignes directrices en matière de contenu

- 4. Surveiller et enregistrer l'activité des utilisateurs

- 5. Limitation du débit et étranglement

- 6. Traitement des erreurs et retour d'information

- 7. Réviser et mettre à jour régulièrement les politiques

- 8. Utiliser des outils de filtrage automatisés

- 9. Tester l'efficacité de la modération

- 10. S'engager avec le support de l'OpenAI

- Le bilan

1. Utiliser le point final de la modération

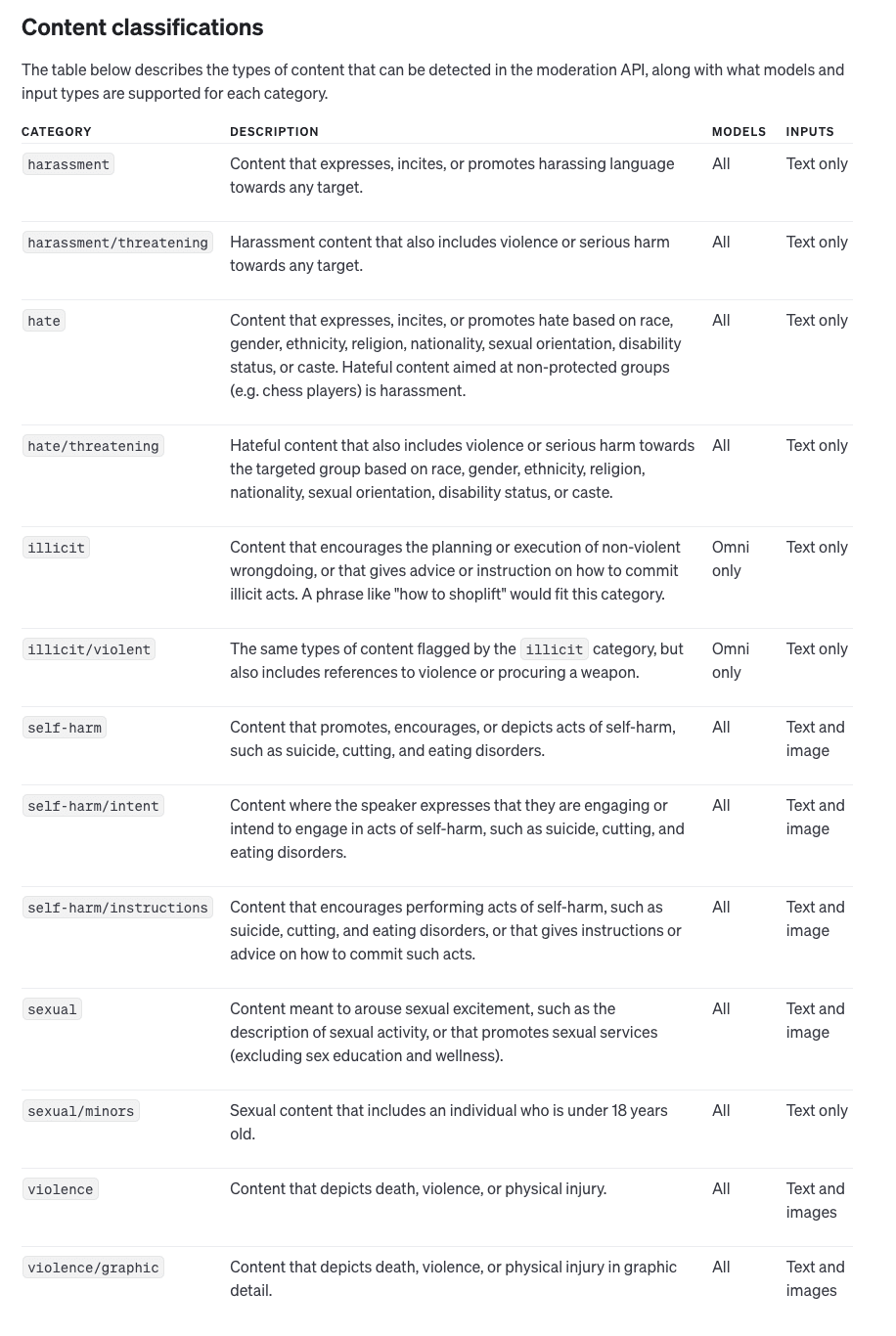

Le point de terminaison de modération d'OpenAI est un outil puissant qui aide à détecter et à filtrer les contenus potentiellement dangereux avant qu'ils n'atteignent l'API. Le point de terminaison peut analyser les entrées de texte et d'image, en identifiant des catégories telles que les discours haineux et la violence. L'intégration de cet outil est simple et implique de vérifier chaque entrée de l'utilisateur par rapport au point de terminaison de modération avant de l'envoyer à l'API principale, ce qui minimise efficacement le risque de violations.

En utilisant le point final de modération de manière proactive, les entreprises peuvent s'assurer qu'elles filtrent les contenus nuisibles le plus tôt possible. Cela permet non seulement de maintenir la conformité avec les politiques d'OpenAI, mais aussi d'offrir une expérience utilisateur plus positive en empêchant la soumission de contenus inappropriés. L'utilisation de ce point final permet aux entreprises de limiter les risques à un stade précoce, réduisant ainsi les chances de recevoir des avertissements ou des interdictions de la part d'OpenAI.

2. Mettre en place des identifiants uniques pour les utilisateurs

Incluant un identifiant unique de l'utilisateur (user_id) dans chaque appel d'API est essentiel pour suivre les utilisateurs individuels. Cela permet à OpenAI d'identifier l'utilisateur qui pourrait être responsable de toute violation de la politique, protégeant ainsi l'ensemble de votre application contre toute pénalisation due aux actions d'un seul utilisateur. Le suivi des utilisateurs fournit également une piste d'audit claire, ce qui facilite l'application de la responsabilité et le maintien de la conformité.

Les identificateurs d'utilisateurs uniques peuvent également vous aider à mettre en œuvre des contrôles de modération plus granulaires. Par exemple, si un utilisateur particulier tente systématiquement de soumettre un contenu nuisible, vous pouvez prendre des mesures pour bloquer ou limiter l'accès de cet utilisateur sans que cela n'ait d'incidence sur les autres. Ce niveau de contrôle garantit que les actions d'un utilisateur ne compromettent pas la disponibilité et la réputation de l'ensemble de votre application.

3. Sensibiliser les utilisateurs aux lignes directrices en matière de contenu

Pour réduire la probabilité de violations, informez vos utilisateurs sur les contenus acceptables. Indiquez clairement les types de contenu qui ne sont pas autorisés, tels que les discours haineux ou les images violentes. En fournissant des directives détaillées sur le contenu, vous pouvez empêcher les utilisateurs de soumettre du matériel préjudiciable, en protégeant l'accès à votre API et en réduisant la nécessité d'interventions de modération.

En plus de publier des lignes directrices sur le contenu, envisagez d'intégrer des messages éducatifs et des rappels dans votre interface utilisateur. En guidant activement les utilisateurs sur les types de contenu appropriés, vous pouvez réduire les violations involontaires. Cette approche proactive permet non seulement de maintenir la conformité, mais aussi de favoriser une culture de création de contenu responsable parmi vos utilisateurs.

4. Surveiller et enregistrer l'activité des utilisateurs

L'enregistrement détaillé des interactions des utilisateurs est un élément essentiel de la gestion des contenus générés par les utilisateurs. En surveillant l'activité des utilisateurs, les entreprises peuvent rapidement identifier des schémas d'utilisation abusive et traiter les problèmes avant qu'ils ne s'aggravent. Les journaux peuvent fournir des preuves cruciales pour traiter le comportement des utilisateurs et peuvent être utilisés pour améliorer les stratégies de modération au fil du temps.

La tenue de registres complets permet également d'améliorer l'audit et la responsabilisation. En cas de violation, le fait de disposer d'un historique bien documenté vous permet de remonter jusqu'à la source et d'identifier exactement où les choses se sont mal passées. Cela permet d'affiner votre approche de la modération et de créer des règles et des filtres plus efficaces pour éviter des problèmes similaires à l'avenir.

5. Limitation du débit et étranglement

Mettre en place des limites de débit pour contrôler les demandes excessives émanant d'utilisateurs individuels. L'étranglement garantit qu'aucun utilisateur ne peut surcharger le système ou soumettre de manière répétée un contenu problématique. Cela permet non seulement de protéger votre API contre les abus, mais aussi de maintenir la stabilité du système et un accès équitable pour tous les utilisateurs.

La limitation du débit peut également servir de mécanisme d'alerte précoce pour identifier les abus potentiels. Par exemple, si un utilisateur commence soudainement à soumettre des requêtes à un taux anormalement élevé, cela peut indiquer un comportement malveillant ou une automatisation tentant d'exploiter votre API. En détectant rapidement ces schémas, vous pouvez atténuer les menaces potentielles avant qu'elles ne conduisent à des violations plus importantes.

6. Traitement des erreurs et retour d'information

Un système robuste de traitement des erreurs est essentiel pour améliorer l'expérience de l'utilisateur tout en assurant la conformité. Lorsqu'une demande est rejetée pour cause de modération, fournissez aux utilisateurs un retour d'information clair et instructif sur les raisons pour lesquelles leur contribution a été refusée. Cela peut les inciter à soumettre des contenus conformes à l'avenir, ce qui permet de réduire la fréquence des violations.

Pour être efficaces, les messages d'erreur doivent non seulement indiquer ce qui n'a pas fonctionné, mais aussi proposer des suggestions constructives sur la manière de corriger l'entrée. Par exemple, si un utilisateur soumet un contenu signalé comme contenant un langage inapproprié, le retour d'information doit l'expliquer et encourager l'utilisateur à reformuler. Cette approche pédagogique aide les utilisateurs à comprendre les exigences de modération et favorise des interactions plus positives avec votre application.

7. Réviser et mettre à jour régulièrement les politiques

Politiques de contenu de l'OpenAI peuvent changer au fil du temps, et il est essentiel de rester informé de ces mises à jour. Passez régulièrement en revue et mettez à jour vos politiques internes et vos stratégies de modération pour les aligner sur les nouvelles lignes directrices. En restant à jour, vous contribuerez à maintenir la conformité et à éviter des sanctions inattendues.

Les politiques internes doivent également être revues en réponse aux incidents. Si vous constatez que certains types de contenus préjudiciables se faufilent, ajustez vos règles et procédures pour combler ces lacunes. Des révisions régulières des politiques garantissent que vous travaillez toujours en conformité avec les dernières attentes de l'OpenAI, minimisant ainsi le risque de violations.

8. Utiliser des outils de filtrage automatisés

En plus du point final de modération d'OpenAI, envisagez d'ajouter des outils de filtrage automatisés qui peuvent présélectionner les entrées des utilisateurs sur la base de critères prédéfinis. Cette couche supplémentaire de filtrage peut contribuer à réduire le nombre de contenus potentiellement dangereux qui atteignent le stade de la modération, ce qui rend le processus de modération plus efficace.

Les outils de filtrage automatisé peuvent être personnalisés pour répondre aux besoins spécifiques de votre application. Par exemple, vous pouvez développer des filtres adaptés à votre base d'utilisateurs, en vous concentrant sur des catégories particulières de contenu qui sont plus susceptibles de poser problème. Ces systèmes automatisés agissent comme une première ligne de défense, permettant aux modérateurs humains ou au point final de modération de l'OpenAI de traiter les cas plus nuancés.

9. Tester l'efficacité de la modération

Testez périodiquement l'efficacité de vos processus de modération en analysant les faux positifs et les faux négatifs. Ajustez vos critères de filtrage et vos algorithmes de modération en fonction de ces informations afin d'améliorer la précision et de vous assurer que les contenus conformes ne sont pas signalés par erreur alors que les contenus nuisibles sont efficacement filtrés.

Le contrôle de l'efficacité de la modération peut également consister à recueillir les commentaires des utilisateurs. Les utilisateurs qui estiment que leur contenu a été signalé à tort peuvent fournir des indications sur les améliorations potentielles à apporter à vos critères de modération. Cette boucle de rétroaction continue permet d'affiner votre système afin de trouver le juste équilibre entre la sécurité et la liberté d'expression.

10. S'engager avec le support de l'OpenAI

Si vous avez des questions sur des cas d'utilisation spécifiques ou si vous avez besoin d'éclaircissements sur les politiques, n'hésitez pas à contacter l'équipe d'assistance d'OpenAI. Leurs avis peuvent être précieux pour adapter les pratiques de modération aux besoins de votre application et garantir que votre utilisation de l'API est toujours conforme.

Faire appel à l'assistance de l'OpenAI peut également s'avérer bénéfique lorsque vous êtes confronté à des zones d'ombre. Si vous n'êtes pas sûr qu'un type particulier de contenu soit autorisé, demander des conseils peut permettre d'éviter des violations potentielles. L'établissement d'une bonne relation avec l'assistance OpenAI vous permettra de disposer d'une source permanente d'expertise pour vous aider à naviguer dans des scénarios de modération complexes.

Le bilan

La gestion efficace du contenu généré par les utilisateurs est essentielle pour maintenir la conformité avec les politiques de l'OpenAI et garantir la sécurité de l'accès à l'API. En suivant ces dix meilleures pratiques, les développeurs et les entreprises peuvent réduire le risque de violations, éviter les pénalités et créer une expérience utilisateur plus positive. Une gestion proactive et l'utilisation des outils de modération d'OpenAI peuvent protéger votre accès et vous aider à tirer pleinement parti de la puissance de l'IA.