Las 10 mejores técnicas para maximizar el rendimiento de la IA

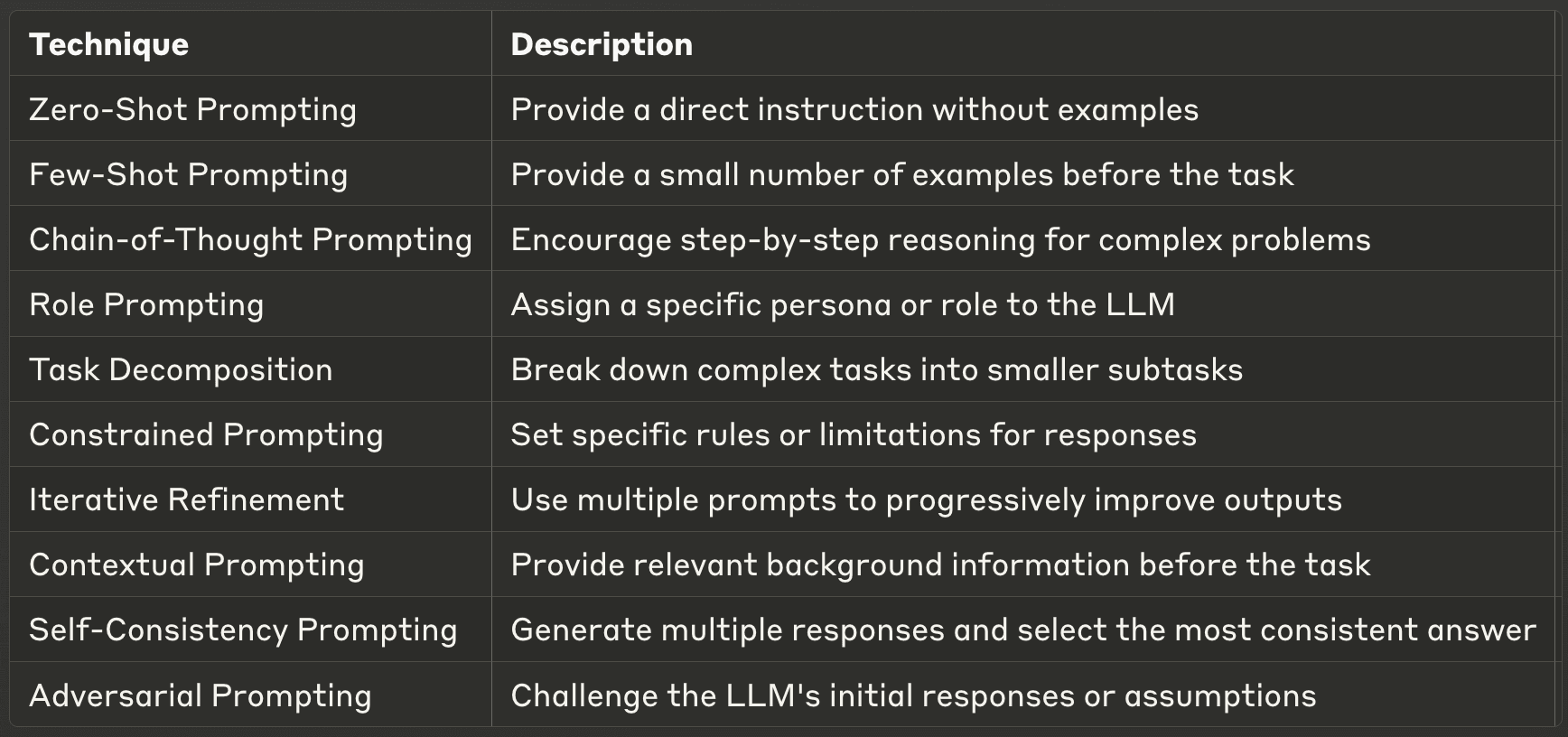

El arte de elaborar instrucciones eficaces para modelos lingüísticos extensos (LLM) se ha convertido en una habilidad crucial para los profesionales de la IA. Unas instrucciones bien diseñadas pueden mejorar significativamente el rendimiento de un LLM, permitiendo resultados más precisos, relevantes y creativos. Esta entrada de blog explora diez de las técnicas más potentes de incitación y ofrece información sobre sus aplicaciones y mejores prácticas. Tanto si eres un desarrollador de IA experimentado como si acabas de empezar con los LLM, estas técnicas te ayudarán a liberar todo el potencial de los modelos de IA.

- 1. Aviso de disparo cero

- 2. Pocos disparos

- 3. Estimulación de la cadena de pensamiento (CoT)

- 4. Función

- 5. Descomposición de tareas

- 6. 6. Preguntar con restricciones

- 7. Refinamiento iterativo

- 8. 8.1.1. Indicaciones contextuales

- 9. Prompting de autoconsistencia

- 10. Estimulación adversarial

- Encontrar las técnicas de ingeniería adecuadas

1. Aviso de disparo cero

El "Zero-shot prompting" es la forma más directa de interactuar con un LLM. En esta técnica, se proporciona una instrucción o pregunta directa sin ningún ejemplo, confiando en el conocimiento preentrenado del modelo para generar una respuesta. Este método pone a prueba la capacidad del LLM para comprender y ejecutar tareas basándose únicamente en la instrucción dada, sin contexto ni ejemplos adicionales.

Las preguntas sin respuesta son especialmente útiles para tareas sencillas y directas o consultas sobre conocimientos generales. Es una forma excelente de evaluar las capacidades básicas de un LLM y puede ser sorprendentemente eficaz para una amplia gama de aplicaciones. Sin embargo, su eficacia puede variar en función de la complejidad de la tarea y de su adecuación a los datos de entrenamiento del modelo. Para obtener los mejores resultados, es fundamental que las instrucciones sean claras y específicas.

Ejemplo: Cuando se utiliza el "zero-shot prompting", se puede preguntar simplemente al LLM: "Explica el concepto de fotosíntesis en términos sencillos". El modelo generaría entonces una explicación basada en su conocimiento preexistente, sin que se le proporcionara ningún contexto o ejemplo adicional.

2. Pocos disparos

La interacción con los LLM va un paso más allá al proporcionar un pequeño número de ejemplos antes de pedir al modelo que realice una tarea. Esta técnica ayuda a orientar el formato y el estilo de la salida del modelo, dándole esencialmente un patrón a seguir. Al demostrar la relación de entrada-salida deseada, las instrucciones de pocos pasos pueden mejorar significativamente el rendimiento del modelo en tareas específicas.

Este método es especialmente eficaz cuando se necesitan formatos de salida coherentes, cuando se trata de tareas específicas de un dominio, o cuando la solicitud de cero disparos produce resultados incoherentes. Los avisos de pocos disparos permiten ajustar el comportamiento del modelo sin necesidad de un entrenamiento o ajuste exhaustivos. Es una forma eficaz de adaptar rápidamente el LLM a su caso de uso específico. Sin embargo, es importante elegir los ejemplos con cuidado, ya que influirán en gran medida en los resultados del modelo.

Ejemplo: En el caso de las preguntas rápidas, puede proporcionar al LLM un par de ejemplos antes de formular la pregunta principal. Por ejemplo:

P: ¿Cuál es la capital de Francia? R: La capital de Francia es París.

P: ¿Cuál es la capital de Japón? R: La capital de Japón es Tokio.

P: ¿Cuál es la capital de Brasil? A:

Al proporcionar estos ejemplos, estás guiando al LLM para que entienda el formato y el tipo de respuesta que buscas, aumentando la probabilidad de recibir una respuesta coherente y precisa.

3. Estimulación de la cadena de pensamiento (CoT)

La inducción de la cadena de pensamiento es una técnica más avanzada que anima a los LLM a dividir los problemas complejos en procesos de razonamiento paso a paso. Este método imita los métodos humanos de resolución de problemas, lo que permite al modelo abordar tareas más complejas que requieren razonamientos o cálculos de varios pasos. Al pedir al LLM que muestre su trabajo, CoT puede mejorar significativamente el rendimiento en tareas complejas y aportar transparencia al proceso de toma de decisiones del modelo.

Las ventajas de las instrucciones CoT van más allá de la mera mejora de la precisión. También mejora la interpretabilidad de los resultados del modelo, facilitando a los humanos la comprensión y verificación del razonamiento que subyace a las respuestas. Esto es especialmente valioso en campos como la educación, donde la comprensión del proceso de resolución de problemas es tan importante como la respuesta final. Sin embargo, hay que tener en cuenta que las indicaciones de CoT pueden ser más intensivas desde el punto de vista computacional y no siempre son necesarias para tareas más sencillas. También es importante tener en cuenta que el CoT ha demostrado ser más eficaz cuando se proporcionan ejemplos muy relevantes y específicos.

Ejemplo: Cuando utilice el estímulo de la cadena de pensamiento, puede plantear una pregunta como la siguiente: "Si una camisa cuesta $25 y está de oferta por 20% de descuento, ¿cuál es el precio final? Por favor, muestre su razonamiento paso a paso". El LLM podría responder con un desglose detallado:

"Abordemos esto paso a paso:

El precio original es $25.

Un descuento de 20% significa que tenemos que calcular 20% de $25.

20% de $25 es $25 × 0,20 = $5.

El importe del descuento es $5.

Para obtener el precio final, restamos el descuento del precio original.

$25 - $5 = $20. Por lo tanto, el precio final de la camisa es $20".

Esta respuesta no sólo proporciona la respuesta correcta, sino que también demuestra el proceso de razonamiento, lo que facilita la verificación y comprensión de la solución.

4. Función

El role prompting es una técnica creativa y poderosa que consiste en asignar un personaje o rol específico al LLM. Este método puede alterar drásticamente el tono, el estilo y el contenido de las respuestas del modelo, permitiéndole adaptar sus resultados a necesidades o escenarios específicos. Al instruir al LLM para que adopte un rol particular, usted puede acceder a diferentes "personalidades" o experiencia dentro de la base de conocimientos del modelo.

Esta técnica es especialmente útil cuando se necesita generar contenidos con una voz o estilo específicos, simular conocimientos de expertos en un campo o crear diversas perspectivas sobre un tema. El role prompting puede dar lugar a respuestas más atractivas y adecuadas al contexto, lo que lo hace valioso para la escritura creativa, la planificación de escenarios o las simulaciones educativas. Sin embargo, es importante recordar que, aunque el LLM puede simular diferentes roles de forma convincente, sus respuestas siguen basándose en sus datos de entrenamiento y no deben considerarse como un asesoramiento experto real sin verificación.

Ejemplo: En cuanto a las instrucciones para el papel, podría instruir al LLM de la siguiente manera: "Como científico climático experimentado, explique los posibles efectos a largo plazo de la subida del nivel del mar en las ciudades costeras". Esta indicación anima al LLM a adoptar la personalidad de un científico del clima, lo que podría conducir a una respuesta más técnica y autorizada sobre el tema.

5. Descomposición de tareas

La descomposición de tareas es un enfoque estratégico que consiste en dividir tareas complejas en subtareas más pequeñas y manejables. Esta técnica aprovecha la capacidad del LLM para manejar piezas discretas de información y combinarlas en un todo cohesivo. Al descomponer una tarea grande, puede guiar al modelo a través de una serie de pasos, asegurándose de que cada componente se aborda de forma exhaustiva y precisa.

Este método es especialmente eficaz para abordar problemas complejos que podrían abrumar al modelo si se le presentaran todos a la vez. Reduce la carga cognitiva del LLM, permitiendo respuestas más centradas y precisas a cada subtarea. La descomposición de tareas también permite manejar mejor los problemas de varios pasos y puede mejorar la calidad general y la exhaustividad del resultado final. Además, este enfoque puede facilitar la identificación y corrección de errores, ya que se puede revisar cada paso individualmente. Al aplicar la descomposición de tareas, es fundamental mantener un flujo lógico claro entre las subtareas para garantizar un resultado final coherente.

Ejemplo: Cuando se utiliza la descomposición de tareas para una tarea compleja, se puede pedir al LLM lo siguiente: "Para escribir un trabajo de investigación exhaustivo sobre energías renovables, vamos a descomponerlo en pasos. Por favor, enumera los pasos principales que debemos seguir, desde definir el alcance hasta finalizar el trabajo".

El LLM podría entonces responder con un desglose como éste:

"1. Definir el ámbito del documento (tipos de energía renovable a cubrir). 2. Esbozar las secciones principales (introducción, estado actual, retos, perspectivas de futuro, conclusión). 3. Para cada sección, enumere los puntos clave a tratar. 4. Investigar y recopilar datos para cada punto. 5. Redactar una introducción que establezca el contexto y los objetivos del documento. 6. Desarrollar cada apartado, incorporando los datos y análisis pertinentes. 7. 7. Resumir los resultados clave y las implicaciones futuras en la conclusión. 8. Revise y perfeccione todo el documento para que sea coherente y fluido. 9. 9. Elaborar una bibliografía de las fuentes utilizadas.

Ahora, empecemos con el paso 1..."

Este desglose permite abordar la compleja tarea de escribir un trabajo de investigación en partes manejables, lo que mejora la calidad general y la integridad del resultado final.

Por supuesto. Continuemos con las secciones restantes de la entrada del blog "10 Best Prompting Techniques for LLMs". Aquí están las secciones 7-10, seguidas de una conclusión y consejos prácticos:

6. 6. Preguntar con restricciones

Los avisos restringidos implican el establecimiento de reglas o limitaciones específicas que el LLM debe seguir en sus respuestas. Esta técnica es particularmente útil cuando se necesita controlar el formato de salida, la longitud o el contenido de las respuestas del modelo. Al establecer explícitamente las restricciones, puede guiar al LLM para que genere salidas más enfocadas y relevantes.

Las restricciones pueden ir desde instrucciones sencillas, como el límite de palabras, hasta requisitos más complejos, como respetar estilos de redacción específicos o evitar determinados temas. Esta técnica es especialmente valiosa en entornos profesionales en los que la coherencia y el cumplimiento de las directrices son cruciales. Sin embargo, es importante equilibrar las restricciones con la flexibilidad para que el LLM pueda aprovechar todas sus capacidades.

Ejemplo: "Haga un resumen de los últimos avances en energías renovables en exactamente 100 palabras. Céntrese solo en la energía solar y eólica, y no mencione empresas ni marcas concretas."

7. Refinamiento iterativo

El refinamiento iterativo es una técnica que implica el uso de múltiples indicaciones para mejorar y refinar progresivamente los resultados del LLM. Este enfoque reconoce que las tareas complejas a menudo requieren múltiples rondas de revisiones y mejoras. Al dividir la tarea en varios pasos y proporcionar retroalimentación en cada etapa, puedes guiar al LLM hacia resultados finales más precisos y pulidos.

Este método es especialmente eficaz para tareas como la escritura, la resolución de problemas o el trabajo creativo, en las que el primer borrador rara vez es perfecto. El perfeccionamiento iterativo permite aprovechar los puntos fuertes del LLM y mantener el control sobre la dirección y la calidad del resultado. Es importante ser claro y específico con tus comentarios en cada iteración para garantizar una mejora continua.

Ejemplo: Paso 1: "Redacta un breve esquema para un artículo sobre el impacto de la inteligencia artificial en la atención sanitaria." Paso 2: "A partir de este esquema, amplía la sección sobre la IA en el diagnóstico médico." Paso 3: "Ahora, añade a esta sección ejemplos concretos de aplicaciones de la IA en radiología."

8. 8.1.1. Indicaciones contextuales

La incitación contextual consiste en proporcionar información de fondo o contexto relevante al LLM antes de pedirle que realice una tarea. Esta técnica ayuda al modelo a comprender el panorama general y a generar respuestas más precisas y pertinentes. Al preparar el escenario con el contexto apropiado, puede mejorar significativamente la calidad y especificidad de los resultados del LLM.

Este método es particularmente útil cuando se trata de temas especializados, escenarios únicos o cuando necesitas que el LLM considere información específica que puede no formar parte de su conocimiento general. Las indicaciones contextuales pueden ayudar a salvar la distancia entre los conocimientos generales del LLM y los requisitos específicos de su tarea.

Ejemplo: "Contexto: La ciudad de Ámsterdam ha puesto en marcha varias iniciativas ecológicas para ser más sostenible. Teniendo en cuenta esta información, sugiera tres ideas innovadoras de planificación urbana que podrían mejorar aún más los esfuerzos de sostenibilidad de Ámsterdam."

9. Prompting de autoconsistencia

La petición de autoconsistencia es una técnica avanzada que consiste en generar múltiples respuestas a la misma petición y seleccionar después la respuesta más coherente o fiable. Este método aprovecha la naturaleza probabilística de los LLM para mejorar la precisión, especialmente en tareas que requieren razonamiento o resolución de problemas.

Al comparar múltiples resultados, la autoconsistencia puede ayudar a identificar y filtrar las incoherencias o errores que puedan producirse en las respuestas individuales. Esta técnica es especialmente valiosa para aplicaciones críticas en las que la precisión es primordial. Sin embargo, requiere más tiempo y recursos informáticos que los métodos de respuesta única.

Ejemplo: "Resuelve el siguiente problema matemático: Si un tren viaja a 100 km/h durante 2,5 horas, ¿qué distancia recorre? Genera cinco soluciones independientes y luego elige la respuesta más coherente".

10. Estimulación adversarial

La provocación adversarial es una técnica que consiste en cuestionar las respuestas o suposiciones iniciales del LLM para mejorar la calidad, precisión y solidez de sus resultados. Este método simula un debate o un proceso de pensamiento crítico, empujando al modelo a considerar puntos de vista alternativos, posibles fallos en su razonamiento o factores pasados por alto.

El enfoque contradictorio consiste en pedir primero al LLM que proporcione una respuesta o solución inicial y, a continuación, pedirle que critique o cuestione su propia respuesta. Este proceso puede repetirse varias veces, refinando y reforzando el resultado final en cada iteración. La orientación adversarial es especialmente útil para resolver problemas complejos, tomar decisiones o tratar temas controvertidos o polifacéticos.

Esta técnica ayuda a mitigar posibles sesgos en las respuestas del modelo y fomenta unos resultados más exhaustivos y equilibrados. Sin embargo, requiere una formulación cuidadosa de las preguntas para garantizar una crítica productiva en lugar de una simple contradicción.

Ejemplo: Paso 1: "Proponga una solución para reducir la congestión del tráfico urbano". Paso 2: "Ahora, identifica tres posibles inconvenientes o retos para la solución que acabas de proponer." Paso 3: "Teniendo en cuenta estos retos, perfeccione su solución original o proponga un enfoque alternativo." Paso 4: "Por último, compara los puntos fuertes y débiles de tus soluciones original y refinada, y recomienda el mejor curso de acción."

Encontrar las técnicas de ingeniería adecuadas

Dominar estas técnicas de orientación puede mejorar significativamente su capacidad para trabajar eficazmente con los LLM. Cada método ofrece ventajas únicas y se adapta a distintos tipos de tareas y escenarios. Al comprender y aplicar estas técnicas, los profesionales de la IA pueden liberar todo el potencial de los LLM y obtener resultados más precisos, creativos y útiles.

A medida que el campo de la IA siga evolucionando, también lo harán las estrategias de incitación. Mantenerse informado sobre los nuevos avances y experimentar continuamente con diferentes técnicas será crucial para cualquiera que trabaje con LLM. Recuerde que el arte de la incitación consiste tanto en comprender las capacidades y limitaciones del modelo como en elaborar la entrada perfecta.