Las 10 mejores formas de eliminar las alucinaciones del LLM

A medida que los grandes modelos lingüísticos (LLM) siguen trastornando casi todos los campos e industrias, traen consigo un reto único: las alucinaciones. Estas imprecisiones generadas por la IA suponen un riesgo importante para la fiabilidad de los resultados de los LLM.

¿Qué son las alucinaciones LLM?

Las alucinaciones de los LLM se producen cuando estos potentes modelos lingüísticos generan texto incorrecto, sin sentido o sin relación con los datos de entrada. A pesar de parecer coherente y seguro, el contenido alucinado puede llevar a la desinformación, a la toma de decisiones erróneas y a la pérdida de confianza en las aplicaciones basadas en IA.

A medida que los sistemas de IA integrar en varios aspectos de nuestras vidas, desde chatbots de atención al cliente hasta herramientas de creación de contenidosla necesidad de mitigar las alucinaciones se convierte en primordial. Las alucinaciones no controladas pueden causar daños a la reputación, problemas legales y posibles perjuicios a los usuarios que confían en la información generada por la IA.

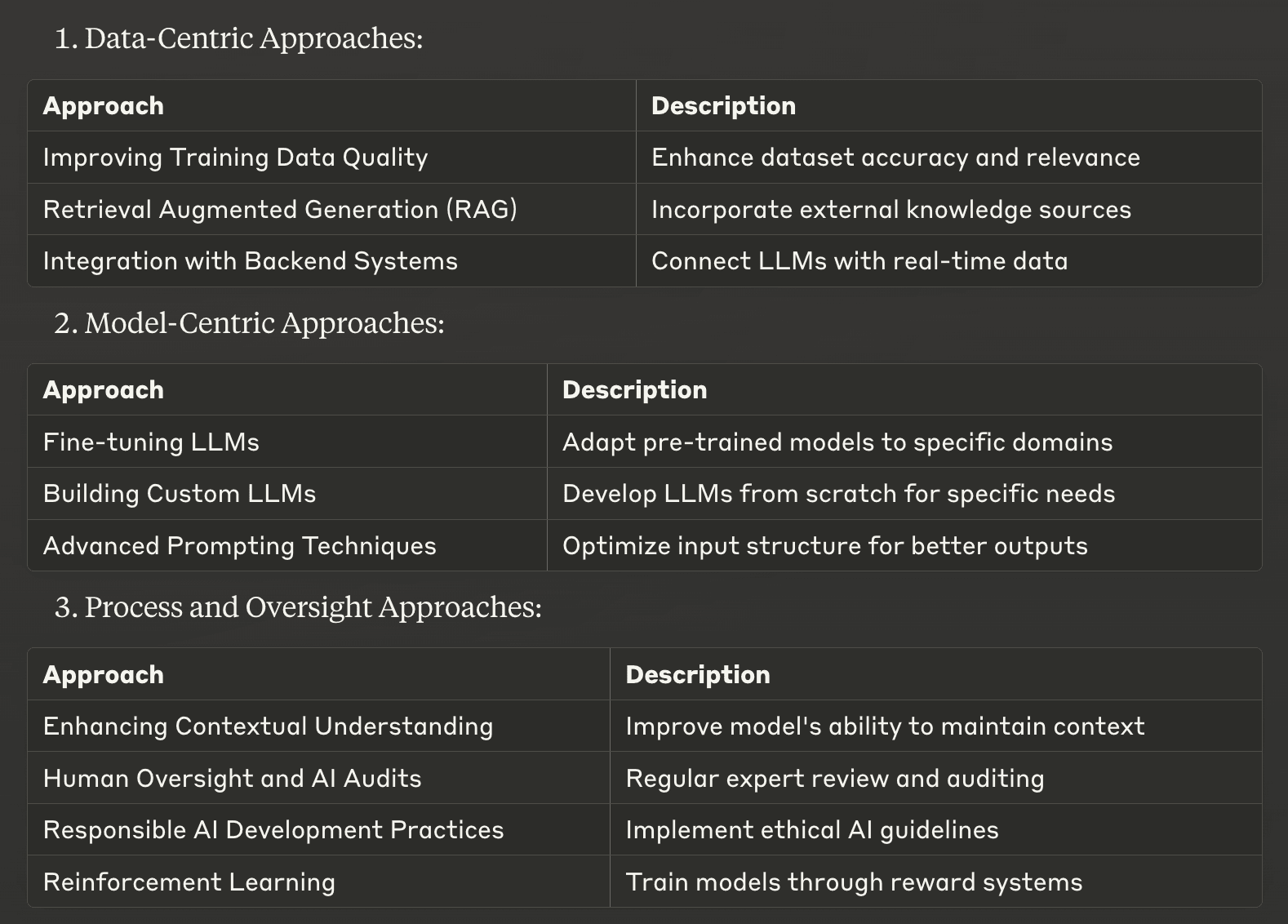

Hemos recopilado una lista de las 10 mejores estrategias para mitigar las alucinaciones LLM, desde enfoques centrados en los datos hasta técnicas centradas en modelos y métodos orientados a procesos. Estas estrategias están diseñadas para ayudar a empresas y desarrolladores a mejorar la precisión de los hechos y la fiabilidad de sus sistemas de IA.

Enfoques centrados en los datos

1. Mejorar la calidad de los datos de formación

Una de las formas más fundamentales de mitigar las alucinaciones es mejorar la calidad de los datos de entrenamiento utilizados para desarrollar grandes modelos lingüísticos. Unos conjuntos de datos de alta calidad, diversos y bien seleccionados pueden reducir significativamente la probabilidad de que los LLM aprendan y reproduzcan información inexacta.

Para aplicar esta estrategia, céntrate en:

Comprobación minuciosa de la exactitud y pertinencia de las fuentes de datos

Garantizar una representación equilibrada de temas y perspectivas

Actualización periódica de los conjuntos de datos para incluir información actual

Eliminación de datos duplicados o contradictorios

Al invertir en datos de entrenamiento superiores, se sientan unas bases sólidas para obtener resultados LLM más fiables y precisos.

2. Generación Aumentada de Recuperación (RAG)

Generación de Recuperación Aumentada (RAG) es una potente técnica que combina los puntos fuertes de los enfoques basados en la recuperación y en la generación. Este método permite a los LLM acceder e incorporar información relevante de fuentes de conocimiento externas durante el proceso de generación de textos.

RAG trabaja por:

Recuperación de información pertinente de una base de conocimientos conservada

Incorporar esta información al contexto proporcionado al LLM

Generar respuestas basadas en información objetiva y actualizada.

Aplicando la GAR, las empresas pueden reducir significativamente las alucinaciones anclando las respuestas LLM a fuentes de información fiables y externas. Este enfoque es especialmente eficaz para aplicaciones de dominios específicos en las que la precisión es crucial, como en los sistemas de IA jurídica o médica.

3. Integración con sistemas backend

La integración de los LLM con los sistemas backend existentes de una empresa puede mejorar drásticamente la precisión y relevancia de los contenidos generados por IA. Este enfoque permite al LLM acceder en tiempo real a datos específicos del contexto directamente desde las bases de datos o API de la empresa.

Entre las principales ventajas de la integración de backend se incluyen:

Garantizar que las respuestas se basan en la información más actualizada.

Resultados personalizados y contextualizados

Reducción de la dependencia de datos de formación potencialmente obsoletos

Por ejemplo, un chatbot de comercio electrónico integrado con el sistema de inventario de la empresa puede proporcionar información precisa y en tiempo real sobre la disponibilidad de productos, reduciendo el riesgo de respuestas alucinadas sobre niveles de existencias o precios.

Mediante la aplicación de estos enfoques centrados en los datos, las empresas pueden mejorar significativamente la fiabilidad de los resultados de sus LLM, mitigando el riesgo de alucinaciones y mejorando el rendimiento general del sistema de IA.

Enfoques centrados en modelos

4. Ajuste de los LLM

El ajuste fino es una potente técnica para adaptar grandes modelos lingüísticos preentrenados a dominios o tareas específicos. Este proceso consiste en seguir entrenando el LLM en un conjunto de datos más pequeño y cuidadosamente seleccionado que sea relevante para la aplicación de destino. El ajuste fino puede reducir significativamente las alucinaciones al alinear los resultados del modelo con el conocimiento y la terminología específicos del dominio.

Las principales ventajas del ajuste fino son:

Mayor precisión en campos especializados

Mejor comprensión de la jerga específica del sector

Menor probabilidad de generar información irrelevante o incorrecta

Por ejemplo, un asistente jurídico de IA perfeccionado con un corpus de documentos jurídicos y jurisprudencia tendrá menos probabilidades de alucinar al responder a consultas jurídicas, lo que mejorará su fiabilidad y utilidad en el ámbito legal.

5. Creación de LLM personalizados

Para las organizaciones con recursos considerables y necesidades específicas, la creación desde cero de grandes modelos lingüísticos personalizados puede ser una forma eficaz de mitigar las alucinaciones. Este enfoque permite controlar por completo los datos de entrenamiento, la arquitectura del modelo y el proceso de aprendizaje.

Ventajas de LLM personalizados incluyen:

Base de conocimientos adaptada a las necesidades de la empresa

Menor riesgo de incorporar información irrelevante o inexacta

Mayor control sobre el comportamiento y los resultados del modelo

Aunque este enfoque requiere importantes recursos informáticos y conocimientos especializados, puede dar lugar a sistemas de IA muy precisos y fiables dentro de su ámbito de actuación previsto.

6. Técnicas avanzadas de incitación

Unas técnicas sofisticadas pueden guiar a los modelos lingüísticos para que generen textos más precisos y coherentes, reduciendo así las alucinaciones. Estos métodos ayudan a estructurar la entrada de modo que el sistema de IA genere resultados más fiables.

Algunas técnicas eficaces de incitación son

Incitación a la cadena de pensamiento: Fomenta el razonamiento paso a paso

Aprendizaje de pocos disparos: Ofrece ejemplos para orientar las respuestas del modelo

Mediante la elaboración cuidadosa de las instrucciones, los desarrolladores pueden mejorar significativamente la precisión y relevancia de los contenidos generados por LLM, minimizando la aparición de alucinaciones.

Proceso y enfoques de supervisión

7. Mejorar la comprensión del contexto

Mejorar la capacidad de un LLM para mantener el contexto a lo largo de una interacción puede reducir en gran medida las alucinaciones. Para ello hay que aplicar técnicas que ayuden al modelo a seguir y utilizar información relevante en conversaciones largas o tareas complejas.

Entre las estrategias clave figuran:

Resolución de coreferencias: Ayudar al modelo a identificar y vincular entidades relacionadas

Seguimiento del historial de conversaciones: Garantizar la consideración de los intercambios anteriores

Modelización avanzada del contexto: Permitir que el modelo se centre en la información pertinente

Estas técnicas ayudan a los LLM a mantener la coherencia y consistencia, reduciendo la probabilidad de generar información contradictoria o irrelevante.

8. Supervisión humana y auditorías de IA

La supervisión humana y la realización periódica de auditorías de IA son cruciales para identificar y abordar las alucinaciones en los resultados del LLM. Este enfoque combina la experiencia humana con las capacidades de la IA para garantizar el máximo nivel de precisión y fiabilidad.

Las prácticas de supervisión eficaces incluyen:

Revisión periódica de los contenidos generados por IA por expertos en la materia

Aplicación de circuitos de retroalimentación para mejorar el rendimiento de los modelos

Realización de auditorías exhaustivas para identificar patrones de alucinación

Al mantener la participación humana en el proceso de IA, las organizaciones pueden detectar y corregir alucinaciones que de otro modo pasarían desapercibidas, mejorando la fiabilidad general de sus sistemas de IA.

9. Prácticas responsables de desarrollo de la IA

Adoptar prácticas de desarrollo de IA responsables es esencial para crear LLM menos propensos a las alucinaciones. Este enfoque hace hincapié en las consideraciones éticas, la transparencia y la responsabilidad a lo largo de todo el ciclo de vida de desarrollo de la IA.

Entre los aspectos clave del desarrollo responsable de la IA se incluyen:

Prioridad a la imparcialidad y a los datos de formación no sesgados

Implantación de procesos sólidos de prueba y validación

Garantizar la transparencia en los procesos de toma de decisiones sobre IA

Siguiendo estos principios, las organizaciones pueden desarrollar sistemas de IA más fiables, dignos de confianza y con menos probabilidades de producir resultados dañinos o engañosos.

10. Aprendizaje por refuerzo

El aprendizaje por refuerzo ofrece un enfoque prometedor para mitigar las alucinaciones en los LLM. Esta técnica consiste en entrenar modelos mediante un sistema de recompensas y penalizaciones, fomentando los comportamientos deseados y desalentando los no deseados.

Beneficios del aprendizaje por refuerzo en la mitigación de alucinaciones:

Alineación de los resultados del modelo con objetivos específicos de precisión

Mejorar la capacidad de autocorrección del modelo

Mejora de la calidad y fiabilidad generales del texto generado

Aplicando técnicas de aprendizaje por refuerzo, los desarrolladores pueden crear LLM más hábiles para evitar alucinaciones y producir contenidos veraces.

Estos enfoques centrados en el modelo y orientados al proceso proporcionan potentes herramientas para mitigar las alucinaciones en grandes modelos lingüísticos. Combinando estas estrategias con los enfoques centrados en los datos comentados anteriormente, las organizaciones pueden mejorar significativamente la fiabilidad y precisión de sus sistemas de IA, allanando el camino para aplicaciones de IA más fiables y eficaces.

Aplicación de estrategias eficaces para mitigar las alucinaciones

Como hemos explorado las 10 formas principales de mitigar las alucinaciones en los grandes modelos lingüísticos, está claro que abordar este reto es crucial para desarrollar sistemas de IA fiables. La clave del éxito reside en la aplicación meditada de estas estrategias, adaptadas a sus necesidades y recursos específicos. A la hora de elegir el enfoque adecuado, tenga en cuenta sus requisitos específicos y los tipos de alucinaciones con los que se encuentra. Algunas estrategias, como la mejora de la calidad de los datos de entrenamiento, pueden ser sencillas de adoptar, mientras que otras, como la creación de LLM personalizados, pueden requerir inversiones significativas.

Es esencial encontrar un equilibrio entre la eficacia y los recursos necesarios. A menudo, una combinación de estrategias proporciona la solución óptima, permitiéndole aprovechar múltiples enfoques a la vez que gestiona las limitaciones. Por ejemplo, la combinación de la GAR con técnicas avanzadas de incitación puede producir mejoras significativas sin necesidad de un reentrenamiento exhaustivo del modelo.

A medida que la inteligencia artificial siga evolucionando, también lo harán los métodos para mitigar las alucinaciones. Si se mantiene informado sobre los últimos avances y perfecciona continuamente su enfoque, podrá asegurarse de que sus sistemas de IA se mantienen a la vanguardia de la precisión y la fiabilidad. Recuerde, el objetivo no es sólo generar texto, sino crear resultados LLM en los que los usuarios puedan confiar y de los que puedan depender, allanando el camino para aplicaciones de IA más eficaces y responsables en diversos sectores.

Si necesitas ayuda para mitigar las alucinaciones del LLM, no dudes en ponerte en contacto con nosotros en Skim AI.