Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- El reto de la escasez de datos en la IA

- Aprendizaje de pocos disparos frente al aprendizaje supervisado tradicional

- El espectro del aprendizaje eficaz por muestreo

- Few Shot Prompting vs Fine Tuning LLM

- Pocos estímulos: Liberar el potencial del LLM

- Ajuste fino de los LLM: Adaptación de modelos con datos limitados

- Pocos disparos o ajuste fino: Elegir el enfoque adecuado

- Top 5 Research Papers for Few-Shot Learning

- Lo esencial

- ¡Gracias por tomarse el tiempo de leer AI & YOU!

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

La estadística de la semana: Research by MobiDev on few-shot learning for coin image classification found that using just 4 image examples per coin denomination, they could achieve ~70% accuracy.

In AI, the ability to learn efficiently from limited data has become crucial. That’s why it’s important for enterprises to understand few-shot learning, few-shot prompting, and fine-tuning LLMs.

En la edición de esta semana de AI&YOU, exploramos las ideas de tres blogs que hemos publicado sobre estos temas:

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

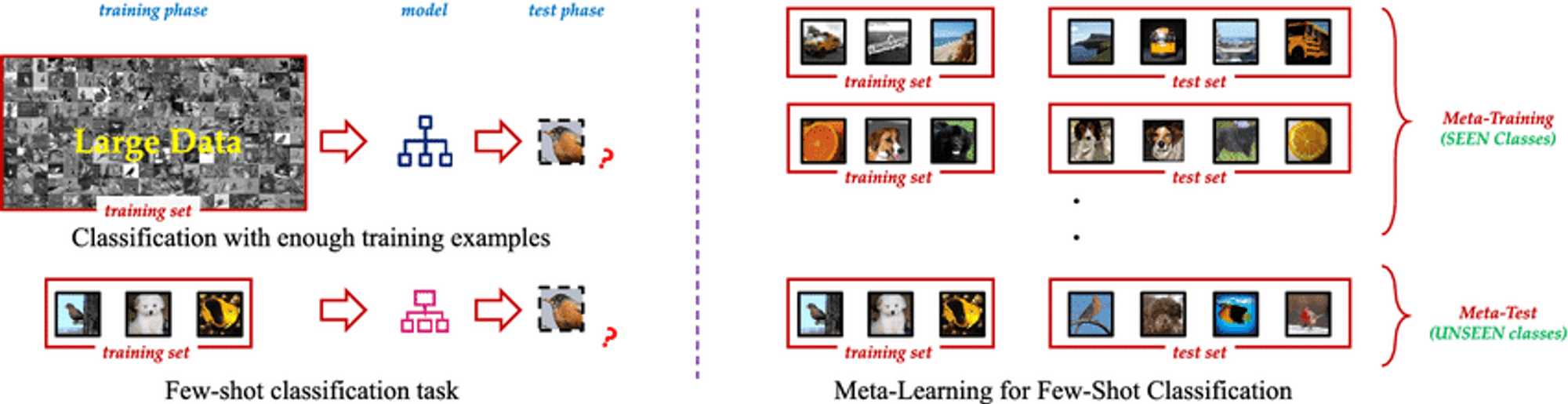

Few Shot Learning is an innovative machine learning paradigm that enables AI models to learn new concepts or tasks from only a few examples. Unlike traditional supervised learning methods that require vast amounts of labeled training data, Few Shot Learning techniques allow models to generalize effectively using just a small number of samples. This approach mimics the human ability to quickly grasp new ideas without the need for extensive repetition.

La esencia del aprendizaje de pocos disparos reside en su capacidad para aprovechar los conocimientos previos y adaptarse rápidamente a nuevos escenarios. Gracias a técnicas como el metaaprendizaje, en el que el modelo "aprende a aprender", los algoritmos de Few Shot Learning pueden abordar una amplia gama de tareas con una formación adicional mínima. Esta flexibilidad lo convierte en una herramienta inestimable en situaciones en las que los datos son escasos, caros de obtener o están en constante evolución.

El reto de la escasez de datos en la IA

No todos los datos son iguales, y los datos etiquetados de alta calidad pueden ser un bien escaso y preciado. Esta escasez supone un reto importante para los métodos tradicionales de aprendizaje supervisado, que suelen requerir miles o incluso millones de ejemplos etiquetados para lograr un rendimiento satisfactorio.

El problema de la escasez de datos es especialmente grave en ámbitos especializados como la sanidad, donde las enfermedades raras pueden tener pocos casos documentados, o en entornos que cambian rápidamente y en los que surgen con frecuencia nuevas categorías de datos. En estos casos, el tiempo y los recursos necesarios para recopilar y etiquetar grandes conjuntos de datos pueden ser prohibitivos, lo que crea un cuello de botella en el desarrollo y la implantación de la IA.

Aprendizaje de pocos disparos frente al aprendizaje supervisado tradicional

Understanding the distinction between Few Shot Learning and traditional supervised learning is crucial to grasp its real-world impact.

Tradicional aprendizaje supervisado, while powerful, has drawbacks:

Dependencia de datos: Struggles with limited training data.

Inflexibilidad: Performs well only on specific trained tasks.

Intensidad de recursos: Requires large, expensive datasets.

Actualización continua: Needs frequent retraining in dynamic environments.

Few Shot Learning offers a paradigm shift:

Eficiencia de la muestra: Generalizes from few examples using meta-learning.

Adaptación rápida: Quickly adapts to new tasks with minimal examples.

Optimización de recursos: Reduces data collection and labeling needs.

Aprendizaje continuo: Suitable for incorporating new knowledge without forgetting.

Versatilidad: Applicable across various domains, from computer vision to NLP.

By tackling these challenges, Few Shot Learning enables more adaptable and efficient AI models, opening new possibilities in AI development.

El espectro del aprendizaje eficaz por muestreo

A fascinating spectrum of approaches aims to minimize required training data, including Zero Shot, One Shot, and Few Shot Learning.

Aprendizaje sin ejemplos: Aprender sin ejemplos

Recognizes unseen classes using auxiliary information like textual descriptions

Valuable when labeled examples for all classes are impractical or impossible

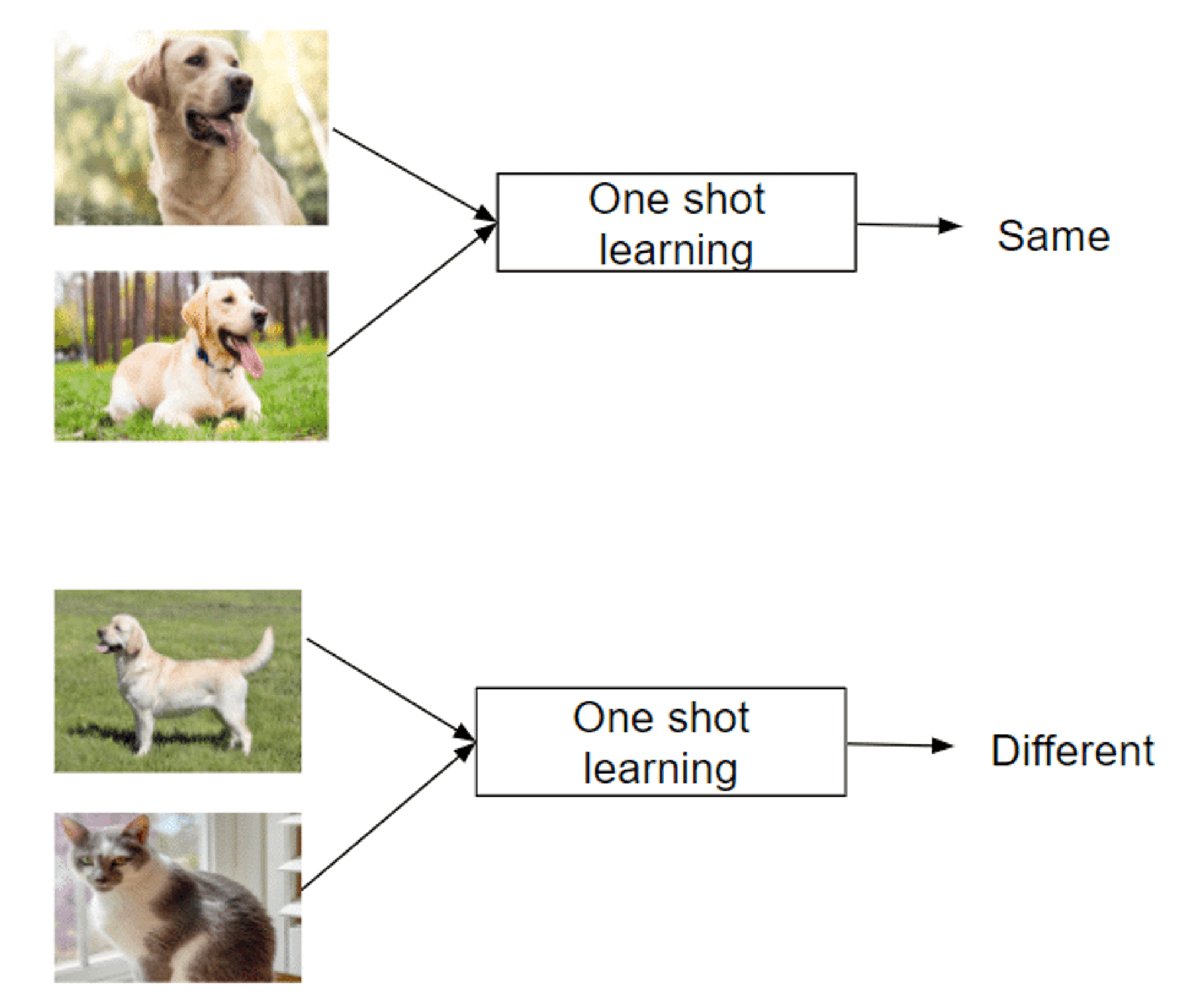

Aprendizaje único: Aprendizaje a partir de una sola instancia

Recognizes new classes from just one example

Mimics human ability to grasp concepts quickly

Successful in areas like facial recognition

Aprendizaje con pocos datos: Dominar tareas con datos mínimos

Uses 2-5 labeled examples per new class

Balances extreme data efficiency and traditional methods

Enables rapid adaptation to new tasks or classes

Leverages meta-learning strategies to learn how to learn

This spectrum of approaches offers unique capabilities in tackling the challenge of learning from limited examples, making them invaluable in data-scarce domains.

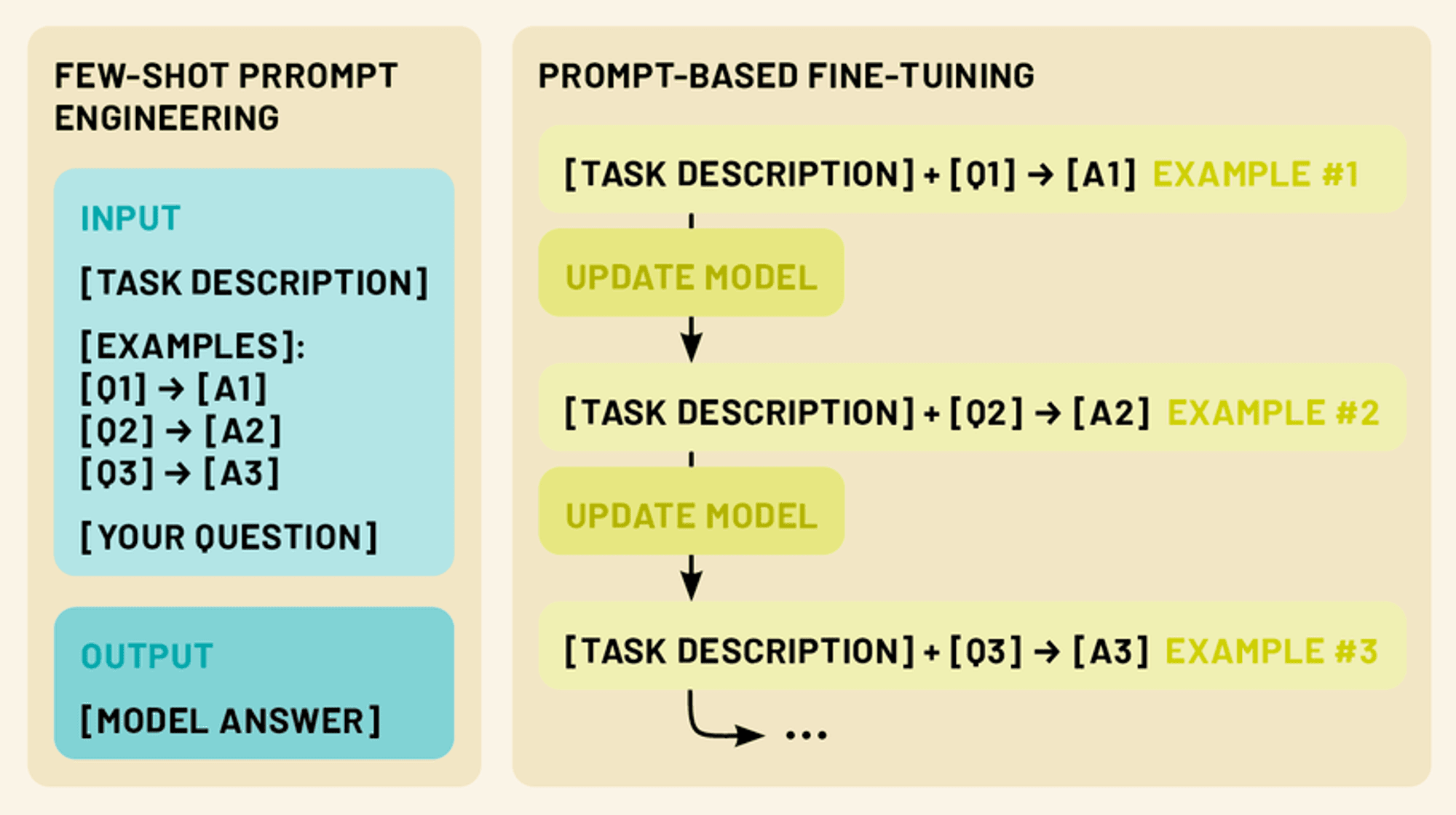

Few Shot Prompting vs Fine Tuning LLM

Two more powerful techniques exist in this realm: few-shot prompting and fine-tuning. Few-shot prompting involves crafting clever input prompts that include a small number of examples, guiding the model to perform a specific task without any additional training. Fine-tuning, on the other hand, involves updating the model’s parameters using a limited amount of task-specific data, allowing it to adapt its vast knowledge to a particular domain or application.

Both approaches fall under the umbrella of few-shot learning. By leveraging these techniques, we can dramatically enhance the performance and versatility of LLMs, making them more practical and effective tools for a wide range of applications in natural language processing and beyond.

Pocos estímulos: Liberar el potencial del LLM

Few-shot prompting capitalizes on the model’s ability to understand instructions, effectively “programming” the LLM through crafted prompts.

Few-shot prompting provides 1-5 examples demonstrating the desired task, leveraging the model’s pattern recognition and adaptability. This enables performance of tasks not explicitly trained for, tapping into the LLM’s capacity for in-context learning.

By presenting clear input-output patterns, few-shot prompting guides the LLM to apply similar reasoning to new inputs, allowing quick adaptation to new tasks without parameter updates.

Tipos de avisos de pocos disparos (cero disparos, un disparo, pocos disparos)

Few-shot prompting encompasses a spectrum of approaches, each defined by the number of examples provided. (Just like few-shot learning):

Aparición sin disparos: En este escenario, no se proporcionan ejemplos. En su lugar, el modelo recibe una instrucción o descripción clara de la tarea. Por ejemplo: "Traduzca el siguiente texto inglés al francés: [texto de entrada]".

Una sola vez: En este caso, se proporciona un único ejemplo antes de la entrada real. De este modo, el modelo dispone de un ejemplo concreto de la relación entrada-salida prevista. Por ejemplo: "Clasifica el sentimiento de la siguiente crítica como positivo o negativo. Ejemplo: '¡Esta película es fantástica!' - Entrada positiva: 'No pude soportar el argumento'. - [el modelo genera la respuesta]".

Pocos indicios: Este enfoque proporciona múltiples ejemplos (normalmente 2-5) antes de la entrada real. Esto permite al modelo reconocer patrones y matices más complejos en la tarea. Por ejemplo: "Clasifique las siguientes frases como preguntas o afirmaciones: El cielo es azul". - Enunciado '¿Qué hora es?' - Pregunta 'Me encanta el helado'. - Enunciado Entrada: '¿Dónde puedo encontrar el restaurante más cercano?' - [el modelo genera la respuesta]"

Diseñar avisos de pocas palabras eficaces

Elaborar mensajes de pocas palabras eficaces es un arte y una ciencia. He aquí algunos principios clave a tener en cuenta:

Claridad y coherencia: Asegúrese de que sus ejemplos e instrucciones sean claros y sigan un formato coherente. Esto ayuda al modelo a reconocer el patrón más fácilmente.

La diversidad: Cuando utilices varios ejemplos, intenta abarcar una gama de posibles entradas y salidas para que el modelo tenga una comprensión más amplia de la tarea.

Relevancia: Elija ejemplos que estén estrechamente relacionados con la tarea específica o el dominio al que se dirige. Esto ayuda al modelo a centrarse en los aspectos más relevantes de sus conocimientos.

Concisión: Aunque es importante proporcionar suficiente contexto, hay que evitar indicaciones demasiado largas o complejas que puedan confundir al modelo o diluir la información clave.

Experimentación: Don’t be afraid to iterate and experiment with different prompt structures and examples to find what works best for your specific use case.

Si dominamos el arte de los avisos de pocos disparos, podremos liberar todo el potencial de los LLM, permitiéndoles abordar una amplia gama de tareas con un mínimo de información o formación adicional.

Ajuste fino de los LLM: Adaptación de modelos con datos limitados

Mientras que la estimulación de pocos disparos es una potente técnica para adaptar los LLM a nuevas tareas sin modificar el propio modelo, el ajuste fino ofrece una forma de actualizar los parámetros del modelo para obtener un rendimiento aún mejor en tareas o dominios específicos. El ajuste fino nos permite aprovechar el vasto conocimiento codificado en los LLM preentrenados y adaptarlos a nuestras necesidades específicas utilizando sólo una pequeña cantidad de datos específicos de la tarea.

Entender el ajuste fino en el contexto de los LLM

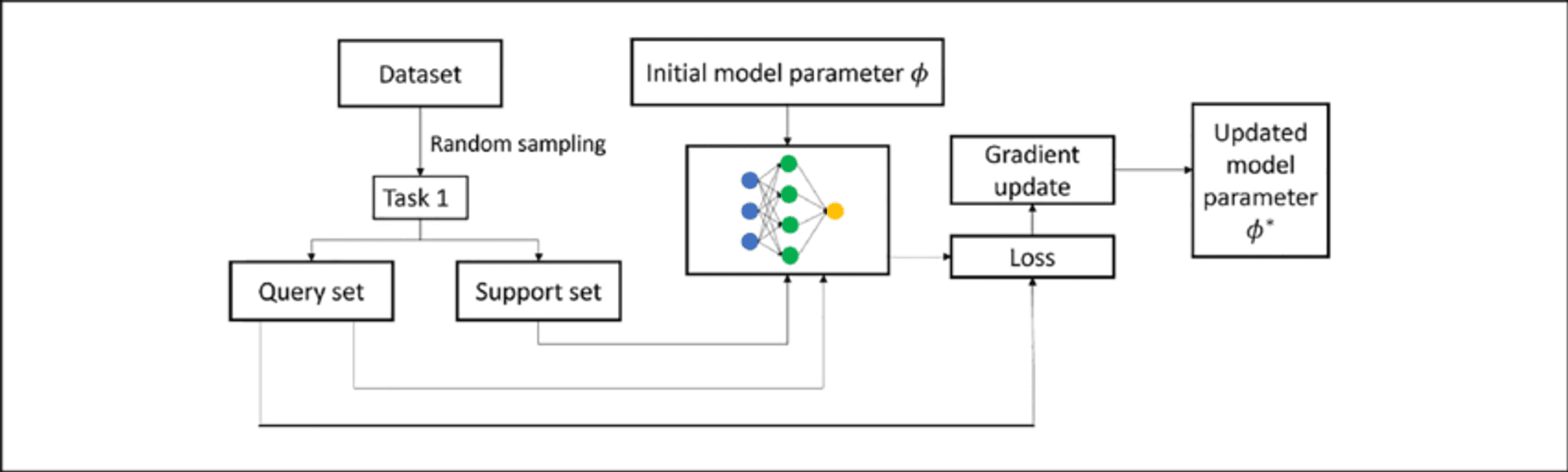

Fine-tuning an LLM involves further training a pre-trained model on a smaller, task-specific dataset. This process adapts the model to the target task while building upon existing knowledge, requiring less data and resources than training from scratch.

In LLMs, fine-tuning typically adjusts weights in upper layers for task-specific features, while lower layers remain largely unchanged. This “transfer learning” approach retains broad language understanding while developing specialized capabilities.

Técnicas de ajuste de pocos disparos

Few-shot fine-tuning adapts the model using only 10 to 100 samples per class or task, valuable when labeled data is scarce. Key techniques include:

Puesta a punto basada en instrucciones: Combines few-shot prompting with parameter updates.

Enfoques de metaaprendizaje: Methods like MAML aim to find good initialization points for quick adaptation.

Adapter-based fine-tuning: Introduces small “adapter” modules between pre-trained model layers, reducing trainable parameters.

Aprendizaje en contexto: Fine-tunes LLMs to better perform adaptation through prompts alone.

These techniques enable LLMs to adapt to new tasks with minimal data, enhancing their versatility and efficiency.

Pocos disparos o ajuste fino: Elegir el enfoque adecuado

A la hora de adaptar los LLM a tareas específicas, tanto el estímulo de pocos disparos como el ajuste fino ofrecen soluciones potentes. Sin embargo, cada método tiene sus puntos fuertes y sus limitaciones, y la elección del enfoque adecuado depende de varios factores.

Few-Shot Prompting Strengths:

No requiere actualizaciones de los parámetros del modelo, preservando el modelo original

Gran flexibilidad y adaptabilidad sobre la marcha

No se necesita tiempo de formación ni recursos informáticos adicionales

Útil para la creación rápida de prototipos y la experimentación

Limitaciones:

El rendimiento puede ser menos constante, especialmente en tareas complejas

Limitado por las capacidades y conocimientos originales del modelo

Puede tener dificultades con ámbitos o tareas muy especializados

Fine-Tuning Strengths:

A menudo se consigue un mejor rendimiento en tareas específicas

Puede adaptar el modelo a nuevos ámbitos y vocabulario especializado

Resultados más coherentes con aportaciones similares

Potencial de aprendizaje y mejora continuos

Limitaciones:

Requiere más tiempo de formación y recursos informáticos

Riesgo de olvido catastrófico si no se gestiona con cuidado

Puede sobreajustarse en conjuntos de datos pequeños

Menos flexible; requiere una nueva formación para cambios significativos en las tareas.

Top 5 Research Papers for Few-Shot Learning

This week, we also explore the following five papers that have significantly advanced this field, introducing innovative approaches that are reshaping AI capabilities.

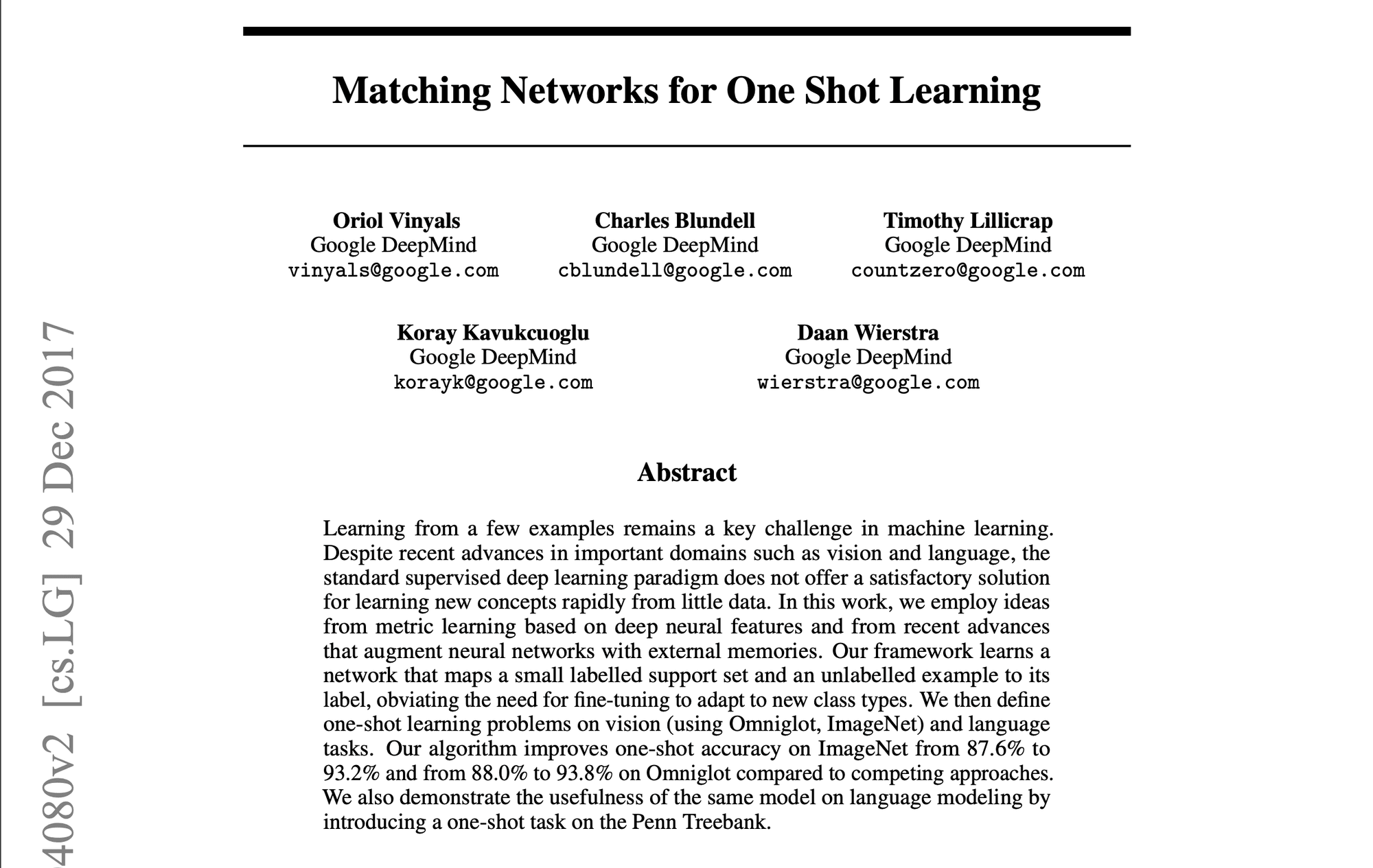

1️⃣ Matching Networks for One Shot Learning” (Vinyals et al., 2016)

Introduced a groundbreaking approach using memory and attention mechanisms. The matching function compares query examples to labeled support examples, setting a new standard for few-shot learning methods.

2️⃣ Prototypical Networks for Few-shot Learning” (Snell et al., 2017)

Presented a simpler yet effective approach, learning a metric space where classes are represented by a single prototype. Its simplicity and effectiveness made it a popular baseline for subsequent research.

3️⃣ Learning to Compare: Relation Network for Few-Shot Learning” (Sung et al., 2018)

Introduced a learnable relation module, allowing the model to learn a comparison metric tailored to specific tasks and data distributions. Demonstrated strong performance across various benchmarks.

4️⃣ A Closer Look at Few-shot Classification” (Chen et al., 2019)

Provided a comprehensive analysis of existing methods, challenging common assumptions. Proposed simple baseline models that matched or exceeded more complex approaches, emphasizing the importance of feature backbones and training strategies.

5️⃣ Meta-Baseline: Exploring Simple Meta-Learning for Few-Shot Learning” (Chen et al., 2021)

Combined standard pre-training with a meta-learning stage, achieving state-of-the-art performance. Highlighted the trade-offs between standard training and meta-learning objectives.

These papers have not only advanced academic research but also paved the way for practical applications in enterprise AI. They represent a progression towards more efficient, adaptable AI systems capable of learning from limited data – a crucial capability in many business contexts.

Lo esencial

Few-shot learning, prompting, and fine-tuning represent groundbreaking approaches, enabling LLMs to adapt swiftly to specialized tasks with minimal data. As we’ve explored, these techniques offer unprecedented flexibility and efficiency in tailoring LLMs to diverse applications across industries, from enhancing natural language processing tasks to enabling domain-specific adaptations in fields like healthcare, law, and technology.

¡Gracias por tomarse el tiempo de leer AI & YOU!

Para obtener más contenido sobre IA empresarial, como infografías, estadísticas, guías prácticas, artículos y vídeos, siga a Skim AI en LinkedIn

¿Es usted fundador, director general, inversor o capitalista de riesgo y busca servicios de asesoramiento sobre IA, desarrollo fraccionado de IA o diligencia debida? Obtenga la orientación que necesita para tomar decisiones informadas sobre la estrategia de productos de IA y las oportunidades de inversión de su empresa.

Creamos soluciones de IA personalizadas para empresas respaldadas por capital riesgo y capital privado en los siguientes sectores: Tecnología Médica, Noticias/Agregación de Contenidos, Producción de Cine y Fotografía, Tecnología Educativa, Tecnología Legal, Fintech y Criptomoneda.