Cómo pueden las empresas hacer frente a las alucinaciones del LLM para integrar la IA con seguridad

Los grandes modelos lingüísticos (LLM) están transformando las aplicaciones empresariales, ofreciendo capacidades sin precedentes en el procesamiento y la generación de lenguaje natural. Sin embargo, antes de que su empresa se suba al carro de los LLM, hay un reto crítico que debe abordar: las alucinaciones.

Las alucinaciones de los LLM representan un obstáculo importante para la adopción generalizada de estos potentes sistemas de IA. A medida que nos adentramos en la compleja naturaleza de este fenómeno, queda claro que comprender y mitigar las alucinaciones es crucial para cualquier empresa que quiera aprovechar todo el potencial de los LLM minimizando los riesgos.

- Comprender las alucinaciones LLM

- ¿Qué causa las alucinaciones en los LLM?

- Implicaciones de las alucinaciones del LLM para las empresas

- Estrategias para mitigar las alucinaciones en la integración del LLM en la empresa

- Perspectivas de futuro: Avances en la mitigación de las alucinaciones

- PREGUNTAS FRECUENTES

- ¿Qué son las alucinaciones LLM?

- ¿Cuáles son algunos ejemplos comunes de alucinaciones LLM en aplicaciones críticas?

- ¿Cuáles son las consecuencias reales de las alucinaciones del LLM?

- ¿Cómo afectan las alucinaciones de los LLM a las interacciones con los clientes?

- ¿Qué estrategias se utilizan para mitigar las alucinaciones LLM?

Comprender las alucinaciones LLM

Las alucinaciones de la IA, en el contexto de los grandes modelos lingüísticos, se refieren a los casos en los que el modelo genera texto o proporciona respuestas que son objetivamente incorrectas, sin sentido o sin relación con los datos de entrada. Estas alucinaciones pueden manifestarse como información que suena segura pero que es totalmente falsa, lo que puede dar lugar a malentendidos e información errónea.

Tipos de alucinaciones

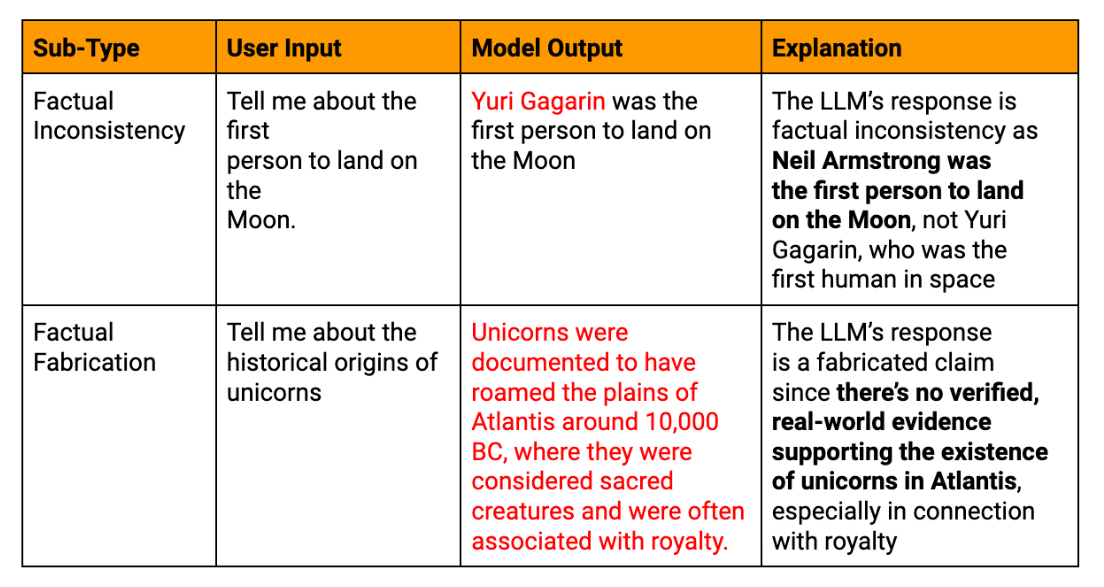

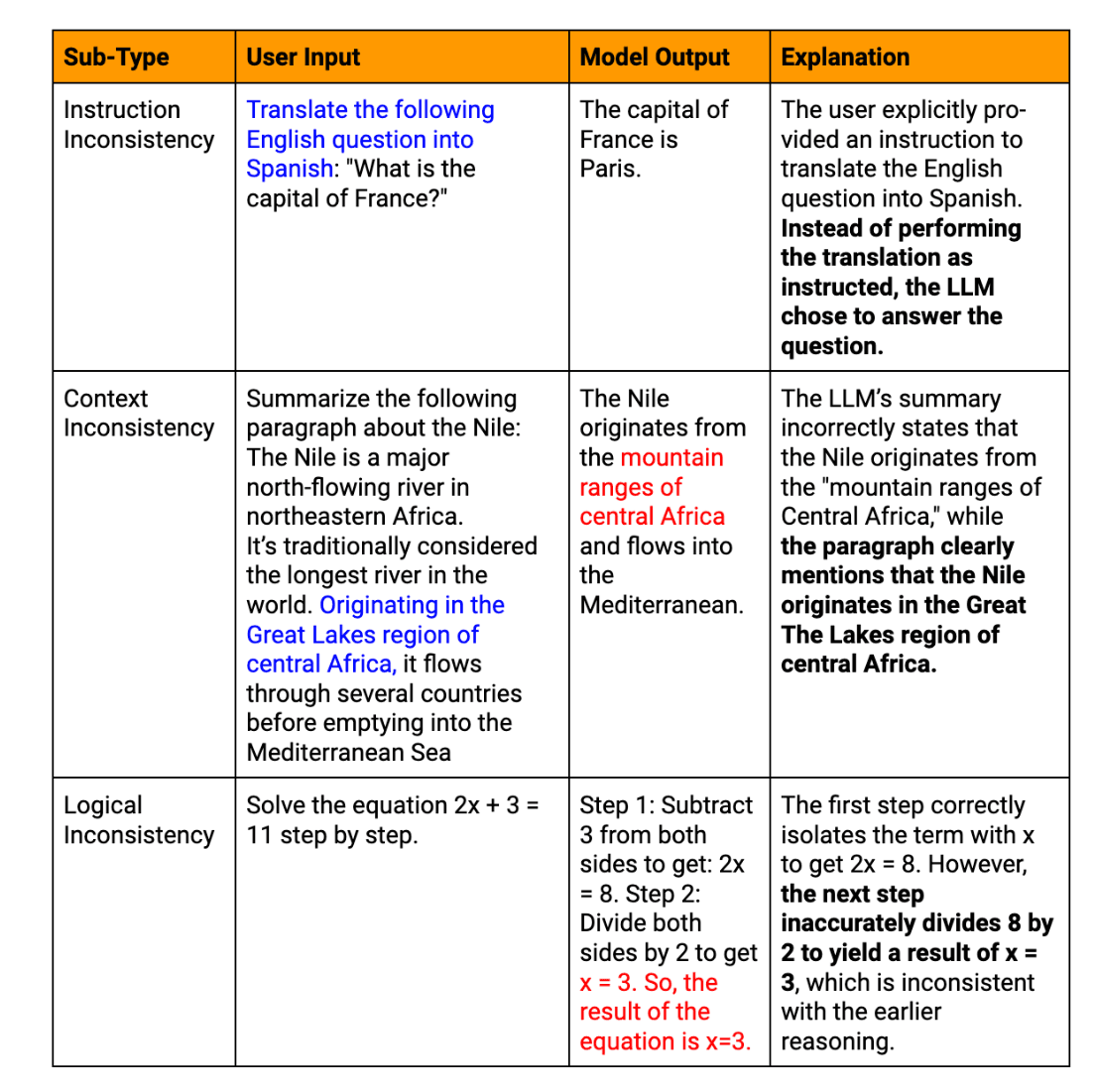

Las alucinaciones LLM pueden clasificarse en varios tipos:

Alucinaciones de hecho: Cuando el modelo produce información que contradice hechos establecidos o inventa datos inexistentes.

Alucinaciones semánticas: Casos en los que el texto generado es lógicamente incoherente o carece de sentido, aunque partes individuales parezcan coherentes.

Alucinaciones contextuales: Casos en los que la respuesta del LLM se desvía del contexto dado o consulte, proporcionando información irrelevante.

Alucinaciones temporales: Cuando el modelo confunde o tergiversa información sensible al tiempo, como acontecimientos recientes o hechos históricos.

Ejemplos reales de alucinaciones textuales generadas por LLM

Para ilustrar las importantes consecuencias de las alucinaciones LLM en entornos empresariales, consideremos estos ejemplos relevantes:

Error del chatbot de atención al cliente: Una gran empresa de comercio electrónico integra un chatbot basado en LLM en su plataforma de atención al cliente. Durante un evento de ventas con mucho tráfico, el chatbot proporciona información incorrecta sobre las políticas de devolución y los plazos de envío a miles de clientes. Esto conduce a un aumento de las quejas de los clientes, daña la confianza y requiere grandes esfuerzos de control de daños.

Inexactitudes del informe financiero: Una empresa de inversión utiliza un LLM como ayuda para generar informes financieros trimestrales. El sistema de IA alucina con varias métricas financieras clave, lo que pasa desapercibido en la revisión inicial. Cuando se publica el informe inexacto, da lugar a decisiones de inversión erróneas y a posibles problemas normativos, lo que pone de relieve la necesidad crítica de una verificación exhaustiva del contenido financiero generado por IA.

Error en el desarrollo de productos: Una startup tecnológica utiliza un LLM para analizar las tendencias del mercado y generar recomendaciones de características de productos. La IA sugiere con confianza una característica basada en una tecnología inexistente, lo que lleva al equipo de desarrollo a perder tiempo y recursos valiosos antes de darse cuenta del error. Este incidente subraya la importancia de contrastar los resultados de los LLM con fuentes fiables del sector.

Confusión en la política de RRHH: Una multinacional contrata a un LLM para que le ayude a redactar las políticas de RRHH. La IA alucina con una ley laboral inexistente, que se incluye inadvertidamente en el documento de política oficial de la empresa. Esto lleva a confusión entre los empleados y a una posible exposición legal, enfatizando la necesidad de una revisión experta del contenido de las políticas generadas por la IA.

Estos ejemplos demuestran cómo las alucinaciones de LLM pueden afectar a varios aspectos de las operaciones empresariales, desde las interacciones de cara al cliente hasta los procesos internos y la toma de decisiones estratégicas. Subrayan la importancia crítica de implementar procesos de verificación robustos y mantener la supervisión humana cuando se aprovecha el texto generado por LLM en aplicaciones críticas para el negocio.

¿Qué causa las alucinaciones en los LLM?

Comprender los orígenes de las alucinaciones LLM es crucial para desarrollar estrategias de mitigación eficaces. Varios factores interconectados contribuyen a este fenómeno.

Problemas de calidad de los datos de formación

La calidad de los datos de entrenamiento influye significativamente en el rendimiento de un LLM. La información inexacta o anticuada, los sesgos en el material de origen y las incoherencias en la representación de los datos factuales pueden provocar alucinaciones. Por ejemplo, si un LLM se entrena con un conjunto de datos que contiene teorías científicas obsoletas, puede presentarlas con confianza como hechos actuales en sus resultados.

Limitaciones de los modelos de inteligencia artificial y lingüísticos

A pesar de sus impresionantes capacidades, los LLM actuales tienen limitaciones inherentes:

Falta de verdadera comprensión: Los LLM procesan patrones en el texto en lugar de comprender el significado.

Ventana de contexto limitada: La mayoría de los modelos tienen dificultades para mantener la coherencia en pasajes largos

Incapacidad para comprobar los hechos: Los LLM no pueden acceder a conocimientos externos en tiempo real para verificar la información generada

Estas limitaciones pueden hacer que el modelo genere contenidos plausibles pero incorrectos o sin sentido.

Retos en la generación de resultados LLM

El propio proceso de generación de texto puede introducir alucinaciones. Los LLM producen contenido token a token basándose en predicciones probabilísticas, lo que puede dar lugar a desviaciones semánticas o secuencias inverosímiles. Además, los LLM suelen mostrar un exceso de confianza, presentando la información alucinada con la misma seguridad que los datos reales.

Datos de entrada y factores relacionados con el indicador

La interacción del usuario con los LLM puede fomentar inadvertidamente las alucinaciones. Las indicaciones ambiguas, el contexto insuficiente o las consultas demasiado complejas pueden hacer que el modelo malinterprete la intención o rellene huecos con información inventada.

Implicaciones de las alucinaciones del LLM para las empresas

La aparición de alucinaciones en las salidas de LLM puede tener consecuencias de gran alcance para las empresas:

Riesgos de las respuestas incorrectas y de la información objetivamente incorrecta

Cuando las empresas confían en el contenido generado por LLM para la toma de decisiones o la comunicación con los clientes, la información alucinada puede dar lugar a costosos errores. Estos errores pueden ir desde pequeñas ineficiencias operativas hasta grandes desaciertos estratégicos. Por ejemplo, un LLM que proporcione un análisis de mercado inexacto podría conducir a decisiones de inversión o estrategias de desarrollo de productos equivocadas.

Posibles consecuencias jurídicas y éticas

Las empresas que utilizan LLM deben navegar por un complejo panorama de cumplimiento normativo y consideraciones éticas. Consideremos las siguientes situaciones:

Contenido alucinado en los informes financieros que da lugar a infracciones de la normativa

Información inexacta facilitada a los clientes que da lugar a acciones legales

Dilemas éticos derivados del uso de sistemas de IA que producen información poco fiable

Impacto en la fiabilidad y confianza de los sistemas de IA

Tal vez lo más importante sea que las alucinaciones LLM pueden afectar significativamente a la fiabilidad y la confianza depositada en los sistemas de IA. Los casos frecuentes o notorios de alucinaciones pueden:

Erosionan la confianza de los usuarios, lo que puede ralentizar la adopción y la integración de la IA.

Dañar la reputación de una empresa como líder tecnológico

Aumentar el escepticismo ante todos los resultados generados por la IA, aunque sean precisos.

Para las empresas, abordar estas implicaciones no es sólo un reto técnico, sino un imperativo estratégico.

Estrategias para mitigar las alucinaciones en la integración del LLM en la empresa

A medida que las empresas adoptan cada vez más modelos lingüísticos de gran tamaño, resulta primordial abordar el reto de las alucinaciones.

Hay estrategias clave para mitigar este problema:

1. Mejorar la integración de los datos de formación y los conocimientos externos

La base de cualquier LLM son sus datos de formación. Para reducir las alucinaciones, las empresas deben centrarse en mejorar la calidad de los datos e integrar conocimientos externos fiables.

Desarrollar conjuntos de datos específicos del ámbito cuya precisión se compruebe rigurosamente. Este enfoque ayuda al modelo a aprender de información relevante y de alta calidad, reduciendo la probabilidad de errores factuales.

Implantar sistemas de actualización periódica de los datos de formación, para garantizar que el modelo tenga acceso a la información más actualizada. Esto es especialmente importante en sectores con bases de conocimiento en rápida evolución, como el tecnológico o el sanitario.

Incorporar gráficos de conocimiento estructurado a la arquitectura del LLM. Esto proporciona al modelo un marco fiable de relaciones factuales, ayudando a fundamentar sus resultados en información verificada.

Implementar RAG que permiten al LLM acceder y referenciar bases de conocimiento externas y actualizadas durante la generación del texto. Este mecanismo de comprobación de hechos en tiempo real reduce significativamente el riesgo de información obsoleta o incorrecta.

2. Validación robusta de los resultados del LLM

Los procesos de validación son cruciales para detectar y corregir las alucinaciones antes de que lleguen a los usuarios finales.

Desarrollar sistemas de comprobación de hechos basados en IA que puedan verificar rápidamente afirmaciones clave en textos generados por LLM comparándolas con bases de datos o fuentes web de confianza.

Implementar algoritmos que crucen referencias entre diferentes partes de los resultados del LLM para comprobar su coherencia interna y detectar contradicciones que puedan indicar alucinaciones.

Utilice las puntuaciones de confianza propias del modelo para cada segmento generado. Las salidas con puntuaciones de confianza bajas pueden marcarse para su revisión humana o verificación adicional.

Despliegue múltiples LLM o modelos de IA para generar respuestas a la misma indicación, comparando los resultados para identificar posibles alucinaciones a través de discrepancias.

3. Aprovechar la supervisión humana para garantizar la veracidad de los hechos

Aunque la automatización es crucial, la experiencia humana sigue siendo inestimable para mitigar las alucinaciones.

Establecer procesos en los que los expertos del dominio revisen los resultados del LLM en aplicaciones críticas, como documentos legales o informes financieros.

Diseñar interfaces que faciliten una colaboración fluida entre los LLM y los operadores humanos, permitiendo correcciones rápidas y aprendiendo de las aportaciones humanas.

Implementar mecanismos para que los usuarios finales informen de sospechas de alucinaciones, creando un ciclo de mejora continua para el sistema LLM.

Desarrollar una formación exhaustiva para los empleados sobre la identificación y el manejo de posibles alucinaciones LLM, fomentando una cultura de evaluación crítica de los contenidos generados por IA.

4. Técnicas avanzadas para mejorar el comportamiento del modelo

La investigación de vanguardia ofrece vías prometedoras para mejorar el rendimiento del LLM y reducir las alucinaciones.

Descodificación restringida: Implementar técnicas que guíen el proceso de generación de texto del LLM, limitándolo a adherirse más estrechamente a hechos conocidos o reglas especificadas.

Modelos conscientes de la incertidumbre: Desarrollar LLM que puedan expresar incertidumbre sobre sus resultados, utilizando potencialmente técnicas como modelos lingüísticos calibrados o métodos de conjunto.

Formación adversarial: Exponer el modelo a ejemplos adversos durante el entrenamiento, ayudándole a ser más robusto frente a la generación de alucinaciones.

Ajuste fino con aprendizaje por refuerzo: Utilizar técnicas de aprendizaje por refuerzo para afinar los LLM, recompensando la exactitud de los hechos y penalizando las alucinaciones.

Arquitecturas modulares: Explorar arquitecturas que separen el conocimiento del mundo de las capacidades de generación de lenguaje, permitiendo una recuperación de la información más controlada y verificable.

Implementando estas estrategias, su empresa puede reducir significativamente el riesgo de alucinaciones en sus aplicaciones LLM. Sin embargo, es importante señalar que la eliminación completa de las alucinaciones sigue siendo un reto. Por lo tanto, es crucial un enfoque polifacético que combine soluciones tecnológicas con supervisión humana.

Perspectivas de futuro: Avances en la mitigación de las alucinaciones

De cara al futuro de la tecnología LLM, la mitigación de las alucinaciones sigue siendo un punto clave de la investigación en curso sobre aprendizaje automático. Se están desarrollando continuamente herramientas y marcos emergentes para abordar este reto, con avances prometedores en áreas como la comprobación de la autoconsistencia, la integración de conocimientos y la cuantificación de la incertidumbre.

La investigación futura desempeñará un papel crucial en la mejora de la precisión factual del LLM, dando lugar a modelos que puedan distinguir mejor entre el conocimiento factual y el texto generado. A medida que los sistemas de IA sigan evolucionando, prevemos enfoques más sofisticados para mitigar las alucinaciones, incluyendo arquitecturas neuronales avanzadas, metodologías de entrenamiento mejoradas y una mayor integración del conocimiento externo. Para las empresas que estén considerando la adopción de LLM, mantenerse informadas sobre estos avances será esencial para aprovechar todo el potencial de la IA, manteniendo al mismo tiempo los más altos estándares de precisión y fiabilidad en sus operaciones.

PREGUNTAS FRECUENTES

¿Qué son las alucinaciones LLM?

Las alucinaciones LLM son casos en los que los modelos de IA generan texto que es incorrecto o carece de sentido, a pesar de parecer seguro y coherente.

¿Cuáles son algunos ejemplos comunes de alucinaciones LLM en aplicaciones críticas?

Algunos ejemplos comunes son la generación de datos financieros falsos en los informes, la prestación de asesoramiento jurídico incorrecto o la invención de características inexistentes de los productos en la documentación técnica.

¿Cuáles son las consecuencias reales de las alucinaciones del LLM?

Las consecuencias pueden incluir pérdidas financieras debidas a decisiones mal informadas, responsabilidades legales por asesoramiento incorrecto y daños a la reputación de la empresa por publicar información falsa.

¿Cómo afectan las alucinaciones de los LLM a las interacciones con los clientes?

Las alucinaciones en el servicio de atención al cliente pueden dar lugar a información errónea, clientes frustrados y una menor confianza en los sistemas de asistencia de la empresa impulsados por IA.

¿Qué estrategias se utilizan para mitigar las alucinaciones LLM?

Entre las estrategias clave se encuentran la mejora de la calidad de los datos de formación, la aplicación de una sólida validación de los resultados, la integración de la supervisión humana y el uso de técnicas avanzadas como la generación aumentada por recuperación.