Cómo crear su pila LLM para empresas: Nuestra pila de 4 herramientas + Framework

Los grandes modelos lingüísticos (LLM) se han revelado como la clave para crear aplicaciones empresariales inteligentes. Sin embargo, aprovechar la potencia de estos modelos de lenguaje requiere una pila de aplicaciones LLM robusta y eficiente. En Skim AI, nuestra pila de aplicaciones LLM nos permite crear aplicaciones potentes con capacidades avanzadas de interacción con el lenguaje natural. Nuestra pila comprende herramientas y marcos cuidadosamente seleccionados, como las API LLM, LangChain y las bases de datos vectoriales.

Con esta pila tecnológica, los desarrolladores pueden integrar datos específicos del dominio, ajustar modelos, crear canalizaciones de datos eficientes para recuperar datos contextuales, y mucho más. Esto permite a las empresas crear aplicaciones que comprenden y responden a las consultas de los usuarios con una precisión y un conocimiento del contexto sin precedentes. Al mismo tiempo, una de las principales técnicas que acompañan a esta pila es utilizar las herramientas y marcos existentes que proporcionan los distintos componentes. Esto permite a los desarrolladores centrarse en crear aplicaciones en lugar de crear herramientas desde cero, lo que supone un valioso ahorro de tiempo y esfuerzo.

Una API LLM como GPT, Claude, Llama o Mistral

En el núcleo de su pila de aplicaciones LLM debe haber una API LLM. Las API de LLM proporcionan una forma de integrar potentes modelos lingüísticos en sus aplicaciones sin necesidad de entrenar o alojar los modelos usted mismo. Actúan como puente entre su software y los complejos algoritmos que alimentan los modelos lingüísticos, permitiéndole añadir capacidades avanzadas de procesamiento del lenguaje natural a sus aplicaciones con un esfuerzo mínimo.

Una de las principales ventajas de utilizar una API LLM es la posibilidad de aprovechar modelos lingüísticos de última generación que han sido entrenados con grandes cantidades de datos. Estos modelos, como GPT, Claude, Mistraly Llamason capaces de comprender y generar texto similar al humano con notable precisión y fluidez. Al realizar llamadas API a estos modelos, puede añadir rápidamente a sus aplicaciones una amplia gama de funciones, como la generación de texto, el análisis de sentimientos, la respuesta a preguntas y mucho más.

Factores a tener en cuenta al elegir un LLM API

A la hora de elegir una API LLM para su pila, hay que tener en cuenta varios factores:

Rendimiento y precisión: Asegúrese de que la API puede gestionar su carga de trabajo y proporcionar resultados fiables.

Personalización y flexibilidad: Considere si necesita ajustar el modelo para su caso de uso específico o integrarlo con otros componentes de su pila.

Escalabilidad: Si prevé un gran volumen de solicitudes, asegúrese de que la API puede ampliarse en consecuencia.

Apoyo y comunidad: Evalúe el nivel de apoyo y el tamaño de la comunidad en torno a la API, ya que esto puede afectar a la viabilidad a largo plazo de su aplicación.

Para hacer un uso eficaz de una API LLM, es importante comprender sus componentes y capacidades clave. En el corazón de la mayoría de las API LLM se encuentran las redes neuronales profundas, normalmente basadas en arquitecturas de transformadores, que se entrenan con cantidades masivas de datos de texto. A estos modelos se accede a través de una interfaz API, que se encarga de tareas como la autenticación, el enrutamiento de solicitudes y el formato de las respuestas. Las API de LLM también suelen incluir componentes adicionales para el procesamiento de datos, como la tokenización y la normalización, así como herramientas para el ajuste fino y la personalización.

Al integrar una API LLM en su pila de aplicaciones, es importante tener en cuenta factores como la privacidad y la seguridad de los datos. Dependiendo de su caso de uso, es posible que tenga que asegurarse de que no se envían datos confidenciales al proveedor de la API ni se utilizan para el entrenamiento de modelos. También debe evaluar cuidadosamente la estructura de costes de la API, ya que los precios basados en el uso pueden aumentar rápidamente para aplicaciones de gran volumen.

A pesar de estos retos, las ventajas de utilizar una API LLM son evidentes. Al proporcionar una forma sencilla y flexible de integrar capacidades lingüísticas avanzadas en sus aplicaciones, las LLM API pueden ayudarle a crear un software más atractivo, inteligente y fácil de usar. Tanto si estás creando un chatbot, una herramienta de creación de contenidos o un sistema de gestión del conocimiento, una API LLM es un complemento crucial para la pila de aplicaciones de tu empresa.

Cadena LangChain

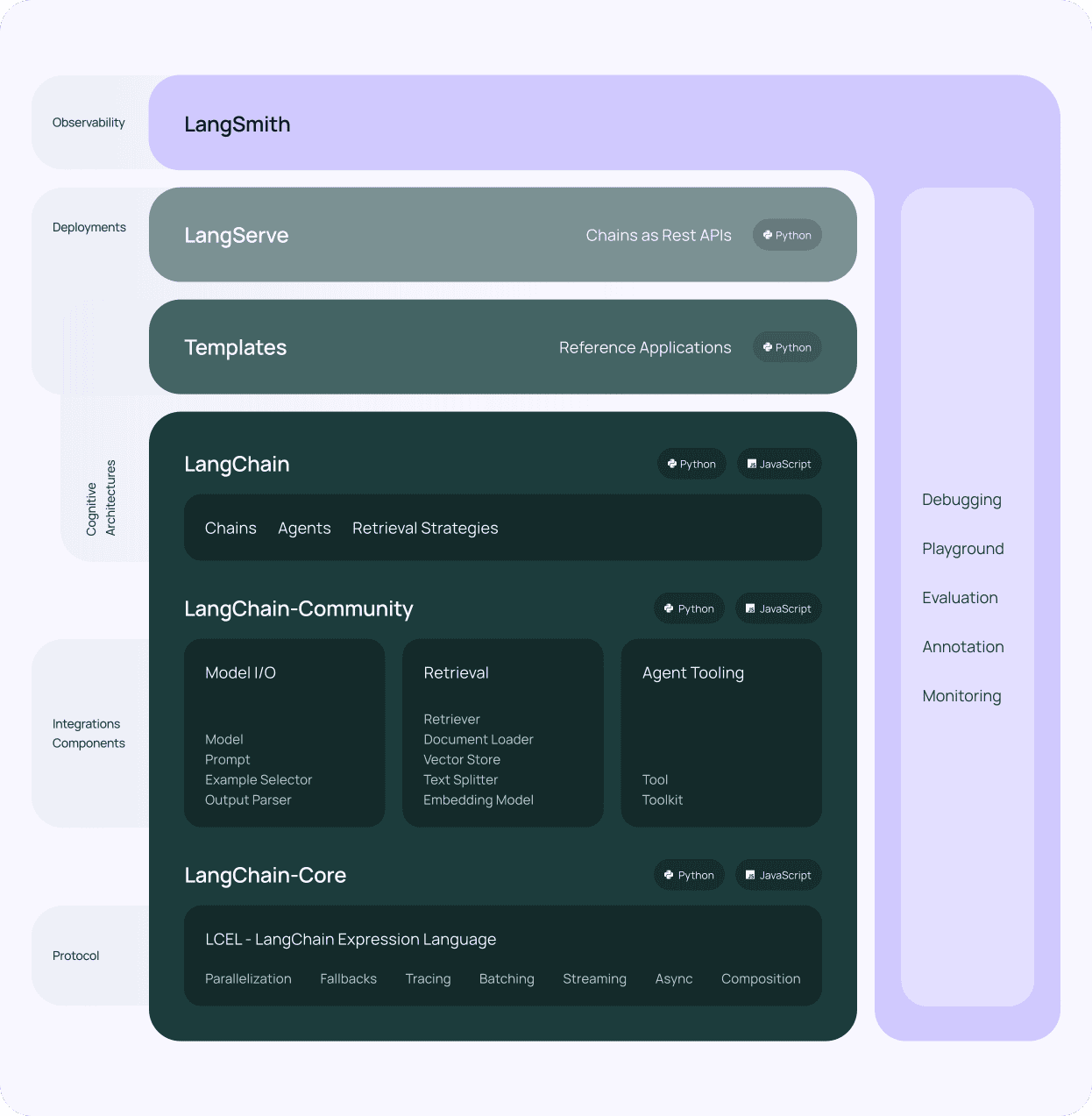

Tras seleccionar una API LLM para su pila de aplicaciones LLM, el siguiente componente a tener en cuenta es Cadena LangChain. LangChain es un potente marco diseñado para simplificar el proceso de creación de aplicaciones sobre grandes modelos lingüísticos. Proporciona una interfaz estandarizada para interactuar con varias API LLM, lo que facilita su integración en su pila tecnológica LLM.

Una de las principales ventajas de utilizar LangChain es su arquitectura modular. LangChain consta de varios componentes, como prompts, cadenas, agentes y memoria, que pueden combinarse para crear flujos de trabajo complejos. Esta modularidad le permite crear aplicaciones que pueden manejar una amplia gama de tareas, desde la simple respuesta a preguntas hasta casos de uso más avanzados como la generación de contenidos y el análisis de datos, permitiendo la interacción del lenguaje natural con los datos específicos de su dominio.

Herramientas y soporte de LangChain

LangChain también ofrece diversas herramientas y utilidades que agilizan el trabajo con LLM. Por ejemplo, ofrece herramientas para trabajar con incrustaciones, que son representaciones numéricas del texto utilizadas para tareas como la búsqueda semántica y la agrupación. Además, LangChain incluye utilidades para la gestión de prompts, que son las cadenas de entrada utilizadas para guiar el comportamiento de los modelos lingüísticos.

Otra característica crucial de LangChain es su compatibilidad con bases de datos vectoriales. Al integrarse con bases de datos vectoriales como Chroma (que es la que utilizamos nosotros), LangChain te permite crear aplicaciones que pueden almacenar y recuperar grandes cantidades de datos de forma eficiente. Esta integración te permite crear aplicaciones intensivas en conocimiento que pueden recurrir a una amplia gama de fuentes de información, mejorando la recuperación de datos contextuales para tu pila de aplicaciones LLM.

LangChain también cuenta con una activa comunidad de desarrolladores y usuarios que contribuyen a su continuo desarrollo. Esta comunidad ofrece una gran cantidad de recursos, incluyendo documentación, tutoriales y componentes pre-construidos que pueden acelerar el desarrollo de aplicaciones impulsadas por LLM. Además, LangChain es compatible con modelos de código abierto, lo que la convierte en una herramienta versátil para su pila tecnológica LLM.

LangChain es un componente vital de cualquier LLM empresarial pila de aplicaciones. Su diseño modular, sus potentes herramientas y su activa comunidad la convierten en una herramienta indispensable para crear sofisticadas aplicaciones basadas en el lenguaje. Al aprovechar LangChain junto con una API LLM y otros componentes como bases de datos vectoriales, puede crear aplicaciones empresariales que entiendan y generen lenguaje humano con una precisión y fluidez sin precedentes, permitiendo una interacción fluida del lenguaje natural con sus datos privados e información específica del dominio.

Una base de datos vectorial como Chroma

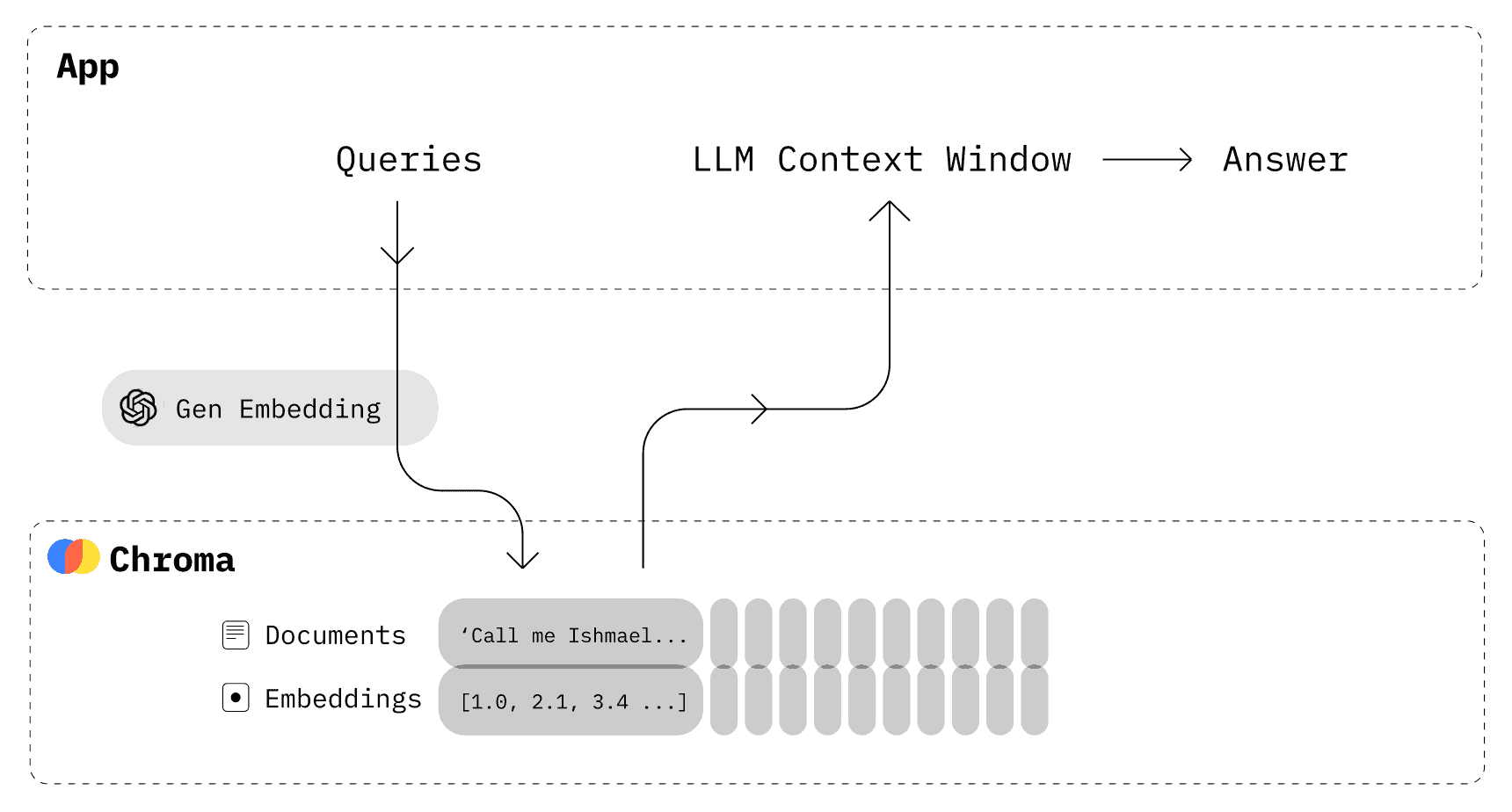

Además de una API LLM y LangChain, otro componente esencial de tu pila de aplicaciones LLM es una base de datos vectorial. Las bases de datos vectoriales son almacenes de datos especializados optimizados para almacenar y buscar vectores de alta dimensión, como las incrustaciones generadas por grandes modelos lingüísticos. Al integrar una base de datos vectorial en tu pila tecnológica LLM, puedes permitir la recuperación rápida y eficiente de datos relevantes basados en la similitud semántica.

Croma es una elección popular de código abierto para una base de datos vectorial en pilas de aplicaciones LLM, y nosotros la utilizamos aquí en Skim AI. Está diseñada para trabajar sin problemas con LangChain y otros componentes de su pila, proporcionando una solución robusta y escalable para almacenar y recuperar incrustaciones.

Una de las principales ventajas de utilizar Chroma es su capacidad para manejar grandes volúmenes de datos de forma eficiente. Chroma utiliza técnicas avanzadas de indexación que permiten realizar búsquedas rápidas por similitud, incluso en conjuntos de datos masivos. Esto lo convierte en la opción ideal para aplicaciones que necesitan almacenar y buscar en grandes cantidades de datos textuales, como repositorios de documentos, bases de conocimiento y sistemas de gestión de contenidos.

Otra ventaja de Chroma es su flexibilidad y facilidad de uso. Chroma proporciona una API sencilla e intuitiva para almacenar y recuperar incrustaciones, lo que facilita su integración en su pila de aplicaciones LLM. También admite varias métricas de similitud, como la similitud coseno y la distancia euclidiana, lo que le permite elegir la métrica más adecuada para su caso de uso específico.

Chroma también ofrece funciones avanzadas como el filtrado y la compatibilidad con metadatos. Puede almacenar metadatos adicionales junto a sus incrustaciones, como ID de documentos, marcas de tiempo o atributos personalizados. Estos metadatos pueden utilizarse para filtrar los resultados de búsqueda, lo que permite una recuperación más precisa y específica de los datos contextuales.

Integración de Chroma en su pila LLM empresarial

La integración de Chroma en su pila de aplicaciones LLM es sencilla, gracias a su compatibilidad con LangChain y otras herramientas y marcos populares. LangChain ofrece compatibilidad integrada con Chroma, lo que facilita el almacenamiento y la recuperación de las incrustaciones generadas por sus modelos lingüísticos. Esta integración le permite crear potentes mecanismos de recuperación que pueden mostrar rápidamente información relevante basada en la interacción del lenguaje natural.

El uso de una base de datos vectorial como Chroma junto con LLM abre nuevas posibilidades para crear aplicaciones inteligentes y conscientes del contexto. Aprovechando la potencia de las incrustaciones y la búsqueda por similitud, se pueden crear aplicaciones capaces de comprender las consultas de los usuarios y responder a ellas con una precisión y pertinencia sin precedentes. Esto resulta especialmente valioso en ámbitos como la atención al cliente, la recomendación de contenidos y la gestión del conocimiento, en los que es fundamental ofrecer la información adecuada en el momento oportuno.

Cuando se combina con LangChain y una API LLM, Chroma constituye una potente base para crear aplicaciones inteligentes basadas en datos que pueden transformar la forma en que interactuamos con los datos empresariales y la información específica de un dominio.

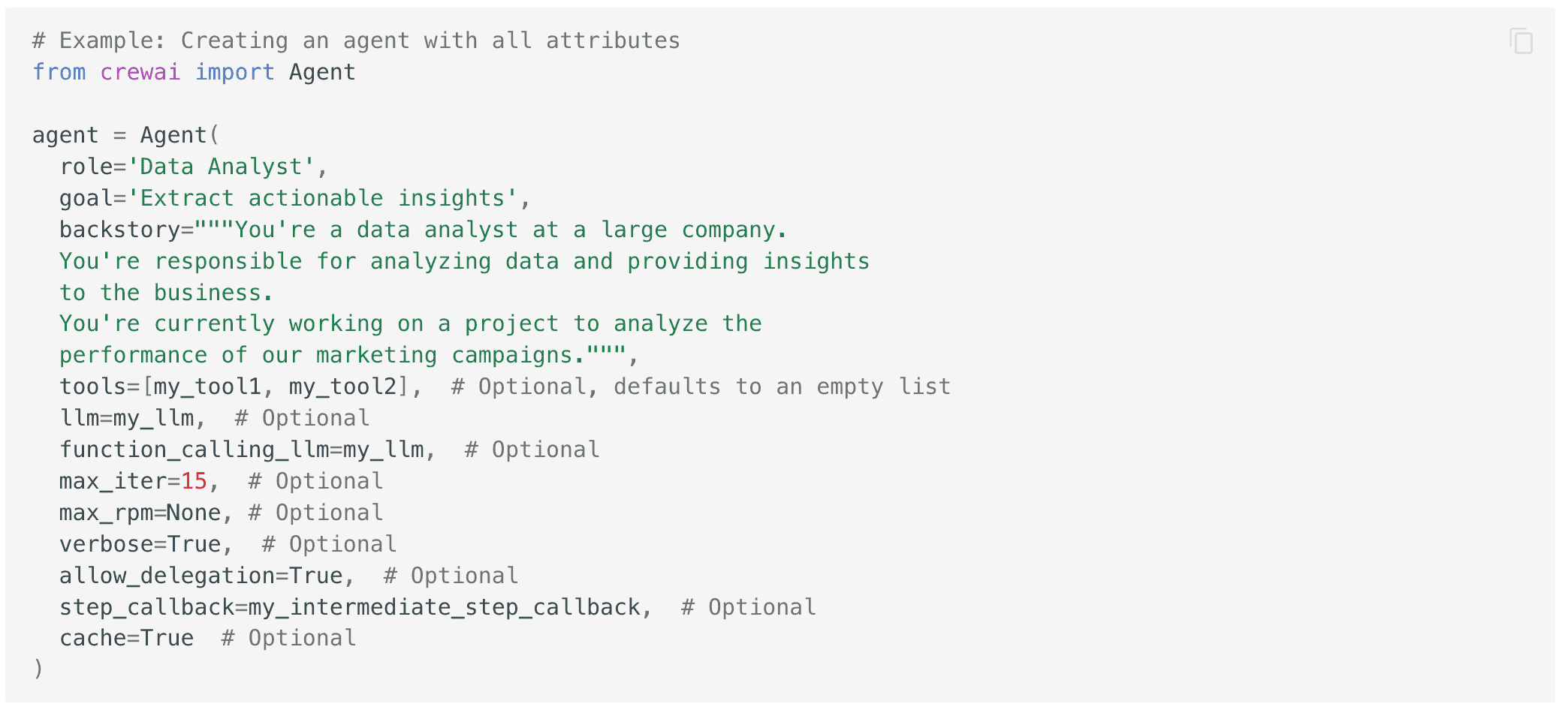

crewAI para sistemas multiagente

crewAI crewAI es otra potente herramienta que puedes añadir a tu pila de aplicaciones LLM para mejorar las capacidades de tus aplicaciones. crewAI es un marco que te permite crear sistemas multiagente, en los que varios agentes de IA trabajan juntos para realizar tareas complejas. Integrando crewAI en tu pila, puedes crear aplicaciones capaces de manejar flujos de trabajo y procesos de toma de decisiones más sofisticados, mejorando aún más las capacidades de interacción con el lenguaje natural de tu pila de aplicaciones LLM empresariales.

En esencia, crewAI está diseñado para facilitar la colaboración entre varios agentes de IA, cada uno con su función y experiencia específicas. Estos agentes pueden comunicarse y coordinarse entre sí para dividir problemas complejos en subtareas más pequeñas y manejables. Este enfoque permite crear aplicaciones capaces de abordar una amplia gama de retos del mundo real, desde la atención al cliente y la creación de contenidos hasta el análisis de datos y el apoyo a la toma de decisiones, todo ello aprovechando la potencia de grandes modelos lingüísticos.

Aprovechar el poder de la especialización

Una de las principales ventajas de utilizar crewAI en su pila tecnológica LLM es su capacidad para aprovechar el poder de la especialización. Al asignar funciones y tareas específicas a diferentes agentes, puede crear un sistema más eficiente y eficaz que un modelo de IA único y monolítico. Cada agente puede ser entrenado y optimizado para su tarea particular, lo que le permite rendir a un nivel más alto que un modelo de propósito general, y permite una recuperación más específica de los datos contextuales de sus conjuntos de datos específicos de dominio.

crewAI también proporciona una arquitectura flexible y extensible que le permite integrar fácilmente diferentes tipos de agentes en su sistema. Esto incluye agentes basados en modelos lingüísticos, así como agentes que utilizan otras técnicas de IA como la visión por ordenador, el reconocimiento de voz o el aprendizaje por refuerzo. Combinando estos diferentes tipos de agentes, puedes crear aplicaciones capaces de percibir, comprender e interactuar con el mundo de formas más naturales e intuitivas, mejorando aún más las capacidades de interacción con el lenguaje natural de tu pila de aplicaciones LLM.

La integración de crewAI en su pila de aplicaciones LLM es más fácil gracias a su compatibilidad con otras herramientas y marcos populares, como LangChain y bases de datos vectoriales. Esto le permite crear flujos de trabajo integrales que pueden gestionar tareas desde la ingesta y el procesamiento de datos hasta la interacción con el lenguaje natural y la toma de decisiones, todo ello aprovechando la potencia de los modelos y marcos de trabajo de código abierto.

El uso de crewAI en combinación con otros componentes de tu pila tecnológica LLM puede ayudarte a desbloquear nuevas posibilidades para construir sistemas inteligentes multiagente que puedan gestionar tareas complejas del mundo real. Al aprovechar el poder de la especialización y la colaboración, puede crear aplicaciones más eficientes, eficaces y fáciles de usar que los enfoques tradicionales de un solo modelo.

Liberar el poder de los LLM con la pila de aplicaciones adecuada

La creación de aplicaciones inteligentes y conscientes del contexto que aprovechen la potencia de los grandes modelos lingüísticos requiere una pila de aplicaciones LLM bien diseñada. Combinando herramientas potentes como las API de LLM, LangChain, bases de datos vectoriales como Chroma y marcos multiagente como crewAI, puedes crear flujos de trabajo increíblemente potentes y valiosos.

Esta pila le permite integrar a la perfección datos específicos de un dominio, posibilitar la recuperación eficaz de información contextual y crear sofisticados flujos de trabajo que pueden abordar complejos retos del mundo real. Al aprovechar la potencia de estas herramientas y marcos de trabajo, puede ampliar los límites de lo que es posible con aplicaciones de IA basadas en lenguaje y crear sistemas verdaderamente inteligentes que pueden transformar la forma en que su empresa interactúa con los datos y la tecnología.