Cómo ayuda AgentOps a gestionar los costes del LLM

En Agentes de IA A medida que los agentes de IA se hacen cada vez más frecuentes en las soluciones empresariales, la gestión de los costes de los grandes modelos lingüísticos (LLM) se ha convertido en una preocupación crítica tanto para los desarrolladores como para las empresas. Los LLM, aunque potentes, pueden ser caros de manejar, especialmente a gran escala. La creciente importancia de la gestión de los costes de los LLM en el desarrollo de agentes de IA no puede exagerarse, ya que...

Seguimiento y optimización Uso del LLM presenta varios retos. Los desarrolladores deben navegar por el complejo panorama del consumo de tokens, equilibrando la necesidad de sofisticadas capacidades de IA con las limitaciones presupuestarias. Además, la naturaleza dinámica de las interacciones de los agentes de IA dificulta la predicción y el control eficaz de los costes. Estos retos subrayan la necesidad de contar con herramientas y estrategias sólidas para gestionar los gastos del LLM y mantener al mismo tiempo agentes de IA de alto rendimiento.

Funciones integrales de gestión de costes LLM de AgentOps

AgentOps ofrece un conjunto de potentes funciones diseñadas para abordar las complejidades de la gestión de costes de LLM. El núcleo de estas funciones es el seguimiento en tiempo real del uso y el gasto de tokens. Esta función permite a los desarrolladores supervisar los costes a medida que se producen, proporcionando una visibilidad inmediata de cómo los agentes de IA consumen los recursos de LLM. Al ofrecer este nivel de granularidad, AgentOps permite a los desarrolladores tomar decisiones informadas sobre la asignación y optimización de recursos en tiempo real.

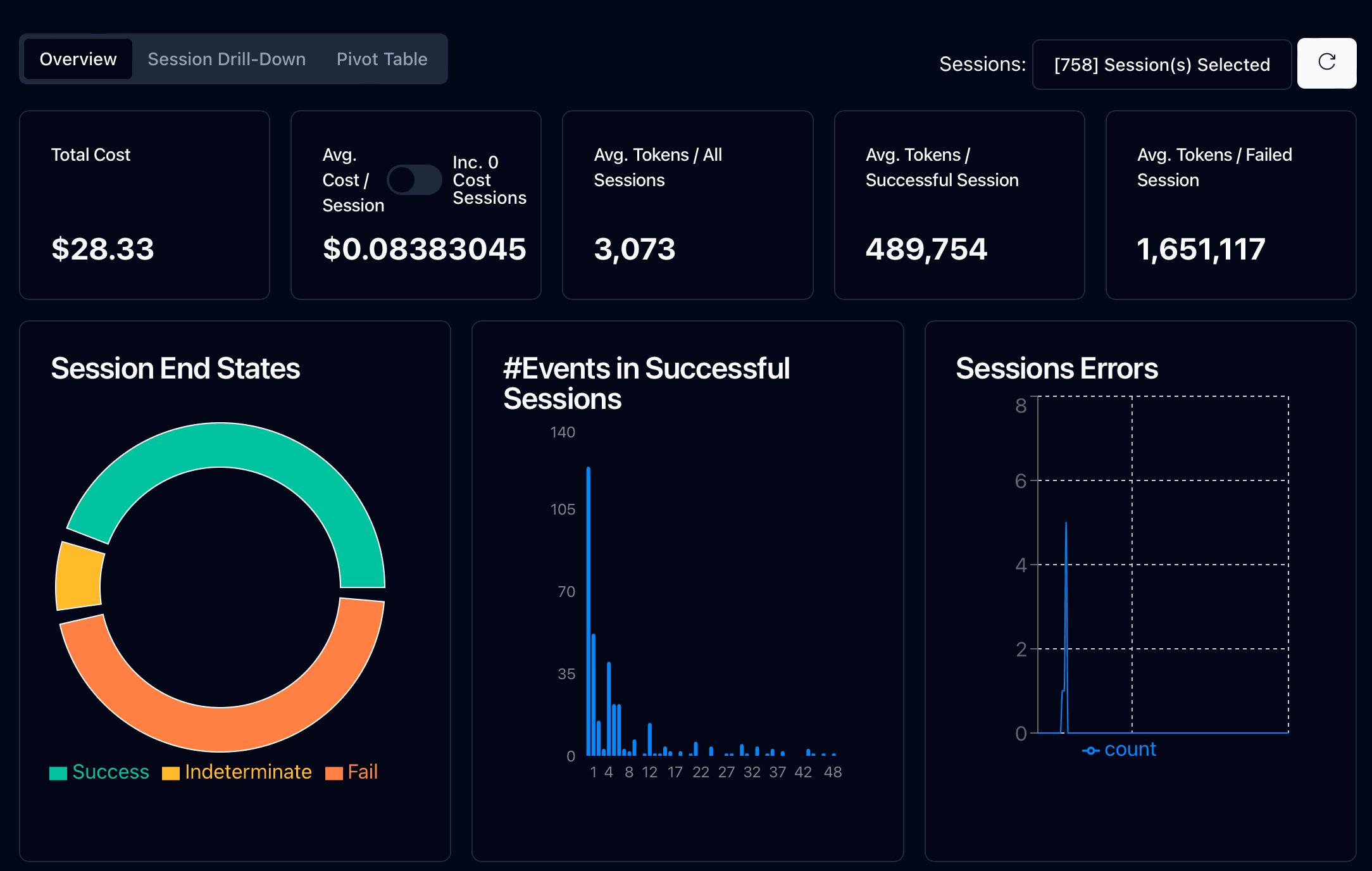

El panel de análisis para la supervisión de costes es otro componente clave del conjunto de herramientas de gestión de costes LLM de AgentOps. Esta interfaz intuitiva presenta estadísticas y métricas de alto nivel sobre los agentes tanto en entornos de desarrollo como de producción. Los desarrolladores pueden realizar fácilmente un seguimiento de los costes, el recuento de tokens, la latencia y las tasas de éxito/fracaso, obteniendo una visión completa del rendimiento y el impacto económico de sus agentes de IA.

Una de las características más valiosas de AgentOps es su instrumentación automática de proveedores LLM populares. Tras un sencillo proceso de inicialización, AgentOps se integra a la perfección con proveedores como OpenAI, Cohere y LiteLLM. Esta automatización reduce significativamente la carga de los desarrolladores, permitiéndoles capturar datos detallados de costes y uso de las llamadas LLM sin esfuerzo adicional. El resultado es un proceso de desarrollo más ágil y un seguimiento de costes más preciso.

Análisis detallado de costes y optimización

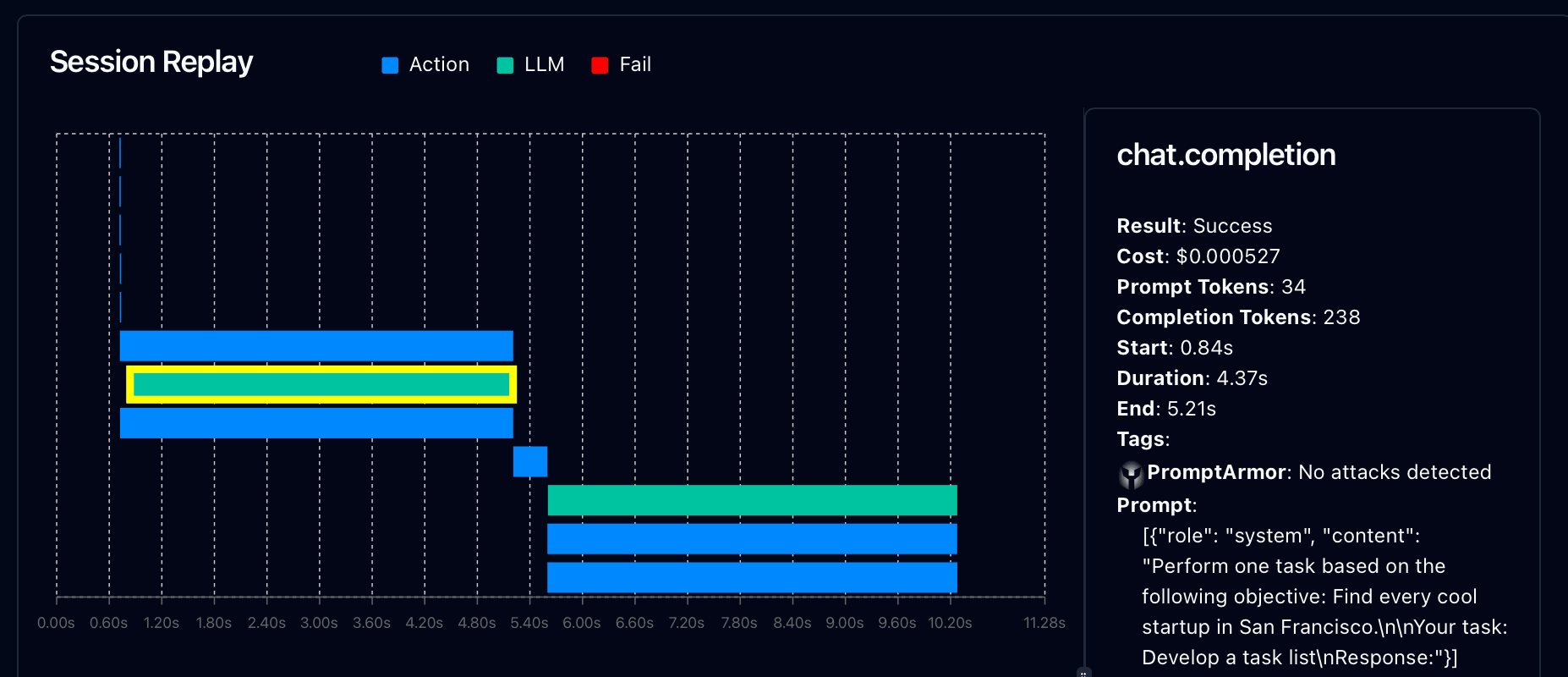

AgentOps va más allá del seguimiento básico de costes al ofrecer herramientas de análisis en profundidad para la optimización. La plataforma proporciona desgloses y repeticiones de las sesiones, lo que ofrece una visión detallada de los costes de cada interacción del agente de IA. Los desarrolladores pueden examinar paso a paso los detalles de la ejecución del agente, incluidas las solicitudes específicas de LLM, las finalizaciones, el uso de tokens y los costes asociados. Este nivel de detalle es muy valioso para identificar áreas de ineficiencia y oportunidades de reducción de costes.

Identificar las llamadas ineficientes de LLM y los patrones de uso es crucial para optimizar los costes. Las herramientas de análisis de AgentOps ayudan a los desarrolladores a identificar los casos en los que los agentes de IA pueden estar sobreutilizando los recursos LLM o realizando llamadas innecesarias. Al poner de relieve estas ineficiencias, AgentOps permite a los desarrolladores perfeccionar los diseños de sus agentes y las indicaciones para un funcionamiento más rentable.

AgentOps también proporciona estrategias para reducir el consumo de tokens, un factor clave en la gestión de los costes de LLM. La plataforma ofrece recomendaciones basadas en patrones de uso, sugiriendo formas de afinar los avisos y optimizar las interacciones con los agentes. Estas estrategias pueden incluir técnicas para ingeniería rápidaUna mejor gestión del contexto o un almacenamiento en caché más inteligente de las respuestas LLM. Al implementar estas optimizaciones, los desarrolladores pueden reducir significativamente sus costes de LLM sin comprometer el rendimiento del agente.

Integración con marcos de agentes de IA

La potencia de AgentOps en la gestión de los costes de LLM se ve amplificada por su perfecta integración con los marcos de agentes de IA más populares. Esta integración permite a los desarrolladores supervisar y optimizar los costes en diversas arquitecturas de agentes sin alterar sus flujos de trabajo actuales.

AgentOps ofrece funciones integradas de supervisión de costes para varios marcos clave:

CrewAI: Ideal para sistemas multiagente en los que el uso de LLM puede acumularse rápidamente.

AutoGen: Permite el seguimiento de los costes de las interacciones automatizadas con agentes de IA

Cadena LangChain: Ofrece información sobre los costes de las cadenas y aplicaciones de modelos lingüísticos

Entre las principales ventajas de la integración del marco de AgentOps se incluyen:

Se requiere una configuración mínima para una visibilidad instantánea de los costes del LLM

Seguimiento de los costes de todos los agentes de un sistema o tripulación

Identificación de agentes o interacciones que consumen muchos recursos

Visibilidad entre marcos para una mejor asignación de recursos

Toma de decisiones informada sobre la selección de marcos para tareas específicas

Al simplificar la gestión de costes en diferentes arquitecturas de agentes, AgentOps permite a los desarrolladores elegir las soluciones más rentables para sus aplicaciones de agentes de IA. Esta integración es crucial para las organizaciones que buscan optimizar sus inversiones en IA a través de diversas plataformas y casos de uso.

Equilibrio entre rendimiento y coste en el desarrollo de agentes de IA

Uno de los aspectos más difíciles del desarrollo de agentes de IA es encontrar el equilibrio adecuado entre rendimiento y coste. AgentOps proporciona herramientas para ayudar a los desarrolladores a navegar por este complejo equilibrio.

AgentOps ofrece información sobre la correlación entre el uso de tokens y el rendimiento del agente. Al analizar esta relación, los desarrolladores pueden identificar el punto óptimo en el que un mayor uso de tokens ya no produce mejoras significativas en el rendimiento. Este conocimiento es crucial para optimizar los agentes de IA y ofrecer el máximo valor con el mínimo coste.

Las pruebas A/B para optimizar la relación coste-rendimiento son otra potente función de AgentOps. Los desarrolladores pueden realizar pruebas paralelas con diferentes configuraciones de agentes, estrategias de avisos u opciones de modelos para determinar qué enfoque ofrece la mejor relación coste-rendimiento. Este método basado en datos elimina las conjeturas de la optimización, lo que permite tomar decisiones basadas en pruebas en el desarrollo de agentes.

Establecer y gestionar umbrales de presupuesto es un aspecto crítico de la gestión de costes de LLM que AgentOps simplifica. Los desarrolladores pueden establecer límites de costes para agentes individuales, proyectos o sistemas de IA completos. AgentOps proporciona alertas en tiempo real cuando estos umbrales se aproximan o se superan, lo que permite un control proactivo de los costes. Esta característica es especialmente valiosa para las empresas que trabajan con presupuestos fijos de IA o para aquellas que buscan escalar gradualmente sus operaciones de IA.

Seguridad y cumplimiento en la gestión de costes LLM

A medida que los agentes de IA gestionan tareas y datos cada vez más sensibles, la seguridad y el cumplimiento en la gestión de costes se vuelven primordiales. AgentOps aborda estas preocupaciones de frente, garantizando que el seguimiento de costes no comprometa la privacidad de los datos ni el cumplimiento normativo.

Garantizar la privacidad de los datos en el seguimiento de costes es un principio básico de AgentOps. La plataforma está diseñada para capturar métricas relacionadas con los costes sin exponer información sensible contenida en las solicitudes o respuestas. Esta separación permite una gestión exhaustiva de los costes sin arriesgarse a que se produzcan filtraciones de datos o se infrinjan las políticas de privacidad.

Para las empresas que operan en sectores regulados, el cumplimiento de la normativa financiera es crucial. AgentOps ayuda a navegar por estos complejos requisitos proporcionando registros de auditoría detallados del uso de LLM y los costes asociados. Estos registros pueden tener un valor incalculable para demostrar un gasto responsable en IA y cumplir las normas de información financiera.

Además, las funciones de cumplimiento de AgentOps se extienden a normativas de protección de datos como GDPR e HIPAA. La plataforma garantiza que los procesos de seguimiento y optimización de costes se ajusten a estos estrictos requisitos de gestión de datos, lo que da a las empresas la confianza necesaria para desplegar agentes de IA en entornos sensibles sin comprometer las capacidades de gestión de costes.

Desarrollo rentable de agentes de IA

AgentOps se erige como una herramienta fundamental en el cambiante panorama del desarrollo de agentes de IA, ofreciendo una solución integral para gestionar los costes de LLM sin comprometer el rendimiento ni la seguridad. Al proporcionar seguimiento de costes en tiempo real, análisis detallados e integración perfecta con marcos populares como CrewAI y AutoGen, AgentOps permite a los desarrolladores tomar decisiones informadas sobre la asignación y optimización de recursos.

La capacidad de la plataforma para equilibrar el rendimiento con la rentabilidad, junto con las sólidas funciones de seguridad y cumplimiento, la convierten en un activo valioso para las empresas que buscan aprovechar los agentes de IA de forma sostenible. A medida que la IA continúa transformando las industrias, AgentOps garantiza que las organizaciones puedan aprovechar todo el potencial de los LLM manteniendo el control sobre sus presupuestos, allanando el camino para un despliegue de agentes de IA más eficiente, rentable y responsable.