ai research paper breakdown for chainpoll a high efficacy method for llm hallucination detection

En este artículo vamos a desglosar un importante trabajo de investigación que aborda uno de los retos más acuciantes a los que se enfrentan los grandes modelos lingüísticos (LLM): las alucinaciones. El artículo, titulado "ChainPoll: Un método de alta eficacia para la detección de alucinaciones en LLMpresenta un enfoque novedoso para identificar y mitigar estas imprecisiones generadas por la IA.

El artículo ChainPoll, escrito por investigadores de Galileo Technologies Inc, presenta una nueva metodología para detectar alucinaciones en los resultados de LLM. Este método, denominado ChainPoll, supera a las alternativas existentes tanto en precisión como en eficacia. Además, el artículo presenta RealHall, un conjunto de datos de referencia cuidadosamente seleccionados y diseñados para evaluar las métricas de detección de alucinaciones de forma más eficaz que los puntos de referencia anteriores.

Las alucinaciones en los LLM hacen referencia a los casos en los que estos modelos de IA generan texto que es incorrecto, carece de sentido o no guarda relación con los datos de entrada. A medida que los LLM se integran cada vez más en diversas aplicaciones, desde chatbots a herramientas de creación de contenidos, el riesgo de propagar información errónea a través de estas alucinaciones crece exponencialmente. Este problema plantea un reto importante para la fiabilidad y la confianza en los contenidos generados por IA.

La capacidad de detectar y mitigar con precisión las alucinaciones es crucial para el despliegue responsable de los sistemas de IA. Esta investigación proporciona un método más sólido para identificar estos errores, lo que puede mejorar la fiabilidad de los contenidos generados por IA, aumentar la confianza de los usuarios en las aplicaciones de IA y reducir el riesgo de difusión de información errónea a través de los sistemas de IA. Al abordar el problema de la alucinación, esta investigación allana el camino para aplicaciones de IA más fiables y dignas de confianza en diversos sectores.

Antecedentes y planteamiento del problema

La detección de alucinaciones en los resultados de los LLM es una tarea compleja debido a varios factores. El gran volumen de texto que pueden generar los LLM, combinado con la naturaleza a menudo sutil de las alucinaciones, hace que sea difícil distinguirlas de la información precisa. Además, la naturaleza dependiente del contexto de muchas alucinaciones y la falta de una "verdad básica" exhaustiva con la que cotejar todo el contenido generado complican aún más el proceso de detección.

Antes del artículo ChainPoll, los métodos de detección de alucinaciones existentes se enfrentaban a varias limitaciones. Muchos carecían de eficacia en diversas tareas y ámbitos, mientras que otros eran demasiado costosos desde el punto de vista computacional para aplicaciones en tiempo real. Algunos métodos dependían de arquitecturas de modelos o datos de entrenamiento específicos, y la mayoría tenía dificultades para distinguir entre distintos tipos de alucinaciones, como los errores factuales frente a los contextuales.

Además, los puntos de referencia utilizados para evaluar estos métodos a menudo no reflejaban los verdaderos retos que plantean los LLM de última generación en las aplicaciones del mundo real. Muchos se basaban en modelos más antiguos y débiles o se centraban en tareas limitadas y específicas que no representaban toda la gama de capacidades y alucinaciones potenciales de los LLM.

Para resolver estos problemas, los investigadores del estudio ChainPoll adoptaron un doble enfoque:

Desarrollo de un nuevo método de detección de alucinaciones más eficaz (ChainPoll)

Creación de un conjunto de criterios de referencia más pertinentes y exigentes (RealHall)

Este enfoque global tenía como objetivo no sólo mejorar la detección de alucinaciones, sino también establecer un marco más sólido para evaluar y comparar distintos métodos de detección.

Principales aportaciones del documento

El documento ChainPoll realiza tres contribuciones principales al campo de la investigación y el desarrollo de la IA, cada una de las cuales aborda un aspecto crítico del reto de la detección de alucinaciones.

En primer lugar, se presenta ChainPolluna novedosa metodología de detección de alucinaciones. ChainPoll aprovecha el poder de los propios LLM para identificar alucinaciones, utilizando una técnica de incitación cuidadosamente diseñada y un método de agregación para mejorar la precisión y la fiabilidad. Emplea una cadena de pensamiento para obtener explicaciones más detalladas y sistemáticas, ejecuta múltiples iteraciones del proceso de detección para aumentar la fiabilidad y se adapta a escenarios de detección de alucinaciones tanto en dominio abierto como en dominio cerrado.

En segundo lugar, reconociendo las limitaciones de los puntos de referencia existentes, los autores desarrollaron RealHallun nuevo conjunto de datos de referencia. RealHall está diseñado para proporcionar una evaluación más realista y exigente de los métodos de detección de alucinaciones. Comprende cuatro conjuntos de datos cuidadosamente seleccionados que suponen un reto incluso para los LLM más avanzados, se centra en tareas relevantes para las aplicaciones LLM del mundo real y abarca escenarios de alucinación tanto de dominio abierto como de dominio cerrado.

Por último, el artículo ofrece una comparación exhaustiva de ChainPoll con una amplia gama de métodos existentes de detección de alucinaciones. Esta exhaustiva evaluación utiliza el recién desarrollado conjunto de pruebas comparativas RealHall, incluye tanto métricas establecidas como innovaciones recientes en este campo, y tiene en cuenta factores como la precisión, la eficiencia y la rentabilidad. A través de esta evaluación, el documento demuestra el rendimiento superior de ChainPoll en varias tareas y tipos de alucinaciones.

Al ofrecer estas tres contribuciones clave, el documento ChainPoll no sólo avanza el estado del arte en la detección de alucinaciones, sino que también proporciona un marco más sólido para la investigación y el desarrollo futuros en esta área crítica de la seguridad y la fiabilidad de la IA.

La metodología de ChainPoll

En esencia, ChainPoll aprovecha las capacidades de los propios modelos lingüísticos de gran tamaño para identificar alucinaciones en textos generados por IA. Este enfoque destaca por su sencillez, eficacia y adaptabilidad a distintos tipos de alucinaciones.

Cómo funciona ChainPoll

El método ChainPoll se basa en un principio sencillo pero potente. Utiliza un LLM (en concreto, GPT-3.5-turbo en los experimentos del artículo) para evaluar si una terminación de texto dada contiene alucinaciones.

El proceso consta de tres pasos fundamentales:

En primer lugar, el sistema pide al LLM que evalúe la presencia de alucinaciones en el texto de destino, utilizando un algoritmo cuidadosamente diseñado. consulte.

A continuación, este proceso se repite varias veces, normalmente cinco, para garantizar la fiabilidad.

Por último, el sistema calcula una puntuación dividiendo el número de respuestas afirmativas (que indican la presencia de alucinaciones) por el número total de respuestas.

Este enfoque permite a ChainPoll aprovechar las capacidades de comprensión lingüística de los LLM y, al mismo tiempo, mitigar los errores de evaluación individuales mediante la agregación.

El papel del estímulo de la cadena de pensamiento

Una innovación crucial en ChainPoll es el uso de la cadena de pensamiento (CoT). Esta técnica anima al LLM a explicar paso a paso su razonamiento a la hora de determinar si un texto contiene alucinaciones. Los autores descubrieron que una indicación de "CoT detallada" cuidadosamente diseñada obtenía del modelo explicaciones más sistemáticas y fiables.

Al incorporar CoT, ChainPoll no sólo mejora la precisión de la detección de alucinaciones, sino que también proporciona información valiosa sobre el proceso de toma de decisiones del modelo. Esta transparencia puede ser crucial para entender por qué ciertos textos se marcan como alucinaciones, lo que podría ayudar a desarrollar LLM más sólidos en el futuro.

Diferenciación entre alucinaciones de dominio abierto y de dominio cerrado

Uno de los puntos fuertes de ChainPoll es su capacidad para abordar tanto las alucinaciones de dominio abierto como las de dominio cerrado. Las alucinaciones de dominio abierto se refieren a afirmaciones falsas sobre el mundo en general, mientras que las de dominio cerrado implican incoherencias con un texto o contexto de referencia específico.

Para manejar estos diferentes tipos de alucinaciones, los autores desarrollaron dos variantes de ChainPoll: ChainPoll-Corrección para alucinaciones de dominio abierto y ChainPoll-Adherencia para alucinaciones de dominio cerrado. Estas variantes difieren principalmente en su estrategia de incitación, lo que permite al sistema adaptarse a diferentes contextos de evaluación, manteniendo al mismo tiempo la metodología básica de ChainPoll.

El paquete RealHall Benchmark

Reconociendo las limitaciones de los puntos de referencia existentes, los autores también desarrollaron RealHall, un nuevo conjunto de puntos de referencia diseñado para proporcionar una evaluación más realista y desafiante de los métodos de detección de alucinaciones.

Criterios de selección del conjunto de datos (desafío, realismo, diversidad de tareas)

La creación de RealHall se guió por tres principios clave:

Desafío: Los conjuntos de datos deberían plantear dificultades significativas incluso para los LLM más avanzados, garantizando que la referencia siga siendo relevante a medida que mejoran los modelos.

Realismo: Las tareas deben reflejar fielmente las aplicaciones de los LLM en el mundo real, para que los resultados de las evaluaciones comparativas sean más aplicables a escenarios prácticos.

Diversidad de tareas: El conjunto debe cubrir una amplia gama de capacidades de LLM, proporcionando una evaluación completa de los métodos de detección de alucinaciones.

Estos criterios condujeron a la selección de cuatro conjuntos de datos que, en conjunto, ofrecen un sólido campo de pruebas para los métodos de detección de alucinaciones.

Visión general de los cuatro conjuntos de datos de RealHall

RealHall consta de dos pares de conjuntos de datos, cada uno de los cuales aborda un aspecto diferente de la detección de alucinaciones:

RealHall Cerrado: Este par incluye el conjunto de datos COVID-QA con recuperación y el conjunto de datos DROP. Se centran en las alucinaciones de dominio cerrado y ponen a prueba la capacidad de un modelo para mantener la coherencia con los textos de referencia proporcionados.

RealHall Open: Este par está formado por el conjunto de datos Open Assistant prompts y el conjunto de datos TriviaQA. Se centran en las alucinaciones de dominio abierto y evalúan la capacidad de un modelo para evitar hacer afirmaciones falsas sobre el mundo.

Cada conjunto de datos de RealHall se eligió por sus desafíos únicos y su relevancia para las aplicaciones LLM del mundo real. Por ejemplo, el conjunto de datos COVID-QA imita escenarios de recuperación y generación aumentada, mientras que DROP pone a prueba la capacidad de razonamiento discreto.

Cómo aborda RealHall las limitaciones de las anteriores evaluaciones comparativas

RealHall representa una mejora significativa con respecto a las pruebas anteriores en varios aspectos. En primer lugar, utiliza LLM más recientes y potentes para generar respuestas, lo que garantiza que las alucinaciones detectadas sean representativas de las producidas por los modelos más avanzados. De este modo se resuelve un problema común de las pruebas anteriores, que utilizaban modelos obsoletos que producían alucinaciones fácilmente detectables.

En segundo lugar, el hecho de que RealHall se centre en la diversidad de tareas y el realismo significa que proporciona una evaluación más exhaustiva y relevante desde el punto de vista práctico de los métodos de detección de alucinaciones. Esto contrasta con muchas pruebas comparativas anteriores que se centraban en tareas específicas o escenarios artificiales.

Por último, al incluir tareas tanto de dominio abierto como de dominio cerrado, RealHall permite una evaluación más matizada de los métodos de detección de alucinaciones. Esto es especialmente importante, ya que muchas aplicaciones LLM del mundo real requieren ambos tipos de detección de alucinaciones.

Gracias a estas mejoras, RealHall proporciona un punto de referencia más riguroso y relevante para evaluar los métodos de detección de alucinaciones, estableciendo un nuevo estándar en este campo.

Resultados experimentales y análisis

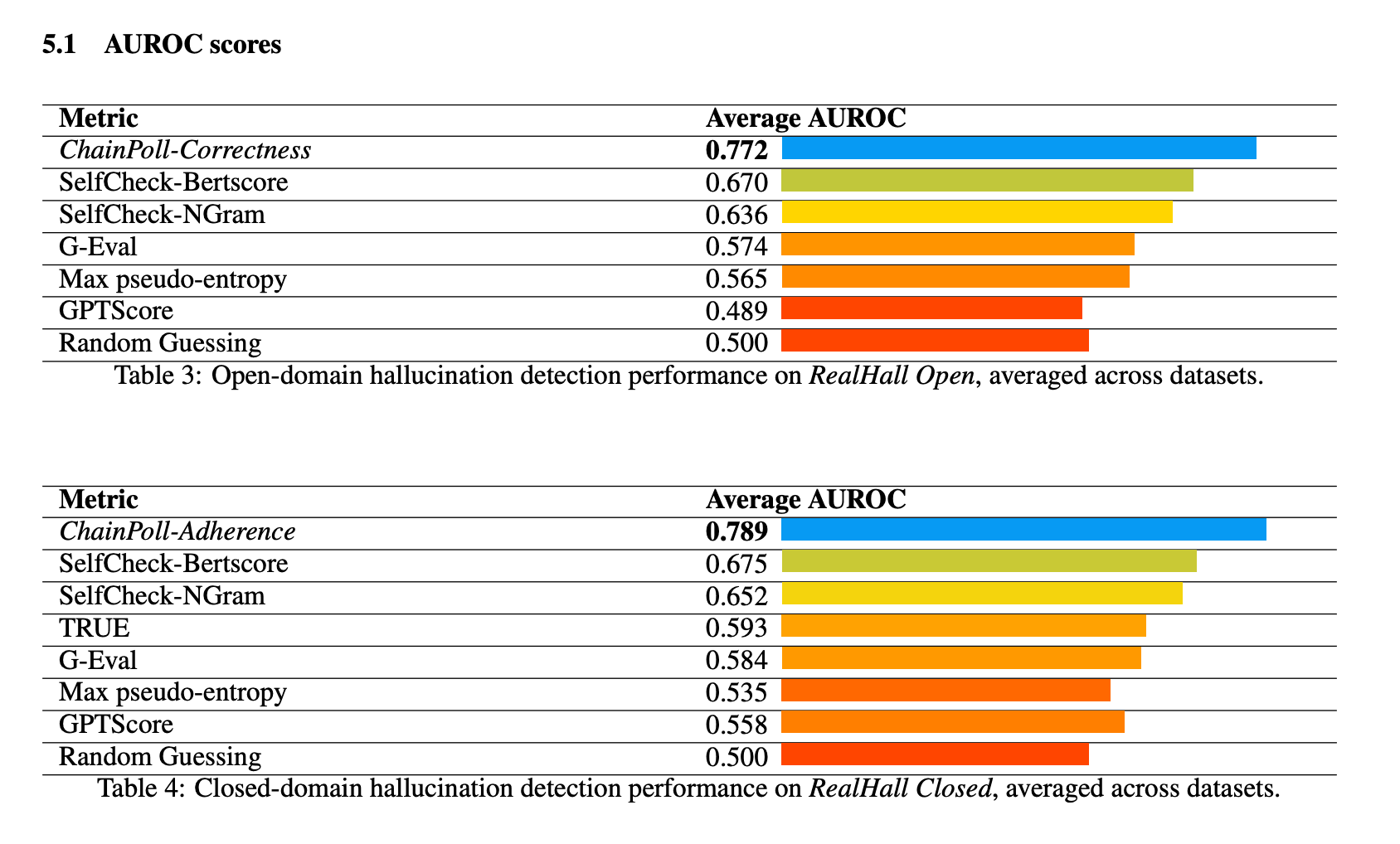

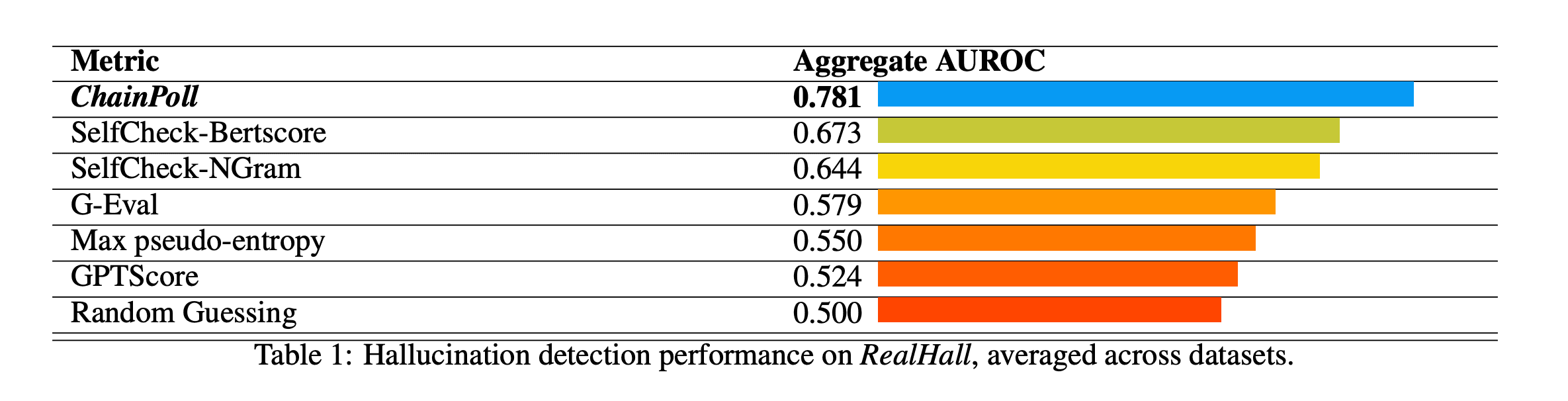

ChainPoll demostró un rendimiento superior en todas las pruebas del paquete RealHall. Alcanzó un AUROC (Area Under the Receiver Operating Characteristic curve) agregado de 0,781, superando significativamente al siguiente mejor método, SelfCheck-BertScore, que obtuvo una puntuación de 0,673. Esta mejora sustancial respecto a 10% representa un salto significativo en la capacidad de detección de alucinaciones.

Otros métodos probados fueron SelfCheck-NGram, G-Eval y GPTScore, todos ellos notablemente peores que ChainPoll. Curiosamente, algunos métodos que habían resultado prometedores en estudios anteriores, como GPTScore, obtuvieron malos resultados en las pruebas RealHall, más exigentes y diversas.

El rendimiento de ChainPoll fue consistentemente bueno tanto en las tareas de detección de alucinaciones de dominio abierto como en las de dominio cerrado. En las tareas de dominio abierto (utilizando ChainPoll-Corrección), alcanzó un AUROC medio de 0,772, mientras que en las tareas de dominio cerrado (utilizando ChainPoll-Adherencia), obtuvo una puntuación de 0,789.

El método demostró ser especialmente eficaz en conjuntos de datos difíciles como DROP, que requiere un razonamiento discreto.

Además de su precisión superior, ChainPoll también ha demostrado ser más eficaz y rentable que muchos métodos de la competencia. Alcanza sus resultados utilizando sólo 1/4 de la inferencia LLM que el siguiente mejor método, SelfCheck-BertScore. Además, ChainPoll no requiere el uso de modelos adicionales como BERT, lo que reduce aún más la carga computacional.

Esta eficacia es crucial para las aplicaciones prácticas, ya que permite detectar alucinaciones en tiempo real en entornos de producción sin incurrir en costes o latencias prohibitivos.

Implicaciones y trabajo futuro

ChainPoll representa un avance significativo en el campo de la detección de alucinaciones para los LLM. Su éxito demuestra el potencial de utilizar los propios LLM como herramientas para mejorar la seguridad y fiabilidad de la IA. Este enfoque abre nuevas vías para la investigación de sistemas de IA que se mejoren y comprueben a sí mismos.

La eficacia y precisión de ChainPoll lo hacen idóneo para su integración en una amplia gama de aplicaciones de IA. Podría utilizarse para aumentar la fiabilidad de los chatbots, mejorar la precisión de los contenidos generados por IA en campos como el periodismo o la escritura técnica, y aumentar la fiabilidad de los asistentes de IA en ámbitos críticos como la sanidad o las finanzas.

Aunque ChainPoll muestra unos resultados impresionantes, aún se puede seguir investigando y mejorando. El trabajo futuro podría explorar:

Adaptación de ChainPoll para trabajar con una gama más amplia de LLM y tareas lingüísticas

Investigar formas de mejorar aún más la eficiencia sin sacrificar la precisión.

Exploración del potencial de ChainPoll para otros tipos de contenidos generados por IA, además del texto

Desarrollar métodos no sólo para detectar, sino también para corregir o prevenir alucinaciones en tiempo real.

El artículo ChainPoll contribuye de forma significativa al campo de la seguridad y la fiabilidad de la IA mediante la introducción de un nuevo método de detección de alucinaciones y un parámetro de evaluación más sólido. Al demostrar un rendimiento superior en la detección de alucinaciones tanto en dominio abierto como en dominio cerrado, ChainPoll allana el camino hacia sistemas de IA más fiables. A medida que los LLM siguen desempeñando un papel cada vez más importante en diversas aplicaciones, la capacidad de detectar y mitigar con precisión las alucinaciones se vuelve crucial. Esta investigación no sólo avanza nuestras capacidades actuales, sino que también abre nuevas vías para la exploración y el desarrollo futuros en el área crítica de la detección de alucinaciones por IA.