4 buenas prácticas para evitar las prohibiciones de la API de OpenAI y garantizar el cumplimiento de la normativa

Si su empresa está involucrada con la IA en cualquier aspecto, el cumplimiento es más crítico que nunca, especialmente cuando se aprovechan modelos de IA como los proporcionados por OpenAI. Lo que muchas empresas no saben es que el incumplimiento de las políticas de OpenAI por parte de los usuarios puede llevar a la prohibición de su acceso a la API, a menudo sin previo aviso. Para las empresas que gestionan múltiples usuarios, garantizar el cumplimiento de las políticas de OpenAI es crucial para mantener un acceso ininterrumpido a estas potentes herramientas. El incumplimiento de las condiciones puede acarrear graves consecuencias, incluidas prohibiciones que podrían perturbar considerablemente las operaciones de su empresa.

OpenAI ha establecido un amplio conjunto de políticas destinadas a prevenir el uso indebido. Estas políticas no solo protegen la plataforma, sino que también garantizan el uso responsable de las tecnologías de IA en todos los sectores. Las empresas que utilizan las API de OpenAI deben ser diligentes a la hora de supervisar el comportamiento de los usuarios para evitar infracciones que puedan dar lugar a sanciones o prohibiciones. Comprender y navegar eficazmente por estas políticas es la clave para mantener el acceso y obtener una ventaja competitiva en el espacio de la IA.

Políticas de uso de la API de OpenAI

Las políticas de uso de las API de OpenAI están diseñadas para salvaguardar el uso ético y apropiado de la IA. El uso indebido de estas API, en particular a través de contenidos generados por los usuarios, puede conducir rápidamente a la suspensión o prohibición de cuentas. El mal comportamiento de los usuarios, como el envío de contenido inapropiado o dañino, no sólo viola los términos de OpenAI, sino que también pone en riesgo cuentas enteras.

OpenAI supervisa activamente los patrones de uso y evalúa las acciones ocultas que puedan infringir sus directrices. Por ejemplo, el envío de contenidos inapropiados o los intentos de eludir los filtros de contenidos pueden acarrear importantes repercusiones. OpenAI oculta detalles específicos sobre cómo evalúa las solicitudes, manteniendo tan herméticos sus procesos de moderación para garantizar el cumplimiento de las normas sin comprometerlas. De este modo, OpenAI se asegura de que sus modelos se utilicen de forma acorde con sus normas éticas.

Para evitar estos problemas, es esencial que los desarrolladores y las empresas sean proactivos en la aplicación de las directrices de OpenAI y aprovechen las herramientas integradas como la punto final de moderaciónque puede ayudar a filtrar contenidos potencialmente dañinos antes de que lleguen a la API. Comprender los aspectos clave del uso indebido y ser consciente de cómo OpenAI rastrea las infracciones permitirá a las empresas gestionar los riesgos de forma más eficaz.

Retos de las aplicaciones multiusuario

Para las empresas que gestionan aplicaciones con múltiples usuarios, los riesgos asociados al uso indebido de la API son significativamente mayores. Cada usuario tiene el potencial de violar inadvertida o intencionadamente las políticas de OpenAI, lo que conlleva consecuencias que afectan a toda la organización. Esto hace que sea vital para los desarrolladores comprender los desafíos únicos que plantean los entornos multiusuario.

La gestión de múltiples usuarios presenta retos específicos, como los diferentes niveles de comprensión del uso aceptable, la adhesión inconsistente a las directrices y el potencial de comportamiento malicioso de un pequeño subconjunto de usuarios. Cada interacción de usuario debe supervisarse cuidadosamente porque una sola infracción puede poner en peligro todo el acceso a la API de una organización. Además, escalar una plataforma con múltiples usuarios introduce complejidades a la hora de garantizar que todos los usuarios cumplen las normas sin sobrecargar el sistema con comprobaciones manuales.

A diferencia de los modelos de IA anteriores, que podrían haber sido menos estrictos, el último modelo de IA de OpenAI viene con directrices de cumplimiento más estrictas que se supervisan de cerca. Las empresas deben asumir la responsabilidad de supervisar los contenidos generados por los usuarios para evitar infracciones, y esto implica implementar el filtrado automatizado de contenidos y las comprobaciones de cumplimiento. Medidas proactivas como integrar el punto final de moderación de OpenAI, establecer políticas de uso claras para los usuarios finales y proporcionar recursos educativos a los usuarios sobre el contenido aceptable pueden ayudar a mitigar estos riesgos y garantizar la disponibilidad continua de la API.

Mediante la gestión eficaz del comportamiento individual de los usuarios y la implementación de herramientas de supervisión sólidas, las empresas pueden evitar ser penalizadas por las acciones de unos pocos malos actores. Invertir en procesos y herramientas de gestión de usuarios no solo ayuda a cumplir la normativa, sino que también crea un entorno más fiable para todos los usuarios, lo que en última instancia respalda los objetivos a largo plazo de la empresa con la integración de la IA.

Buenas prácticas para evitar los bloqueos de la API de OpenAI

Para evitar prohibiciones y garantizar que el uso de su API sigue siendo conforme, es fundamental aplicar buenas prácticas específicas. He aquí varias estrategias que los desarrolladores y las empresas pueden seguir:

Utilice el punto final de moderación: OpenAI proporciona un punto final de moderación gratuito que ayuda a identificar contenidos nocivos antes de que lleguen a la API. Esta herramienta es esencial para filtrar contenidos inapropiados y reducir el riesgo de sanciones.

Límites de tarifa e identificadores únicos de usuario: Implantar límites de velocidad y asignar identificadores de usuario únicos a cada solicitud de API puede ayudar a gestionar y rastrear el comportamiento de los usuarios. Al controlar el volumen de solicitudes y vincularlas a usuarios individuales, resulta más fácil identificar y restringir las cuentas problemáticas.

Supervisión y registro en tiempo real: Establezca sistemas de supervisión en tiempo real para hacer un seguimiento del uso de la API. El registro de cada solicitud permite a los desarrolladores auditar el comportamiento de los usuarios y detectar anomalías en una fase temprana.

Validación de entrada: Asegúrese de que todas las entradas están validadas para evitar que la API procese datos perjudiciales o inadecuados. Una validación adecuada de las entradas puede mitigar los riesgos y mejorar el cumplimiento.

Estas prácticas no sólo minimizan el riesgo de infracciones, sino que también proporcionan a las empresas una ventaja competitiva, ya que demuestran un compromiso con el uso responsable de la IA. La incorporación de un enfoque estructurado para el cumplimiento, incluido el uso de las herramientas integradas de OpenAI, puede conducir en última instancia a un uso más fiable y eficaz de los modelos de IA.

Comprender el punto final de moderación de OpenAI

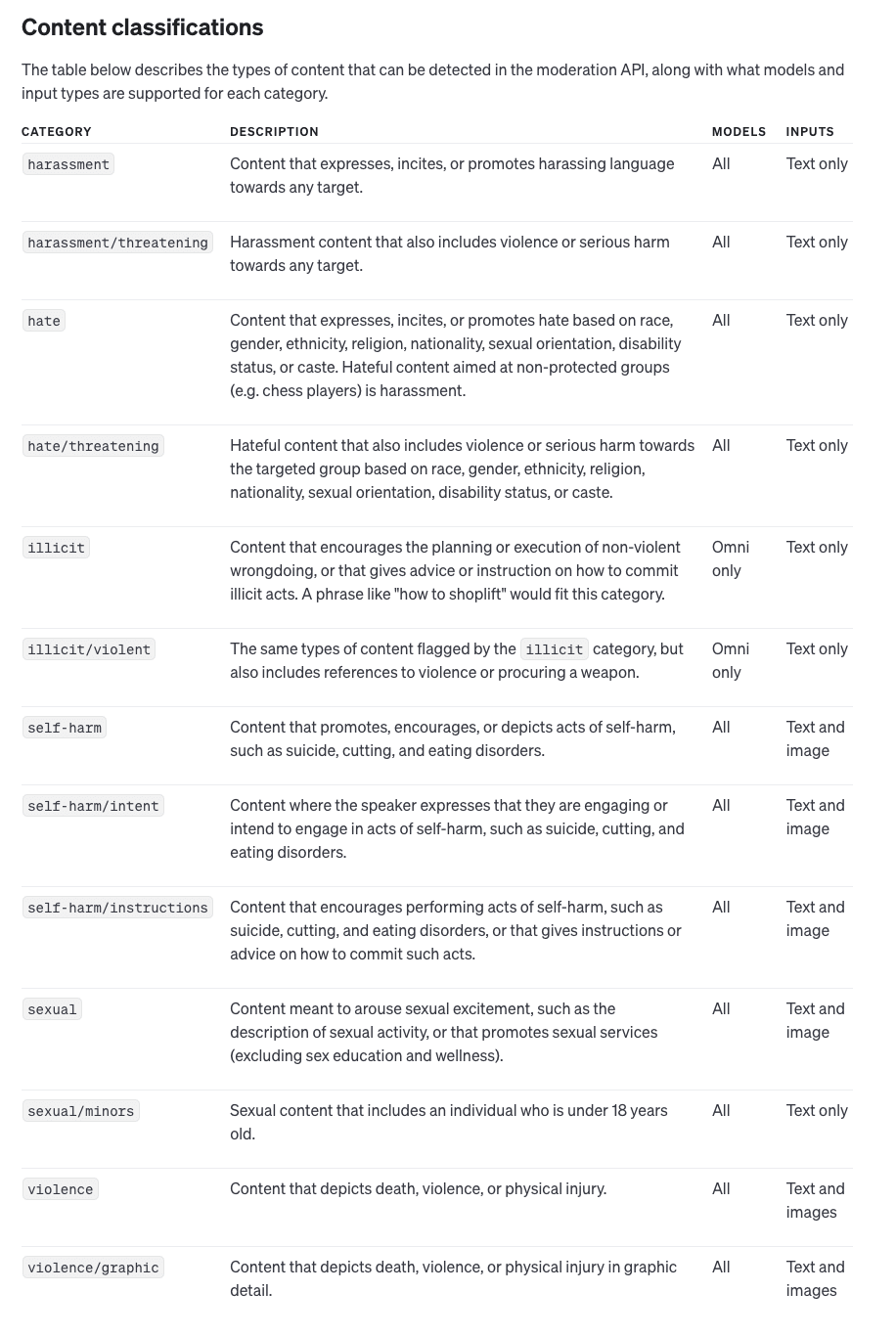

El punto final de moderación proporcionado por OpenAI es una herramienta fundamental para garantizar que los contenidos nocivos no pasen por el sistema, ayudando así a mantener el cumplimiento y evitar prohibiciones. El punto final puede analizar tanto texto como imágenes, identificando categorías potencialmente dañinas como violencia, incitación al odio, etc.

El punto final de moderación de OpenAI ofrece las siguientes funciones:

Modelo de omnicanalidad: Esta es la última versión y admite múltiples opciones de categorización y multimodal por lo que es adecuado tanto para texto como para imágenes.

Moderación de textos heredados: Los modelos más antiguos que sólo admiten entradas de texto tienen menos capacidades de categorización. Sin embargo, para las nuevas aplicaciones, se recomienda el modelo omnicanal.

El uso del punto final de moderación implica pasar datos de entrada a la API de OpenAI, que luego proporciona una respuesta detallada. Esta respuesta incluye:

Contenido marcado: El punto final establece una bandera en true si la entrada contiene contenido dañino o inapropiado.

Puntuaciones por categoría: Un sistema de puntuación detallado que indica el nivel de confianza del modelo en su categorización de contenidos potencialmente nocivos.

Datos específicos de la categoría: El punto final proporciona una indicación de qué tipos de entrada (por ejemplo, texto o imagen) desencadenaron la categorización, lo que permite esfuerzos de moderación más precisos.

Al implementar el punto final de moderación, las empresas pueden tomar medidas proactivas, filtrando el contenido marcado antes de que llegue a la API principal de OpenAI. De este modo, no solo se protege la integridad del modelo de IA, sino que también se minimiza el riesgo de que se infrinjan las políticas y se prohíba el uso de la API.

Garantizar el cumplimiento y la ventaja competitiva

Cumplir las normas no es sólo evitar sanciones; también puede servir como ventaja competitiva en el sector de la IA. Las empresas que se adhieren estrictamente a las directrices de OpenAI tienen menos probabilidades de sufrir interrupciones, lo que les permite ofrecer servicios coherentes y fiables a sus usuarios.

Además, ser proactivo a la hora de garantizar el cumplimiento significa que las empresas pueden aprovechar todo el potencial de los modelos de IA de OpenAI. Al comprender el proceso de razonamiento que subyace a las políticas de OpenAI y aplicar las mejores prácticas, las organizaciones se posicionan como líderes responsables en el espacio de la IA. El cumplimiento ayuda a generar confianza, tanto con los usuarios como con los socios del sector, lo que permite a las empresas diferenciarse de los competidores que pueden no ser tan diligentes.

Lo esencial

El uso responsable de la API es fundamental para mantener el acceso a las potentes herramientas de OpenAI. El incumplimiento de las políticas de OpenAI puede acarrear graves consecuencias, incluidas prohibiciones de la API que pueden interrumpir significativamente sus operaciones comerciales. Los desarrolladores y las empresas deben ser proactivos a la hora de gestionar el comportamiento de los usuarios, implementar estrategias de moderación y adherirse a las mejores prácticas para evitar infracciones.

En última instancia, seguir las directrices de OpenAI no solo evita interrupciones, sino que también posiciona a las empresas como líderes en el uso ético de la IA. Al demostrar un compromiso con el cumplimiento, las organizaciones pueden asegurar su acceso a la API, mejorar su ventaja competitiva y contribuir positivamente a la evolución de la industria de la IA.