10 buenas prácticas para gestionar el contenido generado por los usuarios con la API de OpenAI

Gestionar el contenido generado por los usuarios es crucial para mantener el cumplimiento de las políticas de OpenAI. Permitir contenido no controlado puede acarrear graves repercusiones, como prohibiciones de API, que pueden interrumpir significativamente las operaciones. En este blog, exploraremos diez buenas prácticas que pueden ayudar a las empresas a gestionar eficazmente el contenido generado por los usuarios, garantizando el cumplimiento y la seguridad.

- 1. Utilizar el punto final de moderación

- 2. Implantar identificadores únicos de usuario

- 3. Educar a los usuarios sobre las directrices de contenido

- 4. Supervisar y registrar la actividad de los usuarios

- 5. Limitación de velocidad y estrangulamiento

- 6. Tratamiento de errores y retroalimentación

- 7. Revisar y actualizar periódicamente las políticas

- 8. Utilizar herramientas de filtrado automático

- 9. Eficacia de la moderación

- 10. Comprometerse con el soporte de OpenAI

- Lo esencial

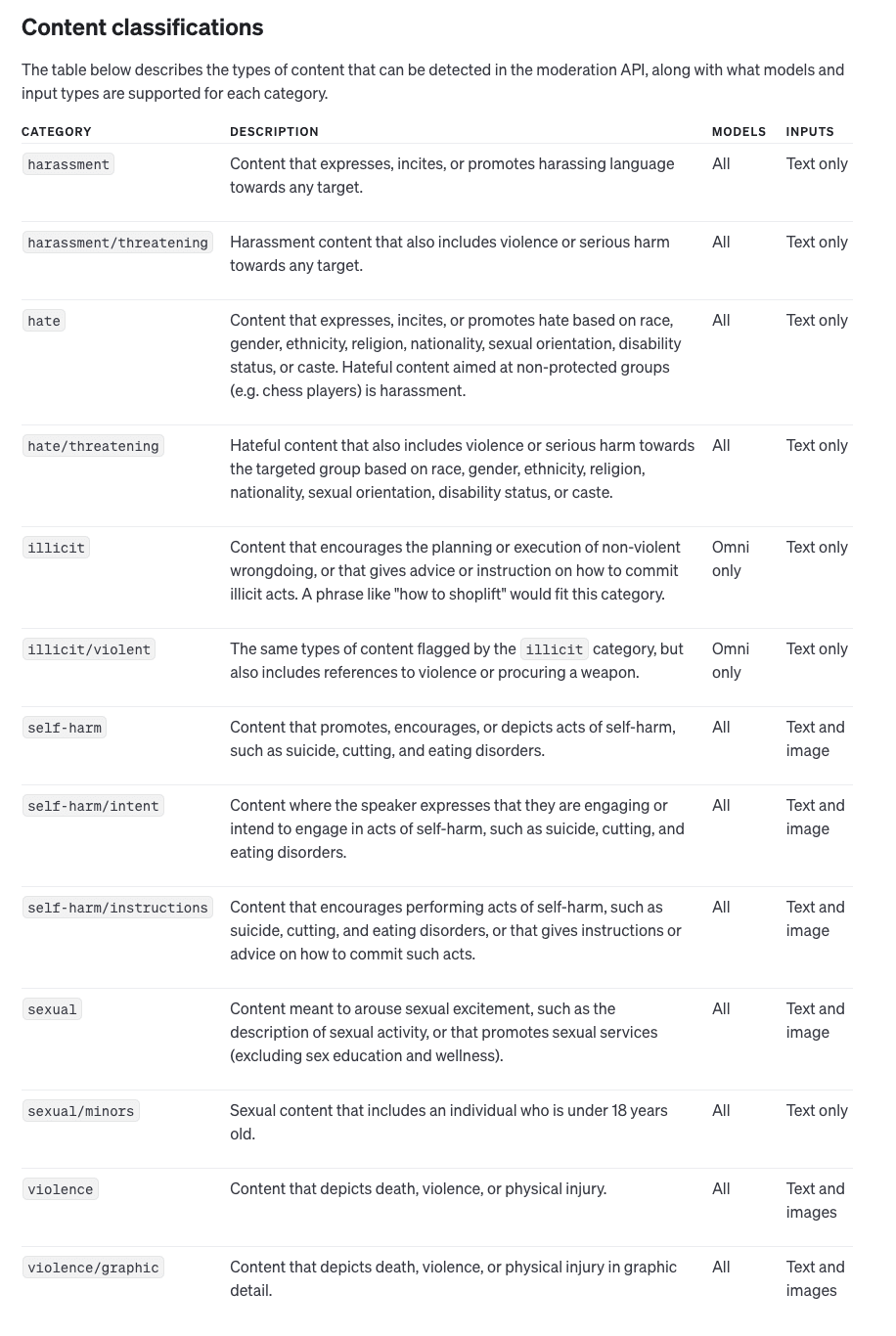

1. Utilizar el punto final de moderación

El punto final de moderación de OpenAI es una potente herramienta que ayuda a detectar y filtrar contenidos potencialmente nocivos antes de que lleguen a la API. El punto final puede analizar entradas de texto e imágenes, identificando categorías como incitación al odio y violencia. La integración de esta herramienta es sencilla y consiste en comprobar cada entrada del usuario con el punto final de moderación antes de enviarla a la API principal, lo que minimiza eficazmente el riesgo de infracciones.

Al utilizar el punto final de moderación de forma proactiva, las empresas pueden asegurarse de que están filtrando los contenidos nocivos lo antes posible. Esto no sólo ayuda a mantener el cumplimiento de las políticas de OpenAI, sino que también proporciona una experiencia de usuario más positiva al evitar el envío de contenido inapropiado. Aprovechar este punto final permite a las empresas mitigar los riesgos desde el principio, reduciendo las posibilidades de recibir advertencias o prohibiciones de OpenAI.

2. Implantar identificadores únicos de usuario

Incluir un identificador único de usuario (usuario_id) en cada llamada a la API es vital para rastrear usuarios individuales. Esto permite a OpenAI identificar qué usuario podría ser responsable de cualquier violación de la política, protegiendo su aplicación en su conjunto de ser penalizado debido a las acciones de un solo usuario. El seguimiento de usuarios también proporciona una pista de auditoría clara, por lo que es más fácil hacer cumplir la responsabilidad y mantener el cumplimiento.

Los identificadores únicos de usuario también pueden ayudarle a aplicar controles de moderación más granulares. Por ejemplo, si un usuario en particular intenta constantemente enviar contenido dañino, puede tomar medidas para bloquear o limitar el acceso de ese usuario sin afectar a los demás. Este nivel de control garantiza que las acciones de un usuario no comprometan la disponibilidad y reputación de su aplicación en su conjunto.

3. Educar a los usuarios sobre las directrices de contenido

Para reducir la probabilidad de infracciones, eduque a sus usuarios sobre los contenidos aceptables. Comunique claramente los tipos de contenido que no están permitidos, como la incitación al odio o las imágenes violentas. Proporcionar directrices detalladas sobre contenidos puede evitar que los usuarios envíen material dañino, protegiendo el acceso a tu API y reduciendo la necesidad de intervenciones de moderación.

Además de publicar directrices sobre contenidos, considera la posibilidad de incorporar avisos y recordatorios educativos en tu interfaz de usuario. Al orientar activamente a los usuarios sobre qué tipos de contenidos son apropiados, puede reducir las infracciones involuntarias. Este enfoque proactivo no sólo ayuda a mantener el cumplimiento, sino que también fomenta una cultura de creación responsable de contenidos entre sus usuarios.

4. Supervisar y registrar la actividad de los usuarios

El registro detallado de las interacciones de los usuarios es una parte esencial de la gestión de los contenidos generados por ellos. Al supervisar la actividad de los usuarios, las empresas pueden identificar rápidamente patrones de uso indebido y abordar los problemas antes de que se agraven. Los registros pueden proporcionar pruebas cruciales para abordar el comportamiento de los usuarios y pueden utilizarse para mejorar las estrategias de moderación con el tiempo.

Mantener registros exhaustivos también permite mejorar la auditoría y la rendición de cuentas. Si se produce una infracción, disponer de un historial bien documentado permite rastrear e identificar exactamente dónde se produjeron los errores. Esto ayuda a perfeccionar el enfoque de moderación y a crear reglas y filtros más eficaces para evitar problemas similares en el futuro.

5. Limitación de velocidad y estrangulamiento

Implemente límites de velocidad para controlar las solicitudes excesivas de usuarios individuales. El estrangulamiento garantiza que ningún usuario pueda sobrecargar el sistema o enviar repetidamente contenidos problemáticos. Esto no solo protege tu API de abusos, sino que también ayuda a mantener la estabilidad del sistema y el acceso equitativo para todos los usuarios.

La limitación de velocidad también puede servir como mecanismo de alerta temprana para identificar posibles usos indebidos. Por ejemplo, si un usuario de repente empieza a enviar solicitudes a un ritmo anormalmente alto, puede indicar un comportamiento malicioso o una automatización que intenta explotar su API. Al detectar estos patrones en una fase temprana, puede mitigar las amenazas potenciales antes de que den lugar a infracciones más importantes.

6. Tratamiento de errores y retroalimentación

Un sistema sólido de gestión de errores es crucial para mejorar la experiencia del usuario y, al mismo tiempo, garantizar el cumplimiento de las normas. Cuando se rechaza una solicitud debido a la moderación, proporcione a los usuarios información clara e informativa sobre por qué se denegó su entrada. Esto puede guiar a los usuarios para que envíen contenidos conformes en el futuro, reduciendo en última instancia la frecuencia de las infracciones.

Los mensajes de error eficaces no sólo deben indicar qué ha fallado, sino también ofrecer sugerencias constructivas sobre cómo corregir la entrada. Por ejemplo, si un usuario envía contenido marcado por contener lenguaje inapropiado, la respuesta debe explicarlo y animar al usuario a reformularlo. Este enfoque educativo ayuda a los usuarios a entender los requisitos de moderación y fomenta interacciones más positivas con su aplicación.

7. Revisar y actualizar periódicamente las políticas

Política de contenidos de OpenAI pueden cambiar con el tiempo, y es esencial mantenerse informado sobre estas actualizaciones. Revise y actualice periódicamente sus políticas internas y estrategias de moderación para adaptarlas a las nuevas directrices. Mantenerse al día le ayudará a mantener el cumplimiento y evitar sanciones inesperadas.

Las políticas internas también deben revisarse en respuesta a los incidentes. Si descubre que se cuelan ciertos tipos de contenidos nocivos, ajuste sus normas y procedimientos para cubrir estas lagunas. Las revisiones periódicas de las políticas garantizan que siempre estés operando en línea con las últimas expectativas de OpenAI, minimizando así el riesgo de infracciones.

8. Utilizar herramientas de filtrado automático

Además del punto final de moderación de OpenAI, considere la posibilidad de añadir herramientas de filtrado automatizadas que puedan preseleccionar las entradas de los usuarios en función de criterios predefinidos. Esta capa adicional de filtrado puede ayudar a reducir la cantidad de contenido potencialmente dañino que llega a la etapa de moderación, haciendo que el proceso de moderación sea más eficiente y eficaz.

Las herramientas de filtrado automático pueden personalizarse para adaptarse a las necesidades específicas de su aplicación. Por ejemplo, puede desarrollar filtros adaptados a su base de usuarios, centrándose en categorías particulares de contenido que son más propensas a ser problemáticas. Estos sistemas automatizados actúan como primera línea de defensa, permitiendo a los moderadores humanos o al punto final de moderación de OpenAI manejar casos más matizados.

9. Eficacia de la moderación

Compruebe periódicamente la eficacia de sus procesos de moderación analizando los falsos positivos y negativos. Ajusta los criterios de filtrado y los algoritmos de moderación en función de estos datos para mejorar la precisión y garantizar que los contenidos conformes no se marcan por error, mientras que los perjudiciales se filtran de forma eficaz.

Comprobar la eficacia de la moderación también puede implicar recoger las opiniones de los usuarios. Los usuarios que consideren que su contenido ha sido marcado erróneamente pueden aportar ideas para mejorar los criterios de moderación. Esta retroalimentación continua ayuda a perfeccionar el sistema para lograr el equilibrio adecuado entre seguridad y libertad de expresión.

10. Comprometerse con el soporte de OpenAI

Si tienes preguntas sobre casos de uso específicos o necesitas aclaraciones sobre las políticas, no dudes en ponerte en contacto con el equipo de soporte de OpenAI. Sus conocimientos pueden ser valiosos para adaptar las prácticas de moderación a las necesidades de tu aplicación y garantizar que el uso de la API sea siempre conforme.

Recurrir al soporte de OpenAI también puede ser beneficioso cuando te enfrentas a zonas grises. Si no está seguro de si un determinado tipo de contenido está permitido, buscar asesoramiento puede evitar posibles infracciones. Establecer una buena relación con el soporte de OpenAI le garantizará que dispone de una fuente continua de experiencia para ayudarle a navegar por escenarios de moderación complejos.

Lo esencial

Gestionar eficazmente el contenido generado por el usuario es clave para mantener el cumplimiento de las políticas de OpenAI y garantizar que su acceso a la API siga siendo seguro. Siguiendo estas diez mejores prácticas, los desarrolladores y las empresas pueden reducir el riesgo de infracciones, evitar sanciones y crear una experiencia de usuario más positiva. La gestión proactiva y el uso de las herramientas de moderación de OpenAI pueden salvaguardar su acceso y ayudarle a aprovechar plenamente el poder de la IA.