Підказки, навчання та доопрацювання для LLMs - AI&YOU #67 Підказки, навчання та доопрацювання для LLMs - AI&YOU #67

- Підказки, навчання та доопрацювання для LLMs - AI&YOU #67 Підказки, навчання та доопрацювання для LLMs - AI&YOU #67

- Підказки, навчання та доопрацювання для магістрів права - AI&YOU #67

- Проблема дефіциту даних в АІ

- Навчання з кількома пострілами проти традиційного навчання під наглядом

- Спектр ефективного навчання на основі зразків

- Малопомітні постріли vs точна настройка LLM

- Підказки з кількох пострілів: Розкриття потенціалу LLM

- Тонке налаштування LLM: Пристосування моделей з обмеженими даними

- Кілька пострілів проти точного налаштування: Вибір правильного підходу

- Топ-5 дослідницьких робіт для швидкого навчання

- Підсумок

- Дякуємо, що знайшли час прочитати AI & YOU!

Підказки, навчання та доопрацювання для LLMs - AI&YOU #67 Підказки, навчання та доопрацювання для LLMs - AI&YOU #67

Статистика тижня: Дослідження MobiDev щодо навчання за допомогою декількох кадрів для класифікації зображень монет показало, що, використовуючи лише 4 приклади зображень для кожного номіналу монети, вони можуть досягти точності ~70%.

У сфері ШІ здатність ефективно навчатися на основі обмежених даних набуває вирішального значення. Ось чому підприємствам важливо розуміти, що таке навчання з кількох пострілів, підказки та точне налаштування LLM.

У цьому випуску AI&YOU ми знайомимося з думками з трьох блогів, які ми опублікували на цю тему:

Підказки, навчання та доопрацювання для магістрів права - AI&YOU #67

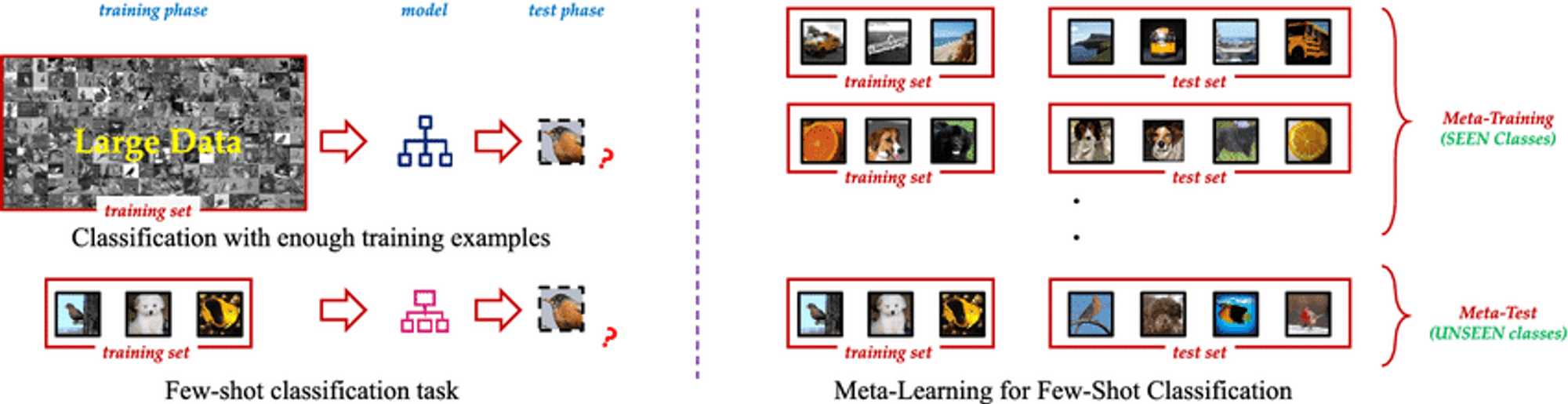

Few Shot Learning - це інноваційна парадигма машинного навчання, яка дозволяє моделям штучного інтелекту вивчати нові концепції або завдання лише на кількох прикладах. На відміну від традиційних методів навчання під контролем, які вимагають величезних обсягів маркованих навчальних даних, методика Few Shot Learning дозволяє моделям ефективно узагальнювати, використовуючи лише невелику кількість зразків. Цей підхід імітує людську здатність швидко схоплювати нові ідеї без необхідності багаторазового повторення.

Суть Few Shot Learning полягає в його здатності використовувати попередні знання та швидко адаптуватися до нових сценаріїв. Використовуючи такі методи, як метанавчання, коли модель "вчиться вчитися", алгоритми Few Shot Learning можуть вирішувати широкий спектр завдань з мінімальним додатковим навчанням. Така гнучкість робить його безцінним інструментом у сценаріях, де даних мало, їх отримання дорого коштує або вони постійно змінюються.

Проблема дефіциту даних в АІ

Не всі дані є рівними, а високоякісні, марковані дані можуть бути рідкісним і цінним товаром. Цей дефіцит створює значні труднощі для традиційних підходів до навчання під наглядом, які зазвичай вимагають тисячі або навіть мільйони мічених прикладів для досягнення задовільної продуктивності.

Проблема дефіциту даних особливо гостро стоїть у спеціалізованих галузях, таких як охорона здоров'я, де рідкісні захворювання можуть мати обмежену кількість задокументованих випадків, або у швидкозмінних середовищах, де часто з'являються нові категорії даних. У цих сценаріях час і ресурси, необхідні для збору і маркування великих наборів даних, можуть бути непомірно великими, що створює вузьке місце в розробці і впровадженні ШІ.

Навчання з кількома пострілами проти традиційного навчання під наглядом

Розуміння різниці між Few Shot Learning і традиційним навчанням під наглядом має вирішальне значення для розуміння його реального впливу.

Традиційний контрольоване навчанняхоч і потужний, але має свої недоліки:

Залежність від даних: Бореться з обмеженими навчальними даними.

Негнучкість: Добре справляється лише з конкретними навченими завданнями.

Ресурсоємність: Потребує великих, дорогих наборів даних.

Постійне оновлення: Потребує частого перенавчання в динамічних умовах.

Навчання кількома пострілами пропонує зміну парадигми:

Ефективність зразка: Узагальнює з кількох прикладів, використовуючи метанавчання.

Швидка адаптація: Швидко адаптується до нових завдань з мінімальною кількістю прикладів.

Оптимізація ресурсів: Зменшує потреби у зборі даних та маркуванні.

Безперервне навчання: Підходить для засвоєння нових знань без забування.

Універсальність: Застосовується в різних сферах, від комп'ютерного зору до НЛП.

Вирішуючи ці проблеми, Few Shot Learning робить моделі ШІ більш адаптивними та ефективними, відкриваючи нові можливості в розробці ШІ.

Спектр ефективного навчання на основі зразків

Цікавий спектр підходів спрямований на мінімізацію необхідних навчальних даних, включаючи навчання з нуля, одним пострілом та кількома пострілами.

Навчання з нуля: Навчання без прикладів

Розпізнає невидимі класи за допомогою допоміжної інформації, наприклад, текстових описів

Цінно, коли марковані приклади для всіх класів є недоцільними або неможливими

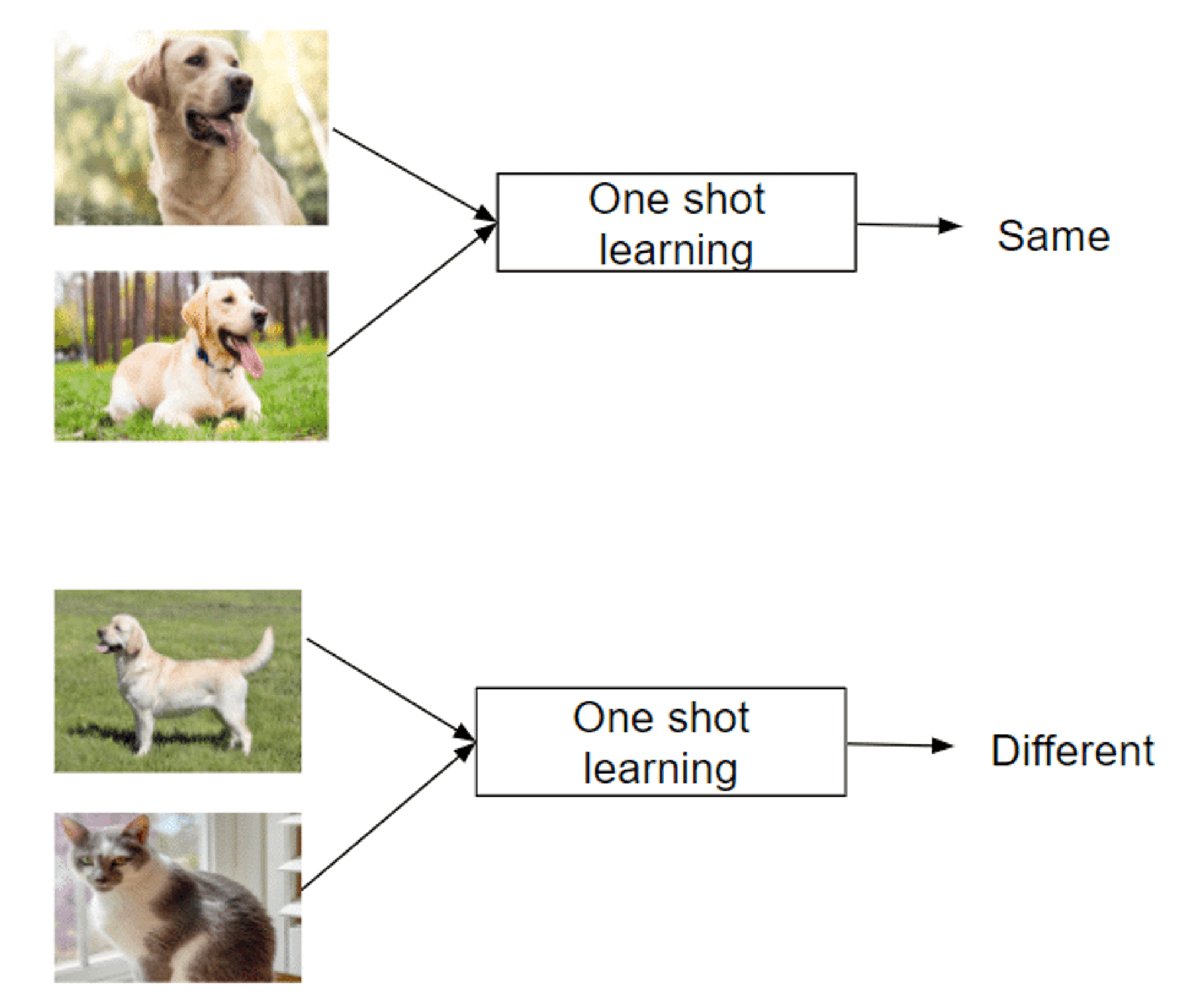

Навчання одним пострілом: Навчання на одному прикладі

Розпізнає нові класи лише з одного прикладу

Імітує людську здатність швидко схоплювати поняття

Успішні в таких сферах, як розпізнавання облич

Навчання кількома пострілами: Виконуємо завдання з мінімальними даними

Використовує 2-5 маркованих прикладів для кожного нового класу

Баланс між надзвичайною ефективністю даних і традиційними методами

Дозволяє швидко адаптуватися до нових завдань або класів

Використовує стратегії метанавчання, щоб навчитися вчитися

Цей спектр підходів пропонує унікальні можливості для вирішення проблеми навчання на обмежених прикладах, що робить їх безцінними у сферах з дефіцитом даних.

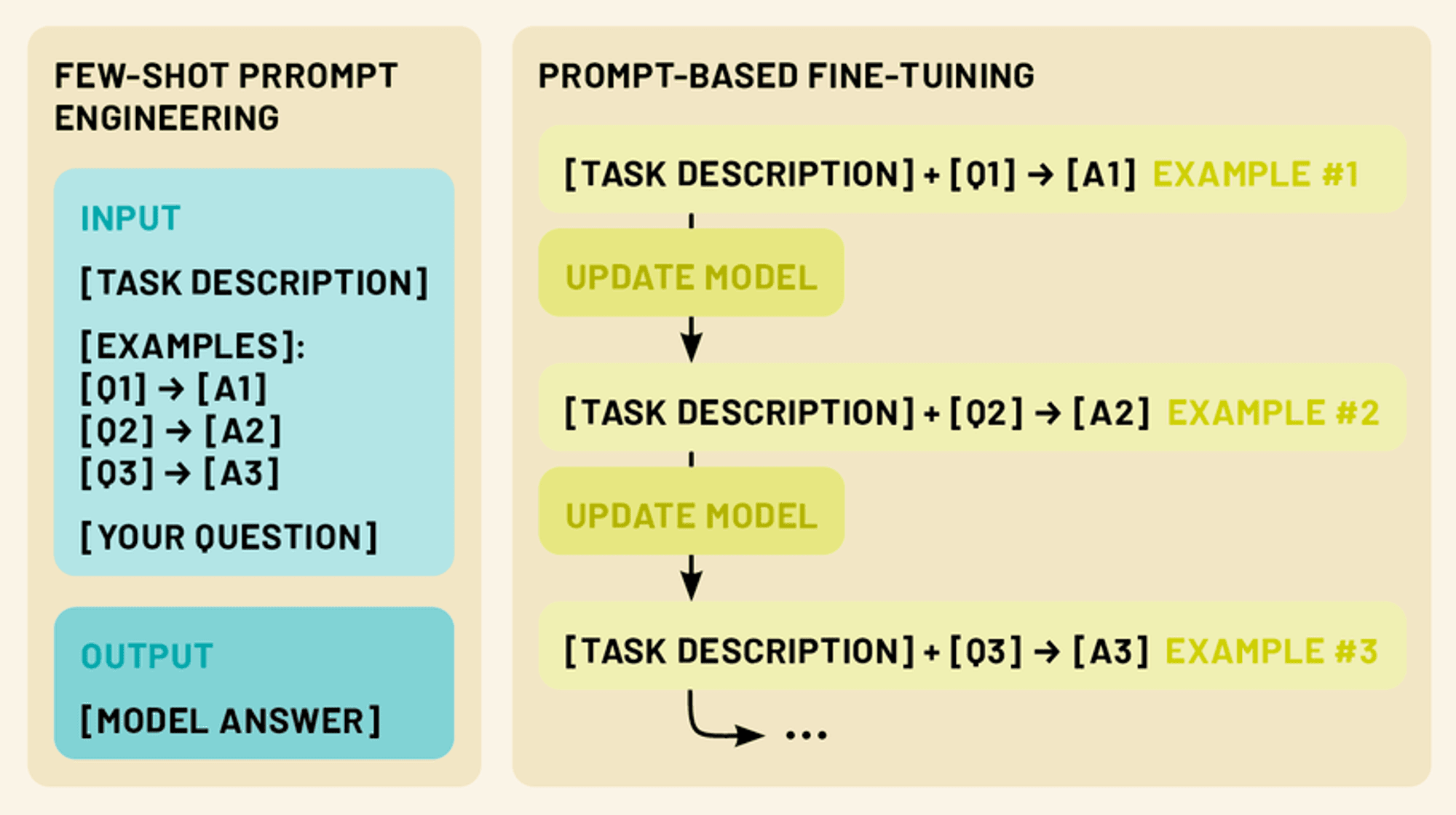

Малопомітні постріли vs точна настройка LLM

У цій сфері існують ще два потужні методи: підказки з кількох спроб і точне налаштування. Підказки з кількох спроб передбачають створення розумних підказок, що містять невелику кількість прикладів, які спрямовують модель на виконання певного завдання без додаткового навчання. Точне налаштування, з іншого боку, передбачає оновлення параметрів моделі з використанням обмеженої кількості даних для конкретного завдання, що дозволяє їй адаптувати свої широкі знання до конкретної області або програми.

Обидва підходи підпадають під парасольку навчання з кількох спроб. Використовуючи ці методи, ми можемо значно підвищити продуктивність і універсальність LLM, зробивши їх більш практичними та ефективними інструментами для широкого спектру застосувань в обробці природної мови та за її межами.

Підказки з кількох пострілів: Розкриття потенціалу LLM

Підказки з кількома пострілами використовують здатність моделі розуміти інструкції, ефективно "програмуючи" LLM за допомогою продуманих підказок.

Підказки з кількох кадрів надають 1-5 прикладів, що демонструють потрібне завдання, використовуючи розпізнавання шаблонів та адаптивність моделі. Це дає змогу виконувати завдання, для яких немає явної підготовки, використовуючи потенціал LLM для навчання в контексті.

Представляючи чіткі шаблони введення-виведення, підказки з кількома пострілами спрямовують LLM на застосування аналогічних міркувань до нових вхідних даних, що дозволяє швидко адаптуватися до нових завдань без оновлення параметрів.

Типи підказок з кількома пострілами (з нульовим пострілом, з одним пострілом, з кількома пострілами)

Підказки з кількома пострілами охоплюють цілий спектр підходів, кожен з яких визначається кількістю наданих прикладів. (Так само, як і в навчанні з кількома пострілами):

Ніяких підказок: У цьому сценарії приклади не наводяться. Натомість моделі дається чітка інструкція або опис завдання. Наприклад, "Перекладіть наступний англійський текст французькою мовою: [введіть текст]".

Одноразова підказка: Тут наведено один приклад перед фактичними вхідними даними. Це дає моделі конкретний приклад очікуваного зв'язку між вхідними та вихідними даними. Наприклад: "Класифікуйте враження від наступного відгуку як позитивне чи негативне. Приклад: "Цей фільм був фантастичним!" - Позитивний вхід: "Я не витримав сюжету". - [модель генерує відповідь]"

Кілька пострілів підказки: Цей підхід передбачає кілька прикладів (зазвичай 2-5) перед введенням даних. Це дозволяє моделі розпізнавати більш складні патерни та нюанси в задачі. Наприклад: "Класифікуйте наступні речення як питання або твердження: "Небо блакитне". - Твердження "Котра година?" - Питання "Я люблю морозиво". - Вхідне твердження: "Де я можу знайти найближчий ресторан?" - [модель генерує відповідь]".

Створення ефективних коротких підказок

Створення ефективних коротких підказок - це і мистецтво, і наука. Ось кілька ключових принципів, які слід враховувати:

Чіткість і послідовність: Переконайтеся, що ваші приклади та інструкції зрозумілі та відповідають єдиному формату. Це допоможе моделі легше розпізнати шаблон.

Різноманітність: Використовуючи кілька прикладів, намагайтеся охопити діапазон можливих входів і виходів, щоб дати моделі ширше розуміння завдання.

Доречність: Вибирайте приклади, які тісно пов'язані з конкретною задачею або сферою, на яку ви орієнтуєтесь. Це допоможе моделі зосередитися на найбільш релевантних аспектах її знань.

Лаконічність: Хоча важливо надати достатньо контексту, уникайте надто довгих або складних підказок, які можуть заплутати модель або розмити ключову інформацію.

Експеримент: Не бійтеся повторювати та експериментувати з різними структурами підказок і прикладами, щоб знайти те, що найкраще підходить для вашого конкретного випадку використання.

Оволодівши мистецтвом підказок, ми можемо розкрити весь потенціал LLMs, даючи їм змогу вирішувати широкий спектр завдань з мінімальними додатковими зусиллями чи навчанням.

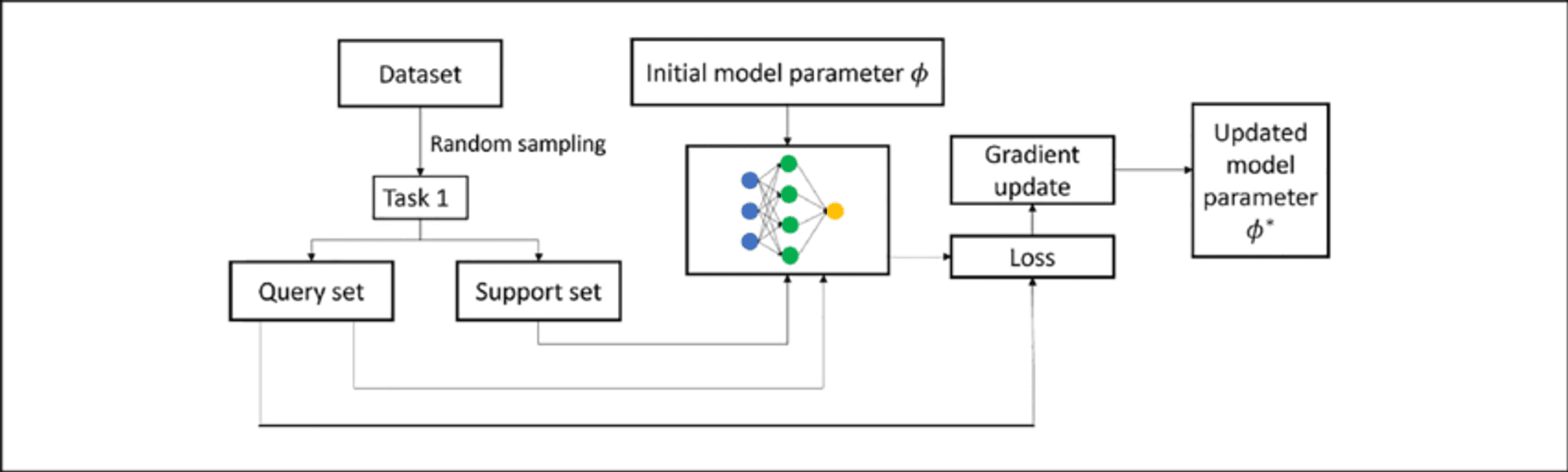

Тонке налаштування LLM: Пристосування моделей з обмеженими даними

У той час як підказки з кількох пострілів є потужним методом адаптації LLM до нових завдань без зміни самої моделі, точне налаштування пропонує спосіб оновити параметри моделі для ще кращої продуктивності на конкретних завданнях або в конкретних сферах. Тонке налаштування дозволяє нам використовувати величезні знання, закодовані в попередньо навчених LLM, пристосовуючи їх до наших конкретних потреб, використовуючи лише невелику кількість специфічних даних про завдання.

Розуміння тонкого налаштування в контексті магістерських програм

Доопрацювання LLM передбачає подальше навчання попередньо навченої моделі на меншому наборі даних для конкретної задачі. Цей процес адаптує модель до цільового завдання, спираючись на наявні знання, вимагаючи менше даних і ресурсів, ніж навчання з нуля.

У LLM точне налаштування зазвичай коригує ваги у верхніх шарах відповідно до специфіки завдання, тоді як нижні шари залишаються практично незмінними. Такий підхід "трансферного навчання" зберігає широке розуміння мови, водночас розвиваючи спеціалізовані здібності.

Кілька методів точного налаштування

Малопострільна точна настройка адаптує модель, використовуючи лише від 10 до 100 зразків на клас або завдання, що є цінним, коли мічених даних мало. Основні методи включають:

Оперативне доопрацювання: Поєднує підказки з кількома пострілами та оновлення параметрів.

Підходи до метанавчання: Такі методи, як MAML прагнуть знайти хороші початкові точки для швидкої адаптації.

Точне налаштування на основі адаптера: Вводить невеликі "перехідні" модулі між попередньо навченими шарами моделі, зменшуючи кількість параметрів, що підлягають навчанню.

Контекстне навчання: Налаштовує LLM для кращої адаптації лише за допомогою підказок.

Ці методи дозволяють LLM адаптуватися до нових завдань з мінімальним обсягом даних, підвищуючи їхню універсальність та ефективність.

Кілька пострілів проти точного налаштування: Вибір правильного підходу

При адаптації LLM до конкретних завдань ефективними рішеннями можуть бути як підказки, так і точне налаштування. Однак кожен метод має свої сильні та слабкі сторони, і вибір правильного підходу залежить від різних факторів.

Сильні сторони: малопомітні постріли:

Не потребує оновлення параметрів моделі, зберігаючи оригінальну модель

Висока гнучкість і можливість адаптації на льоту

Не потребує додаткового часу на навчання або обчислювальних ресурсів

Корисно для швидкого створення прототипів та експериментів

Обмеження:

Продуктивність може бути менш стабільною, особливо для складних завдань

Обмежені початковими можливостями та знаннями моделі

Можуть виникати проблеми з вузькоспеціалізованими доменами або завданнями

Доопрацювання сильних сторін:

Часто досягає кращих результатів у виконанні конкретних завдань

Може адаптувати модель до нових доменів та спеціалізованої лексики

Більш узгоджені результати за однакових вхідних даних

Потенціал для постійного навчання та вдосконалення

Обмеження:

Потребує додаткового навчального часу та обчислювальних ресурсів

Ризик катастрофічного забування, якщо ним не керувати

Можливе перевантаження на невеликих наборах даних

Менш гнучкий; вимагає перенавчання при значних змінах завдань

Топ-5 дослідницьких робіт для швидкого навчання

Цього тижня ми також розглянемо наступні п'ять статей, які значно просунули цю галузь, представивши інноваційні підходи, що змінюють можливості штучного інтелекту.

1️⃣ Matching Networks for One Shot Learning" (Vinyals et al., 2016)

Впроваджено революційний підхід з використанням механізмів пам'яті та уваги. Функція зіставлення порівнює приклади запитів з маркованими прикладами підтримки, встановлюючи новий стандарт для методів навчання з кількох спроб.

2️⃣ Прототипові мережі для навчання з кількох пострілів" (Снелл та ін., 2017)

Представлено простіший, але ефективний підхід - вивчення метричного простору, де класи представлені єдиним прототипом. Його простота та ефективність зробили його популярним базовим для подальших досліджень.

3️⃣ Вчимося порівнювати: Мережа зв'язків для навчання з кількох пострілів" (Sung et al., 2018)

Впроваджено модуль зв'язків, що навчається, який дозволяє моделі вивчати метрику порівняння, пристосовану до конкретних завдань і розподілів даних. Продемонструвала високу продуктивність за різними бенчмарками.

4️⃣ Ближчий погляд на класифікацію з кількома пострілами" (Chen et al., 2019)

Надано всебічний аналіз існуючих методів, що ставить під сумнів загальноприйняті припущення. Запропонував прості базові моделі, які відповідали або перевершували більш складні підходи, підкреслюючи важливість базових функцій і стратегій навчання.

Поєднали стандартну попередню підготовку з етапом метанавчання, досягнувши найсучасніших результатів. Висвітлив компроміси між стандартним навчанням та цілями метанавчання.

Ці роботи не тільки просунули вперед академічні дослідження, а й проклали шлях до практичного застосування штучного інтелекту на підприємствах. Вони демонструють прогрес у створенні більш ефективних, адаптивних систем штучного інтелекту, здатних навчатися на основі обмежених даних, що має вирішальне значення в багатьох бізнес-контекстах.

Підсумок

Навчання, підказки та точне налаштування - це новаторські підходи, які дозволяють LLM швидко адаптуватися до спеціалізованих завдань з мінімальним обсягом даних. Як ми дослідили, ці методи пропонують безпрецедентну гнучкість і ефективність у пристосуванні LLM до різноманітних застосувань у різних галузях, від покращення завдань з обробки природної мови до адаптації до специфічних доменів у таких сферах, як охорона здоров'я, право та технології.

Дякуємо, що знайшли час прочитати AI & YOU!

Щоб отримати ще більше матеріалів про корпоративний ШІ, включаючи інфографіку, статистику, інструкції, статті та відео, підписуйтесь на канал Skim AI на LinkedIn

Ви засновник, генеральний директор, венчурний інвестор або інвестор, який шукає консультації з питань ШІ, фракційної розробки ШІ або послуги Due Diligence? Отримайте рекомендації, необхідні для прийняття обґрунтованих рішень щодо продуктової стратегії та інвестиційних можливостей вашої компанії у сфері ШІ.

Ми створюємо індивідуальні AI-рішення для компаній, що підтримуються венчурним та приватним капіталом, у наступних галузях: Медичні технології, новини/контент-агрегація, кіно- та фото-виробництво, освітні технології, юридичні технології, фінтех та криптовалюта.