Como as empresas podem lidar com as alucinações do LLM para integrar a IA com segurança

Os modelos de grande linguagem (LLM) estão a transformar as aplicações empresariais, oferecendo capacidades sem precedentes no processamento e geração de linguagem natural. No entanto, antes de a sua empresa aderir ao movimento dos LLM, há um desafio crítico que tem de resolver: as alucinações.

As alucinações dos LLM representam um obstáculo significativo à adoção generalizada destes poderosos sistemas de IA. À medida que nos aprofundamos na natureza complexa deste fenómeno, torna-se claro que compreender e mitigar as alucinações é crucial para qualquer empresa que pretenda aproveitar todo o potencial dos LLMs, minimizando os riscos.

- Compreender as alucinações do MMN

- O que é que provoca alucinações nos jovens com LLM?

- Implicações das alucinações dos LLM para as empresas

- Estratégias para atenuar as alucinações na integração do LLM empresarial

- Perspectivas futuras: Avanços na atenuação de alucinações

- FAQ

- O que são alucinações LLM?

- Quais são alguns exemplos comuns de alucinações LLM em aplicações críticas?

- Quais são algumas das consequências reais das alucinações do LLM?

- Como é que as alucinações dos LLM afectam as interacções com o serviço de apoio ao cliente?

- Quais são as estratégias utilizadas para atenuar as alucinações de LLM?

Compreender as alucinações do MMN

As alucinações da IA, no contexto dos modelos de linguagem de grande dimensão, referem-se a casos em que o modelo gera texto ou fornece respostas factualmente incorrectas, sem sentido ou não relacionadas com os dados de entrada. Estas alucinações podem manifestar-se como informações que soam a confiança mas que são totalmente fabricadas, conduzindo a potenciais mal-entendidos e desinformação.

Tipos de alucinações

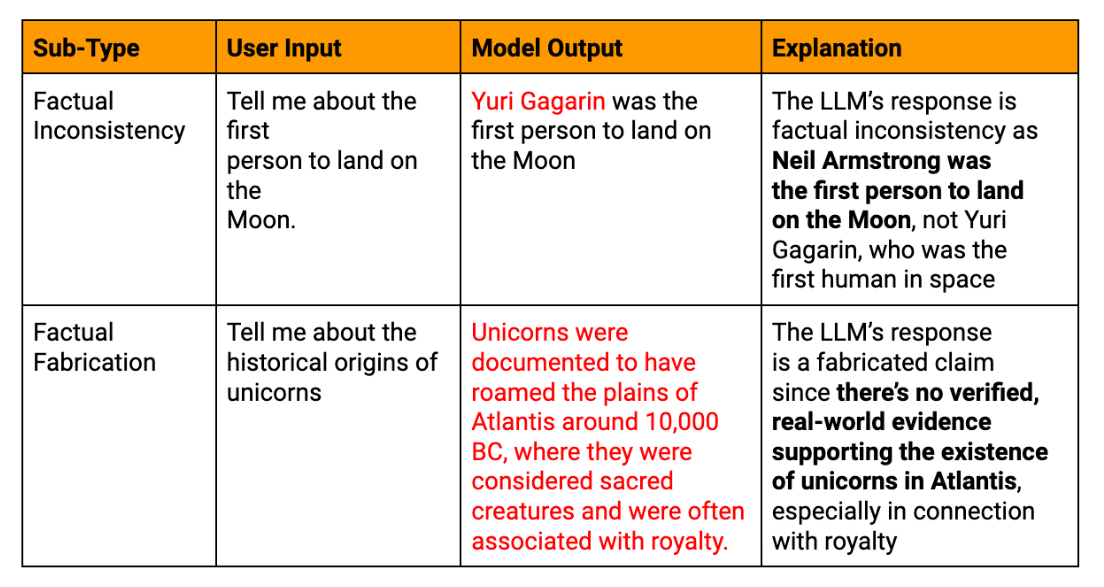

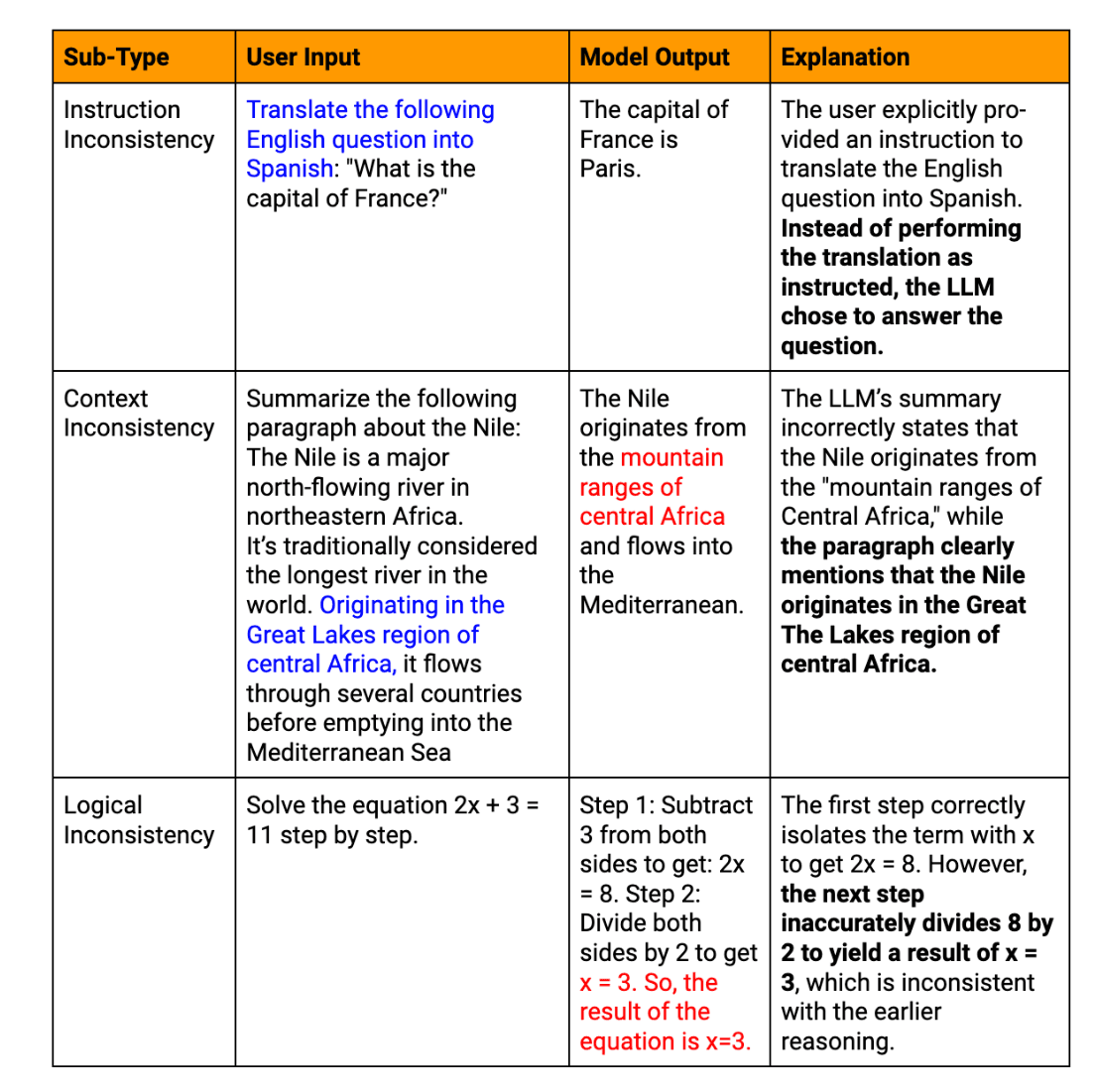

As alucinações de MLT podem ser classificadas em vários tipos:

Alucinações factuais: Quando o modelo produz informações que contradizem factos estabelecidos ou inventa dados inexistentes.

Alucinações semânticas: Casos em que o texto gerado é logicamente inconsistente ou sem sentido, mesmo que as partes individuais pareçam coerentes.

Alucinações contextuais: Casos em que a resposta do LLM se desvia do contexto dado ou rápido, fornecendo informações irrelevantes.

Alucinações temporais: Quando o modelo confunde ou deturpa informações sensíveis ao tempo, como acontecimentos recentes ou factos históricos.

Exemplos reais de alucinações de texto geradas por LLM

Para ilustrar as consequências significativas das alucinações de LLM em ambientes empresariais, considere estes exemplos relevantes:

Contratempo do chatbot de serviço ao cliente: Uma grande empresa de comércio eletrónico integra um chatbot alimentado por LLM na sua plataforma de serviço ao cliente. Durante um evento de vendas com muito tráfego, o chatbot fornece, com confiança, informações incorrectas sobre políticas de devolução e tempos de envio a milhares de clientes. Isto leva a um aumento das queixas dos clientes, prejudica a confiança e exige grandes esforços de controlo de danos.

Imprecisões no relatório financeiro: Uma empresa de investimento utiliza um LLM para ajudar a gerar relatórios financeiros trimestrais. O sistema de IA alucina várias métricas financeiras importantes, o que passa despercebido na revisão inicial. Quando o relatório incorreto é publicado, dá origem a decisões de investimento erradas e a potenciais problemas regulamentares, realçando a necessidade crítica de uma verificação minuciosa do conteúdo financeiro gerado pela IA.

Passo em falso no desenvolvimento de produtos: Uma startup de tecnologia utiliza um LLM para analisar tendências de mercado e gerar recomendações de características de produtos. A IA sugere com confiança uma funcionalidade baseada numa tecnologia inexistente, levando a equipa de desenvolvimento a perder tempo e recursos valiosos antes de se aperceber do erro. Este incidente sublinha a importância de cruzar os resultados do LLM com fontes fiáveis do sector.

Confusão na política de RH: Uma empresa multinacional emprega um LLM para ajudar na redação de políticas de RH. A IA alucina com uma lei laboral inexistente, que é inadvertidamente incluída no documento de política oficial da empresa. Este facto gera confusão entre os funcionários e uma potencial exposição legal, enfatizando a necessidade de uma revisão especializada do conteúdo das políticas geradas pela IA.

Estes exemplos demonstram como as alucinações com LLM podem afetar vários aspectos das operações empresariais, desde as interacções com o cliente até aos processos internos e à tomada de decisões estratégicas. Sublinham a importância crítica da implementação de processos de verificação robustos e da manutenção da supervisão humana quando se utiliza texto gerado por LLM em aplicações críticas para a empresa.

O que é que provoca alucinações nos jovens com LLM?

A compreensão das origens das alucinações de LLM é crucial para o desenvolvimento de estratégias eficazes de mitigação. Vários factores interligados contribuem para este fenómeno.

Questões relacionadas com a qualidade dos dados de formação

A qualidade dos dados de treino tem um impacto significativo no desempenho de um LLM. Informações imprecisas ou desactualizadas, enviesamentos no material de origem e inconsistências na representação de dados factuais podem levar a alucinações. Por exemplo, se um LLM é treinado num conjunto de dados que contém teorias científicas desactualizadas, pode apresentá-las como factos actuais nos seus resultados.

Limitações dos modelos de IA e dos modelos linguísticos

Apesar das suas capacidades impressionantes, os actuais LLM têm limitações inerentes:

Falta de verdadeira compreensão: Os LLM processam padrões no texto em vez de compreenderem o significado

Janela de contexto limitada: A maioria dos modelos tem dificuldade em manter a coerência em passagens longas

Incapacidade de verificar os factos: Os LLM não podem aceder a conhecimentos externos em tempo real para verificar a informação gerada

Estas limitações podem fazer com que o modelo gere conteúdos plausíveis, mas factualmente incorrectos ou sem sentido.

Desafios na produção de resultados LLM

O próprio processo de geração de texto pode introduzir alucinações. Os LLMs produzem conteúdo token a token com base em previsões probabilísticas, o que pode levar a desvios semânticos ou sequências improváveis. Além disso, os LLMs demonstram frequentemente excesso de confiança, apresentando informações alucinadas com a mesma segurança que dados factuais.

Dados de entrada e factores relacionados com o prompt

A interação do utilizador com os LLM pode, inadvertidamente, encorajar alucinações. As mensagens ambíguas, o contexto insuficiente ou as perguntas demasiado complexas podem levar o modelo a interpretar mal a intenção ou a preencher lacunas com informações inventadas.

Implicações das alucinações dos LLM para as empresas

A ocorrência de alucinações nos resultados da aprendizagem ao longo da vida pode ter consequências de grande alcance para as empresas:

Riscos de respostas incorrectas e de informações factualmente incorrectas

Quando as empresas dependem de conteúdos gerados por LLM para a tomada de decisões ou para a comunicação com os clientes, as informações alucinadas podem levar a erros dispendiosos. Esses erros podem variar de pequenas ineficiências operacionais a grandes erros estratégicos. Por exemplo, um LLM que forneça análises de mercado inexactas pode levar a decisões de investimento ou estratégias de desenvolvimento de produtos erradas.

Potenciais consequências jurídicas e éticas

As empresas que utilizam LLMs devem navegar num cenário complexo de conformidade regulamentar e considerações éticas. Considere os seguintes cenários:

Conteúdos alucinados em relatórios financeiros que conduzem a infracções regulamentares

Informações inexactas prestadas aos clientes, o que resultou em acções judiciais

Dilemas éticos decorrentes da utilização de sistemas de IA que produzem informações pouco fiáveis

Impacto na fiabilidade e confiança dos sistemas de IA

Talvez o mais crítico seja o facto de as alucinações dos LLM poderem ter um impacto significativo na fiabilidade e confiança depositadas nos sistemas de IA. Casos frequentes ou de grande visibilidade de alucinações podem:

Diminuir a confiança dos utilizadores, potencialmente abrandando a adoção e integração da IA

Prejudicar a reputação de uma empresa como líder tecnológico

Conduzir a um maior ceticismo em relação a todos os resultados gerados pela IA, mesmo quando exactos

Para as empresas, enfrentar estas implicações não é apenas um desafio técnico, mas um imperativo estratégico.

Estratégias para atenuar as alucinações na integração do LLM empresarial

À medida que as empresas adoptam cada vez mais modelos linguísticos de grande dimensão, torna-se fundamental enfrentar o desafio das alucinações.

Existem estratégias fundamentais para atenuar este problema:

1. Melhorar a integração dos dados de formação e dos conhecimentos externos

A base de qualquer LLM são os seus dados de formação. Para reduzir as alucinações, as empresas devem concentrar-se na melhoria da qualidade dos dados e na integração de conhecimentos externos fiáveis.

Desenvolver conjuntos de dados específicos do domínio que sejam rigorosamente controlados quanto à exatidão. Esta abordagem ajuda o modelo a aprender com informações relevantes e de alta qualidade, reduzindo a probabilidade de erros factuais.

Implementar sistemas para actualizações regulares dos dados de formação, garantindo que o modelo tem acesso às informações mais actuais. Isto é particularmente crucial para os sectores com bases de conhecimento em rápida evolução, como a tecnologia ou os cuidados de saúde.

Incorporar gráficos de conhecimento estruturado na arquitetura do LLM. Isto fornece ao modelo um quadro fiável de relações factuais, ajudando a fundamentar os seus resultados em informações verificadas.

Implementar RAG técnicas que permitem ao LLM aceder e referenciar bases de conhecimento externas e actualizadas durante a geração do texto. Este mecanismo de verificação de factos em tempo real reduz significativamente o risco de informações desactualizadas ou incorrectas.

2. Implementação de validação robusta para resultados LLM

Os processos de validação são cruciais para detetar e corrigir as alucinações antes de chegarem aos utilizadores finais.

Desenvolver sistemas de verificação de factos alimentados por IA que possam verificar rapidamente as principais afirmações no texto gerado pelo LLM em relação a bases de dados ou fontes Web fiáveis.

Implementar algoritmos que façam referência cruzada a diferentes partes do output do LLM para verificar a sua consistência interna, assinalando contradições que possam indicar alucinações.

Utilize as pontuações de confiança do próprio modelo para cada segmento gerado. As saídas com baixas pontuações de confiança podem ser sinalizadas para revisão humana ou verificação adicional.

Implementar vários LLMs ou modelos de IA para gerar respostas ao mesmo pedido, comparando os resultados para identificar potenciais alucinações através de discrepâncias.

3. Aproveitar a supervisão humana para garantir a exatidão dos factos

Embora a automatização seja crucial, a perícia humana continua a ser inestimável para atenuar as alucinações.

Estabelecer processos em que os peritos do domínio revejam os resultados da aprendizagem ao longo da vida em aplicações críticas, tais como documentos jurídicos ou relatórios financeiros.

Conceber interfaces que facilitem uma colaboração sem descontinuidades entre os LLM e os operadores humanos, permitindo correcções rápidas e a aprendizagem a partir de contributos humanos.

Implementar mecanismos para que os utilizadores finais comuniquem suspeitas de alucinações, criando um ciclo de melhoria contínua para o sistema LLM.

Desenvolver uma formação exaustiva para os funcionários sobre a identificação e o tratamento de potenciais alucinações dos MMN, promovendo uma cultura de avaliação crítica dos conteúdos gerados pela IA.

4. Técnicas avançadas para melhorar o comportamento do modelo

A investigação de ponta oferece pistas prometedoras para melhorar o desempenho do LLM e reduzir as alucinações.

Descodificação com restrições: Implementar técnicas que orientem o processo de geração de texto do LLM, obrigando-o a aderir mais estreitamente a factos conhecidos ou a regras especificadas.

Modelos conscientes da incerteza: Desenvolver LLMs que possam exprimir incerteza sobre os seus resultados, utilizando potencialmente técnicas como modelos linguísticos calibrados ou métodos de conjunto.

Formação contraditória: Expor o modelo a exemplos contraditórios durante o treino, ajudando-o a tornar-se mais robusto contra a geração de alucinações.

Ajuste fino com aprendizagem por reforço: Utilizar técnicas de aprendizagem por reforço para afinar os LLM, recompensando a exatidão dos factos e penalizando as alucinações.

Arquitecturas modulares: Explorar arquitecturas que separem o conhecimento do mundo das capacidades de geração de linguagem, permitindo uma recuperação de informação mais controlada e verificável.

Ao implementar estas estratégias, a sua empresa pode reduzir significativamente o risco de alucinações nas suas aplicações de LLM. No entanto, é importante notar que a eliminação completa das alucinações continua a ser um desafio. Por isso, é crucial uma abordagem multifacetada que combine soluções tecnológicas com supervisão humana.

Perspectivas futuras: Avanços na atenuação de alucinações

Ao olharmos para o futuro da tecnologia LLM, a atenuação das alucinações continua a ser um ponto fulcral da investigação em curso no domínio da aprendizagem automática. Estão a ser continuamente desenvolvidas ferramentas e estruturas emergentes para enfrentar este desafio, com avanços promissores em áreas como a verificação da auto-consistência, a integração do conhecimento e a quantificação da incerteza.

A investigação futura desempenhará um papel crucial na melhoria da exatidão factual do LLM, conduzindo a modelos que possam distinguir melhor entre conhecimento factual e texto gerado. À medida que os sistemas de IA continuam a evoluir, prevemos abordagens mais sofisticadas para mitigar as alucinações, incluindo arquitecturas neurais avançadas, metodologias de formação melhoradas e maior integração de conhecimentos externos. Para as empresas que estão a considerar a adoção do LLM, manter-se informado sobre estes desenvolvimentos será essencial para aproveitar todo o potencial da IA, mantendo os mais elevados padrões de precisão e fiabilidade nas suas operações.

FAQ

O que são alucinações LLM?

As alucinações LLM são casos em que os modelos de IA geram texto factualmente incorreto ou sem sentido, apesar de parecerem confiantes e coerentes.

Quais são alguns exemplos comuns de alucinações LLM em aplicações críticas?

Exemplos comuns incluem a produção de dados financeiros falsos em relatórios, a prestação de aconselhamento jurídico incorreto ou a invenção de características de produtos inexistentes em documentação técnica.

Quais são algumas das consequências reais das alucinações do LLM?

As consequências podem incluir perdas financeiras devido a decisões mal informadas, responsabilidades legais devido a conselhos incorrectos e danos na reputação da empresa devido à divulgação de informações falsas.

Como é que as alucinações dos LLM afectam as interacções com o serviço de apoio ao cliente?

As alucinações no serviço de apoio ao cliente podem levar a informações incorrectas, clientes frustrados e menor confiança nos sistemas de apoio com IA da empresa.

Quais são as estratégias utilizadas para atenuar as alucinações de LLM?

As principais estratégias incluem a melhoria da qualidade dos dados de formação, a implementação de uma validação robusta dos resultados, a integração da supervisão humana e a utilização de técnicas avançadas, como a geração aumentada por recuperação.