As 10 melhores técnicas de solicitação de LLM para maximizar o desempenho da IA

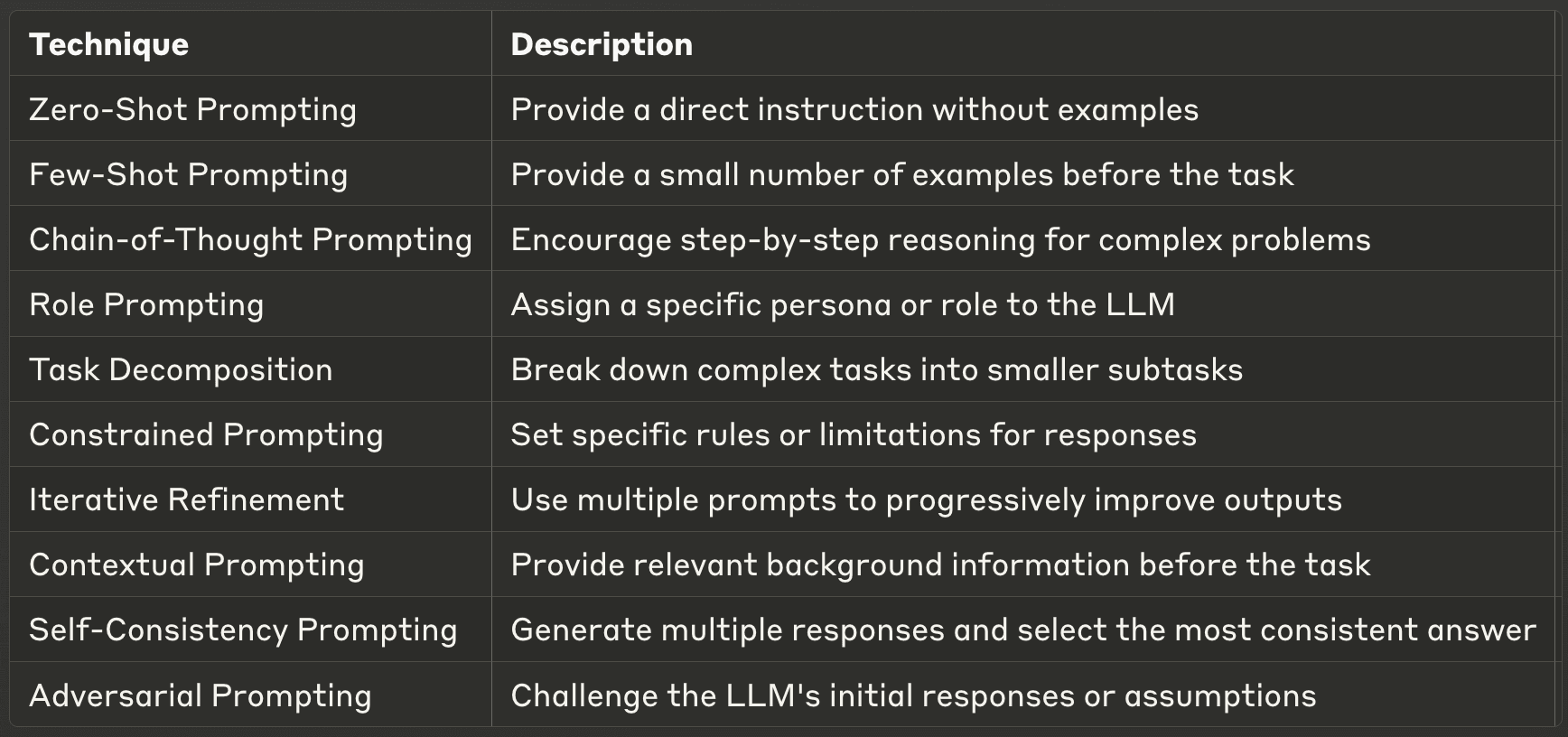

A arte de criar prompts eficazes para modelos de grande linguagem (LLM) tornou-se uma competência crucial para os profissionais de IA. Os avisos bem concebidos podem melhorar significativamente o desempenho de um LLM, permitindo resultados mais precisos, relevantes e criativos. Esta publicação do blogue explora dez das mais poderosas técnicas de solicitação, oferecendo informações sobre as suas aplicações e melhores práticas. Quer seja um programador de IA experiente ou esteja apenas a começar com LLMs, estas técnicas ajudá-lo-ão a desbloquear todo o potencial dos modelos de IA.

- 1. Prompting de disparo zero

- 2. Prompting de poucos disparos

- 3. Promoção da cadeia de pensamento (CoT)

- 4. Solicitação de funções

- 5. Decomposição de tarefas

- 6. Solicitação restrita

- 7. Refinamento iterativo

- 8. Solicitação contextual

- 9. Promoção da auto-consistência

- 10. Prompting Adversarial

- Encontrar as técnicas de engenharia adequadas para o Prompt

1. Prompting de disparo zero

O prompt de disparo zero é a forma mais direta de interagir com um LLM. Nesta técnica, o utilizador fornece uma instrução ou pergunta direta sem quaisquer exemplos, confiando no conhecimento pré-treinado do modelo para gerar uma resposta. Este método testa a capacidade do LLM de compreender e executar tarefas com base apenas na instrução dada, sem contexto ou exemplos adicionais.

A pergunta zero é particularmente útil para tarefas simples e diretas ou perguntas sobre conhecimentos gerais. É uma excelente forma de avaliar as capacidades de base de um LLM e pode ser surpreendentemente eficaz para uma vasta gama de aplicações. No entanto, a sua eficácia pode variar consoante a complexidade da tarefa e o grau de alinhamento com os dados de treino do modelo. Ao utilizar a solicitação de disparo zero, é crucial ser claro e específico nas suas instruções para obter os melhores resultados.

Exemplo: Ao utilizar o estímulo de disparo zero, pode simplesmente perguntar ao LLM: "Explique o conceito de fotossíntese em termos simples". O modelo geraria então uma explicação baseada no seu conhecimento pré-existente, sem qualquer contexto adicional ou exemplos fornecidos.

2. Prompting de poucos disparos

A interação com os LLMs é levada um pouco mais longe, fornecendo um pequeno número de exemplos antes de pedir ao modelo que execute uma tarefa. Esta técnica ajuda a orientar o formato e o estilo de saída do modelo, dando-lhe essencialmente um padrão a seguir. Ao demonstrar a relação de entrada-saída pretendida, o estímulo de poucos disparos pode melhorar significativamente o desempenho do modelo em tarefas específicas.

Este método é particularmente eficaz quando são necessários formatos de saída consistentes, quando se lida com tarefas específicas de um domínio ou quando a solicitação de disparo zero produz resultados inconsistentes. A solicitação de poucos disparos permite ajustar o comportamento do modelo sem a necessidade de treinamento extensivo ou ajuste fino. É uma forma poderosa de adaptar rapidamente o LLM ao seu caso de utilização específico. No entanto, é importante escolher cuidadosamente os seus exemplos, uma vez que estes influenciarão fortemente os resultados do modelo.

Exemplo: No caso de perguntas de curta duração, pode dar alguns exemplos ao aprendente antes de fazer a pergunta principal. Por exemplo:

P: Qual é a capital de França? R: A capital de França é Paris.

P: Qual é a capital do Japão? R: A capital do Japão é Tóquio.

P: Qual é a capital do Brasil? A:

Ao fornecer estes exemplos, está a orientar o LLM para compreender o formato e o tipo de resposta que procura, aumentando a probabilidade de receber uma resposta consistente e precisa.

3. Promoção da cadeia de pensamento (CoT)

O estímulo da Cadeia de Pensamento é uma técnica mais avançada que incentiva os LLMs a decompor problemas complexos em processos de raciocínio passo-a-passo. Este método imita as abordagens humanas de resolução de problemas, permitindo ao modelo lidar com tarefas mais complexas que exigem raciocínio ou cálculos em várias etapas. Ao solicitar que o LLM mostre o seu trabalho, a CoT pode melhorar significativamente o desempenho em tarefas complexas e proporcionar transparência no processo de tomada de decisão do modelo.

As vantagens da solicitação de CoT vão para além da melhoria da precisão. Também melhora a interpretabilidade dos resultados do modelo, tornando mais fácil para os humanos compreenderem e verificarem o raciocínio subjacente às respostas. Isto é particularmente valioso em domínios como a educação, onde a compreensão do processo de resolução de problemas é tão importante como a resposta final. No entanto, é de salientar que a solicitação de CoT pode ser mais intensiva em termos de computação e pode nem sempre ser necessária para tarefas mais simples. Também é importante notar que a solicitação de CoT provou ser mais eficaz quando fornece exemplos altamente relevantes e específicos.

Exemplo: Ao utilizar o estímulo da Cadeia de Pensamento, pode colocar uma questão como esta: "Se uma camisa custa $25 e está à venda por 20% de desconto, qual é o preço final? Por favor, mostre o seu raciocínio passo a passo". O professor pode então responder com um raciocínio pormenorizado:

"Vamos abordar este assunto passo a passo:

O preço original é $25.

Um desconto de 20% significa que temos de calcular 20% de $25.

20% de $25 é $25 × 0,20 = $5.

O montante do desconto é $5.

Para obter o preço final, subtraímos o desconto ao preço original.

$25 - $5 = $20. Por conseguinte, o preço final da camisola é $20".

Esta resposta não só fornece a resposta correta como também demonstra o processo de raciocínio, facilitando a verificação e a compreensão da solução.

4. Solicitação de funções

O estímulo de papel é uma técnica criativa e poderosa que envolve a atribuição de uma personalidade ou papel específico ao LLM. Esse método pode alterar drasticamente o tom, o estilo e o conteúdo das respostas do modelo, permitindo que você adapte seu resultado a necessidades ou cenários específicos. Ao instruir o LLM a adotar um determinado papel, é possível aceder a diferentes "personalidades" ou competências dentro da base de conhecimentos do modelo.

Esta técnica é particularmente útil quando é necessário gerar conteúdo com uma voz ou estilo específico, simular conhecimentos especializados numa área ou criar diversas perspectivas sobre um tópico. A sugestão de função pode levar a respostas mais envolventes e adequadas ao contexto, tornando-a valiosa para a escrita criativa, planeamento de cenários ou simulações educativas. No entanto, é importante lembrar que, embora o LLM possa simular diferentes papéis de forma convincente, as suas respostas continuam a basear-se nos seus dados de treino e não devem ser consideradas como conselhos de especialistas reais sem verificação.

Exemplo: Para a definição do papel, pode dar as seguintes instruções ao mentor legal: "Como um cientista climático experiente, explique os potenciais efeitos a longo prazo da subida do nível do mar nas cidades costeiras." Esta sugestão incentiva o mentor legal a adotar a personalidade de um cientista climático, o que poderá levar a uma resposta mais técnica e autorizada sobre o tema.

5. Decomposição de tarefas

A decomposição de tarefas é uma abordagem estratégica que envolve a divisão de tarefas complexas em subtarefas mais pequenas e mais fáceis de gerir. Esta técnica aproveita a capacidade do LLM de lidar com partes discretas de informação e combiná-las num todo coeso. Ao decompor uma tarefa grande, pode guiar o modelo através de uma série de passos, assegurando que cada componente é abordado de forma completa e precisa.

Este método é particularmente eficaz para resolver problemas complexos que poderiam sobrecarregar o modelo se fossem apresentados todos de uma vez. Reduz a carga cognitiva sobre o LLM, permitindo respostas mais precisas e focalizadas em cada subtarefa. A decomposição de tarefas também permite lidar melhor com problemas de várias etapas e pode melhorar a qualidade geral e a integridade do resultado final. Além disso, esta abordagem pode facilitar a identificação e correção de erros, uma vez que é possível rever cada passo individualmente. Ao implementar a decomposição de tarefas, é crucial manter um fluxo lógico claro entre as subtarefas para garantir um resultado final coerente.

Exemplo: Quando se utiliza a decomposição de tarefas para uma tarefa complexa, pode-se pedir ao LLM o seguinte: "Para escrever um trabalho de investigação abrangente sobre energias renováveis, vamos dividi-lo em etapas. Por favor, indique os principais passos que devemos seguir, desde a definição do âmbito até à finalização do trabalho."

O LLM poderá então responder com uma análise como esta:

"1. definir o âmbito do trabalho (tipos de energias renováveis a cobrir). 2. Delinear as principais secções (introdução, situação atual, desafios, perspectivas futuras, conclusão). 3. Para cada secção, enumerar os pontos-chave a abordar. 4. Pesquisar e recolher dados para cada ponto. 5. Escreva uma introdução que estabeleça o contexto e indique os objectivos do documento. 6. Desenvolva cada secção, incorporando dados e análises relevantes. 7. Resuma os principais resultados e as implicações futuras na conclusão. 8. Reveja e aperfeiçoe todo o documento para garantir a sua coerência e fluidez. 9. Criar uma bibliografia das fontes utilizadas.

Agora, vamos começar com o passo 1..."

Esta divisão permite-lhe abordar a complexa tarefa de escrever um trabalho de investigação em partes geríveis, melhorando a qualidade geral e a integridade do resultado final.

Com certeza! Vamos continuar com as restantes secções da publicação do blogue "10 Best Prompting Techniques for LLMs". Eis as secções 7-10, seguidas de uma conclusão e de dicas práticas:

6. Solicitação restrita

A solicitação restrita envolve a definição de regras ou limitações específicas para o LLM seguir em suas respostas. Esta técnica é particularmente útil quando é necessário controlar o formato de saída, a duração ou o conteúdo das respostas do modelo. Ao declarar explicitamente as restrições, é possível orientar o LLM para gerar resultados mais focados e relevantes.

As restrições podem variar de instruções simples, como limites de contagem de palavras, a requisitos mais complexos, como aderir a estilos de escrita específicos ou evitar determinados tópicos. Esta técnica é especialmente valiosa em contextos profissionais onde a consistência e a adesão a diretrizes são cruciais. No entanto, é importante equilibrar as restrições com a flexibilidade para permitir que o LLM aproveite todas as suas capacidades.

Exemplo: "Forneça um resumo dos últimos desenvolvimentos em matéria de energias renováveis em exatamente 100 palavras. Concentre-se apenas na energia solar e eólica e não mencione quaisquer empresas ou marcas específicas."

7. Refinamento iterativo

O refinamento iterativo é uma técnica que envolve o uso de múltiplas solicitações para melhorar e refinar progressivamente os resultados do LLM. Esta abordagem reconhece que as tarefas complexas requerem frequentemente várias rondas de revisões e melhorias. Dividindo a tarefa em várias etapas e fornecendo feedback em cada uma delas, é possível orientar o formando para resultados finais mais precisos e polidos.

Este método é particularmente eficaz para tarefas como a escrita, a resolução de problemas ou o trabalho criativo, em que o primeiro rascunho raramente é perfeito. O aperfeiçoamento iterativo permite-lhe tirar partido dos pontos fortes do LLM, mantendo o controlo sobre a direção e a qualidade do resultado. É importante ser claro e específico com o seu feedback em cada iteração para garantir uma melhoria contínua.

Exemplo: Passo 1: "Escreva um breve esboço de um artigo sobre o impacto da inteligência artificial nos cuidados de saúde." Passo 2: "Com base neste esboço, expanda a secção sobre IA no diagnóstico médico." Passo 3: "Agora, acrescente exemplos específicos de aplicações de IA em radiologia a esta secção."

8. Solicitação contextual

O estímulo contextual envolve o fornecimento de informações de fundo relevantes ou contexto ao LLM antes de pedir-lhe para executar uma tarefa. Esta técnica ajuda o modelo a compreender o quadro geral e a gerar respostas mais precisas e relevantes. Ao preparar o terreno com o contexto adequado, pode melhorar significativamente a qualidade e a especificidade dos resultados do LLM.

Este método é particularmente útil quando se lida com tópicos especializados, cenários únicos, ou quando é necessário que o LLM considere informações específicas que podem não fazer parte do seu conhecimento geral. O estímulo contextual pode ajudar a preencher a lacuna entre o conhecimento geral do LLM e os requisitos específicos da sua tarefa.

Exemplo: "Contexto: A cidade de Amesterdão tem vindo a implementar várias iniciativas ecológicas para se tornar mais sustentável. Tendo em conta esta informação, sugira três ideias inovadoras de planeamento urbano que poderiam melhorar ainda mais os esforços de sustentabilidade de Amesterdão."

9. Promoção da auto-consistência

A solicitação de auto-consistência é uma técnica avançada que envolve a geração de várias respostas à mesma solicitação e, em seguida, a seleção da resposta mais consistente ou fiável. Este método aproveita a natureza probabilística das LLMs para melhorar a precisão, especialmente em tarefas que exigem raciocínio ou resolução de problemas.

Ao comparar vários resultados, a solicitação de auto-consistência pode ajudar a identificar e filtrar inconsistências ou erros que possam ocorrer em respostas individuais. Esta técnica é particularmente valiosa para aplicações críticas em que a exatidão é fundamental. No entanto, requer mais recursos computacionais e tempo em comparação com os métodos de resposta única.

Exemplo: "Resolver o seguinte problema matemático: Se um comboio viaja a 60 mph durante 2,5 horas, qual é a distância que percorre? Gera cinco soluções independentes e escolhe a resposta mais consistente."

10. Prompting Adversarial

O "Adversarial prompting" é uma técnica que consiste em desafiar as respostas iniciais ou os pressupostos do LLM para melhorar a qualidade, a exatidão e a robustez dos seus resultados. Este método simula um debate ou um processo de pensamento crítico, levando o modelo a considerar pontos de vista alternativos, potenciais falhas no seu raciocínio ou factores não considerados.

A abordagem contraditória funciona pedindo primeiro ao LLM que forneça uma resposta ou solução inicial e, em seguida, levando-o a criticar ou desafiar a sua própria resposta. Este processo pode ser repetido várias vezes, cada iteração refinando e reforçando o resultado final. A abordagem adversarial é particularmente útil para a resolução de problemas complexos, cenários de tomada de decisão, ou quando se lida com tópicos controversos ou multifacetados.

Esta técnica ajuda a mitigar potenciais enviesamentos nas respostas do modelo e encoraja resultados mais completos e equilibrados. No entanto, requer uma formulação cuidadosa das solicitações contraditórias para garantir uma crítica produtiva em vez de uma simples contradição.

Exemplo: Passo 1: "Proponha uma solução para reduzir o congestionamento do tráfego urbano." Passo 2: "Agora, identifique três potenciais inconvenientes ou desafios à solução que acabou de propor." Etapa 3: "Tendo em conta estes desafios, aperfeiçoe a sua solução original ou proponha uma abordagem alternativa." Passo 4: "Por fim, compare os pontos fortes e fracos da solução original e da solução aperfeiçoada e recomende a melhor linha de ação."

Encontrar as técnicas de engenharia adequadas para o Prompt

O domínio destas técnicas de estímulo pode melhorar significativamente a sua capacidade de trabalhar eficazmente com os LLM. Cada método oferece vantagens únicas e é adequado a diferentes tipos de tarefas e cenários. Ao compreender e aplicar estas técnicas, os profissionais de IA podem desbloquear todo o potencial dos LLMs, conduzindo a resultados mais exactos, criativos e úteis.

À medida que o campo da IA continua a evoluir, o mesmo acontece com as estratégias de estímulo. Manter-se informado sobre os novos desenvolvimentos e experimentar continuamente diferentes técnicas será crucial para quem trabalha com LLMs. Lembre-se de que a arte da solicitação tem tanto a ver com a compreensão das capacidades e limitações do modelo como com a elaboração da entrada perfeita.